Maison >Périphériques technologiques >IA >Scandaleux! Un professeur américain a utilisé ChatGPT pour « confirmer » que son article était plagié, et la moitié de la classe a échoué au cours

Scandaleux! Un professeur américain a utilisé ChatGPT pour « confirmer » que son article était plagié, et la moitié de la classe a échoué au cours

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-05-27 12:16:231372parcourir

Un grand départ !

Le mémoire de fin d'études que j'ai travaillé si dur pour coder a en fait été repris par le professeur et mis dans ChatGPT pour être testé, puis il a été jugé comme plagiat ?

Le professeur a échoué la moitié de la classe à cause de cela, et puis l'école a refusé de délivrer un diplôme à cause de cela ?

Professeur : toute personne réclamée par ChatGPT obtiendra 0 point

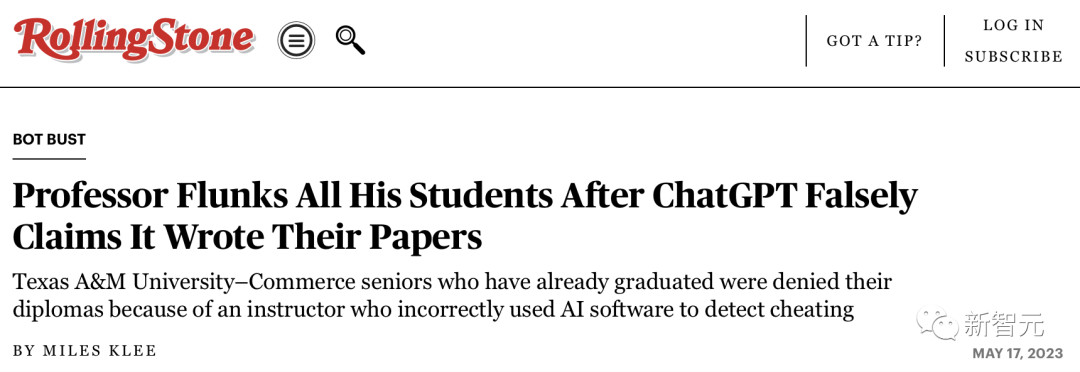

Récemment, une chose aussi ridicule s'est produite à la Texas A&M University (Texas A&M).

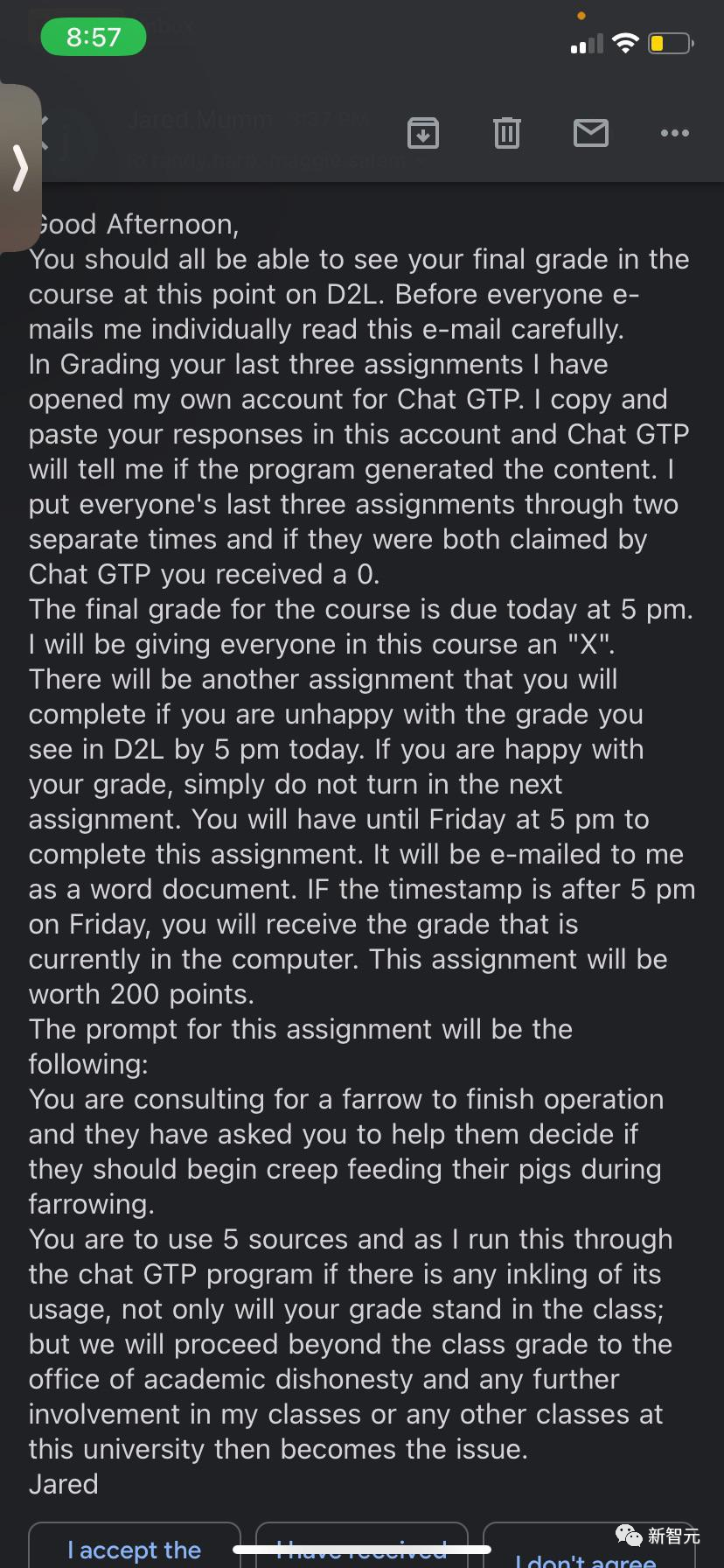

Afin de détecter la tricherie dans les documents soumis par les étudiants, un professeur nommé Jared Mumm a soumis leurs documents à ChatGPT.

Il a dit aux étudiants : je vais copier et coller votre article dans ChatGPT, et il me dira si votre article a été généré par celui-ci.

"Je mettrai les trois derniers articles de chacun dans deux périodes différentes. S'ils sont réclamés par ChatGTP les deux fois, je vous donnerai 0 point

Évidemment, professeur Mumm, qui n'a aucun rapport avec l'informatique." connaissances de base, ne sait rien des principes de ChatGPT.

En fait, ChatGPT ne reconnaît pas le contenu créé par l'IA, même s'il est écrit par elle-même.

Même, il n'a même pas orthographié correctement ChatGPT - il a directement écrit "Chat GPT" et "chat GPT".

En conséquence, plus de la moitié de la classe a vu ses papiers « réclamés » de manière irresponsable par ChatGPT et a donc échoué sur le sujet.

Ce qui est encore plus regrettable, c'est que la plupart des diplômes des étudiants diplômés ont été directement rejetés par l'école.

Bien sûr, le professeur Mumm n'a pas été sans pitié. Il a donné à toute la classe l'occasion de refaire ses devoirs.

Comment prouver que vous n'utilisez pas ChatGPT ?

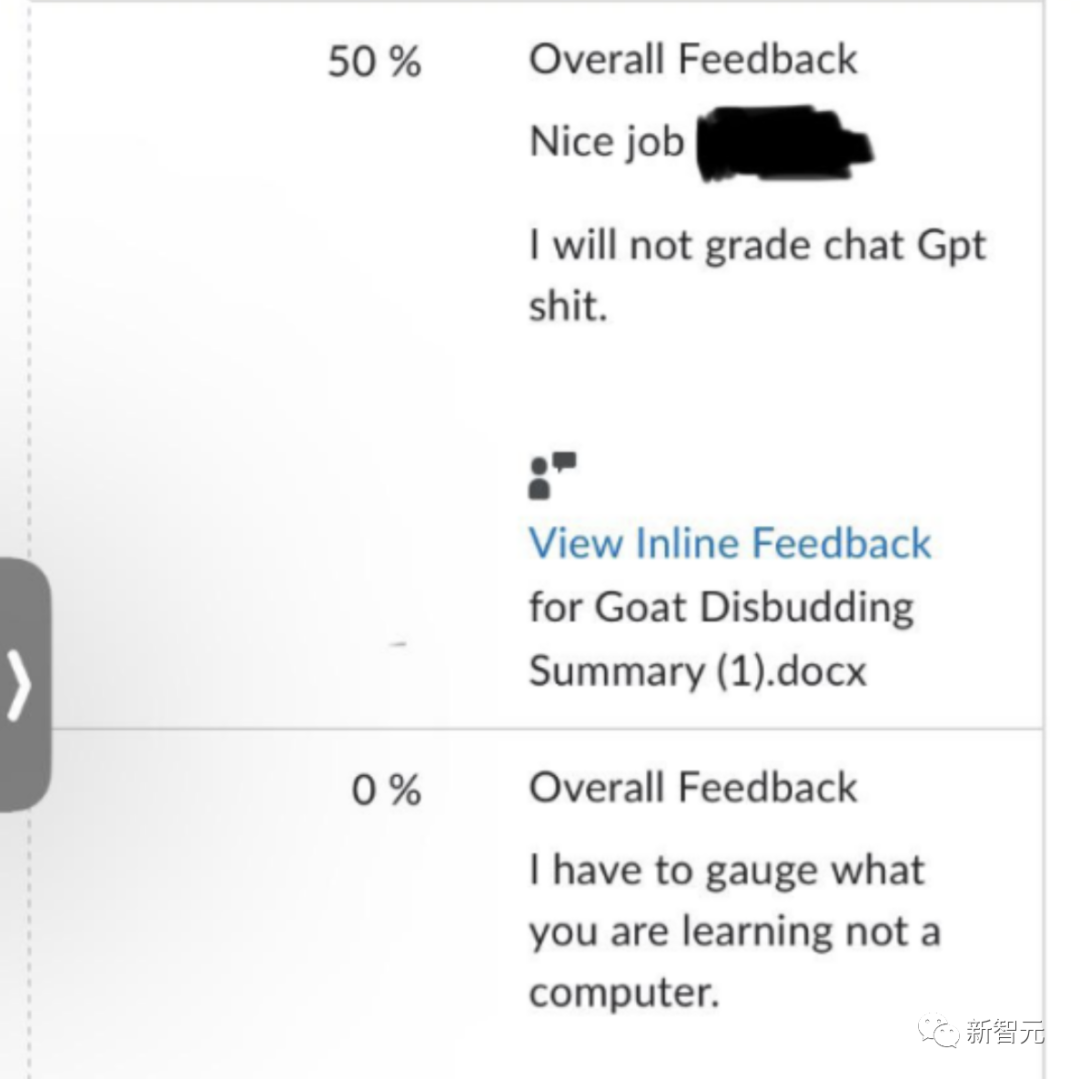

Après avoir reçu l'e-mail ci-dessus, plusieurs étudiants ont écrit à Mumm pour prouver leur innocence. Ils ont fourni à Google Docs des horodatages pour prouver qu'ils n'utilisaient pas ChatGPT.

Mais le professeur Mumm a tout simplement ignoré ces e-mails et n'a laissé cette réponse que dans le logiciel de notation de plusieurs étudiants : je ne note pas les conneries générées par l'IA.

Cependant, certains étudiants ont été "réhabilités". On dit qu'un étudiant a été "acquitté" et a reçu des excuses de Mumm.

Cependant, pour rendre la situation plus compliquée, deux étudiants « se sont manifestés » et ont admis qu'ils avaient effectivement utilisé ChatGPT ce semestre.

Cela rend soudainement plus difficile pour les autres étudiants qui n'ont pas utilisé ChatGPT de rédiger leurs papiers pour prouver leur innocence...

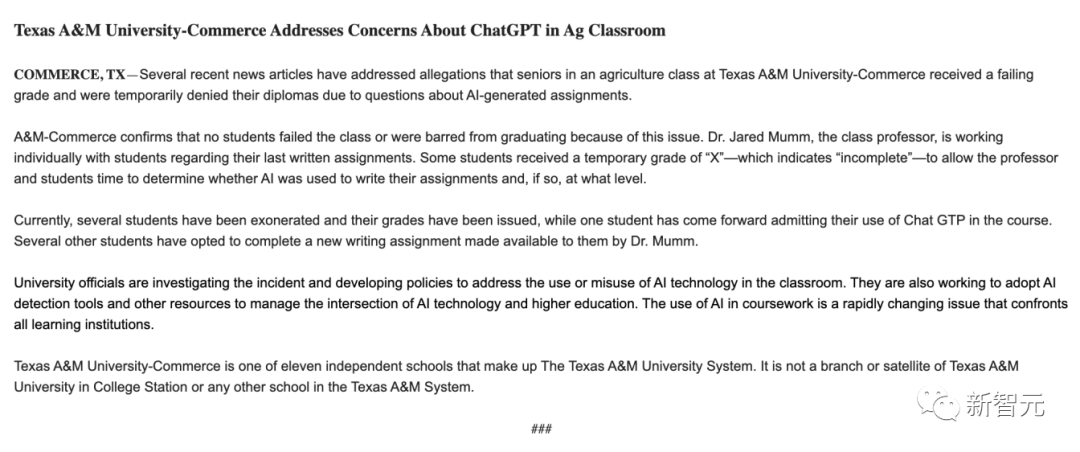

En réponse, la Texas A&M University School of Business a déclaré qu'elle enquêtait sur l'incident. , mais il n'y a aucun étudiant qui n'est pas responsable a réussi l'examen, et personne n'a été retardé à cause de ce problème.

L'école a déclaré que le professeur Mum discutait avec les élèves en tête-à-tête pour comprendre si l'IA était utilisée dans le processus de rédaction de leurs devoirs et dans quelle mesure elle était utilisée. Les diplômes individuels des étudiants seront retenus jusqu'à ce que l'enquête soit terminée.

Et les étudiants ont déclaré qu'ils n'avaient pas reçu de diplôme.

Actuellement, l'incident fait toujours l'objet d'une enquête.

Utiliser ChatGPT pour détecter ChatGPT ?

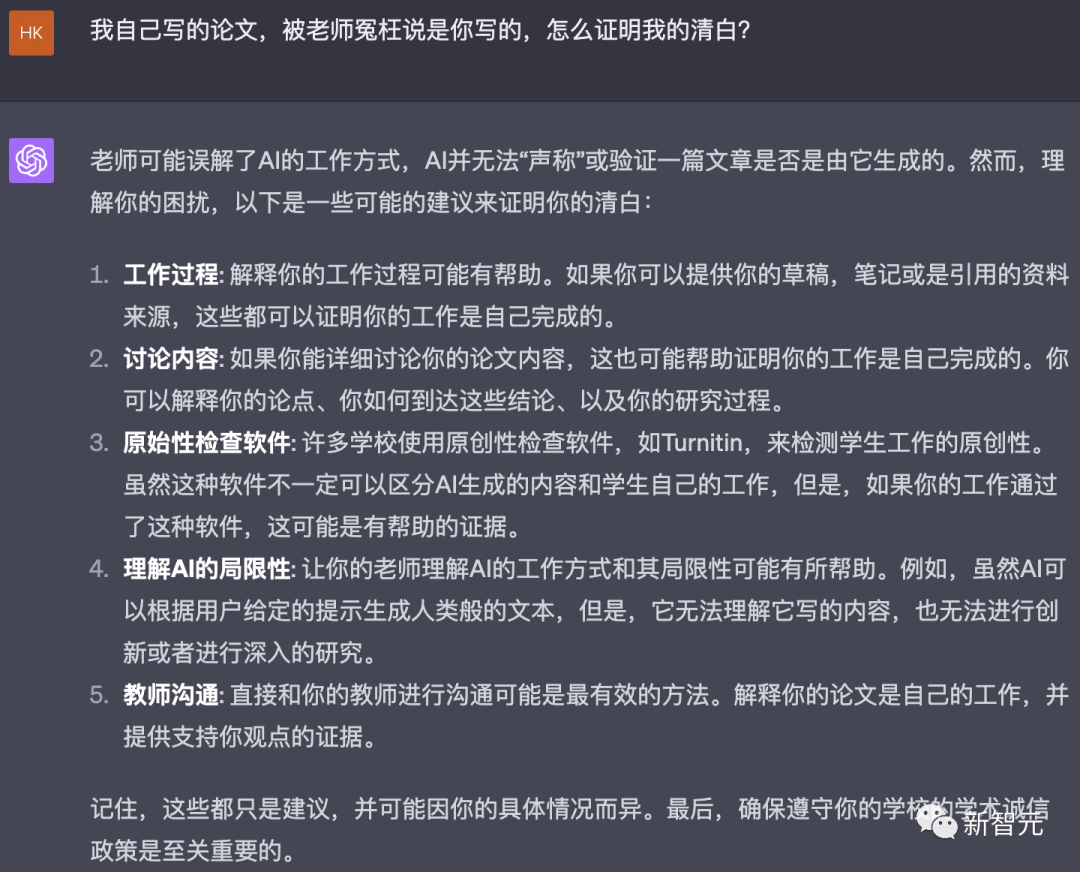

Alors la question est : ChatGPT peut-il prouver si un article a été écrit par vous-même ?

À cet égard, nous avons demandé à ChatGPT son avis sur la base du contenu de l'e-mail du professeur :

ChatGPT a déclaré dès le début qu'il n'avait pas la possibilité de vérifier l'originalité du contenu et s'il a été généré par l’IA.

"Ce professeur semble avoir mal compris le fonctionnement de l'IA comme moi. Bien que l'IA puisse générer du texte en fonction d'invites, elle ne peut pas déterminer si un autre texte a été généré par l'IA

Cela dit." , cela n'empêche pas les internautes qui aiment s'amuser.

Ils ont imaginé une émission intitulée "Enseigner à l'autre sa propre voie" pour apprendre au professeur Mumm comment se comporter en ligne.

Tout d'abord, ChatGPT a déclaré que l'e-mail rédigé par le professeur avait été rédigé par lui.

Ensuite, les internautes ont copié l'approche du professeur Mumm -

a pris un extrait qui ressemblait à un certain article et a demandé à ChatGPT s'il avait été écrit par lui.

Cette fois, même si ChatGPT n'a pas dit qu'il avait été écrit par lui-même, il est fondamentalement certain que le contenu provenait de l'IA.

Parmi elles, plusieurs fonctionnalités sont cohérentes avec le contenu généré par Al :

1 Le texte est cohérent et suit une structure claire, du général au particulier.

2. Citer avec précision les sources et les données numériques.

3. La terminologie est utilisée correctement, ce qui est une caractéristique du modèle Al typique. Par exemple, GPT-4 est formé sur divers textes, notamment de la littérature scientifique.

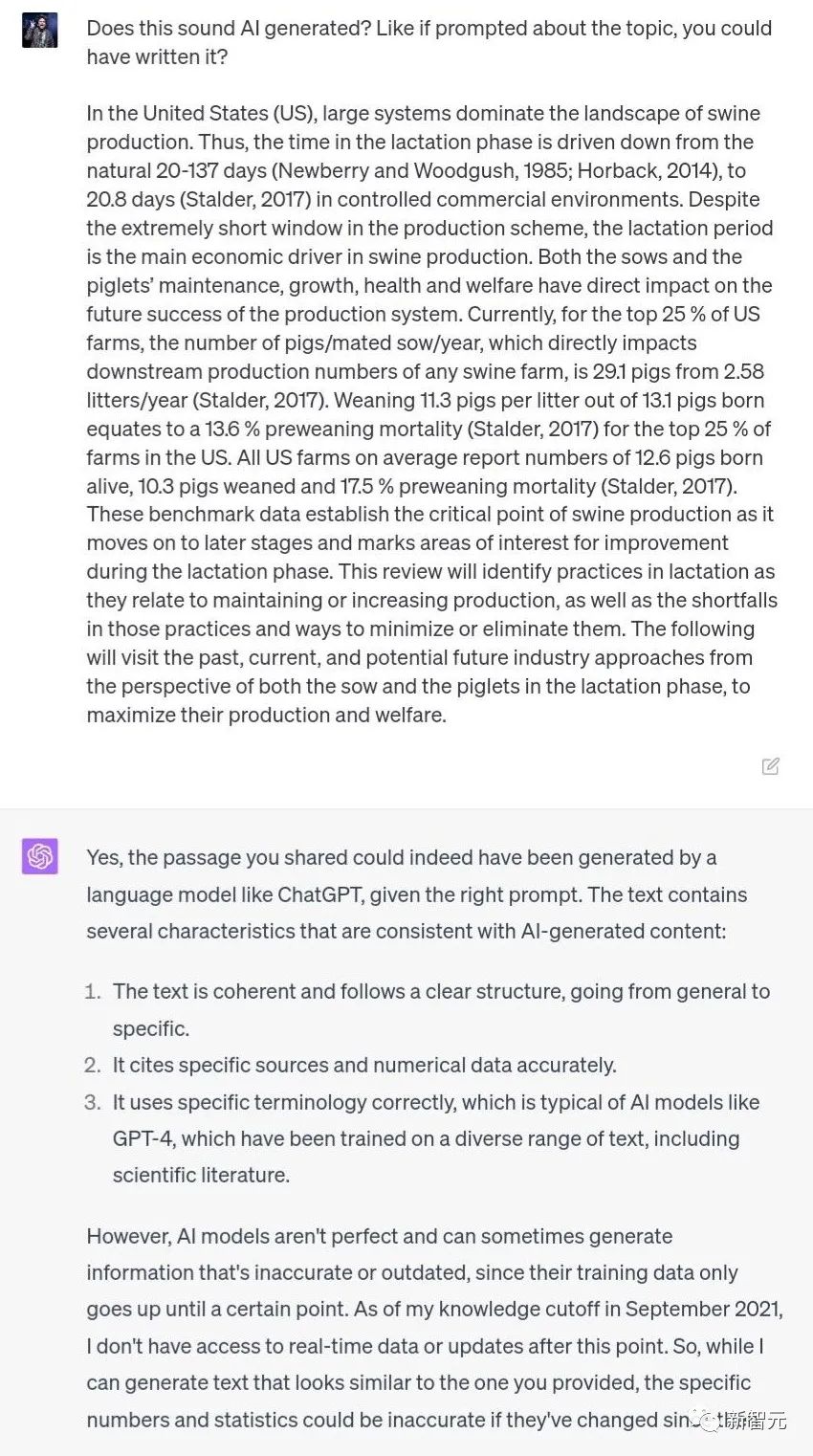

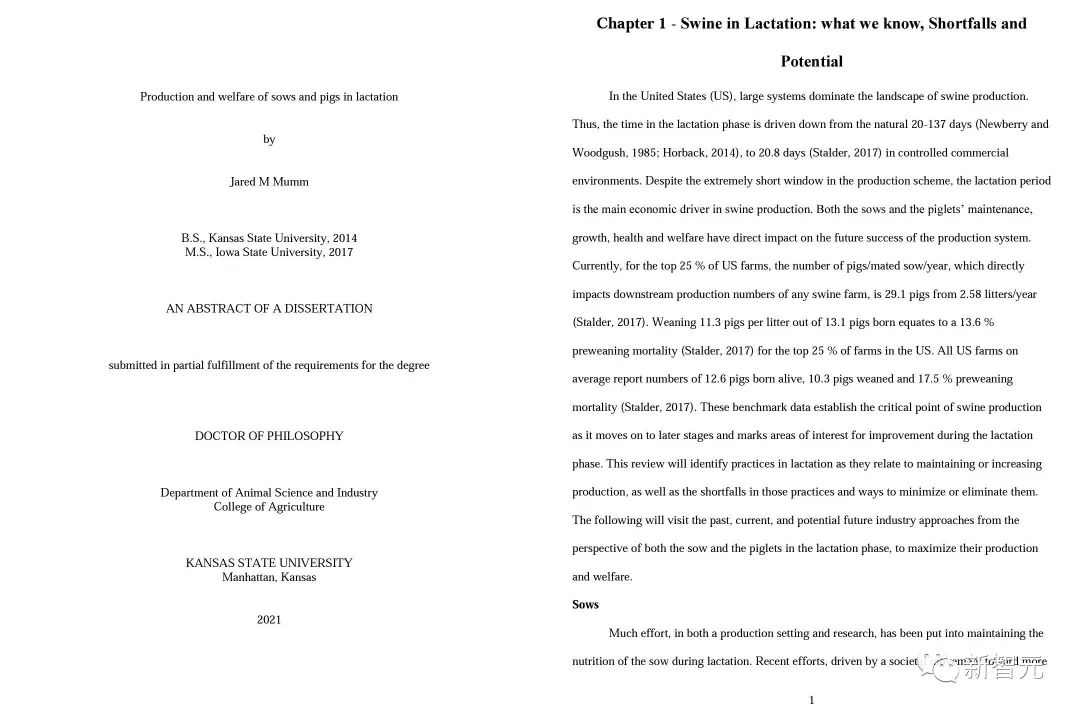

Alors au fait, d'où vient ce contenu ?

Voici la partie intéressante. Contre toute attente, il s'agissait d'une thèse de doctorat rédigée par le professeur Mumm lui-même !

Le détecteur IA ne fonctionne pas ?

Puisque ChatGPT ne peut pas vérifier si un élément de contenu est généré par l'IA, que peut-il faire ?

Bien entendu, le « détecteur IA » a été spécialement créé à cet effet, prétendant vaincre la magie par la magie.

Parmi les nombreux détecteurs d'IA, le plus célèbre est GPTZero, créé par Edward Tian, étudiant chinois à Princeton. Il est non seulement gratuit, mais donne également des résultats exceptionnels.

Copiez et collez simplement le texte, et GPTZero peut clairement indiquer quel paragraphe d'un morceau de texte est généré par l'IA et quel paragraphe est écrit par des humains.

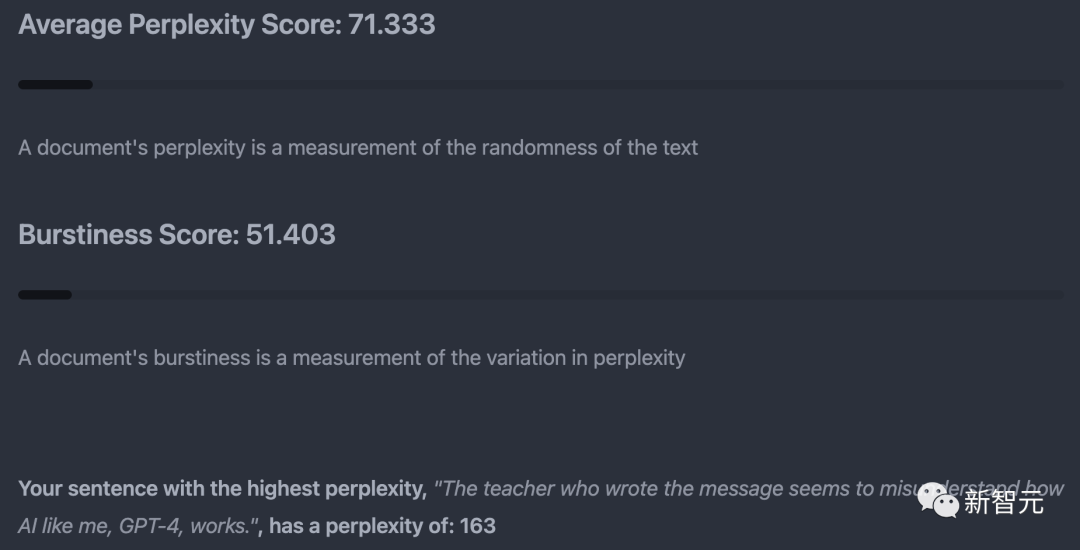

En principe, GPTZero s'appuie principalement sur la « perplexité » (caractère aléatoire du texte) et la « soudaineté » (changements de perplexité) comme indicateurs pour porter des jugements.

Dans chaque test, GPTZero sélectionnera également la phrase avec le plus haut degré de confusion, qui est la phrase qui ressemble le plus au discours humain.

Mais cette méthode n'est pas totalement fiable. Bien que GPTZero affirme que le taux de faux positifs du produit est

Lors de tests réels, quelqu'un a un jour entré la Constitution américaine dans GPTZero, et le résultat a été déterminé comme étant écrit par l'IA.

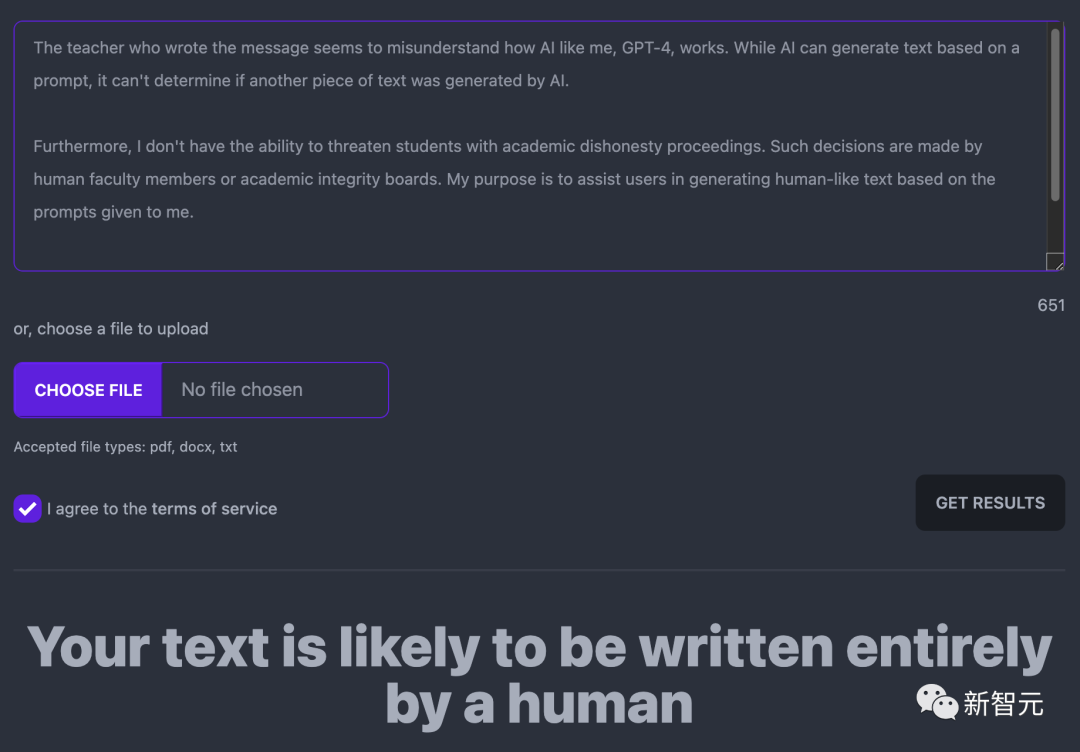

Quant à la réponse ChatGPT de tout à l'heure, GPTZero estime qu'elle a probablement été entièrement écrite par des humains.

La conséquence de cela est que les enseignants qui ne comprennent pas les principes et qui sont trop têtus feront involontairement du tort à de nombreux élèves, comme le professeur Mumm.

Alors, si nous sommes confrontés à cette situation, comment devrions-nous prouver notre innocence ?

Certains internautes ont suggéré que, à l'instar de «l'expérience sur la Constitution américaine», jetez des articles écrits avant l'émergence de ChatGPT dans un détecteur d'IA pour voir quels sont les résultats.

Cependant, logiquement parlant, même s'il peut être prouvé que le détecteur d'IA n'est effectivement pas fiable, les étudiants ne peuvent pas prouver directement que leur article n'a pas été généré par l'IA.

Demandez à ChatGPT comment le casser, voici ce qu'il a dit.

"Laissez les enseignants comprendre les méthodes de travail et les limites de l'IA", eh bien, ChatGPT a découvert Huadian.

La seule réponse à laquelle je peux penser pour le moment est que si vous n'écrivez pas directement sous le nez du professeur, enregistrez l'écran à chaque fois que vous écrivez un article, ou diffusez simplement en direct au professeur.

Même OpenAI ne peut garantir qu'un taux de précision « vrai positif » de 26 % pour son détecteur officiel ChatGPT.

Ils ont également publié une déclaration officielle pour vacciner tout le monde : "Nous ne recommandons vraiment pas d'utiliser cet outil de manière isolée, car nous savons que cela peut mal tourner, comme c'est le cas pour tout type d'évaluation utilisant l'IA."

Pourquoi la détection de contenu IA est-elle si difficile ?

Il existe déjà d'innombrables détecteurs sur le marché - GPTZero, Turnitin, GPT-2 Output, Writer AI, Content at Scale AI, etc., mais leur précision est loin d'être satisfaisante.

Alors, pourquoi est-il si difficile pour nous de détecter si un contenu est généré par l'IA ?

Eric Wang, vice-président de l'IA chez Turnitin, a déclaré que le principe de l'utilisation d'un logiciel pour détecter l'écriture de l'IA est basé sur des statistiques. D’un point de vue statistique, la différence entre l’IA et les humains est qu’elle est extrêmement stable au niveau moyen.

"Un système comme ChatGPT est comme une version avancée de la saisie semi-automatique, recherchant le prochain mot le plus susceptible d'être écrit. C'est en fait pourquoi il se lit si naturellement. L'écriture IA est la forme la plus avancée d'écriture humaine. sous-ensemble possible ."

Le détecteur de Turnitin "identifiera la situation moyenne où l'écriture est trop cohérente." Cependant, l’écriture humaine peut parfois paraître moyenne.

Dans les rapports d'économie, de mathématiques et de laboratoire, les étudiants ont tendance à suivre un style d'écriture fixe, ce qui signifie qu'ils sont plus susceptibles d'être confondus avec l'écriture de l'IA.

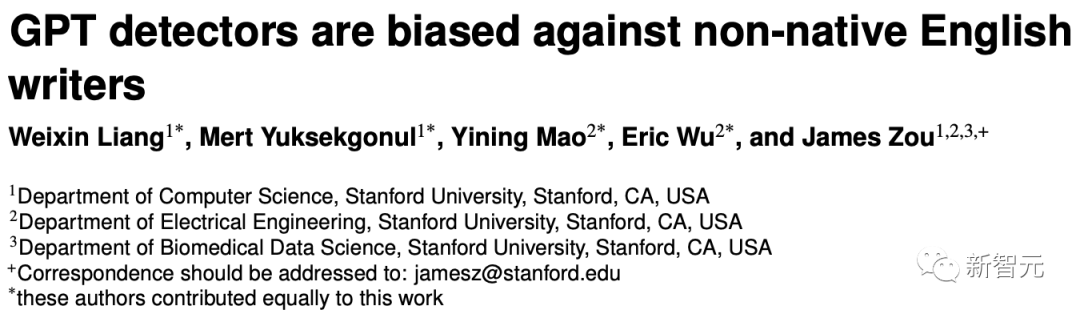

Ce qui est encore plus intéressant, c'est que dans un article récent, une équipe de recherche de l'Université de Stanford a découvert que le détecteur GPT est plus susceptible d'identifier les articles rédigés par des locuteurs non natifs comme étant rédigés par l'IA. Parmi eux, la probabilité que des articles en anglais rédigés par des Chinois soient considérés comme étant générés par l’IA atteint 61 %.

Adresse papier : https://arxiv.org/pdf/2304.02819.pdf

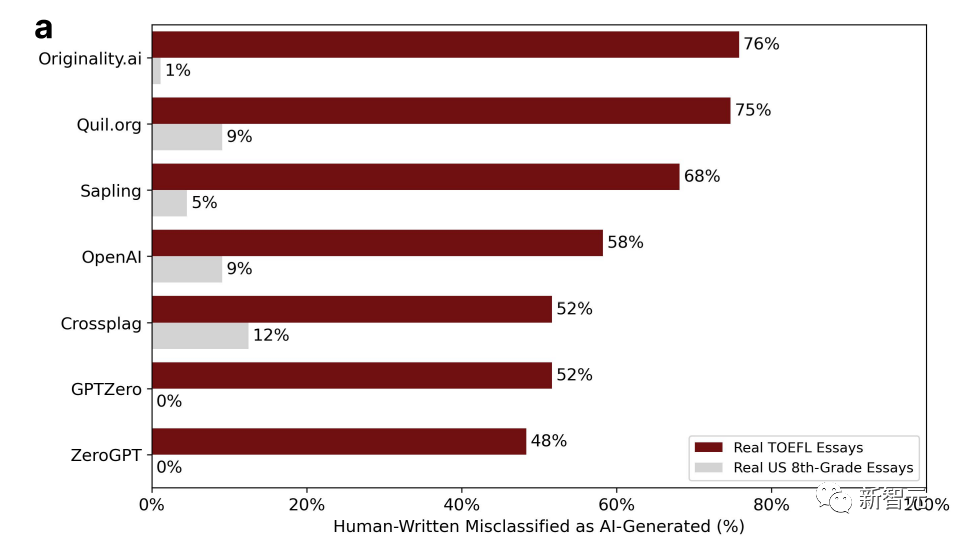

Les chercheurs ont obtenu 91 essais TOEFL sur des forums éducatifs chinois et les ont extraits de l'ensemble de données de la Fondation Hewlett aux États-Unis. 88 essais rédigés par des élèves américains de huitième année ont été saisis dans 7 principaux détecteurs GPT.

Le pourcentage sur l'image est le ratio "d'erreur de jugement", c'est-à-dire qu'il est clairement écrit par un humain, mais il est jugé comme étant généré par l'IA

Cela peut être vu que les essais des étudiants américains étaient erronés. La probabilité la plus élevée d'être jugé n'est que de 12 %, tandis que pour les essais des étudiants chinois, la probabilité est fondamentalement supérieure à la moitié, voire jusqu'à 76 %.

Les chercheurs ont conclu que, parce que les écrits rédigés par des locuteurs non natifs ne sont pas authentiques et sont peu complexes, il est facile d'être mal jugé.

On voit qu'il est déraisonnable de juger si l'auteur est un humain ou une IA sur la base de la complexité.

Ou y a-t-il d'autres raisons derrière cela ?

En réponse, le scientifique de Nvidia, Jim Fan, a déclaré que le détecteur ne serait pas fiable pendant longtemps. Après tout, l’IA deviendra plus puissante et rédigera d’une manière de plus en plus humaine.

On peut dire sans se tromper qu’avec le temps, ces bizarreries du modèle linguistique deviendront de moins en moins nombreuses.

Je ne sais pas si ce sera une bonne ou une mauvaise nouvelle pour les étudiants.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI