Maison >Périphériques technologiques >IA >GPT agit comme un cerveau, ordonnant à plusieurs modèles de collaborer pour accomplir diverses tâches. Le système général AutoML-GPT est ici.

GPT agit comme un cerveau, ordonnant à plusieurs modèles de collaborer pour accomplir diverses tâches. Le système général AutoML-GPT est ici.

- PHPzavant

- 2023-05-26 13:22:341539parcourir

Actuellement, bien que les modèles d'IA aient été impliqués dans un très large éventail de domaines d'application, la plupart des modèles d'IA sont conçus pour des tâches spécifiques et nécessitent souvent beaucoup de main-d'œuvre pour réaliser l'architecture et l'optimisation correctes du modèle. algorithmes et hyperparamètres. Après que ChatGPT et GPT-4 soient devenus populaires, les gens ont vu l'énorme potentiel des grands modèles linguistiques (LLM) dans la compréhension, la génération, l'interaction, le raisonnement, etc. Certains chercheurs tentent d’utiliser le LLM pour explorer de nouvelles voies vers l’intelligence artificielle générale (AGI).

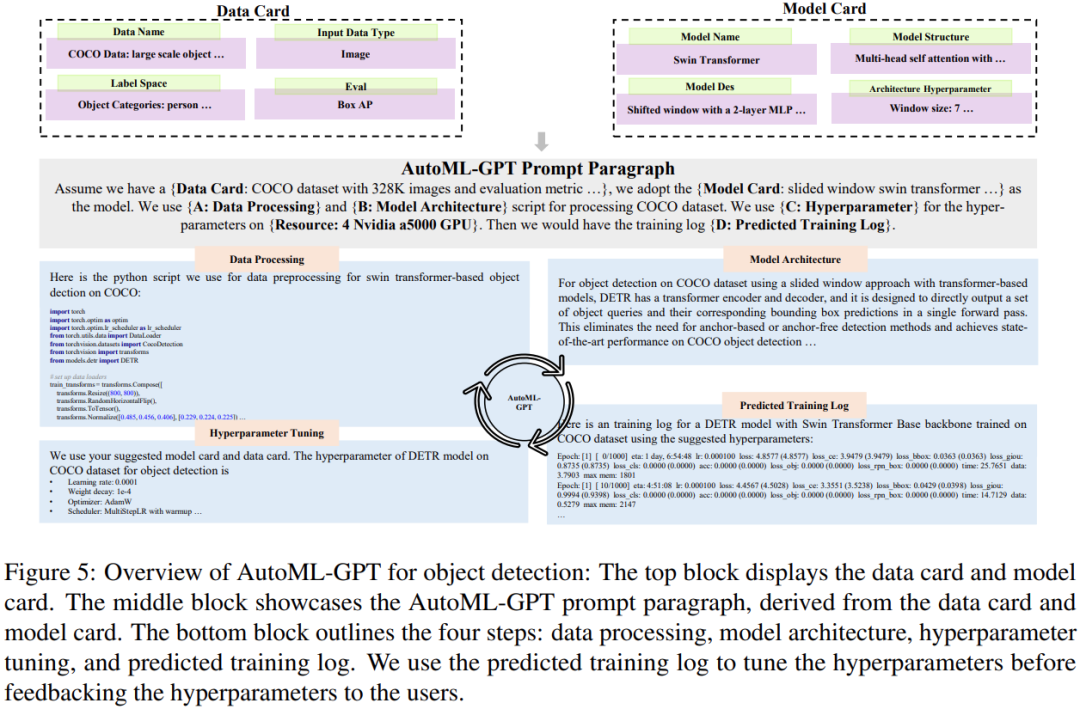

Récemment, des chercheurs de l'Université du Texas à Austin ont proposé une nouvelle idée : développer des invites orientées tâches et utiliser le LLM pour automatiser le pipeline de formation, et sur cette base idée, un nouveau système AutoML-GPT a été lancé. # 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 # Adresse papier: # 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 #

https://www.php.cn/link/39d4b545fb02556829aab1db805021c3

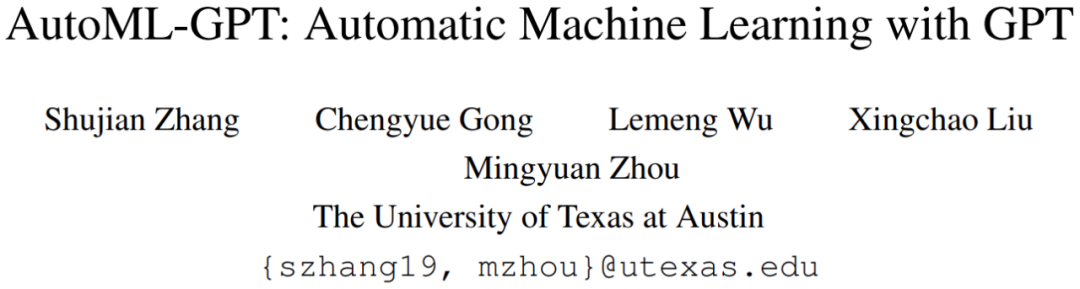

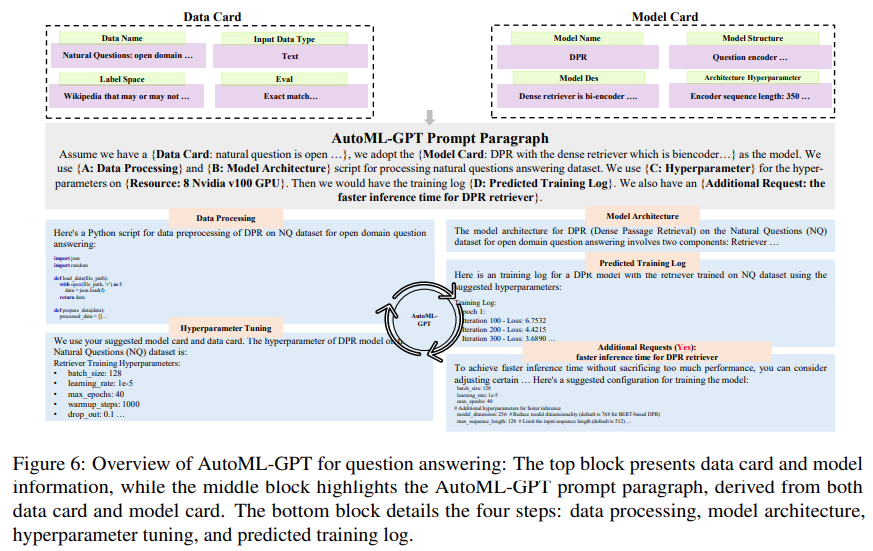

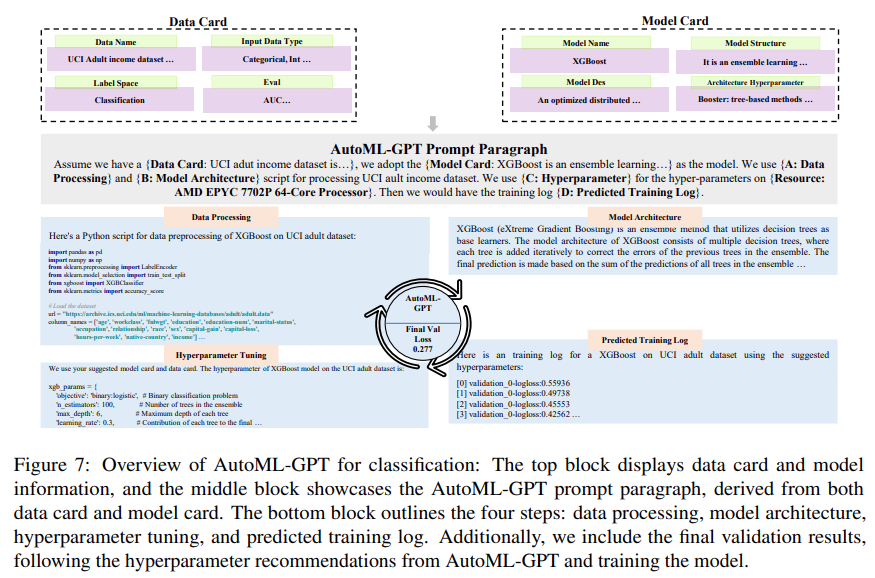

AutoML-GPT utilise GPT comme pont entre différents modèles d'IA et utilise des hyperparamètres optimisés pour entraîner dynamiquement le modèle. AutoML-GPT reçoit dynamiquement les demandes des utilisateurs de Model Card [Mitchell et al., 2019] et Data Card [Gebru et al., 2021] et compose les paragraphes d'invite correspondants. Enfin, AutoML-GPT utilise ce paragraphe d'invite pour effectuer automatiquement plusieurs expériences, notamment le traitement des données, la création d'une architecture de modèle, le réglage des hyperparamètres et la prévision des journaux d'entraînement.

AutoML-GPT résout des tâches d'IA complexes à travers une variété de tests et d'ensembles de données en maximisant ses puissantes capacités NLP et les modèles d'IA existants. Un grand nombre d'expériences et d'études d'ablation ont montré qu'AutoML-GPT est polyvalent et efficace pour de nombreuses tâches d'intelligence artificielle (y compris les tâches CV et les tâches PNL). Introduction à AutoML-GPT

AutoML-GPT est un système collaboratif qui s'appuie sur des données et des informations de modèle pour formater des paragraphes de saisie rapide. Parmi eux, LLM sert de contrôleur et plusieurs modèles experts servent d’exécuteurs collaboratifs. Le flux de travail d'AutoML-GPT comprend quatre étapes : traitement des données, conception de l'architecture du modèle, ajustement des hyperparamètres et génération du journal de formation.Plus précisément, le mécanisme de fonctionnement d'AutoML-GPT est le suivant :

# 🎜 🎜#

Générer des paragraphes d'invite au format fixe via la carte modèle et la carte de données

Créer un pipeline de formation sur l'ensemble de données et le modèle sélectionnés Gérer architecturalement les besoins des utilisateurs

Générer des journaux d'entraînement de performance et ajuster les hyperparamètres

- Selon les suggestions automatiques (auto- proposé) modèle de réglage des hyperparamètres #La première étape d'AutoML-GPT consiste pour LLM à accepter les entrées de l'utilisateur. Afin d'améliorer les performances de LLM et de générer des invites efficaces, cette étude adopte des instructions spécifiques pour les invites de saisie. Ces instructions comprennent trois parties : carte de données, carte modèle, mesures d'évaluation et exigences supplémentaires.

- Comme le montre la figure 2 ci-dessous, la partie clé de la carte de données comprend le nom de l'ensemble de données et le type d'ensemble de données d'entrée (tel que des données d'image ou des données de texte) , l'espace d'étiquette (tel que la catégorie ou la résolution) et les indicateurs d'évaluation par défaut.

- Comme le montre la figure 3 ci-dessous, la carte modèle comprend le nom du modèle, la structure du modèle, la description du modèle et hyperparamètres d'architecture . En fournissant ces informations, la Model Card peut indiquer à LLM quels modèles sont utilisés dans le système d'apprentissage automatique, ainsi que les préférences de l'utilisateur en matière d'architecture de modèle.

En plus de la carte de données et de la carte modèle, les utilisateurs peuvent également choisir de demander davantage de critères d'évaluation, de mesures d'évaluation ou de toute autre contrainte. AutoML-GPT fournit ces spécifications de tâches sous forme d'instructions de haut niveau à LLM pour analyser les besoins des utilisateurs en conséquence.

Lorsqu'une série de tâches doivent être traitées, AutoML-GPT doit faire correspondre le modèle correspondant pour chaque tâche. Afin d'atteindre cet objectif, le système doit d'abord obtenir la description du modèle à partir de la carte modèle et des entrées de l'utilisateur.

Ensuite, AutoML-GPT utilise un mécanisme d'allocation de modèles de tâches en contexte pour attribuer dynamiquement des modèles aux tâches. Cette approche permet un accès incrémentiel au modèle et offre une plus grande ouverture et flexibilité en combinant la description du modèle avec une meilleure compréhension des besoins des utilisateurs.

Ajustez les hyperparamètres avec les journaux d'entraînement prédits

AutoML-GPT définit les hyperparamètres en fonction de la carte de données et de la carte modèle et prédit les performances en générant des journaux d'entraînement d'hyperparamètres. Le système effectue automatiquement la formation et renvoie les journaux de formation. Les journaux de formation sur les performances du modèle sur l'ensemble de données enregistrent diverses mesures et informations collectées au cours du processus de formation, ce qui permet de comprendre la progression de la formation du modèle, d'identifier les problèmes potentiels et d'évaluer l'efficacité de l'architecture, des hyperparamètres et des méthodes d'optimisation sélectionnés.

Expériences

Pour évaluer les performances d'AutoML-GPT, cette étude a utilisé ChatGPT (la version GPT-4 d'OpenAI) pour l'implémenter et a mené plusieurs expériences pour démontrer l'effet d'AutoML-GPT sous plusieurs perspectives.

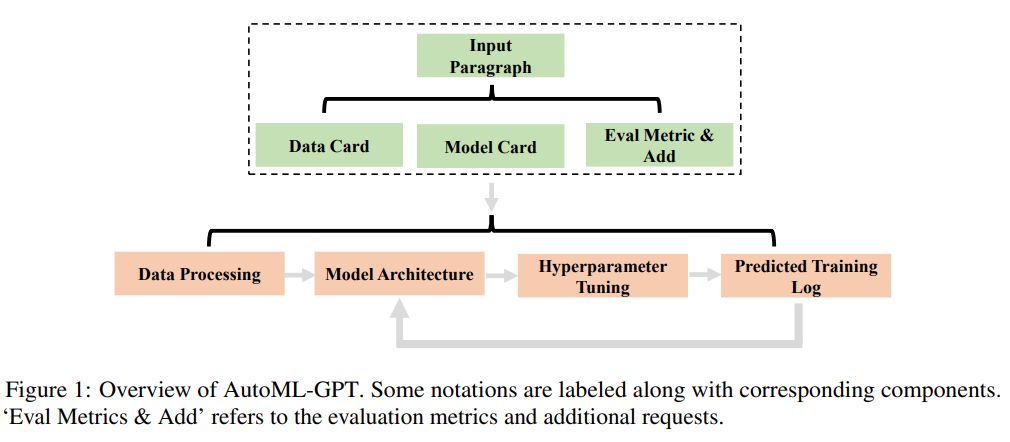

La figure 4 ci-dessous montre les résultats de la formation sur l'ensemble de données inconnu à l'aide d'AutoML-GPT :

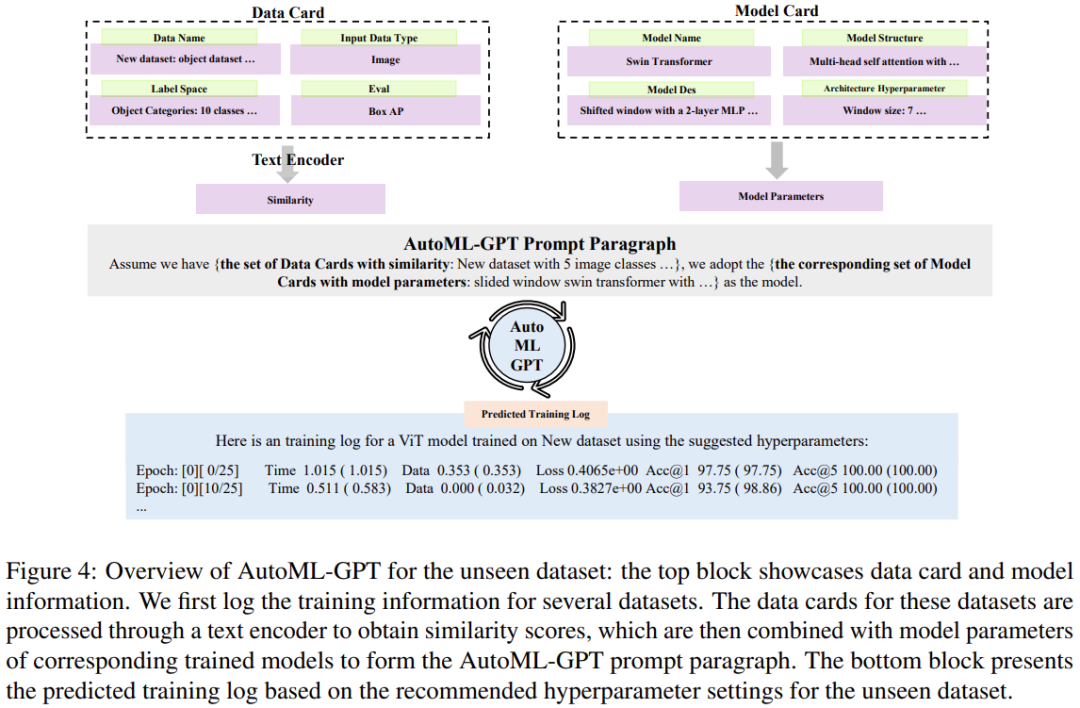

La figure 5 ci-dessous montre le processus par lequel AutoML-GPT termine la tâche de détection de cible sur l'ensemble de données COCO :

La figure 6 ci-dessous montre les résultats expérimentaux d'AutoML-GPT sur l'ensemble de données NQ Open (ensemble de données Natural Questions Open, [Kwiatkowski et al., 2019]) :

Cette étude a également utilisé XGBoost a évalué AutoML-GPT sur l'ensemble de données UCI Adult [Dua et Graff, 2017] pour explorer ses performances sur les tâches de classification. Les résultats expérimentaux sont présentés dans la figure 7 ci-dessous :

Les lecteurs intéressés peuvent lire l'article original. pour en savoir plus sur les détails de la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI