Maison >Périphériques technologiques >IA >Meta lance continuellement l'IA pour accélérer le mouvement ultime ! La première puce d'inférence IA, supercalculateur IA spécialement conçu pour la formation de grands modèles

Meta lance continuellement l'IA pour accélérer le mouvement ultime ! La première puce d'inférence IA, supercalculateur IA spécialement conçu pour la formation de grands modèles

- 王林avant

- 2023-05-25 22:04:041722parcourir

Compilé | Li Shuiqing

edit | 心元

zhixixi Actualités du 19 mai. Le 18 mai, heure locale, Meta a publié une annonce sur son site officiel afin de faire face à la forte croissance de la demande de puissance de calcul de l'IA au cours des dix prochaines années, Meta exécute un grand projet. plan - spécialement conçu pour l'infrastructure de nouvelle génération.

Meta a annoncé ses derniers progrès dans la construction d'une infrastructure de nouvelle génération pour l'IA, y compris la première puce personnalisée pour exécuter des modèles d'IA, une nouvelle conception de centre de données optimisée pour l'IA, le premier ASIC de transcodage vidéo et un GPU intégré de 16 000 blocs, l'IA supercalculateur RSC pour accélérer la formation en IA, etc.

▲Divulgation par le site officiel de Meta des détails de l'infrastructure de l'IA

Meta considère l’IA comme l’infrastructure de base de l’entreprise. Depuis que Meta a lancé la construction de son premier centre de données en 2010, l'IA est devenue le moteur de plus de 3 milliards de personnes utilisant chaque jour la famille d'applications Meta. Du matériel Big Sur en 2015 au développement de PyTorch, en passant par le déploiement initial du supercalculateur d'IA de Meta l'année dernière, Meta continue actuellement de mettre à niveau et de faire évoluer ces infrastructures.

1. Accélérateur d'inférence IA de première génération de Meta, processus 7 nm, puissance de calcul 102,4TOPS

MTIA (Meta Training and Inference Accelerator) est la première série de puces accélératrices personnalisées internes de Meta pour les charges de travail d'inférence.

Les charges de travailIA sont omniprésentes dans les activités de Meta et constituent la base d'un large éventail de projets d'application, notamment la compréhension du contenu, le flux d'informations, l'IA générative et le classement des annonces. À mesure que la taille et la complexité des modèles d’IA augmentent, les systèmes matériels sous-jacents doivent fournir une augmentation exponentielle de la mémoire et des calculs tout en maintenant l’efficacité. Cependant, Meta a constaté qu'il était difficile pour les processeurs de répondre aux exigences de niveau d'efficacité requises par son échelle. Elle a donc conçu la série d'accélérateurs de formation et d'inférence auto-développée par Meta, la série MTIA ASIC, pour relever ce défi.

Depuis 2020, Meta a conçu le MTIA ASIC de première génération pour ses charges de travail internes. L'accélérateur utilise le processus 7 nm de TSMC, fonctionne à 800 MHz et fournit une puissance de calcul de 102,4TOPS avec une précision INT8 et une puissance de calcul de 51,2TFLOPS avec une précision FP16. Sa puissance thermique de conception (TDP) est de 25W.

Selon les rapports, le MTIA offre une puissance de calcul et une efficacité supérieures à celles du CPU. En déployant simultanément des puces MTIA et des GPU, il offrira de meilleures performances, une latence plus faible et une efficacité plus élevée pour chaque charge de travail.

2. Aménager le centre de données nouvelle génération et développer le premier ASIC de transcodage vidéo

La conception du centre de données de nouvelle génération de Meta prendra en charge ses produits actuels tout en prenant en charge la formation et l'inférence pour les futures générations de matériel d'IA. Ce nouveau centre de données sera optimisé pour l'IA, prenant en charge du matériel d'IA refroidi par liquide et un réseau d'IA haute performance connectant des milliers de puces d'IA pour des clusters de formation d'IA à l'échelle du centre de données.

Selon le site officiel, le centre de données de nouvelle génération de Meta sera également construit plus rapidement et de manière plus rentable, et sera complété par d'autres nouveaux matériels, tels que la première solution ASIC développée en interne par Meta, MSVP, conçue pour prendre en charge Croissance continue des charges de travail vidéo de Meta.

Avec l'émergence de nouveaux contenus technologiques tels que l'IA générative, la demande des gens en matière d'infrastructure vidéo s'est encore intensifiée, ce qui a incité Meta à lancer un processeur vidéo évolutif MSVP.

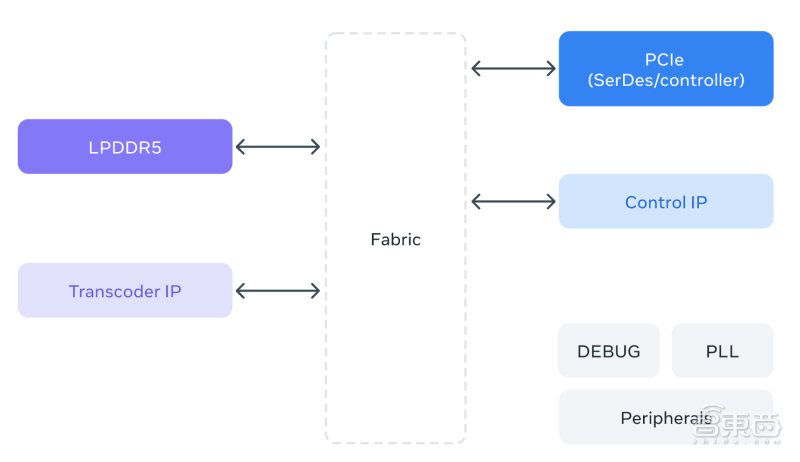

MSVP est le premier ASIC développé en interne par Meta pour le transcodage vidéo. MSVP est programmable et évolutif, et peut être configuré pour prendre en charge efficacement le transcodage de haute qualité requis pour la demande, ainsi que la faible latence et les temps de traitement plus rapides requis pour la diffusion en direct. À l'avenir, MSVP contribuera également à apporter de nouvelles formes de contenu vidéo à chaque membre de la famille d'applications Meta, y compris le contenu généré par l'IA ainsi que le contenu VR (réalité virtuelle) et AR (réalité augmentée).

▲Schéma d'architecture MSVP

3. Le supercalcul IA intègre 16 000 GPU et prend en charge les grands modèles LLaMA pour accélérer les itérations de formation

Selon l'annonce de Meta, son AI Super Computer (RSC) est l'un des superordinateurs d'intelligence artificielle les plus rapides au monde. Il est conçu pour former la prochaine génération de modèles d'IA à grande échelle et fournir de nouveaux outils de réalité augmentée et de compréhension du contenu. les systèmes et la technologie de traduction en temps réel, etc., fournissent de l’énergie.

Meta RSC comprend 16 000 GPU, tous accessibles via une structure de réseau Clos à trois niveaux, fournissant une bande passante complète à chacun des 2 000 systèmes de formation. Au cours de la dernière année, la RSC a fait la promotion de projets de recherche comme LLaMA.

LLaMA est un grand modèle de langage construit et open source par Meta plus tôt cette année, avec une échelle de 65 milliards de paramètres. Meta affirme que son objectif est de fournir un modèle plus petit et plus performant que les chercheurs peuvent étudier et affiner pour des tâches spécifiques sans avoir besoin de matériel important.

Meta a formé le LLaMA 65B et le plus petit LLaMA 33B sur la base de 1,4 billion de jetons. Son plus petit modèle, LLaMA 7B, utilise également mille milliards de jetons pour la formation. La capacité de fonctionner à grande échelle permet à Meta d'accélérer les itérations de formation et de réglage, publiant ainsi des modèles plus rapidement que les autres entreprises.

Conclusion : L'application de la technologie des grands modèles a contraint les grands fabricants à accélérer l'aménagement des infrastructures

Meta conçoit sur mesure la plupart de son infrastructure principalement parce que cela lui permet d'optimiser l'expérience de bout en bout, y compris de la couche physique à la couche logicielle en passant par l'expérience utilisateur réelle. La pile étant contrôlée de haut en bas, elle peut être personnalisée selon vos besoins spécifiques. Ces infrastructures aideront Meta à développer et à déployer des modèles d'IA plus grands et plus complexes.

Au cours des prochaines années, nous verrons une spécialisation et une personnalisation accrues dans la conception de puces, une infrastructure d'IA spécialisée et spécifique à la charge de travail, de nouveaux systèmes et outils, ainsi qu'une efficacité accrue dans le support produit et de conception. Ceux-ci fourniront des modèles et des produits de plus en plus sophistiqués, basés sur les dernières recherches, permettant aux utilisateurs du monde entier d'utiliser cette technologie émergente.

Source : Site officiel de Meta

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI