Maison >Périphériques technologiques >IA >Finale de la segmentation vidéo ! L'Université du Zhejiang a récemment publié SAM-Track : une segmentation vidéo intelligente universelle en un seul clic

Finale de la segmentation vidéo ! L'Université du Zhejiang a récemment publié SAM-Track : une segmentation vidéo intelligente universelle en un seul clic

- WBOYavant

- 2023-05-23 14:07:061435parcourir

Récemment, le laboratoire ReLER de l'université du Zhejiang a profondément combiné SAM avec la segmentation vidéo et a publié Segment-and-Track Anything (SAM-Track).

SAM-Track donne à SAM la possibilité de suivre des cibles vidéo et prend en charge plusieurs modes d'interaction (points, pinceaux, texte).

Sur cette base, SAM-Track unifie plusieurs tâches de segmentation vidéo traditionnelles, réalisant le suivi de segmentation en un clic de n'importe quelle cible dans n'importe quelle vidéo et segmentant les vidéos traditionnelles Extrapolation au général segmentation vidéo.

SAM-Track a d'excellentes performances et peut suivre de manière stable des centaines de cibles de haute qualité dans des scénarios complexes avec une seule carte.

Adresse du projet : https://github.com /z-x-yang/Segment-and-Track-Anything

Adresse papier : https://arxiv.org/abs/2305.06558

Affichage des effets

SAM-Track prend en charge la saisie de la langue en tant qu'invite. Par exemple, étant donné le texte de la catégorie « Panda », une segmentation en un clic au niveau de l'instance peut être utilisée pour suivre toutes les cibles appartenant à la catégorie « Panda ».

Vous pouvez également donner une description plus détaillée, par exemple en saisissant du texte " "Panda à l'extrême gauche", SAM-Track peut localiser des cibles spécifiques pour le suivi de segmentation.

Par rapport aux algorithmes de suivi vidéo traditionnels, SAM-Track est un autre La puissance est qu'il peut suivre et segmenter un grand nombre de cibles simultanément et détecter automatiquement les objets émergents. SAM-Track prend également en charge la combinaison de plusieurs méthodes interactives, les utilisateurs peuvent Correspondance selon les besoins réels. Par exemple, utilisez un pinceau pour encadrer une planche à roulettes étroitement liée au corps humain afin d'éviter la segmentation d'objets redondants, puis utilisez des clics pour sélectionner le corps humain.

La segmentation et le suivi entièrement automatiques des cibles vidéo sont naturellement un jeu d'enfant. Divers scénarios d'application incluent des vues de rue, des photographies aériennes, de la RA, des animations, des images médicales, etc., le tout avec. un clic. Suivi des segments et détection automatique des objets émergents.

Si vous n'êtes pas satisfait des résultats de la segmentation automatique, l'utilisateur peut Apportez des corrections d'édition, par exemple en utilisant des clics pour corriger un tramway trop segmenté.

En même temps, la dernière version de SAM-Track prend en charge en ligne En parcourant les résultats de suivi, vous pouvez sélectionner le résultat de segmentation de n'importe quelle image au milieu pour modifier et ajouter une cible, puis le suivre à nouveau.

Composition du modèle

Le modèle SAM-Track est basé sur le schéma de championnat à quatre pistes DeAOT de l'atelier ECCV'22 VOT.

DeAOT est un modèle VOS multi-objectif efficace étant donné l'annotation d'objet de la première image, il peut suivre et segmenter les objets dans les images restantes de la vidéo.

DeAOT utilise un mécanisme de reconnaissance pour intégrer plusieurs cibles dans une vidéo dans le même espace de grande dimension, réalisant ainsi le suivi simultané de plusieurs objets.

Les performances de vitesse de DeAOT dans le suivi multi-objets sont comparables à celles des autres méthodes VOS pour le suivi d'un seul objet.

De plus, grâce au mécanisme de propagation en couches basé sur Transformer, DeAOT agrège mieux les informations à long terme et à court terme, affichant d'excellentes performances de suivi.

Étant donné que DeAOT nécessite une annotation de cadre de référence pour l'initialisation, afin d'améliorer la commodité, SAM-Track utilise le Segment Anything Model (SAM), qui a récemment fait sensation dans le domaine de la segmentation d'images. ) modèle pour obtenir des informations d'annotation.

Grâce aux excellentes capacités de migration sans échantillon de SAM et à ses multiples méthodes d'interaction, SAM-Track peut obtenir efficacement des informations d'annotation de cadre de référence de haute qualité pour DeAOT.

Bien que le modèle SAM fonctionne bien dans le domaine de la segmentation d'images, il ne peut pas générer d'étiquettes sémantiques et les invites de texte ne peuvent pas bien prendre en charge la segmentation d'objets référents et d'autres méthodes qui s'appuient sur sémantique profonde. La tâche de compréhension.

Par conséquent, le modèle SAM-Track intègre davantage Grounding-DINO pour obtenir une segmentation vidéo guidée par le langage de haute précision. Grounding DINO est un modèle de détection d'objets ouvert avec de bonnes capacités de compréhension du langage.

En fonction de la catégorie d'entrée ou de la description détaillée de l'objet cible, Grounding-DINO peut détecter la cible et renvoyer la zone de localisation.

Architecture du modèle SAM-Track

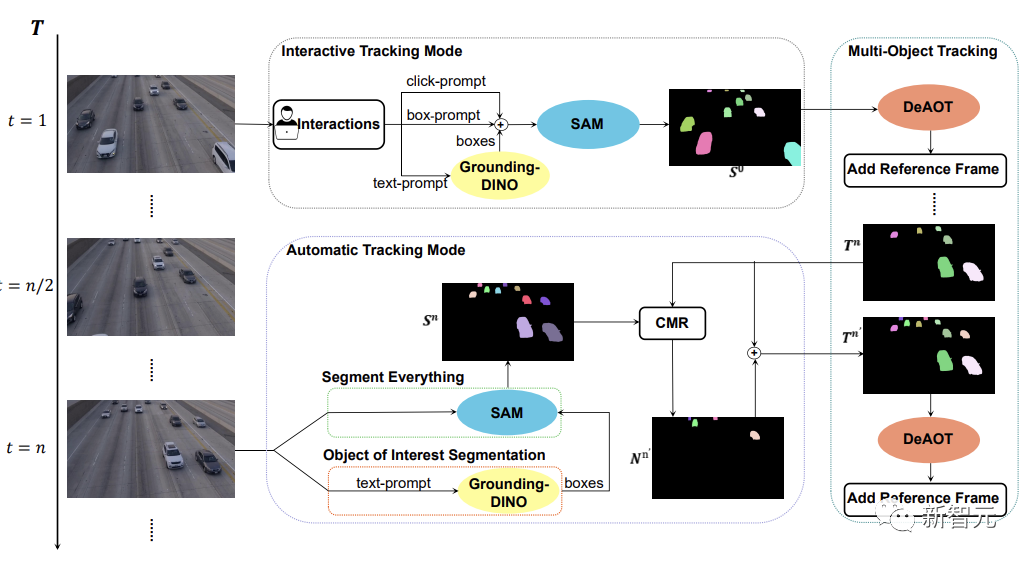

Comme le montre la figure ci-dessous, le modèle SAM-Track prend en charge trois modes de suivi d'objets, à savoir le suivi interactif mode, mode de suivi automatique et mode de fusion.

Pour le mode de suivi interactif, le modèle SAM-Track applique d'abord SAM, Sélectionnez la cible dans le cadre de référence en cliquant ou en dessinant un cadre jusqu'à ce qu'un résultat de segmentation interactive satisfaisant l'utilisateur soit obtenu.

Si vous souhaitez implémenter une segmentation d'objet vidéo guidée par le langage, SAM-Track appellera Grounding-DINO pour obtenir d'abord le cadre de position de l'objet cible en fonction de l'entrée texte, et sur cette base, le résultat de la segmentation de l'objet d'intérêt est obtenu via SAM.

Enfin, DeAOT utilise les résultats de la segmentation interactive comme cadre de référence pour suivre la cible sélectionnée. Au cours du processus de suivi, DeAOT propagera par couche l'intégration visuelle et l'intégration d'ID haute dimension dans les images passées vers l'image actuelle pour réaliser un suivi image par image et une segmentation de plusieurs objets cibles. Par conséquent, SAM-Track peut suivre les objets d'intérêt dans des vidéos segmentées en prenant en charge les interactions multimodales.

Cependant, le mode de suivi interactif ne peut pas gérer les objets nouvellement apparus apparaissant dans la vidéo. Limite l'application de SAM-Track dans des domaines spécifiques, tels que la conduite autonome, les villes intelligentes, etc.

Afin d'élargir davantage la portée de l'application et les performances de SAM-Track, SAM-Track implémente un mode de suivi automatique pour suivre les nouveaux objets apparaissant dans la vidéo.

Le mode de suivi automatique utilise Segment Everything et Object of Interest Segmentation pour obtenir des annotations de nouveaux objets apparaissant dans toutes les n images. Pour le problème d'attribution d'ID d'objets nouvellement émergents, SAM-Track utilise le module de masque de comparaison (CMR) pour déterminer l'ID du nouvel objet.

Le mode fusion combine le mode de suivi interactif et le mode de suivi automatique. Le mode de suivi interactif permet aux utilisateurs d'obtenir facilement des annotations pour la première image d'une vidéo, tandis que le mode de suivi automatique gère les nouveaux objets non sélectionnés qui apparaissent dans les images suivantes de la vidéo. La combinaison des méthodes de suivi élargit le champ d'application de SAM-Track et augmente la praticité de SAM-Track.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI