Maison >Périphériques technologiques >IA >Avec 3,6 billions de jetons et 340 milliards de paramètres, les détails du grand modèle PaLM 2 de Google ont été dévoilés.

Avec 3,6 billions de jetons et 340 milliards de paramètres, les détails du grand modèle PaLM 2 de Google ont été dévoilés.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-05-21 08:07:201007parcourir

Jeudi dernier, lors de la conférence Google I/O 2023, le PDG de Google, Pichai, a annoncé le lancement de PaLM 2, un grand modèle qui compare GPT-4, et a officiellement publié une version préliminaire, qui a amélioré les mathématiques, le code, le raisonnement et les fonctionnalités multiples. -capacités de traduction linguistique et de génération de langage naturel.

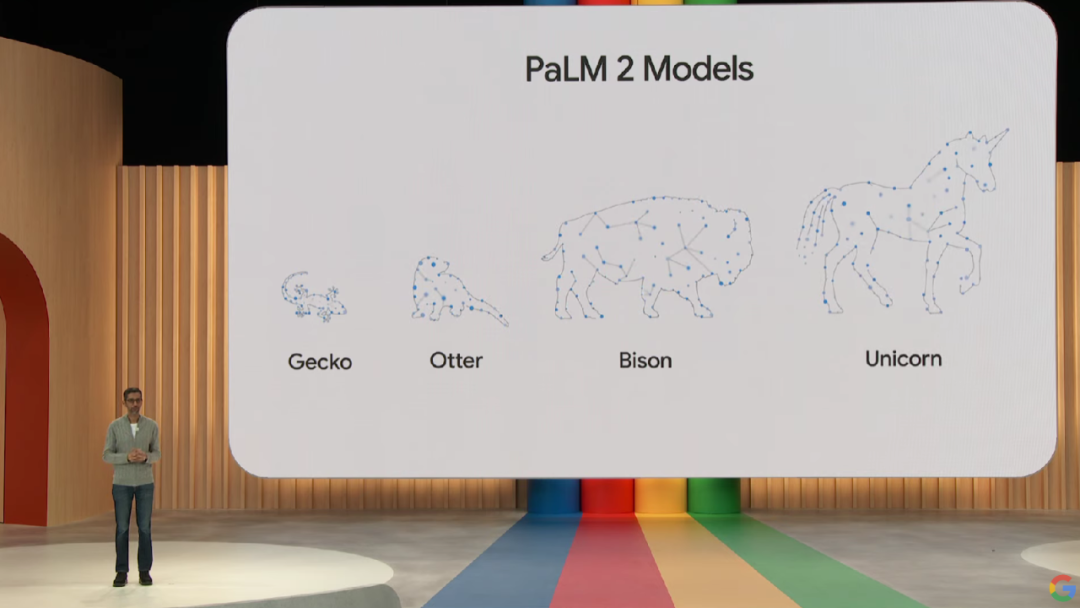

Le modèle PaLM 2 est disponible en quatre versions de tailles différentes, allant du petit au grand, Gecko, Otter, Bison et Unicorn, ce qui facilite son déploiement pour divers cas d'utilisation. Parmi eux, le modèle léger Gecko peut fonctionner très rapidement sur des appareils mobiles, et d'excellentes applications interactives peuvent être exécutées sur l'appareil sans être connecté à Internet.

Cependant, Google n'a pas donné de détails techniques spécifiques sur PaLM 2 lors de la réunion, déclarant seulement qu'il est construit sur les derniers JAX et TPU v4 de Google.

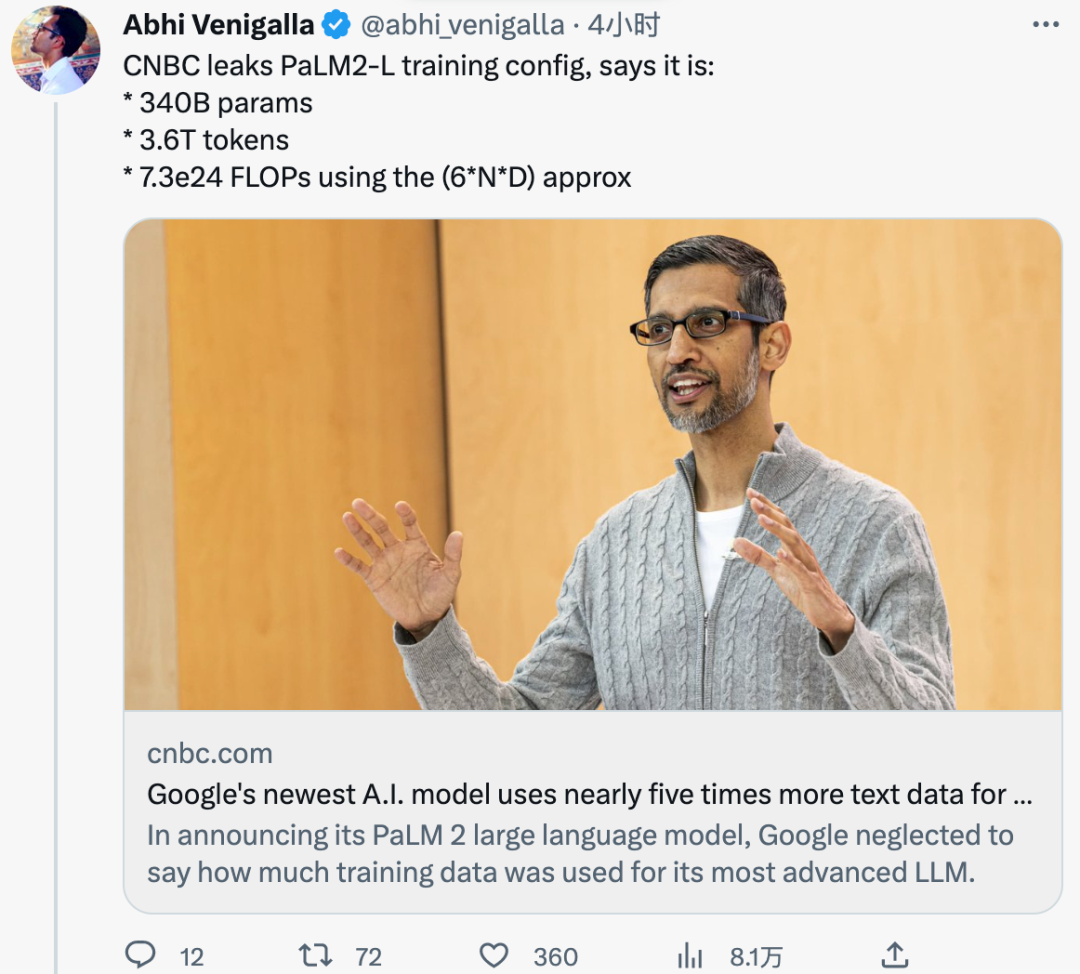

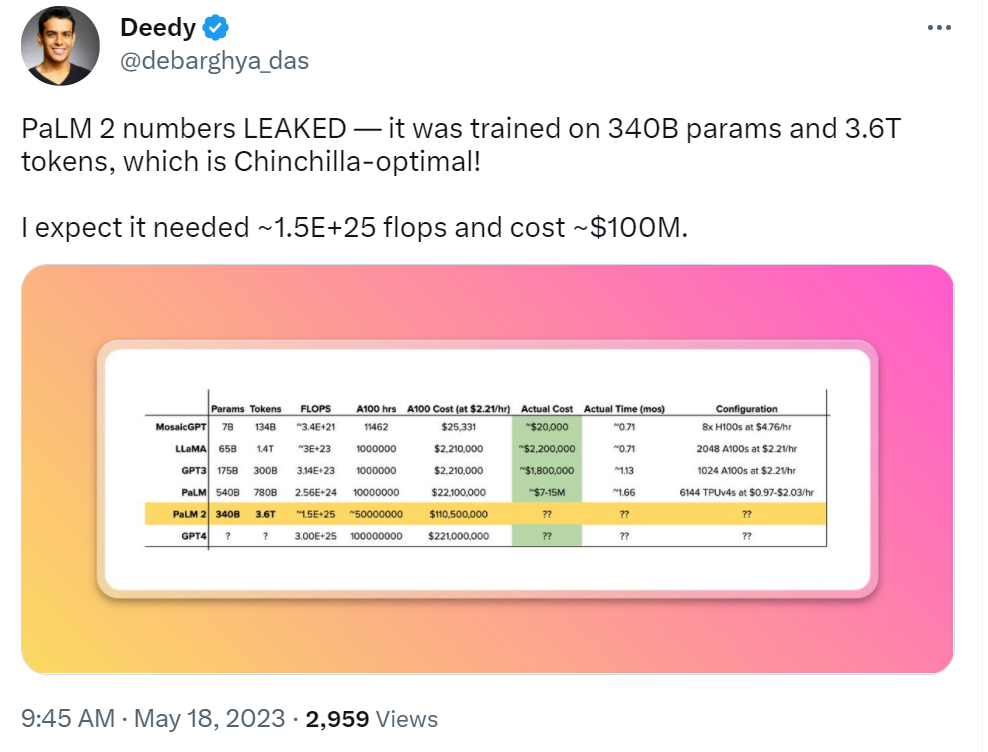

Hier, selon des documents internes consultés par le média étranger CNBC, PaLM 2 a été formé sur 3,6 billions de tokens. À titre de comparaison, la génération précédente de PaLM était formée sur 780 milliards de jetons.

De plus, Google a précédemment déclaré que PaLM 2 est plus petit que les LLM précédents, ce qui signifie qu'il peut devenir plus efficace tout en accomplissant des tâches plus complexes. Cela a également été vérifié dans des documents internes. La taille des paramètres d'entraînement de PaLM 2 est de 340 milliards, ce qui est bien inférieur aux 540 milliards de PaLM.

Comment les jetons de formation et les paramètres de PaLM 2 se comparent-ils à ceux des autres LLM ? À titre de comparaison, LLaMA, publié par Meta en février, a été formé sur 1 400 milliards de jetons. Le paramètre GPT-3 de 175 milliards d’OpenAI a été formé sur 300 milliards de jetons.

Alors que Google était impatient de démontrer la puissance de sa technologie d'IA et comment elle peut être intégrée dans la recherche, le courrier électronique, le traitement de documents et les feuilles de calcul, il s'est également montré réticent à divulguer la taille de ses données de formation ou d'autres détails. . En fait, Google n’est pas le seul à faire cela. OpenAI reste également silencieux sur les détails de son dernier grand modèle multimodal GPT-4. Ils ont tous déclaré que la non-divulgation des détails découlait de la nature concurrentielle de l'entreprise.

Cependant, alors que la course aux armements en matière d’IA continue de s’intensifier, la communauté des chercheurs exige de plus en plus de transparence. Et dans un document interne de Google divulgué il y a quelque temps, des chercheurs internes de Google ont exprimé ce point de vue : même si, à première vue, il semble qu'OpenAI et Google se poursuivent sur de grands modèles d'IA, le véritable gagnant ne viendra pas nécessairement de ces deux-là. à la maison, parce que la force tierce « open source » augmente tranquillement.

À l'heure actuelle, l'authenticité de ce document interne n'a pas été vérifiée et Google n'a pas commenté le contenu concerné.

Commentaires des internautes

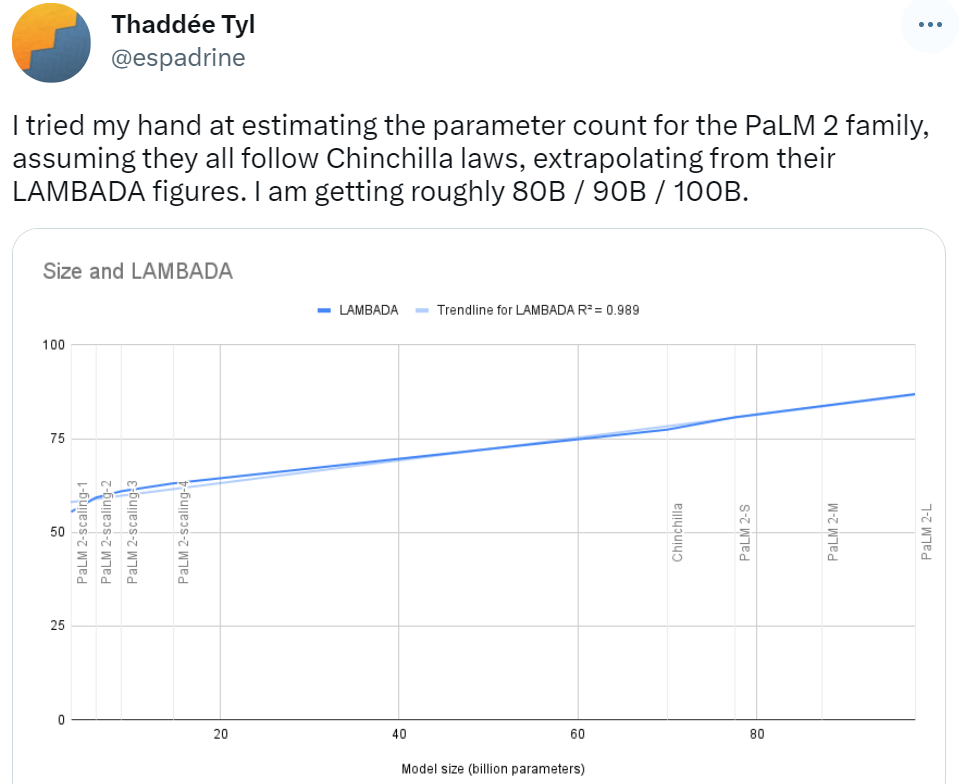

Au début de l'annonce officielle de PaLM 2, certains internautes ont prédit le montant de ses paramètres sur la base de la loi de Chinchilla. Ils ont prédit que les résultats des paramètres de la famille de modèles PaLM 2 seraient de 80B / 90B / 100B, ce qui est différent de ce qui a été révélé cette fois, le 340B est encore loin derrière.

Quelqu'un a également fait une vague de prédictions sur le coût de formation de PaLM 2. Sur la base du développement de grands modèles dans le passé, cet internaute a déclaré que la construction de PaLM 2 coûterait 100 millions de dollars américains.

Les paramètres de PaLM 2 ont été divulgués, vous pouvez essayer de deviner Bard, cet internaute a dit :

Avec la fuite du nombre de tokens PaLM 2, les internautes ne peuvent s'empêcher de se demander, combien de tokens faudra-t-il pour un grand tournant avant l'arrivée de l'AGI ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI