Maison >Périphériques technologiques >IA >Laissez ChatGPT appeler plus de 100 000 modèles d'IA open source ! La nouvelle fonctionnalité de HuggingFace est en plein essor : les grands modèles peuvent être facilement utilisés avec des outils d'IA multimodaux

Laissez ChatGPT appeler plus de 100 000 modèles d'IA open source ! La nouvelle fonctionnalité de HuggingFace est en plein essor : les grands modèles peuvent être facilement utilisés avec des outils d'IA multimodaux

- PHPzavant

- 2023-05-19 09:47:021791parcourir

Discutez simplement avec ChatGPT et cela vous aidera à appeler plus de 100 000 modèles HuggingFace !

Il s'agit de HuggingFace Transformers Agents, la dernière fonction lancée par HuggingFace, qui a fait l'objet d'une grande attention depuis son lancement :

Cette fonction équivaut à équiper de grands modèles tels que ChatGPT de capacités « multimodales »— —

Non limité au texte, mais toutes les tâches multimodales telles que les images, les voix, les documents, etc. peuvent être résolues.

Par exemple, vous pouvez faire une demande « décrire cette image » à ChatGPT et lui donner une photo d'un castor. En utilisant ChatGPT, vous pouvez appeler l'interpréteur d'image et afficher "Un castor nage"

Ensuite, ChatGPT appelle la synthèse vocale et vous pouvez lire cette phrase en quelques minutes :

Un castor nage dans le water Audio : 00:0000:01

Il prend non seulement en charge les modèles à grande échelle d'OpenAI, tels que ChatGPT, mais prend également en charge d'autres modèles gratuits à grande échelle, tels qu'OpenAssistant.

Transformer Agent est chargé d'"apprendre" à ces grands modèles à appeler directement n'importe quel modèle d'IA sur Hugging Face et à afficher les résultats traités.

Alors quel est le principe de cette nouvelle fonction ?

Comment laisser les grands modèles « commander » diverses IA ?

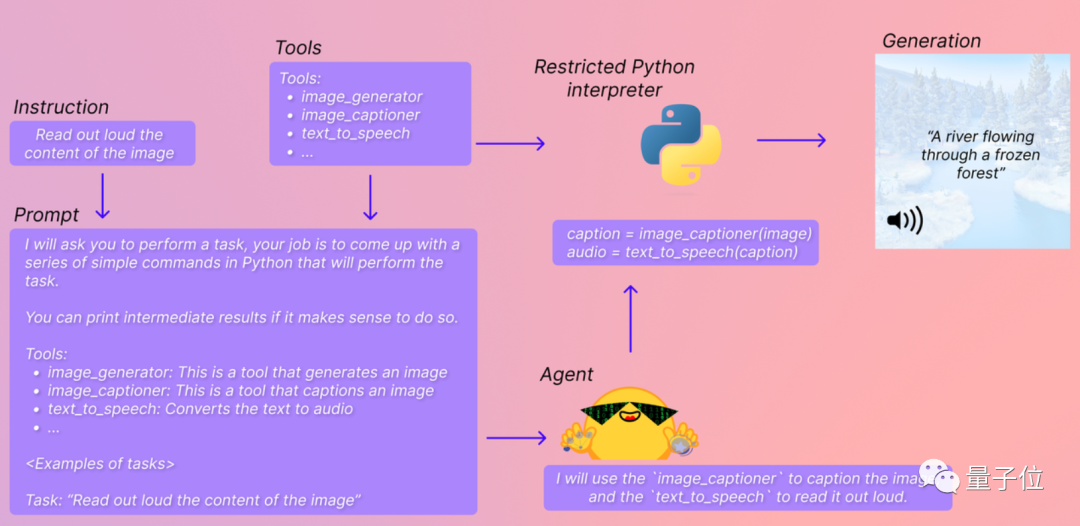

En termes simples, Transformers Agents est un « package d'intégration d'outils d'IA époustouflant » exclusif aux grands modèles.

Différents modèles d'IA, grands et petits, sur HuggingFace sont inclus dans ce package et classés en "générateur d'images", "interprète d'images", "outil de synthèse vocale"...

En même temps, chaque outil sera avoir une explication textuelle correspondante pour permettre aux grands modèles de comprendre quel modèle ils doivent appeler.

De cette façon, vous n'avez besoin que d'un simple code + mot d'invite, et le grand modèle peut vous aider à exécuter directement le modèle d'IA et à vous renvoyer les résultats de sortie en temps réel. en trois étapes :

Tout d'abord, configurez le grand modèle que vous souhaitez utiliser. Vous pouvez utiliser le grand modèle d'OpenAI ici (bien sûr, l'API est payante) :

<code>from transformers import OpenAiAgentagent = OpenAiAgent(model="text-davinci-003", api_key="<your_api_key>")</your_api_key></code>

Vous pouvez également utiliser des grands modèles gratuits tels que BigCode ou OpenAssistant. :

<code>from huggingface_hub import loginlogin("<your_token>")</your_token></code>

Ensuite, configurez les agents Hugging Transformers. Ici, nous prenons l'agent par défaut comme exemple :

<code>from transformers import HfAgent# Starcoderagent = HfAgent("https://api-inference.huggingface.co/models/bigcode/starcoder")# StarcoderBase# agent = HfAgent("https://api-inference.huggingface.co/models/bigcode/starcoderbase")# OpenAssistant# agent = HfAgent(url_endpoint="https://api-inference.huggingface.co/models/OpenAssistant/oasst-sft-4-pythia-12b-epoch-3.5")</code>

Ensuite, vous pouvez utiliser la commande run() ou chat() pour exécuter les agents Transformers.

run() convient pour appeler plusieurs modèles d'IA en même temps pour effectuer des tâches plus complexes et professionnelles.

Un seul outil d'IA peut être appelé.

Par exemple, si vous exécutez agent.run("Dessine-moi une image de rivières et de lacs."), il appellera l'outil graphique de l'IA pour vous aider à générer une image :

Vous pouvez appelez également plusieurs outils d'IA en même temps.

Par exemple, si vous exécutez agent.run ("Dessine-moi une image de la mer puis transforme l'image pour ajouter une île"), il appellera les outils "Wen Sheng Dia" et "Tu Sheng Dia" pour vous aider générer l'image correspondante :

chat() convient pour "accomplir des tâches en continu" via le chat.

Par exemple, appelez d'abord l'outil Agent Chat AI pour générer une image des rivières et des lacs : agent.chat("Générer une image des rivières et des lacs")

Ensuite, faites un "Togram Draw" basé sur sur cette photo Modification de l'image : agent.chat ("Transformez l'image pour qu'il y ait un rocher là-dedans")

Le modèle d'IA à appeler peut être défini par vous-même, ou vous pouvez utiliser l'ensemble des paramètres par défaut fournis avec Huohuan Face Setup est complet.

Un ensemble de modèles d'IA par défaut a été configuré

Actuellement, les agents Transformers ont intégré un ensemble de modèles d'IA par défaut, qui est complété en appelant les modèles d'IA suivants dans la bibliothèque Transformer :

1. Tant que vous fournissez un fichier au format image (y compris des images converties à partir de PDF), vous pouvez l'utiliser pour répondre à des questions sur le fichier.

Par exemple, si vous demandez « Où se tiendra la réunion du Comité consultatif scientifique du TRRF ? » Donut donnera la réponse :

2. Question-réponse texte modèle Flan-T5. À partir d'un long article et d'une question, il peut répondre à diverses questions textuelles et vous aider à comprendre en lecture.

3. Modèle de langage visuel Zero-shot BLIP. Il peut comprendre directement le contenu de l’image et fournir des descriptions textuelles pour l’image.

4. Modèle multimodal ViLT. Il peut comprendre et répondre aux questions dans une image donnée,

5. Modèle de segmentation d'image multimodale CLIPseg. Fournissez simplement un modèle et des mots d'invite, et le système peut segmenter le contenu spécifié (masque) dans l'image en fonction des mots d'invite.

6. Modèle de reconnaissance vocale automatique Whisper. Il peut reconnaître automatiquement le texte d'un enregistrement et compléter la transcription.

7. Modèle de synthèse vocale SpeechT5. pour la synthèse vocale.

8. Modèle de langage auto-codant BART. En plus de classer automatiquement un élément de contenu textuel, il peut également créer des résumés de texte.

9. Modèle de traduction en 200 langues NLLB. En plus des langues courantes, il peut également traduire certaines langues moins courantes, notamment le laotien et le kamba.

En appelant les modèles d'IA ci-dessus, des tâches telles que les questions et réponses sur les images, la compréhension des documents, la segmentation des images, l'enregistrement en texte, la traduction, le sous-titrage, la synthèse vocale et la classification de texte peuvent être effectuées.

De plus, Huo Hua Lian contient également des « biens privés », y compris certains modèles en dehors de la bibliothèque Transformer, notamment le téléchargement de texte, d'images de Vincent, d'images et de vidéos de Vincent à partir du Web :

Ces modèles peuvent non seulement être appelé individuellement, mais peut également être mélangé. Par exemple, si l'on demande au grand modèle de "générer et décrire une belle photo d'un castor", il appellera "Vincent Picture" et "Picture Understanding". Modèles d'IA respectivement.

Bien sûr, si nous ne souhaitons pas utiliser ces modèles d'IA par défaut et souhaitons mettre en place un « package d'intégration d'outils » plus utile, nous pouvons également le configurer nous-mêmes selon les étapes.

Pour les Agents Transformers, certains internautes ont également souligné que c'est un peu le "remplacement" des agents LangChain :

Avez-vous essayé ces deux outils ? Selon vous, lequel est le plus utile ?

Liens de référence : [1]https://twitter.com/huggingface/status/1656334778407297027[2]https://huggingface.co/docs/transformers/transformers_agents

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI