Maison >Périphériques technologiques >IA >GPT4ALL : la solution ultime de grand modèle de langage open source

GPT4ALL : la solution ultime de grand modèle de langage open source

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-05-17 11:02:312652parcourir

Il existe un écosystème croissant de modèles linguistiques open source qui fournit aux individus des ressources complètes pour créer des applications linguistiques à des fins de recherche et commerciales.

Cet article approfondit GPT4ALL, qui va au-delà des cas d'utilisation spécifiques en fournissant des éléments de base complets qui permettent à quiconque de développer des chatbots de type ChatGPT.

Qu'est-ce que le projet GPT4ALL ?

GPT4ALL peut fournir tout le support nécessaire lors de l'utilisation de grands modèles de langage open source de pointe. Il peut accéder à des modèles et des ensembles de données open source, les entraîner et les exécuter à l'aide du code fourni, interagir avec eux à l'aide d'une interface Web ou d'une application de bureau, se connecter au backend Langchain pour l'informatique distribuée et utiliser l'API Python pour une intégration facile.

Les développeurs ont récemment lancé le chatbot GPT4All-J sous licence Apache-2, qui est formé sur un corpus vaste et organisé d'interactions avec les assistants, notamment des questions de mots, des conversations à plusieurs tours, du code, de la poésie, des chansons et des histoires. Pour le rendre plus accessible, ils ont également publié des liaisons Python et une interface utilisateur de chat, permettant à presque tout le monde d'exécuter le modèle sur un processeur.

Vous pouvez l'essayer vous-même en installant un client de chat local sur votre bureau.

- Mac/OSX (https://gpt4all.io/installers/gpt4all-installer-darwin.dmg)

- Windows (https://gpt4all.io/installers/gpt4all-installer-win64.exe)

- Ubuntu (https://gpt4all.io/installers/gpt4all-installer-linux.run)

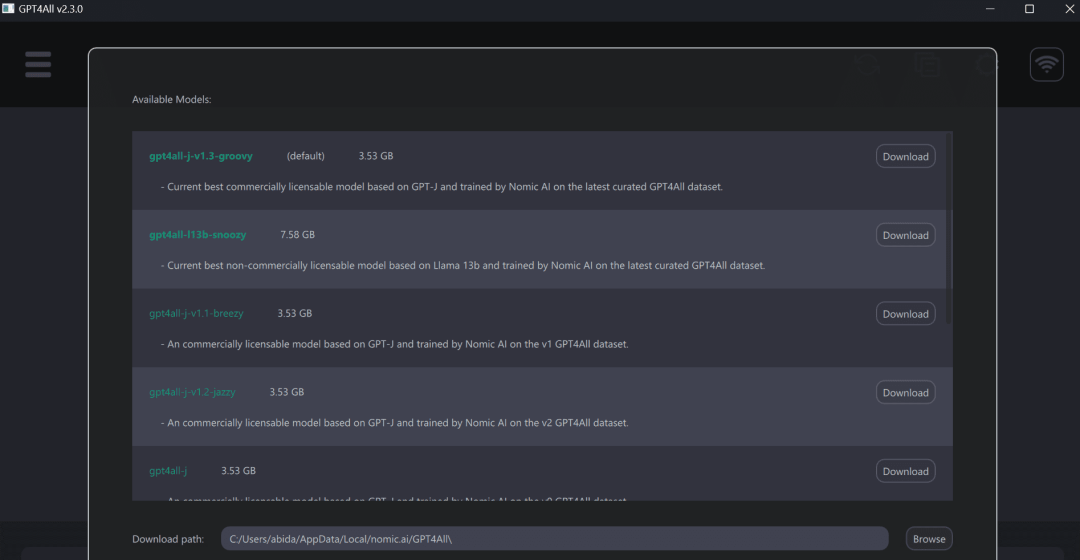

Après cela, exécutez le programme GPT4ALL et téléchargez le modèle de votre choix. Vous pouvez également télécharger manuellement le modèle ici (https://github.com/nomic-ai/gpt4all-chat#manual-download-of-models) et l'installer à l'emplacement indiqué par la boîte de dialogue de téléchargement du modèle dans l'interface graphique.

L'utilisation de GPT4ALL offre une meilleure expérience sur votre ordinateur portable, obtenant des réponses rapides et précises. Même les personnes non techniques peuvent facilement utiliser GPT4ALL car il est très convivial.

Client Python GPT4ALL

GPT4ALL possède Python, TypeScript, une interface Web Chat et un backend Langchain.

Dans cette section, nous examinerons l'API Python pour accéder aux modèles à l'aide de nomic-ai/pygpt4all.

- Utilisez PIP pour installer la bibliothèque Python GPT4ALL.

<code>pip install pygpt4all</code>

- Téléchargez le modèle GPT4All depuis http://gpt4all.io/models/ggml-gpt4all-l13b-snoozy.bin, également disponible ici (https://github.com/nomic-ai/gpt4all-chat# téléchargement manuel des modèles) pour parcourir d'autres modèles.

- Créez une fonction de rappel de texte, chargez le modèle et fournissez un indice à la fonction mode.generate() pour générer du texte. Consultez la documentation de la bibliothèque (https://nomic-ai.github.io/pygpt4all/) pour en savoir plus.

<code>from pygpt4all.models.gpt4all import GPT4Alldef new_text_callback(text):print(text, end="")model = GPT4All("./models/ggml-gpt4all-l13b-snoozy.bin")model.generate("Once upon a time, ", n_predict=55, new_text_callback=new_text_callback)</code>

De plus, les convertisseurs peuvent être utilisés pour télécharger et exécuter des inférences. Fournissez simplement le nom du modèle et la version. Les exemples de cet article accèdent au dernier modèle amélioré v1.3-groovy.

<code>from transformers import AutoModelForCausalLMmodel = AutoModelForCausalLM.from_pretrained("nomic-ai/gpt4all-j", revisinotallow="v1.3-groovy")</code>

Getting Started

Dans le référentiel nomic-ai/gpt4all, vous pouvez obtenir du code source, des poids de modèle, des ensembles de données et de la documentation pour la formation et l'inférence. Vous pouvez d'abord essayer certains modèles, puis les intégrer à l'aide du client Python ou de LangChain.

GPT4ALL nous fournit un point de contrôle du modèle GPT4All quantifié par le CPU. Pour y accéder il faut :

- Téléchargez le fichier gpt4all-lora-quantized.bin depuis Direct Link ou [Torrent-Magnet].

- Clonez cette bibliothèque de ressources et déplacez le fichier bin téléchargé vers le dossier de discussion.

- Exécutez la commande appropriée pour accéder au modèle :

- M1 Mac/OSX : cd chat;./gpt4all-lora-quantized-OSX-m1

Linux : cd chat;./gpt4all-lora-quantized-linux- x86

- Windows (PowerShell) : cd chat ;./gpt4all-lora-quantized-win64.exe

- Intel Mac/OSX : cd chat ;./gpt4all-lora-quantized-OSX-intel

Vous pouvez également vous rendre sur Hugging Face Spaces et essayer la démo de Gpt4all.

Photos de Gpt4all

资源:

- 技术报告:GPT4All-J : un chatbot de style assistant sous licence Apache-2(https://static.nomic.ai/gpt4all/2023_GPT4All-J_Technical_Report_2 .pdf)

- GitHub:nomic-ai/gpt4all(https://github.com/nomic-ai/gpt4all)

- API Python:nomic-ai/pygpt4all( https://github.com/nomic-ai/pygpt4all)

- 模型:nomic-ai/gpt4all-j(https://huggingface.co/nomic-ai/gpt4all-j)#🎜 🎜# 数据集:nomic-ai/gpt4all-j-prompt-Generations(https://huggingface.co/datasets/nomic-ai/gpt4all-j-prompt-Generations)

- #🎜🎜 #Hugging Face演示:Gpt4all(https://huggingface.co/spaces/Monster/GPT4ALL)

- ChatUI:nomic-ai/gpt4all-chat: gpt4all-j chat(https://github. com/nomic-ai/gpt4all-chat)

- GPT4ALL后端:GPT4ALL - ????LangChain 0.0.154(https://python.langchain.com/en/latest/modules/models /llms/integrations/gpt4all.html)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI