Maison >Périphériques technologiques >IA >Meta est un modèle d'intelligence artificielle multisensorielle open source qui intègre six types de données, notamment le texte, l'audio et la vision.

Meta est un modèle d'intelligence artificielle multisensorielle open source qui intègre six types de données, notamment le texte, l'audio et la vision.

- 王林avant

- 2023-05-16 09:43:051485parcourir

Meta Inc. a publié ImageBind, un nouveau modèle d'intelligence artificielle open source qui intègre plusieurs flux de données, notamment du texte, de l'audio, des données visuelles, des relevés de température et de mouvement, et bien plus encore. Le modèle n’est actuellement qu’un projet de recherche et n’a pas encore d’application directe auprès des consommateurs ou pratiques, mais il démontre les possibilités des futurs systèmes d’IA générative capables de créer des expériences immersives et multisensorielles. Dans le même temps, le modèle montre également l'attitude ouverte de Meta dans le domaine de la recherche sur l'intelligence artificielle, alors que ses concurrents tels qu'OpenAI et Google sont de plus en plus fermés.

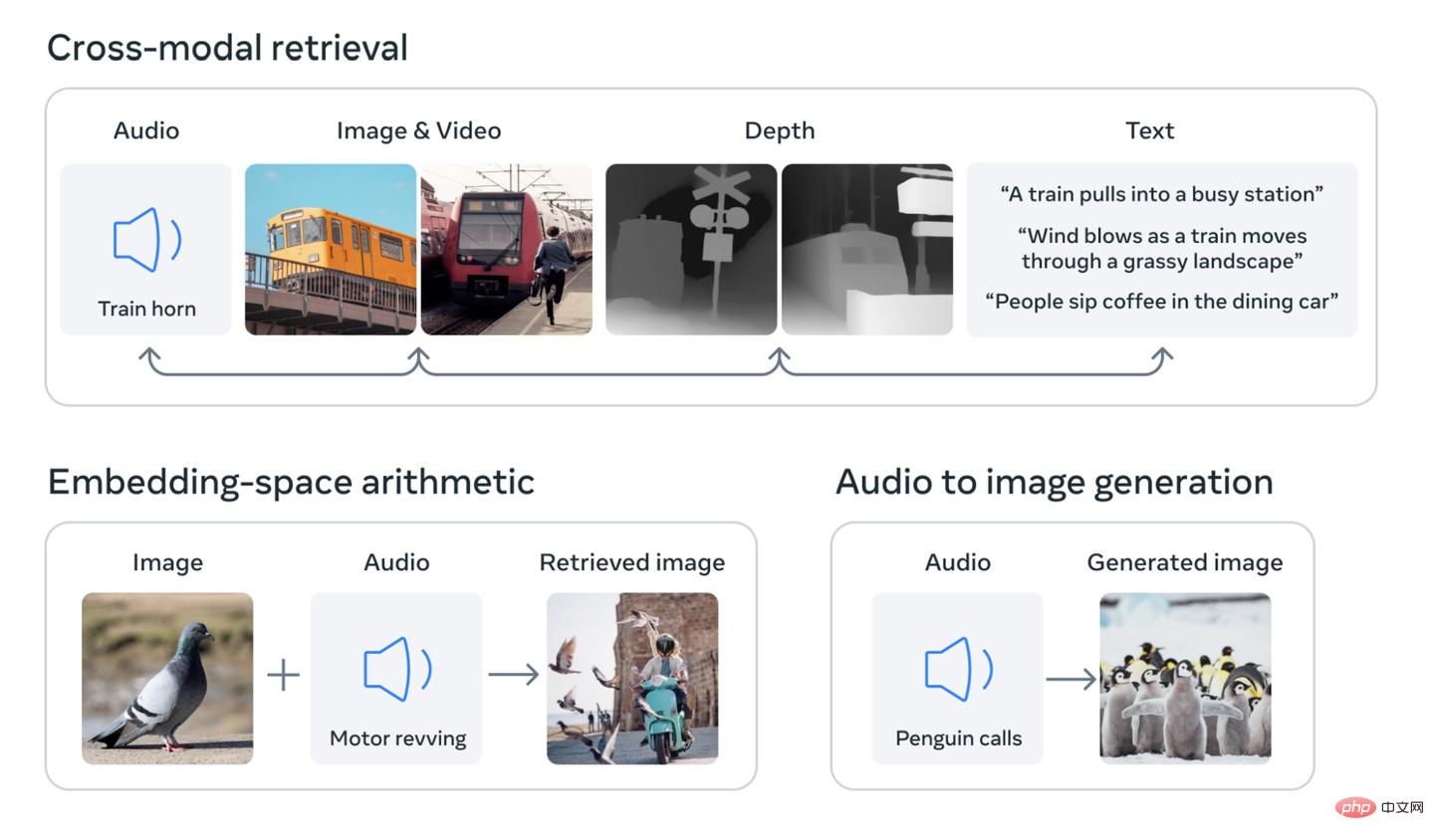

Le concept de base de la recherche est d'intégrer plusieurs types de données dans un index multidimensionnel (ou dans la terminologie de l'intelligence artificielle, « intégration de l'espace »). . Le concept est peut-être un peu abstrait, mais il est à la base du récent boom de l’intelligence artificielle générative. Par exemple, les générateurs d'images d'IA tels que DALL-E, Stable Diffusion et Midjourney s'appuient sur des systèmes qui relient le texte et les images pendant la phase de formation. Ils recherchent des modèles dans les données visuelles tout en reliant ces informations à la description de l'image. C'est pourquoi ces systèmes sont capables de générer des images basées sur la saisie de texte de l'utilisateur. Il en va de même pour de nombreux outils d’IA capables de générer de la vidéo ou de l’audio de la même manière.

Meta affirme que son modèle ImageBind est le premier à intégrer six types de données dans un seul espace d'intégration. Les six types de données comprennent : visuelles (y compris les images et les vidéos) ; thermiques (images infrarouges) ; informations audio et, le plus intéressant de toutes, les lectures de mouvement produites par une unité de mesure inertielle (IMU) ; (Les IMU se trouvent dans les téléphones et les montres intelligentes et sont utilisées pour effectuer diverses tâches, allant du passage d'un téléphone du paysage au portrait à la distinction entre différents types de mouvements.)

Les futurs systèmes d'intelligence artificielle pourront pour croiser ces données comme les systèmes actuels de saisie de texte. Par exemple, imaginez un futur appareil de réalité virtuelle capable de générer non seulement des entrées audio et visuelles, mais également le mouvement de votre environnement et de votre plate-forme physique. Vous pouvez lui demander de simuler un long voyage en mer, et non seulement il vous mettra à bord d'un navire avec le bruit des vagues en arrière-plan, mais vous sentirez également les ponts se balancer sous vos pieds et la brise marine souffler.

Meta a noté dans un article de blog que les futurs modèles pourraient également ajouter d'autres flux d'entrée sensorielle, notamment "les signaux tactiles, vocaux, olfactifs et IRMf cérébraux". La société affirme également que cette recherche "rapproche les machines de la capacité humaine à apprendre simultanément, de manière globale et directe à partir de nombreuses formes d'informations différentes". les applications de cette recherche seront très limitées. L’année dernière, par exemple, la société Meta a présenté un modèle d’IA capable de générer des vidéos courtes et floues basées sur des descriptions textuelles. Des recherches comme ImageBind montrent comment les futures versions du système peuvent intégrer d'autres flux de données, comme la génération d'un son correspondant à la sortie vidéo.

Pour les observateurs de l'industrie, cette recherche est également intéressante, car IT House a remarqué que la société Meta a rendu open source le modèle sous-jacent, ce qui constitue une préoccupation croissante dans le domaine de la pratique de l'intelligence artificielle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI