Maison >Opération et maintenance >exploitation et maintenance Linux >Quelles sont les commandes nvidia-smi couramment utilisées sous Linux ?

Quelles sont les commandes nvidia-smi couramment utilisées sous Linux ?

- 王林avant

- 2023-05-12 08:34:273063parcourir

Introduction

nvidia-smi - Programme d'interface de gestion du système NVIDIA

nvidia smi (également connu sous le nom de NVSMI) pour nvidia Tesla de la série d'architectures Fermi et supérieures, Quadro Les appareils , GRID et GeForce offrent des capacités de surveillance et de gestion. Les appareils de la série GeForce Titan prennent en charge la plupart des fonctionnalités, avec des informations très limitées fournies pour le reste de la marque GeForce. NVSMI est un outil multiplateforme qui prend en charge toutes les distributions Linux prises en charge par les pilotes NVIDIA standard, ainsi que les versions 64 bits de Windows à partir de Windows Server 2008 R2.

✨nvidia-smi

NVIDIA System Management Interface (nvidia-smi) est un outil de ligne de commande basé sur la NVIDIA Management Library (NVML), conçu pour aider à la gestion et Surveiller les appareils GPU NVIDIA.

Cet utilitaire permet aux administrateurs d'interroger l'état du périphérique GPU et permet aux administrateurs de modifier l'état du périphérique GPU avec les autorisations appropriées. Il cible les produits Tesla, GRID, Quadro et Titan X, mais d'autres GPU NVIDIA ont également une prise en charge limitée.

NVIDIA-smi est livré avec le pilote d'affichage GPU NVIDIA sous Linux, ainsi que Windows Server 2008 R2 64 bits et Windows 7. Nvidia-smi peut rapporter les informations de requête sous forme de XML ou de texte brut lisible par l'homme vers une sortie standard ou un fichier.

✨Les commandes nvidia-smi couramment utilisées affichent toutes les informations du GPU

nvidia-smi

Actualiser les informations du GPU toutes les 1 seconde

nvidia-smi -l 1

Liste de tous les appareils GPU actuels

nvidia-smi -L

Afficher la vitesse d'horloge actuelle du GPU, la vitesse d'horloge par défaut et la vitesse d'horloge maximale possible#🎜🎜 #

nvidia-smi -q -d CLOCKPS : commande nvidia-smi Entrez directement la commande

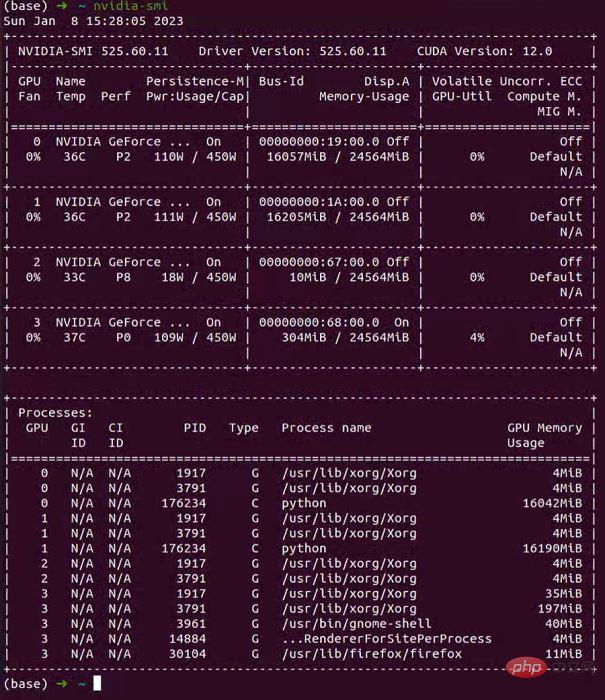

nvidia-smi sur la ligne de commande. La commande doit être utilisée. par tous les alchimistes. Une commande très familière.

nvidia-smi命令应该是各位炼丹师再熟悉不过的命令了。注意:建议使用

watch -n 0.5 nvidia-smiRemarque : Il est recommandé d'utiliserwatch -n 0.5 nvidia-smipour observer dynamiquement l'état du GPU.Grâce à la commande nvidia-smi, nous obtiendrons une page informative :

Mar 9 novembre 13:47:51 2021

+------------------------------------- ---------------------------------------------+

| NVIDIA-SMI 495.44 Version du pilote : 495.44 Version CUDA : 11.5 |

|-------------------------------+--- -------------------+----------------------+

| GPU Nom Persistance-M| Bus-Id Disp.A | Uncorr. volatile. CEC |

| Ventilateur Temp Perf Pwr:Utilisation/Cap| Utilisation de la mémoire | GPU-Util Compute M. |

| | | MIG M. |

|===============================+============ ==========+======================|

| 0 NVIDIA GeForce ... Désactivé | 00000000:17:00.0 Désactivé | N/A |

| 62 % 78 C P2 155 W / 170 W | 10 123 Mo/12 051 Mo | 100 % Par défaut |

| | | N/A |

+-------------------------------+------------ ----------+----------------------+

| 1 NVIDIA GeForce... Désactivé | 00000000:65:00.0 Désactivé | N/A |

|100% 92C P2 136W / 170W | 10 121 Mo/12 053 Mo | 99 % Par défaut |

| | | N/A |

+-------------------------------+------------ ----------+----------------------+

| 2 NVIDIA GeForce... Désactivé | 00000000:B5:00.0 Désactivé | N/A |

| 32% 34C P8 12W / 170W | 5 Mo / 12 053 Mo | 0% Par défaut |

| | | N/A |

+-------------------------------+------------ ----------+----------------------+

| 3 NVIDIA GeForce... Désactivé | 00000000:B6:00.0 Désactivé | N/A |

| 30 % 37C P8 13W / 170W | 5 Mo / 12 053 Mo | 0% Par défaut |

| | | N/A |

+-------------------------------+------------ ----------+----------------------++-----------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=============================================================================|

| 0 N/A N/A 1258 G /usr/lib/xorg/Xorg 6MiB |

| 0 N/A N/A 10426 C ...a3/envs/JJ_env/bin/python 10111MiB |

| 1 N/A N/A 1258 G /usr/lib/xorg/Xorg 4MiB |

| 1 N/A N/A 10427 C ...a3/envs/JJ_env/bin/python 10111MiB |

| 2 N/A N/A 1258 G /usr/lib/xorg/Xorg 4MiB |

| 3 N/A N/A 1258 G /usr/lib/xorg/Xorg 4MiB |

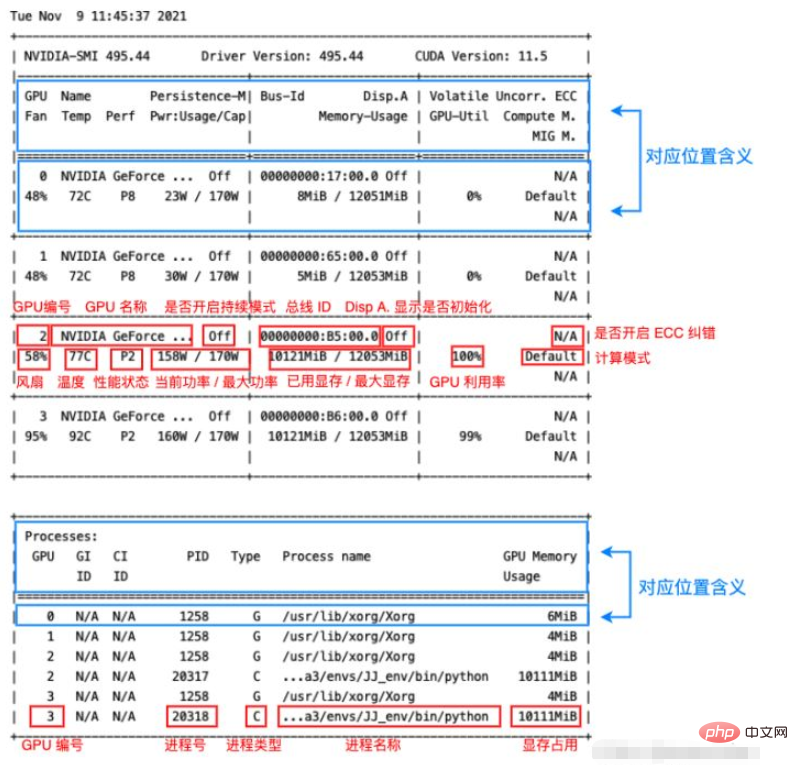

+-----------------------------------------------------------------------------+其中显存占用和 GPU 利用率当然是我们最常来查看的参数,但是在一些情况下(比如要重点监控 GPU 的散热情况时)其他参数也很有用,笔者简单总结了一下该命令输出的各个参数的含义如下图:

可以看到其中各个位置的对应含义在输出本身中其实都已经指出了(蓝框),红框则指出了输出各个部分的含义,大部分输出的作用一目了然,这里笔者将其中几个不那么直观的参数简单整理一下:

Fan:从0到100%之间变动,这个速度是计算机期望的风扇转速,实际情况下如果风扇堵转,可能打不到显示的转速。

Perf:是性能状态,从P0到P12,P0表示最大性能,P12表示状态最小性能。

Persistence-M:是持续模式的状态,持续模式虽然耗能大,但是在新的GPU应用启动时,花费的时间更少,这里显示的是off的状态。

Disp.A:Display Active,表示GPU的显示是否初始化。

Compute M:是计算模式。

Volatile Uncorr. ECC:是否开启 ECC 纠错。

type:进程类型。C 表示计算进程,G 表示图形进程,C+G 表示都有。

nvidia-smi 命令的其他参数

除了直接运行

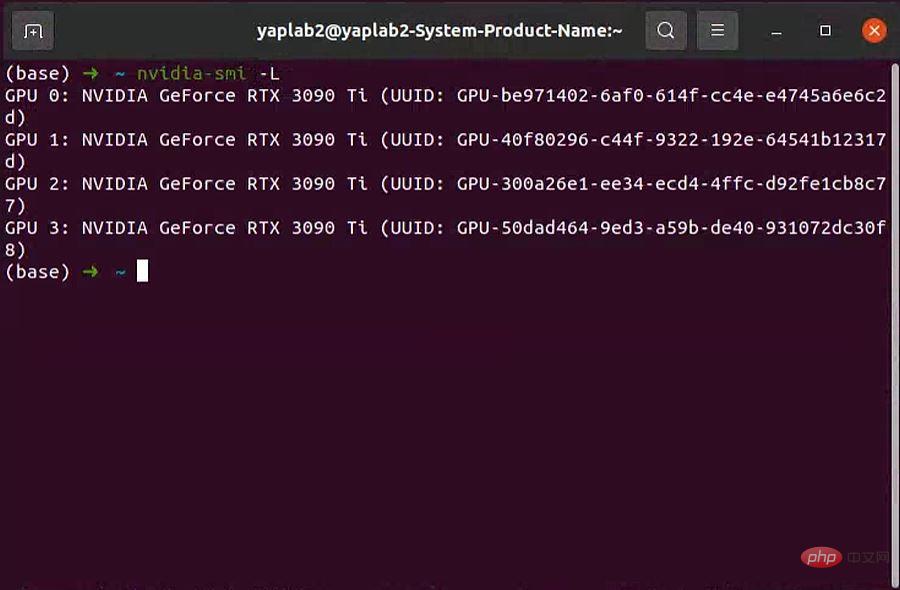

nvidia-smi命令之外,还可以加一些参数,来查看一些本机 Nvidia GPU 的其他一些状态。下面笔者简单介绍几个常用的参数,其他的有需要可以去手册中查找:man nvidia-smi。-L

-L参数显示连接到系统的 GPU 列表。nvidia-smi -L # 输出: GPU 0: NVIDIA GeForce RTX 3060 (UUID: GPU-55275dff-****-****-****-6408855fced9) GPU 1: NVIDIA GeForce RTX 3060 (UUID: GPU-0a1e7f37-****-****-****-df9a8bce6d6b) GPU 2: NVIDIA GeForce RTX 3060 (UUID: GPU-38e2771e-****-****-****-d5cbb85c58d8) GPU 3: NVIDIA GeForce RTX 3060 (UUID: GPU-8b45b004-****-****-****-46c05975a9f0)

GPU UUID:此值是GPU的全球唯一不可变字母数字标识符。它与主板上的物理标签无关。-i

-i参数指定某个 GPU,多用于查看 GPU 信息时指定其中一个 GPU。-q

-q参数查看 GPU 的全部信息。可通过-i参数指定查看某个 GPU 的参数。如:

nvidia-smi -i 0 -q输出太长了,笔者这里就不列了,大家可以自己试一下,是很完整的信息。

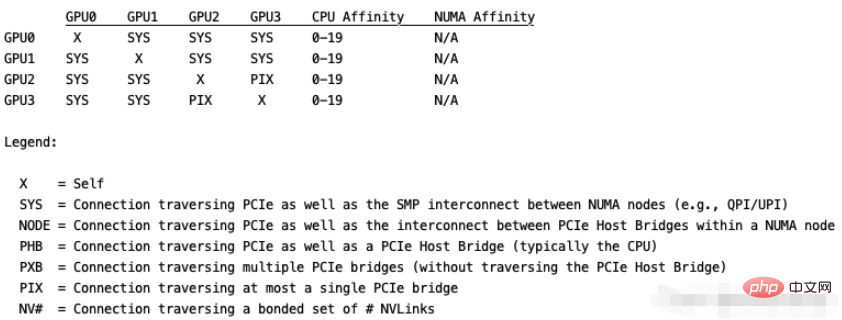

topo

topo展示多GPU系统的拓扑连接信息,通常配合-m参数即nvidia-smi topo -m,其他参数可自行查阅。输出如下,这里用代码块没法对齐,就直接贴图了:

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Apprenez à installer le serveur Nginx sous Linux

- Introduction détaillée à la commande wget de Linux

- Explication détaillée d'exemples d'utilisation de yum pour installer Nginx sous Linux

- Explication détaillée des problèmes de connexions des travailleurs dans Nginx

- Explication détaillée du processus d'installation de python3 sous Linux