Maison >Périphériques technologiques >IA >L'équipe de You Yang a obtenu de nouveaux résultats lors du AAAI 2023 Outstanding Paper Award, en utilisant un seul V100 pour entraîner le modèle 72 fois plus rapidement.

L'équipe de You Yang a obtenu de nouveaux résultats lors du AAAI 2023 Outstanding Paper Award, en utilisant un seul V100 pour entraîner le modèle 72 fois plus rapidement.

- 王林avant

- 2023-05-10 09:04:101139parcourir

Cet article est réimprimé avec l'autorisation d'AI New Media Qubit (ID de compte public : QbitAI). Veuillez contacter la source pour la réimpression.

Tout à l'heure, le Ph.D. de l'UC Berkeley et jeune professeur You Yang, président de l'Université nationale de Singapour, a publié la dernière nouvelle :

a remporté le AAAI 2023Outstanding Paper Award (Distinguished Paper) !

Les résultats de la recherche ont augmenté la vitesse d'entraînement du modèle de 72 fois en une seule fois.

Même les internautes ont exprimé leur émotion après avoir lu le journal :

De 12 heures à 10 minutes, vache tendre(toi vache)ah !

Le Dr You Yang a déjà établi le record du monde de vitesse d'entraînement ImageNet et BERT pendant ses études.

Les algorithmes qu'il a conçus sont également largement utilisés par des géants de la technologie tels que Google, Microsoft, Intel et NVIDIA.

Maintenant, il est retourné en Chine pour démarrer une entreprise Luchen TechnologyAprès un an et demi, quel type d'algorithme lui et son équipe ont-ils mis au point pour remporter un tel honneur lors de la plus haute conférence sur l'IA ?

Durée de formation de 12 heures à 10 minutes

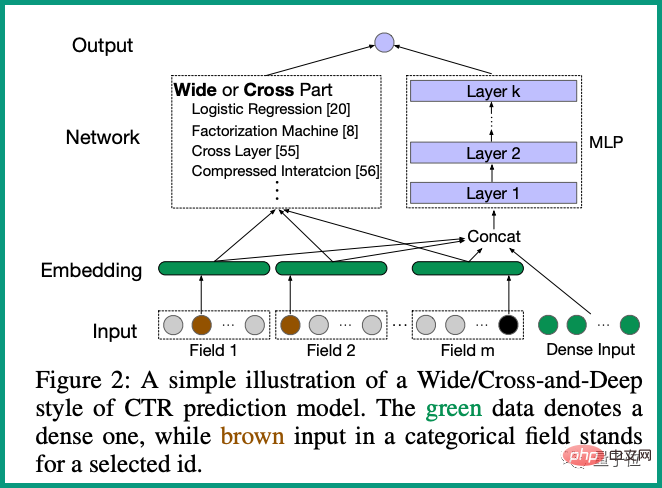

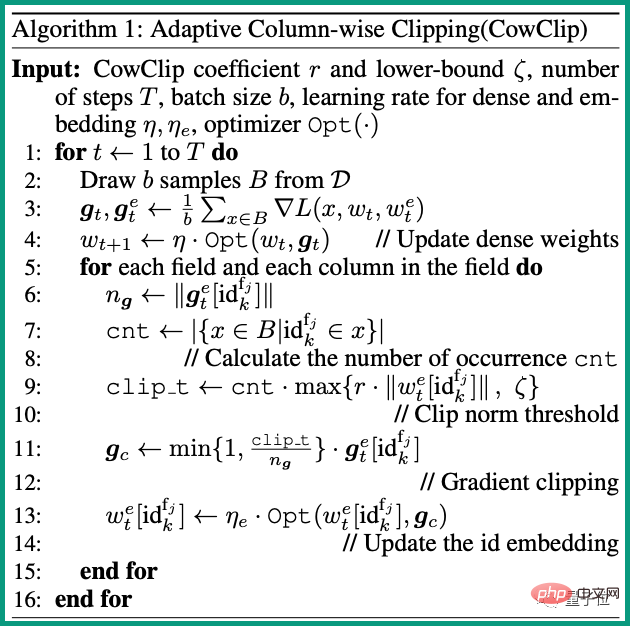

Dans cette étude, l'équipe de You Yang a proposé une stratégie d'optimisation CowClip, qui peut accélérer la formation en grands lots de modèles de prédiction CTR.

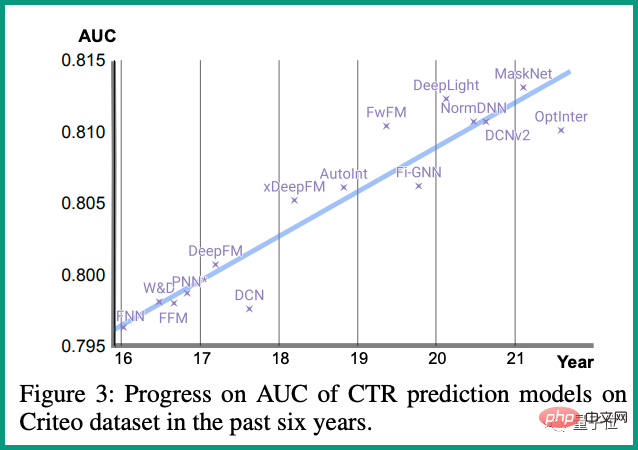

CTR(taux de clics)Le modèle de prédiction est un algorithme couramment utilisé dans les scénarios de recommandation personnalisés.

Il a généralement besoin d'apprendre les commentaires des utilisateurs (clics, collections, achats, etc.) , et la quantité de données générées en ligne chaque jour est sans précédent.

Il est donc crucial d'accélérer la formation des modèles de prédiction CTR.

De manière générale, la formation par lots est utilisée pour augmenter la vitesse d'entraînement. Cependant, si la taille du lot est trop grande, la précision du modèle sera réduite.

Grâce à une analyse mathématique, l'équipe a prouvé que le taux d'apprentissage des fonctionnalités peu fréquentes ne devrait pas être augmenté lors de l'expansion du lot.

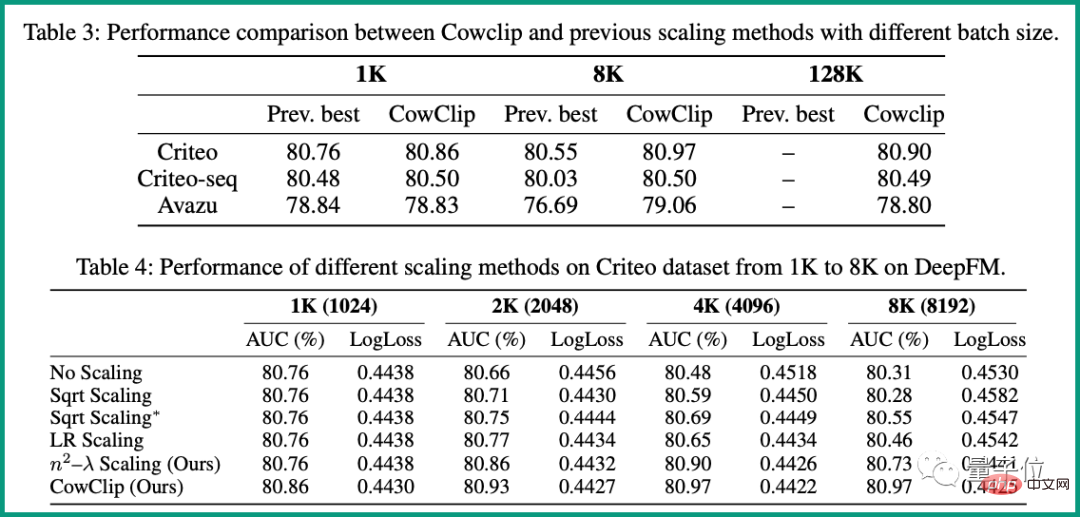

128 fois sans entraîner de perte de précision.

Surtout sur DeepFM, CowClip obtient une amélioration de plus de 0,1 % de l'AUC en augmentant la taille du lot de 1K à 128K. Et sur un seul GPU V100, le temps d'entraînement est réduit de 12 heures d'origine à seulement 10 minutes, et la vitesse d'entraînement est augmentée72 fois.

Zheng Changwei Il est diplômé de la classe Computer Elite de l'Université de Nanjing avec un baccalauréat et un doctorat de l'Université nationale de Singapour.

Ses axes de recherche incluent l'apprentissage automatique, la vision par ordinateur et le calcul haute performance.Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI