Maison >Périphériques technologiques >IA >Selon les règles officielles d'arXiv, l'utilisation d'outils comme ChatGPT en tant qu'auteur n'est pas autorisée

Selon les règles officielles d'arXiv, l'utilisation d'outils comme ChatGPT en tant qu'auteur n'est pas autorisée

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-05-09 22:34:16890parcourir

ChatGPT, cet outil de génération de texte récemment publié, a suscité de vives discussions au sein de la communauté des chercheurs. Il peut rédiger des essais d'étudiants, résumer des documents de recherche, répondre à des questions, générer du code informatique utilisable et est même assez bon pour réussir des examens médicaux, des examens de MBA, des examens judiciaires...

L'une des questions clés est la suivante : ChatGPT peut être recherche nommée L'auteur de l'article ?

Maintenant, la réponse officielle et claire d'arXiv, la plus grande plateforme de publication de prépublications au monde, est : « Non ».

L'IA n'a aucun droit de paternité

Avant ChatGPT, les chercheurs utilisaient depuis longtemps des chatbots comme assistants de recherche pour les aider à organiser leur réflexion, générer des commentaires sur leur propre travail, aider à rédiger du code et résumer la littérature de recherche.

Il semble que ces tâches auxiliaires puissent être reconnues, mais lorsqu'il s'agit de « signature », c'est une tout autre affaire. "De toute évidence, un programme informatique ne peut pas être responsable du contenu d'un article. Il ne peut pas non plus accepter les termes et conditions d'arXiv."

Il existe un certain nombre de prépublications et d'articles publiés qui ont officiellement attribué la paternité à ChatGPT. Pour résoudre ce problème, arXiv a adopté une nouvelle politique pour les auteurs concernant l'utilisation d'outils linguistiques d'IA génératifs.

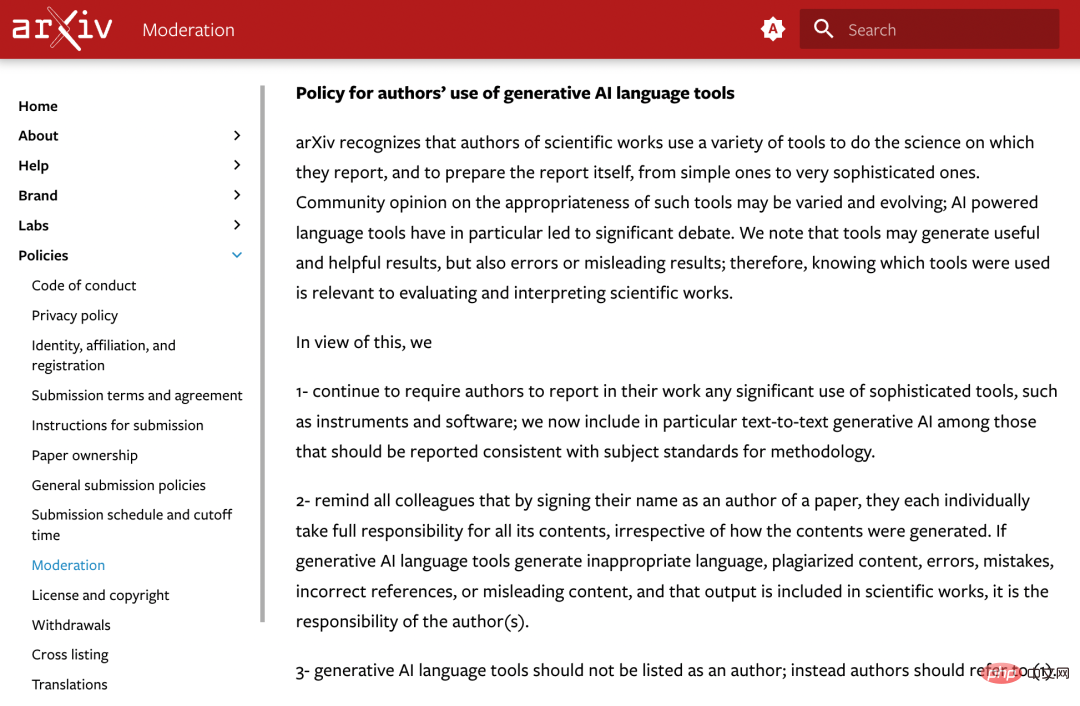

Le communiqué officiel est le suivant :

arXiv reconnaît que les travailleurs scientifiques utilisent une variété d'outils pour mener les travaux scientifiques sur lesquels ils rendent compte et pour préparer eux-mêmes les rapports, allant d'outils simples à des outils très complexes.

Les opinions de la communauté sur la pertinence de ces outils peuvent varier et évoluent constamment ; les outils linguistiques basés sur l'IA suscitent des débats clés. Nous notons que les outils peuvent produire des résultats utiles et utiles, mais peuvent également produire des résultats erronés ou trompeurs. Par conséquent, comprendre quels outils sont utilisés est pertinent pour évaluer et interpréter les travaux scientifiques ;

Sur cette base, arXiv a décidé de :

1. Continuer à exiger des auteurs qu'ils signalent l'utilisation de tout outil complexe, tel que des instruments et des logiciels, dans leur travail ; inclure spécifiquement le texte à texte « L'intelligence artificielle générative » est incluse parmi les outils déclarables qui répondent aux normes méthodologiques du sujet.

2. Rappelez à tous les collègues que tant qu'ils signent leur nom sur le journal, ils assument chacun l'entière responsabilité de tout le contenu du journal, quelle que soit la manière dont il a été produit. Si un outil linguistique d'IA générative produit un langage inapproprié, un contenu plagié, un contenu erroné, des références incorrectes ou un contenu trompeur, et que ce résultat est incorporé dans un travail scientifique, cela relève de la responsabilité de l'auteur.

3. Les outils linguistiques d'intelligence artificielle générative ne doivent pas être répertoriés comme auteurs, veuillez vous référer à 1.

La signification des « règles »

Il y a quelques jours, le magazine « Nature » a déclaré publiquement qu'il avait développé conjointement deux principes avec toutes les revues Springer Nature, et ces principes ont été ajoutés aux lignes directrices existantes des auteurs :

Tout d’abord, tout grand outil de modélisation linguistique ne sera pas accepté comme auteur nommé d’un article de recherche. En effet, toute paternité implique la responsabilité du travail et les outils d’IA ne peuvent pas assumer cette responsabilité.

Deuxièmement, les chercheurs utilisant de grands outils de modélisation linguistique devraient documenter cette utilisation dans la section Méthodes ou Remerciements. Si le document n'inclut pas ces sections, utilisez une introduction ou une autre section appropriée pour documenter l'utilisation de grands modèles de langage.

Ces réglementations sont très similaires aux derniers principes publiés par arXiv. Il semble que les organisations du domaine de l'édition académique soient parvenues à un certain consensus.

Bien que ChatGPT dispose de puissantes capacités, ses abus dans les devoirs scolaires, l'édition papier et d'autres domaines ont suscité une inquiétude généralisée.

La conférence sur l'apprentissage automatique ICML a déclaré : "ChatGPT est formé sur les données publiques, qui sont généralement collectées sans consentement, ce qui entraînera une série de problèmes d'attribution de responsabilité."

Par conséquent, la communauté universitaire a commencé à explorer des méthodes et des outils pour détecter le texte généré par de grands modèles de langage (LLM) tels que ChatGPT. À l’avenir, détecter si le contenu est généré par l’IA pourrait devenir « une partie importante du processus d’examen ».

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI