Maison >Périphériques technologiques >IA >AltDiffusion-m18, un outil polyvalent pour générer des textes et des images multilingues

AltDiffusion-m18, un outil polyvalent pour générer des textes et des images multilingues

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-05-07 18:37:081441parcourir

Actuellement, la sélection de modèles de génération de texte et d'images non anglais est limitée et les utilisateurs doivent souvent traduire l'invite en anglais avant de saisir le modèle. Cela entraînera non seulement une charge opérationnelle supplémentaire, mais également des erreurs linguistiques et culturelles dans le processus de traduction affecteront l'exactitude des images générées.

L'équipe FlagAI de l'Institut de recherche Zhiyuan a été pionnière d'une méthode de formation efficace, utilisant un modèle de pré-formation multilingue combiné à Stable Diffusion pour former un modèle de génération de texte et d'image multilingue - AltDiffusion-m18, qui prend en charge le texte et génération d'images en 18 langues.

Y compris le chinois, l'anglais, le japonais, le thaï, le coréen, l'hindi, l'ukrainien, l'arabe, le turc, le vietnamien, le polonais, le néerlandais, le portugais, l'italien, l'espagnol, l'allemand, le français et le russe.

Huggingface : https://huggingface.co/BAAI/AltDiffusion-m18

GitHub : https://github.com/FlagAI-Open/FlagAI/blob/master/examples/AltDiffusion-m18

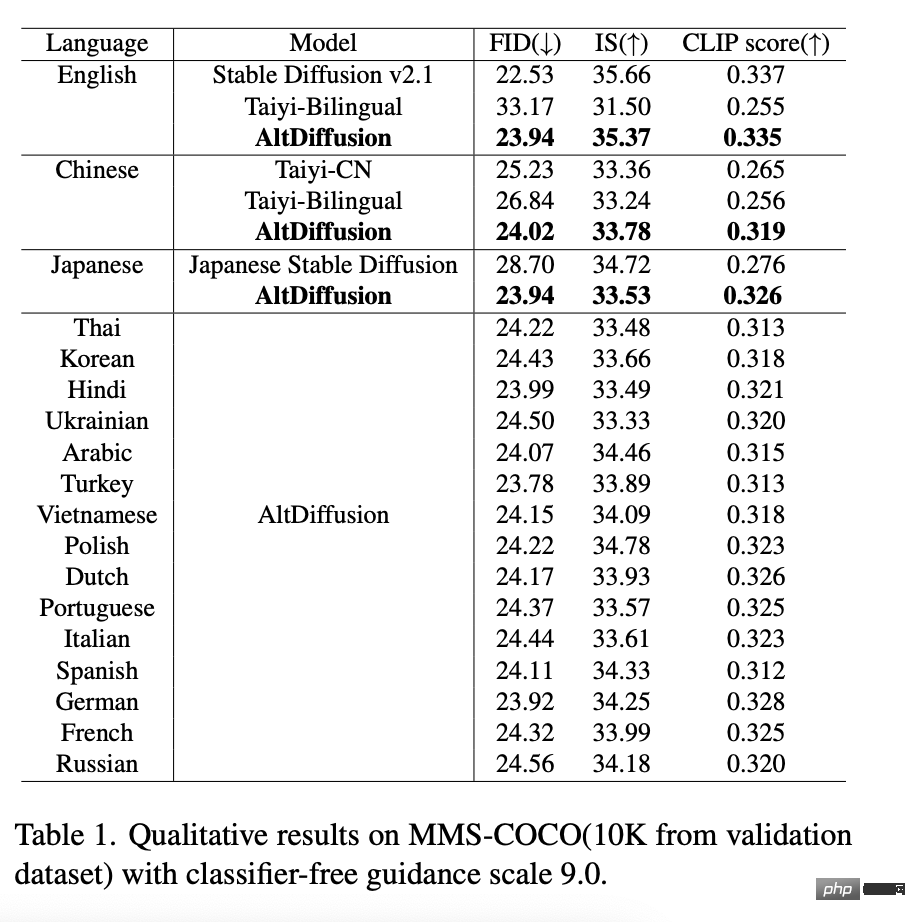

AltDiffusion-m18 dans L'évaluation objective des scores FID, IS et CLIP en anglais a atteint un effet de diffusion stable de 95 à 99 %, atteignant le niveau optimal en chinois et en japonais. En même temps, elle a comblé les lacunes des modèles de génération de texte et d'images. les 15 langues restantes, ce qui satisfait grandement aux besoins des utilisateurs. Il existe une forte demande dans l'industrie pour la génération de textes et de graphiques multilingues. Des remerciements particuliers vont à l’équipe de recherche sur la diffusion stable pour avoir fourni des conseils sur ce travail.

De plus, le rapport technologique innovant lié à AltDiffusion-m18 « AltCLIP : Altering the Language Encoder in CLIP for Extended Language Capabilities » a été accepté par les conclusions de l'ACL 2023.

Points forts techniques

1 Nouvel AltCLIP, construction efficace et peu coûteuse de modèles T2I multilingues

Dans AltDiffusion-m9 sorti l'année dernière, l'équipe Zhiyuan a remplacé de manière innovante la tour de langage basée sur Stable Diffusion v1. 4 AltCLIP pour la tour multilingue et affiné avec des données multilingues en neuf langues, étendant la diffusion stable originale uniquement en anglais pour prendre en charge neuf langues différentes.

AltCLIP : https://github.com/FlagAI-Open/FlagAI/tree/master/examples/AltCLIP-m18

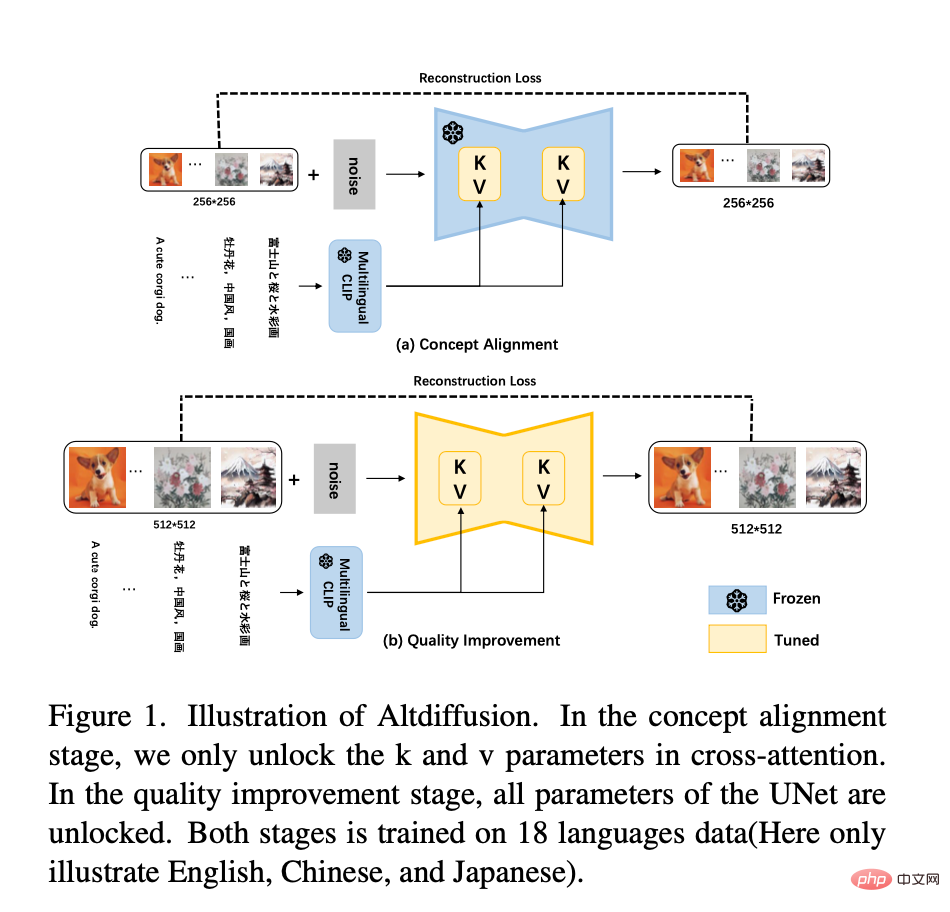

Et AltDiffusion-m18 est formé sur la base de Stable Diffusion v2.1. La nouvelle tour de langage de Stable Diffusion v2.1 est la deuxième couche inversée d'OpenCLIP. Par conséquent, le nouvel AltCLIP utilise la deuxième couche inversée d'OpenCLIP comme cible de distillation pour se recycler, et sur la base de m9, il n'utilisera que la couche CrossAttention K. et V dans Unet Le réglage fin est étendu à une méthode de formation en deux étapes, comme le montre la figure ci-dessous :

- Phase 1 : plus tôt au cours de l'expérience de m9, il a été découvert que le réglage fin des matrices Unet. Les matrices K et V apprennent principalement l'alignement des concepts du texte et des images. Par conséquent, la première étape de la formation m18 continue d'utiliser les données de 18 langues pour affiner les matrices K et V. De plus, des expériences ont prouvé que réduire la résolution d'une image de 512*512 à 256*256 ne fait pas perdre les informations sémantiques de l'image. Par conséquent, dans la première étape de l'apprentissage de l'alignement des concepts texte-image, la résolution de 256*256 est utilisée pour la formation, ce qui accélère la formation.

- La deuxième étape : Afin d'améliorer encore la qualité des images générées, utilisez la résolution de 512*512 pour entraîner tous les paramètres d'Unet dans les données de 18 langues. De plus, 10 % du texte est supprimé pour une formation inconditionnelle afin de servir à l'inférence de guidage sans classificateur.

- De plus, une technique de formation guidée sans classificateur est adoptée pour améliorer encore la qualité de la génération.

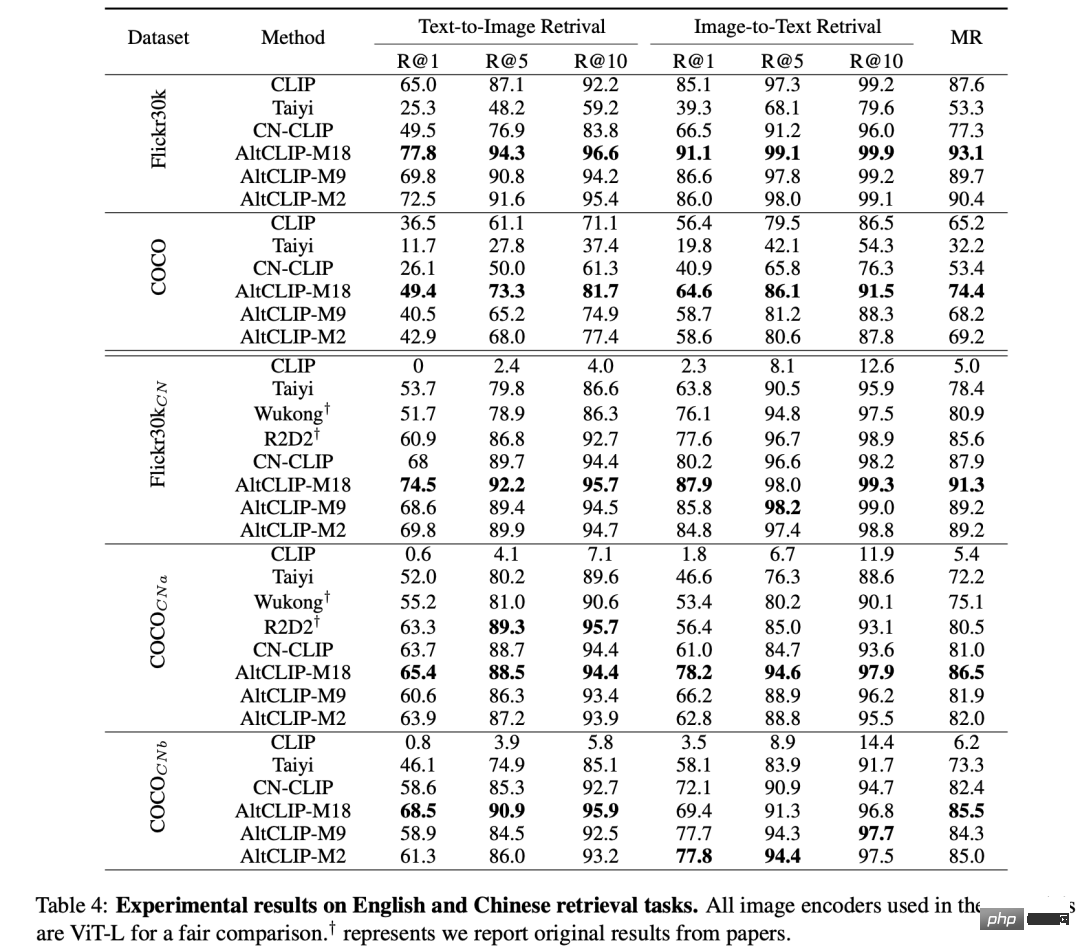

Les derniers résultats d'évaluation montrent qu'AltCLIP-m18 surpasse CLIP et atteint le niveau optimal dans les tâches de récupération zéro-shot (échantillon zéro) en chinois et en anglais ⬇️

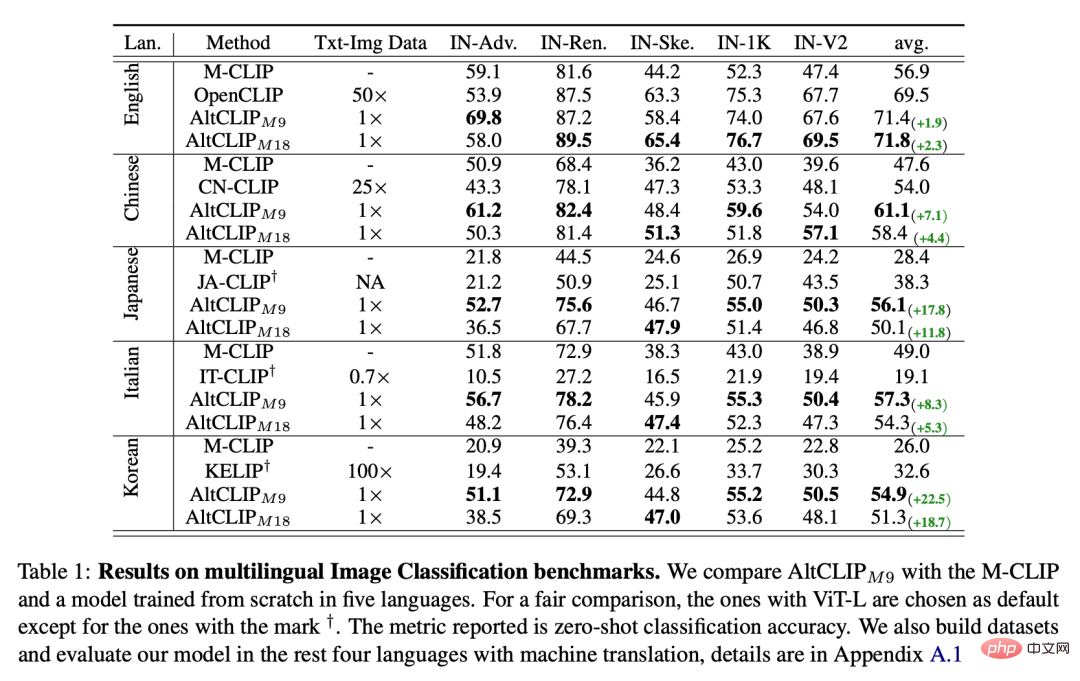

Sur les benchmarks de classification d'images multilingues, AltCLIP-m9 (premier version, prend en charge 9 langues) atteint le niveau optimal avec AltCLIP-m18 ⬇️

De même, grâce à l'idée innovante de changement de tour d'AltCLIP, AltDiffusion-m18 peut également accéder de manière transparente à Stable Diffusion, tous construits sur les modèles CLIP originaux et les outils écologiques , tous les outils prenant en charge Stable Diffusion tels que Stable Diffusion WebUI, DreamBooth, etc. peuvent être appliqués à AltDiffusion-m18. Une prise en main indolore et une grande jouabilité !

2 Les effets de génération multilingues sont alignés, avec des performances supérieures et des détails précis

Avec la bénédiction du nouveau AltCLIP, AltDiffusion-m18 a atteint 95 ~ 99 % de l'effet de diffusion stable d'origine en anglais FID, IS, évaluation du score CLIP et a obtenu les performances les plus avancées dans 17 langues, dont le chinois et le japonais, les données détaillées sont présentées dans le tableau suivant :

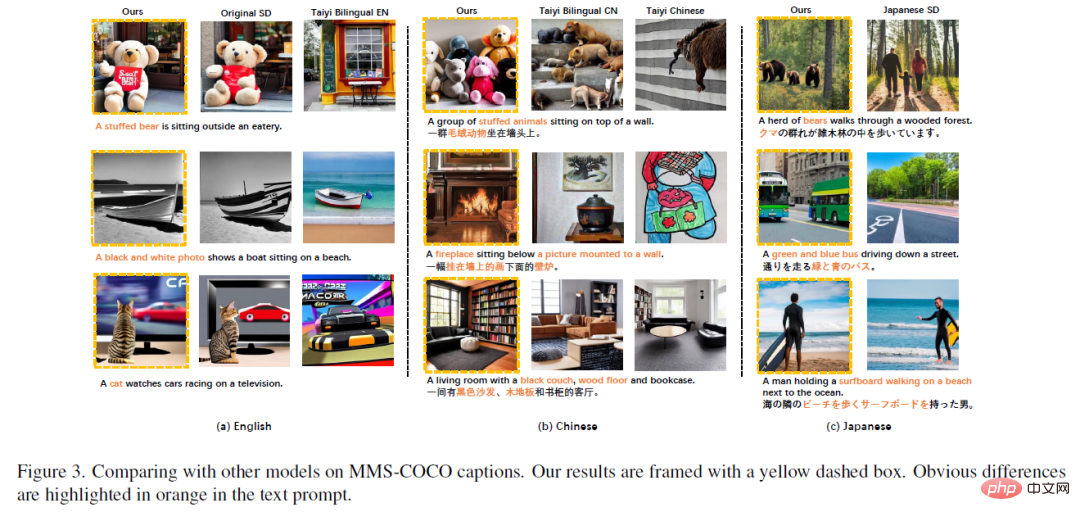

En anglais, chinois et japonais, AltDiffusion-m18 a des résultats supérieurs et des détails plus précis que les autres résultats de génération de modèles :

Image ci-dessus (a) chinois AltDiffusion-m18 peut générer des résultats très cohérents avec la diffusion stable originale et est supérieur aux autres modèles nationaux bilingues chinois-anglais en termes de compréhension rapide, tels que : "Un ours en peluche", "Une photo en noir et blanc", "un chat ", etc. Les concepts qui ne parviennent pas à être générés dans d'autres modèles bilingues chinois-anglais nationaux peuvent être générés avec succès dans AltDiffusion. Le même phénomène se produit en chinois et en japonais.

Le "canapé noir, parquet" en (b) ci-dessus n'est correctement généré que par AltDiffusion-m18.

"ours" dans (c) ci-dessus, Japanese Stable Diffusion génère incorrectement "humain", mais AltDiffusion-m18 peut générer correctement "ours".

De plus, l'équipe Zhiyuan FlagEval a développé l'outil d'évaluation de modèles de génération de texte et d'images ImageEval. Après évaluation, la précision d'AltDiffusion-m18 dans les dimensions de l'objet d'entité et de la quantité d'entité dépasse celle des modèles homologues nationaux de 11 % et 10 % respectivement (Remarque : la méthode d'évaluation et les résultats d'ImageEval seront rendus publics dans un avenir proche, alors restez accordé).

3 Le sauveur des textes et des images en petites langues, fournissant un système de référence pour les modèles de génération de textes et d'images multilingues

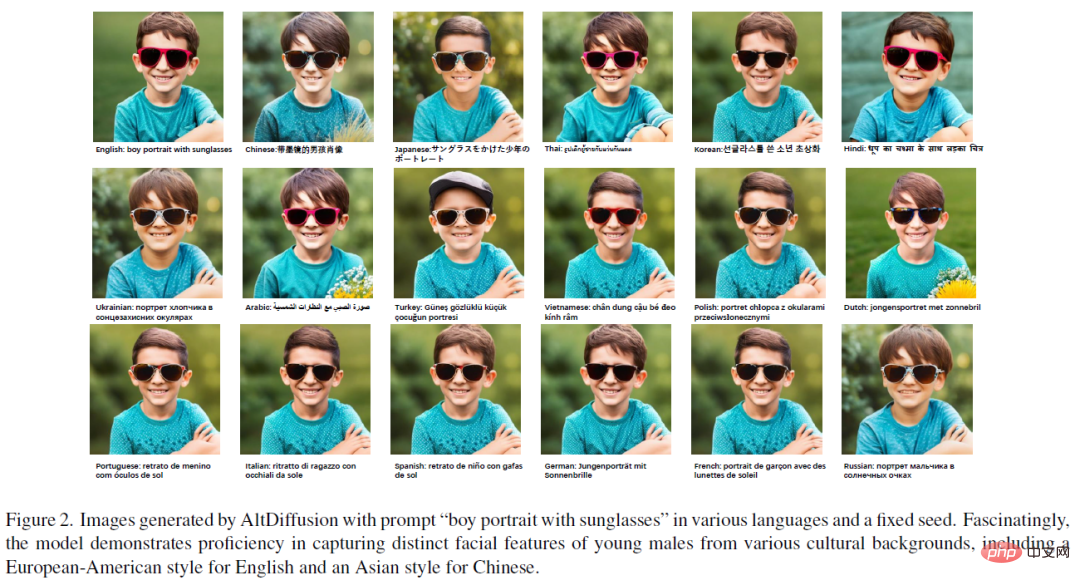

AltDiffusion-m18 apprend les préjugés de différentes langues à partir de données multilingues, aidant les utilisateurs à franchir le seuil de traduction linguistique et contourner la traduction culturelle. Réduit la perte d’informations culturelles derrière la langue. Comme le montre la figure ci-dessous, le contour du visage du petit garçon généré par les invites chinoises et japonaises est davantage de « style asiatique », tandis que le contour du visage du petit garçon généré par l'anglais et d'autres invites de langues européennes est davantage de « style européen et américain ».

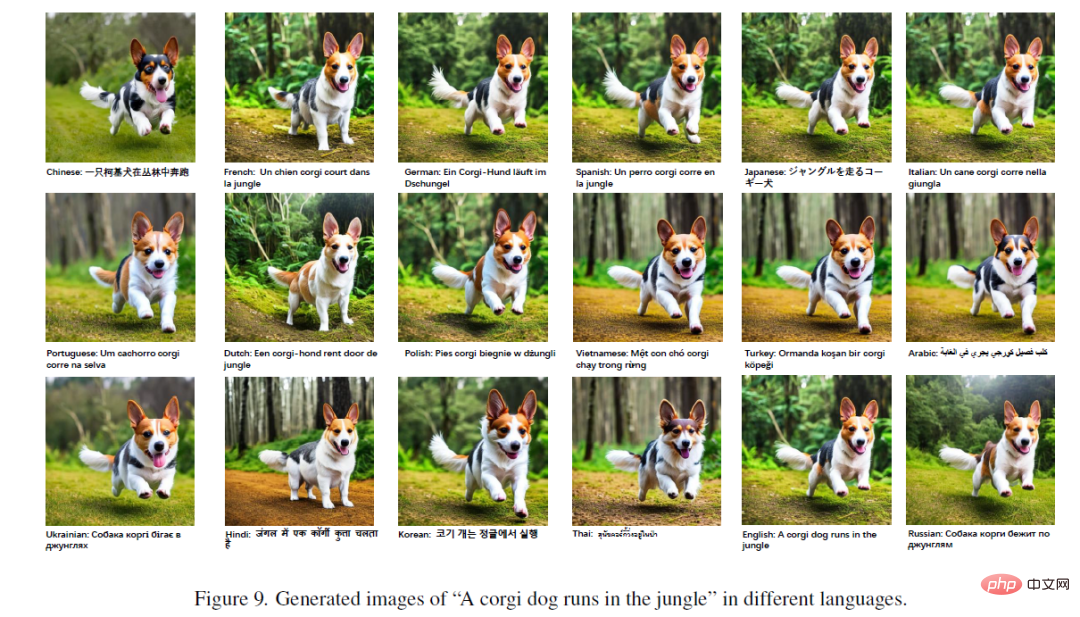

Ce qui est plus intéressant, c'est que les détails des images générées par les invites d'animaux dans différentes languessont également différents. Comme le montre la figure ci-dessous, bien que les images générées dans différentes langues soient globalement très cohérentes, il existe des différences subtiles dans l'arrière-plan de l'image et dans les détails des traits du visage de Corgi.

En général, AltDiffusion-m18 fournit un cadre de référence de base pour les modèles de génération de texte et d'images multilingues. Les utilisateurs dont les langues maternelles incluent l'espagnol, l'allemand et le français peuvent profiter du plaisir d'AIGC sans avoir à traduire les invites dans leur esprit en anglais. Les experts en formation en IA peuvent également optimiser davantage sur la base d'AltDiffusion-m18 en combinant DreamBooth, ControlNet et LoRA, ou utiliser le réglage fin du corpus dans d'autres langages pour obtenir de meilleurs effets de génération de texte et d'images.

Dans le même temps, FlagAI (github.com/FlagAI-Open/FlagAI), un projet open source unique pour les algorithmes, modèles et outils de grands modèles, fournit également des outils et des API pour l'inférence de formation, ce qui rend la tâche facile pour tout le monde. pour télécharger et utiliser rapidement AltDiffusion-m18.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI