Maison >Périphériques technologiques >IA >Meta lance un grand modèle open source polyvalent pour aider à faire un pas de plus vers l'unification visuelle

Meta lance un grand modèle open source polyvalent pour aider à faire un pas de plus vers l'unification visuelle

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-05-07 15:49:181264parcourir

Après l'open source du modèle SAM qui « divise tout », Meta va de plus en plus loin sur la voie du « modèle visuel de base ».

Cette fois, ils ont open source un ensemble de modèles appelé DINOv2. Ces modèles peuvent produire des représentations visuelles hautes performances qui peuvent être utilisées pour des tâches en aval telles que la classification, la segmentation, la récupération d'images et l'estimation de la profondeur sans réglage fin.

Cet ensemble de modèles présente les caractéristiques suivantes :

- est formé de manière auto-supervisée sans nécessiter une grande quantité de données étiquetées

- peut être utilisé ; comme presque n'importe quel CV L'épine dorsale des tâches qui ne nécessitent pas de réglage fin, telles que la classification d'images, la segmentation, la récupération d'images et l'estimation de la profondeur

- Apprenez les fonctionnalités directement à partir des images sans vous fier aux descriptions textuelles, ce qui permet au modèle de mieux s'améliorer ; comprendre les informations locales ;

- Peut apprendre de n'importe quelle collection d'images

- Une version pré-entraînée de DINOv2 est déjà disponible et est comparable à CLIP et OpenCLIP sur une gamme de tâches.

- Lien papier : https://arxiv.org/pdf/2304.07193.pdf

- Lien du projet : https://dinov2.metademolab.com/

Présentation de l'article

L'apprentissage de représentations pré-entraînées qui ne sont pas spécifiques à une tâche est devenue une norme dans le traitement du langage naturel. Vous pouvez utiliser ces fonctionnalités « telles quelles » (aucun réglage fin requis) et elles fonctionneront nettement mieux sur les tâches en aval que les modèles spécifiques à des tâches. Ce succès est dû à une pré-formation sur de grandes quantités de texte brut utilisant des objectifs auxiliaires, comme la modélisation du langage ou les vecteurs de mots, qui ne nécessitent pas de supervision.

Alors que ce changement de paradigme se produit dans le domaine de la PNL, on s'attend à ce que des modèles « de base » similaires apparaissent dans la vision par ordinateur. Ces modèles doivent générer des fonctionnalités visuelles qui fonctionnent « immédiatement » sur n'importe quelle tâche, que ce soit au niveau de l'image (par exemple, la classification d'images) ou au niveau des pixels (par exemple, la segmentation).

Ces modèles de base ont de grands espoirs de se concentrer sur la pré-formation guidée par texte, c'est-à-dire l'utilisation d'une forme de supervision de texte pour guider la formation des fonctionnalités. Cette forme de pré-formation guidée par texte limite les informations sur l'image qui peuvent être conservées, car la légende ne fait que se rapprocher des informations riches de l'image, et des informations plus fines et complexes au niveau des pixels peuvent ne pas être découvertes avec cette supervision. De plus, ces encodeurs d’images nécessitent des corpus texte-image déjà alignés et n’offrent pas la flexibilité de leurs homologues textuels, c’est-à-dire qu’ils ne peuvent pas apprendre uniquement à partir des données brutes.

Une alternative à la pré-formation guidée par texte est l'apprentissage auto-supervisé, où les fonctionnalités sont apprises uniquement à partir d'images. Ces méthodes sont conceptuellement plus proches des tâches frontales telles que la modélisation du langage et peuvent capturer des informations au niveau de l'image et du pixel. Cependant, malgré leur potentiel d'apprentissage de fonctionnalités générales, la plupart des améliorations en matière d'apprentissage auto-supervisé ont été réalisées dans le contexte d'une pré-formation sur le petit ensemble de données raffinées ImageNet1k. Certains chercheurs ont déployé des efforts pour étendre ces méthodes au-delà d'ImageNet-1k, mais ils se sont concentrés sur des ensembles de données non filtrés, ce qui a souvent entraîné une dégradation significative de la qualité des performances. Cela est dû à un manque de contrôle sur la qualité et la diversité des données, qui sont essentielles à l’obtention de bons résultats.

Dans ce travail, les chercheurs explorent si l'apprentissage auto-supervisé est possible pour apprendre des caractéristiques visuelles générales s'il est pré-entraîné sur une grande quantité de données raffinées. Ils revisitent les méthodes discriminantes auto-supervisées existantes qui apprennent des fonctionnalités au niveau des images et des correctifs, telles que iBOT, et reconsidèrent certains de leurs choix de conception dans des ensembles de données plus vastes. La plupart de nos contributions techniques sont conçues pour stabiliser et accélérer l'apprentissage auto-supervisé discriminant lors de la mise à l'échelle des tailles de modèles et de données. Ces améliorations ont rendu leur méthode environ 2 fois plus rapide et ont nécessité 1/3 de mémoire en moins que des méthodes discriminantes auto-supervisées similaires, leur permettant ainsi de profiter d'une formation plus longue et de lots plus grands.

Concernant les données de pré-formation, ils ont construit un pipeline automatisé pour filtrer et rééquilibrer l'ensemble de données à partir d'une large collection d'images non filtrées. Ceci s'inspire des pipelines utilisés en PNL, où la similarité des données est utilisée à la place des métadonnées externes et où l'annotation manuelle n'est pas requise. Une difficulté majeure lors du traitement d’images est de rééquilibrer les concepts et d’éviter le surajustement dans certains modes dominants. Dans ce travail, la méthode de regroupement naïf peut bien résoudre ce problème, et les chercheurs ont collecté un corpus petit mais diversifié composé de 142 millions d’images pour valider leur méthode.

Enfin, les chercheurs fournissent divers modèles de vision pré-entraînés, appelés DINOv2, sur leurs données en utilisant différentes architectures de transformateur visuel (ViT). Ils ont publié tous les modèles et codes pour recycler DINOv2 sur n'importe quelle donnée. Une fois étendus, ils ont validé la qualité de DINOv2 sur une variété de tests de vision par ordinateur au niveau de l'image et des pixels, comme le montre la figure 2. Nous concluons que la pré-formation auto-supervisée à elle seule est un bon candidat pour l'apprentissage de fonctionnalités gelées transférables, comparable aux meilleurs modèles faiblement supervisés disponibles publiquement.

Traitement des données

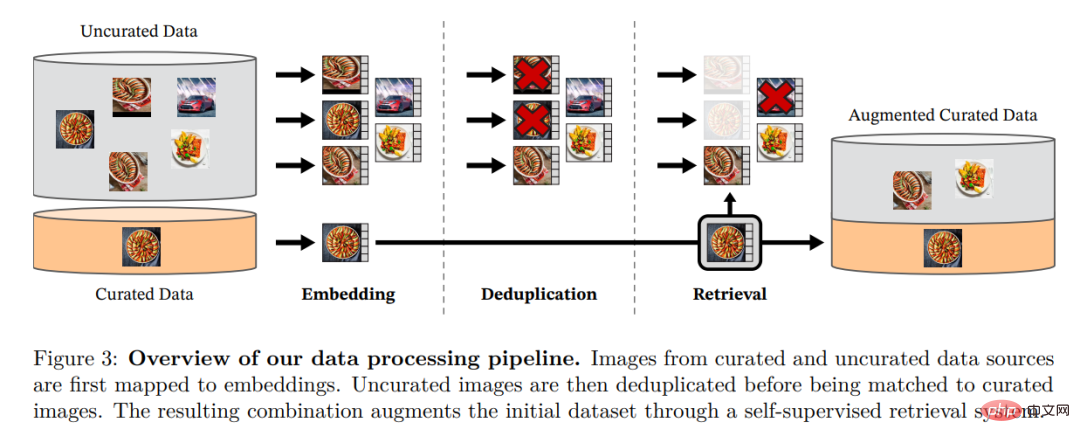

Les chercheurs ont récupéré des images à partir de grandes quantités de données non filtrées qui étaient proches des images dans plusieurs ensembles de données raffinés. -142 millions de données. Dans leur article, ils décrivent les principaux composants du pipeline de données, notamment les sources de données organisées/non filtrées, les étapes de déduplication d'images et les systèmes de récupération. L'ensemble du pipeline ne nécessite aucune métadonnée ni texte et traite directement les images, comme le montre la figure 3. Le lecteur est invité à consulter l'annexe A pour plus de détails sur la méthodologie du modèle. Figure 3 : Aperçu du pipeline de traitement des données. Les images provenant de sources de données raffinées et non raffinées sont d'abord mappées aux intégrations. L'image non raffinée est ensuite dédupliquée avant d'être mise en correspondance avec l'image standard. La combinaison résultante enrichit davantage l’ensemble de données initial grâce à un système de récupération auto-supervisé.

Pré-formation auto-supervisée discriminante

Pré-formation auto-supervisée discriminante

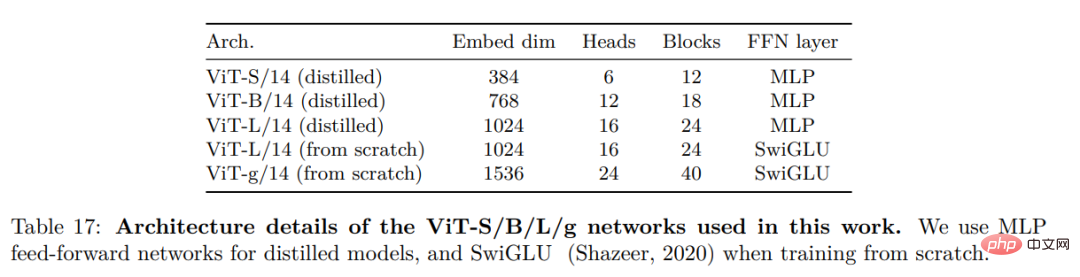

Les chercheurs apprennent grâce à une approche auto-supervisée discriminante Leurs caractéristiques , la méthode peut être vue comme une combinaison de pertes DINO et iBOT et centrée sur SwAV. Ils ont également ajouté un régulariseur pour propager les fonctionnalités et une brève phase de formation haute résolution. Ils ont envisagé plusieurs améliorations pour entraîner le modèle à plus grande échelle. Le modèle est entraîné sur un GPU A100 à l'aide de PyTorch 2.0, et le code peut également être utilisé avec un modèle pré-entraîné pour l'extraction de fonctionnalités. Les détails du modèle se trouvent dans le tableau 17 en annexe. Sur le même matériel, le code DINOv2 n'utilise que 1/3 de la mémoire et s'exécute 2 fois plus vite que l'implémentation iBOT.

Résultats expérimentaux

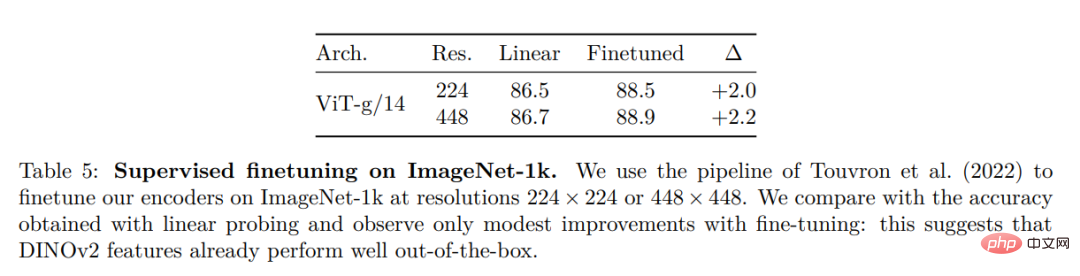

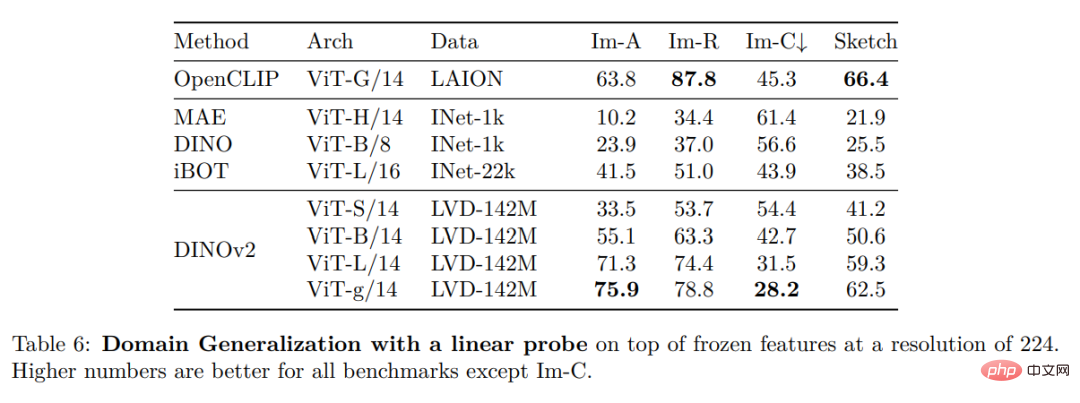

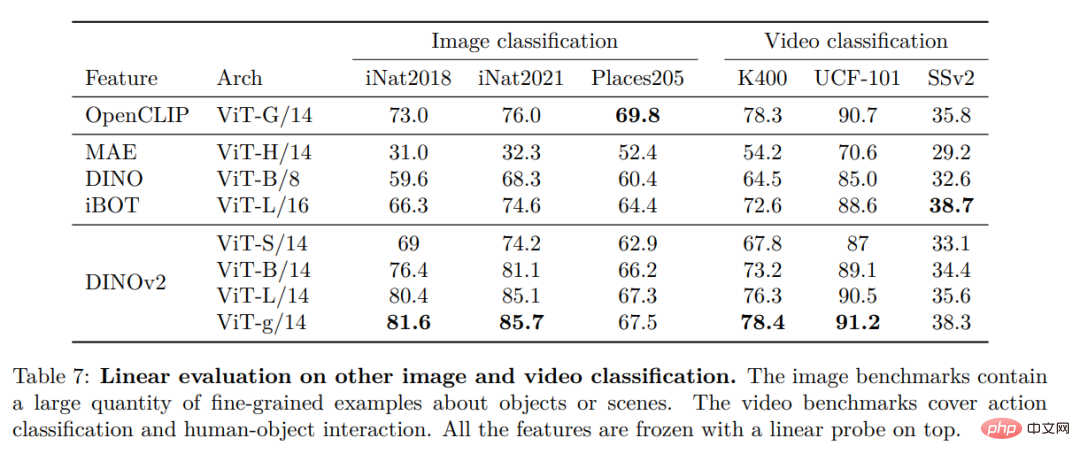

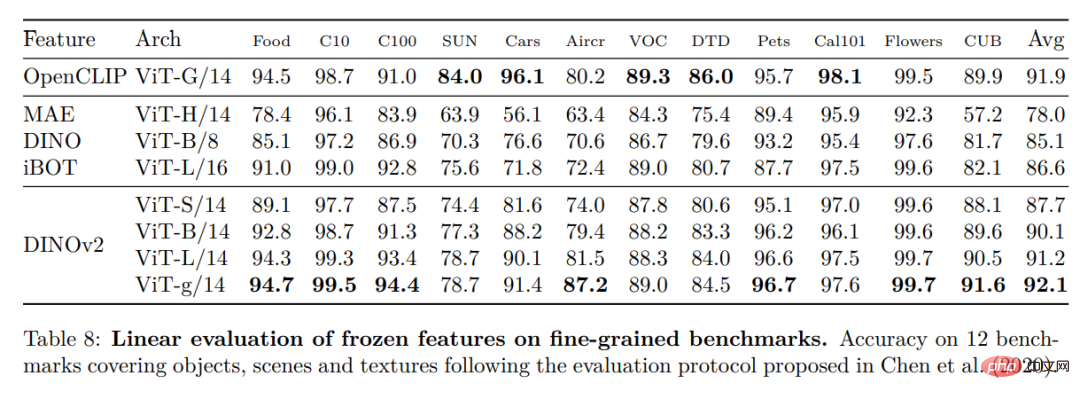

Dans cette section, les chercheurs présenteront l'évaluation empirique du nouveau modèle sur un certain nombre de tâches de compréhension d'images. Ils ont évalué les représentations d'images globales et locales, y compris la reconnaissance au niveau des catégories et des instances, la segmentation sémantique, la prédiction de la profondeur monoculaire et la reconnaissance des actions.ImageNet Catégorie

Autres repères de classification d'images et de vidéos

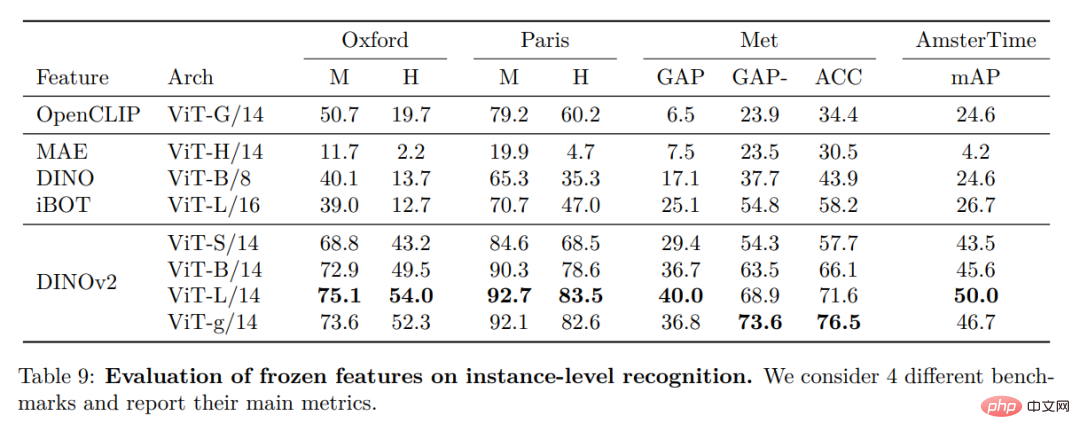

Reconnaissance d'instance

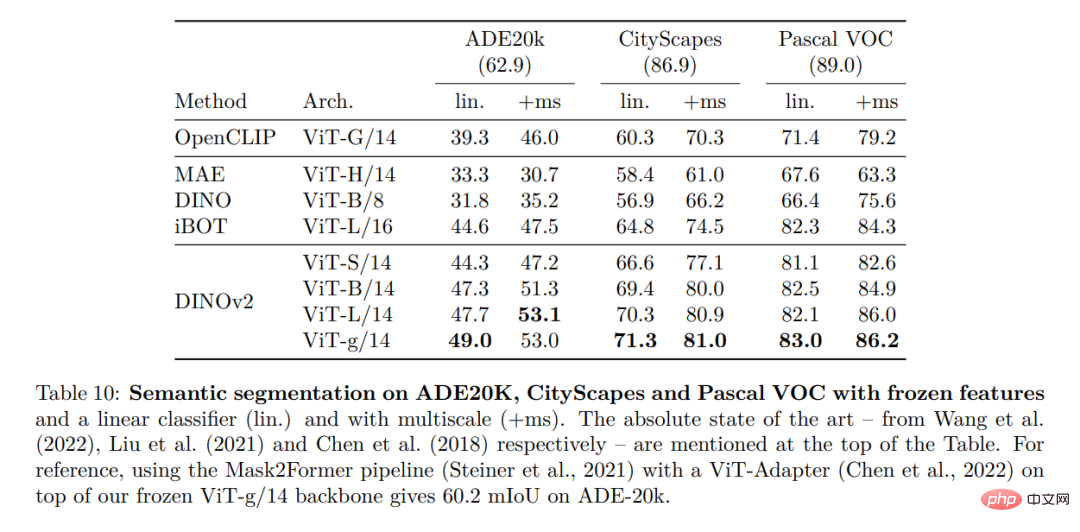

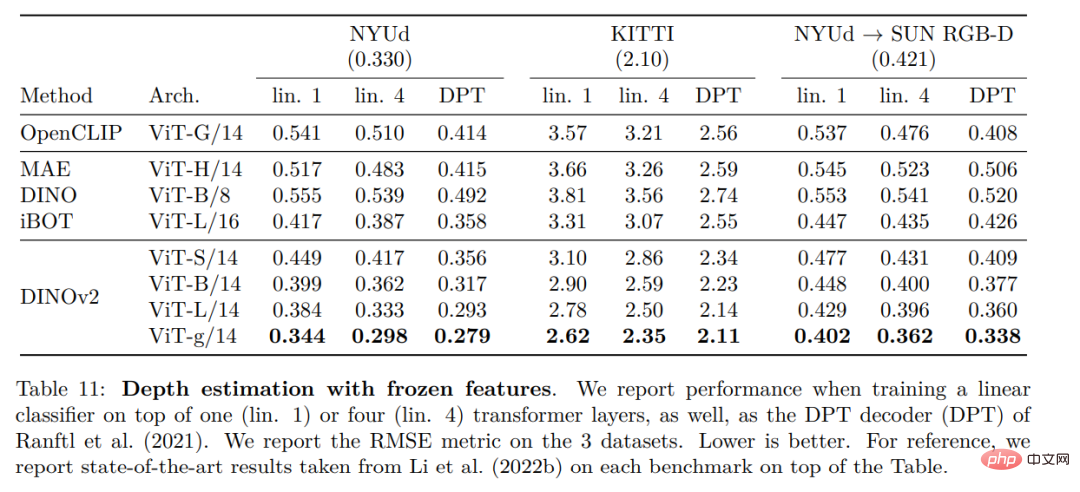

Reconnaissance dense Tâche

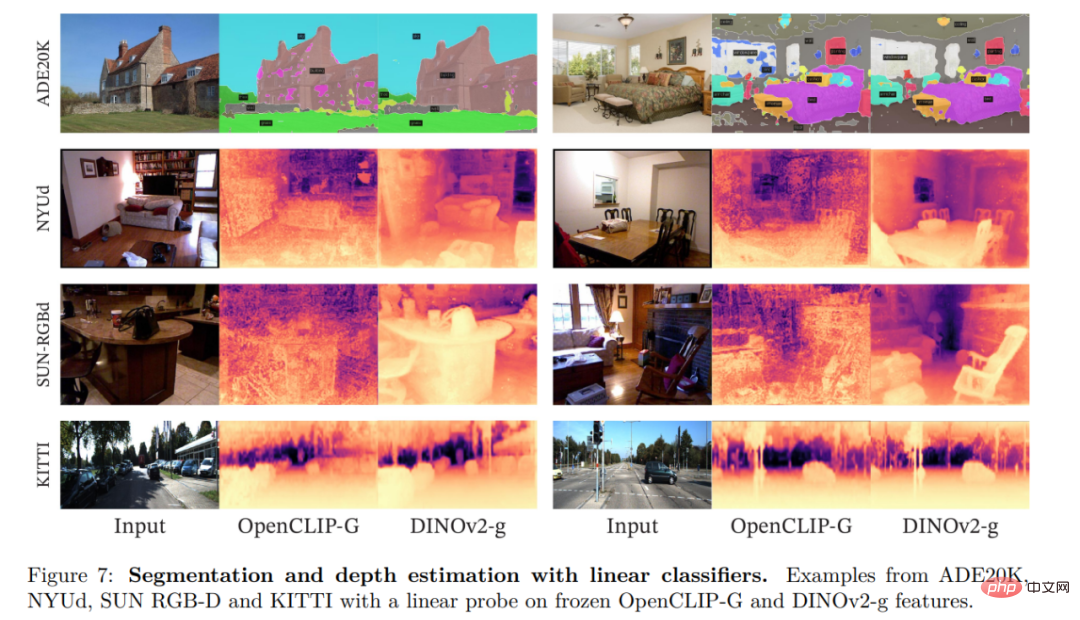

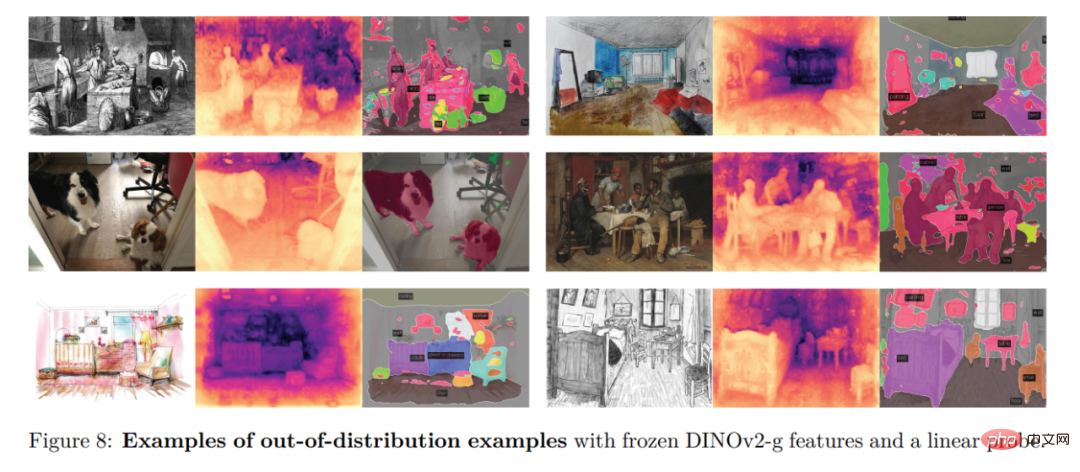

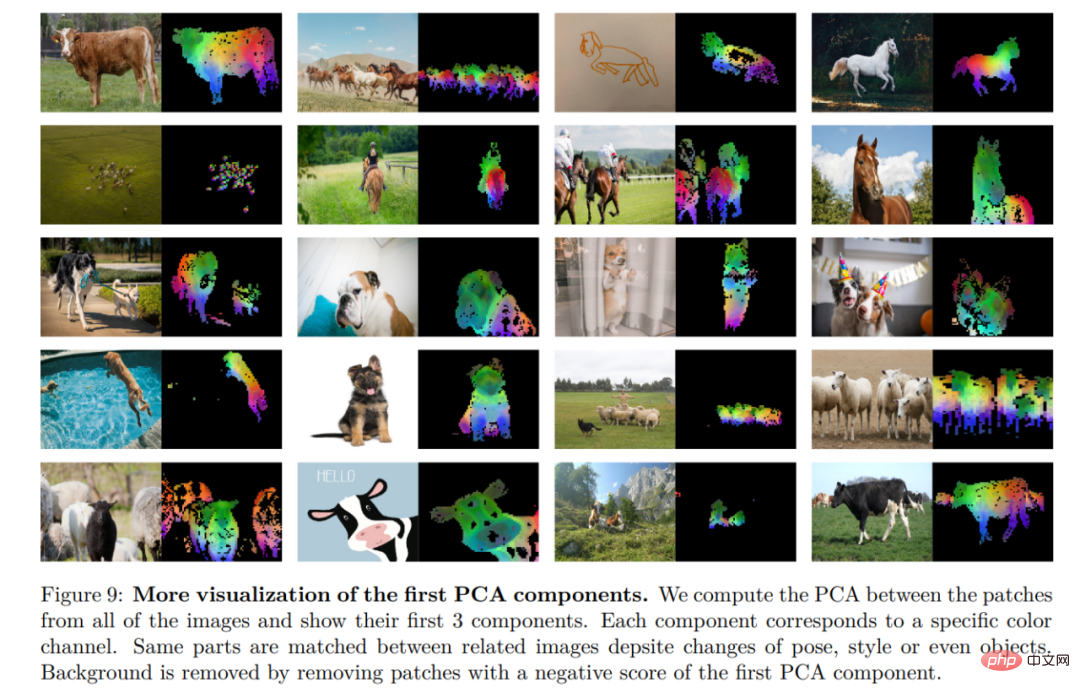

Résultats qualitatifs

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI