Maison >Périphériques technologiques >IA >30 000 A100, c'est trop cher, et 300 personnes chez Microsoft ont développé en secret leurs propres puces IA pendant 5 ans ! TSMC 5 nm, ChatGPT permet d'économiser environ 30 %

30 000 A100, c'est trop cher, et 300 personnes chez Microsoft ont développé en secret leurs propres puces IA pendant 5 ans ! TSMC 5 nm, ChatGPT permet d'économiser environ 30 %

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-26 23:58:12822parcourir

Afin de former ChatGPT, Microsoft a dépensé beaucoup d'argent.

La puissance de calcul totale consommée par ChatGPT est d'environ 3640PF-jours Si elle est calculée un quadrillion de fois par seconde, il faudra 3640 jours pour le calculer.

Microsoft a connecté plus de 30 000 puces Nvidia A100 pour construire un supercalculateur sur mesure pour OpenAI pour un coût de centaines de millions de dollars.

Si cette consommation continue, le portefeuille de Microsoft ne pourra peut-être pas la supporter.

En fait, le projet de remplacement des puces Nvidia est secrètement mené au sein de l'entreprise depuis 2019.

The Information rapporte qu'il y a environ 5 ans, Microsoft a commencé à développer une puce, nommée en interne "Athena", et a été développée conjointement par 300 personnes.

Le plan initial était d’utiliser le processus 5 nm de TSMC.

Athena auto-développée pour défier NVIDIA

Inutile de dire que "Athena" est spécialement conçue pour la formation de grands modèles de langage (LLM).

Maintenant, si Microsoft souhaite intégrer toutes les fonctionnalités GPT-4 dans les compartiments FamilyMart, notamment Bing, Microsoft 365 et GitHub, cela nécessitera certainement une grande puissance de calcul.

Étonnamment, le coût de développement d'une puce comme Athena pourrait être d'environ 100 millions de dollars par an.

Lors de la formation de modèles, les chercheurs peuvent utiliser les fonctions d'« Athena » pour traiter de nouvelles données et effectuer des inférences en même temps.

De cette façon, la situation antérieure consistant à devoir utiliser des ordinateurs dédiés pour traiter les logiciels d'intelligence artificielle a été atténuée. Après tout, les ordinateurs spécifiquement utilisés pour exécuter l'IA n'ont jamais suffi.

Parce que seul NVIDIA produisait auparavant ce type de puce, et le manque d'approvisionnement a fait ressentir cette pénurie à l'ensemble de l'industrie technologique.

C'est précisément pour cette raison que Microsoft doit fournir des puces dédiées à certaines équipes internes.

Auparavant, la société de recherche SemiAnalysis avait estimé que ChatGPT brûlait 700 000 $ US par jour, chaque requête coûtant 0,36 centime.

Si "Athena" est compétitif, il peut réduire le coût de chaque puce de 1/3.

Tracy Woo, analyste senior du cloud chez Forrester Research, a déclaré que l'explosion de l'IA a poussé les grandes entreprises à s'y précipiter, et que le manque de puces exerce non seulement une pression sur les fournisseurs, mais également sur les entreprises de technologie de l'IA. .

Les grandes entreprises technologiques comme Google et Amazon disposent de suffisamment de capital pour concevoir et développer leurs propres puces, et les autres entreprises doivent suivre le rythme.

Retour à « Athena » de Microsoft.

En fait, le moment de la sortie du projet de puce IA de Microsoft était purement accidentel et non planifié.

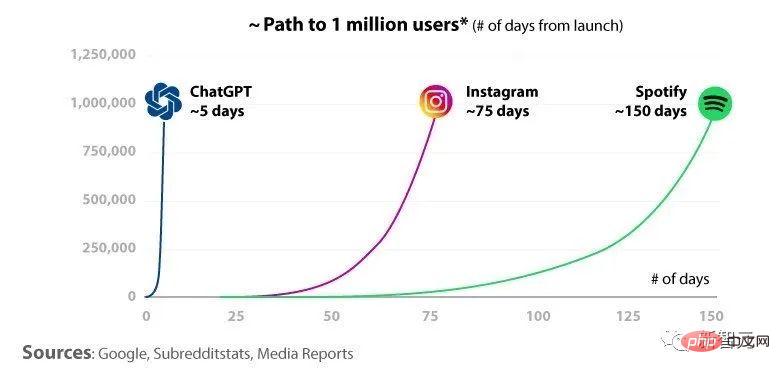

Au début de cette année, OpenAI et Microsoft ont fait un saut qualitatif dans la formation LLM. Des personnes proches du dossier ont déclaré que la sortie de ChatGPT avait fait exploser Internet et que, pour cette raison, Microsoft avait accéléré le lancement d'"Athena".

Vous savez, ChatGPT compte plus de 100 millions d'utilisateurs.

Il est prévu que Microsoft pourrait appliquer "Athena" à grande échelle dès l'année prochaine, y compris au sein de Microsoft et d'OpenAI. Ce qu'ils hésitent encore, c'est de savoir s'ils doivent fournir « Athena » aux clients des services de cloud computing Azure.

Microsoft a déclaré que la plupart des clients n'ont pas besoin de former leur propre LLM, ils n'ont donc pas besoin de bénédiction de puce.

Cependant, si vous voulez vraiment le donner, Microsoft devra faire mieux que NVIDIA. Après tout, les puces NVIDIA fonctionnent dur depuis quinze ans et sont les plus vendues auprès de tous les développeurs.

Dylan Patel, analyste en chef de la société de recherche SemiAnalysis, a déclaré que le coût de fonctionnement de ChatGPT est d'environ 700 000 dollars américains par jour, soit environ 0,36 centime par requête. La principale source de ces coûts est le serveur, qui est trop cher.

Mais si OpenAI utilise son propre "Athena" développé et peut battre Nvidia, alors le coût peut être réduit d'un tiers.

Il a en outre déclaré que Microsoft espère également utiliser LLM dans toutes ses applications à l'avenir, telles que Bing, Office 365, GitHub, etc. Si vous continuez à utiliser le matériel actuel pour le déploiement, cela coûtera des dizaines de milliards de dollars chaque année.

De plus, les puces auto-développées par Microsoft disposent d'un autre support de données.

Les dirigeants de Microsoft prédisent combien d'unités de traitement graphique seront nécessaires pour prendre en charge le travail de l'IA. L’une des personnes proches du dossier a déclaré que s’appuyer entièrement sur les puces Nvidia serait d’un coût prohibitif.

Bien que Microsoft et NVIDIA viennent de conclure un projet de coopération pour construire un supercalculateur l'année dernière, en termes de puces, "Athena" est toujours en concurrence avec les produits NVIDIA.

Cependant, NVIDIA a refusé de commenter ce sujet sensible.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI