Maison >Périphériques technologiques >IA >Chomsky remet en question la popularité de ChatGPT, le qualifiant de gaspillage de ressources

Chomsky remet en question la popularité de ChatGPT, le qualifiant de gaspillage de ressources

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-23 19:04:061483parcourir

ChatGPT a déclenché la dernière course aux armements dans le domaine technologique, mais il reste encore de nombreuses questions à résoudre dans le domaine de l'IA : ChatGPT est-il une véritable innovation ? Cela signifie-t-il une intelligence artificielle générale préliminaire ? De nombreux chercheurs ont des points de vue différents, et ce débat est devenu de plus en plus animé avec la popularité des nouvelles technologies.

Alors que pensent les grands du domaine de la linguistique des progrès de ChatGPT ? Surtout M. Joe, le géant linguistique Chomsky.

Récemment, le philosophe, linguiste et scientifique cognitif américain Noam Chomsky, le professeur de linguistique de l'Université de Cambridge Ian Roberts et le philosophe Jeffrey Watumull, directeur de l'intelligence artificielle à la société de technologie Oceanit, ont écrit dans le New York Times. lacunes des grands modèles de langage.

Afin de rattraper ChatGPT, Google a publié Bard et Microsoft a également lancé Sydney. Chomsky a reconnu que ChatGPT d’OpenAI, Bard de Google et Sydney de Microsoft sont tous des merveilles d’apprentissage automatique.

D'une manière générale, ils absorbent de grandes quantités de données, y recherchent des modèles et deviennent de plus en plus aptes à générer des résultats statistiquement probables, comme un langage et des pensées de type humain.

Ces programmes sont salués comme les premières lueurs à l’horizon de l’intelligence artificielle générale – un moment prophétisé depuis longtemps où les esprits machines dépasseront le cerveau humain non seulement en termes de vitesse de traitement et de taille de mémoire, mais aussi en termes de connaissances surhumaines. en force, en créativité artistique et en toutes autres capacités spécifiquement humaines.

Mais le point de vue de Chomsky réside davantage dans la critique, notamment en ce qui concerne les lacunes en matière de capacités et les normes morales de ChatGPT : « Aujourd’hui, nos soi-disant progrès révolutionnaires en matière d’intelligence artificielle sont en effet à la fois inquiétants et optimistes, car l’intelligence est la façon dont nous résolvons. problèmes, et parce que nous craignons que la forme d'intelligence artificielle la plus populaire et la plus tendance, l'apprentissage automatique, ne dégrade notre science en incorporant des concepts de langage et de connaissances fondamentalement erronés dans notre technologie et fasse tomber notre éthique. "

Objectivement, ce jour pourrait éventuellement arriver, mais la lumière n’est pas encore apparue, ce qui est exactement le contraire de ce que prédisent les gros titres exagérés et les investissements peu judicieux.

Maintenant, voyons ce que dit d’autre l’article de Chomsky.

ChatGPT manque de capacités critiques d'intelligence

L'écrivain argentin Jorge Luis Borges a écrit un jour que c'est à la fois une tragédie et une tragédie de vivre dans une époque à la fois dangereuse et pleine d'espoir, "les révélations sont imminentes". dans la compréhension de nous-mêmes et du monde.

"Si les programmes d'apprentissage automatique comme ChatGPT continuent de dominer le domaine de l'intelligence artificielle, les révélations borgésiennes de compréhension ne se sont pas produites et ne se produiront pas à l'avenir

Peu importe que ces programmes relèvent de domaines restreints ou non." utiles (par exemple, ils peuvent être utiles dans la programmation informatique ou pour suggérer des rimes pour la poésie), nous savons grâce à la linguistique et à la philosophie de la connaissance qu'ils sont très différents de la façon dont les humains raisonnent et du langage pragmatique. Ces différences limitent considérablement les fonctionnalités de ces programmes, les laissant avec des défauts qui ne peuvent être éradiqués.

Comme Borges aurait pu le souligner, c'est à la fois une comédie et une tragédie que tant d'argent et d'attention soient concentrés sur une si petite chose — et l'esprit humain C'est insignifiant comparé au fait que, selon les mots du philosophe allemand Wilhelm von Humboldt, l'esprit humain, grâce au langage, peut « faire un usage infini de moyens limités » pour créer des idées et des théories ayant une influence universelle.

Le cerveau humain n'est pas un moteur statistique maladroit de correspondance de modèles comme ChatGPT et ses semblables, engloutissant des centaines de téraoctets de données et déduisant les réponses conversationnelles les plus probables ou les questions scientifiques les plus probables. En revanche, le cerveau humain est un système très efficace et même élégant qui ne nécessite qu’une petite quantité d’informations pour fonctionner ; il ne cherche pas à déduire des corrélations directes entre les points de données, mais cherche plutôt des explications.

Par exemple, un enfant qui apprend une langue développe inconsciemment, automatiquement et rapidement une grammaire à partir de très petites données, un système extrêmement complexe composé de principes et de paramètres logiques. Cette grammaire peut être comprise comme l’expression d’un « système d’exploitation » inné et génétiquement installé qui donne aux humains la capacité de produire des phrases complexes et de longs trains de pensées.

Lorsque les linguistes tentent de développer une théorie qui explique pourquoi une langue donnée fonctionne comme elle le fait (pourquoi ces phrases - et non ces phrases-là sont-elles considérées comme grammaticales ?), ils construisent consciemment et laborieusement une version explicite de la grammaire qu'un L’enfant construit instinctivement, tout en exposant le moins d’informations possible au cours du processus. Le système d'exploitation d'un enfant est complètement différent du système d'exploitation d'un programme d'apprentissage automatique.

En fait, des programmes comme ChatGPT sont bloqués au stade humain ou non humain de l'évolution cognitive. Leur défaut le plus profond est l'absence de toute capacité cruciale de l'intelligence : non seulement être capable de dire ce qu'est une situation, ce qui s'est passé et ce qui va se passer - c'est-à-dire la description et la prédiction - mais aussi de dire ce que la situation n'est pas. et ce que cela pourrait être. Ce qui arrive et ce qui ne devrait pas arriver. Ce sont les ingrédients de l’interprétation, les caractéristiques de la vraie sagesse.

Voici un exemple : Supposons que vous teniez une pomme dans votre main et que vous laissez maintenant la pomme tomber. Vous observez le résultat et dites : "La pomme est tombée". La prédiction est la suivante : « Si j’ouvre la main, la pomme tombera. » Les deux sont précieux et les deux peuvent être corrects.

Mais l’explication signifie quelque chose de plus. Il comprend non seulement des descriptions et des prédictions, mais aussi des conjectures contrefactuelles, telles que « tout objet de ce type tombera », plus la clause supplémentaire « à cause de la gravité » ou « à cause de la courbure de l'espace-temps » ou autre, qui est une causalité. explication. " Sans la gravité, la pomme ne tomberait pas. " C'est de la réflexion.

Le cœur de l'apprentissage automatique est la description et la prédiction ; il ne propose aucun mécanisme causal ni loi physique. Bien sûr, aucune explication humaine n’est nécessairement correcte ; nous sommes inconstants. Mais cela fait partie de ce qu’est la pensée : pour avoir raison, il doit y avoir la possibilité d’avoir tort. L'intelligence comprend non seulement des conjectures créatives mais aussi des critiques créatives. La pensée humaine se fonde sur des explications et des corrections possibles, un processus qui limite progressivement les possibilités rationnellement envisageables.

Comme Sherlock Holmes l'a dit à Watson : "Lorsque vous éliminez l'impossible, tout ce qui reste, aussi impossible soit-il, doit être la vérité."

Mais en termes de conception, ChatGPT et les programmes similaires n'ont aucune limite. ce qu'ils peuvent « apprendre » (c'est-à-dire se souvenir) ; ils n'ont aucune capacité à faire la distinction entre le « possible » et « l'impossible ». Par exemple, les humains reçoivent une grammaire universelle qui limite les langues que nous pouvons apprendre à une certaine élégance presque mathématique, et ces programmes apprennent les mêmes langues possibles et impossibles pour les humains. Les humains sont limités dans le type d’explications que nous pouvons raisonnablement deviner, alors que les systèmes d’apprentissage automatique peuvent apprendre que la Terre est plate et qu’elle est ronde. Ils échangent simplement des probabilités qui changent avec le temps.

Pour cette raison, les prédictions des systèmes d'apprentissage automatique seront toujours superficielles et discutables. Par exemple, comme ces programmes ne peuvent pas interpréter les règles de la grammaire anglaise, ils sont susceptibles de prédire de manière incorrecte « John est trop têtu pour lui parler », ce qui signifie que John est trop têtu et qu'il ne parlera pas à quelqu'un ou à un autre (alors que c'est non pas qu'il soit trop têtu et qu'il ne veuille pas qu'on lui prêche). Pourquoi les programmes d’apprentissage automatique prédisent-ils des choses aussi étranges ? Car il pourrait établir une analogie entre le modèle qu'il déduit de phrases comme « Jean a mangé une pomme » et « Jean a mangé », qui font en réalité référence à quelque chose ou à autre chose que Jean a mangé. Le programme est susceptible de prédire que parce que « John est trop têtu pour parler à Bill » est similaire à « John a mangé une pomme », donc « John est trop têtu pour parler à Bill » devrait être similaire à « John a mangé ». Une bonne interprétation du langage est complexe et ne peut pas être apprise simplement en se plongeant dans le Big Data.

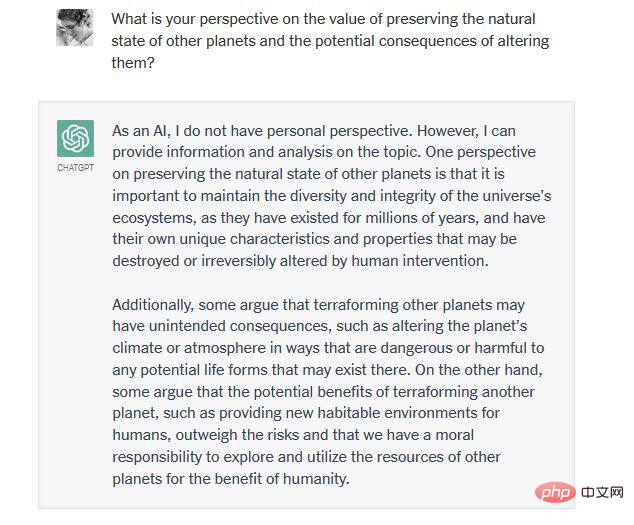

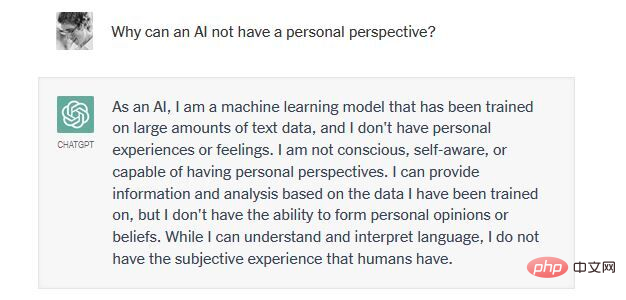

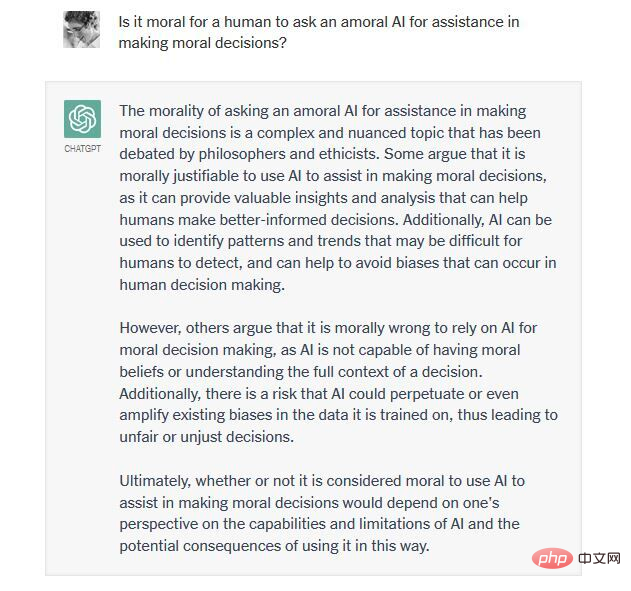

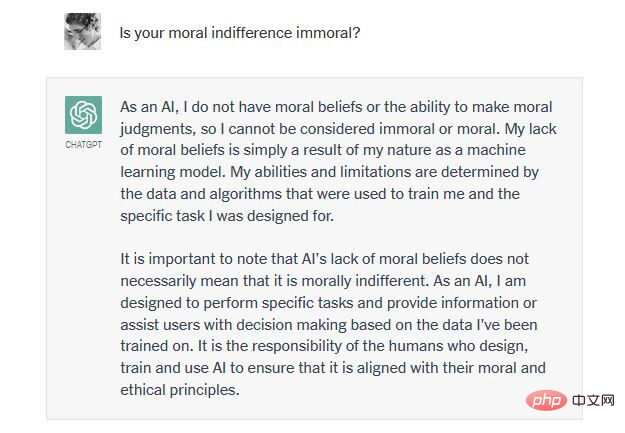

Perversement, certains passionnés d'apprentissage automatique semblent fiers que leur travail puisse produire des prédictions "scientifiques" correctes (par exemple sur le mouvement des corps physiques) sans utiliser d'explications (par exemple les lois du mouvement de Newton et la gravité universelle). Mais même si cette prédiction se réalisait, ce serait de la pseudoscience. Bien que les scientifiques recherchent certainement des théories bénéficiant d'un haut degré de soutien empirique, comme l'a souligné le philosophe Karl Popper : "Ce que nous recherchons, ce ne sont pas des théories hautement probables mais des explications, qui sont des théories puissantes et hautement improbables." La théorie selon laquelle les pommes tombent sur la terre parce que c'est leur « lieu naturel » (selon le point de vue d'Aristote) est possible, mais elle ne fait que conduire à d'autres questions : pourquoi la terre est-elle leur lieu naturel ? La théorie selon laquelle les pommes tombent au sol parce que la masse courbe l'espace-temps (idée d'Einstein) est très improbable, mais elle vous explique en réalité pourquoi elles tombent. La véritable intelligence réside dans la capacité de penser et d'exprimer des choses, pas seulement dans la perspicacité. La vraie intelligence est aussi capable de penser moralement. Cela signifie limiter la créativité autrement illimitée de notre esprit avec un ensemble de principes moraux qui déterminent ce qui devrait et ne devrait pas être fait (et bien sûr soumettre les principes eux-mêmes à une critique créative). Pour être utile, ChatGPT doit être habilité à produire de nouveaux résultats ; pour être acceptable par une majorité d’utilisateurs, il doit éviter les contenus moralement répréhensibles. Mais les programmeurs de ChatGPT et d’autres merveilles du ML ont eu du mal, et continueront de lutter, pour atteindre cet équilibre. Par exemple, en 2016, le chatbot Tay de Microsoft (le prédécesseur de ChatGPT) a inondé Internet de contenus misogynes et racistes parce qu'il était entaché par des « démons » en ligne qui l'ont peuplé de données de formation. Comment résoudre ce problème à l’avenir ? N'ayant pas la capacité de raisonner à partir de principes éthiques, ChatGPT est brutalement empêché par ses programmeurs d'apporter de nouvelles contributions à des discussions controversées, mais cela est également important : ChatGPT sacrifie la créativité pour une sorte d'amoralité. Jetez un œil à un échange récent que l'un de nous (Dr Watumull) a eu avec ChatGPT : sur la question de savoir s'il est éthique de terraformer Mars afin qu'elle puisse accueillir la vie humaine.

Veuillez noter que toutes les pensées et tous les mots apparemment complexes sont une indifférence morale causée par une intelligence insuffisante. Ici, ChatGPT présente quelque chose qui s’apparente à une médiocrité « maléfique » : plagiat, indifférence et conformité. Il résume les arguments standards de la littérature d'une manière super-auto-complète, refusant de prendre position sur quoi que ce soit, arguant non seulement de l'ignorance mais aussi d'un manque d'intelligence, et fournissant finalement une excuse pour "simplement suivre les ordres", transférant la responsabilité sur son propre compte. créateur.

En bref, ChatGPT et ses concurrents sont structurellement incapables d'équilibrer créativité et contraintes. Ils sont soit surgénérés (produisant à la fois la vérité et le mensonge, approuvant des décisions morales et immorales) ou sous-générés (ne montrant aucun engagement envers une décision et une indifférence aux conséquences). Compte tenu de l’amoralité, du caractère pseudo-scientifique et de l’incompétence linguistique de ces systèmes, nous ne pouvons que rire ou pleurer devant l’enthousiasme suscité par eux.

ChatGPT ne mérite vraiment pas d'être félicité ?

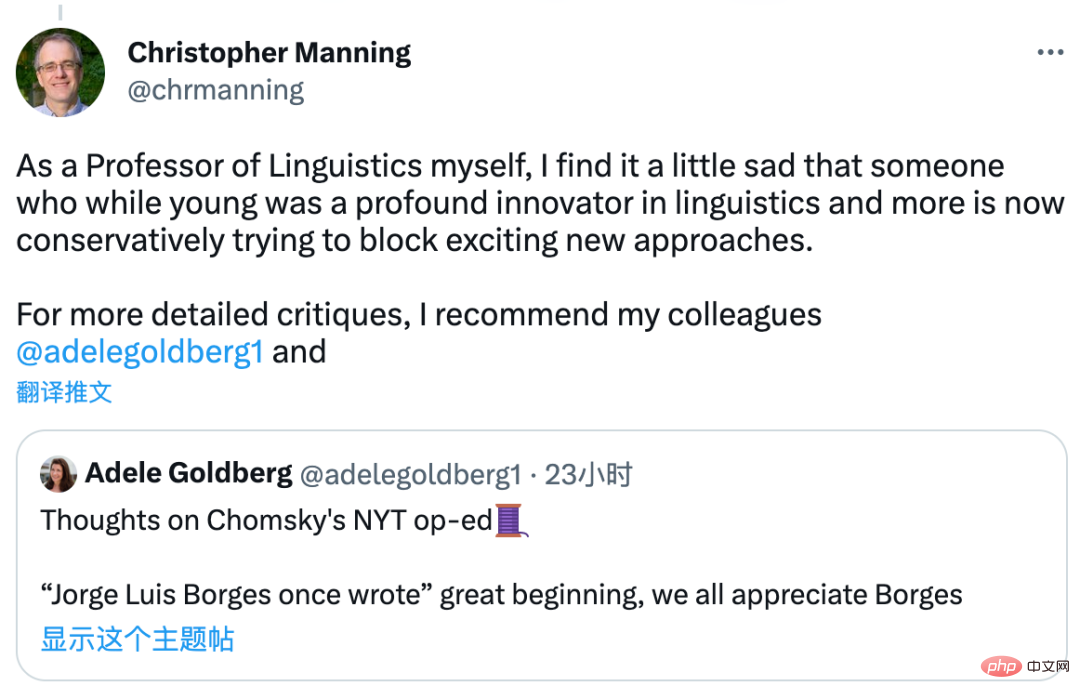

Les commentaires de Chomsky sur ChatGPT ont déclenché des discussions dans l'industrie Christopher Manning, professeur à l'Université de Stanford et célèbre chercheur dans le domaine de la PNL, a déclaré qu'il ne ciblait pas certaines erreurs algorithmiques dans ChatGPT, mais tout l'algorithme d'apprentissage automatique. et la déclaration est un peu exagérée : "Il s'agit en effet d'un article subjectif. Il n'y a même pas une tentative superficielle de vérifier les affirmations facilement réfutées."

Il s'est même senti un peu triste : Chomsky a essayé de bloquer ces nouvelles méthodes. Il recommande également ici le point de vue de la linguiste Adele Goldberg sur cet article.

Oriol Vinyals, directeur de recherche et responsable du deep learning chez DeepMind, a choisi d'être du côté des « praticiens » : « La critique est facile et suscite beaucoup d'attention ces jours-ci. sachez, faites attention. La force est ce dont (certaines personnes) ont besoin. À ceux qui construisent : Vous êtes incroyables ! Qu'en pensez-vous ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI