Maison >Périphériques technologiques >IA >Révéler le secret de la victoire dans la compétition de données : analyser les avantages de l'A100 en 200 jeux

Révéler le secret de la victoire dans la compétition de données : analyser les avantages de l'A100 en 200 jeux

- PHPzavant

- 2023-04-21 19:55:071422parcourir

2022 est une grande année pour l'IA, mais aussi pour les compétitions de données, avec un total de prix sur toutes les plateformes dépassant les 5 millions de dollars.

Récemment, la plateforme d'analyse des compétitions d'apprentissage automatique ML Contests a mené une statistique à grande échelle sur la compétition de données 2022. Un nouveau rapport revient sur tous les événements marquants de 2022. Ce qui suit est une compilation du texte original.

Points forts :

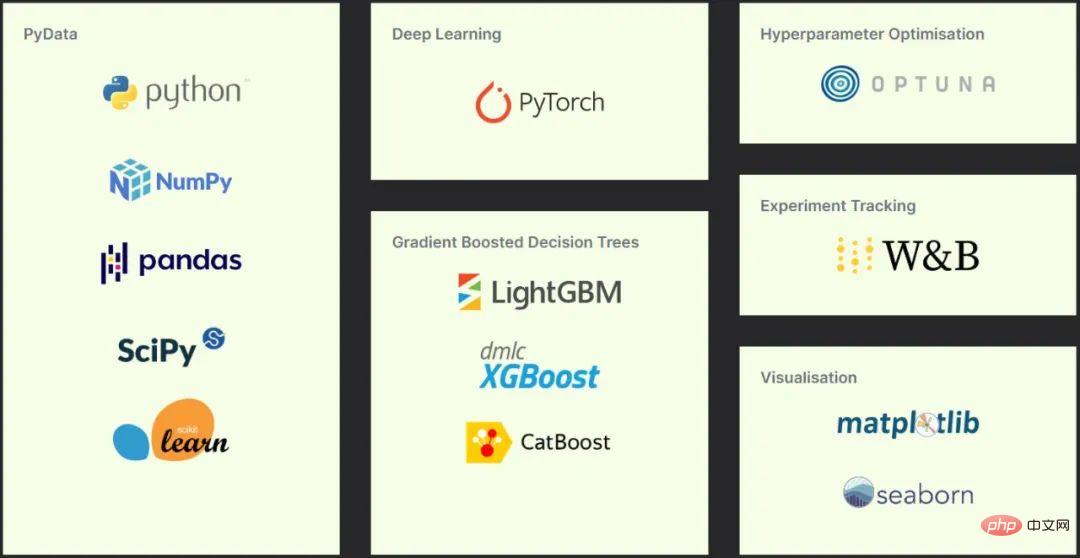

- Sélection d'outils pour les candidats retenus : Python, Pydata, Pytorch et arbres de décision améliorés par gradient.

- Le deep learning n'a pas encore remplacé les arbres de décision boostés par gradient, bien que le premier prenne souvent de la valeur lorsqu'on se familiarise avec les méthodes de boosting.

- Transformer continue de dominer en PNL et commence à rivaliser avec les réseaux de neurones convolutifs en vision par ordinateur.

- Le concours de données d'aujourd'hui couvre un large éventail de domaines de recherche, notamment la vision par ordinateur, la PNL, l'analyse de données, la robotique, l'analyse de séries chronologiques, etc.

- Les modèles à grand ensemble sont encore courants parmi les solutions gagnantes, et certaines solutions à modèle unique gagnent également.

- Il existe plusieurs plateformes de compétition de données actives.

- La communauté des compétitions de données continue de croître, y compris dans le monde universitaire.

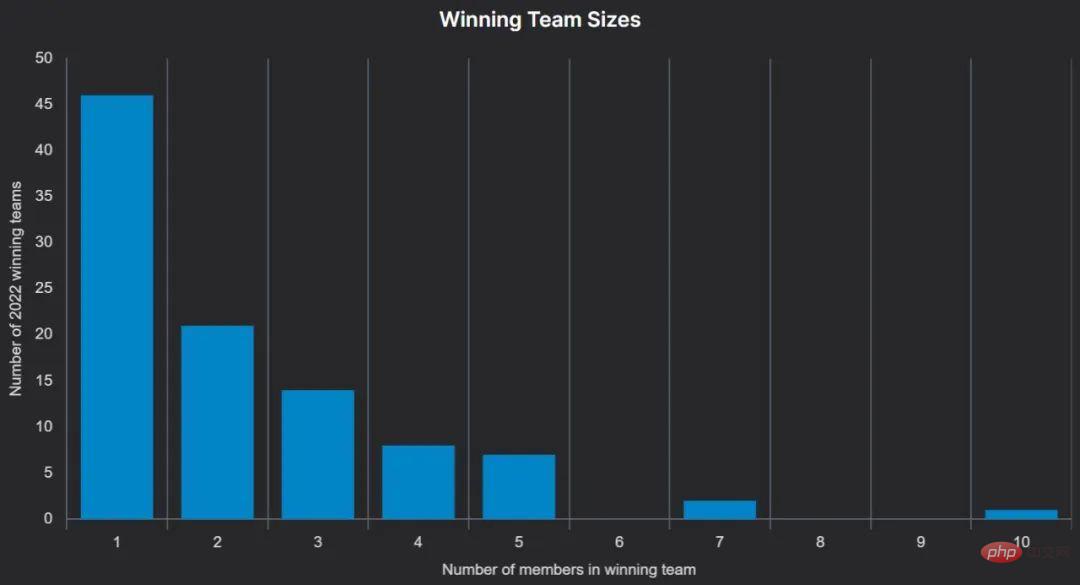

- Environ 50 % des gagnants sont des équipes composées d'une seule personne et 50 % des gagnants sont des gagnants pour la première fois.

- Certaines personnes utilisent du matériel haut de gamme, mais des ressources gratuites comme Google Colab peuvent également gagner la partie.

Concours et tendances

Le concours avec le plus gros prix en argent est le concours Snow Cast Showdown de Drivendata, parrainé par le Bureau of Reclamation des États-Unis. Les participants reçoivent un prix de 500 000 $ et sont conçus pour contribuer à améliorer la gestion de l'approvisionnement en eau en fournissant des estimations précises des débits de neige pour différentes régions de l'Ouest. Comme toujours, Drivendata a écrit un article détaillé sur la correspondance et propose un rapport de solution détaillé qui vaut la peine d'être lu.

Le concours le plus populaire de 2022 est le concours American Express Default Prediction de Kaggle, qui vise à prédire si les clients rembourseront leurs prêts. Plus de 4 000 équipes ont concouru, et 100 000 $ de prix en argent ont été distribués aux quatre meilleures équipes. Pour la première fois cette année, une première participation a été remportée par une équipe composée d'une seule personne utilisant un ensemble de réseaux neuronaux et de modèles LightGBM.

Le plus grand concours indépendant est l'AI Audit Challenge de l'Université de Stanford, qui offre une récompense de 71 000 $ pour les meilleurs « modèles, solutions, ensembles de données et outils » afin de trouver des moyens de résoudre le problème du « système d'examen de l'IA ». .

Trois compétitions basées sur des prédictions financières sont toutes sur Kaggle : les prédictions de la Bourse de Tokyo de JPX, les prédictions de marché d'Ubiquant et les prédictions cryptographiques de G-Research.

Dans les comparaisons dans différentes directions, la vision par ordinateur représente la proportion la plus élevée, la PNL occupe la deuxième place et les problèmes de prise de décision séquentielle (apprentissage par renforcement) sont en augmentation. Kaggle a répondu à cette popularité croissante en introduisant des compétitions de simulation en 2020. Aicrowd organise également de nombreux concours d'apprentissage par renforcement. En 2022, 25 de ces événements interactifs totalisent plus de 300 000 $.

Dans le Real Robot Challenge, le concours officiel NeurIPS 2022, les participants doivent apprendre à contrôler un robot à trois doigts pour déplacer un cube vers un emplacement cible ou le positionner à un point précis de l'espace, tout en faisant face à la bonne direction. Les stratégies des participants sont exécutées chaque semaine sur le robot physique et les résultats sont mis à jour dans le classement. Le prix est un prix de 5 000 $ et l'honneur académique de prendre la parole au symposium NeurIPS.

Plateforme

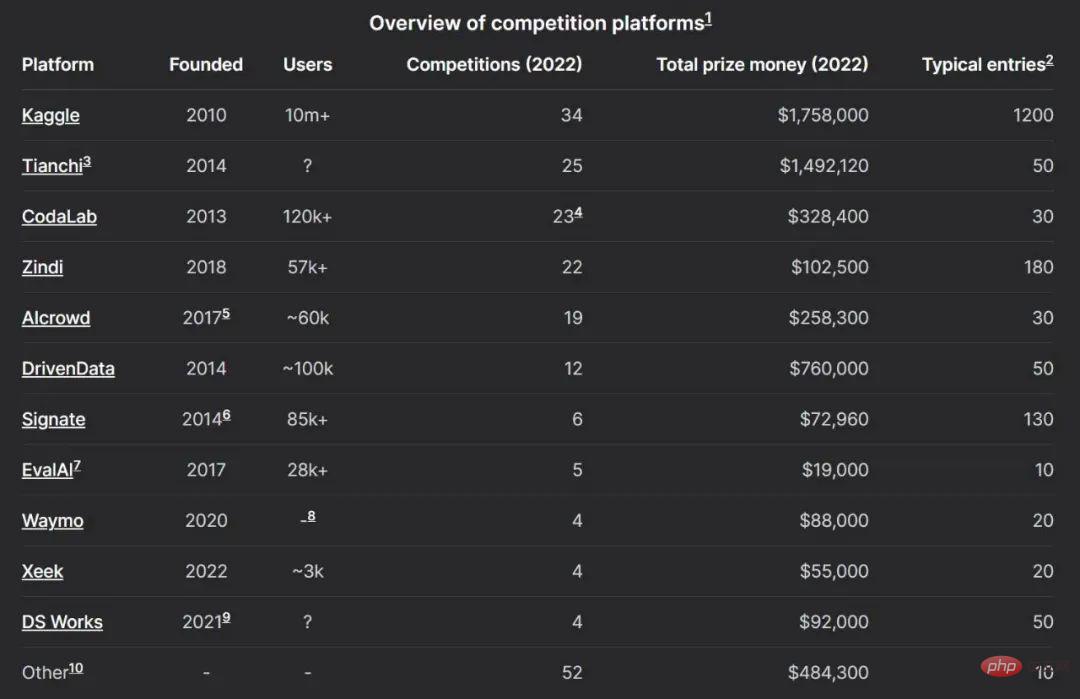

Bien que les gens connaissent Kaggle et Tianchi, il existe actuellement de nombreuses plateformes de compétition d'apprentissage automatique qui forment un écosystème actif.

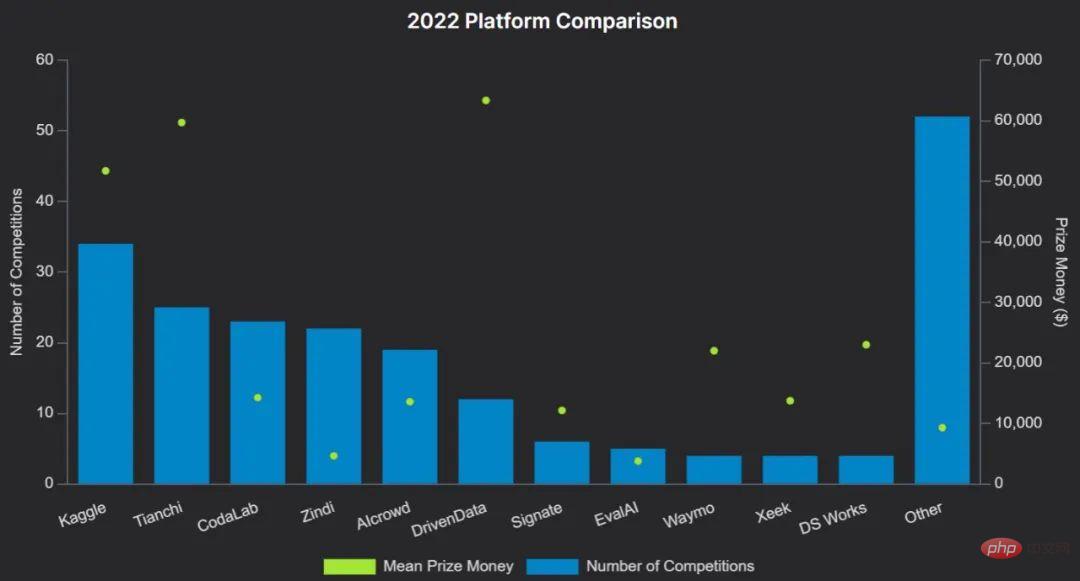

L'image ci-dessous montre la comparaison des plateformes 2022 :

Citer quelques exemples :

- Kaggle est l'une des plateformes les plus établies, elle a été acquise par Google en 2017 et possède la plus grande communauté, attirant récemment 10 millions d'utilisateurs. Organiser des concours avec des prix sur Kaggle peut coûter très cher. En plus d'héberger des concours, Kaggle permet également aux utilisateurs d'héberger des ensembles de données, des notes et des modèles.

- Codalab est une plateforme de concours open source maintenue par l'Université Paris - Saclay. Tout le monde peut s'inscrire, organiser ou participer à un concours. Il fournit des ressources CPU gratuites pour en déduire que les organisateurs de compétitions peuvent compléter avec leur propre matériel.

- Zindi est une plateforme plus petite avec une communauté très active axée sur la mise en relation des institutions avec des data scientists en Afrique. Drivendata se concentre sur les compétitions à impact social et a développé des compétitions pour la NASA et d'autres organisations. Les concours sont toujours suivis de rapports de recherche approfondis.

- Aicrowd a débuté comme un projet de recherche à l'École polytechnique fédérale de Suisse (EPFL) et fait désormais partie des cinq meilleures plateformes de concours. Il héberge plusieurs compétitions officielles NeurIPS.

Academia

La plupart des prix en argent pour les concours organisés sur de grandes plateformes proviennent de l'industrie, mais les concours d'apprentissage automatique ont clairement une histoire plus riche dans le monde universitaire, comme Isabelle Guyon l'a fait à NeurIPS cette année. Comme discuté dans le discours d'invitation.

NeurIPS est l'une des conférences académiques sur l'apprentissage automatique les plus prestigieuses au monde, où sont régulièrement présentés les articles sur l'apprentissage automatique les plus importants de la dernière décennie, notamment AlexNet, GAN, Transformer et GPT-3.

NeurIPS a organisé pour la première fois un atelier Data Challenge in Machine Learning (CIML) en 2014, et il y a un volet concours depuis 2017. Depuis lors, la compétition et le montant total des prix n’ont cessé de croître, atteignant près de 400 000 $ en décembre 2022.

D'autres conférences sur l'apprentissage automatique accueillent également des concours, notamment CVPR, ICPR, IJCAI, ICRA, ECCV, PCIC et AutoML.

Prix

Environ la moitié de toutes les compétitions d'apprentissage automatique ont des cagnottes de plus de 10 000 $. Il ne fait aucun doute que de nombreux concours intéressants offrent de petits prix, et ce rapport ne prend en compte que ceux dotés de prix monétaires ou de distinctions académiques. Souvent, les concours de données associés à des conférences universitaires prestigieuses offrent aux gagnants des bourses de voyage pour assister à la conférence.

Bien que certaines plateformes de tournois aient tendance à avoir en moyenne des cagnottes plus importantes que d'autres (voir le tableau comparatif des plateformes), de nombreuses plateformes ont accueilli au moins un tournoi avec une très grande cagnotte en 2022 - Total des prix Les dix meilleures compétitions incluent celles exécuté sur DrivenData, Kaggle, CodaLab et AIcrowd.

Comment gagner

Cette enquête analyse les techniques utilisées par l'algorithme gagnant à travers des questionnaires et l'observation de codes.

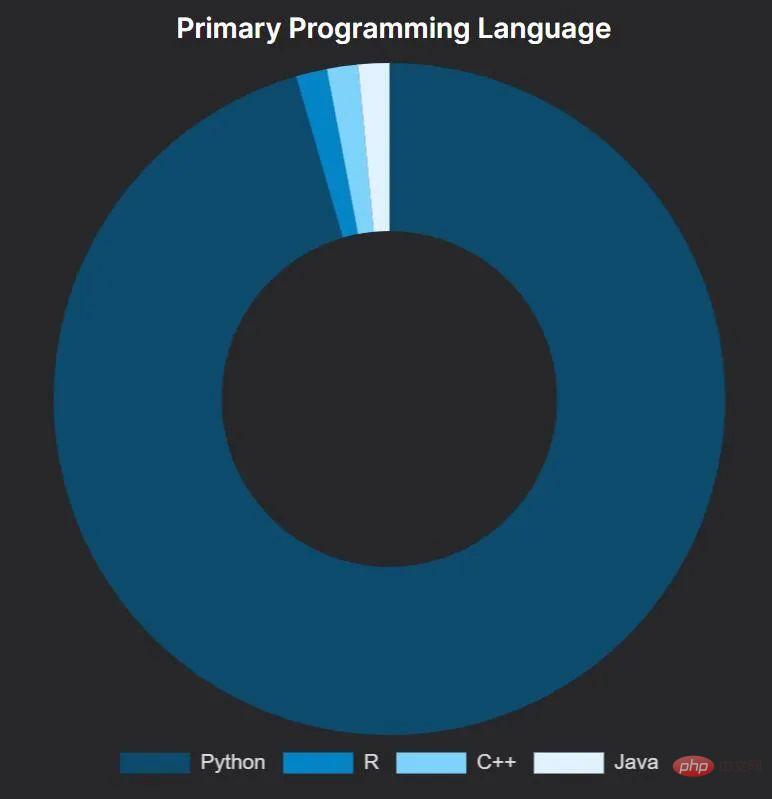

De manière assez constante, Python a été le langage de choix des gagnants du concours, ce qui n'est peut-être pas un résultat inattendu pour les gens. Parmi ceux qui utilisent Python, environ la moitié utilisent principalement Jupyter Notebook et l’autre moitié utilise des scripts Python standard.

Une solution gagnante utilisant principalement R : Amir Ghazi a remporté le concours Kaggle pour prédire le vainqueur du championnat américain de basket-ball universitaire masculin 2022. Il l'a fait en utilisant – apparemment en copiant textuellement – le code d'une solution gagnante du concours 2018 écrite par le grand maître Kaggle Darius Barušauskas. Incroyablement, Darius a également participé à cette course en 2022, en utilisant une nouvelle approche et en terminant 593e.

Packages Python utilisés par les gagnants

En examinant les packages utilisés dans les solutions gagnantes, il s'est avéré que tous les gagnants utilisant Python utilisaient la pile PyData dans une certaine mesure.

Les progiciels les plus populaires sont divisés en trois catégories : les boîtes à outils de base, les catégories PNL et les catégories de vision par ordinateur.

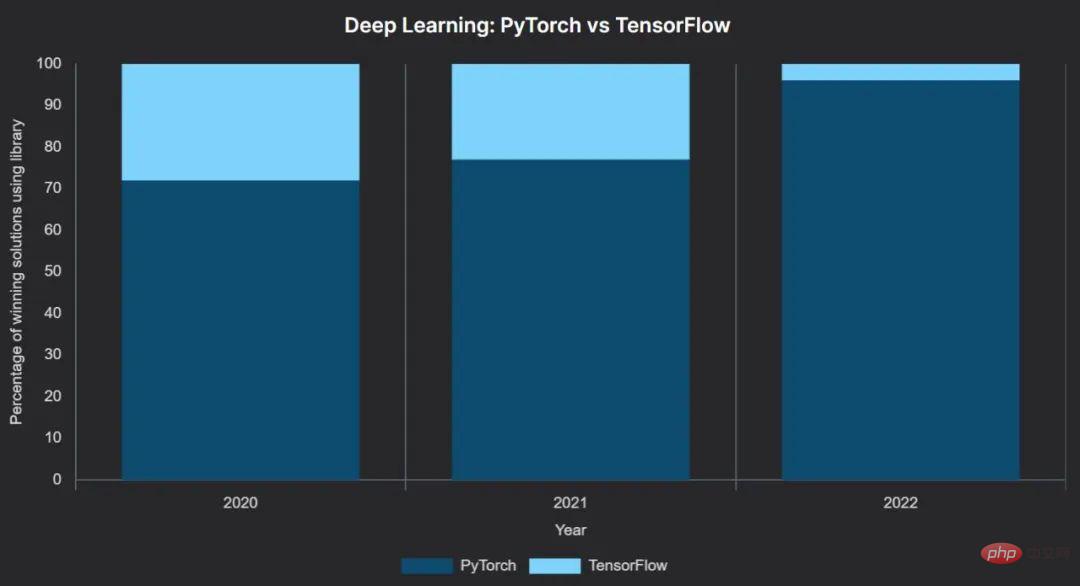

Parmi eux, la croissance du framework d'apprentissage profond PyTorch a été régulière, et son saut de 2021 à 2022 est très évident : PyTorch est passé de 77 % à 96 % de solutions gagnantes.

Sur les 46 solutions gagnantes utilisant le deep learning, 44 utilisaient PyTorch comme framework principal et seulement deux utilisaient TensorFlow. Plus révélateur encore, l'un des deux concours remportés avec TensorFlow, le concours de la Grande Barrière de Corail de Kaggle, offre un prix supplémentaire de 50 000 $ à l'équipe gagnante utilisant TensorFlow. Un autre concours remporté grâce à TensorFlow utilisait l'API Keras de haut niveau.

Alors que 3 gagnants ont utilisé pytorch-lightning et 1 fastai - tous deux construits sur PyTorch - la grande majorité a utilisé PyTorch directement.

Maintenant, on peut dire qu'au moins dans la course aux données, PyTorch a gagné la bataille des frameworks d'apprentissage automatique. Cela est cohérent avec les tendances plus larges de la recherche sur l’apprentissage automatique.

Il convient de noter que nous n'avons trouvé aucune instance de l'équipe gagnante utilisant d'autres bibliothèques de réseaux neuronaux, telles que JAX (construit par Google et utilisé par DeepMind), PaddlePaddle (développé par Baidu) ou MindSpore (développé par Huawei). ).

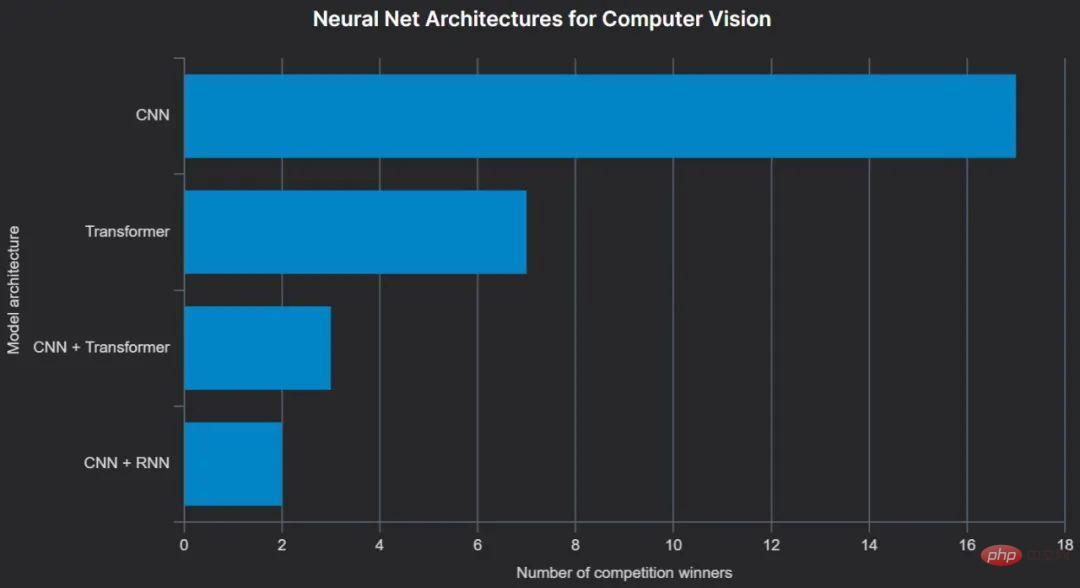

Computer Vision

Les outils ont tendance à dominer le monde, mais pas la technologie. Lors du CVPR 2022, l'architecture ConvNext a été présentée comme le « ConvNet des années 2020 » et s'est avérée surpasser les récents modèles basés sur Transformer. Elle a été utilisée dans au moins deux solutions de vision par ordinateur primées, et CNN reste globalement l'architecture de réseau neuronal la plus populaire parmi les gagnants du concours de vision par ordinateur à ce jour.

La vision par ordinateur est très similaire à la modélisation du langage dans l'utilisation de modèles pré-entraînés : des architectures faciles à comprendre formées sur des ensembles de données publics tels qu'ImageNet. Le référentiel le plus populaire est Hugging Face Hub, accessible via timm, ce qui rend extrêmement pratique le chargement de versions pré-entraînées de dizaines de modèles de vision par ordinateur différents.

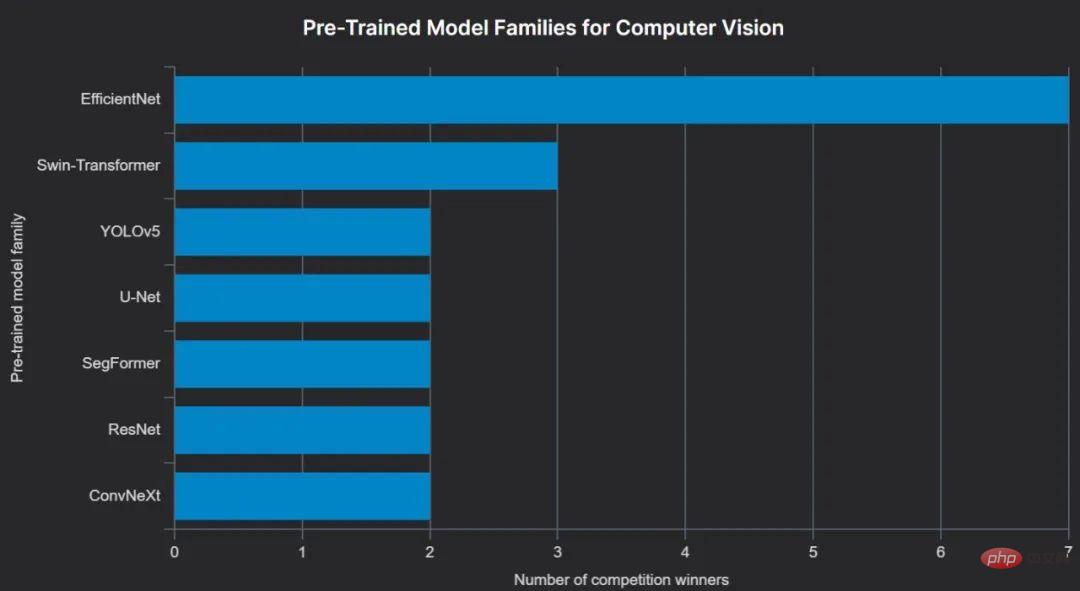

Les avantages de l'utilisation de modèles pré-entraînés sont évidents : les images du monde réel et le texte généré par l'homme ont certaines caractéristiques communes, et l'utilisation de modèles pré-entraînés peut apporter des connaissances de bon sens, similaires à l'utilisation de modèles plus grands et plus généraux. ensemble de données de formation.

Souvent, les modèles pré-entraînés sont affinés – et entraînés davantage – sur la base de données spécifiques à une tâche (telles que les données fournies par les organisateurs de compétitions), mais pas toujours. Le gagnant de l'Image Matching Challenge a utilisé un modèle pré-entraîné sans aucun réglage - "En raison de la qualité (différente) des données de formation et de test dans ce concours, nous n'avons pas affiné en utilisant la formation fournie car nous pensions que ce ne serait pas très efficace." La décision a porté ses fruits.

Le type de modèle de vision par ordinateur pré-entraîné le plus populaire parmi les gagnants de 2022 jusqu'à présent est EfficientNet, qui, comme son nom l'indique, a l'avantage d'être moins gourmand en ressources que de nombreux autres modèles.

Traitement du langage naturel

Depuis leur introduction en 2017, les modèles basés sur Transformer ont dominé le domaine du traitement du langage naturel (NLP). Transformer est le « T » dans BERT et GPT, et est également le cœur de ChatGPT.

Il n’est donc pas surprenant que toutes les solutions gagnantes des concours de traitement du langage naturel reposent sur des modèles basés sur Transformer. Il n’est pas surprenant qu’ils soient tous implémentés dans PyTorch. Ils ont tous utilisé des modèles pré-entraînés, chargés à l’aide de la bibliothèque Transformers de Hugging Face, et presque tous ont utilisé la version de Microsoft Research du modèle DeBERTa – généralement deberta-v3-large.

Beaucoup d’entre eux nécessitent de grandes quantités de ressources informatiques. Par exemple, le gagnant de Google AI4Code a exécuté un A100 (80 Go) pendant environ 10 jours pour former un seul deberta-v3-large pour sa solution finale. Cette approche est l'exception (utilisant un modèle maître unique et une répartition fixe train/évaluation) - toutes les autres solutions font un usage intensif de modèles d'ensemble et presque toutes utilisent une forme de validation croisée k fois. Par exemple, le gagnant du concours Jigsaw Toxic Comments a utilisé une moyenne pondérée des résultats de 15 modèles.

Les ensembles basés sur Transformer sont parfois utilisés en conjonction avec LSTM ou LightGBM, et il existe également au moins deux instances de pseudo-étiquetage qui ont été efficacement utilisées pour la solution gagnante.

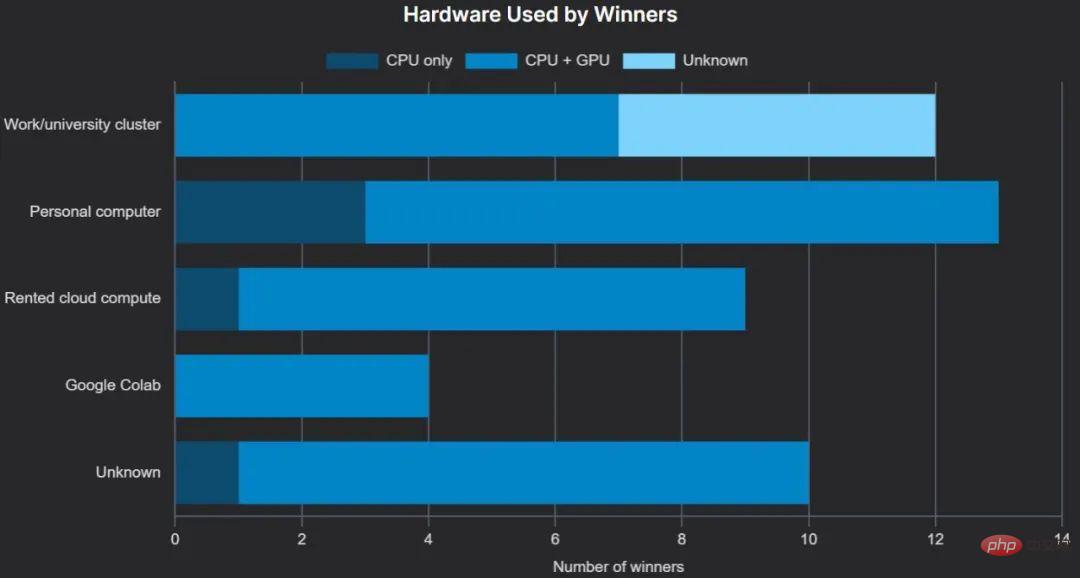

XGBoost était synonyme de Kaggle. Cependant, LightGBM est clairement la bibliothèque GBDT préférée des gagnants de 2022 : les gagnants ont mentionné LightGBM autant de fois dans leurs rapports ou questionnaires de solutions que CatBoost et XGBoost réunis, CatBoost est arrivé en deuxième position et XGBoost s'est étonnamment classé troisième. « Informatique et matériel informatique » Un nombre important de lauréats ont accès à des clusters fournis par leur employeur ou leur université, comprenant souvent des GPU.

Étonnamment, nous n'avons trouvé aucun cas d'utilisation de l'unité de traitement tensoriel (TPU) de Google pour former un modèle gagnant. Nous n’avons pas non plus vu de modèles gagnants formés sur les puces de la série M d’Apple, qui sont prises en charge par PyTorch depuis mai 2022.

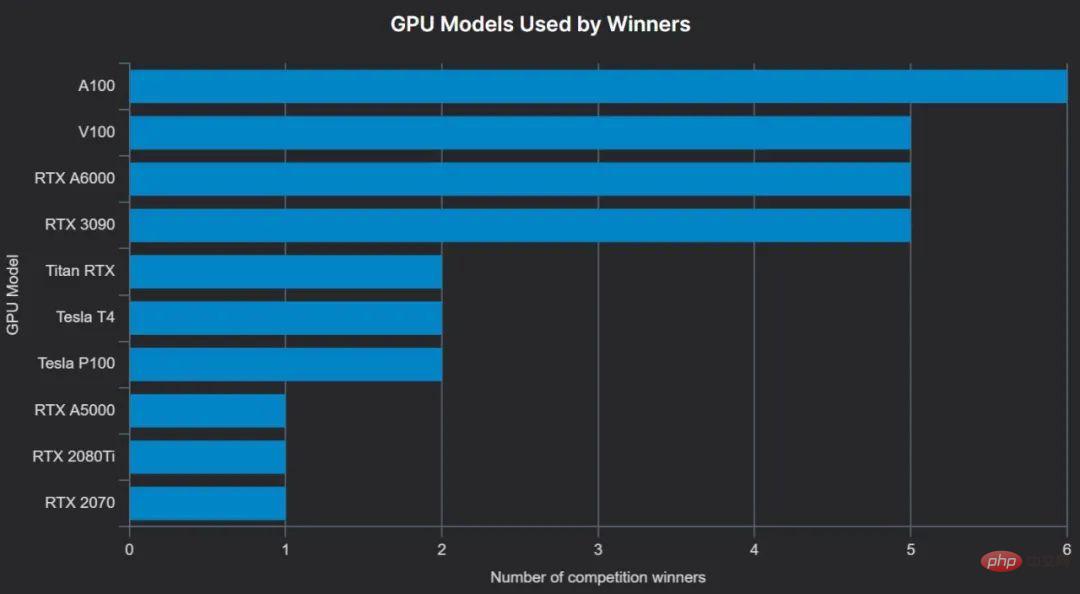

Le matériel personnel local était plus populaire que le matériel cloud, et bien que neuf gagnants aient mentionné le GPU qu'ils ont utilisé pour la formation, ils n'ont pas précisé s'ils utilisaient un GPU local ou un GPU cloud.

Le GPU le plus populaire est la dernière carte accélératrice d'IA haut de gamme NVIDIA A100 (A100 40 Go et A100 80 Go sont réunis ici car le gagnant ne peut pas toujours faire la distinction entre les deux) et est couramment utilisé plusieurs A100. - Par exemple, le gagnant du concours Turtle Recall de Zindi a utilisé 8 GPU A100 (40 Go), et les deux autres gagnants ont utilisé 4 A100.

Formation d'équipe

De nombreuses compétitions autorisent jusqu'à 5 participants par équipe, et les équipes peuvent être formées à partir d'individus ou d'équipes plus petites qui sont « fusionnées » avant une certaine date limite avant la date limite de soumission des résultats.

Certaines compétitions permettent des équipes plus grandes, par exemple, l'Open Data Challenge de Waymo autorise jusqu'à 10 personnes par équipe.

Conclusion

Ceci est un aperçu approximatif du concours d'apprentissage automatique 2022. J'espère que vous pourrez y trouver des informations utiles.

De nombreux nouveaux concours passionnants arriveront en 2023 et nous sommes impatients de publier davantage d'informations à leur fin.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI