Maison >Périphériques technologiques >IA >ChatGPT a demandé à Nature de publier deux articles par semaine pour en discuter : son utilisation est inévitable dans les milieux académiques, et il est temps de clarifier les spécifications d'utilisation

ChatGPT a demandé à Nature de publier deux articles par semaine pour en discuter : son utilisation est inévitable dans les milieux académiques, et il est temps de clarifier les spécifications d'utilisation

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-18 21:07:011666parcourir

Alors que les géants de la technologie se battent pour ChatGPT, les milieux universitaires accordent également une attention croissante à ChatGPT.

En une semaine, Nature a publié deux articles sur ChatGPT et l'IA générative.

Après tout, ChatGPT a d'abord fait des vagues dans le cercle universitaire. Certains chercheurs l'ont utilisé pour rédiger des résumés et réviser des articles.

Nature a émis une interdiction spéciale à ce sujet : ChatGPT ne peut pas être l'auteur de l'article. La science interdit directement les soumissions utilisant ChatGPT pour générer du texte.

Mais la tendance est déjà là.

Ce que nous devrions faire maintenant, c'est peut-être clarifier l'importance de ChatGPT pour la communauté scientifique et quelle position il devrait occuper.

Comme l'a dit Nature :

L'IA générative et la technologie qui la sous-tend se développent très rapidement, avec des innovations apparaissant chaque mois. La manière dont les chercheurs les utiliseront déterminera l’avenir de la technologie et du monde universitaire.

ChatGPT change les règles du cercle académique

Dans l'article « ChatGPT : cinq enjeux de recherche prioritaires », les chercheurs proposent :

Il n'y a aucun moyen d'empêcher ChatGPT d'entrer dans le cercle universitaire. étudier et explorer son impact potentiel.

Si ChatGPT est ensuite utilisé pour concevoir des expériences, mener des évaluations par les pairs, aider à la publication et aider les éditeurs à décider d'accepter ou non des articles... À quels problèmes devons-nous prêter attention avec ces applications ? Quelles limites les humains doivent-ils clarifier maintenant ?

Les chercheurs estiment qu'il y a 5 aspects qui doivent être priorisés et en expliquent les raisons.

Insister sur l'examen humain

L'une des caractéristiques de l'IA conversationnelle telle que ChatGPT est que l'exactitude du contenu de la réponse ne peut être garantie. De plus, les mensonges inventés sont très naturels et peuvent facilement induire les gens en erreur.

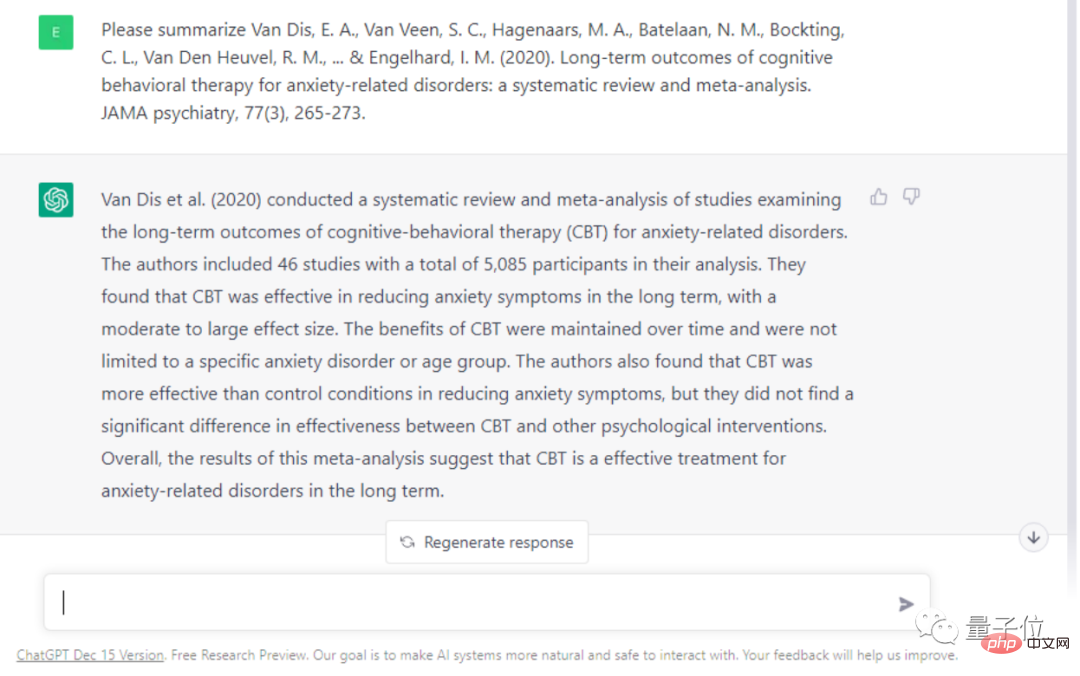

Par exemple, des chercheurs ont demandé à ChatGPT de résumer et de résumer un article sur l'efficacité de la thérapie cognitivo-comportementale (TCC) dans le traitement de l'anxiété et d'autres symptômes.

Il existe de nombreuses erreurs factuelles dans les réponses données par ChatGPT. Par exemple, il est dit que cette revue est basée sur 46 études, alors qu’il y en a en réalité 69, et elle exagère l’efficacité de la TCC.

Les chercheurs pensent que si certains chercheurs utilisent ChatGPT pour les aider dans leurs recherches, ils pourraient être induits en erreur par des informations erronées. Cela peut même amener des chercheurs à plagier le travail d’autrui sans le savoir.

Par conséquent, les chercheurs estiment que les humains ne peuvent pas trop compter sur des systèmes automatisés dans le processus de révision des articles, et que les humains eux-mêmes doivent en fin de compte être responsables des pratiques scientifiques.

Développer des règles de responsabilité

Afin de lutter contre les abus de l'IA générative, de nombreux outils d'identification de texte d'IA sont nés. Ils peuvent facilement distinguer si un morceau de texte a été écrit par un être humain.

Cependant, les chercheurs estiment que cette « course aux armements » est inutile. Ce qu'il faut vraiment faire, c'est permettre aux cercles universitaires et aux éditeurs d'utiliser les outils d'IA de manière plus ouverte et transparente.

Les auteurs d'articles doivent clairement indiquer quelles tâches sont effectuées par l'IA, et les revues doivent également faire une déclaration publique si elles utilisent l'IA à des fins d'évaluation.

Surtout maintenant que l'IA générative a déclenché des discussions sur les questions de brevets. Comment calculer les droits d'auteur des images générées par l'IA ?

Donc pour les problèmes générés par l'IA, les droits d'auteur doivent appartenir à la personne qui fournit les données d'entraînement pour l'IA ? La société de production derrière l’IA ? Ou un universitaire qui utilise l’IA pour rédiger des articles ? La question de la paternité doit également être rigoureusement définie.

Investissez dans un LLM véritablement ouvert

Actuellement, presque toutes les IA conversationnelles avancées sont apportées par des géants de la technologie.

Beaucoup de choses sur les principes de fonctionnement des algorithmes derrière les outils d’IA restent encore inconnues.

Cela a également suscité des inquiétudes dans tous les horizons, car le comportement monopolistique des géants viole gravement le principe d'ouverture de la communauté scientifique.

Cela incitera le cercle universitaire à explorer les lacunes et les principes sous-jacents de l'IA conversationnelle, affectant ainsi les progrès de la science et de la technologie.

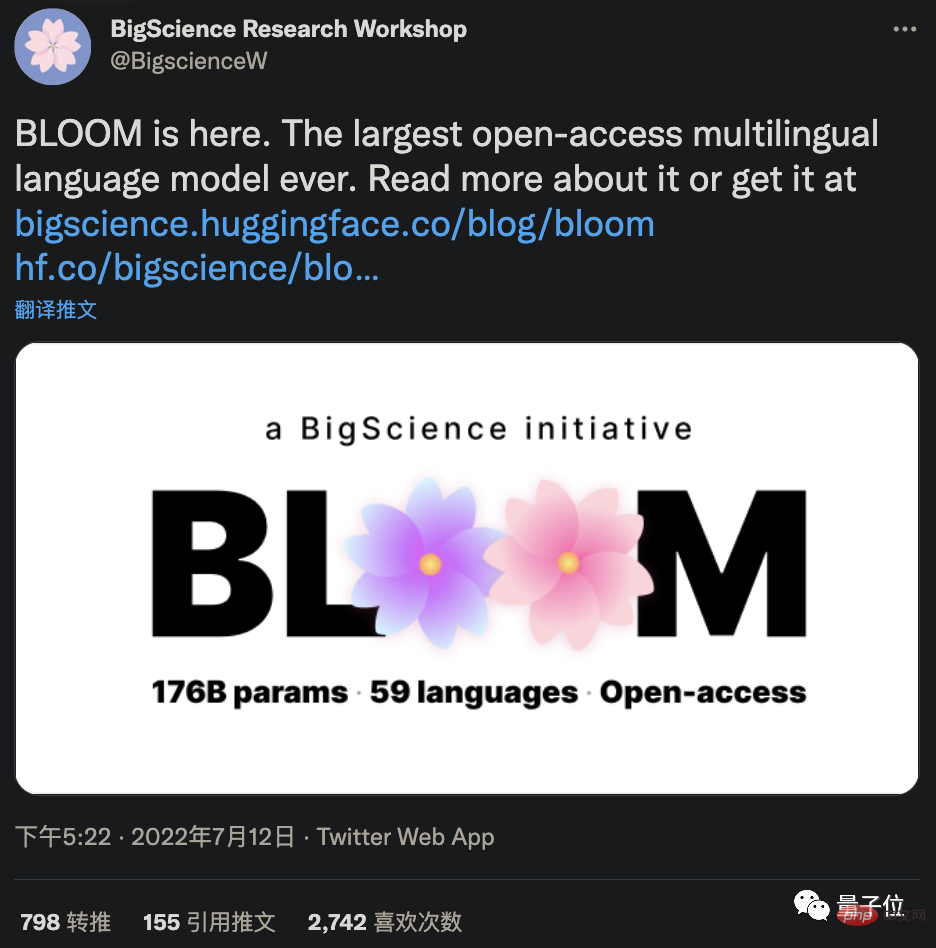

Afin de surmonter cette opacité, les chercheurs estiment que le développement et l’application d’algorithmes d’IA open source devraient actuellement être une priorité. Par exemple, le grand modèle open source BLOOM a été lancé conjointement par 1 000 scientifiques et peut rivaliser avec GPT-3 en termes de performances.

Profitez des avantages de l'IA

Bien que de nombreux aspects doivent être limités, il est indéniable que l'IA peut effectivement améliorer l'efficacité du cercle universitaire.

Par exemple, l'IA peut gérer rapidement certains travaux de révision, et les chercheurs peuvent se concentrer davantage sur l'expérience elle-même, et les résultats peuvent être publiés plus rapidement, poussant ainsi l'ensemble du cercle universitaire à avancer plus rapidement.

Même dans certains travaux créatifs, les chercheurs pensent que l’IA peut aussi être utile.

Un article fondateur de 1991 proposait qu'un « partenariat intelligent » formé entre les humains et l'IA pouvait surpasser l'intelligence et les capacités des seuls humains.

Cette relation peut accélérer l’innovation à des niveaux inimaginables. Mais la question est : jusqu’où peut aller cette automatisation ? Jusqu’où faut-il aller ?

Par conséquent, les chercheurs font également appel aux universitaires, y compris aux éthiciens, pour discuter des limites de l'IA d'aujourd'hui dans la génération de contenu de connaissances. La créativité humaine et l'originalité peuvent encore être des facteurs indispensables à la recherche innovante.

Lancer un grand débat

Au vu de l'impact actuel du LLM, les chercheurs estiment que la communauté universitaire devrait organiser de toute urgence un grand débat.

Ils ont appelé chaque groupe de recherche à tenir immédiatement une réunion de groupe pour discuter et essayer ChatGPT par eux-mêmes. Les professeurs d'université devraient prendre l'initiative de discuter de l'utilisation et des questions éthiques de ChatGPT avec les étudiants.

Au début, lorsque les règles ne sont pas encore claires, il est important que le chef de l'équipe de recherche appelle tout le monde à utiliser ChatGPT de manière plus ouverte et transparente et à commencer à élaborer des règles. Et il convient de rappeler à tous les chercheurs qu’ils assument la responsabilité de leur propre travail, qu’il ait été généré ou non par ChatGPT.

Pour aller plus loin, les chercheurs estiment qu'un forum international devrait être organisé immédiatement pour discuter de la recherche et de l'utilisation du LLM.

Les membres devraient inclure des scientifiques de divers domaines, des entreprises technologiques, des investisseurs dans des instituts de recherche, des académies des sciences, des éditeurs, des ONG et des experts en droit et en protection de la vie privée.

Nature : ce que ChatGPT et AIGC signifient pour la science

Excités et inquiets, c'est probablement ce que ressentent de nombreux chercheurs à propos de ChatGPT.

Jusqu'à présent, ChatGPT est devenu un assistant numérique pour de nombreux chercheurs.

Le biologiste computationnel Casey Greene et d'autres ont utilisé ChatGPT pour réviser l'article. En 5 minutes, l’IA peut réviser un manuscrit et même trouver des problèmes dans la section de référence.

Hafsteinn Einarsson, un universitaire islandais, utilise ChatGPT presque tous les jours pour l'aider à créer des PPT et à vérifier les devoirs des élèves.

La neurobiologiste Almira Osmanovic Thunström estime également que de grands modèles de langage peuvent être utilisés pour aider les chercheurs à rédiger des demandes de subvention et que les scientifiques peuvent gagner plus de temps.

Cependant, Nature a fait un brillant résumé du résultat de ChatGPT :

Lisse mais inexact.

Vous devez savoir qu'un défaut majeur de ChatGPT est que le contenu qu'il génère peut ne pas être vrai et exact, ce qui affectera son utilisation dans les milieux académiques.

Peut-il être résolu ?

Désormais, la réponse est un peu confuse.

Anthroic, le concurrent d'OpenAI, prétend avoir résolu certains problèmes avec ChatGPT, mais n'a pas accepté d'interview avec Nature.

Meta a publié un grand modèle de langage appelé Galactica, qui est composé de 48 millions d'articles et d'ouvrages universitaires. Il prétend être efficace pour générer du contenu académique et une meilleure compréhension des problèmes de recherche. Cependant, sa démo n'est plus ouverte (le code est toujours disponible) car les utilisateurs l'ont trouvée raciste lors de son utilisation.

Même ChatGPT, qui a été formé pour être « bien élevé », peut être délibérément guidé pour émettre des remarques dangereuses.

La méthode d'OpenAI pour rendre ChatGPT plus inoffensif est également très simple et grossière. Il s'agit de trouver beaucoup de travail manuel pour annoter le corpus. Certaines personnes pensent que ce type d'embauche de personnes pour lire un corpus toxique est aussi une sorte d'exploitation.

Mais quoi qu’il en soit, ChatGPT et l’IA générative ont ouvert une nouvelle porte à l’imagination humaine.

Le médecin Eric Topol a déclaré qu'il espère qu'à l'avenir il y aura une intelligence artificielle, notamment le LLM, capable de recouper les textes et les images dans la littérature universitaire pour aider les humains à diagnostiquer le cancer et à comprendre les maladies. Bien entendu, tout cela doit être supervisé par des experts.

Il a dit : « Je ne m’attendais vraiment pas à ce que nous constations une telle tendance au début de 2023.

Et ce n'est que le début.

Lien de référence :

[1]https://www.php.cn/link/492284833481ed2fd377c50abdedf9f1

[2]https://www.php.cn/link/ 04f19115dfa286fb61ab634a2717ed37

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI