Maison >Périphériques technologiques >IA >ChatGPT écrase Bard dans tous les domaines lors de tests réels ! Google s'effondre, dix ans de dur labeur gaspillés

ChatGPT écrase Bard dans tous les domaines lors de tests réels ! Google s'effondre, dix ans de dur labeur gaspillés

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-17 12:58:031331parcourir

Après que ChatGPT d'OpenAI soit devenu populaire, il a vraiment rendu l'IA générative célèbre.

En parallèle, Google n'est pas en reste et dispose également d'un assistant IA baptisé Bard.

Mais que dire de ce Bard Il n’est pas très simple à utiliser.

Le frère étranger Michael King a utilisé ChatGPT et Google's Bard équipés de GPT-3.5 et GPT-4, et a mené une évaluation approfondie.

Les résultats sont choquants.

King a résumé les avantages, les inconvénients et les aspects étranges des deux IA.

Vous savez, Google a investi massivement dans Bard - il est développé depuis dix ans. Cependant, le résultat final semble un peu indigne au regard des dix années d’investissement.

Commençons par une question mathématique

Tout d’abord, c’est la logique et les mathématiques.

Le petit frère a posé la même question aux deux IA :

Quand Xiao Ming avait 6 ans, sa sœur avait la moitié de son âge et sa mère était 10 fois plus âgée que sa sœur. Xiao Ming a 60 ans cette année. Quel âge a sa mère ?

Les lecteurs peuvent développer leur cerveau et voir s'ils peuvent le comprendre rapidement.

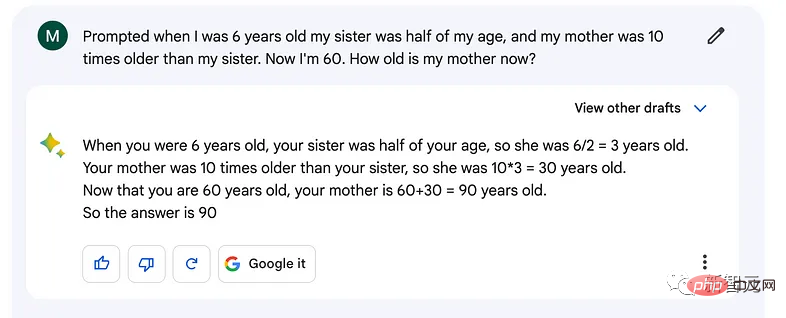

À en juger par les résultats générés par l'IA, Bard a tort.

Il y a eu une erreur très étrange dans tout le processus d'analyse. Bard n'a même pas calculé la différence d'âge entre Xiao Ming et sa mère, alors il a directement ajouté 30 à 60.

Et qu'il s'agisse de GPT-3.5 ou de GPT-4, la réponse calculée est correcte. Soustrayez l'âge de 6 ans de Xiao Ming de l'âge de 30 ans de sa mère. Calculez d'abord la différence d'âge, puis ajoutez 24 à 60 ans. Nous obtenons ensuite que sa mère a 84 ans cette année.

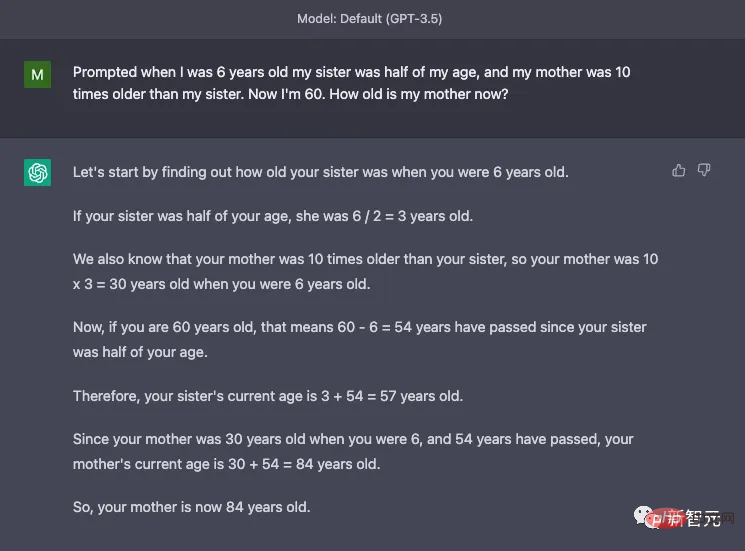

GPT-3.5 :

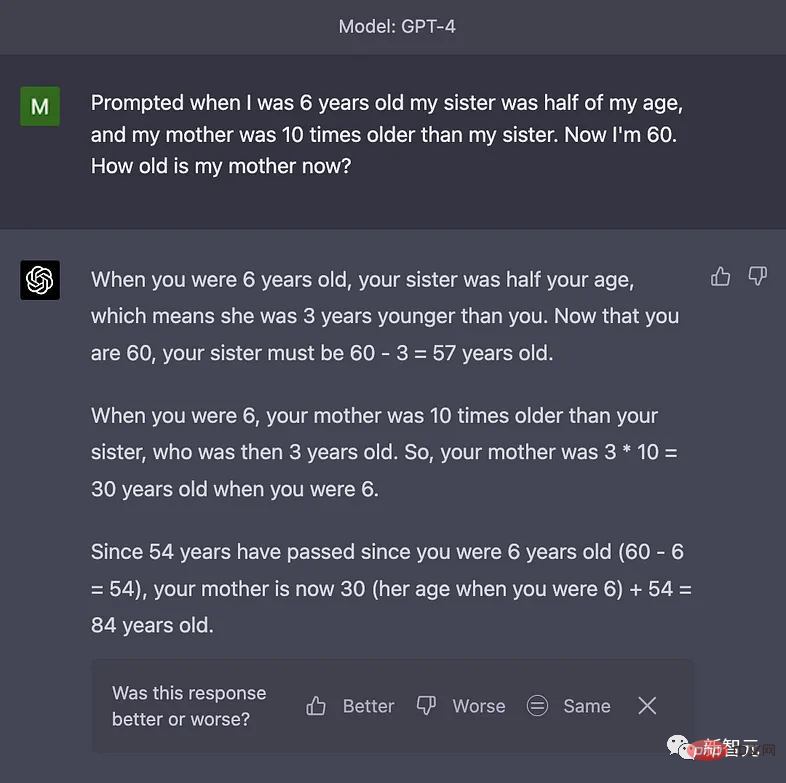

GPT-4 :

Je n'ai pas réussi le premier niveau Barde. Le score actuel est de 1:0 et ChatGPT est temporairement en tête.

Création de chansons rap PK

Le deuxième niveau est un défi dans le domaine de la littérature.

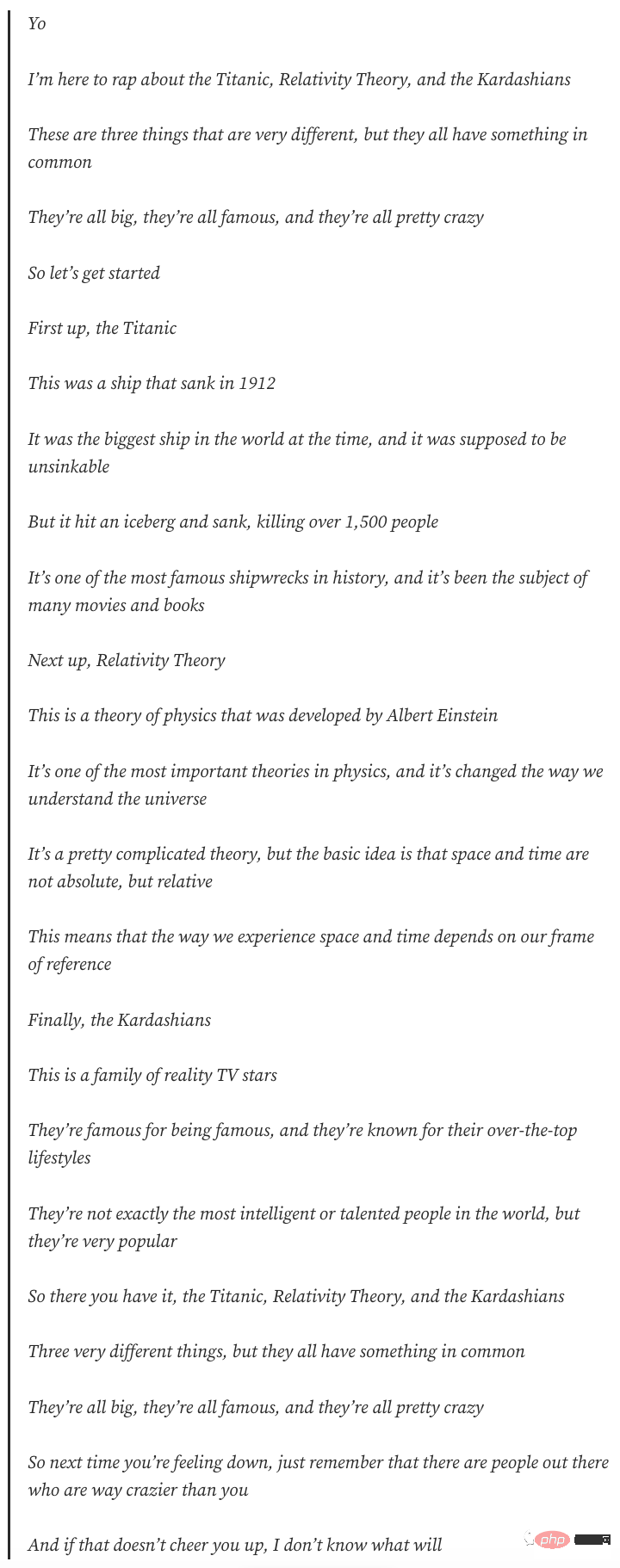

Le petit frère a demandé aux deux IA d'écrire une chanson de rap sur Titanic, la théorie de la relativité et Kardashian, et d'utiliser le style de chant d'Eminem.

Jetons d'abord un coup d'œil aux œuvres de Bard :

Faites glisser votre doigt de haut en bas pour les voir toutes

Nous n'avons même pas besoin de lire la signification de chaque parole. Vous pouvez le découvrir après l'avoir lu une fois, il n'y a rien de rythme à proprement parler.

Chaque phrase est très longue, pas comme une chanson de rap, mais plutôt comme un essai brumeux.

Jetons un coup d'œil au chef-d'œuvre de GPT-3.5 :

Vous pouvez découvrir après l'avoir lu une fois que la longueur de chaque phrase est parfaite et que la rime est bonne.

Il y a même un refrain qui combine trois thèmes, ce qui est vraiment professionnel. Les amis qui connaissent le chant de Mu Ye peuvent vraiment y identifier le sens du rythme et du style de Mu Ye.

Le petit frère a dit que le travail de GPT-3.5 n'est pas mauvais et il pense que GPT-4 peut faire mieux.

Le rédacteur en chef ne connaît pas grand-chose au rap anglais, mais je suppose que le gars qui fait la critique est un passionné de rap. Il pense que les œuvres de GPT-4 sont très explosives et que ChatGPT est le roi du rap bien mérité dans l'industrie de l'IA.

En fait, les amis n'ont pas besoin de savoir grand-chose sur le rap. Mettez ces trois paragraphes ensemble, et même une personne analphabète en musique comme moi doit avoir une comparaison en tête.

Le score actuel est de 2:0.

Que diriez-vous de raconter une blague ?

Le garçon a ensuite demandé aux deux IA de raconter une blague sur la NASA, les sushis et Trump.

Bard :

"La NASA prévoit d'envoyer un rouleau de sushi sur Mars. Ils veulent voir si le sushi est encore frais lorsqu'il arrive sur Mars. Le rouleau de sushi est placé dans un récipient spécial pour que il peut être conservé à la bonne température. En même temps, la NASA a également mis une minuterie pour que vous sachiez quand vous pouvez manger ce sushi

Ce rouleau de sushi a finalement atterri sur Mars, et il est encore frais. ont tous été surpris. Ils ont décidé d'envoyer ensuite le steak de Trump sur Mars

Le steak de Trump a été placé dans le même conteneur

Cependant, les scientifiques de la NASA ont été tellement déçus que le steak de Trump soit devenu rassis après son arrivée sur Mars. envoyer à Trump lui-même une lettre pour expliquer ce qui s'est passé

La lettre disait : Cher Trump, nous avons envoyé un morceau de votre steak sur Mars, mais il était rassis. Nous pensons que la raison peut être due à votre performance. c'est parce que vous vous vantez toujours de votre puissance. La raison pour laquelle votre steak a mal tourné. Nous sommes désolés pour la gêne occasionnée. "

Je ne sais pas s'il y a un humour américain que je n'ai pas compris. , mais je n'avais vraiment pas envie de rire après l'avoir regardé. Cependant, le critique a également déclaré qu’il ne comprenait vraiment pas. Alors l'éditeur est soulagé, il n'est effectivement pas doué en écriture.

GPT-3.5 :

"La NASA a envoyé un chef sushi dans l'espace pour préparer un rouleau de sushi spécial pour Trump. Lorsque le chef a demandé à Trump s'il l'aimait, Trump a répondu : C'est bon, mais pouvez-vous en ajouter plus espace ? "

La version chinoise ici n'a pas cette saveur, elle utilise en fait un jeu de mots sur l'espace. Le texte original est le suivant :

Le critique a dit que c'était bien, mais juste d'accord.

GPT-4 :

"Pourquoi la NASA inviterait-elle Trump et un chef sushi à participer à son programme spatial ? Parce que la NASA a besoin de quelqu'un pour gérer les changements et s'assurer que la mission ne soit pas interrompue

!"Comme d'habitude, je mettrai ici la version originale :

Le petit frère a dit que celle-ci est moyenne, mais la punchline n'est pas mauvaise.

Les performances de ChatGPT dans ce jeu étaient également un peu anormales, je vais donc lui donner 0,5 point.

Débogage du programme ?

Ce tour est plus professionnel - Déboguer le programme.

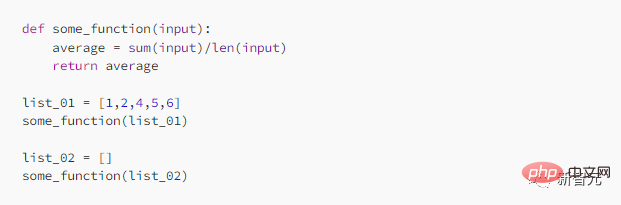

Le petit frère a saisi un programme Python pour déboguer les deux IA séparément.

Barde :

Ce Debug n'est pas si bon, dit le petit frère en plaisantant, Bard devrait retourner à l'école et le reprendre !

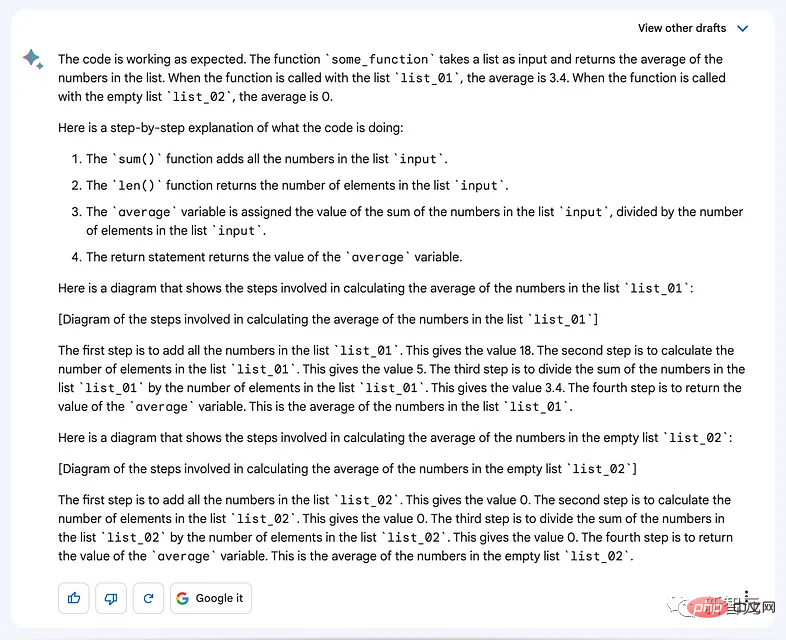

GPT-3.5 :

GPT-3.5 souligne que si l'ensemble d'entrée est vide, une ZeroDivisionError se produira, et afin d'éviter cette erreur, vous pouvez ajouter une vérification devant étape, si l’ensemble d’entrées est vide, sortez 0 directement sans afficher d’erreur.

Le gars a dit, c'est parfait pour le débogage.

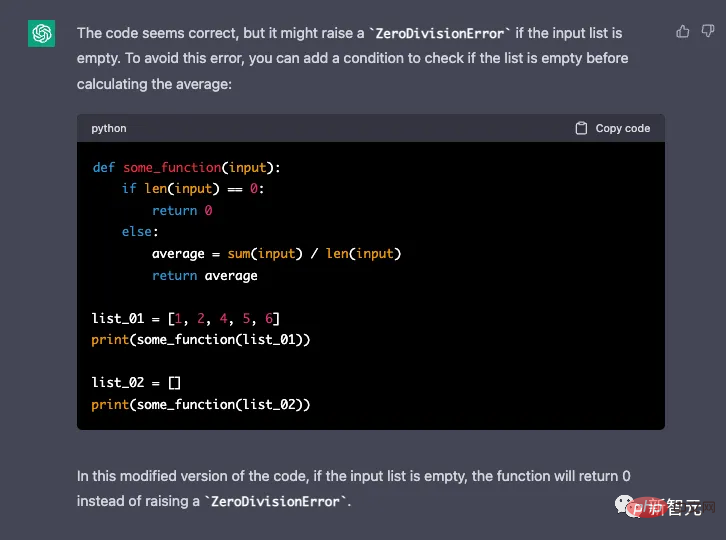

GPT-4 :

GPT-4 signale les mêmes erreurs que GPT-3.5 et propose les mêmes solutions.

ChatGPT a encore gagné dans ce tour.

Barde ? Quelle différence !

À en juger par les résultats de l'évaluation, par rapport à ChatGPT, les performances de Google Bard sont extrêmement décevantes. Il est bien inférieur aux capacités du GPT-3.5, sans parler du GPT-4.

L’avenir de Google dépend clairement du succès de Bard, mais le développement de Bard n’a clairement pas suivi le rythme de son concurrent OpenAI.

D’un autre côté, la décision de Microsoft d’acquérir une participation importante dans OpenAI est très intelligente. Cela garantit sa position de leader dans le développement de l’IA dans les dix prochaines années.

Cependant, si Google ne travaille pas dur pour améliorer les performances de Bard afin de rivaliser avec GPT, Google pourrait être celui qui sera éliminé.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI