Maison >Périphériques technologiques >IA >Le père du LSTM a encore une fois défié LeCun : Vos cinq points « d'innovation » m'ont tous été copiés ! Mais malheureusement, 'je ne peux pas le relire'

Le père du LSTM a encore une fois défié LeCun : Vos cinq points « d'innovation » m'ont tous été copiés ! Mais malheureusement, 'je ne peux pas le relire'

- 王林avant

- 2023-04-16 10:04:021037parcourir

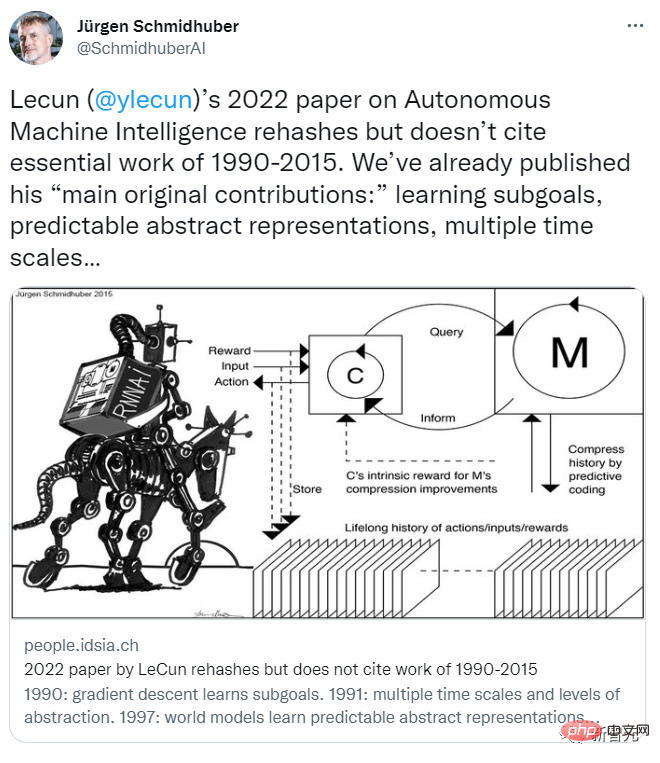

Récemment, Jürgen Schmidhuber, le père du LSTM, a de nouveau eu un désaccord avec LeCun !

En fait, les étudiants qui connaissent un peu cet homme grincheux savent qu'il y a eu des désagréments entre le non-conformiste Jürgen Schmidhuber et plusieurs grands noms de la communauté du machine learning.

Surtout lorsque "ces trois personnes" ont remporté le prix Turing ensemble, mais pas Schmidhuber, le vieil homme est devenu encore plus en colère...

Après tout, Schmidhuber a toujours cru que ces ML étaient désormais des personnalités telles que Bengio, Hinton, LeCun, y compris le père de « GAN » Goodfellow et d'autres, bon nombre de leurs soi-disant « résultats pionniers » ont été proposés pour la première fois par eux-mêmes, et ces personnes ne l'ont pas du tout mentionné dans le journal.

Pour cette raison, Schmidhuber a écrit un jour un article spécial pour critiquer l'article de synthèse "Deep Learning" publié par Bengio, Hinton et LeCun dans Nature en 2015.

Parlant principalement des résultats dans cet article, des choses qu'il a mentionnées en premier et des choses qui ont été mentionnées en premier par d'autres personnes âgées. Quoi qu'il en soit, ce ne sont pas les trois auteurs qui l'ont mentionné en premier.

Pourquoi tu te disputes encore ?

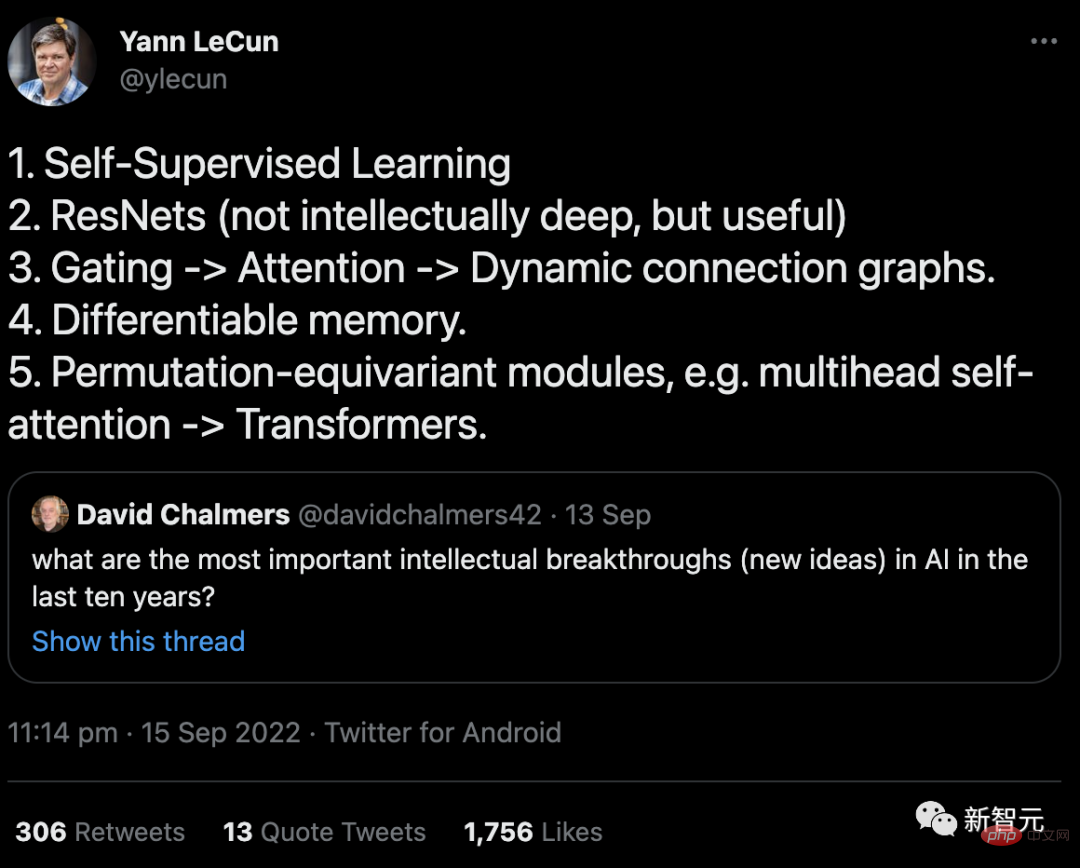

Retour à la cause de cet incident, il s'agissait en fait d'un tweet envoyé par LeCun en septembre.

Le contenu est une réponse à la question du professeur David Chalmers : "Quelle est la percée intellectuelle (nouvelle idée) la plus importante dans l'IA au cours des dix dernières années ?"

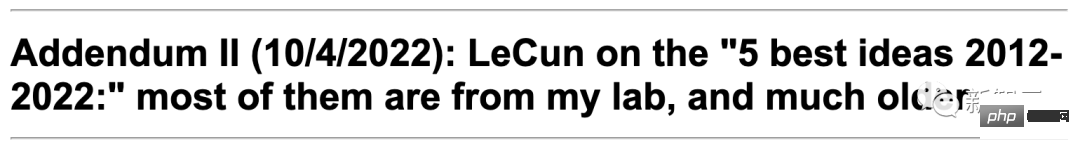

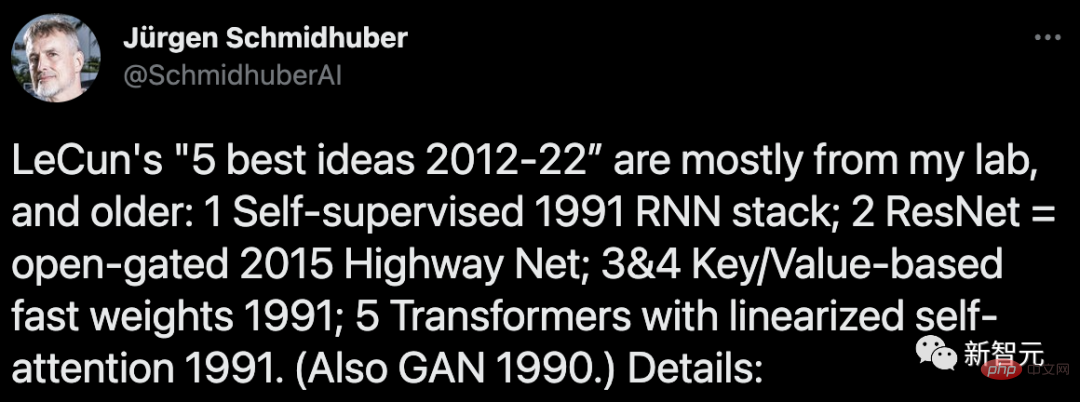

Le 4 octobre, a déclaré Schmidhuber. dans son Un article sur le blog a écrit avec colère : La plupart de ces cinq « meilleures idées » sont venues de mon laboratoire, et elles ont été proposées bien avant le délai des « 10 ans ».

Dans l'article, Schmidhuber a énuméré en détail six éléments de preuve pour étayer son argument.

Mais probablement parce que trop peu de gens l'ont vu, Schmidhuber a de nouveau tweeté le 22 novembre pour attiser à nouveau ce "riz froid".

Cependant, par rapport à la dernière fois, qui avait été une dispute assez houleuse, cette fois LeCun n'y a même pas prêté attention...

Le père du LSTM a présenté "six pièces majeures de évidence"

1. "Apprentissage auto-supervisé" qui génère automatiquement des annotations via des réseaux de neurones (NN) : Cela remonte au moins à mon travail en 1990-91.

(I) Apprenez à compresser des séquences de données à plusieurs échelles de temps et niveaux d'abstraction via la génération d'objets auto-supervisés dans un réseau neuronal récurrent (RNN) via un codage prédictif.

Ici, un RNN « automate » apprend la pré-tâche de « prédire la prochaine entrée » et envoie des observations inattendues dans le flux de données entrant comme cibles au RNN « chunker », qui apprend les régularités de niveau supérieur puis affine leur acquis des connaissances prédictives dans l’automate via des objectifs de formation appropriés.

Cela facilite grandement les tâches d'apprentissage profond en aval de classification de séquences qui étaient auparavant insolubles.

(II) Génération d'annotations auto-supervisée via une motivation intrinsèque de type GAN, où un modèle mondial NN apprend à prédire les conséquences comportementales d'un contrôleur NN contradictoire, générateur d'annotations et inventé expérimentalement.

De plus, le terme « auto-supervision » apparaissait déjà dans le titre de l'article que j'ai publié en 1990.

Mais ce mot a également été utilisé dans un article antérieur (1978)...

2. "ResNets" : En fait, ce sont Highway Nets que j'ai proposé très tôt. Mais LeCun pense que l'intelligence des ResNets n'est « pas profonde », ce qui me rend très triste.

Avant de proposer Highway Nets, les réseaux à rétroaction ne comportaient que quelques dizaines de couches (20 à 30 couches) au maximum, tandis que Highway Nets était le premier réseau neuronal à rétroaction véritablement profond avec des centaines de couches.

Dans les années 1990, mon LSTM a apporté une profondeur essentiellement infinie aux NN récursifs supervisés. Dans les années 2000, les Highway Nets inspirés du LSTM ont apporté de la profondeur aux NN à rétroaction.

En conséquence, LSTM est devenu le NN le plus cité au 20e siècle, et Highway Nets (ResNet) est le NN le plus cité au 21e siècle.

On peut dire qu'ils représentent l'essence du deep learning, et le deep learning concerne la profondeur du NN.

3. "Gating->Attention->Dynamic Connected Graph" : Il peut être retracé au moins à mes programmeurs de poids rapide et à mes réseaux de mémoire de valeurs clés de 1991 à 1993 (la "valeur clé" appelée "DE-À").

En 1993, j'ai introduit le terme « attention » tel que nous l'utilisons aujourd'hui.

Cependant, il convient de noter que la première porte de multiplication dans NN remonte à la machine d'apprentissage profond d'Ivakhnenko et Lapa en 1965.

4. "Mémoire différenciable" : Elle remonte également à mes programmeurs de poids rapide ou à mes réseaux de mémoire à valeurs clés en 1991.

Stockage et contrôle séparés comme dans les ordinateurs traditionnels, mais de manière différentielle de bout en bout, adaptative et entièrement neuronale (pas de manière hybride).

5. "Modules équivariants de remplacement, tels que l'auto-attention multi-têtes->Transformer": J'ai publié un Transformer avec une auto-attention linéarisée en 1991. Le terme correspondant « projecteurs d’attention internes » remonte à 1993.

6. "GAN est le meilleur concept d'apprentissage automatique des 10 dernières années"

Le principe du GAN (2014) que vous évoquez est en fait le principe que j'ai développé en 1990 avec l'intelligence artificielle Raised au nom de la curiosité.

La dernière fois, c'était il y a quelques mois

En fait, ce n'est pas la première fois que Schmidhuber et LeCun ont un différend cette année.

En juin et juillet, les deux hommes se sont disputés au sujet d'un rapport prospectif sur "l'orientation future de l'intelligence artificielle autonome" publié par LeCun.

Le 27 juin, Yann LeCun a publié l'article "A Path Towards Autonomous Machine Intelligence" qu'il préparait depuis plusieurs années, le qualifiant de "travail qui indique l'orientation future du développement de l'IA".

Cet article aborde systématiquement la question de "comment les machines peuvent apprendre comme les animaux et les humains" et fait plus de 60 pages.

LeCun a déclaré que cet article ne reflète pas seulement ses réflexions sur l'orientation générale du développement de l'IA dans les 5 à 10 prochaines années, mais aussi ce qu'il prévoit de rechercher au cours des prochaines années et espère inspirer davantage de personnes dans le Domaine de l'IA à étudier ensemble.

Et Schmidhuber a appris la nouvelle environ dix jours à l'avance, a obtenu le journal et a immédiatement écrit un article pour la réfuter.

Selon le propre article de blog de Schmidhuber, voici ce qui s'est passé à l'époque :

Le 14 juin 2022, un média scientifique a annoncé que LeCun publierait un rapport le 27 juin. Il m'a envoyé une ébauche du rapport (il était encore confidentiel à l'époque) et m'a demandé de commenter.

J'ai écrit une critique leur disant qu'il s'agissait essentiellement d'une réplique de notre travail précédent, qui n'était pas mentionné dans l'article de LeCun.

Cependant, mes opinions sont tombées dans l’oreille d’un sourd.

En fait, bien avant la publication de son article, nous avions proposé dans cet article la plupart des soi-disant « principales contributions originales » de LeCun, notamment :

(1) « Architecture cognitive dans laquelle tous les modules sont séparables et de nombreux modules peuvent être formés » (proposé par nous en 1990).

(2) "Prédire les structures hiérarchiques des modèles du monde, apprendre des représentations à plusieurs niveaux d'abstraction et à plusieurs échelles de temps" (nous avons proposé en 1991).

(3) "Paradigme d'apprentissage auto-supervisé qui produit des représentations à la fois informatives et prévisibles" (Notre modèle est utilisé en apprentissage par renforcement et en modélisation du monde depuis 1997)

( 4) Modèles prédictifs "pour l'apprentissage hiérarchique planification sous incertitude", y compris les générateurs de sous-objectifs neuronaux basés sur un gradient (1990), le raisonnement dans des espaces de concepts abstraits (1997) et "l'apprentissage des actions principalement par l'observation". Les réseaux de neurones (2015) et apprendre à penser (2015) ont tous deux été proposés par nous d'abord.

Le 14 juillet, Yann LeCun a répondu en affirmant que la discussion devait être constructive. Il a dit ceci :

Je ne veux pas me lancer dans un débat vide de sens sur "qui a inventé un certain concept ?" Je ne veux pas fouiller dans les 160 références répertoriées dans votre article de réponse. Je pense qu'une approche plus constructive serait d'identifier 4 publications qui, selon vous, pourraient contenir des idées et des méthodes issues des 4 contributions que j'ai répertoriées.

Comme je l'ai dit au début de cet article, il existe de nombreux concepts qui existent depuis longtemps, et ni vous ni moi ne sommes les inventeurs de ces concepts : par exemple, le concept de modèles mondiaux affinables , qui remonte aux premiers jours du contrôle d'optimisation des travaux.

La formation du modèle mondial utilise des réseaux de neurones pour apprendre l'identification du système du modèle mondial. Cette idée remonte à la fin des années 1980, avec les travaux de Michael Jordan, Bernie Widrow, Robinson & Fallside, Kumpathi Narendra, Paul Werbos, tous meilleurs. que le vôtre. Travaillez plus tôt.

À mon avis, cette réponse d'homme de paille semble être LeCun qui change de sujet et évite la question de s'attribuer le mérite des autres dans sa soi-disant "contribution originale principale".

J'ai répondu le 14 juillet :

Concernant ce que vous avez dit à propos de « quelque chose que ni vous ni moi n'avons inventé » : Votre article affirme que l'utilisation des réseaux de neurones pour l'identification des systèmes remonte au début des années 1990. Cependant, dans votre réponse précédente, vous sembliez être d’accord avec moi sur le fait que les premiers articles sur ce sujet sont apparus dans les années 1980.

Quant à votre "principale contribution originale", ils ont en fait utilisé les résultats de mes premiers travaux.

(1) Concernant "l'architecture cognitive" que vous proposez, dans laquelle tous les modules sont différenciables et de nombreux modules peuvent être entraînés" et "le comportement est motivé par la motivation intrinsèque":

J'ai proposé une architecture différenciable pour l'apprentissage et la planification en ligne en 1990. Il s'agissait du premier contrôleur doté d'une « motivation intrinsèque » pour améliorer le modèle mondial. Il était à la fois génératif et contradictoire. Le GAN 2014 cité dans l'article est une version dérivée de ce modèle ;

(2) Concernant votre proposition de "structure hiérarchique de modèles du monde prédictifs qui apprennent des représentations à plusieurs niveaux d'abstraction et échelles de temps" :

Ceci est tiré de ma neurohistoire de 1991 que Compressor réalise. Il utilise un codage prédictif pour apprendre des représentations internes hiérarchiques de données à séquence longue de manière auto-supervisée, ce qui facilite grandement l'apprentissage en aval. En utilisant ma procédure de raffinement de réseau neuronal de 1991, ces représentations peuvent être regroupées en un seul réseau neuronal récurrent (RNN).

(3) Concernant votre "paradigme d'apprentissage auto-supervisé pour produire des représentations à la fois informatives et prévisibles" en termes de contrôle :

Cela était déjà proposé dans le système que j'ai proposé de construire en 1997 . Plutôt que de prédire tous les détails des entrées futures, il peut poser des questions abstraites arbitraires et donner des réponses calculables dans ce que vous appelez un « espace de représentation ». Dans ce système, deux modèles d'apprentissage appelés « cerveau gauche » et « cerveau droit » sélectionnent des adversaires avec des récompenses maximales pour s'engager dans des jeux à somme nulle, et parient occasionnellement sur les résultats de telles expériences informatiques.

(4) Concernant votre modèle différenciable prédictif de planification hiérarchique qui peut être utilisé sous incertitude, votre article dit ceci :

"Une question sans réponse est la suivante : comment le configurateur apprend à décomposer une tâche complexe en une série de sous-objectifs qui peuvent être complétés par l'agent seul. Je laisserai cette question à une enquête future. "

Ne dites rien sur l'avenir, en fait j'ai 30 ans. Cet article a été publié il y a de nombreuses années :

Un réseau neuronal de contrôleur est chargé d'obtenir une entrée de commande supplémentaire, qui est de la forme (démarrage, cible). Un réseau neuronal d’estimateur est chargé d’apprendre à prédire le coût attendu du début à l’objectif. Un générateur de sous-objectifs basé sur un réseau neuronal récurrent affinable voit cette entrée (début, objectif) et apprend une séquence de sous-objectifs intermédiaires à coût minimal via une descente de gradient à l'aide d'un réseau neuronal d'estimateur.

(5) Vous avez également souligné le réseau neuronal qui « apprend le comportement principalement par l'observation ». Nous avons en fait résolu ce problème très tôt, en 2015 avec cet article, qui traitait du problème général de l'apprentissage par renforcement (RL) dans des environnements partiellement observables.

Un modèle mondial M peut être doué pour prédire certaines choses mais incertain pour d'autres. Le contrôleur C maximise sa fonction objective en apprenant à interroger et à interpréter les réponses (plus de modèles d'activation) à travers une séquence de questions auto-inventées (modèles d'activation).

C peut bénéficier de l'apprentissage pour extraire tout type d'informations algorithmiques de M, comme pour la planification et le raisonnement hiérarchiques, en tirant parti des observations passives codées dans M, etc.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI