Maison >Périphériques technologiques >IA >Un GPU peut produire des modèles 3D en quelques secondes ! Le nouveau travail d'OpenAI : Point-E peut générer un modèle de nuage de points 3D à l'aide de texte

Un GPU peut produire des modèles 3D en quelques secondes ! Le nouveau travail d'OpenAI : Point-E peut générer un modèle de nuage de points 3D à l'aide de texte

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-15 08:58:02986parcourir

Où est la prochaine percée qui prendra d’assaut le monde de l’IA ?

Beaucoup de gens prédisent qu'il s'agit d'un générateur de modèles 3D.

Après que le DALL-E 2 lancé en début d'année ait surpris tout le monde avec son pinceau génial, OpenAI a publié mardi son dernier modèle de génération d'images "POINT-E", qui peut générer directement des modèles 3D à partir de texte.

Lien papier : https://arxiv.org/pdf/2212.08751.pdf

Par rapport aux concurrents (comme DreamFusion de Google) qui nécessitent plusieurs GPU pour fonctionner pendant plusieurs heures, POINT - E génère des images 3D en quelques minutes avec un seul GPU.

Après des tests réels par l'éditeur, POINT-E peut essentiellement produire des images 3D en quelques secondes après une saisie rapide. De plus, l'image de sortie prend également en charge l'édition personnalisée, l'enregistrement et d'autres fonctions.

Adresse : https://huggingface.co/spaces/openai/point-e

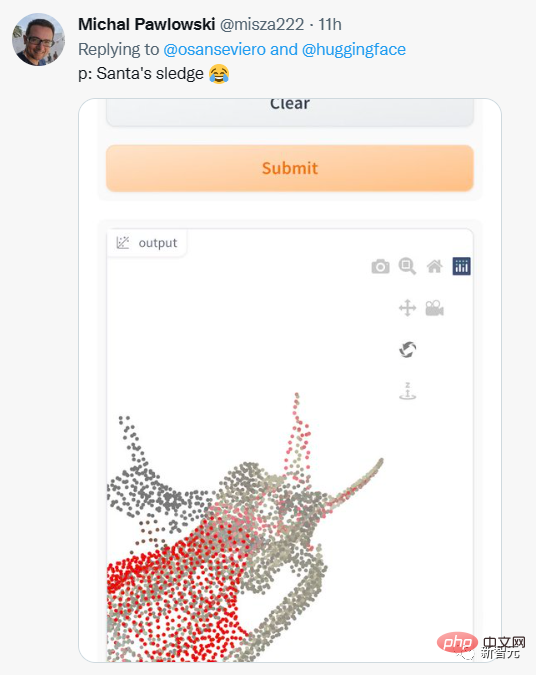

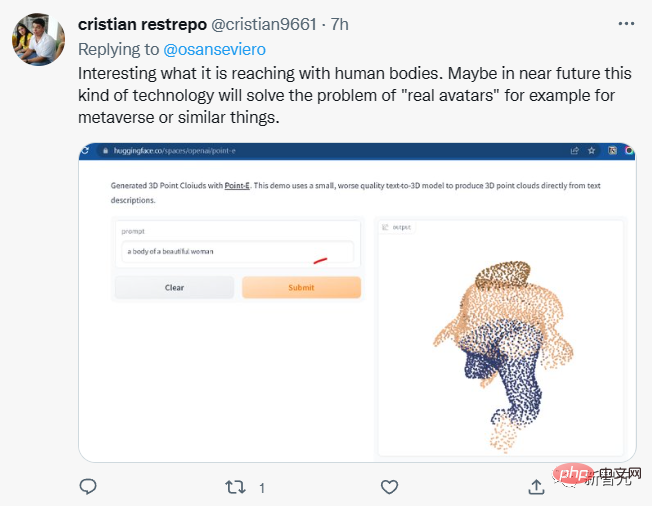

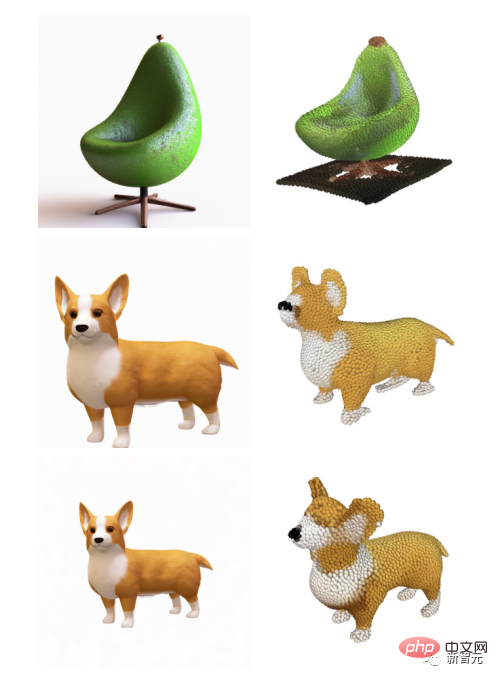

Les internautes ont également commencé à essayer différentes entrées d'invite.

Mais les résultats de sortie ne sont pas toujours satisfaisants.

Certains internautes ont dit que POINT-E pourrait être capable de réaliser la vision métaverse de Meta ?

Il est à noter que POINT-E génère des images 3D via un nuage de points (point cloud), qui est un ensemble de données de points dans l'espace.

Simplement parlant, il s'agit de collecter des données à travers un modèle tridimensionnel pour obtenir des données de nuage de points représentant une forme 3D dans l'espace.

Les nuages de points sont plus faciles à synthétiser d'un point de vue informatique, mais ils ne peuvent pas capturer la forme ou la texture délicate des objets, ce qui constitue actuellement un défaut du Point-E.

Pour remédier à cette limitation, l’équipe Point-E a formé un système d’intelligence artificielle supplémentaire pour convertir les nuages de points de Point-E en maillages.

Convertir le nuage de points Point-E en maillage

Au-delà du modèle de génération de maillage indépendant, Point-E se compose de deux modèles :

Un modèle de conversion texte-image (texte -modèle en image) et modèle 3D de conversion d'image (modèle image en 3D).

Le modèle de conversion texte en image est similaire au DALL-E 2 et à Stable Diffusion d'OpenAI, formé sur des images étiquetées pour comprendre l'association entre les mots et les concepts visuels.

Ensuite, un ensemble d'images appariées avec des objets 3D est introduit dans le modèle de transformation 3D afin que le modèle apprenne à se transformer efficacement entre les deux.

Lorsqu'une invite est saisie, le modèle de conversion d'image texte génère un objet de rendu synthétique, qui est transmis au modèle 3D de conversion d'image, qui génère ensuite un nuage de points.

Les chercheurs d'OpenAI affirment que Point-E a été formé sur un ensemble de données de millions d'objets 3D et de métadonnées associées.

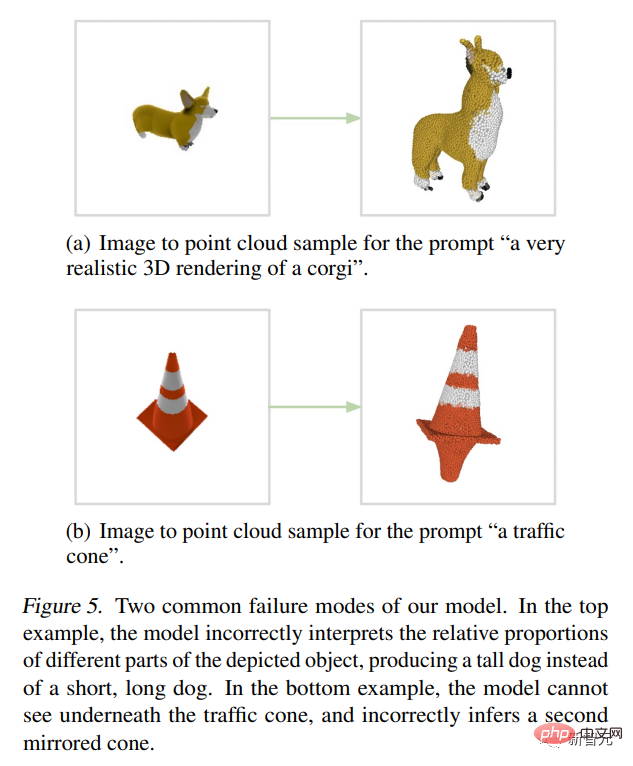

Mais ce n'est pas parfait, le modèle image-3D de Point-E ne parvient parfois pas à comprendre les images dans le modèle texte-image, ce qui entraîne des formes qui ne correspondent pas à l'indice du texte. Pourtant, c’est des ordres de grandeur plus rapides que les technologies de pointe précédentes.

Ils ont écrit dans le journal :

Bien que notre méthode soit moins performante que l'état de l'art en matière d'évaluation, elle génère des échantillons en une fraction du temps. Cela peut le rendre plus pratique pour certaines applications et découvrir des objets 3D de meilleure qualité.

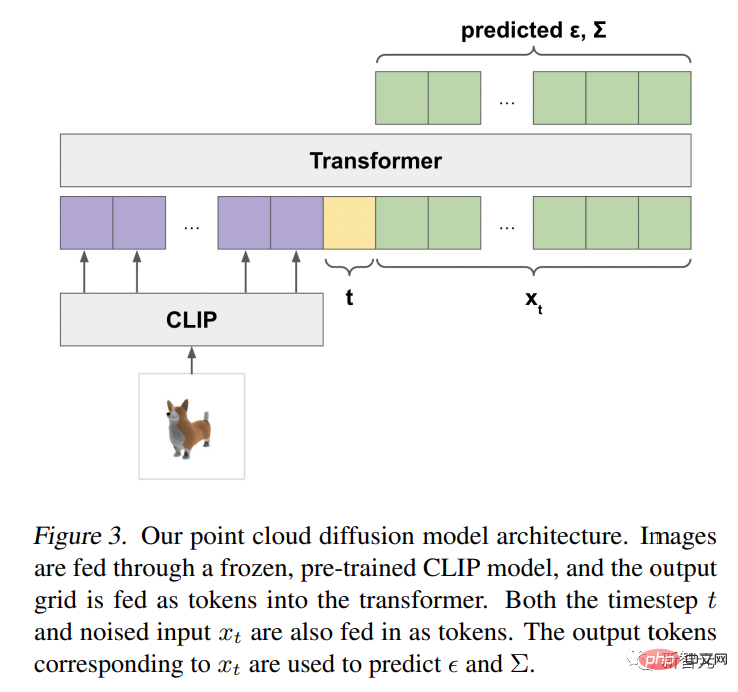

Architecture Point-E et mécanisme de fonctionnement

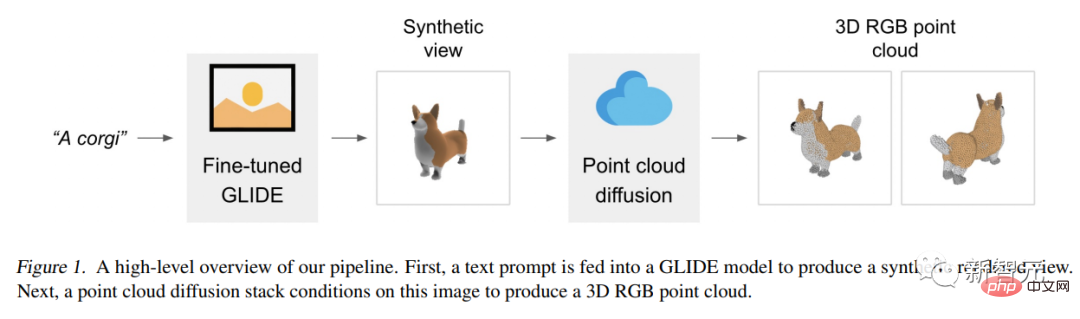

Le modèle Point-E utilise d'abord un modèle de diffusion texte-image pour générer une vue synthétique unique, puis utilise un deuxième modèle de diffusion pour générer un nuage de points 3D, qui est généré par Les images sont conditionnelles.

Bien que cette méthode ne soit pas encore à la pointe de la technologie en termes de qualité d'échantillonnage, elle est un à deux ordres de grandeur plus rapide, offrant un compromis pratique pour certains cas d'utilisation.

La figure suivante est un diagramme de pipeline de haut niveau du modèle :

Au lieu de former un modèle à génération unique et de générer directement des nuages de points conditionnés par du texte, nous divisons le processus de génération en trois étapes.

Tout d'abord, générez une vue complète conditionnée par le titre du texte.

Ensuite, générez un nuage de points approximatif (1 024 points) basé sur la vue synthétique.

Enfin, un nuage de points fins (4 096 points) conditionné sur le nuage de points basse résolution et la vue synthétique a été généré.

Après avoir entraîné des modèles sur des millions de modèles 3D, nous avons constaté que le format des données et la qualité des ensembles de données variaient considérablement, ce qui nous a incité à développer diverses étapes de post-traitement pour garantir une meilleure qualité des données.

Afin de convertir toutes les données dans un format commun, nous utilisons Blender pour restituer chaque modèle 3D en images RGBAD sous 20 angles de caméra aléatoires (Blender prend en charge plusieurs formats 3D et est livré avec un moteur de rendu optimisé).

Pour chaque modèle, un script Blender normalise le modèle dans un cube englobant, configure les paramètres d'éclairage standard et exporte enfin une image RGBAD à l'aide du moteur de rendu en temps réel intégré de Blender.

Ensuite, utilisez Render pour convertir chaque objet en un nuage de points coloré. Tout d’abord, un nuage de points dense est construit pour chaque objet en comptant les points pour chaque pixel de chaque image RGBAD. Ces nuages de points contiennent généralement des centaines de milliers de points inégalement répartis. Nous utilisons donc également l'échantillonnage des points les plus éloignés pour créer un nuage de points 4K uniforme.

En construisant des nuages de points directement à partir de rendus, nous sommes en mesure d'éviter divers problèmes qui peuvent survenir lors de l'échantillonnage directement à partir d'un maillage 3D, de l'échantillonnage de points contenus dans un modèle ou du traitement de modèles 3D stockés dans des formats de fichiers inhabituels.

Enfin, nous utilisons diverses heuristiques pour réduire la fréquence des modèles de mauvaise qualité dans notre ensemble de données.

Tout d'abord, nous éliminons les objets planaires en calculant le SVD de chaque nuage de points, en ne gardant que les objets dont la valeur singulière minimale est supérieure à un certain seuil.

Ensuite, nous regroupons l'ensemble de données par caractéristiques CLIP (pour chaque objet, nous faisons la moyenne des caractéristiques sur tous les rendus).

Nous avons constaté que certains clusters contenaient de nombreuses catégories de modèles de faible qualité, tandis que d'autres clusters semblaient plus diversifiés ou interprétables.

Nous divisons ces clusters en plusieurs compartiments de qualités différentes et utilisons un mélange pondéré des compartiments résultants comme ensemble de données final.

Perspectives d'application

Les chercheurs d'OpenAI ont souligné que le nuage de points de Point-E peut également être utilisé pour créer des objets du monde réel, tels que l'impression 3D.

Avec des modèles de conversion de maillage supplémentaires, le système peut également entrer dans les flux de travail de développement de jeux et d'animations.

Alors que tous les regards sont actuellement tournés vers les générateurs d’art 2D, l’IA de synthèse de modèles pourrait être le prochain grand perturbateur de l’industrie.

Les modèles 3D sont largement utilisés dans le cinéma et la télévision, la décoration intérieure, l'architecture et divers domaines scientifiques.

Actuellement, la fabrication de modèles 3D prend généralement plusieurs heures, et l'émergence du Point-E vient justement compenser cette lacune.

Les chercheurs affirment que Point-E présente encore de nombreux défauts à ce stade, comme des biais hérités des données d'entraînement et un manque de mesures de protection pour les modèles susceptibles d'être utilisés pour créer des objets dangereux.

Point-E n'est qu'un point de départ, ils espèrent qu'il inspirera "des travaux supplémentaires" dans le domaine de la synthèse texte-3D.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI