Maison >Périphériques technologiques >IA >'À mi-parcours dans le domaine de la vidéo' ! Le travail de test bêta interne de la recrue de génération vidéo AI Gen-2 a été divulgué, les internautes ont déclaré que c'était trop réaliste

'À mi-parcours dans le domaine de la vidéo' ! Le travail de test bêta interne de la recrue de génération vidéo AI Gen-2 a été divulgué, les internautes ont déclaré que c'était trop réaliste

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-14 23:10:011703parcourir

Gen-2, l'outil de génération vidéo IA qui prétend pouvoir filmer des superproductions en une phrase, a commencé à révéler ses vraies couleurs.

Un blogueur Twitter a pris la tête des qualifications pour la bêta fermée.

C'est le résultat qu'il a généré en utilisant le mot invite "Un homme bien proportionné ou symétrique a été interviewé dans un bar" :

J'ai vu un homme en chemise sombre regardant l'autre personne et parlant, ses yeux étaient amicaux. Son expression révélait du sérieux et de la franchise, et la personne en face de lui acquiesçait de temps en temps.

La vidéo dans son ensemble est très cohérente et la qualité de l'image est très claire. À première vue, on dirait une véritable interview !

Une autre version de la même génération de mots d'invite n'est pas mauvaise non plus :

Cette fois, la caméra est plus proche, l'arrière-plan est plus réaliste et les personnages sont toujours expressifs.

Après avoir lu cet ensemble d'œuvres, certains internautes ont déclaré :

C'est incroyable. De tels résultats peuvent être générés par de simples invites textuelles !

Certaines personnes ont dit sans détour :

C'est le Midjourney dans le domaine de la vidéo.

Blogger a effectivement testé Gen-2

Ce blogueur s'appelle Nick St. Pierre, spécialisé dans le partage de ses travaux réalisés avec l'IA sur Twitter.

En plus du style réaliste vu au début, il a également publié un ensemble d'œuvres de science-fiction Gen-2.

Par exemple « Des astronautes voyageant dans l'espace » :

« Un soldat armé court dans le couloir d'un vaisseau spatial, une ombre détruisant le mur derrière lui » :

« Une famille de robots mangeant des puces électroniques dans un zoo humain " :

"Une armée de robots humanoïdes colonise les plaines gelées" :

(Elle a l'élan de l'armée des Marcheurs Blancs attaquant la Grande Muraille dans Game of Thrones...)

" Le dernier homme sur terre regarde Le vaisseau spatial envahisseur a atterri au-dessus de Tokyo » :

…

Tout ce qui précède peut être complété par un seul mot, sans avoir besoin de se référer à d'autres images et vidéos.

Bien que l'effet de cet ensemble de science-fiction soit légèrement inférieur à celui de "un homme dans un bar interviewé", ce qui est magique, c'est qu'il est comparable à la saveur "chaotique" du début de la naissance de l'IA modèle de génération d'images. ——Il semble que je puisse voir l'ombre d'une IA telle que la diffusion stable à ce moment-là.

Comme l'a dit Nick St. Pierre :

La génération 2 en est encore à ses balbutiements, et elle sera certainement meilleure à l'avenir.

Nous avons également trouvé quelques effets sur Internet testés par d'autres personnes qualifiées pour des tests internes :

On peut dire qu'à part le plus des travaux de science-fiction difficiles, et tout le reste qu'il fait est plutôt bon.

La génération vidéo IA est également en plein essor

Gen-2, un outil d'IA spécialisé dans la génération vidéo, a été publié le 20 mars (article du 11 mars).

En tant que nouveau venu dans le domaine de l'AIGC, sa vitesse d'itération et sa qualité sont également assez rapides :

La version Gen-1 vient de naître en février, et elle ne pouvait éditer que des vidéos existantes

Maintenant Gen-2 You ; peut déjà utiliser du texte et des images comme mots d’invite pour générer directement des vidéos.

L'appelle officiellement « la prochaine étape de l'IA générative », et le slogan est également très dominateur :

dis-le, vois-le. (Tant que vous pouvez le dire, je peux vous laisser le voir)

La mise à jour de Gen-2 apporte huit fonctions majeures en un seul souffle :

Vidéo d'aventure, texte + vidéo d'image de référence, image fixe en vidéo, vidéo style Migration, storyboarding, masque (comme transformer un chien blanc qui marche en dalmatien), rendu et personnalisation (comme transformer un jouet en tortue en quelques secondes).

Comme la peinture IA, son émergence a fait voir aux gens les énormes changements cachés dans les domaines du cinéma et de la télévision, des jeux et du marketing.

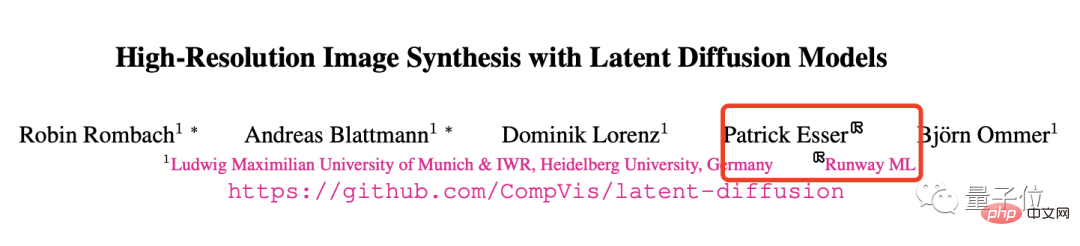

La société de développement derrière cela mérite également d'être mentionnée, il s'agit de Runway.

Runway a été créée en 2018. Elle a fourni un support technique pour les effets spéciaux de "The Instant Universe" et a également participé au développement de Stable Diffusion (un titre prometteur).

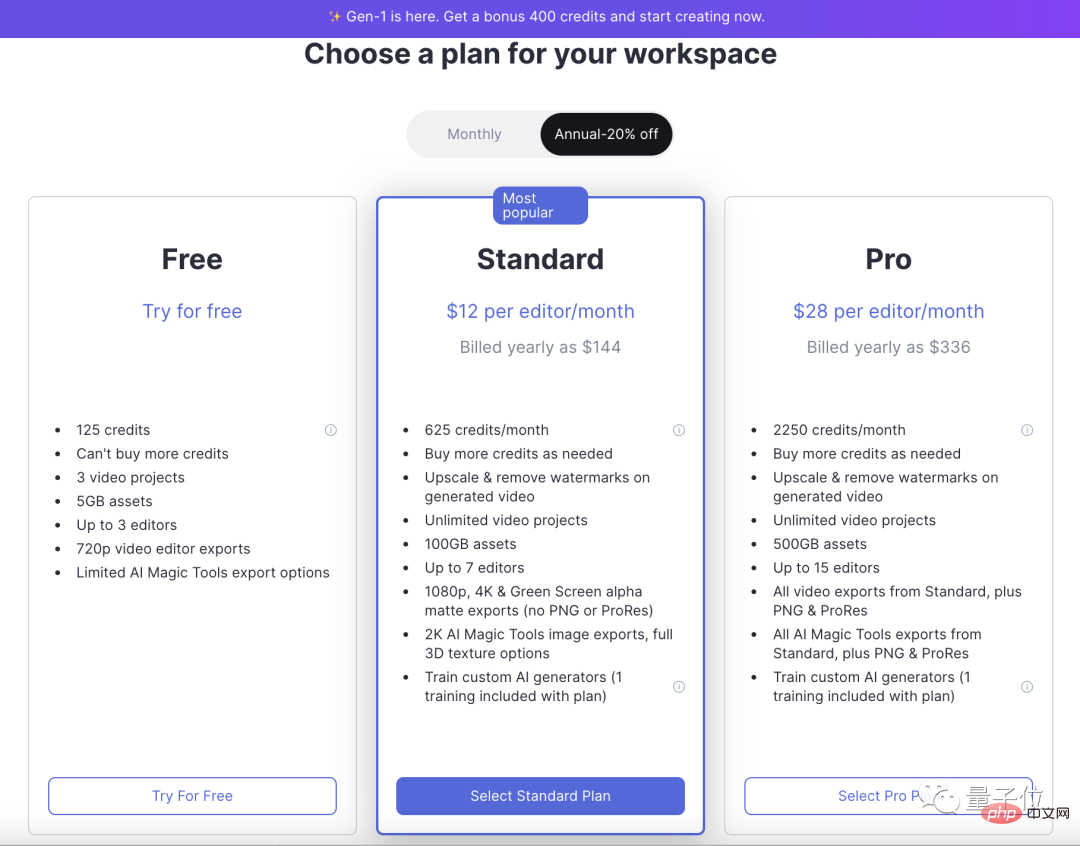

Conseils : Gen-1 peut déjà être joué (une fois 125 opportunités épuisées, vous ne pouvez payer que mensuellement), Gen-2 n'a pas encore été officiellement rendu public.

En plus de la série Gen, le Microsoft Asia Research Institute a également récemment publié une IA capable de générer des vidéos ultra-longues basées sur du texte : NUWA-XL.

Avec seulement 16 phrases simples, il peut obtenir une animation de 11 minutes :

Pour aller un peu plus loin, le jour même de la sortie de Gen-2, Alibaba Damo Academy l'a également open source Text-to -IA vidéo avec 1,7 milliard de paramètres :

L'effet est celui de tante Jiang :

...

On peut prédire que non seulement la génération d'images, mais aussi le champ vidéo deviendront animés.

Ahem, alors sera-ce la prochaine vague de carnaval massif de l'IA ?

Lien de référence :

[1]https://www.php.cn/link/4d7e0d72898ae7ea3593eb5ebf20c744

[2]https://www.php.cn/link/ e00944d55e6432ccf20f9fda2492b6fd

[3]https://www.php.cn/link/ce653013fadbb2ff27530d3de3790f1b

[4]https://www.php.cn/link/ 6e3adb1ae0e02c934766182313b6775d

[5]https://www.php.cn/link/b9b72b29352f3764ea4dec130772bd9d

[6]https://www.php.cn/ lien / 79d37fb2893b428f7ea4ed3b07a84096

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI