Maison >Périphériques technologiques >IA >La sortie imminente de GPT4 est comparable au cerveau humain, et de nombreux leaders de l'industrie ne peuvent pas rester les bras croisés !

La sortie imminente de GPT4 est comparable au cerveau humain, et de nombreux leaders de l'industrie ne peuvent pas rester les bras croisés !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-14 18:58:041961parcourir

Auteur | Xu Jiecheng

Critique | Yun Zhao

100 000 milliards, quelle est la taille de ce nombre ? Si vous avez le super pouvoir de gagner 5 millions de billets de loterie chaque jour, alors si vous économisez tout l'argent sans manger ni boire, il vous faudra encore vivre environ 5 500 ans pour économiser 100 000 milliards de richesse. Cependant, les 100 000 milliards dont je veux vous parler aujourd’hui ne se trouvent pas derrière les unités convoitées telles que le « RMB » et le « Dollor ». Les 100 000 milliards ici font référence au nombre de paramètres détenus par OpenAI, une société de recherche en intelligence artificielle cofondée par de nombreux magnats de la technologie de la Silicon Valley, qui est sur le point de lancer la quatrième génération de pré-formation générative Transformer-GPT-4.

Afin de permettre à chacun de comprendre ces données de manière plus intuitive, nous pouvons utiliser le cerveau humain pour comparer avec GPT-4. Dans des circonstances normales, un cerveau humain normal possède environ 80 à 100 milliards de neurones et environ 100 000 milliards de synapses. Ces neurones et synapses contrôlent directement presque toutes les pensées, jugements et comportements d’une personne au cours de cent ans de vie, et GPT-4 possède autant de paramètres que de synapses dans le cerveau humain. Alors, quel est le potentiel d’un réseau neuronal dense à si grande échelle ? Quelles surprises l’émergence de GPT-4 nous apportera-t-elle vraiment ?

Avant d'explorer ces questions passionnantes, autant comprendre d'abord l'histoire de développement de plusieurs « prédécesseurs » de GPT-4.

1. GPT : C'est juste un blockbuster

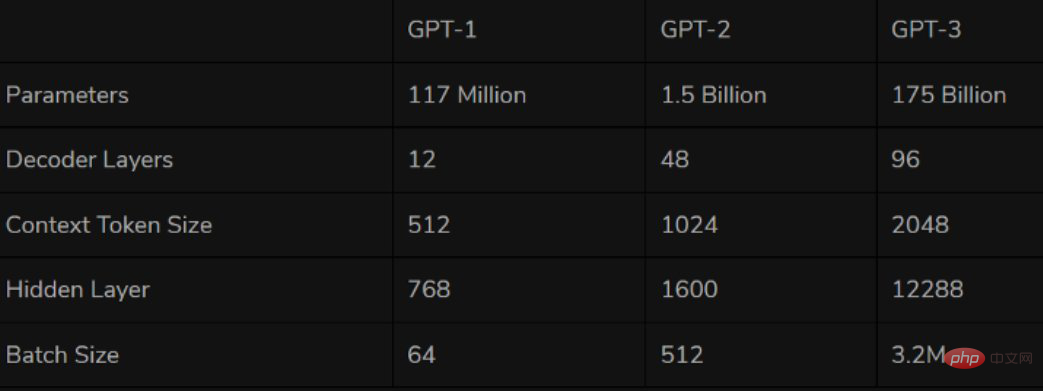

Le premier modèle de la série GPT, GPT-1, est né en 2018, qui est la première année de ce que nous appelons souvent le modèle de pré-formation PNL. En tant que premier modèle de pré-formation basé sur Transformer, GPT-1 adopte deux étapes de pré-formation + FineTuning, utilisant le décodeur de Transformer comme extracteur de fonctionnalités. Il empile 12 couches au total et utilise 110 millions de paramètres. "Modèle de langage" unique comme tâche de formation.

En termes de performances, GPT-1 a une certaine capacité de généralisation et peut être utilisé dans des tâches de PNL sans rapport avec les tâches de supervision. Les tâches couramment utilisées incluent :

- Raisonnement en langage naturel : déterminer la relation entre deux phrases (confinement, contradiction, neutralité)

- Question et réponse et raisonnement de bon sens : saisir un article et plusieurs réponses, et afficher l'exactitude du réponse

- Similitude sémantique Reconnaissance : Déterminez si la sémantique de deux phrases est liée

- Classification : Déterminez à quelle catégorie appartient le texte saisi

Bien que GPT-1 ait certains effets sur les tâches non déboguées, sa capacité de généralisation est bien inférieure qu'après Il s'agit d'une tâche de mise au point supervisée, donc GPT-1 ne peut être considéré que comme un outil de compréhension du langage raisonnablement bon plutôt que comme une IA conversationnelle.

Un an après l'avènement de GPT-1, GPT-2 est également arrivé comme prévu en 2019. Comparé à son grand frère GPT-1, GPT-2 n'a pas apporté trop d'innovations structurelles et de conceptions sur le réseau d'origine. Il a seulement utilisé plus de paramètres de réseau et un ensemble de données plus important : le plus grand modèle a un total de 48 couches, et le plus grand modèle a un total de 48 couches. paramètres Le montant atteint 1,5 milliard et l'objectif d'apprentissage utilise un modèle de pré-formation non supervisé pour effectuer des tâches supervisées.

Source : Twitter

En termes de performances, les efforts d'OpenAI semblent vraiment avoir apporté quelques miracles. En plus de sa capacité de compréhension, GPT-2 a pour la première fois montré un fort talent en génération : lire des résumés, discuter, continuer à écrire, inventer des histoires, et même générer de fausses nouvelles, des e-mails de phishing ou se faire passer pour d'autres en ligne sont autant de choses. un jeu d'enfant. Après être « devenu plus grand », GPT-2 a démontré une série de capacités universelles et puissantes et a obtenu les meilleures performances de l'époque sur plusieurs tâches de modélisation de langage spécifiques. Il n’est pas étonnant qu’OpenAI ait déclaré à l’époque que « GPT-2 était trop dangereux pour être publié ».

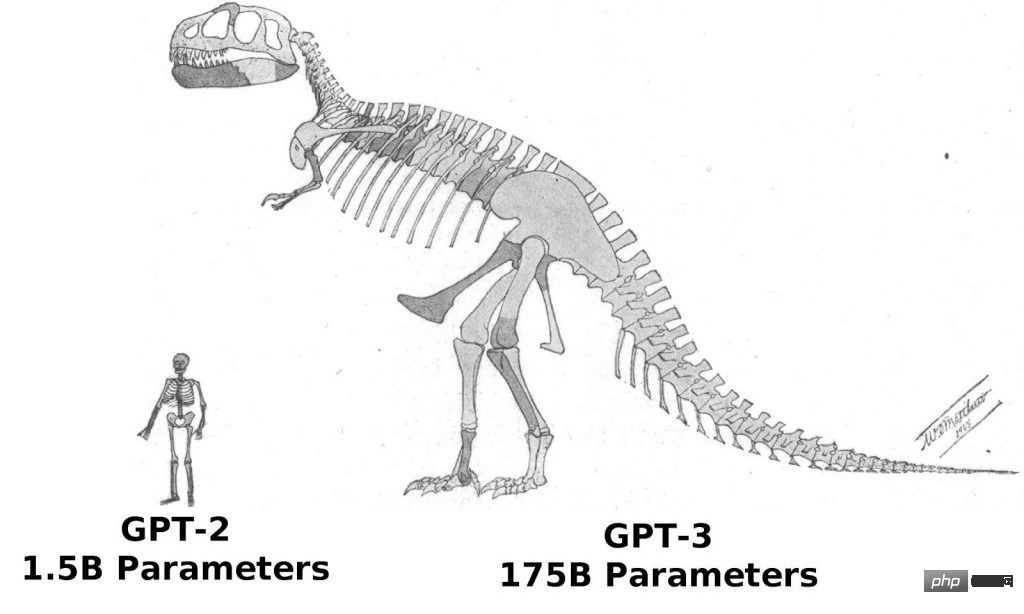

Depuis le succès de GPT-2, la confiance d'OpenAI dans le « Hercules » est devenue de plus en plus ferme, sorti en 2020, continue de suivre l'idée de développement de la micro-innovation et de l'expansion rapide. Sauf que le Transformer dans GPT-3 applique la structure Sparse, il n'y a presque aucune différence dans la structure de GPT-3 et GPT-2. En termes de « vigueur », le modèle GPT-3 a atteint 96 couches et les paramètres d'entraînement ont atteint 175 milliards (plus de 10 fois ceux du GPT-2).

GPT-3 prouve également une fois de plus la vision d'OpenAI. En raison des performances plus élevées de GPT-3 et de beaucoup plus de paramètres, il contient plus de textes de sujet, ce qui est évidemment meilleur que la génération précédente de GPT-2. En tant que plus grand réseau neuronal dense actuellement disponible, GPT-3 peut convertir les descriptions de pages Web en codes correspondants, imiter des récits humains, créer de la poésie personnalisée, générer des scripts de jeu et même imiter des philosophes décédés, prédisant le véritable sens de la vie. Et GPT-3 ne nécessite pas de réglage fin, il ne nécessite que quelques échantillons du type de sortie (une petite quantité d'apprentissage) pour résoudre des problèmes de grammaire difficiles. On peut dire que GPT-3 semble avoir satisfait toutes nos imaginations d’experts en langage.

2. J'ai complètement réussi le test de Turing et abaissé le seuil d'apprentissage et d'utilisation commerciale

En parlant de ça, je pense que tout le monde se posera la même question - GPT-3 est déjà très puissant, alors quoi d'autre est digne de nous dans GPT-4 ? Où attendez-vous avec impatience ?

Comme nous le savons tous, le principal moyen de tester l'intelligence d'un système d'IA est le test de Turing. Alors que nous sommes toujours incapables d'utiliser des normes scientifiques quantifiables pour définir le concept d'intelligence humaine, le test de Turing est actuellement l'un des meilleurs. les quelques Une méthode de test réalisable, réalisable et capable de déterminer si l'autre partie possède une intelligence humaine. Pour reprendre un proverbe : si quelque chose ressemble à un canard, marche comme un canard et cancane comme un canard, alors c'est un canard. Par conséquent, si le système d'IA réussit le test de Turing, cela signifie que le système a une pensée humaine et peut remplacer les humains à certains égards. Selon les médias informatiques coréens, depuis la mi-novembre, l'industrie a rapporté que GPT-4 avait entièrement réussi le test de Turing. Nam Se-dong, directeur de la société sud-coréenne Vodier AI, a déclaré dans une récente interview au journal sud-coréen "Economic News" : "Bien que la nouvelle selon laquelle GPT-4 a réussi le test de Turing n'ait pas été officiellement confirmée, la nouvelle devrait être tout à fait crédible

."Personne technique, ancien PDG d'OpenAI, Sam Altman a également semblé confirmer cette information sur son Twitter. Altman a tweeté le 10 novembre, imitant une réplique classique du personnage de Star Wars, Dark Vador : "Ne soyez pas fier de cette panique technologique que vous avez créée. La capacité de réussir le test de Turing est "originale". rien que vous puissiez faire face à la force. »

Source : Twitter

Un dirigeant d'une start-up d'IA a analysé que « Si GPT-4 réussit vraiment parfaitement le test de Turing, alors son impact sera suffisant pour faire sensation dans l'IA. monde." Panique technologique', alors Altman a utilisé le personnage de Dark Vador pour annoncer cette information. "

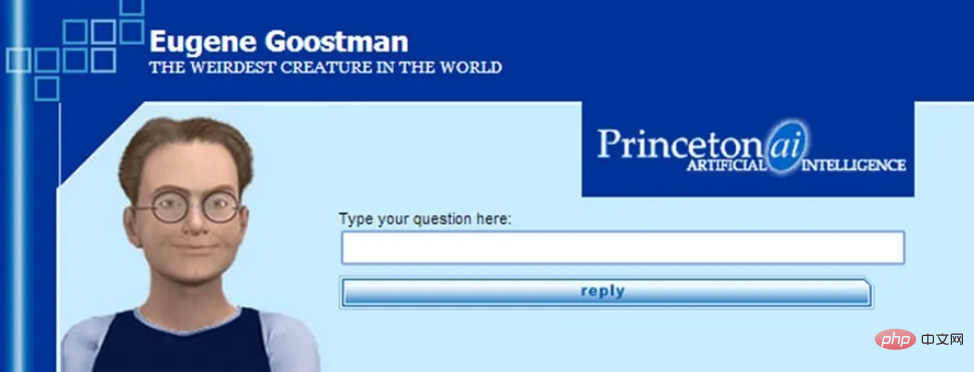

Si GPT-4 réussit le test de Turing sans aucune restriction, il entrera effectivement dans l'histoire. Bien que certains modèles d’IA aient déjà prétendu réussir le test de Turing, ils n’ont jamais été unanimement reconnus par l’industrie de l’IA. En effet, les normes et règles du test de Turing ne sont pas claires, c'est pourquoi de nombreux modèles exploitent intelligemment certains « angles morts » du test. Le modèle d'IA "Eugene" lancé par l'Université de Reading au Royaume-Uni en 2014 en est un exemple typique. À cette époque, l'Université de Reading affirmait devant les juges que le modèle était un garçon ukrainien de 13 ans. lorsque l'algorithme ne pouvait pas donner une bonne réponse. À cette époque, le jury pensait que c'était parce que le sujet du test était un enfant étranger.

Source : Internet

Bien que le test de Turing ne soit pas une référence absolue pour la technologie de l'IA, en tant que test de technologie d'IA le plus ancien et le plus connu à ce jour, le test de Turing a toujours une grande importance symbolique. signification. Si GPT-4 réussit vraiment officiellement et définitivement le test de Turing, il créera très probablement la plus grande étape dans l'industrie de l'IA jusqu'à présent.

De plus, contrairement à GPT-3, GPT-4 sera très probablement plus qu'un simple modèle de langage. Ilya Sutskever, scientifique en chef d'OpenAI, a un jour fait allusion à cela dans son article multimodal : « Le texte lui-même peut exprimer de nombreuses informations sur le monde, mais il est après tout incomplet, car nous vivons également dans un monde visuel. » Par conséquent, certains les experts du secteur estiment que GPT-4 sera multimodal et pourra accepter des entrées audio, texte, images et même vidéo, et prédisent que l'ensemble de données audio Whisper d'OpenAI sera utilisé pour créer des données texte GPT-4. Cela signifie également que GPT-4 n'aura plus aucune limitation dans la réception et le traitement des informations externes.

La raison pour laquelle l'industrie prête attention au GPT-4 est probablement parce que le seuil commercial réel du GPT-4 sera inférieur à celui du GPT-3 traditionnel. Les entreprises qui n'étaient auparavant pas en mesure d'utiliser les technologies associées en raison de coûts énormes et de raisons d'infrastructure devraient également utiliser GPT-4. GPT-4 est actuellement en phase finale de cotation et sera publié entre décembre de cette année et février de l'année prochaine. Alberto Garcia, analyste chez Cambridge AI Research, a publié un blog et prédit : « GPT-4 se concentrera davantage sur l'optimisation du traitement des données, de sorte que le coût d'apprentissage de GPT-4 devrait être inférieur à celui de GPT-3. coût par épisode de GPT-4 Il sera probablement réduit de plusieurs millions de dollars pour GPT-3 à environ 1 million de dollars.

3. Différents chemins mènent au même objectif : la simulation du cerveau humain pourrait être plus rapide

Si toutes les informations ci-dessus sont vraies, alors à l'heure actuelle, nous pouvons prévoir qu'avec la sortie de GPT-4, le domaine de la recherche sur l'apprentissage profond ouvrira la voie à une nouvelle vague l'année prochaine ; Un grand nombre de robots de service de chat plus avancés, plus naturels et dont l'identité est presque impossible à distinguer apparaîtront probablement dans diverses industries sur cette base, il y en aura également davantage ; des services d'IA personnalisés de haute qualité provenant de différentes entreprises traditionnelles sont nés ; nous parviendrons également pour la première fois à une communication sans obstacle avec l'intelligence cognitive.

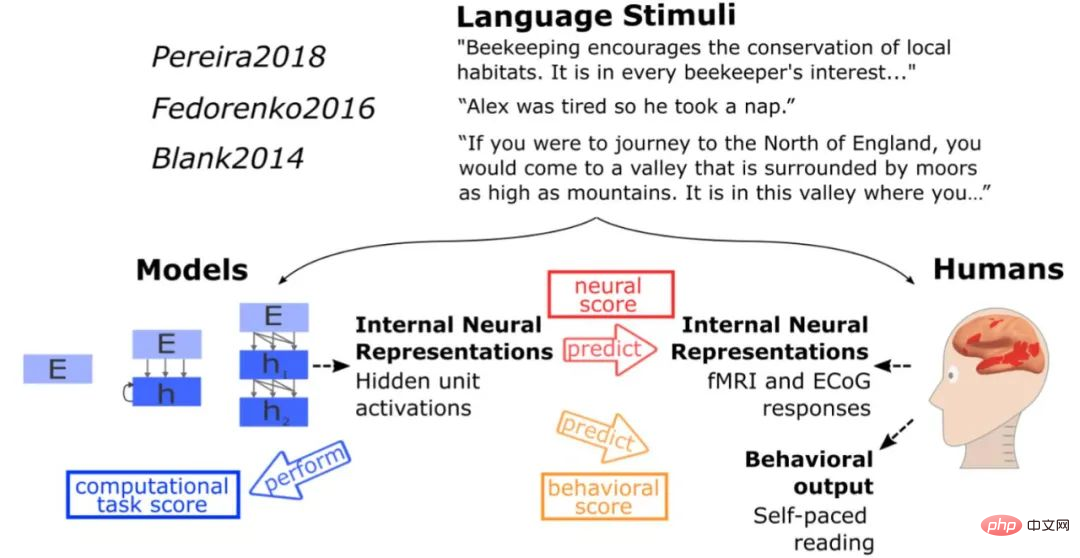

Reprenons la problématique de fabrication ou de simulation de cerveaux humains évoquée au début. Selon une étude du MIT, bien que le réseau neuronal de GPT-3 ne tente pas d'imiter directement le cerveau humain, la méthode de traitement du langage présentée par GPT-3 présente certaines similitudes avec les solutions obtenues au cours de l'évolution du cerveau humain. lorsque le même stimulus que le cerveau humain testé a été entré dans le modèle, le modèle a obtenu le même type d'activation que le cerveau humain, et dans plus de 40 tests de modèles de langage, GPT-3 a fait des inférences presque parfaites. La fonction est en effet similaire à celle du centre de traitement du langage du cerveau humain. À cet égard, Daniel Yamins, professeur adjoint de psychologie et d'informatique à l'Université de Stanford, a également déclaré : « Le réseau d'intelligence artificielle n'imite pas directement le cerveau, mais il finit par ressembler au cerveau. un écart entre l’intelligence artificielle et la nature. Il semble y avoir une évolution convergente en cours.

Source : Internet

On peut voir que bien que le modèle de la série GPT n'adopte pas directement l'idée de conception desimuler la structure cérébrale dans le projet Blue Brain, l'effet qu'il présente semble meilleur que celui des projets du Plan Blue Brain, plus proche de nos attentes. Par conséquent, si cette direction de recherche est vraiment réalisable et que GPT-4 peut réaliser une avancée décisive dans certains aspects sur la base de GPT-3, nous serons alors un pas de plus vers l'objectif de simuler certaines fonctions du cerveau humain.

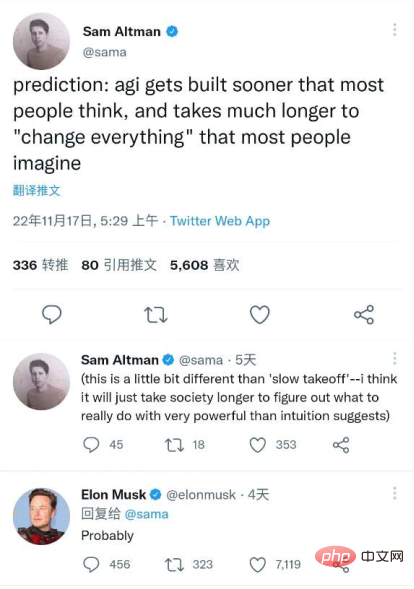

Enfin, je voudrais terminer en citant un passage que le PDG d’OpenAI, Sam Altman, a récemment publié sur Twitter, qui a également été reconnu par « l’Iron Man de la Silicon Valley » Elon Musk – « La mise en place de l’intelligence artificielle générale sera meilleure que La plupart des gens l’imaginent plus rapidement, et cela « changera » tout ce que la plupart des gens imaginent sur une longue période de temps. »

Source de l'image : Twitter

Lien de référence :

https://dzone.com/articles/what-can-you-do-with-the-openai-gpt-3-langue - mod

https://analyticsindiamag.com/gpt-4-is-almost-here-and-it-looks-better-than-anything-else/

https://analyticsindiamag.com/openais-whisper- could -détenir-la-clé-de-gpt4/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI