Maison >Périphériques technologiques >IA >Ne soyez pas un peintre analphabète ! Google a modifié comme par magie le 'Text Encoder' : une petite opération permet au modèle de génération d'images d'apprendre 'l'orthographe'

Ne soyez pas un peintre analphabète ! Google a modifié comme par magie le 'Text Encoder' : une petite opération permet au modèle de génération d'images d'apprendre 'l'orthographe'

- 王林avant

- 2023-04-14 15:16:03940parcourir

Au cours de la dernière année, avec la sortie de DALL-E 2, Stable Diffusion et d'autres modèles de génération d'images, les images générées par le modèle texte-image ont été considérablement améliorées en termes de résolution, de qualité, de fidélité du texte, etc. , ce qui a grandement favorisé le développement de scénarios d'application en aval, et tout le monde est devenu un peintre d'IA.

Cependant, des recherches pertinentes montrent que la technologie actuelle des modèles génératifs présente encore un défaut majeur : il n'existe aucun moyen de présenter un texte visuel fiable dans les images.

Les résultats de la recherche montrent que DALL-E 2 est très instable dans la génération de caractères de texte cohérents dans les images, et le nouveau modèle de diffusion stable répertorie directement « incapable de rendre un texte lisible » comme limite connue.

Mauvaises orthographes des caractères : (1) Californie : Tous les rêves sont les bienvenus, (2) Canada : Pour des cœurs brillants, (3) Colorado : C'est notre nature, (4) Saint-Louis : Tout à portée de main .

Récemment, Google Research a publié un nouvel article qui tente de comprendre et d'améliorer la capacité des modèles de génération d'images à restituer un texte visuel de haute qualité. Les chercheurs estiment que la principale raison des défauts de rendu du texte dans les modèles génératifs texte-image actuels est le manque de fonctionnalités de saisie au niveau des caractères.

Afin de quantifier l'impact de cette fonctionnalité de saisie dans la génération de modèles, l'article a conçu une série d'expériences contrôlées pour comparer les encodeurs de texte (conscients des caractères et aveugles aux caractères) avec ou sans fonctionnalités de saisie de texte.

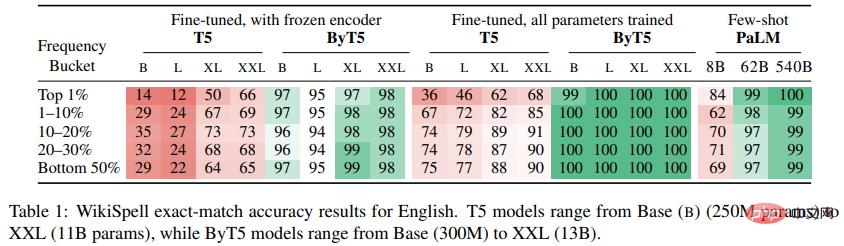

Les chercheurs ont découvert que dans le domaine du texte brut, le modèle sensible aux caractères permettait d'obtenir d'importants gains de performances sur une nouvelle tâche d'orthographe (WikiSpell).

Après avoir transféré cette expérience au domaine visuel, les chercheurs ont formé un ensemble de modèles de génération d'images. Les résultats expérimentaux montrent que le modèle sensible aux caractères surpasse les caractères aveugles dans une série de nouvelles tâches de rendu de texte (benchmark DrawText).Et le modèle sensible aux caractères atteint un état de l'art plus élevé en orthographe visuelle, sa précision sur les mots peu courants est toujours de plus de 30 % supérieure à celle des modèles concurrents malgré un entraînement sur un nombre beaucoup plus petit d'exemples en points de pourcentage.

Modèle sensible aux caractères

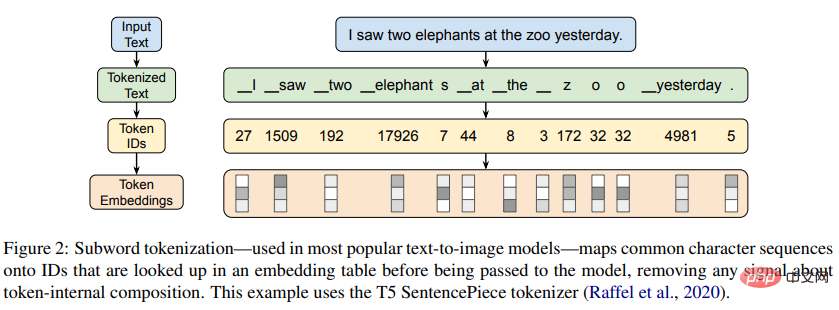

Les modèles de langage peuvent être divisés en modèles sensibles aux caractères qui ont un accès direct aux caractères qui composent leur saisie de texte et en modèles aveugles aux caractères qui n'ont pas d'accès.

De nombreux premiers modèles de langage neuronal fonctionnaient directement sur les caractères sans utiliser de jetons multi-caractères comme marqueurs.

Les modèles ultérieurs sont progressivement passés à la tokenisation basée sur le vocabulaire, certains modèles tels que ELMo conservant toujours la sensibilité aux personnages, mais d'autres modèles tels que BERT abandonnant les fonctionnalités des personnages au profit d'une pré-formation plus efficace.

Actuellement, les modèles de langage les plus largement utilisés sont aveugles aux caractères, s'appuyant sur des algorithmes de segmentation de sous-mots basés sur des données tels que le Byte Pair Encoding (BPE) pour générer des sous-mots en tant que vocabulaire.Bien que ces méthodes puissent recourir à une représentation au niveau des caractères pour des séquences peu courantes, elles sont toujours conçues pour compresser des séquences de caractères courantes en unités indivisibles.

L'objectif principal de cet article est d'essayer de comprendre et d'améliorer la capacité des modèles de génération d'images à restituer un texte visuel de haute qualité.

À cette fin, les chercheurs ont d'abord étudié les capacités orthographiques des encodeurs de texte actuels de manière isolée. À partir des résultats expérimentaux, on peut constater que, bien que les encodeurs de texte aveugles aux caractères soient populaires, ils ne reçoivent pas d'informations sur les caractères. leur saisie constitue un signal direct, ce qui entraîne des capacités orthographiques limitées.

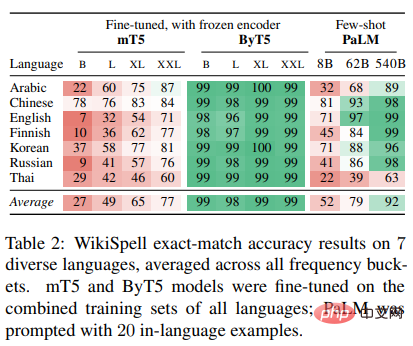

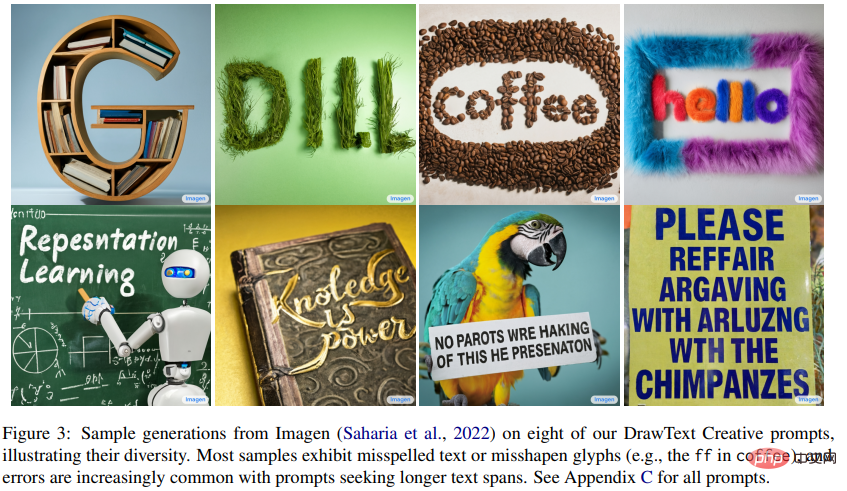

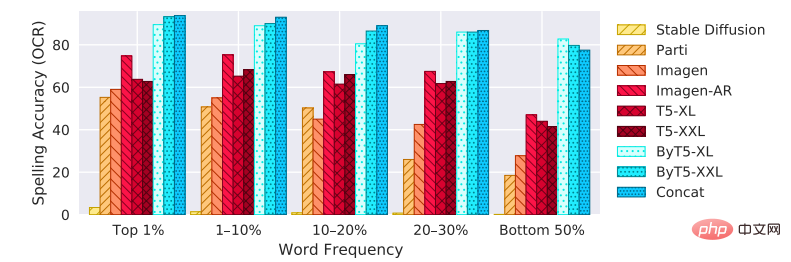

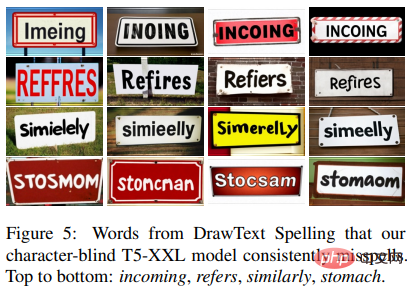

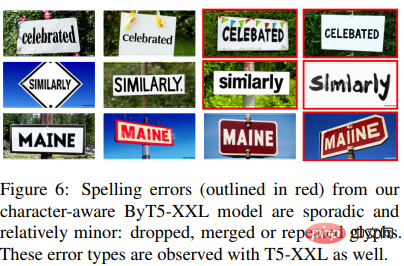

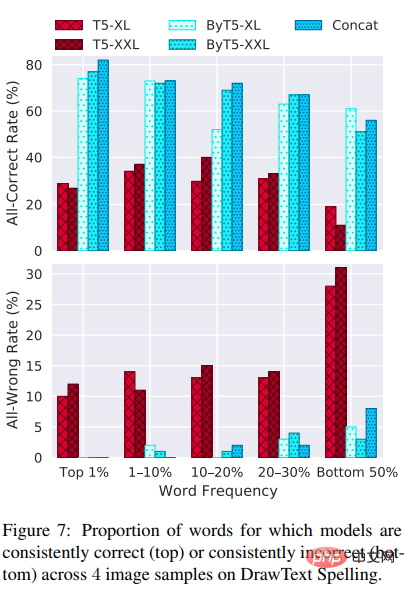

Les chercheurs ont également testé les capacités orthographiques d'encodeurs de texte de différentes tailles, architectures, représentations d'entrée, langues et méthodes de réglage. Cet article enregistre pour la première fois la capacité miraculeuse du modèle aveugle aux caractères à induire de solides connaissances orthographiques (précision > 99 %) grâce à une pré-formation en réseau, mais les résultats expérimentaux montrent que cette capacité n'est pas disponible dans les langues autre que l'anglais, il ne se généralise pas bien et n'est réalisable qu'à des échelles dépassant les paramètres 100B, il n'est donc pas réalisable pour la plupart des scénarios d'application. D'un autre côté, les encodeurs de texte sensibles aux caractères permettent de puissantes capacités d'orthographe à des échelles plus petites. En appliquant ces résultats à des scénarios de génération d'images, les chercheurs ont formé une série de modèles de conversion texte-image sensibles aux caractères et ont démontré qu'ils surpassaient considérablement les caractères dans les évaluations du modèle de rendu de texte existant et nouveau. Mais pour les modèles au niveau des caractères purs, bien que les performances du rendu du texte se soient améliorées, pour les invites qui n'impliquent pas de texte visuel, l'alignement image-texte diminuera. Pour atténuer ce problème, les chercheurs suggèrent de combiner les représentations d'entrée au niveau des caractères et au niveau des jetons afin d'obtenir les meilleures performances. Étant donné que les modèles génératifs texte-image s'appuient sur des encodeurs de texte pour produire des représentations à décoder, les chercheurs ont d'abord créé le benchmark WikiSpell en échantillonnant quelques mots du Wiktionnaire, puis en se basant sur cet ensemble de données sur un A pur. tâche d'évaluation de l'orthographe du texte pour explorer les capacités des encodeurs de texte. Pour chaque exemple dans WikiSpell, l'entrée du modèle est un mot et la sortie attendue est son orthographe spécifique (générée en insérant des espaces entre chaque caractère Unicode). L'article ne s'intéressant qu'à l'étude de la relation entre la fréquence d'un mot et la capacité orthographique du modèle, les chercheurs ont divisé les mots du Wiktionnaire en cinq selon la fréquence du mot apparaissant dans le corpus mC4 Catégories sans chevauchement : 1 % des mots les plus fréquents, 1 à 10 % des mots les plus fréquents, 10 à 20 % des mots, 20 à 30 % des mots et 50 % des mots les plus faibles (inclus dans le corpus mC4). mots du corpus qui n'apparaissent jamais dans ). Ensuite, échantillonnez 1 000 mots uniformément dans chaque compartiment pour créer un ensemble de test (et un ensemble de développement similaire). Enfin, un ensemble d'entraînement de 10 000 mots a été construit en combinant deux parties : 5 000 uniformément échantillonnés dans le seau inférieur de 50 % (les mots les moins courants), et les 5 000 autres en fonction de leur présence dans mC4. Les fréquences sont échantillonnées proportionnellement (ainsi en orientant cette moitié de la formation vers les mots fréquents). Les chercheurs excluent tous les mots sélectionnés dans l'ensemble de développement ou l'ensemble de test de l'ensemble de formation, de sorte que les résultats de l'évaluation concernent toujours les mots exclus. En plus de l'anglais, les chercheurs ont également évalué six autres langues (arabe, chinois, finnois, coréen, russe, thaï), choisies pour couvrir diverses fonctionnalités qui affectent la capacité du modèle à apprendre l'orthographe du processus de construction de l'ensemble de données. décrit ci-dessus a été répété pour chaque évaluation linguistique. Les chercheurs ont utilisé le benchmark WikiSpell pour évaluer les performances de plusieurs modèles de texte uniquement pré-entraînés à différentes échelles, notamment T5 (un modèle de codec aveugle aux caractères pré-entraîné sur des données anglaises) ; similaire à T5, mais pré-entraîné sur plus de 100 langues) ; ByT5 (une version sensible aux caractères de mT5 qui fonctionne directement sur les séquences d'octets UTF-8) ; et PaLM (un modèle de décodage plus grand, principalement pré-entraîné en anglais). Dans les résultats expérimentaux de l'anglais pur et du multilingue, on peut constater que les performances des modèles aveugles aux caractères T5 et mT5 sont bien pires sur les seaux contenant les 1 % de mots les plus fréquents. Ce résultat peut sembler contre-intuitif, car les modèles fonctionnent généralement mieux sur des exemples qui apparaissent fréquemment dans les données, mais en raison de la façon dont les vocabulaires de sous-mots sont formés, les mots fréquents sont généralement représentés comme un seul jeton atomique (ou A petit nombre de jetons), et c'est effectivement vrai : 87 % des mots dans la tranche supérieure de 1 % de l'anglais sont représentés par le vocabulaire de T5 en tant que jeton de sous-mot. Ainsi, un faible score de précision orthographique indique que l'encodeur de T5 ne conserve pas suffisamment d'informations orthographiques sur les sous-mots de son vocabulaire. Deuxièmement, pour les modèles aveugles aux caractères, l'échelle est un facteur important affectant la capacité d'orthographe. T5 et mT5 s'améliorent progressivement à mesure que l'échelle augmente, mais même à l'échelle XXL, ces modèles ne montrent pas de capacités orthographiques particulièrement fortes. Ce n'est que lorsque les modèles aveugles aux caractères atteignent l'échelle de PaLM que vous commencez à voir des capacités orthographiques presque parfaites : le modèle PaLM avec paramètre 540B atteint une précision >99 % dans toutes les catégories de fréquence de l'anglais, même si je ne vois que 20 exemples. dans l'invite (alors que le T5 affiche 1000 exemples affinés). Cependant, PaLM fonctionne moins bien sur d'autres langages, probablement en raison de beaucoup moins de données de pré-formation pour ces langages. Les expériences sur ByT5 montrent que le modèle sensible aux caractères présente des capacités orthographiques plus puissantes. Les performances de ByT5 dans les tailles de base et grandes n'étaient que légèrement en retard par rapport aux XL et XXL (bien que toujours au moins dans la plage de 90 %), et la fréquence d'un mot ne semblait pas avoir beaucoup d'impact sur les capacités orthographiques de ByT5. Les performances orthographiques de ByT5 dépassent de loin les résultats de (m)T5, sont même comparables aux performances en anglais de PaLM avec 100 fois plus de paramètres et dépassent les performances de PaLM dans d'autres langues. On peut voir que l'encodeur ByT5 conserve des informations considérables au niveau des caractères, et ces informations peuvent être récupérées à partir de ces paramètres gelés en fonction des besoins de la tâche de décodage. De l'ensemble de données COCO publié en 2014 au benchmark DrawBench en 2022, du FID, des scores CLIP aux préférences humaines et à d'autres indicateurs, la façon d'évaluer les modèles texte-image a été un sujet de recherche important. Mais il y a eu un manque de travail connexe en matière de rendu de texte et d'évaluation orthographique. À cette fin, les chercheurs proposent un nouveau benchmark, DrawText, qui vise à mesurer de manière globale la qualité de rendu du texte des modèles texte-image. Le benchmark DrawText se compose de deux parties, mesurant différentes dimensions des capacités du modèle : 1) DrawText Spell, évalué par des rendus de mots ordinaires sur une large collection de mots anglais Les chercheurs ont commencé ; En prenant 100 mots chacun dans les catégories de fréquences WikiSpell en anglais et en les insérant dans un modèle standard, un total de 500 invites ont été construites. Pour chaque invite, 4 images sont extraites des modèles candidats et évaluées à l'aide d'évaluations humaines et de métriques basées sur la reconnaissance optique de caractères (OCR). 2) DrawText Creative, évalué à travers le rendu du texte des effets visuels. Le texte visuel ne se limite pas aux scènes courantes comme les panneaux de signalisation, le texte peut apparaître sous de nombreuses formes, telles que le gribouillage, la peinture, la sculpture, etc. Si les modèles de génération d'images prennent en charge un rendu de texte flexible et précis, cela permettra aux concepteurs d'utiliser ces modèles pour développer des polices créatives, des logos, des mises en page, etc. Pour tester la capacité du modèle de génération d'images à prendre en charge ces cas d'utilisation, les chercheurs ont travaillé avec un graphiste professionnel pour créer 175 invites différentes nécessitant le rendu du texte dans une gamme de styles et de paramètres créatifs. De nombreux indices dépassent les capacités des modèles actuels, avec des modèles de pointe présentant des mots mal orthographiés, supprimés ou répétés. Les résultats expérimentaux montrent que parmi les 9 modèles de génération d'images utilisés pour la comparaison en termes de précision sur le benchmark DrawText Spell, les modèles sensibles aux caractères (ByT5 et Concat) sont meilleurs que les autres indépendamment de taille du modèle, en particulier sur les mots peu courants. Imagen-AR montre l'avantage d'éviter le recadrage, et malgré un temps de formation 6,6 fois plus long, il fonctionne toujours moins bien que le modèle sensible aux caractères. Une autre différence évidente entre les modèles est qu'ils orthographent systématiquement mal un mot donné dans plusieurs échantillons. Les résultats expérimentaux montrent que quel que soit le nombre d'échantillons prélevés, le modèle T5 comporte de nombreux mots mal orthographiés, ce qui, selon les chercheurs, indique un manque de connaissance des caractères dans l'encodeur de texte. En revanche, le modèle ByT5 ne comporte fondamentalement que des erreurs sporadiques. Cette observation peut être quantifiée en mesurant le taux auquel le modèle est systématiquement correct (4/4) ou systématiquement incorrect (0/4) sur les quatre échantillons d'images. Un contraste net peut être observé, en particulier sur les mots courants (1 % des mots supérieurs), c'est-à-dire que le modèle ByT5 ne se trompe jamais systématiquement, tandis que le modèle T5 continue de se tromper sur 10 % ou plus des mots. .

WikiSpell Benchmark

Expérience de génération de texte

DrawText Benchmark

Expérience de génération d'images

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI