Maison >Périphériques technologiques >IA >Se faisant passer pour un auteur humain, ChatGPT et d'autres abus suscitent des inquiétudes, un article résume les méthodes de détection de texte générées par l'IA

Se faisant passer pour un auteur humain, ChatGPT et d'autres abus suscitent des inquiétudes, un article résume les méthodes de détection de texte générées par l'IA

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-14 14:10:031242parcourir

Les progrès récents dans la technologie de génération de langage naturel (NLG) ont considérablement amélioré la variété, le contrôle et la qualité du texte généré par les grands modèles de langage. Un exemple notable est ChatGPT d’OpenAI, qui a démontré des performances supérieures dans des tâches telles que répondre à des questions, rédiger des e-mails, des articles et du code. Cependant, cette nouvelle capacité à générer efficacement du texte soulève également des inquiétudes quant à la détection et à la prévention de l’utilisation abusive de grands modèles de langage dans des tâches telles que le phishing, la désinformation et la malhonnêteté académique. Par exemple, en raison des inquiétudes concernant les étudiants utilisant ChatGPT pour rédiger leurs devoirs, les écoles publiques de New York ont interdit l'utilisation de ChatGPT, et les médias ont également émis des avertissements concernant les fausses nouvelles générées par les grands modèles linguistiques. Ces préoccupations concernant l'utilisation abusive de grands modèles linguistiques ont sérieusement entravé l'application de la génération de langage naturel dans des domaines importants tels que les médias et l'éducation.

Des discussions ont récemment eu lieu sur la question de savoir si et comment détecter correctement le texte généré par de grands modèles de langage. Cet article fournit une introduction technique complète aux méthodes de détection existantes.

- Adresse papier : https://github.com/datamllab/The-Science-of-LLM-generated-Text-Detection

- Adresse de recherche associée : https:/ /github.com/datamllab/The-Science-of-LLM-generated-Text-Detection

/github.com/datamllab/awsome-LLM-generated-text-detection/tree/main

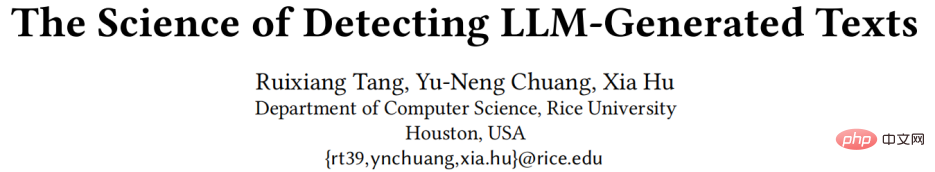

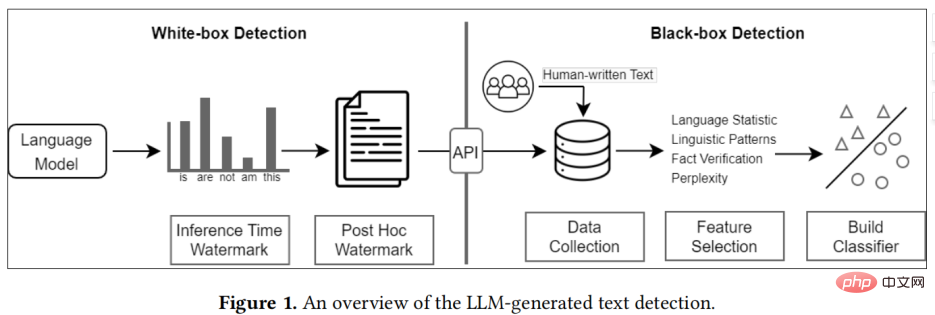

Les méthodes existantes peuvent être grossièrement divisées en deux catégories :détection de boîte noire et détection de boîte blanche

Détection de boîte blanche, ce type de méthode a tous accès à de grands modèles de langage et peut contrôler le comportement de génération du modèle ; ou Ajoutez un filigrane au texte généré pour suivre et détecter le texte généré.

- En pratique, les détecteurs de boîte noire sont généralement construits par des tiers, tels que GPTZero, tandis que les détecteurs de boîte blanche sont généralement construits par de grands développeurs de modèles de langage.

Taxonomie de la détection de texte générée par un grand modèle de langage

Détection de boîte noire

Détection de boîte noire

La détection de boîte noire comporte généralement trois étapes, à savoir la collecte de données, la sélection de fonctionnalités et la création de modèles

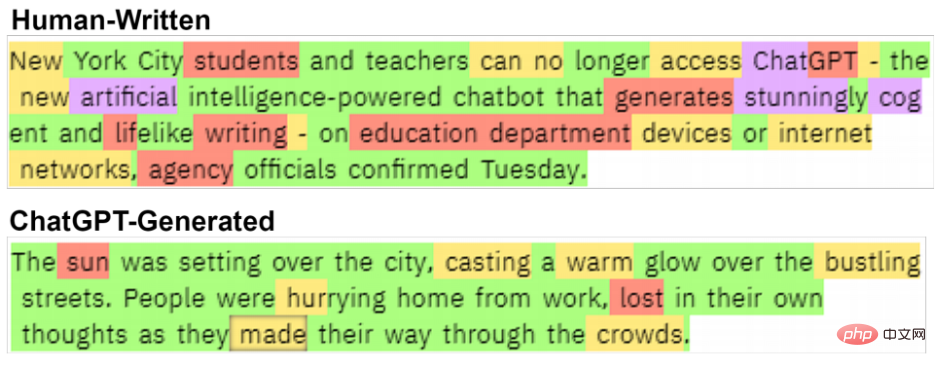

.Pour la collecte de textes humains, une méthode consiste à recruter des professionnels pour la collecte de données, mais cette méthode prend du temps et demande beaucoup de travail et ne convient pas à la collecte de grands ensembles de données. Une méthode plus efficace consiste à. utilisez des données textuelles humaines existantes, telles que Collectez des entrées éditées par divers experts de Wikipédia, ou collectez des données à partir de médias, tels que Reddit. La sélection des fonctionnalités est généralement divisée en fonctionnalités statistiques, fonctionnalités linguistiques et fonctionnalités factuelles. Les fonctionnalités statistiques sont généralement utilisées pour vérifier si le texte généré par un grand modèle de langage est différent du texte humain dans certains indicateurs statistiques de texte couramment utilisés, notamment TFIDF, la loi de Zipf, etc. Les fonctionnalités linguistiques recherchent généralement certaines caractéristiques linguistiques, telles que les parties du discours, l'analyse des dépendances, l'analyse des sentiments, etc. Enfin, les grands modèles de langage génèrent souvent des déclarations contrefactuelles, donc la vérification des faits

peut également fournir des informations qui distinguent le texte généré par les grands modèles de langage.Les modèles de classification existants sont généralement divisés en modèles d'apprentissage automatique traditionnels, tels que SVM, etc. Les recherches les plus récentes tendent à utiliser des modèles de langage comme épine dorsale, tels que BERT et RoBERTa, et ont permis d'obtenir des performances de détection plus élevées.

Il y a une nette différence entre ces deux textes. texte écrit par des humains de Chalkbeat New York.

Détection de boîte blanche

La détection de boîte blanche est généralement par défaut la détection fournie par les grands développeurs de modèles de langage. Différente de la détection par boîte noire, la détection par boîte blanche a un accès complet au modèle, elle peut donc intégrer des filigranes en modifiant la sortie du modèle pour atteindre l'objectif de détection.

Les méthodes de détection actuelles peuvent être divisées en Filigranes post-hoc et filigranes de temps d'inférence :

- Parmi eux, les filigranes post-hoc sont ajoutés au texte après que le texte soit généré par le grand modèle de langage. Les informations cachées sont utilisées pour la détection ultérieure ;

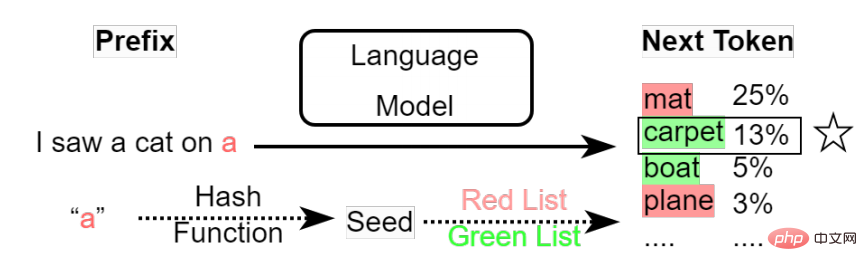

- Le filigrane du temps d'inférence modifie le mécanisme d'échantillonnage des grands modèles de langage pour ajouter des filigranes. Dans le processus de génération de chaque jeton par le grand modèle de langage, il sera basé. sur la probabilité de tous les jetons. Et la stratégie d'échantillonnage prédéfinie est utilisée pour sélectionner le prochain mot généré, et des filigranes peuvent être ajoutés à ce processus de sélection. Filigrane temporel d'inférence Ce processus introduit très facilement des biais. Par exemple, les ensembles de données existants se concentrent principalement sur plusieurs tâches telles que la génération de questions et réponses et d’histoires, ce qui introduit un biais de sujet. De plus, le texte généré par les grands modèles a souvent un style ou un format fixe. Ces biais sont souvent utilisés par les classificateurs boîte noire comme principales caractéristiques de classification et réduisent la robustesse de la détection.

À mesure que les capacités des modèles de langage à grande échelle s'améliorent, l'écart entre le texte généré par les modèles de langage à grande échelle et les humains deviendra de plus en plus petit, ce qui entraînera une précision de détection des modèles de boîte noire de plus en plus faible. Par conséquent, la détection des boîtes blanches sera plus importante à l’avenir. Comment détecter les prospects.

(2)

La méthode de détection existante est par défaut un grand modèle de langage appartenant à l'entreprise, de sorte que tous les utilisateurs obtiennent le grand service de modèle de langage de l'entreprise via l'API, ces relations plusieurs-à-un sont très utile pour exploiter le déploiement de systèmes de détection. Mais si l’entreprise mettait à disposition un grand modèle de langage, cela rendrait presque toutes les méthodes de détection existantes inefficaces.Pour la détection de boîte noire, étant donné que les utilisateurs peuvent affiner leurs modèles et modifier le style ou le format de sortie du modèle, la détection de boîte noire ne peut pas trouver de fonctionnalités de détection communes. La détection de boîte blanche peut être une solution. Les entreprises peuvent ajouter un filigrane au modèle avant l'open source. Cependant, les utilisateurs peuvent également affiner le modèle et modifier le mécanisme d'échantillonnage du jeton de modèle pour supprimer le filigrane. Il n’existe actuellement aucune technologie de filigrane capable de protéger les utilisateurs de ces menaces potentielles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI