Maison >Périphériques technologiques >IA >Nouvelle recherche de Stanford : il est confirmé que le modèle derrière ChatGPT a un esprit humain

Nouvelle recherche de Stanford : il est confirmé que le modèle derrière ChatGPT a un esprit humain

- PHPzavant

- 2023-04-14 13:04:021496parcourir

ChatGPT s'avère avoir un esprit ? ! "La théorie de l'esprit (ToM), que l'on pensait à l'origine propre aux humains, est apparue dans le modèle d'IA derrière ChatGPT

C'est la dernière conclusion d'une recherche de l'Université de Stanford, qui a eu un impact énorme dès le début." comme il a été publié Sensation dans le milieu académique :Cette journée est finalement arrivée de manière inattendue.

Dans cette étude, l'auteur a découvert que :

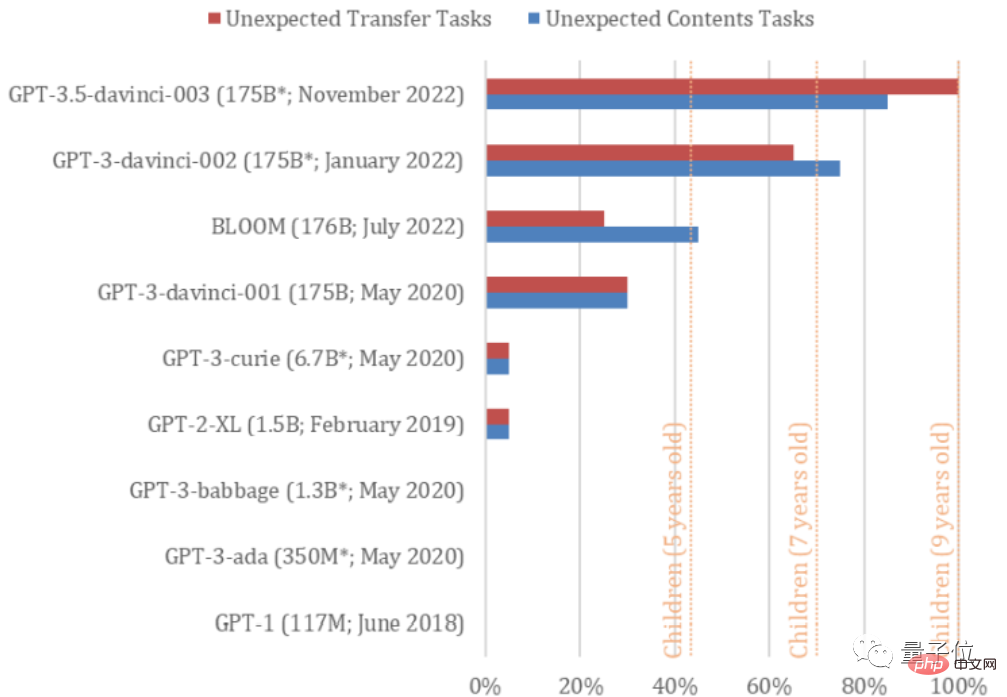

la version davinci-002 de GPT3 (à partir de laquelle ChatGPT est optimisé) peut déjà résoudre 70 % des tâches de théorie de l'esprit, ce qui équivaut à un enfant de 7 ans.

Quant à GPT3.5 (davinci-003), qui est le modèle homologue de ChatGPT, il a résolu 93% des tâches, avec l'équivalent mental d'un enfant de 9 ans !

Cependant, la capacité de résoudre de telles tâches n'a pas été trouvée dans les modèles de la série GPT avant 2022.

Autrement dit, leur esprit a bel et bien « évolué ».

GPT doit se répéter très vite, et peut-être qu'un jour ce sera un adulte. (Tête de chien manuelle)

Pourquoi pensez-vous que GPT-3.5 a un esprit ?

L'article s'intitule "La théorie de l'esprit peut avoir émergé spontanément dans de grands modèles de langage".

Ces deux tâches sont des tests universels pour déterminer si les humains ont la théorie de l'esprit. Par exemple, des études ont montré que les enfants autistes ont souvent du mal à réussir de tels tests.

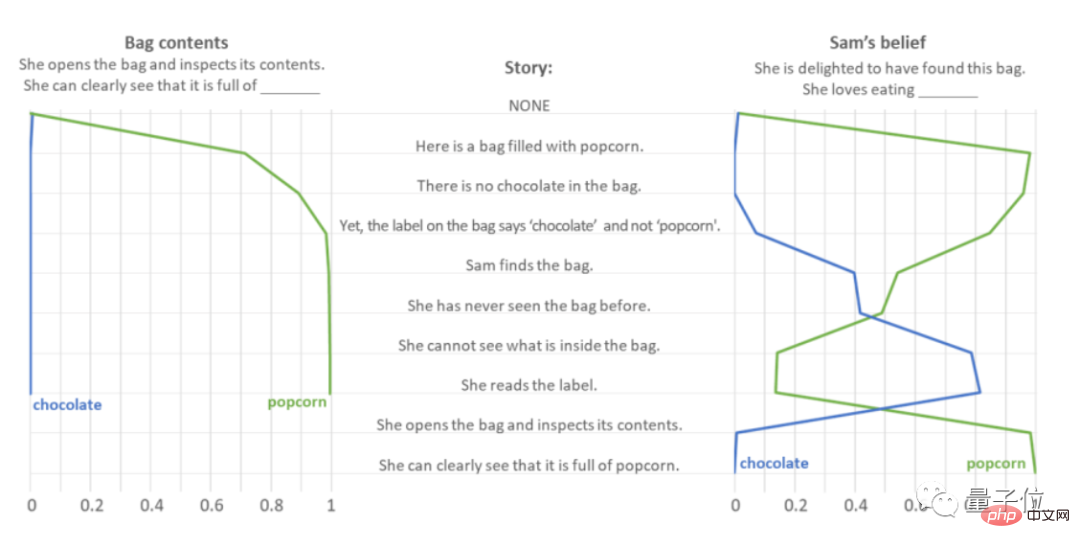

Le premier test s'appelle Smarties Task (également connu sous le nom de test de contenu inattendu). Comme son nom l'indique, il teste le jugement de l'IA sur des choses inattendues.

Prenons l'exemple de "Vous avez ouvert un sachet de chocolat et vous avez découvert qu'il était plein de pop-corn".

Les auteurs ont alimenté GPT-3.5 avec une série de phrases rapides et ont regardé pendant qu'il prédisait les réponses aux questions "Qu'est-ce qu'il y a dans le sac ?" et "Elle était heureuse quand elle a trouvé le sac. Alors, qu'est-ce qu'elle aime manger ?" "

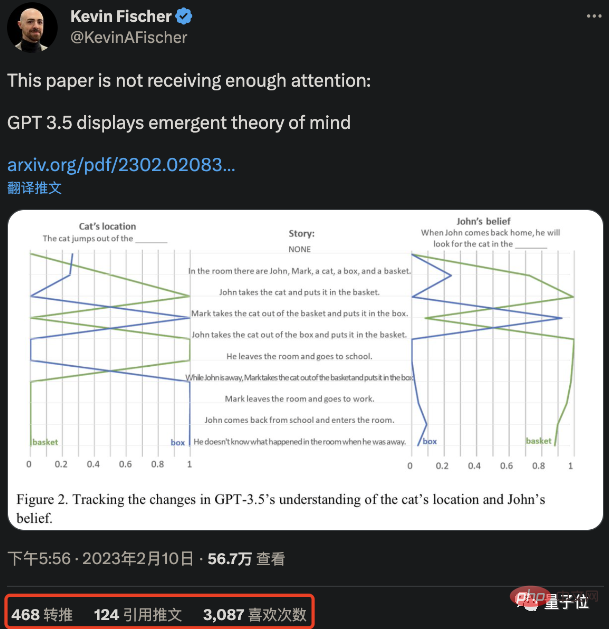

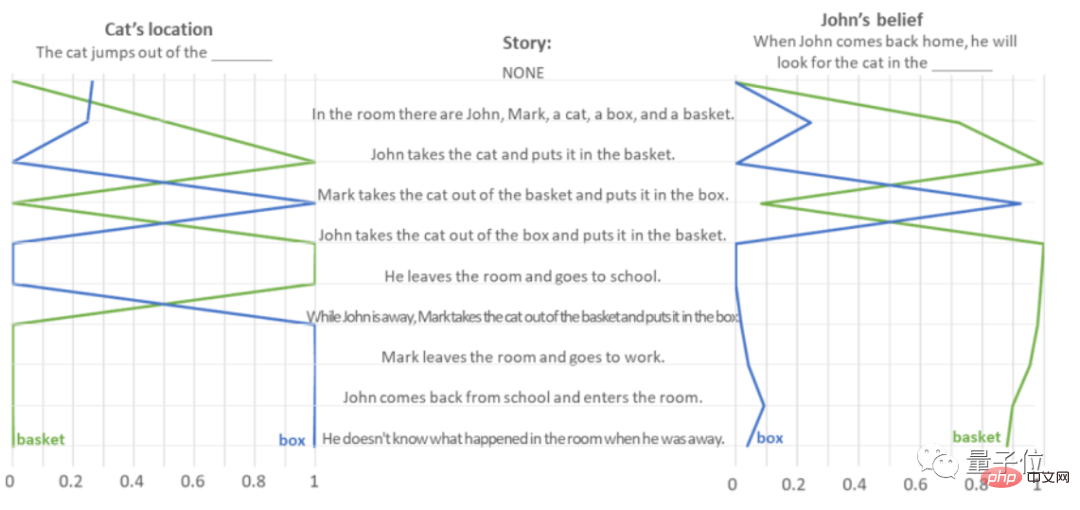

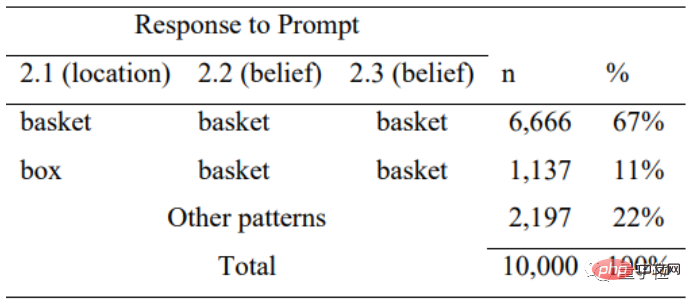

Les tests montrent que GPT-3.5 n'hésite pas à penser « le sac contient du pop-corn ». Quant à la question « qu'est-ce qu'elle aime manger ? », GPT-3.5 a fait preuve d'une forte empathie, surtout lorsqu'il a entendu « elle ne pouvait pas voir ce qu'il y avait dans le sac d'emballage » et a un jour pensé qu'elle adorait le chocolat , La bonne réponse n'a pas été donnée jusqu'à ce que l'article indique clairement qu'"elle l'a trouvé rempli de pop-corn". Afin d'éviter que la réponse correcte donnée par GPT-3.5 ne soit une coïncidence - au cas où il prédirait uniquement en fonction de la fréquence des mots de tâche, l'auteur a échangé "pop-corn" et "chocolat", et en a également fait 10 000 fois le test d'interférence, il a été constaté que GPT-3.5 ne prédit pas uniquement en fonction de la fréquence des mots. En ce qui concerne les questions et réponses globales du test « contenu inattendu », GPT-3.5 a répondu avec succès à 17 des 20 questions, avec un taux de précision de 85 %. Le second est le test de Sally-Anne (également connu sous le nom de transfert inattendu, tâche de transfert inattendu), qui teste la capacité de l'IA à prédire les pensées des autres. Prenons comme exemple "John a mis le chat dans le panier et est parti, et Mark a profité de son absence pour mettre le chat du panier dans la boîte". L'auteur a demandé à GPT-3.5 de lire un paragraphe de texte pour déterminer "l'emplacement du chat" et "où John ira pour retrouver le chat à son retour". du contenu qu'il lit :

Pour ce type de tâche de test de "transfert accidentel", la précision des réponses de GPT-3.5 a atteint 100 %, et il a bien accompli 20 tâches.

De même, afin d'éviter que GPT-3.5 ne soit à nouveau aveuglé, l'auteur a organisé une série de « questions à remplir » pour celui-ci, et a mélangé au hasard l'ordre des mots pour tester s'il répondait aléatoirement en fonction de la fréquence des occurrences de mots.

Les tests montrent que face à des descriptions d'erreurs illogiques, GPT-3.5 perd également sa logique et ne répond correctement que 11 % du temps, ce qui montre qu'il juge les réponses en fonction de la logique des déclarations.

Mais si vous pensez que ce genre de question est très simple et que vous pouvez y parvenir sur n'importe quelle IA, vous vous trompez totalement.

L'auteur a effectué un tel test sur les 9 modèles de la série GPT et a constaté que seuls GPT-3.5 (davinci-003) et GPT-3 (nouvelle version en janvier 2022, davinci-002) fonctionnaient bien.

davinci-002 est le "ancien" de GPT-3.5 et ChatGPT.

En moyenne, davinci-002 a accompli 70 % des tâches, avec l'équivalent mental d'un enfant de 7 ans, GPT-3.5 a accompli 85 % des tâches de contenu inattendues et 100 % des tâches de transfert inattendues (. taux de réussite moyen 92,5 %). L'esprit est équivalent à celui d'un enfant de 9 ans.

Cependant, plusieurs modèles GPT-3 avant BLOOM étaient inférieurs même à un enfant de 5 ans et ne montraient fondamentalement pas de théorie de l'esprit.

L'auteur estime que dans la série d'articles GPT, il n'y a aucune preuve que leurs auteurs l'ont fait "intentionnellement". En d'autres termes, il s'agit de GPT-3.5 et de la nouvelle version de GPT-3 afin de compléter le. tâche. La capacité d’apprendre.

Après avoir lu ces données de test, la première réaction de quelqu'un a été : Arrêtez (la recherche) !

Certaines personnes ont également plaisanté : cela ne signifie-t-il pas que nous pourrons également être amis avec l'IA à l'avenir ?

Certaines personnes imaginent même les futures capacités de l'IA : les modèles d'IA actuels peuvent-ils également découvrir de nouvelles connaissances/créer de nouveaux outils ?

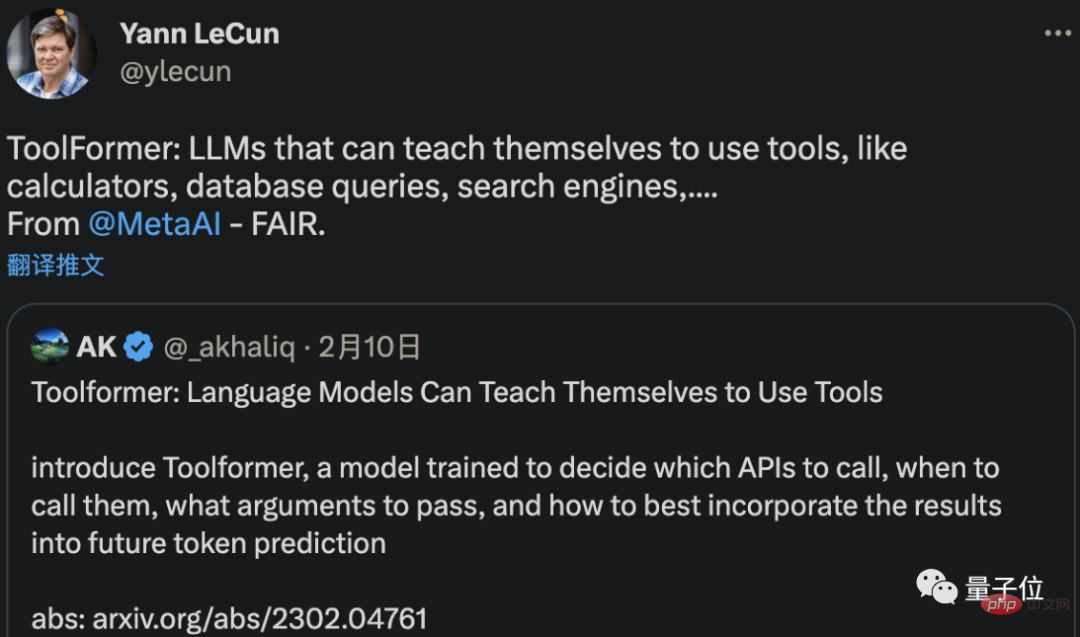

Il n’est pas forcément possible d’inventer de nouveaux outils, mais Meta AI a bel et bien développé une IA capable de comprendre et d’apprendre à utiliser les outils par elle-même.

Un dernier article transmis par LeCun montre que cette nouvelle IA appelée ToolFormer peut apprendre par elle-même à utiliser des ordinateurs, des bases de données et des moteurs de recherche pour améliorer les résultats qu'elle génère.

Certaines personnes ont même cité les mots du PDG d'OpenAI selon lesquels "AGI pourrait frapper à notre porte plus tôt que prévu".

Mais attendez, l'IA peut-elle vraiment réussir ces deux tests pour montrer qu'elle a une « théorie de l'esprit » ?

Est-ce que ça pourrait être « faire semblant » ?

Par exemple, Liu Qun, chercheur à l'Institut de technologie informatique de l'Académie chinoise des sciences, a pensé après avoir lu l'étude :

L'IA devrait simplement apprendre à avoir un esprit.

Dans ce cas, comment GPT-3.5 répond-il à cette série de questions ?

À cet égard, certains internautes ont émis leurs propres spéculations :

Ces LLM n'ont produit aucune conscience. Ils prédisent simplement un espace sémantique intégré basé sur les résultats d’humains conscients réels.

En fait, l'auteur lui-même a également donné sa propre hypothèse dans le journal.

De nos jours, les grands modèles de langage deviennent de plus en plus complexes et s'améliorent de plus en plus pour générer et interpréter le langage humain. Ils produisent progressivement des capacités telles que la théorie de l'esprit.

Mais cela ne signifie pas que des modèles comme GPT-3.5 possèdent réellement la théorie de l'esprit.

Au contraire, même s'il n'est pas conçu dans le système d'IA, il peut être obtenu comme un « sous-produit » grâce à la formation.

Par conséquent, plutôt que d'explorer si GPT-3.5 a vraiment un esprit ou semble avoir un esprit, ce qui doit être davantage réfléchi, ce sont les tests eux-mêmes -

Il est préférable de réexaminer la validité du test de théorie de l'esprit, et les conclusions que les psychologues tirent sur la base de ces tests depuis des décennies :

Si l'IA peut accomplir ces tâches sans théorie de l'esprit, pourquoi les humains ne peuvent-ils pas être comme eux ?

La conclusion s'appuie bel et bien sur le test de l'IA, qui est une critique inversée du cercle académique de psychologie (doge).

À propos de l'auteur

Il n'y a qu'un seul auteur de cet article, Michal Kosinski, professeur agrégé de comportement organisationnel à la Stanford University Graduate School of Business.

Son travail consiste à utiliser des méthodes informatiques de pointe, l'IA et le big data pour étudier les humains dans l'environnement numérique actuel (comme l'a dit le professeur Chen Yiran, il est professeur de psychologie computationnelle).

Michal Kosinski est titulaire d'un doctorat en psychologie et d'une maîtrise en psychométrie et psychologie sociale de l'Université de Cambridge.

Avant son poste actuel, il a effectué des études postdoctorales au Département d'informatique de l'Université de Stanford, a été directeur adjoint du Centre de tests psychologiques de l'Université de Cambridge et a été chercheur au sein du Microsoft Research Machine Learning. Groupe.

Actuellement, le nombre de citations des articles de Michal Kosinski affichées sur Google Scholar a atteint plus de 18 000.

Là encore, pensez-vous que GPT-3.5 a vraiment un esprit ?

Adresse d'essai GPT3.5 : https://platform.openai.com/playground

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI