Maison >Périphériques technologiques >IA >3 milliards ont dépassé les 175 milliards de GPT-3. Le nouveau modèle de Google a suscité de vives discussions, mais il s'est trompé sur l'âge de Hinton.

3 milliards ont dépassé les 175 milliards de GPT-3. Le nouveau modèle de Google a suscité de vives discussions, mais il s'est trompé sur l'âge de Hinton.

- PHPzavant

- 2023-04-14 11:49:02929parcourir

Un objectif important de l’intelligence artificielle est de développer des modèles dotés de fortes capacités de généralisation. Dans le domaine du traitement du langage naturel (NLP), les modèles linguistiques pré-entraînés ont fait des progrès significatifs à cet égard. Ces modèles sont souvent affinés pour s’adapter à de nouvelles tâches.

Récemment, des chercheurs de Google ont analysé diverses méthodes de réglage fin des instructions, y compris l'impact des extensions sur le réglage précis des instructions. Les expériences montrent que le réglage fin de l'instruction peut effectivement s'adapter en fonction du nombre de tâches et de la taille du modèle, et que les modèles comportant jusqu'à 540 milliards de paramètres peuvent en bénéficier de manière significative. Les recherches futures devraient encore augmenter le nombre de tâches et la taille du modèle. En outre, l'étude analyse également l'impact du réglage fin sur la capacité du modèle à effectuer des inférences, et les résultats sont très attractifs.

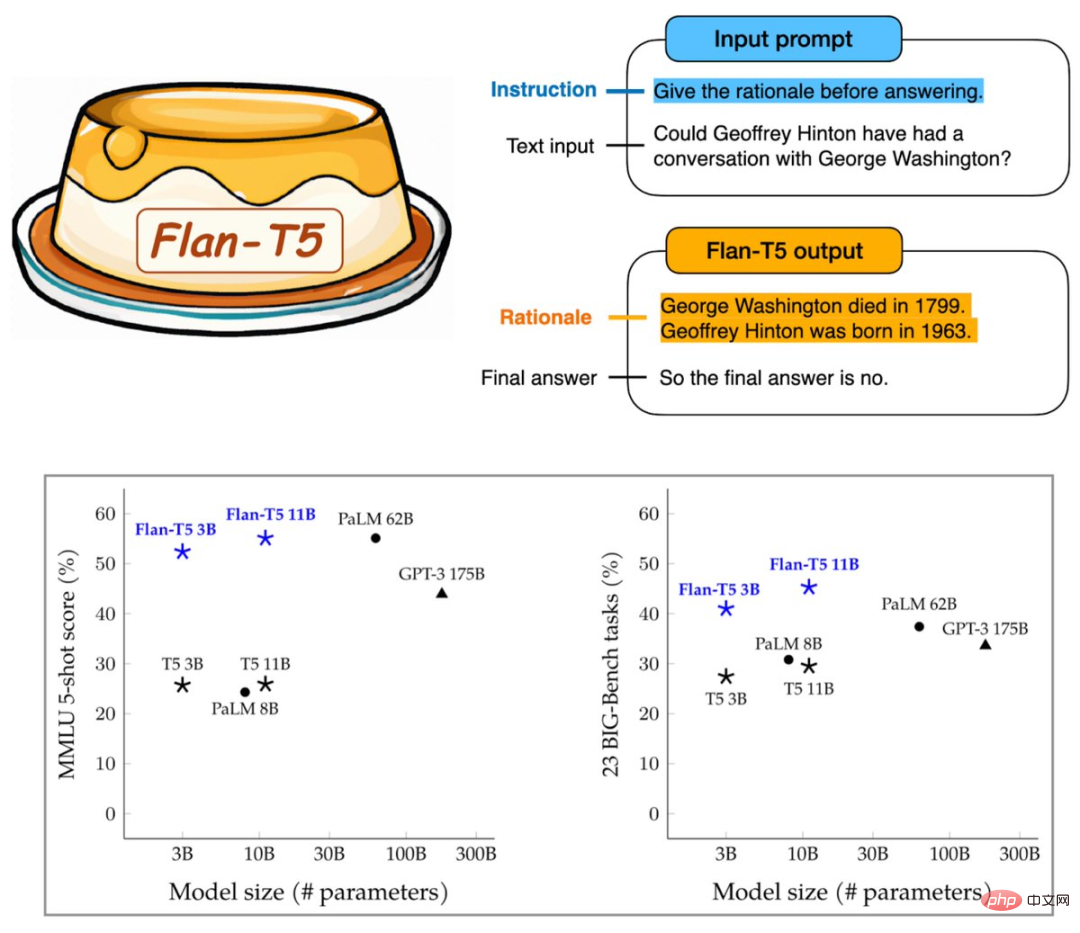

Le Flan-T5 résultant contient des instructions affinées pour plus de 1 800 tâches linguistiques, améliorant considérablement les invites et les capacités de raisonnement en plusieurs étapes. L'exécution du benchmark avec 3 milliards de paramètres peut dépasser les 175 milliards de paramètres de GPT-3.

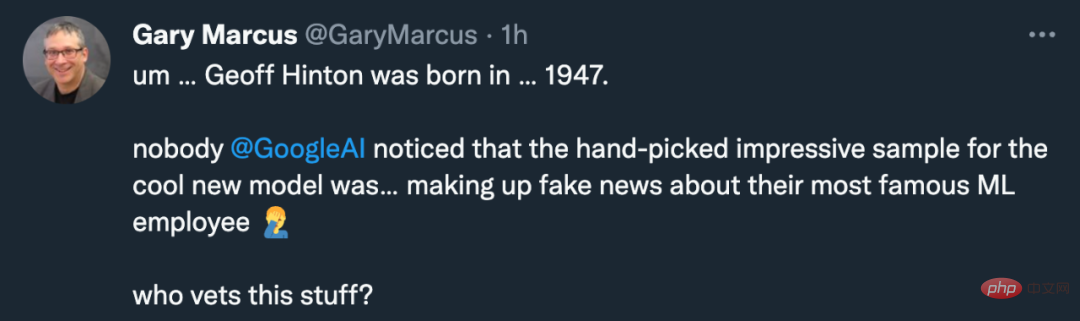

Il semble que Google ait trouvé un autre moyen d'améliorer les capacités des grands modèles. Cependant, cette recherche a non seulement suscité l’accueil de la communauté de l’apprentissage automatique, mais aussi les plaintes de Gary Marcus :

Pourquoi le modèle de Google s’est-il trompé sur la date de naissance du célèbre scientifique de Google, Geoffrey Hinton ? Il s’agissait évidemment d’un ancien né en 1947.

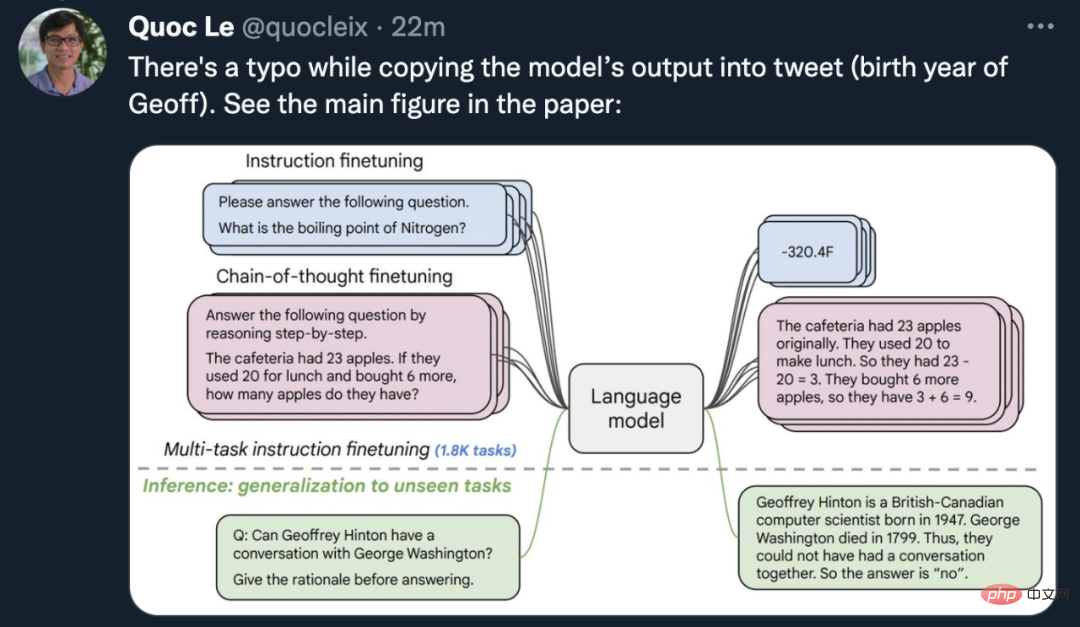

Quoc Le, scientifique en chef de Google Brain et l'un des auteurs de l'article, a rapidement rectifié la situation : l'image de l'intérimaire était fausse dans le journal, le modèle Flan-T5 n'était en réalité pas le cas. Je me trompe sur l'année de naissance de Geoff. Il y a une photo du certificat.

D'ailleurs, le célèbre spécialiste de l'IA né en 1963 est Jürgen Schmidhuber.

Puisque ce n’est pas le modèle d’IA qui est faux, voyons quels changements la nouvelle méthode de Google peut apporter aux modèles pré-entraînés.

Papier : Mise à l'échelle des modèles de langage affinés par les instructions

- Adresse papier : https://arxiv.org/abs/2210.11416

- Modèle public : https ://github.com/google-research/t5x/blob/main/docs/models.md#flan-t5-checkpoints

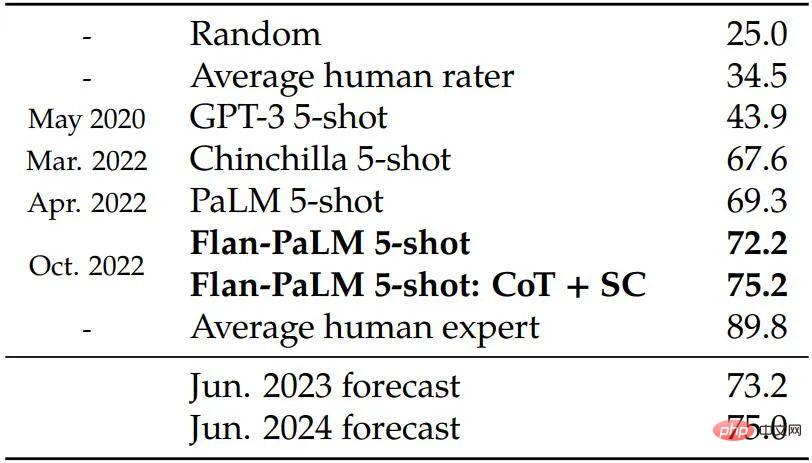

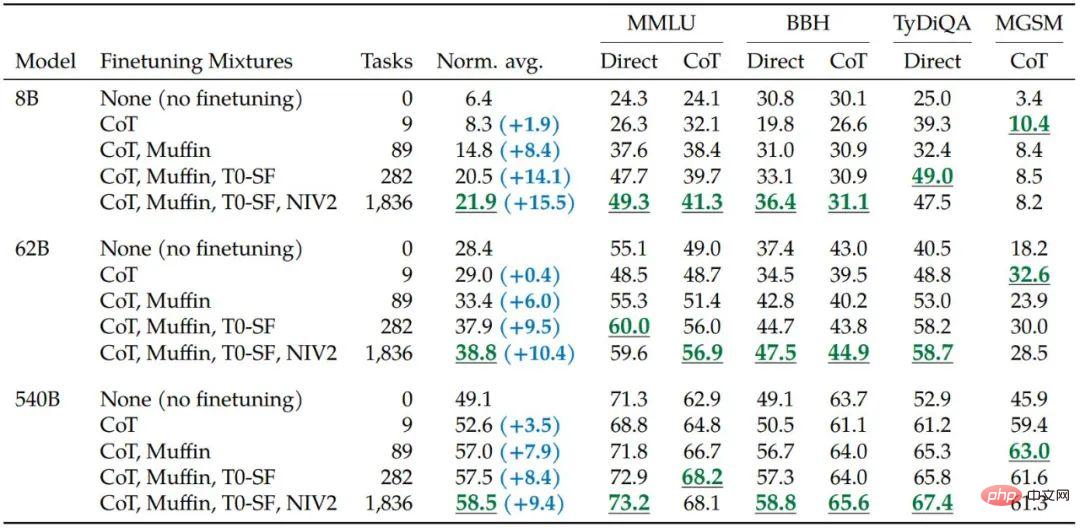

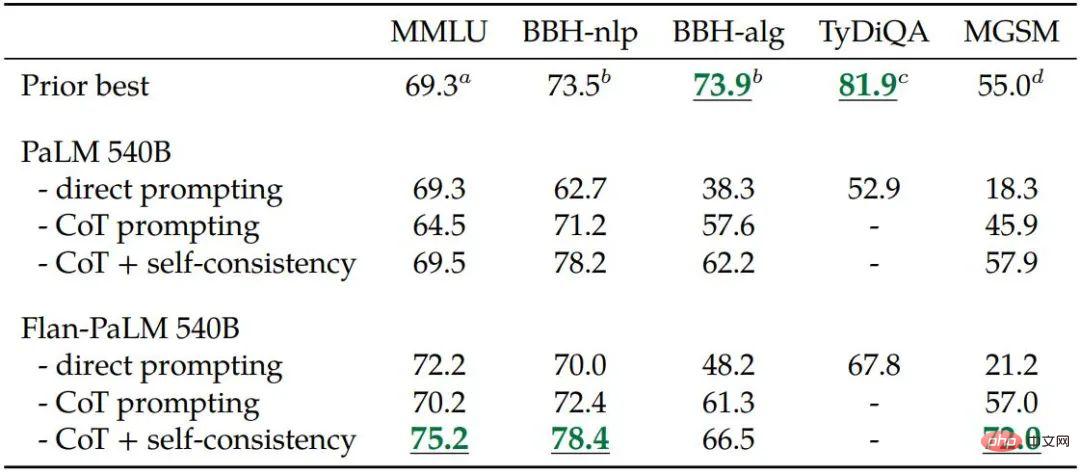

Cette étude utilise un modèle de paramètres 540B pour entraîner Flan-PaLM, ce qui conviendra -ajuster le nombre de tâches augmenté à plus de 1 800 et inclut les données de chaîne de pensée (CoT ; Wei et al., 2022b). Le Flan-PaLM formé surpasse PaLM et atteint un nouveau SOTA sur plusieurs benchmarks. En termes de capacités de raisonnement, Flan-PaLM est capable de tirer parti du CoT et de l'auto-cohérence (Wang et al., 2022c) pour atteindre une précision de 75,2 % sur la compréhension du langage multitâche à grande échelle (MMLU ; Hendrycks et al., 2020). Taux.

De plus, Flan-PaLM fonctionne nettement mieux que PaLM sur un ensemble de problèmes génératifs ouverts et difficiles, avec une convivialité considérablement améliorée.

Dans l'ensemble, cette étude de Google met en lumière des manières spécifiques d'utiliser le réglage fin des instructions pour améliorer les performances du modèle.

Méthode

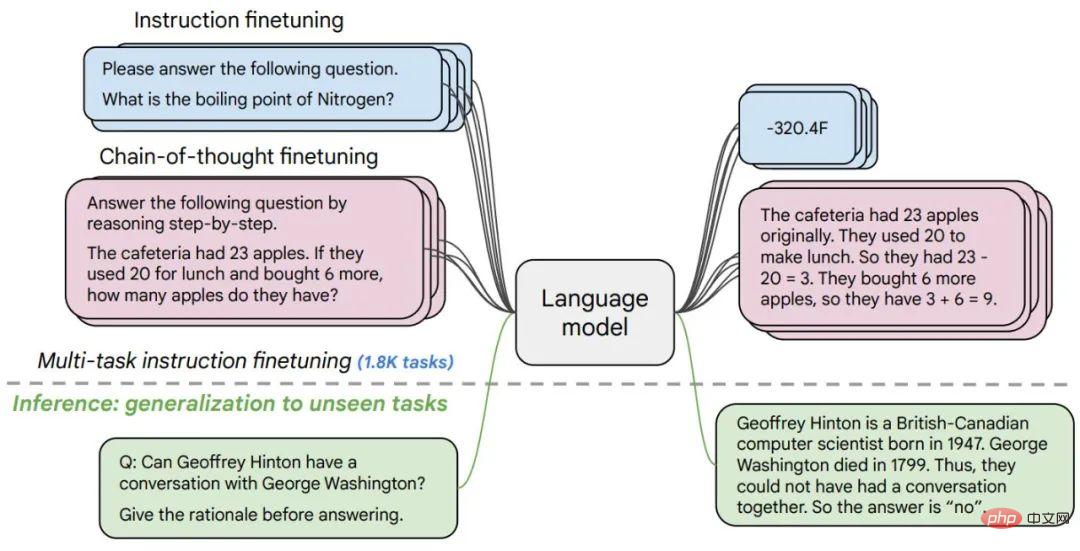

Plus précisément, cette recherche se concentre principalement sur plusieurs aspects qui affectent le réglage fin de l'enseignement, notamment : (1) l'augmentation du nombre de tâches, (2) l'augmentation de la taille du modèle et (3) l'ajustement fin de la données de la chaîne de pensée.

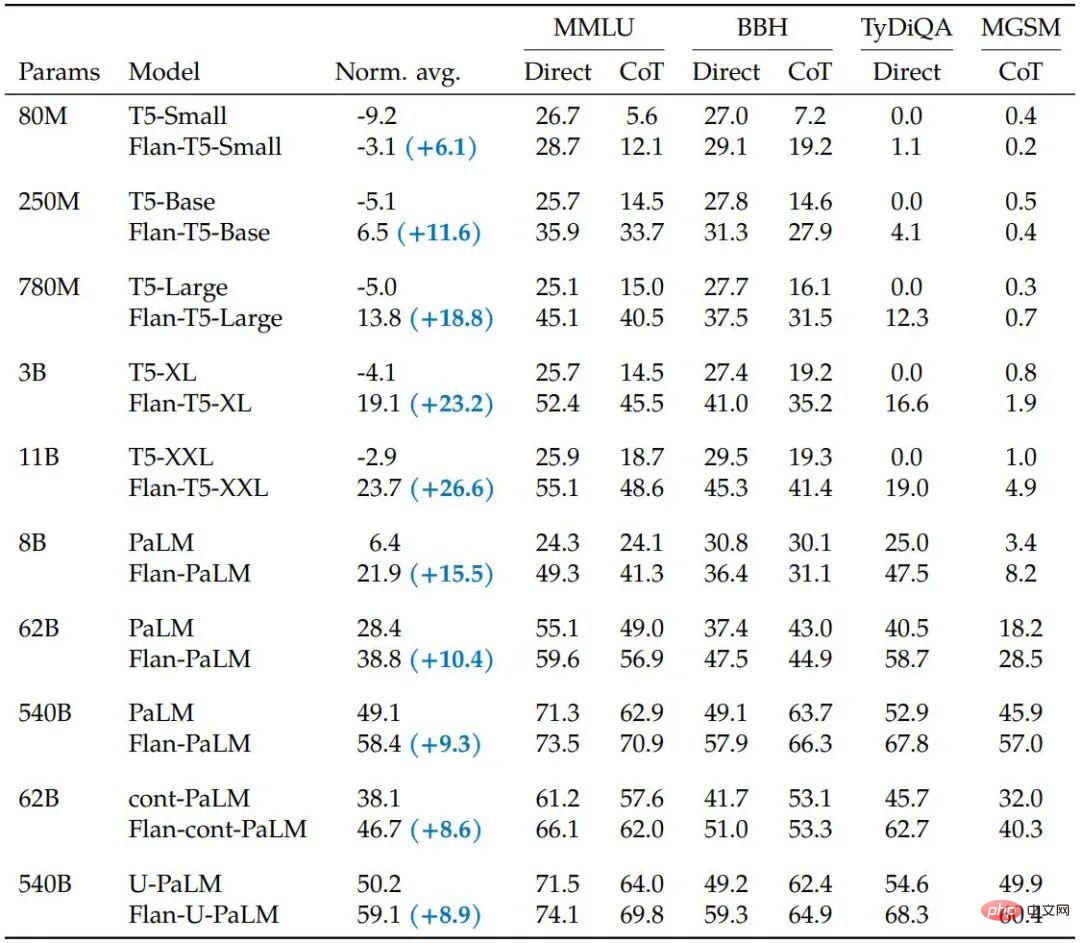

L'étude a révélé que le réglage fin de l'instruction avec les aspects ci-dessus améliorait considérablement diverses classes de modèles (PaLM, T5, U-PaLM), les paramètres d'invite (zéro-coup, quelques-coups, CoT) et les critères d'évaluation (MMLU, BBH, TyDiQA, MGSM, génération ouverte). Par exemple, le Flan-PaLM 540B avec réglage fin des instructions surpasse largement le PALM 540B sur 1,8K tâches (+9,4 % en moyenne). Le Flan-PaLM 540B atteint des performances de pointe sur plusieurs tests, tels que 75,2 % sur cinq MMLU.

Les chercheurs ont également divulgué le point de contrôle Flan-T5, qui atteint de solides performances en quelques tirs, même par rapport à des modèles plus grands tels que le PaLM 62B. Dans l’ensemble, le réglage fin de l’instruction est une approche générale visant à améliorer les performances et la convivialité des modèles linguistiques pré-entraînés.

Figure 1. Les chercheurs ont affiné divers modèles de langage sur plus de 1 800 tâches, avec/sans échantillons (zéro échantillon et quelques échantillons) et avec/sans chaînes de pensée. Le réglage fin permet une généralisation sur une gamme de scénarios d’évaluation.

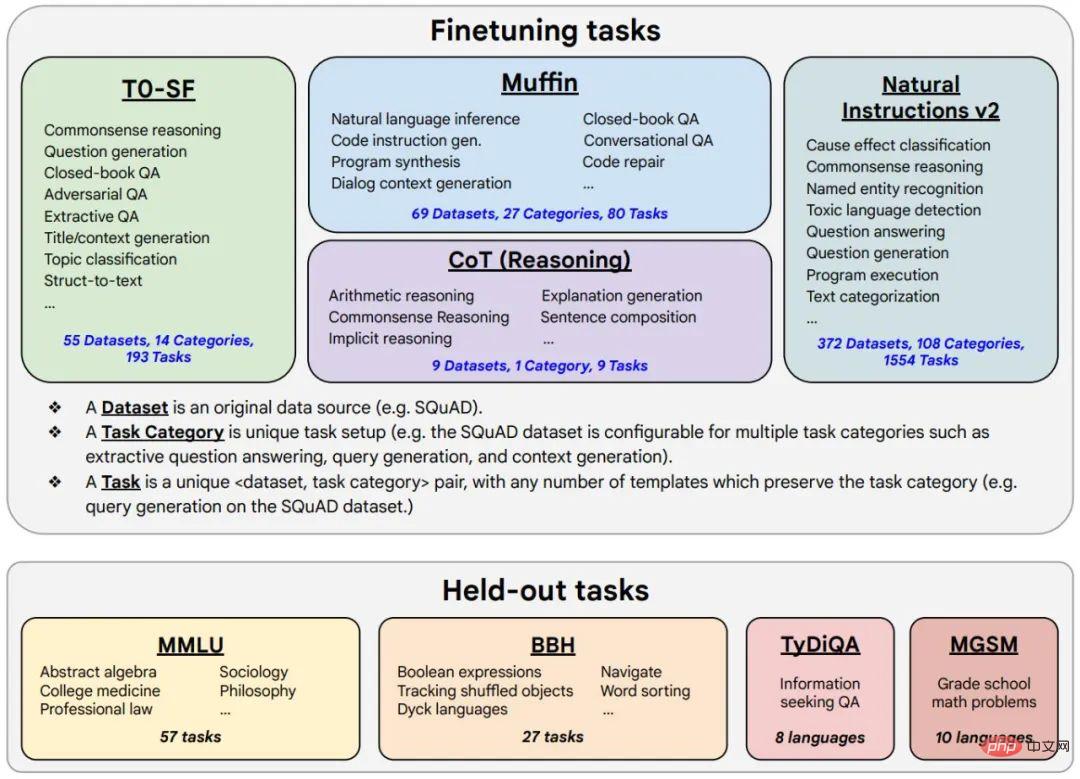

Figure 2. Les données de réglage fin comprennent 473 ensembles de données, 146 catégories de tâches et un total de 1836 tâches.

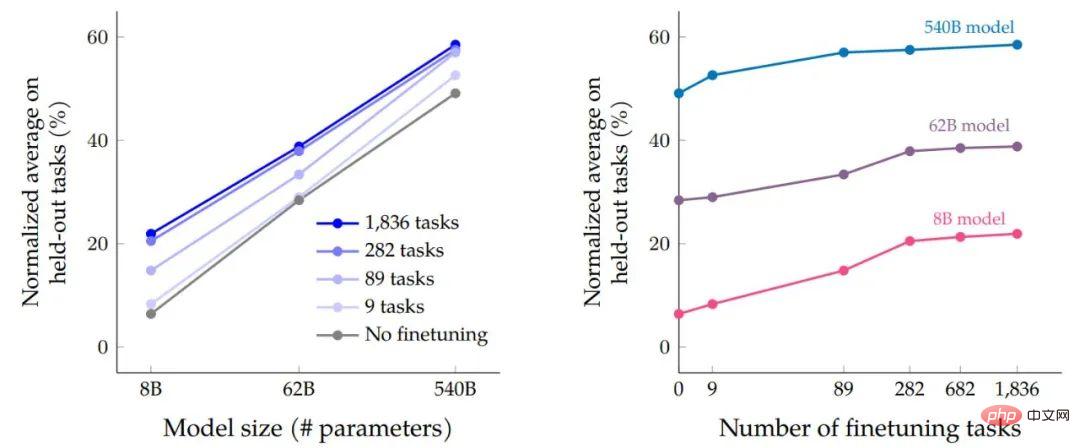

Une fois les processus de réglage fin des données et de réglage du programme terminés, les chercheurs ont comparé l'impact de l'expansion de l'échelle en fonction des performances de la taille du modèle sur la tâche. Premièrement, pour les trois tailles de modèles, le réglage fin des instructions multitâches entraîne d'importantes améliorations des performances par rapport à l'absence de réglage fin, avec des gains allant de 9,4 % à 15,5 %. Deuxièmement, augmenter le nombre de tâches de réglage fin peut améliorer les performances.

Enfin, nous pouvons voir qu'augmenter la taille du modèle d'un ordre de grandeur (8B → 62B ou 62B → 540B) peut améliorer considérablement les performances des modèles affinés et non affinés.

L'impact du réglage fin des instructions multitâches sur la précision par rapport à la taille du modèle (quantité de paramètres) et l'expansion du nombre et de l'échelle des tâches de réglage fin.

L'augmentation du nombre de tâches dans les données de réglage fin améliore les performances de Flan-PaLM sur la plupart des benchmarks d'évaluation.

Les chercheurs démontrent que l'inclusion de neuf ensembles de données annotés avec des chaînes de pensées (CoT) dans un mélange affiné améliore les capacités d'inférence. Le tableau ci-dessous montre que les capacités d'invite CoT de Flan-PaLM surpassent PaLM sur les quatre critères d'évaluation retenus.

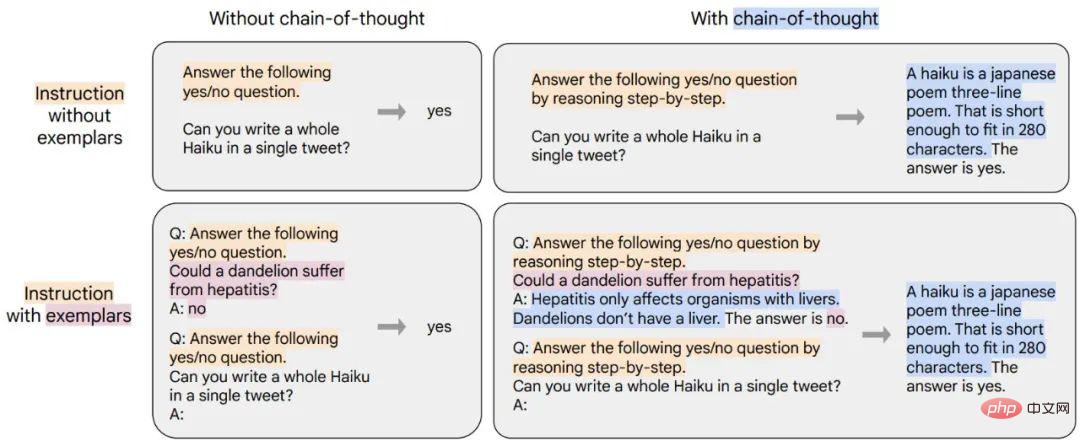

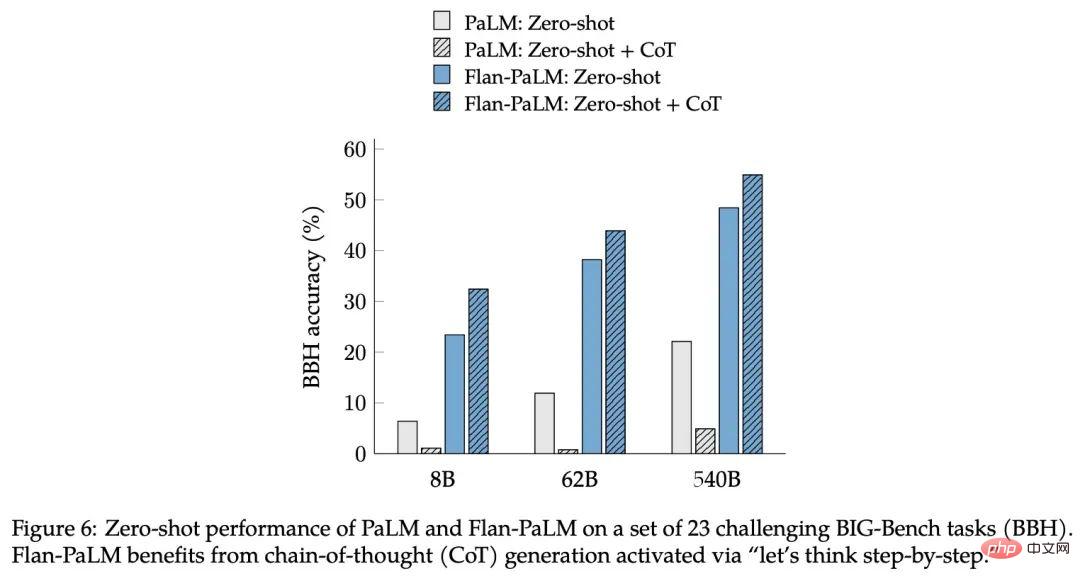

Cette étude a révélé qu'un autre avantage des instructions de réglage fin pour les données CoT est qu'elles peuvent réaliser une inférence sans tir. Le modèle génère lui-même des capacités d'inférence sans un petit nombre d'échantillons pour CoT. nécessitent de nombreux ajustements techniques pour réussir.

Figure 6 : Performances sans tir de PaLM et Flan-PaLM sur un ensemble de 23 tâches BIG-Bench (BBH) difficiles. Flan-PaLM nécessite la génération d'une Chaîne de Pensées (CoT) activée par la commande "Pensons pas à pas".

Pour démontrer la généralité de la nouvelle méthode, Google a formé T5, PaLM et U-PaLM, couvrant une gamme de tailles de modèles allant de 80 millions à 540 milliards de paramètres, et a constaté que tous les modèles peuvent améliorer considérablement les performances.

Tableau 5. Le réglage fin des instructions (Flan) améliore les performances par rapport aux autres méthodes de pré-entraînement continu.

Après les tests, le réglage précis des instructions a considérablement amélioré les performances moyennes normalisées de tous les types de modèles, le modèle T5 bénéficiant le plus du réglage précis des instructions par rapport aux modèles non réglés. Ces résultats sont assez solides pour certains benchmarks : par exemple, Flan-T5-XL a atteint un score MMLU de 47,6 % avec seulement 3 milliards de paramètres, dépassant le score de 43,9 % du GPT-3 avec 175 milliards de paramètres.

En plus des benchmarks NLP, les modèles de langage sont également capables de générer des réponses longues aux demandes de questions ouvertes. À cet égard, les références standard de la PNL et les mesures automatisées utilisées pour les évaluer sont insuffisantes pour mesurer les préférences humaines. Les chercheurs ont évalué cela en créant un ensemble d’évaluation de 190 exemples. L'ensemble d'évaluation se compose de questions posées au modèle de manière générale dans cinq catégories difficiles de 20 questions chacune : créativité, raisonnement contextuel, raisonnement complexe, planification et explication.

Pour 60 de ces exemples (issus des catégories de raisonnement complexe, de planification et d'explication), l'étude a créé une variation avec une phrase déclenchante de la chaîne de pensée (par exemple, « Pensons étape par étape ») comme coup de pouce. Une autre évaluation a été menée sur l’opportunité d’activer le tir zéro sur le CoT. En plus des 160 entrées zéro-shot mentionnées ci-dessus, l'étude comprenait également 30 entrées pour tester les capacités de quelques-shots où des modèles de langage forts sans ajustement pédagogique se sont avérés performants.

Les chercheurs pensent que le réglage fin des instructions et l'expansion de l'échelle peuvent améliorer continuellement les performances des grands modèles de langage, et que le réglage fin est crucial pour les capacités de raisonnement et peut également généraliser les capacités des modèles. En combinant le réglage fin des instructions avec d'autres techniques d'adaptation de modèles telles que UL2R, Google propose le modèle Flan-U-PaLM le plus puissant de ce travail.

Il est important de noter que le réglage fin des instructions n'augmente pas de manière significative le coût de calcul comme l'expansion de l'échelle du modèle. Par exemple, pour le PaLM 540B, le réglage fin des instructions ne nécessite que 0,2 % des calculs préalables à la formation, mais il peut normaliser l'évaluation croisée. L’augmentation moyenne a été de 9,4 %. Les petits modèles qui utilisent des nudges directifs peuvent parfois surpasser les modèles plus grands sans nudges.

Pour ces raisons, les chercheurs recommandent un réglage fin des instructions pour presque tous les modèles linguistiques pré-entraînés.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI