Maison >Périphériques technologiques >IA >Du transformateur au modèle de diffusion, découvrez les méthodes d'apprentissage par renforcement basées sur la modélisation de séquences dans un seul article

Du transformateur au modèle de diffusion, découvrez les méthodes d'apprentissage par renforcement basées sur la modélisation de séquences dans un seul article

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-14 11:25:031082parcourir

Les modèles génératifs à grande échelle ont apporté d’énormes avancées dans le traitement du langage naturel et même dans la vision par ordinateur au cours des deux dernières années. Récemment, cette tendance a également affecté l'apprentissage par renforcement, notamment l'apprentissage par renforcement hors ligne (offline RL), tel que Decision Transformer (DT)[1], Trajectory Transformer (TT)[2], Gato[3], Diffuser[4], etc. Cette méthode considère les données d'apprentissage par renforcement (y compris le statut, l'action, la récompense et le retour à l'emploi) comme une chaîne de données de séquence déstructurées et modélise ces données de séquence comme la tâche principale de l'apprentissage. Ces modèles peuvent être formés à l’aide de méthodes d’apprentissage supervisé ou auto-supervisé, évitant ainsi les signaux de gradient instables de l’apprentissage par renforcement traditionnel. Même en utilisant des méthodes complexes d’amélioration des politiques et d’estimation de la valeur, ils affichent de très bonnes performances en matière d’apprentissage par renforcement hors ligne.

Cet article parlera brièvement de ces méthodes d'apprentissage par renforcement basées sur la modélisation de séquences. Dans le prochain article, l'auteur présentera notre nouveau planificateur d'autoencodage de trajectoire (TAP), qui utilise l'autoencodeur variationnel quantifié vectoriel (VQ-VAE). Une méthode de modélisation de séquences et de planification efficace dans un espace d'action latent.

Transformer et apprentissage par renforcement

L'architecture Transformer [5] a été proposée en 2017 et a lentement déclenché une révolution dans le traitement du langage naturel. Le BERT et le GPT-3 qui ont suivi ont progressivement poussé la combinaison d'auto-supervision + Transformer dans un nouveau Highly. , si des propriétés telles que l'apprentissage en quelques étapes émergent constamment dans le domaine du traitement du langage naturel, elles commencent également à s'étendre à des domaines tels que la vision par ordinateur [6][7].

Cependant, pour l’apprentissage par renforcement, ce processus ne semble pas particulièrement évident avant 2021. En 2018, le mécanisme d'attention multi-têtes a également été introduit dans l'apprentissage par renforcement [8]. Ce type de travail est essentiellement appliqué dans des domaines similaires au semi-symbolique (sous-symbolique) pour tenter de résoudre le problème de la généralisation de l'apprentissage par renforcement. Depuis lors, ces tentatives ont été tièdes. Selon l'expérience personnelle de l'auteur, Transformer ne présente en réalité pas d'avantage stable et écrasant en matière d'apprentissage par renforcement, et il est également difficile à former. Dans l'un de nos travaux utilisant le GCN relationnel pour l'apprentissage par renforcement en 20 ans [9], nous avons en fait essayé Transformer en coulisses, mais c'était fondamentalement bien pire que la structure traditionnelle (similaire à CNN), et il était difficile de former et de former de manière stable. obtenir une politique utilisable. Pourquoi Transformer n'est pas compatible avec l'apprentissage par renforcement en ligne traditionnel (RL en ligne) est toujours une question ouverte. Par exemple, Melo [10] a expliqué que c'est parce que l'initialisation des paramètres du Transformer traditionnel n'est pas adaptée à l'apprentissage par renforcement, je n'en discuterai donc pas. plus loin ici.

Mi-2021, la sortie de Decision Transformer (DT) et Trajectory Transformer (TT) a déclenché une nouvelle vague d'applications Transformer en RL. L'idée de ces deux travaux est en fait très simple : si les algorithmes de Transformer et d'apprentissage par renforcement en ligne ne sont pas très compatibles, que diriez-vous simplement de traiter l'apprentissage par renforcement comme une tâche d'apprentissage auto-supervisée ? Profitant du fait que le concept d'apprentissage par renforcement hors ligne est également très populaire, ces deux travaux ont verrouillé leurs principales tâches cibles dans la modélisation d'ensembles de données hors ligne, puis utilisent ce modèle de séquence pour le contrôle et la prise de décision.

Pour l'apprentissage par renforcement, la séquence dite est la trajectoire  composée de l'état s, de l'action

composée de l'état s, de l'action  , de la récompense r et de la valeur v. La valeur est actuellement généralement remplacée par le retour à l'achat, qui peut être considéré comme une estimation de Monte Carlo. L'ensemble de données hors ligne est constitué de ces trajectoires. La génération de trajectoires est liée à la dynamique de l'environnement et à la politique comportementale. La modélisation dite de séquence consiste à modéliser la distribution de probabilité (distribution) qui génère cette séquence, ou à proprement parler, certaines des probabilités conditionnelles.

, de la récompense r et de la valeur v. La valeur est actuellement généralement remplacée par le retour à l'achat, qui peut être considéré comme une estimation de Monte Carlo. L'ensemble de données hors ligne est constitué de ces trajectoires. La génération de trajectoires est liée à la dynamique de l'environnement et à la politique comportementale. La modélisation dite de séquence consiste à modéliser la distribution de probabilité (distribution) qui génère cette séquence, ou à proprement parler, certaines des probabilités conditionnelles.

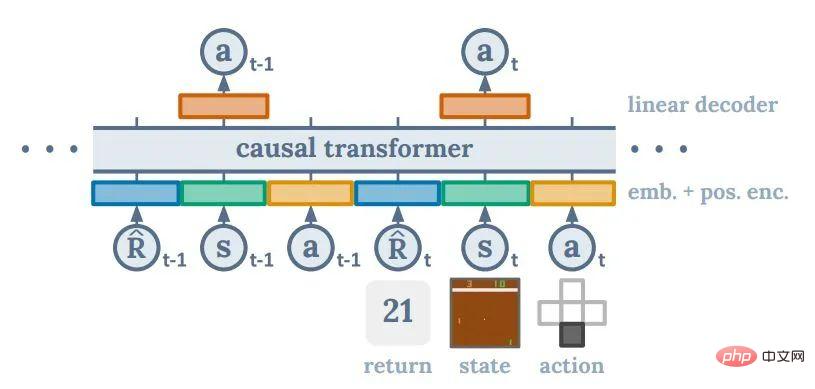

Decision Transformer

DT consiste à modéliser une cartographie des données et valeurs passées vers les actions (politique conditionnée par le retour), ce qui consiste à modéliser l'espérance mathématique de la probabilité conditionnelle d'une action . Cette idée est très similaire à Upside Down RL [11], mais il est très probable que la motivation directe derrière elle est d'imiter la méthode de GPT2/3 pour accomplir des tâches en aval basées sur des invites. L’un des problèmes de cette approche est qu’il n’existe aucun moyen systématique de décider quelle est la meilleure valeur cible. Cependant, les auteurs de DT ont constaté que même si la valeur cible est définie sur le rendement le plus élevé de l'ensemble des données, les performances finales de DT peuvent être très bonnes.

. Cette idée est très similaire à Upside Down RL [11], mais il est très probable que la motivation directe derrière elle est d'imiter la méthode de GPT2/3 pour accomplir des tâches en aval basées sur des invites. L’un des problèmes de cette approche est qu’il n’existe aucun moyen systématique de décider quelle est la meilleure valeur cible. Cependant, les auteurs de DT ont constaté que même si la valeur cible est définie sur le rendement le plus élevé de l'ensemble des données, les performances finales de DT peuvent être très bonnes.

Pour les personnes ayant une formation en apprentissage par renforcement, il est très contre-intuitif qu'une méthode comme DT puisse atteindre de fortes performances. Si des méthodes telles que DQN et Policy Gradient ne peuvent considérer le réseau neuronal que comme une fonction appropriée pouvant être utilisée pour l’interpolation et la généralisation, l’amélioration des politiques et la valorisation dans l’apprentissage par renforcement restent au cœur de la construction des politiques. On peut dire que DT est entièrement basé sur des réseaux de neurones. L'ensemble du processus permettant de connecter une valeur cible potentiellement irréaliste à une action appropriée est complètement une boîte noire. Le succès du DT peut être considéré comme quelque peu déraisonnable du point de vue de l'apprentissage par renforcement, mais je pense que c'est le charme de ce type de recherche empirique. L'auteur estime que la capacité de généralisation des réseaux de neurones, ou Transformers, pourrait dépasser les attentes antérieures de l'ensemble de la communauté RL.

DT est également très simple parmi toutes les méthodes de modélisation de séquences, et presque tous les problèmes fondamentaux de l'apprentissage par renforcement sont résolus dans Transformer. Cette simplicité est l’une des raisons pour lesquelles il est actuellement le plus populaire. Cependant, sa nature de boîte noire nous fait également perdre beaucoup de contrôle au niveau de la conception des algorithmes, et certaines avancées de l’apprentissage par renforcement traditionnel sont difficiles à y intégrer. L'efficacité de ces résultats a été confirmée à plusieurs reprises dans certaines expériences à très grande échelle (telles que AlphaGo, AlphaStar, VPT). L'approche de

Trajectory Transformer

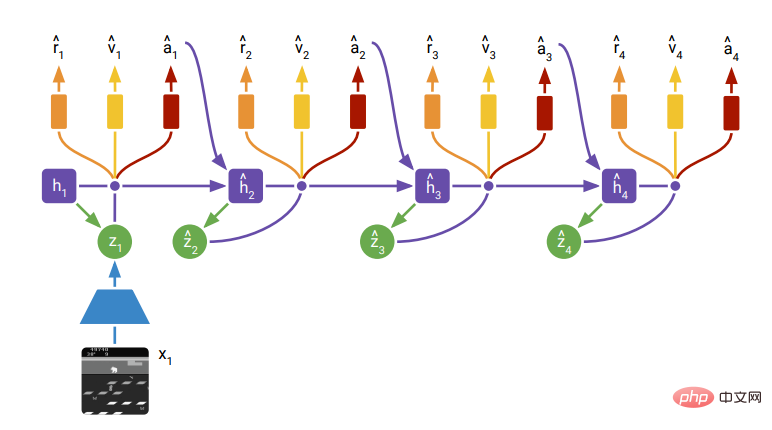

TT est plus similaire à la méthode traditionnelle de planification d'apprentissage par renforcement basé sur un modèle (RL basée sur un modèle). En termes de modélisation, il discrétise les éléments de la séquence entière, puis utilise une méthode auto-régressive discrète comme GPT-2 pour modéliser l'intégralité de l'ensemble de données hors ligne. Cela lui permet de modéliser la suite d’une séquence donnée moins le retour à l’ordre. Parce qu'il modélise la distribution des séquences ultérieures, TT devient en fait un modèle de génération de séquences. En recherchant une séquence avec une meilleure estimation de valeur dans la séquence générée, TT peut produire un « plan optimal ». Quant à la méthode de recherche de la séquence optimale, TT utilise une méthode couramment utilisée en langage naturel : une variante de la recherche par faisceau. Fondamentalement, il s'agit de toujours conserver la partie optimale de la séquence

dans la séquence développée, puis de trouver le prochain ensemble de séquences optimales  en fonction d'elles.

en fonction d'elles.

Du point de vue de l'apprentissage par renforcement, le TT n'est pas aussi peu orthodoxe que le DT. Ce qui est intéressant, c'est que (comme DT), il abandonne complètement la structure de graphe causal du processus de décision markovien original dans l'apprentissage par renforcement. Les méthodes précédentes basées sur des modèles, telles que PETS, le modèle mondial, dramerv2, etc., suivent toutes la définition de la fonction politique, de la fonction de transfert, de la fonction de récompense, etc. dans le processus de Markov (ou Markov implicite), c'est-à-dire la condition de la répartition de l'état est l'état de l'étape précédente, et les actions, récompenses et valeurs sont toutes déterminées par l'état actuel. L’ensemble de la communauté de l’apprentissage par renforcement estime généralement que cela peut améliorer l’efficacité des échantillons, mais une telle structure graphique peut en réalité constituer une contrainte. Le passage de RNN à Transformer dans le domaine du langage naturel et de CNN à Transformer dans le domaine de la vision par ordinateur reflète en réalité : à mesure que les données augmentent, laisser le réseau apprendre par lui-même la structure du graphe est plus propice à l'obtention d'un modèle plus performant. .

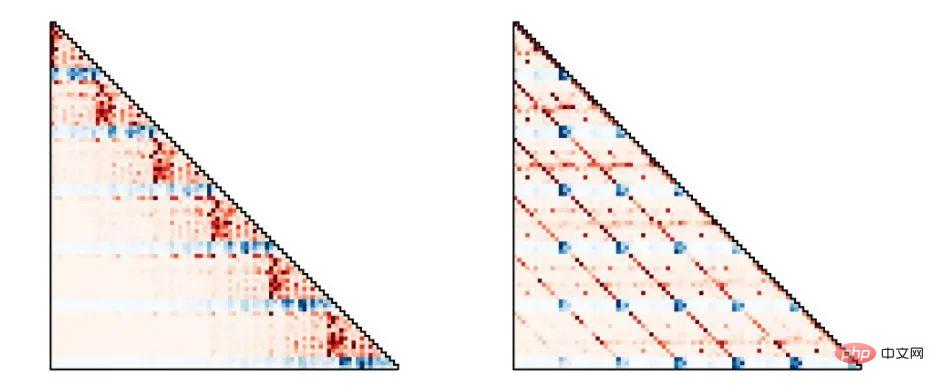

DreamerV2, Figure 3Étant donné que TT confie essentiellement toutes les tâches de prédiction de séquence à Transformer, Transformer peut apprendre de meilleures structures graphiques à partir des données de manière plus flexible. Comme le montre la figure ci-dessous, les stratégies comportementales modélisées par TT montrent différentes structures graphiques en fonction de différentes tâches et ensembles de données. Le côté gauche de la figure correspond à la stratégie de Markov traditionnelle et le côté droit de la figure correspond à une stratégie de moyenne mobile d'action.

Trajectory Transformer, Figure 4

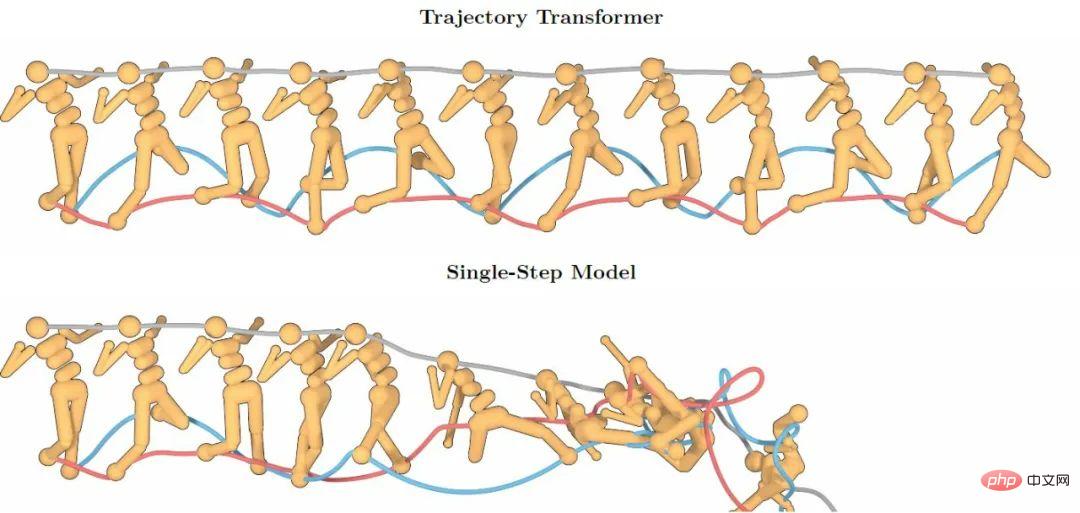

Les puissantes capacités de modélisation de séquence du Transformer apportent une plus grande précision de modélisation de séquences longues. La figure ci-dessous montre que les prédictions de TT sur 100 étapes sont toujours maintenues. Afin d'atteindre une grande précision, le modèle de prédiction en une seule étape qui suit les propriétés de Markov s'est rapidement effondré en raison du problème de superposition des erreurs de prédiction.

Trajectory Transformer, Figure 2TT Bien qu'elle soit différente des méthodes traditionnelles en termes de modélisation et de prédiction spécifiques, la capacité de prédiction qu'elle offre laisse encore beaucoup de place à d'autres résultats intégrant l'apprentissage par renforcement. à l'avenir. Bonne adhérence. Cependant, TT a un problème important en termes de vitesse de prédiction : comme il doit modéliser la distribution de la séquence entière, il discrétise tous les éléments de la séquence en fonction de dimensions. Cela signifie qu'un état à 100 dimensions doit occuper 100 éléments dans la séquence. . position, ce qui permet à la longueur réelle de la séquence modélisée de devenir particulièrement longue. Pour Transformer, sa complexité de calcul pour la longueur de séquence N est de  , ce qui rend l'échantillonnage d'une prédiction future à partir de TT très coûteux. Même une tâche TT comportant moins de 100 dimensions nécessite plusieurs secondes, voire des dizaines de secondes, pour prendre une décision en une seule étape. Un tel modèle est difficile à mettre en œuvre dans le contrôle d'un robot en temps réel ou dans l'apprentissage en ligne.

, ce qui rend l'échantillonnage d'une prédiction future à partir de TT très coûteux. Même une tâche TT comportant moins de 100 dimensions nécessite plusieurs secondes, voire des dizaines de secondes, pour prendre une décision en une seule étape. Un tel modèle est difficile à mettre en œuvre dans le contrôle d'un robot en temps réel ou dans l'apprentissage en ligne.

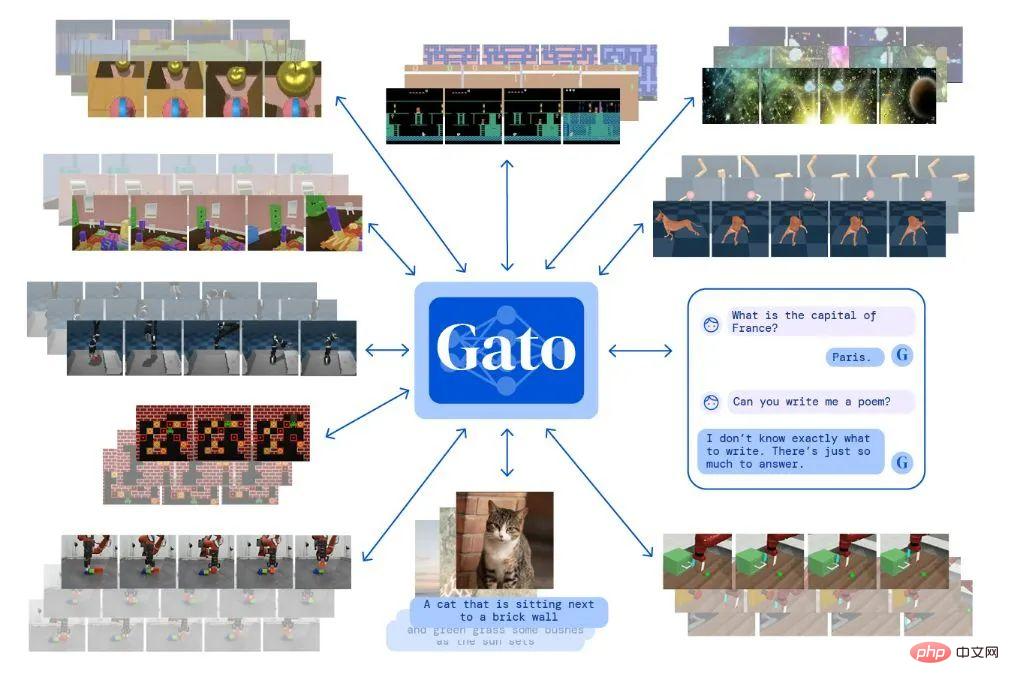

Gato

Gato est un "modèle généraliste" publié par Deepmind. Il s'agit en fait d'un modèle de génération multi-tâches multimodal. Avec le même Transformer, il peut effectuer diverses tâches allant de la réponse à des questions en langage naturel, à la description d'images, en passant par la lecture de jeux vidéo et le contrôle de robots. L'approche de Gato en matière de modélisation du contrôle continu est fondamentalement similaire à celle de TT. C'est juste que Gato ne fait pas d'apprentissage par renforcement au sens strict, il modélise simplement les données de séquence générées par la stratégie experte, puis lorsqu'il passe à l'action, il lui suffit d'échantillonner l'action suivante. .

Gato Blog

Autres modèles de génération de séquences : Modèle de diffusion

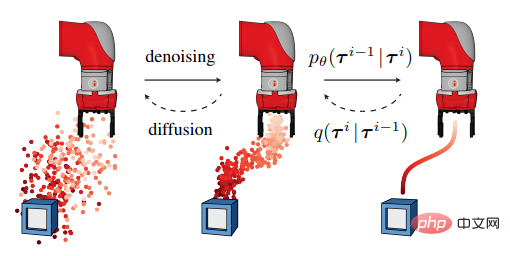

Le modèle de diffusion peut être considéré comme très populaire dans le domaine de la génération d'images récemment, DALLE-2 et Stable Diffusion est basé sur celui-ci pour la génération d'images. Diffuser a également appliqué cette méthode à l'apprentissage par renforcement hors ligne. Son idée est similaire à celle de TT. Elle modélise d'abord la distribution conditionnelle de la séquence, puis échantillonne les séquences futures possibles en fonction de l'état actuel.

Le diffuseur a une plus grande flexibilité que TT : il peut laisser le modèle remplir le chemin intermédiaire tout en définissant le point de départ et le point final, de sorte qu'un contrôle axé sur les objectifs (plutôt que de maximiser la fonction de récompense) puisse être obtenu. Il peut également mélanger plusieurs objectifs et conditions a priori pour atteindre les objectifs afin d'aider le modèle à accomplir la tâche.

Diffuser Figure 1Diffuser est également assez subversif par rapport au modèle d'apprentissage par renforcement traditionnel. Le plan qu'il génère ne se déroule pas progressivement sur la timeline, mais devient flou dans le sens de l'ensemble de la séquence. Progressivement précis. La poursuite des recherches sur le modèle de diffusion lui-même est également un sujet brûlant en vision par ordinateur, et le modèle lui-même connaîtra probablement une avancée décisive dans les prochaines années.

Cependant, le modèle de diffusion lui-même présente actuellement un défaut particulier par rapport aux modèles des autres générations, c'est-à-dire que sa vitesse de génération est plus lente que celle des modèles des autres générations. De nombreux experts dans des domaines connexes estiment que cette situation pourrait être atténuée dans les prochaines années. Cependant, le temps de génération de plusieurs secondes est actuellement difficilement acceptable pour des scénarios où l’apprentissage par renforcement nécessite un contrôle en temps réel. Diffuser a proposé une méthode pour améliorer la vitesse de génération : ajouter une petite quantité de bruit du plan de l'étape précédente pour régénérer le plan de l'étape suivante, mais cela réduirait dans une certaine mesure les performances du modèle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI