Périphériques technologiques

Périphériques technologiques IA

IA Des articles au code, de la recherche de pointe à la mise en œuvre industrielle, comprenez parfaitement la perception du BEV

Des articles au code, de la recherche de pointe à la mise en œuvre industrielle, comprenez parfaitement la perception du BEV

BEV Qu'est-ce que la perception exactement ? Quels sont les aspects de la perception du BEV auxquels les cercles académiques et industriels de la conduite autonome prêtent attention ? Cet article vous révélera la réponse.

Dans le domaine de la conduite autonome, permettre aux modèles de perception d'apprendre de puissantes représentations en vue à vol d'oiseau (BEV) est une tendance et a attiré une large attention de l'industrie et du monde universitaire. Par rapport à la plupart des modèles précédents dans le domaine de la conduite autonome qui reposent sur l'exécution de tâches telles que la détection, la segmentation et le suivi en vue de face ou en perspective, la représentation Bird's Eye View (BEV) permet au modèle de mieux identifier les véhicules obstrués et a Facilite le développement et le déploiement des modules ultérieurs (par exemple, planification, contrôle).

On peut constater que la recherche sur la perception du BEV a un impact potentiel énorme sur le domaine de la conduite autonome et mérite une attention et un investissement à long terme de la part du monde universitaire et de l'industrie. Alors, qu'est-ce que la perception du BEV exactement ? Quel est le contenu de la perception du BEV auquel les leaders universitaires et industriels de la conduite autonome prêtent attention ? Cet article vous révélera la réponse à travers l'BEVPerception Survey.

BEVPerception Survey est un article collaboratif entre l'équipe Autonomous Driving OpenDriveLab du Shanghai Artificial Intelligence Laboratory et SenseTime Research Institute"Plongez dans les démons de la perception à vol d'oiseau : une revue , Évaluation et recette" 》La méthode pratique de présentation des outils est divisée en deux parties : la dernière recherche documentaire basée sur BEVPercption et la boîte à outils open source de perception BEV basée sur PyTorch.

- Adresse papier : https://arxiv.org/abs/2209.05324

- Adresse du projet : https://github.com/OpenPerceptionX/BEVPerception-Survey-Re e

Interprétation générale, interprétation technique

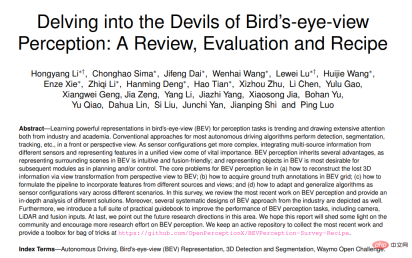

Enquête BEVPerception La dernière recherche de revue de la littérature comprend principalement trois parties : Caméra BEV, lidar BEV et fusion BEV. La caméra BEV représente un algorithme axé uniquement sur la vision ou centré sur la vision pour la détection ou la segmentation d'objets 3D à partir de plusieurs caméras environnantes. Le lidar BEV décrit la tâche de détection ou de segmentation de l'entrée de nuage de points. La fusion BEV décrit la tâche de détection ou de segmentation à partir de plusieurs capteurs. Mécanismes de fusion d'entrée ; tels que caméras, lidar, systèmes de navigation globaux, odométrie, cartes HD, bus CAN, etc.

BEV Perception Toolbox fournit une plate-forme de détection d'objets 3D basée sur des caméras BEV et fournit une plate-forme expérimentale sur l'ensemble de données Waymo, qui peut réaliser des tutoriels manuels et des expériences sur des ensembles de données à petite échelle.

Figure 1 : Cadre d'enquête BEVPerception

Plus précisément, la caméra BEV représente un algorithme de détection ou de segmentation d'objets 3D à partir de plusieurs caméras environnantes. Le lidar BEV représente un algorithme utilisant un nuage de points comme entrée pour compléter l'analyse ; tâche de détection ou de segmentation ; la fusion BEV utilise la sortie de plusieurs capteurs comme entrée, tels que des caméras, LiDAR, GNSS, odomètre, HD-Map, CAN-bus, etc.

Recherche de revue de la littérature BEVPercption

Caméra BEV

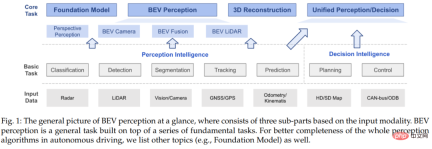

La perception de la caméra BEV comprend trois parties : un extracteur de caractéristiques 2D, une transformation de vue et un décodeur 3D. La figure ci-dessous montre l'organigramme de perception de la caméra BEV. Dans la transformation de vue, il existe deux façons de coder les informations 3D : l'une consiste à prédire les informations de profondeur à partir d'entités 2D ; l'autre consiste à échantillonner des entités 2D à partir de l'espace 3D.

Figure 2 : Organigramme de perception de la caméra BEV

Pour l'Extracteur de fonctionnalités 2D, il y a beaucoup d'expérience dans la tâche de perception 2D qui peut être empruntée dans la tâche de perception 3D, comme le forme de formation à l’intervention principale.

Le module de conversion de vue est un aspect très différent du système de perception 2D. Comme le montre la figure ci-dessus, il existe généralement deux manières d'effectuer une transformation de vue : l'une est la transformation de l'espace 3D en espace 2D, l'autre est la transformation de l'espace 2D en espace 3D. Ces deux méthodes de transformation utilisent soit l'espace 3D. connaissance préalable de la physique du système ou utilisation d'informations 3D supplémentaires pour la supervision. Il convient de noter que toutes les méthodes de perception 3D ne disposent pas de modules de transformation de vue. Par exemple, certaines méthodes détectent les objets dans l'espace 3D directement à partir des entités dans l'espace 2D.

Décodeur 3D reçoit des fonctionnalités dans l'espace 2D/3D et génère des résultats de perception 3D. La plupart des décodeurs 3D sont conçus à partir de modèles de perception basés sur LiDAR. Ces méthodes effectuent une détection dans l'espace BEV, mais il existe encore des décodeurs 3D qui exploitent les fonctionnalités de l'espace 2D et régressent directement la localisation des objets 3D.

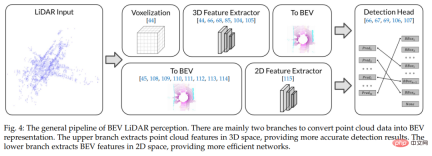

BEV LiDAR

BEV Le processus commun de perception LiDAR implique principalement deux branches pour convertir les données de nuages de points en représentation BEV. La figure ci-dessous montre l'organigramme de détection lidar BEV. La branche supérieure extrait les caractéristiques du nuage de points dans l'espace 3D pour fournir des résultats de détection plus précis. La branche inférieure extrait les fonctionnalités BEV dans l'espace 2D, offrant ainsi un réseau plus efficace. En plus des méthodes basées sur des points qui fonctionnent sur des nuages de points bruts, les méthodes basées sur les voxels voxelisent les points dans des grilles discrètes, offrant ainsi une représentation plus efficace en discrétisant les coordonnées 3D continues. Basée sur une représentation de voxels discrets, la convolution 3D ou la convolution clairsemée 3D peuvent être utilisées pour extraire des caractéristiques de nuages de points.

Figure 3 : Organigramme de détection lidar BEV

fusion BEV

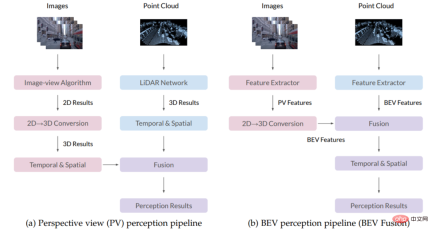

L'algorithme de fusion de détection BEV comporte deux méthodes : la détection PV et la détection BEV, adaptées à milieu universitaire et industriel . La figure ci-dessous montre une comparaison des organigrammes de détection PV et de détection BEV. La principale différence entre les deux réside dans le module de conversion et de fusion 2D en 3D. Dans l'organigramme compatible PV, les résultats de différents algorithmes sont d'abord convertis en espace 3D, puis fusionnés à l'aide de connaissances préalables ou de règles conçues manuellement. Dans l'organigramme de perception BEV, la carte des caractéristiques PV sera convertie en perspective BEV, puis fusionnée dans l'espace BEV pour obtenir le résultat final, maximisant ainsi la conservation des informations sur les caractéristiques d'origine et évitant une conception manuelle excessive.

Figure 4 : Organigramme de détection PV (à gauche) et de détection BEV (à droite)

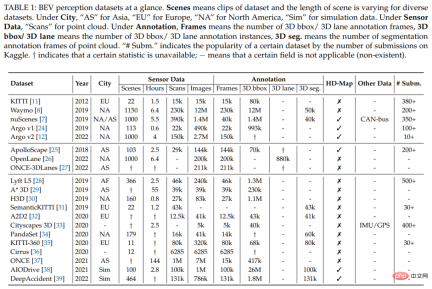

Ensembles de données adaptés aux modèles de détection BEV

Il existe de nombreux ensembles de données pour les tâches de détection BEV. Généralement, un ensemble de données se compose de plusieurs scènes, et chaque scène a une longueur différente dans différents ensembles de données. Le tableau suivant résume les ensembles de données couramment utilisés dans la communauté universitaire. Nous pouvons voir que l'ensemble de données Waymo contient des scènes plus diversifiées et des annotations de boîte de détection 3D plus riches que les autres ensembles de données.

Tableau 1 : Aperçu des ensembles de données de détection BEV

Cependant, il n'existe actuellement aucun logiciel pour la tâche de détection BEV développé par Waymo rendu public dans la communauté universitaire. Par conséquent, nous avons choisi de développer sur la base de l'ensemble de données Waymo, dans l'espoir de promouvoir le développement de tâches de perception BEV sur l'ensemble de données Waymo.

Boîte à outils - Boîte à outils de perception BEV

BEVFormer est une méthode de perception BEV couramment utilisée. Elle utilise un transformateur spatio-temporel pour convertir les caractéristiques extraites par le réseau fédérateur à partir d'une entrée multi-vues en caractéristiques BEV, puis entre les caractéristiques BEV dans la détection. tête pour obtenir les résultats finaux des tests. BEVFormer possède deux fonctionnalités : il permet une conversion précise des fonctionnalités d'image 2D en fonctionnalités 3D et peut appliquer les fonctionnalités BEV qu'il extrait à différentes têtes de détection. Nous avons encore amélioré la qualité de conversion de vue et les performances de détection finale de BEVFormer grâce à une série de méthodes.

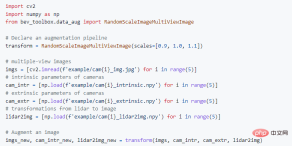

Après avoir remporté la première placeCVPR 2022 Waymo Challenge avec BEVFormer++, nous avons lancé Toolbox - BEV Perception Toolbox, en fournissant un ensemble complet d'outils de traitement de données Waymo Open Dataset faciles à utiliser, Celui-ci intègre une série de méthodes qui peuvent améliorer considérablement les performances du modèle (y compris, mais sans s'y limiter, l'amélioration des données, les têtes de détection, les fonctions de perte, l'intégration de modèles, etc.), et est compatible avec les frameworks open source largement utilisés dans le domaine, tels que mmdetection3d. et détecteurron2. Par rapport à l'ensemble de données de base Waymo, la boîte à outils de perception BEV optimise et améliore les compétences d'utilisation pour différents types de développeurs. La figure ci-dessous montre un exemple d'utilisation de la boîte à outils de sensibilisation BEV basée sur l'ensemble de données Waymo.

Figure 5 : Exemple d'utilisation de la boîte à outils basé sur l'ensemble de données Waymo

Résumé

- L'enquête BEVPerception résume la situation globale de la recherche sur la technologie de perception BEV au cours des dernières années, y compris l'élaboration de concepts de haut niveau et une discussion plus approfondie et détaillée. Une analyse complète de la littérature relative à la détection BEV couvre des questions essentielles telles que l'estimation de la profondeur, la transformation de vue, la fusion de capteurs et l'adaptation de domaine, et fournit une explication plus approfondie de l'application de la détection BEV dans les systèmes industriels.

- En plus des contributions théoriques, BEVPerception Survey fournit également une boîte à outils très pratique pour améliorer les performances de détection d'objets en vue à vol d'oiseau 3D (BEV) par caméra, y compris une série de stratégies d'amélioration des données de formation et une conception efficace de l'encodeur, fonction de perte conception, stratégies d'amélioration des données de test et d'intégration de modèles, etc., ainsi que la mise en œuvre de ces techniques sur l'ensemble de données Waymo. Nous espérons aider davantage de chercheurs à réaliser le principe « utiliser et prendre » et offrir plus de commodité aux chercheurs du secteur de la conduite autonome.

Nous espérons que BEVPerception Survey aidera non seulement les utilisateurs à utiliser facilement les modèles de perception BEV hautes performances, mais deviendra également un bon point de départ pour les novices pour se lancer dans les modèles de perception BEV. Nous nous engageons à repousser les frontières de la recherche et du développement dans le domaine de la conduite autonome et sommes impatients de partager nos points de vue et d'échanger des discussions avec la communauté universitaire pour explorer en permanence le potentiel d'application de la recherche liée à la conduite autonome dans le monde réel.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Les dangers cachés du déploiement interne de l'IA: lacunes de gouvernance et risques catastrophiquesApr 28, 2025 am 11:12 AM

Les dangers cachés du déploiement interne de l'IA: lacunes de gouvernance et risques catastrophiquesApr 28, 2025 am 11:12 AMLe déploiement interne non contrôlé des systèmes d'IA avancés présente des risques importants, selon un nouveau rapport d'Apollo Research. Ce manque de surveillance, répandu parmi les grandes entreprises d'IA, permet des résultats catastrophiques potentiels, allant de peu

Construire le polygraphe AIApr 28, 2025 am 11:11 AM

Construire le polygraphe AIApr 28, 2025 am 11:11 AMLes détecteurs de mensonges traditionnels sont dépassés. S'appuyant sur le pointeur connecté par le bracelet, un détecteur de mensonge qui imprime les signes vitaux et les réactions physiques du sujet n'est pas précis pour identifier les mensonges. C'est pourquoi les résultats de détection de mensonge ne sont généralement pas adoptés par le tribunal, bien que cela ait conduit à de nombreuses personnes innocentes emprisonnées. En revanche, l'intelligence artificielle est un puissant moteur de données, et son principe de travail est d'observer tous les aspects. Cela signifie que les scientifiques peuvent appliquer l'intelligence artificielle aux applications qui recherchent la vérité de diverses manières. Une approche consiste à analyser les réponses des signes vitaux de la personne interrogée comme un détecteur de mensonge, mais avec une analyse comparative plus détaillée et précise. Une autre approche consiste à utiliser le balisage linguistique pour analyser ce que les gens disent réellement et utiliser la logique et le raisonnement. Comme le dit le dicton, un mensonge engendre un autre mensonge, et finalement

L'IA est-elle autorisée pour le décollage dans l'industrie aérospatiale?Apr 28, 2025 am 11:10 AM

L'IA est-elle autorisée pour le décollage dans l'industrie aérospatiale?Apr 28, 2025 am 11:10 AML'industrie aérospatiale, pionnière de l'innovation, tire parti de l'IA pour relever ses défis les plus complexes. La complexité croissante de l'Aviation moderne nécessite l'automatisation de l'IA et les capacités d'intelligence en temps réel pour une sécurité améliorée, un fonctionnement réduit

Regarder la course de robot de printemps de PékinApr 28, 2025 am 11:09 AM

Regarder la course de robot de printemps de PékinApr 28, 2025 am 11:09 AMLe développement rapide de la robotique nous a apporté une étude de cas fascinante. Le robot N2 de Noetix pèse plus de 40 livres et mesure 3 pieds de haut et pourrait être en mesure de se retourner. Le robot G1 de Uniree pèse environ deux fois la taille du N2 et mesure environ 4 pieds de haut. Il existe également de nombreux petits robots humanoïdes qui participent à la compétition, et il y a même un robot qui est poussé par un fan. Interprétation des données Le demi-marathon a attiré plus de 12 000 spectateurs, mais seulement 21 robots humanoïdes ont participé. Bien que le gouvernement ait souligné que les robots participants ont mené une "formation intensive" avant le concours, tous les robots n'ont pas terminé l'ensemble de la compétition. Champion - Tiangong Ult développé par Pékin Humanoid Robot Innovation Center

Le piège miroir: l'éthique de l'IA et l'effondrement de l'imagination humaineApr 28, 2025 am 11:08 AM

Le piège miroir: l'éthique de l'IA et l'effondrement de l'imagination humaineApr 28, 2025 am 11:08 AML'intelligence artificielle, dans sa forme actuelle, n'est pas vraiment intelligente; Il est apte à imiter et à affiner les données existantes. Nous ne créons pas de l'intelligence artificielle, mais plutôt une inférence artificielle - qui traite qui traitent les informations, tandis que les humains

La nouvelle fuite Google révèle la mise à jour des fonctionnalités de Google PhotosApr 28, 2025 am 11:07 AM

La nouvelle fuite Google révèle la mise à jour des fonctionnalités de Google PhotosApr 28, 2025 am 11:07 AMUn rapport a révélé qu'une interface mise à jour était masquée dans le code de Google Photos Android version 7.26, et chaque fois que vous visualisez une photo, une rangée de miniatures de visage nouvellement détectées s'affiche en bas de l'écran. Les nouvelles miniatures faciales manquent de balises de nom, donc je soupçonne que vous devez cliquer sur eux individuellement pour voir plus d'informations sur chaque personne détectée. Pour l'instant, cette fonctionnalité ne fournit aucune information autre que les personnes que Google Photos a trouvées dans vos images. Cette fonctionnalité n'est pas encore disponible, nous ne savons donc pas comment Google l'utilisera avec précision. Google peut utiliser des miniatures pour accélérer la recherche de plus de photos de personnes sélectionnées, ou peut être utilisée à d'autres fins, comme la sélection de l'individu à modifier. Attendons et voyons. Pour l'instant

Guide du renforcement Finetuning - Analytics VidhyaApr 28, 2025 am 09:30 AM

Guide du renforcement Finetuning - Analytics VidhyaApr 28, 2025 am 09:30 AMLe renforcement de la fintuning a secoué le développement de l'IA en enseignant les modèles à s'ajuster en fonction de la rétroaction humaine. Il mélange des fondations d'apprentissage supervisées avec des mises à jour basées sur la récompense pour les rendre plus sûres, plus précises et vraiment aider

Dançon: mouvement structuré pour affiner nos filets neuronaux humainsApr 27, 2025 am 11:09 AM

Dançon: mouvement structuré pour affiner nos filets neuronaux humainsApr 27, 2025 am 11:09 AMLes scientifiques ont largement étudié les réseaux de neurones humains et plus simples (comme ceux de C. elegans) pour comprendre leur fonctionnalité. Cependant, une question cruciale se pose: comment adapter nos propres réseaux de neurones pour travailler efficacement aux côtés de nouvelles IA

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Navigateur d'examen sécurisé

Safe Exam Browser est un environnement de navigation sécurisé permettant de passer des examens en ligne en toute sécurité. Ce logiciel transforme n'importe quel ordinateur en poste de travail sécurisé. Il contrôle l'accès à n'importe quel utilitaire et empêche les étudiants d'utiliser des ressources non autorisées.

Version crackée d'EditPlus en chinois

Petite taille, coloration syntaxique, ne prend pas en charge la fonction d'invite de code

SublimeText3 Linux nouvelle version

Dernière version de SublimeText3 Linux

Listes Sec

SecLists est le compagnon ultime du testeur de sécurité. Il s'agit d'une collection de différents types de listes fréquemment utilisées lors des évaluations de sécurité, le tout en un seul endroit. SecLists contribue à rendre les tests de sécurité plus efficaces et productifs en fournissant facilement toutes les listes dont un testeur de sécurité pourrait avoir besoin. Les types de listes incluent les noms d'utilisateur, les mots de passe, les URL, les charges utiles floues, les modèles de données sensibles, les shells Web, etc. Le testeur peut simplement extraire ce référentiel sur une nouvelle machine de test et il aura accès à tous les types de listes dont il a besoin.