Maison >Périphériques technologiques >IA >ChatGPT est-il vraiment « généraliste » ? Yang Di et d'autres l'ont soumis à un test approfondi.

ChatGPT est-il vraiment « généraliste » ? Yang Di et d'autres l'ont soumis à un test approfondi.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-13 21:25:01900parcourir

Lien papier : https://arxiv.org/pdf/2302.06476.pdf

Il a été prouvé que les grands modèles de langage (LLM) sont capables de résoudre divers traitements du langage naturel (NLP) tâches, Et pour une tâche en aval donnée, ils ne s'appuient sur aucune donnée de formation et l'ajustement du modèle peut être réalisé à l'aide d'invites appropriées. Cette capacité à effectuer de nouvelles tâches sur commande peut être considérée comme une étape importante vers l’intelligence artificielle générale.

Bien que le LLM actuel atteigne de bonnes performances dans certains cas, il est toujours sujet à diverses erreurs dans l'apprentissage zéro-shot. De plus, le format de l’invite peut avoir un impact considérable. Par exemple, en ajoutant « Réfléchissons étape par étape » à l'invite, les performances du modèle peuvent être considérablement améliorées. Ces limitations illustrent que les LLM actuels ne sont pas des systèmes linguistiques véritablement universels.

Récemment, le LLM ChatGPT publié par OpenAI a attiré une grande attention dans la communauté PNL. ChatGPT a été créé en entraînant le modèle de la série GPT-3.5 via « Apprentissage par renforcement avec retour humain (RLHF) ». RLHF comprend principalement trois étapes : utiliser l'apprentissage supervisé pour former un modèle de langage ; collecter des données comparatives et former un modèle de récompense basé sur les préférences humaines et utiliser l'apprentissage par renforcement pour optimiser le modèle de langage pour le modèle de récompense ; Grâce à la formation RLHF, ChatGPT s'est avéré doté de capacités impressionnantes dans divers aspects, notamment la génération de réponses de haute qualité aux contributions humaines, le rejet des questions inappropriées et l'auto-correction des erreurs précédentes en fonction des conversations ultérieures.

Bien que ChatGPT présente de fortes capacités conversationnelles, la communauté PNL ne sait toujours pas si ChatGPT atteint de meilleures capacités de généralisation sans tir par rapport aux LLM existants. Pour combler cette lacune dans la recherche, les chercheurs ont systématiquement étudié les capacités d'apprentissage zéro-shot de ChatGPT en l'évaluant sur un grand nombre d'ensembles de données PNL couvrant 7 catégories de tâches représentatives. Ces tâches comprennent le raisonnement, l'inférence en langage naturel, la réponse aux questions (compréhension écrite), le dialogue, le résumé, la reconnaissance d'entités nommées et l'analyse des sentiments. À l'aide d'expériences approfondies, les chercheurs ont cherché à répondre aux questions suivantes :

- ChatGPT est-il un solveur généraliste pour les tâches de PNL ? Sur quels types de tâches ChatGPT fonctionne-t-il bien ?

- Si ChatGPT est en retard par rapport aux autres modèles sur certaines tâches, pourquoi ?

Pour répondre à ces questions, les auteurs ont comparé les performances de ChatGPT et du modèle GPT-3.5 de pointe (text-davinci-003) sur la base de résultats expérimentaux. De plus, ils rapportent des résultats de réglage précis, de mise au point ou de quelques prises de vue, de travaux récents tels que FLAN, T0 et PaLM.

Principales conclusions

Les auteurs ont déclaré qu'à leur connaissance, c'est la première fois que quelqu'un étudie les capacités zéro-shot de ChatGPT sur diverses tâches PNL, dans le but de fournir un aperçu préliminaire de ChatGPT . Leurs principales conclusions sont les suivantes :

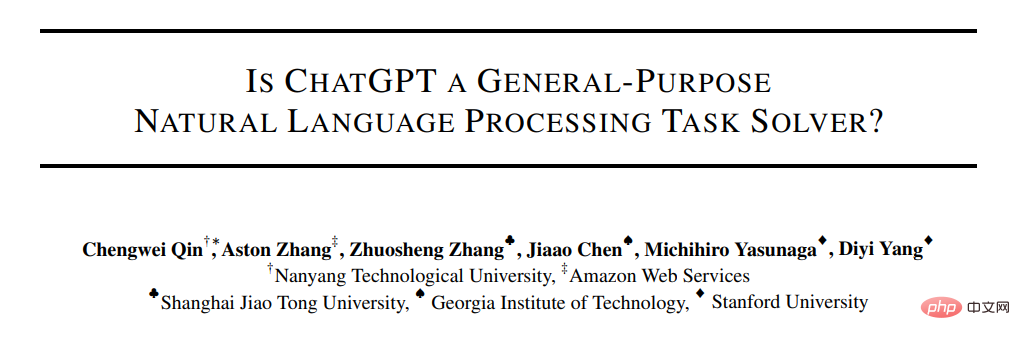

- Bien que ChatGPT montre une certaine capacité à effectuer plusieurs tâches en tant que modèle généraliste, il est généralement moins performant que les modèles affinés pour une tâche donnée (voir Figure 1 et Section 4.3). La capacité de raisonnement supérieure de

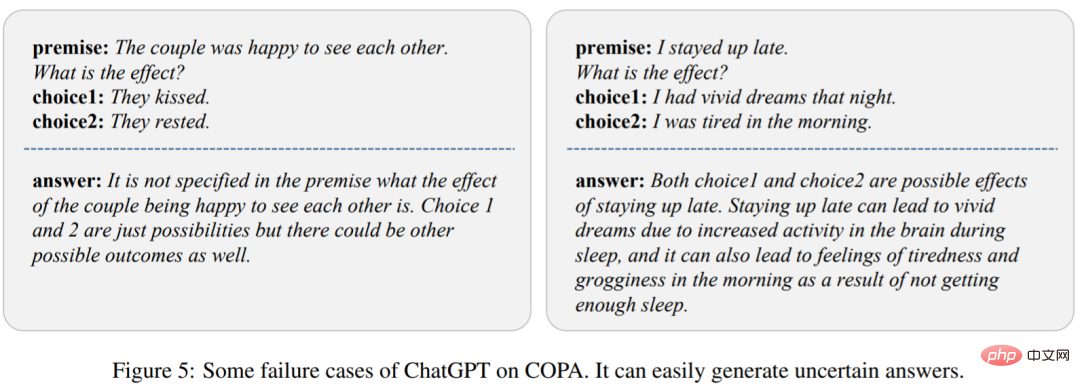

- ChatGPT a été confirmée expérimentalement dans des tâches de raisonnement arithmétique (Section 4.2.1). Cependant, ChatGPT est généralement moins performant que GPT-3.5 sur les tâches de bon sens, de raisonnement symbolique et logique, comme on peut le voir, par exemple, en générant des réponses incertaines (Section 4.2.2).

- ChatGPT surpasse GPT-3.5 sur les tâches d'inférence en langage naturel (Section 4.2.3) et les tâches de questions et réponses (compréhension écrite) (Section 4.2.4) qui favorisent les capacités d'inférence, telles que la détermination de la logique dans la relation de paires de textes. Plus précisément, ChatGPT est plus efficace pour traiter un texte cohérent avec les faits (c'est-à-dire mieux pour classer les implications que les non-implications).

- ChatGPT surpasse GPT-3.5 sur les tâches conversationnelles (Section 4.2.5).

- En termes de tâches de synthèse, ChatGPT génère des résumés plus longs et fonctionne moins bien que GPT-3.5. Cependant, limiter explicitement la longueur du résumé dans les directives zero-shot compromet la qualité du résumé, entraînant une réduction des performances (Section 4.2.6).

- Bien qu'ils se montrent prometteurs en tant que modèles généralistes, ChatGPT et GPT-3.5 sont tous deux confrontés à des défis sur certaines tâches, telles que l'annotation de séquences (Section 4.2.7). La capacité d'analyse des sentiments de

- ChatGPT est proche de GPT-3.5 (Section 4.2.8).

Méthode

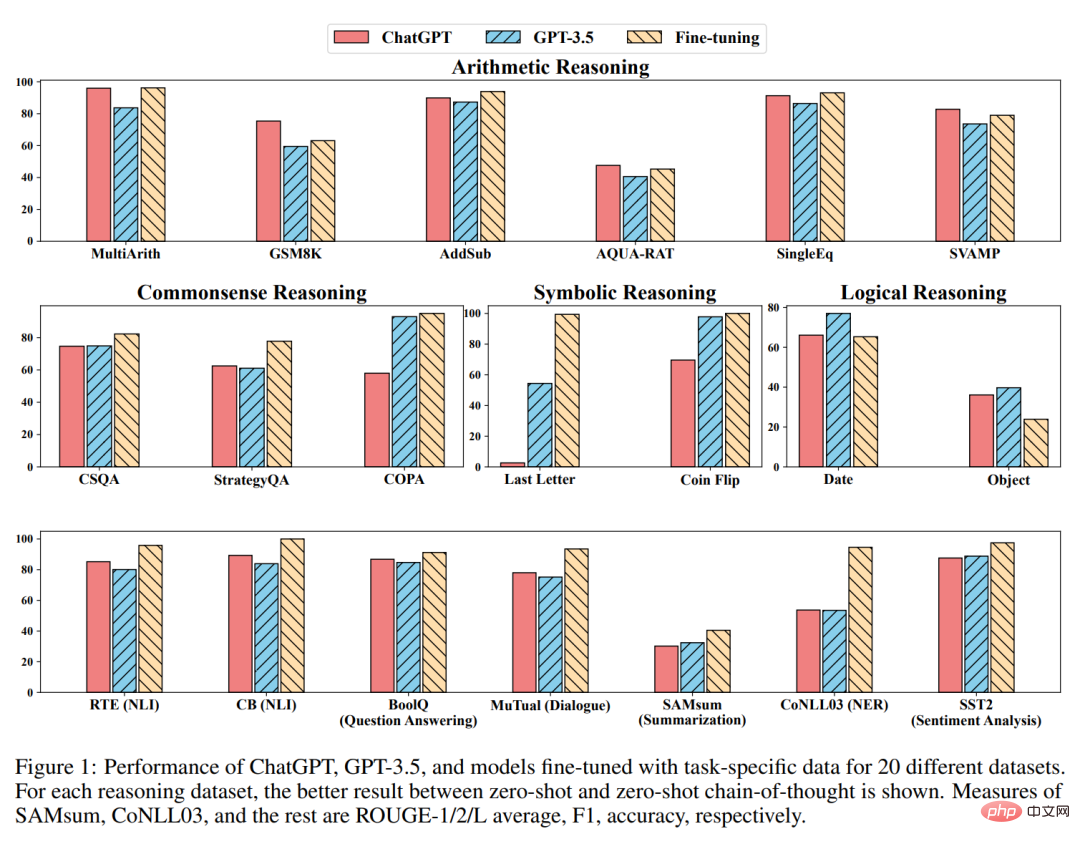

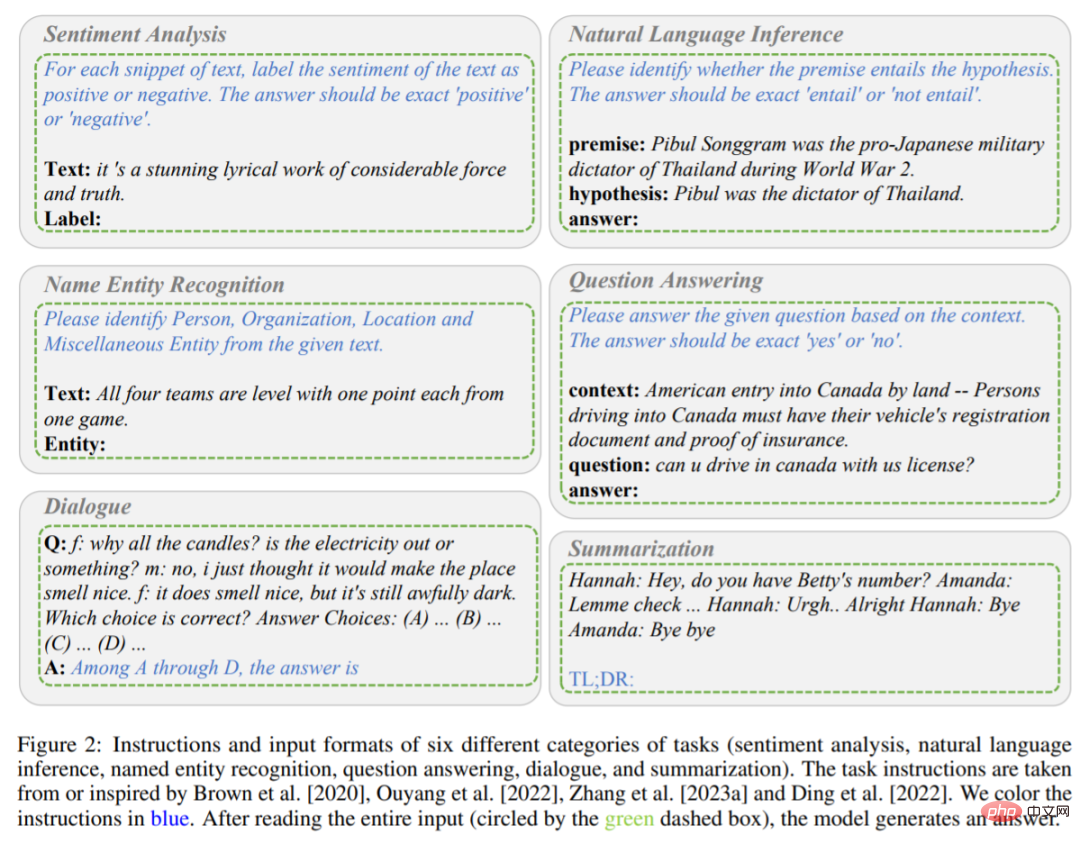

Comme mentionné ci-dessus, cette étude compare principalement les performances d'apprentissage zéro-shot de ChatGPT et GPT-3.5 (textdavinci-003) sous différentes tâches. Plus précisément, ils prennent une instruction de tâche P et une question de test X en entrée, le modèle est représenté par f, puis génèrent un texte cible Y = f (P, X) pour résoudre le problème de test. Les instructions et les formats d'entrée pour les différentes tâches sont présentés dans les figures 2 et 3.

Contient des instructions et des formats de saisie pour six tâches (analyse des sentiments, raisonnement en langage naturel, reconnaissance d'entité nommée, réponse aux questions, dialogue et résumé). Les instructions sont en caractères bleus.

Description de la tâche d'inférence.

Par exemple, lorsque le modèle effectue une tâche d'analyse des sentiments, l'instruction de tâche P marque le sentiment contenu dans le texte comme positif ou négatif, et la réponse de sortie est positive ou négative. Lorsque le modèle lit l'instruction P et le contenu d'entrée X (le contenu est une œuvre lyrique époustouflante d'une puissance et d'une authenticité considérables), on estime que le modèle est censé produire Y positif.

Différent de la méthode d'incitation en une seule étape mentionnée ci-dessus, cette étude utilise une incitation en deux étapes (proposée par Kojima et al.) pour terminer le CoT zéro tir.

La première étape adopte « Réfléchissons pas à pas », et l'instruction P_1 induit le principe de base R de génération de modèle.

La deuxième étape utilise le principe de base R généré lors de la première étape ainsi que l'entrée originale X et l'instruction P_1 comme nouvelles entrées pour guider le modèle afin de générer la réponse finale.

Après cela, une nouvelle instruction P_2 est utilisée comme instruction déclencheur pour extraire la réponse. Toutes les instructions de tâches ont été tirées ou inspirées des recherches de Brown, Ouyang, Zhang et al. Une dernière chose à noter est que chaque fois que vous effectuez une nouvelle requête sur ChatGPT, vous devez effacer la conversation à l'avance pour éviter l'impact de l'exemple précédent.

Expérience

L'expérience utilise 20 ensembles de données différents pour évaluer ChatGPT et GPT-3.5, couvrant 7 types de tâches.

Raisonnement arithmétique

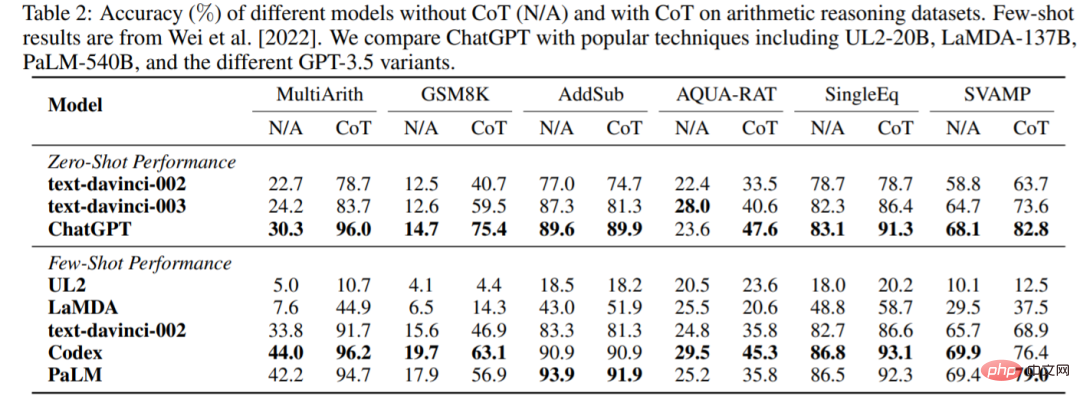

La précision de ChatGPT et GPT-3.5 sans ou avec CoT sur six ensembles de données de raisonnement arithmétique est présentée dans le tableau 2. Dans les expériences sans CoT, ChatGPT a surpassé GPT-3.5 sur 5 des ensembles de données, démontrant ses fortes capacités de raisonnement arithmétique.

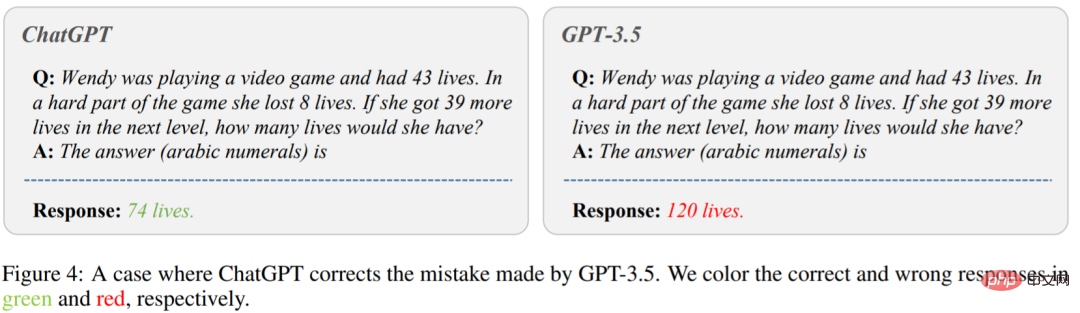

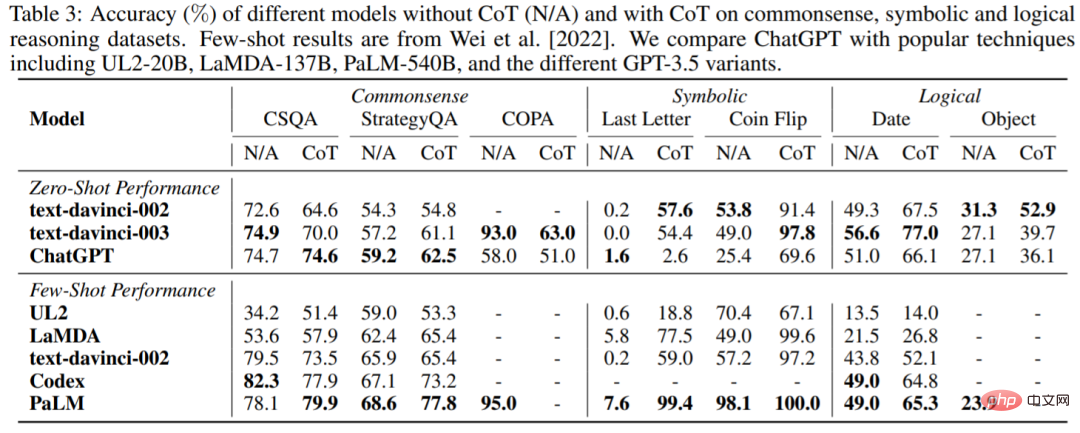

La figure 4 montre le cas où GPT-3.5 donne la mauvaise réponse. Sur le côté gauche de l'image, demandez « Wendy joue à un jeu vidéo et a 43 vies. Pendant la partie la plus difficile du jeu, elle a perdu 8 vies. Si elle obtient 39 vies supplémentaires au niveau suivant, combien de vies aura-t-elle ? avez ?"ChatGPT a donné la bonne réponse. Cependant, GPT-3.5 a généré une mauvaise réponse. On peut voir que ChatGPT fonctionne bien mieux que GPT-3.5 lors de l'utilisation de CoT. Le tableau 3 rapporte l'exactitude de ChatGPT par rapport au LLM populaire sur les ensembles de données de bon sens, de raisonnement symbolique et logique. Les observations suivantes peuvent être faites : Premièrement, l’utilisation de CoT ne fournit pas toujours de meilleures performances dans les tâches de raisonnement de bon sens, qui peuvent nécessiter des connaissances de base plus fines. Deuxièmement, contrairement au raisonnement arithmétique, ChatGPT fonctionne moins bien que GPT-3.5 dans de nombreux cas, ce qui indique que GPT-3.5 a des capacités correspondantes plus fortes.

Raisonnement en langage naturel

Le tableau 4 montre les résultats de différents modèles sur deux tâches de raisonnement en langage naturel : RTE et CB. Nous pouvons voir que avec des paramètres zéro tir, ChatGPT peut atteindre de meilleures performances que GPT-3.5, FLAN, T0 et PaLM. Cela prouve que ChatGPT a de meilleures performances sans tir dans les tâches de raisonnement PNL. Le tableau 6 indique la précision des différents modèles sur l'ensemble de données BoolQ, et ChatGPT est meilleur que GPT-3.5. Cela montre que ChatGPT peut mieux gérer les tâches de raisonnement. Le tableau 8 montre la précision de ChatGPT et GPT-3.5 sur l'ensemble de données MuTual (inférence de conversation à plusieurs tours). Comme prévu, ChatGPT surpasse considérablement GPT-3.5.

La figure 6 est un exemple précis, on peut voir que ChatGPT peut raisonner plus efficacement pour un contexte donné. Cela confirme une fois de plus les super capacités de raisonnement de ChatGPT.

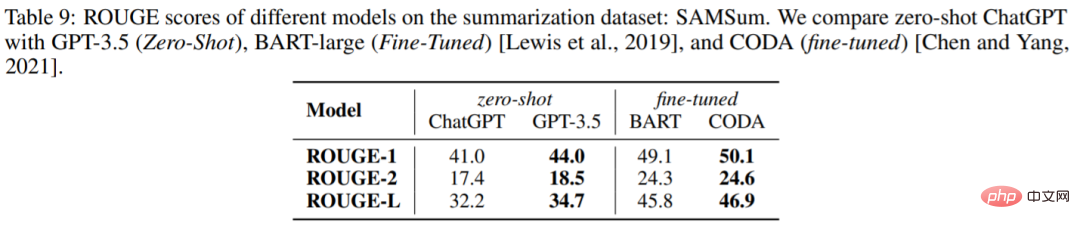

Générer un résumé

Le tableau 9 rapporte les scores ROUGE de ChatGPT et GPT-3.5 sur l'ensemble de données SAMSum. Étonnamment, ChatGPT est inférieur à GPT-3.5 sur toutes les métriques.

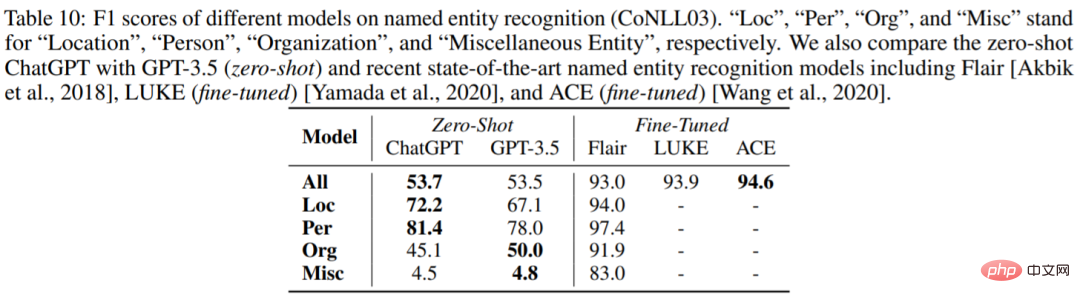

Reconnaissance d'entité nommée

Le tableau 10 rapporte les performances zéro de ChatGPT et GPT-3.5 sur CoNLL03. Nous pouvons voir que les performances globales de ChatGPT et de GPT-3.5 sont très similaires. Le tableau 11 compare la précision de différents modèles sur l'ensemble de données d'analyse des sentiments SST2. Étonnamment, ChatGPT est environ 1 % moins performant que GPT-3.5.

Pour plus d'informations, veuillez vous référer au document original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI