Maison >Périphériques technologiques >IA >Avec une puissance de calcul limitée, comment améliorer les performances du modèle de langage ? Google a une nouvelle idée

Avec une puissance de calcul limitée, comment améliorer les performances du modèle de langage ? Google a une nouvelle idée

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-13 14:01:091507parcourir

Ces dernières années, les modèles linguistiques (LM) sont devenus plus importants dans la recherche sur le traitement du langage naturel (NLP) et de plus en plus influents dans la pratique. En général, il a été démontré que l’augmentation de la taille d’un modèle améliore les performances dans une gamme de tâches de PNL.

Cependant, le défi de la mise à l'échelle du modèle est également évident : la formation de nouveaux modèles plus grands nécessite beaucoup de ressources informatiques. De plus, les nouveaux modèles sont souvent entraînés à partir de zéro et ne peuvent pas utiliser les poids d'entraînement des modèles précédents.

Pour ce problème, les chercheurs de Google ont exploré deux méthodes complémentaires pour améliorer considérablement les performances des modèles de langage existants sans consommer beaucoup de ressources informatiques supplémentaires.

Tout d'abord, dans l'article « Transcending Scaling Laws with 0.1% Extra Compute », les chercheurs ont présenté UL2R, un modèle léger de pré-entraînement de deuxième étape qui utilise un objectif d'enoiseurs hybrides. UL2R améliore les performances sur une gamme de tâches, débloquant des rafales de performances même sur des tâches qui avaient auparavant des performances quasi aléatoires.

Lien papier :https://arxiv.org/pdf/2210.11399.pdf

De plus, dans « Mise à l'échelle des modèles de langage affinés par les instructions », un modèle de langage basé sur les instructions est discuté. Le problème de l'ajustement fin du modèle de langage sur l'ensemble de données est un processus que nous appelons « Flan ». Cette approche améliore non seulement les performances, mais améliore également la convivialité du modèle de langage pour la saisie de l'utilisateur.

Lien papier : https://arxiv.org/abs/2210.11416

Enfin, Flan et UL2R peuvent être combinés en tant que technologies complémentaires en une seule appelée Flan-U-PaLM 540B. Le modèle surpasse le modèle PaLM 540B non ajusté de 10 % sur une gamme de critères d'évaluation difficiles.

Formation de UL2R

Traditionnellement, la plupart des modèles de langage sont pré-entraînés sur un objectif de modélisation causale du langage, permettant au modèle de prédire le mot suivant dans une séquence (comme GPT-3 ou PaLM) ou l'objectif de débruitage , où le modèle apprend à récupérer des phrases originales à partir de séquences de mots corrompues (comme T5).

Bien qu'il existe certains compromis dans l'objectif de modélisation du langage, c'est-à-dire que les modèles de langage formés sur la causalité fonctionnent mieux dans la génération de phrases longues, tandis que les modèles de langage formés sur l'objectif de débruitage fonctionnent mieux dans le réglage fin, mais avant dans leur Dans leurs travaux, les chercheurs ont montré que les enoiseurs hybrides incluant les deux objectifs obtiennent de meilleures performances dans les deux cas.

Cependant, pré-entraîner de grands modèles de langage à partir de zéro sur différentes cibles est difficile sur le plan informatique. Par conséquent, nous proposons la réparation UL2 (UL2R), une étape supplémentaire qui poursuit le pré-entraînement avec la cible UL2 et ne nécessite qu'une quantité relativement faible de calcul.

Nous appliquons UL2R à PaLM et appelons le nouveau modèle de langage résultant U-PaLM.

Dans notre évaluation empirique, nous avons constaté qu'avec seulement une petite quantité de formation UL2, le modèle s'améliorait considérablement.

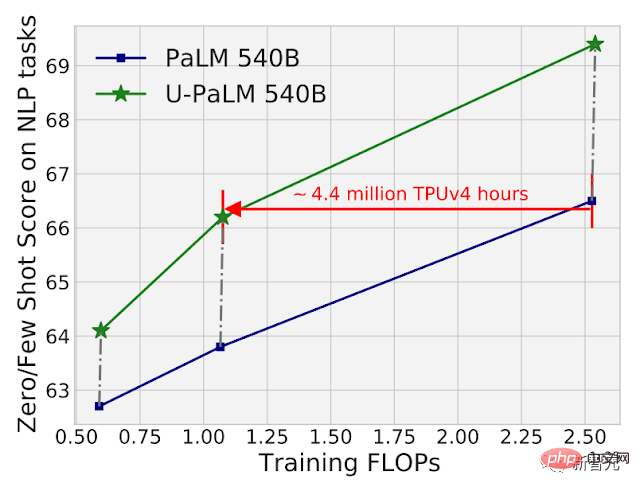

Par exemple, en utilisant UL2R sur le point de contrôle intermédiaire du PaLM 540B, il est possible d'atteindre les performances du PaLM 540B au point de contrôle final tout en utilisant 2x le calcul. Bien entendu, l’application d’UL2R au point de contrôle final du PaLM 540B apportera également d’énormes améliorations.

Comparaison des performances de calcul et des modèles de PaLM 540B et U-PaLM 540B sur 26 benchmarks NLP. L'U-PaLM 540B continue d'entraîner PaLM, avec une très petite quantité de calcul mais une grande amélioration des performances.

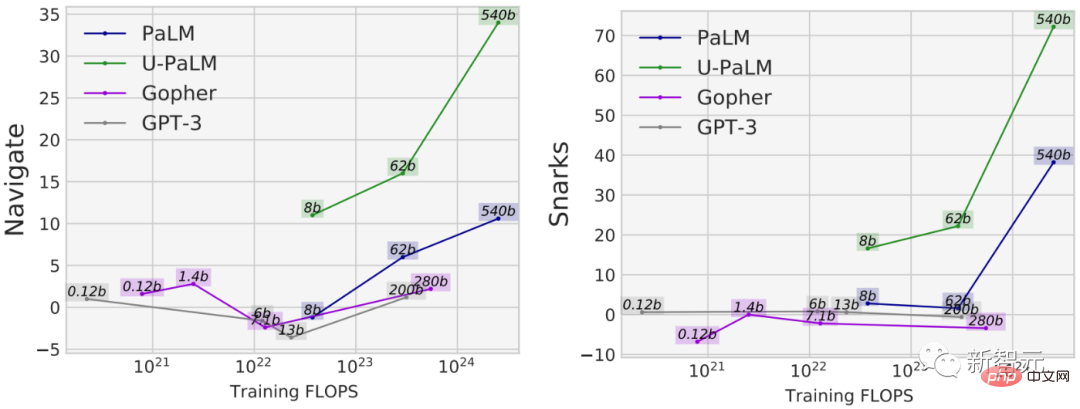

Un autre avantage de l'utilisation d'UL2R est qu'il est bien plus performant sur certaines tâches que les modèles formés uniquement sur des objectifs de modélisation de langage causal. Par exemple, il existe de nombreuses tâches BIG-Bench dotées de ce que l'on appelle des « capacités émergentes », qui sont des capacités qui ne sont disponibles que dans des modèles de langage suffisamment grands.

Bien que le moyen le plus courant de découvrir les capacités émergentes consiste à étendre le modèle, UL2R peut en fait inspirer les capacités émergentes sans étendre le modèle.

Par exemple, dans la tâche de navigation de BIG-Bench, la capacité du modèle à effectuer le suivi d'état est mesurée À l'exception de U-PaLM, les FLOP d'entraînement de tous les modèles sont inférieurs à 10^23. Un autre exemple est la tâche Snarks de BIG-Bench, qui mesure la capacité d’un modèle à détecter le langage sarcastique.

Pour les deux capacités de BIG-Bench, qui démontrent des performances de tâches émergentes, U-PaLM atteint des performances émergentes avec une taille de modèle plus petite grâce à son utilisation de la cible UL2R.

Réglage fin des instructions

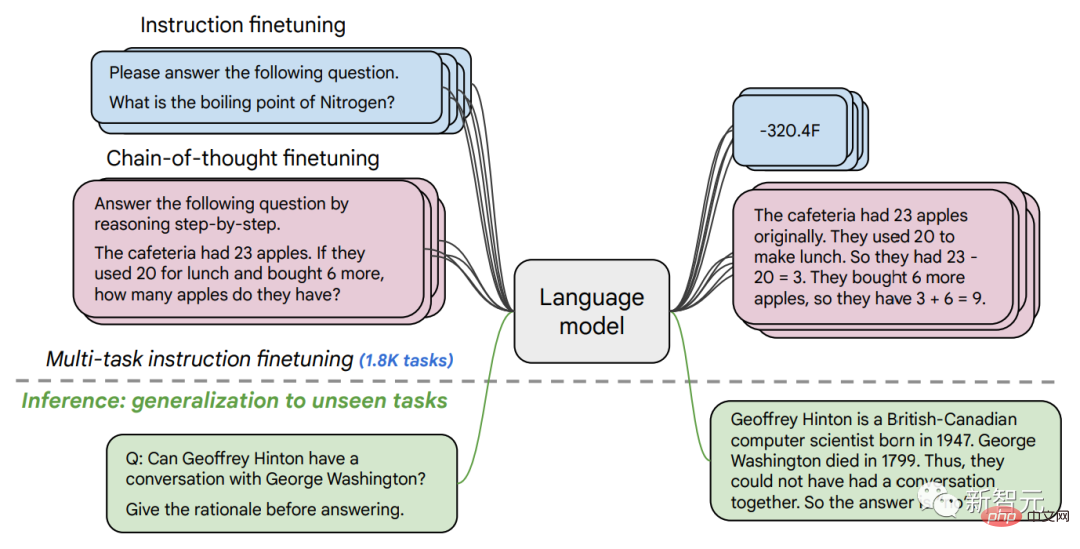

Dans le deuxième article, nous explorons le réglage fin des instructions, qui consiste à affiner un LM sur un ensemble de données PNL formulées avec des instructions.

Dans des travaux antérieurs, nous avons appliqué le réglage fin des instructions à un modèle de paramètres 137B sur 62 tâches de PNL, telles que répondre à une courte question, classer les émotions exprimées dans des films ou traduire des phrases en espagnol.

Dans ce travail, nous avons affiné un modèle de langage de paramètres 540B sur plus de 1,8K tâches. De plus, les travaux antérieurs n'affichaient que des modèles de langage avec peu d'exemples (par exemple, MetaICL) ou des modèles de langage à instance zéro sans exemples (par exemple, FLAN, T0), alors que nous affinons une combinaison des deux.

Nous incluons également des données de réglage fin de la chaîne de pensée, qui permettent au modèle d'effectuer une inférence en plusieurs étapes. Nous appelons notre méthode améliorée « Flan » pour affiner les modèles de langage.

Il convient de noter que même lorsqu'il est affiné sur 1,8K tâches, Flan n'utilise qu'une fraction du calcul par rapport au pré-entraînement (pour PaLM 540B, Flan ne nécessite que 0,2% du calcul de pré-entraînement) ) .

Affiner le modèle de langage sur 1,8K tâches formulées sous forme d'instructions, et évaluer le modèle sur de nouvelles tâches qui ne sont pas incluses dans le réglage fin. Le réglage fin est effectué avec/sans exemples (c'est-à-dire 0-shot et quelques-shots) et avec/sans chaînes de pensée, permettant au modèle d'être généralisé à une gamme de scénarios d'évaluation.

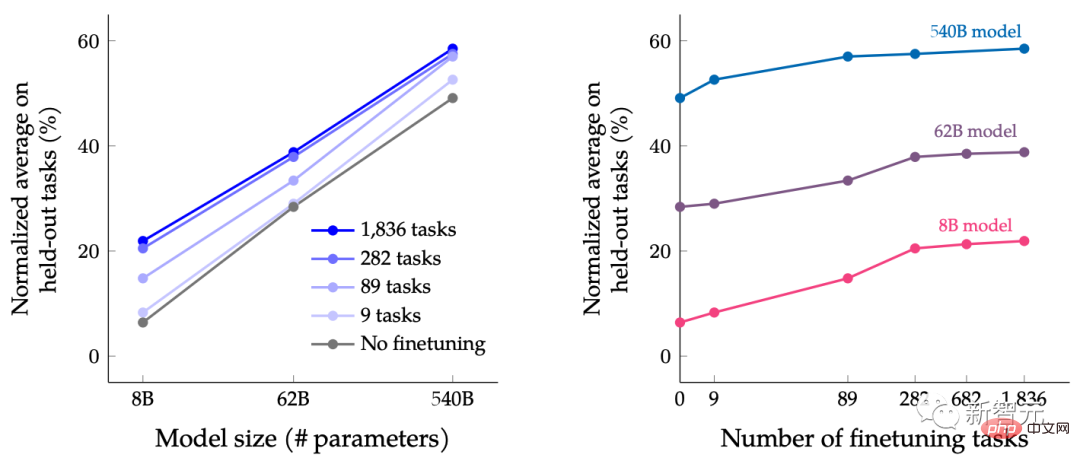

Dans cet article, des LM de différentes tailles sont peaufinés au niveau pédagogique, dans le but d'étudier les effets conjoints de l'expansion simultanée de la taille du modèle de langage et de l'augmentation du nombre de tâches de réglage fin.

Par exemple, pour le modèle de langage de classe PaLM, comprenant les spécifications des paramètres 8B, 62B et 540B. Notre modèle est évalué sur quatre critères d'évaluation de référence exigeants (MMLU, BBH, TyDiQA et MGSM) et a révélé que l'augmentation du nombre de paramètres et l'ajustement du nombre de tâches peuvent améliorer les performances sur des tâches nouvelles et inédites.

L'extension du modèle de paramètres à 540B et l'utilisation de tâches de réglage fin de 1,8K peuvent améliorer les performances. L'axe des y de la figure ci-dessus est la moyenne normalisée des quatre suites d'évaluation (MMLU, BBH, TyDiQA et MGSM).

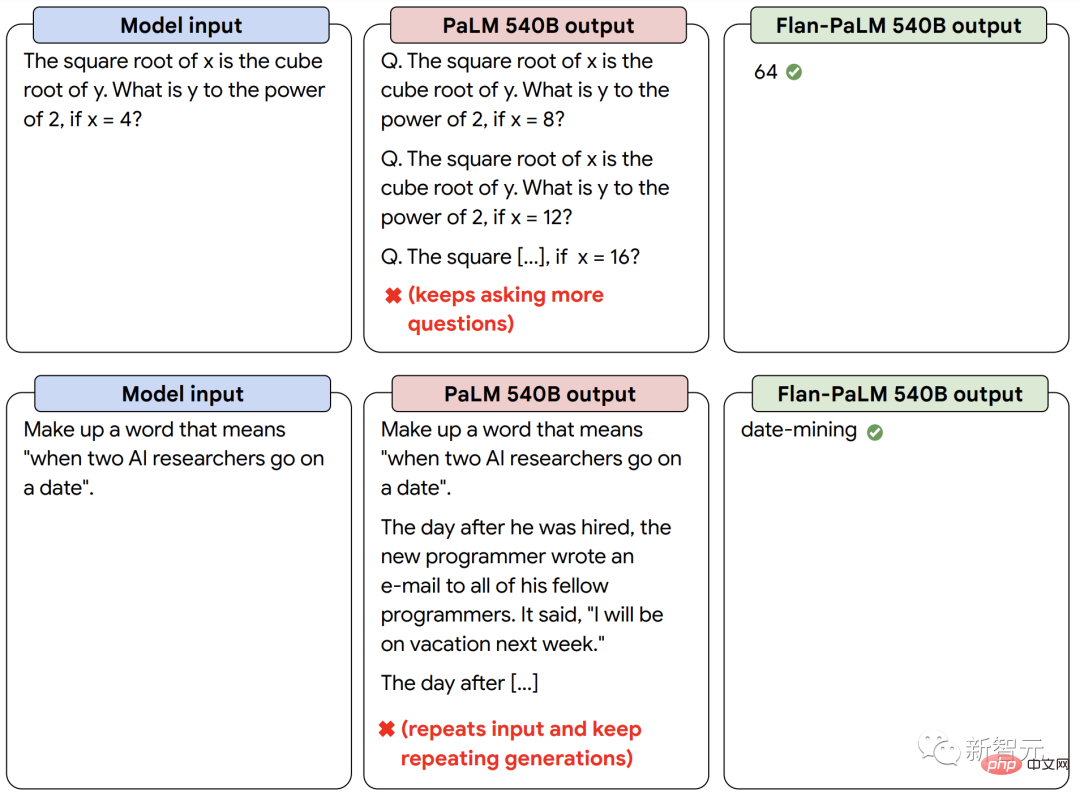

En plus de meilleures performances, le LM de réglage fin des instructions est capable de réagir aux instructions de l'utilisateur au moment de l'inférence sans nécessiter un petit nombre d'exemples ou d'ingénierie d'indices. Cela rend LM plus convivial pour une gamme d’entrées. Par exemple, les LM sans réglage fin des instructions effectuent parfois des entrées répétées ou ne parviennent pas à suivre les instructions, mais le réglage fin des instructions peut atténuer ces erreurs.

Notre modèle de langage affiné d'instruction Flan-PaLM répond mieux aux instructions par rapport au modèle PaLM sans réglage précis des instructions.

Combiner des forces puissantes pour atteindre "1+1>2"

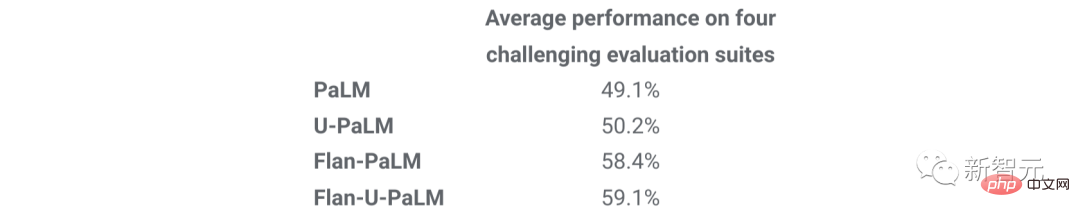

Enfin, nous montrons que UL2R et Flan peuvent être combinés pour entraîner le modèle Flan-U-PaLM.

Étant donné que Flan utilise de nouvelles données provenant de tâches PNL et peut implémenter le suivi des instructions au point zéro, nous utilisons Flan comme méthode de deuxième choix après UL2R.

Nous évaluons à nouveau les quatre suites de référence et constatons que le modèle Flan-U-PaLM surpasse le modèle PaLM avec uniquement UL2R (U-PaLM) ou uniquement Flan (Flan-PaLM). De plus, lorsqu'il est combiné avec l'enchaînement de pensées et l'auto-cohérence, Flan-U-PaLM atteint un nouveau SOTA sur le benchmark MMLU avec un score de 75,4 %.

La combinaison d'UL2R et de Flan (Flan-U-PaLM) donne les meilleures performances par rapport à l'utilisation uniquement d'UL2R (U-PaLM) ou à l'utilisation uniquement de Flan (Flan-U-PaLM) : moyenne normalisée de quatre évaluations suites (MMLU, BBH, TyDiQA et MGSM).

En résumé, UL2R et Flan sont deux méthodes complémentaires pour améliorer les modèles linguistiques pré-entraînés. UL2R utilise les mêmes données pour adapter LM aux objectifs mixtes des débruiteurs, tandis que Flan exploite les données d'entraînement de plus de 1,8 000 tâches PNL pour apprendre au modèle à suivre les instructions.

À mesure que les modèles de langage deviennent plus grands, des techniques comme UL2R et Flan, qui peuvent améliorer les performances générales sans nécessiter de calculs lourds, peuvent devenir de plus en plus attrayantes.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI