Maison >Périphériques technologiques >IA >Produit conjointement par Qingbei ! Une enquête pour comprendre les tenants et les aboutissants du 'Transformer+Reinforcement Learning'

Produit conjointement par Qingbei ! Une enquête pour comprendre les tenants et les aboutissants du 'Transformer+Reinforcement Learning'

- PHPzavant

- 2023-04-13 14:01:031162parcourir

Depuis sa sortie, le modèle Transformer est rapidement devenu une architecture neuronale courante dans les contextes d'apprentissage supervisé dans les domaines du traitement du langage naturel et de la vision par ordinateur.

Bien que l'engouement pour Transformer ait commencé à balayer le domaine de l'Apprentissage par renforcement, en raison des caractéristiques de RL lui-même, telles que le besoin de fonctionnalités uniques, la conception de l'architecture, etc., la combinaison actuelle de Transformer et l'apprentissage par renforcement n'est pas fluide et son chemin de développement manque également d'articles pertinents pour fournir un résumé complet.

Récemment, des chercheurs de l'Université Tsinghua, de l'Université de Pékin et de Tencent ont publié conjointement un document de recherche sur la combinaison de Transformer et de l'apprentissage par renforcement, examinant systématiquement la motivation et l'historique de développement de l'utilisation de Transformer dans l'apprentissage par renforcement.

Lien papier : https://arxiv.org/pdf/2301.03044.pdf

L'article classe les résultats des travaux connexes existants et mène des discussions approfondies sur chaque sous-domaine. les perspectives d'avenir de cette direction de recherche sont résumées.

Transformer avec RL

L'apprentissage par renforcement (RL) fournit une forme mathématique pour la prise de décision séquentielle, permettant au modèle d'obtenir automatiquement un comportement intelligent.

RL fournit un cadre général pour le contrôle basé sur l'apprentissage. Avec l'introduction des réseaux de neurones profonds, la généralité de l'apprentissage par renforcement profond (DRL) a également fait de grands progrès ces dernières années, mais des problèmes d'efficacité des échantillons ont entravé le DRL A. large gamme d'applications dans le monde réel.

Afin de résoudre ce problème, un mécanisme efficace consiste à introduire un biais inductif dans le cadre DRL. Le plus important est le choix des architectures d'approximation de fonctions, telles que le réseau neuronal de l'agent DRL.

Cependant, la question du choix de la conception d'architecture en DRL est encore sous-explorée par rapport à la conception d'architecture en apprentissage supervisé (SL), et la plupart des travaux existants sur l'architecture RL sont (semi-)supervisés. Inspirés par le succès des communautés d'apprentissage.

Par exemple, une pratique courante pour gérer les entrées basées sur des images de grande dimension dans DRL consiste à introduire des réseaux de neurones convolutifs (CNN) ; une autre pratique courante pour gérer l'observabilité partielle consiste à introduire des réseaux de neurones récurrents (RNN) ;

Ces dernières années, l'architecture Transformer a révolutionné le paradigme d'apprentissage dans un large éventail de tâches SL et a montré des performances supérieures à celles de CNN et RNN. Par exemple, l'architecture Transformer peut modéliser des dépendances plus longues et offre d'excellentes performances.

Inspiré par le succès de SL, l'intérêt de l'industrie pour l'application de Transformer dans l'apprentissage par renforcement s'est accru, ce qui remonte à un article de 2018, dans lequel le mécanisme d'auto-attention était utilisé pour le raisonnement relationnel de la représentation structurée de l'état. .

Après cela, de nombreux chercheurs ont commencé à essayer d'appliquer l'auto-attention à l'apprentissage de la représentation afin d'extraire les relations entre les entités, ce qui peut conduire à un meilleur apprentissage politique.

En plus de l'apprentissage de la représentation d'état, des travaux antérieurs ont également utilisé Transformer pour capturer la dépendance temporelle de plusieurs étapes afin de traiter les problèmes d'observabilité partielle.

Récemment, le RL hors ligne a attiré l'attention en raison de sa capacité à utiliser des ensembles de données hors ligne à grande échelle. Les résultats de recherches connexes montrent également que l'architecture Transformer peut être directement utilisée comme modèle pour la prise de décision séquentielle et peut être généralisée à. plusieurs tâches et domaines.

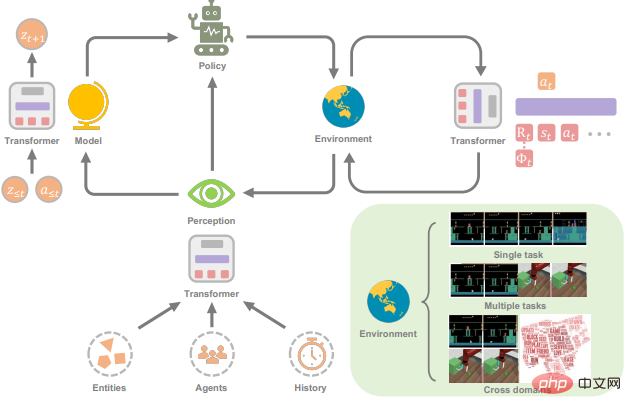

Le but de ce document de recherche est de présenter le domaine des transformateurs en apprentissage par renforcement (TransformRL).

Bien que Transformer ait été considéré comme le modèle de base pour la plupart des recherches SL actuelles, il est encore moins exploré dans la communauté RL. En fait, par rapport au champ SL, l'utilisation de Transformer comme approximateur de fonction dans RL doit résoudre différents problèmes :

1 Les données de formation de l'agent RL sont généralement fonction de la politique actuelle, qui est dans le. le processus d’apprentissage du Transformer entraînera la non-stationnarité.

2. Les algorithmes RL existants sont généralement très sensibles aux choix de conception au cours du processus de formation, y compris l'architecture et la capacité du réseau.

3. Les architectures basées sur des transformateurs souffrent souvent de coûts de calcul et de mémoire élevés, ce qui signifie que la formation et l'inférence sont lentes et coûteuses.

Par exemple, dans certains cas d'intelligence artificielle dans les jeux, l'efficacité de la génération d'échantillons affecte grandement les performances de formation, en fonction du coût de calcul du réseau de politiques RL et du réseau de valeurs.

L'avenir de TransformRL

L'article passe brièvement en revue les progrès de Transformers pour RL. Ses avantages incluent principalement :

1 Les transformateurs peuvent être utilisés comme un module puissant dans RL, comme un module de représentation ou un monde. modèle ;

2. Transformer peut être utilisé comme décideur de séquence ;

3.

Étant donné que Transformer a montré de solides performances dans la communauté plus large de l'intelligence artificielle, les chercheurs estiment que la combinaison de Transformer et de RL est une direction de recherche prometteuse. Voici quelques perspectives d'avenir et questions ouvertes sur cette direction.

Combinant l'apprentissage par renforcement et l'apprentissage (auto)supervisé

En suivant le développement de TransformRL, vous constaterez que sa méthode de formation couvre à la fois l'apprentissage RL et l'apprentissage (auto-)supervisé.

Lorsqu'elle est utilisée comme module de représentation formé dans un framework RL traditionnel, l'optimisation de l'architecture Transformer est généralement instable. Le paradigme d'apprentissage (auto)supervisé peut éliminer le problème mortel de la triade lors de l'utilisation de Transformers pour résoudre des problèmes de prise de décision grâce à la modélisation de séquences.

Dans le cadre de l'apprentissage (auto)supervisé, la performance de la politique est profondément contrainte par la qualité des données hors ligne, et le compromis clair entre exploitation et exploration n'existe plus, combinant donc RL dans l'apprentissage Transformer Avec l’apprentissage (auto)supervisé, de meilleures stratégies peuvent être apprises.

Certains travaux ont tenté des solutions de pré-formation supervisée et de réglage fin pour la participation à la RL, mais dans le cadre de stratégies relativement fixes, l'exploration sera limitée, ce qui est également l'un des goulots d'étranglement à résoudre.

De plus, dans cette optique, les tâches utilisées pour l'évaluation des performances sont également relativement simples. Transfomer peut-il étendre cet apprentissage (auto)supervisé à des ensembles de données plus vastes, à des environnements plus complexes et à des applications du monde réel qui méritent également d'être explorées plus en profondeur ?

De plus, les chercheurs espèrent que les travaux futurs fourniront davantage d’informations théoriques et empiriques sur les conditions dans lesquelles un tel apprentissage (auto)supervisé devrait bien fonctionner.

Connecter l'apprentissage en ligne et hors ligne via Transformer

Entrer dans le RL hors ligne est une étape importante pour TransformRL, mais en fait, tirer parti de Transformer pour capturer les dépendances dans les séquences de décision et faire abstraction des stratégies, principalement indissociable du support des données hors ligne considérables utilisées.

Cependant, pour certaines tâches de prise de décision, se débarrasser des cadres en ligne n'est pas réalisable dans les applications pratiques.

D'une part, il n'est pas si simple d'obtenir des données d'experts sur certaines tâches ; d'autre part, certains environnements sont ouverts (comme Minecraft), ce qui signifie que les stratégies doivent constamment être ajustées pour faire face à des situations inconnues. situations lors d’interactions en ligne. Voir la tâche.

Par conséquent, les chercheurs estiment qu’il est nécessaire de connecter l’apprentissage en ligne et l’apprentissage hors ligne.

La plupart des progrès de recherche après Decision Transformer se concentrent sur les cadres d'apprentissage hors ligne et certains travaux tentent d'adopter le paradigme de la pré-formation hors ligne et du réglage fin en ligne. Cependant, le changement de distribution dans le réglage fin en ligne existe toujours dans les algorithmes RL hors ligne, et les chercheurs espèrent résoudre ce problème grâce à certaines conceptions spéciales du transformateur de décision.

De plus, comment former un transformateur de décision en ligne à partir de zéro est une question ouverte intéressante.

Structure de Transformer adaptée aux problèmes de prise de décision

La structure actuelle de Transformer dans la série de méthodes Decision Transformer est principalement Vanilla Transformer, qui a été initialement conçu pour les séquences de texte et peut avoir certaines fonctionnalités qui ne conviennent pas pour la prise de décision Nature du problème.

Par exemple, est-il approprié d'utiliser un mécanisme d'auto-attention vanille pour les séquences de trajectoires ? Les différents éléments d’une séquence de décision ou les différentes parties du même élément doivent-ils être distingués lors de l’intégration positionnelle ?

De plus, comme il existe de nombreuses variantes de représentation des trajectoires sous forme de séquences dans différents algorithmes de transformateur de décision, la manière de choisir parmi elles fait encore défaut de recherche systématique.

Par exemple, comment choisir des informations d'indice robustes lors du déploiement de tels algorithmes dans l'industrie ?

Et le Transformer Vanilla est également une structure coûteuse en termes de calcul, ce qui la rend coûteuse à la fois dans les étapes de formation et d'inférence, et a une empreinte mémoire élevée, ce qui limite également la longueur des dépendances qu'il peut capturer.

Afin d'atténuer ces problèmes, certains travaux en PNL ont amélioré la structure de Transformer, mais il vaut également la peine d'explorer si une structure similaire peut être utilisée pour les problèmes de prise de décision.

Utilisez Transformers pour implémenter davantage d'agents généraux

L'examen de Transformers pour les agents généralistes dans le document a montré le potentiel de Transformers en tant que stratégie générale.

En fait, la conception de Transformer permet le traitement de plusieurs modalités (telles que des images, des vidéos, du texte et de la parole) en utilisant une approche similaire au traitement des blocs, et démontre une excellente évolutivité vers des réseaux de très grande capacité et d'énormes ensembles de données.

Des travaux récents ont également permis de réaliser des progrès significatifs dans la formation d'agents capables d'effectuer des tâches multimodales et interdomaines.

Cependant, étant donné que ces agents sont formés sur des ensembles de données à grande échelle, il n'est pas encore certain s'ils mémorisent simplement l'ensemble de données et s'ils peuvent généraliser efficacement.

Par conséquent, comment apprendre un agent capable de généraliser à des tâches invisibles sans hypothèses fortes reste une question qui mérite d'être étudiée.

De plus, les chercheurs sont également curieux de savoir si Transformer est suffisamment puissant pour être utilisé pour apprendre un modèle mondial général pouvant être utilisé pour différentes tâches et scénarios.

RL pour Transformers

Bien que l'article ait expliqué comment RL peut bénéficier du modèle Transformer, à l'inverse, l'utilisation de RL pour améliorer la formation Transformer est toujours un problème ouvert intéressant qui n'a pas encore été bien exploré. .

On peut voir que le récent apprentissage par renforcement à partir de la rétroaction humaine (RLHF) peut apprendre un modèle de récompense et utiliser l'algorithme RL pour affiner le transformateur afin de rendre le modèle de langage cohérent avec les intentions humaines.

À l'avenir, les chercheurs pensent que RL peut devenir un outil utile pour améliorer encore les performances de Transformer dans d'autres domaines.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI