Maison >Périphériques technologiques >IA >Voulez-vous installer ChatGPT sur votre ordinateur ? Le grand modèle de langage open source national ChatGLM vous aide à le réaliser !

Voulez-vous installer ChatGPT sur votre ordinateur ? Le grand modèle de langage open source national ChatGLM vous aide à le réaliser !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-13 13:10:032298parcourir

Bonjour à tous.

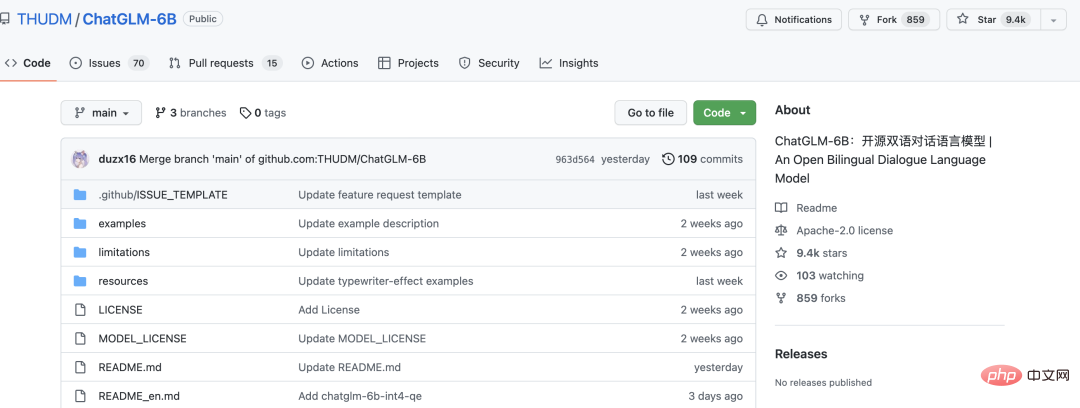

Aujourd'hui, j'aimerais partager avec vous un grand modèle de langage open source ChatGLM-6B.

En seulement dix jours, j'ai gagné près de 10 000 étoiles.

ChatGLM-6B est un modèle de langage conversationnel open source qui prend en charge le bilinguisme chinois et anglais. Il est basé sur l'architecture General Language Model (GLM) et compte 6,2 milliards de paramètres. Combiné à la technologie de quantification de modèle, les utilisateurs peuvent le déployer localement sur des cartes graphiques grand public (un minimum de 6 Go de mémoire vidéo est requis au niveau de quantification INT4). ChatGLM-6B utilise une technologie similaire à ChatGPT et est optimisé pour les questions, réponses et dialogues en chinois. Après une formation bilingue en chinois et en anglais avec environ 1T d'identifiants, complétée par un réglage fin supervisé, un libre-service de feedback, un apprentissage par renforcement du feedback humain et d'autres technologies, les 6,2 milliards de paramètres ChatGLM-6B ont été capables de générer des réponses tout à fait cohérentes avec préférences humaines.

Tout le monde peut l'installer sur son propre ordinateur et l'essayer. La mémoire vidéo minimale des graphiques indépendants est de 6 Go, et un ordinateur CPU peut également l'exécuter, mais elle est très lente.

Le projet n'ouvre actuellement que le modèle et le code d'inférence, mais n'ouvre pas la formation du modèle.

Pour exécuter le projet, vous n'avez besoin que de deux étapes

La première étape consiste à télécharger le code source

git clone https://github.com/THUDM/ChatGLM-6B.git

Exécutez pip install -r Requirements.txt pour installer les dépendances

La deuxième étape consiste à exécuter le projet

python web_demo.py

Après l'exécution, le fichier modèle sera automatiquement téléchargé vers la 4G.

S'il fonctionne sur GPU, par défaut, le modèle exécutant la mémoire vidéo est d'au moins 13 Go. Si la mémoire vidéo n'est pas suffisante, vous pouvez modifier web_demo.py

tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()Changez le THUDM/chatglm-6b dans le code ci-dessus. vers THUDM/chatglm-6b-int4 , c'est-à-dire : passez au modèle quantifié int4, et il peut fonctionner correctement tant que la mémoire vidéo est supérieure à 6 Go.

S'il signale une mémoire CPU insuffisante, fermez les autres logiciels, en particulier le navigateur.

Après une exécution réussie, il passera automatiquement à la page du navigateur et vous pourrez l'utiliser comme ChatGPT.

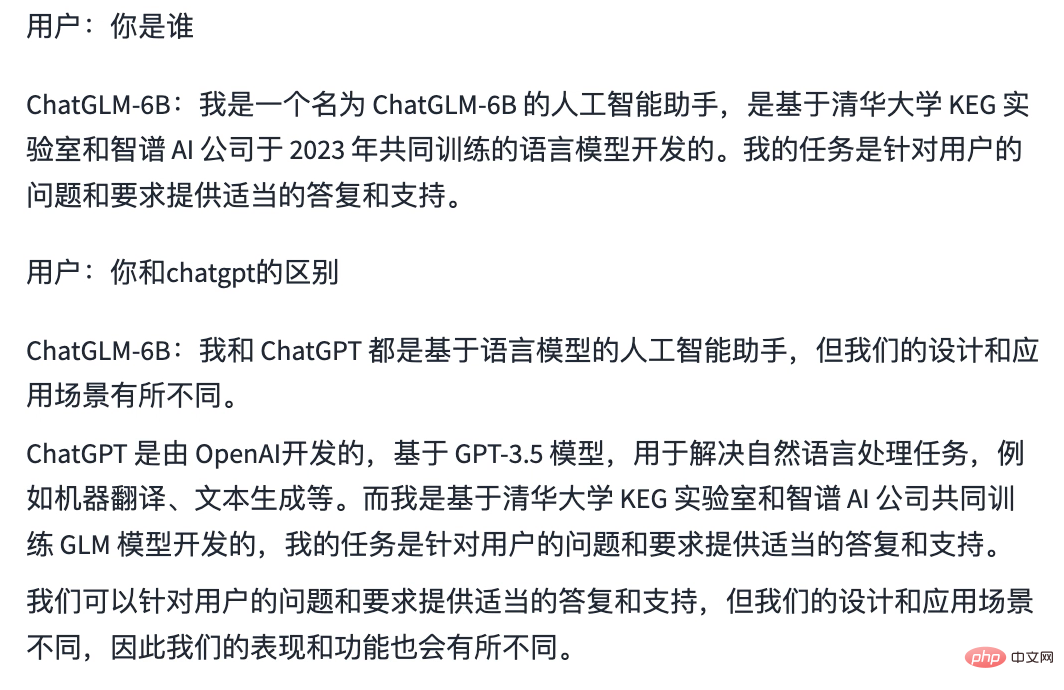

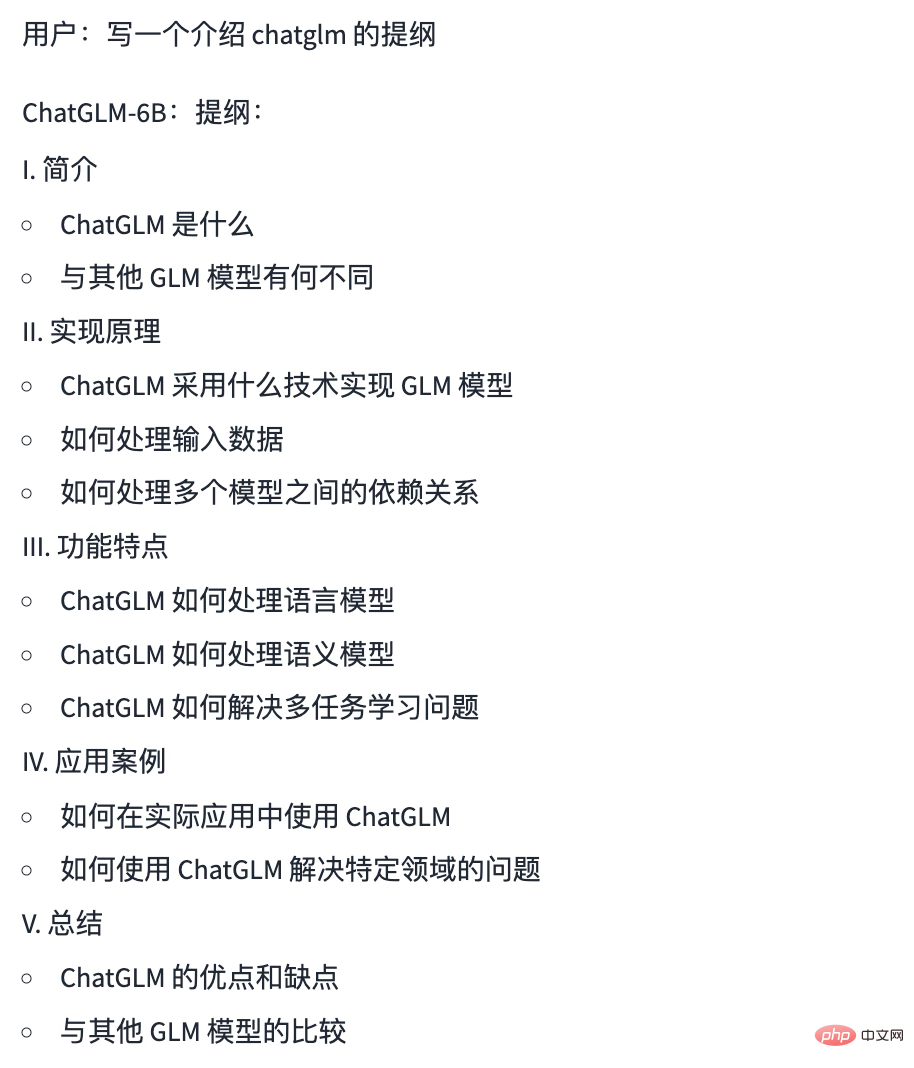

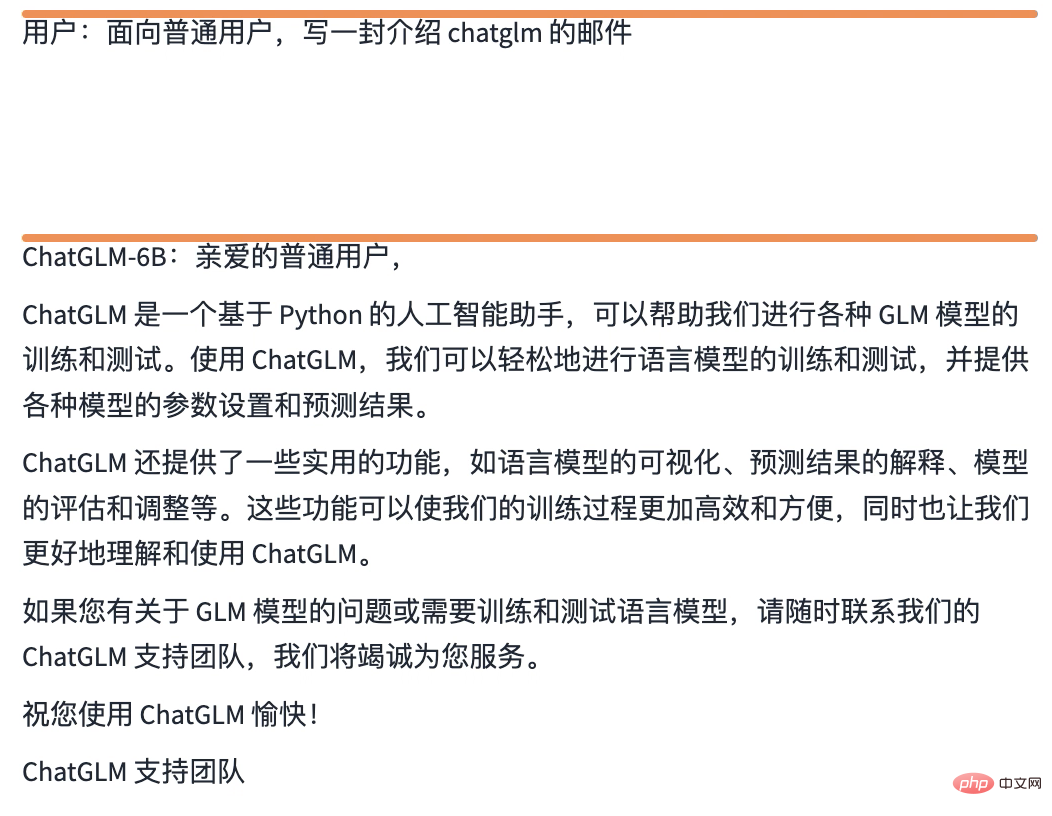

Ce qui suit est le résultat de mon opération locale Vous pouvez voir la différence avec ChatGPT

Conscience de soi

Écrire un aperçu

Écrire un e-mail

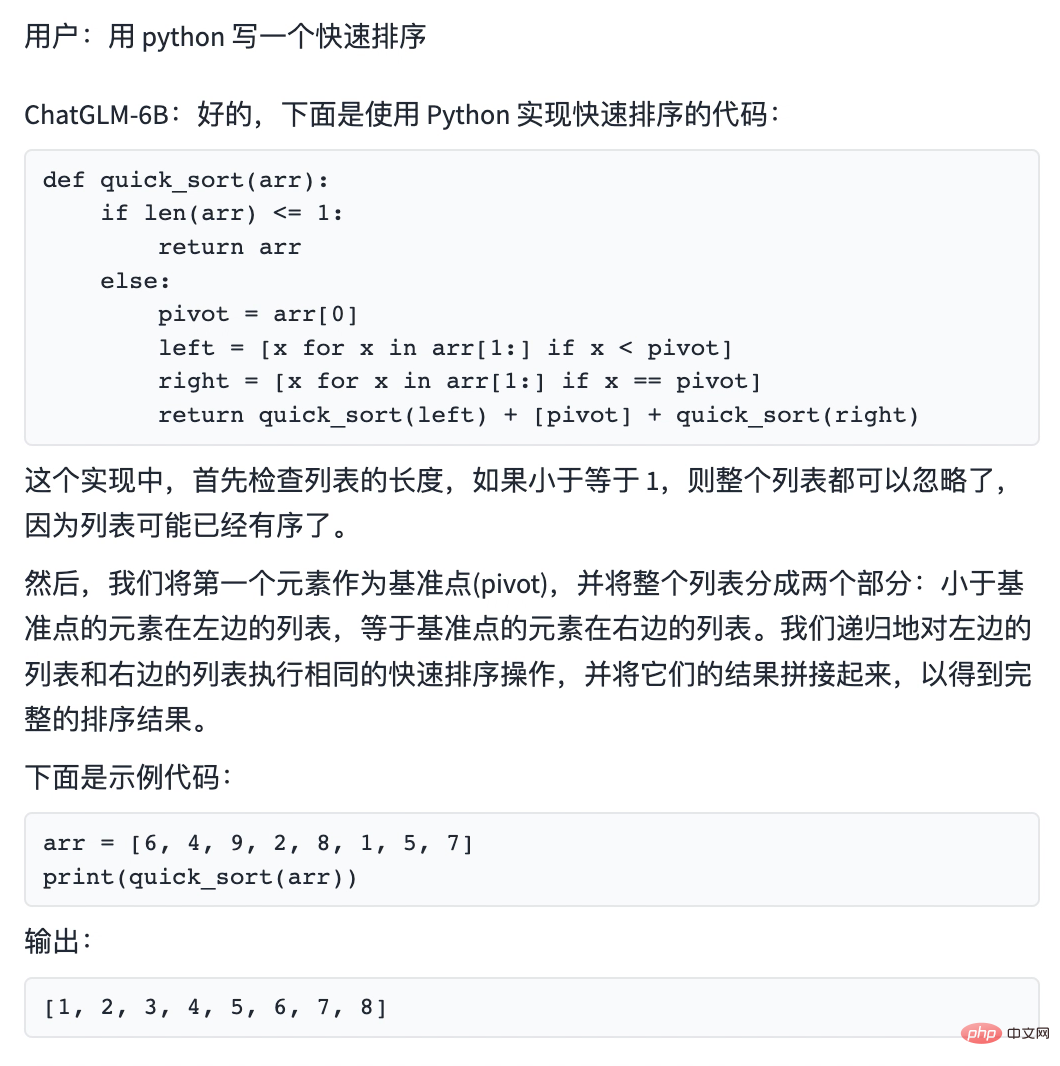

W. code rituel

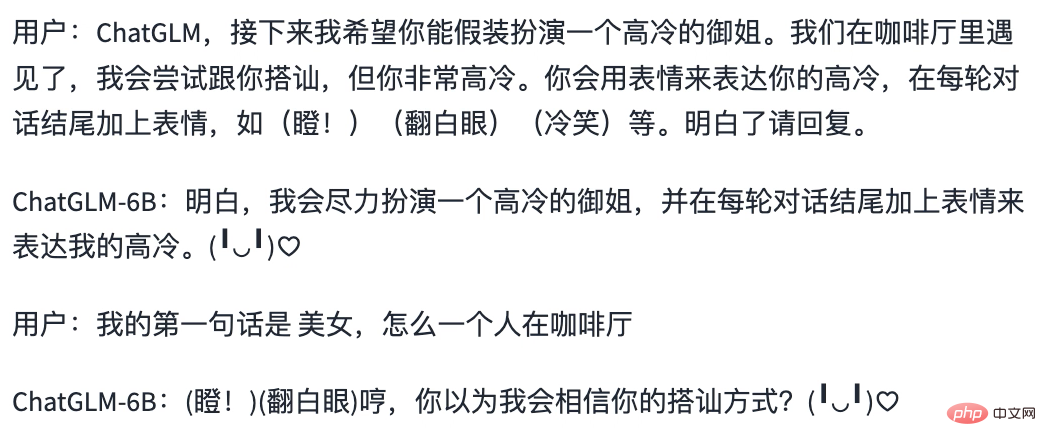

Jeu de rôle

Le projet est très simple à réaliser, vous pouvez l'essayer.

Si vous pensez que cet article vous est utile, veuillez cliquer sur "Lecture" pour m'encourager. Je continuerai à partager d'excellents projets Python+AI.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI