Maison >Périphériques technologiques >IA >Le nombre d'étoiles ControlNet dépasse les 10 000 ! En 2023, la peinture IA va-t-elle devenir folle ?

Le nombre d'étoiles ControlNet dépasse les 10 000 ! En 2023, la peinture IA va-t-elle devenir folle ?

- 王林avant

- 2023-04-13 11:25:021203parcourir

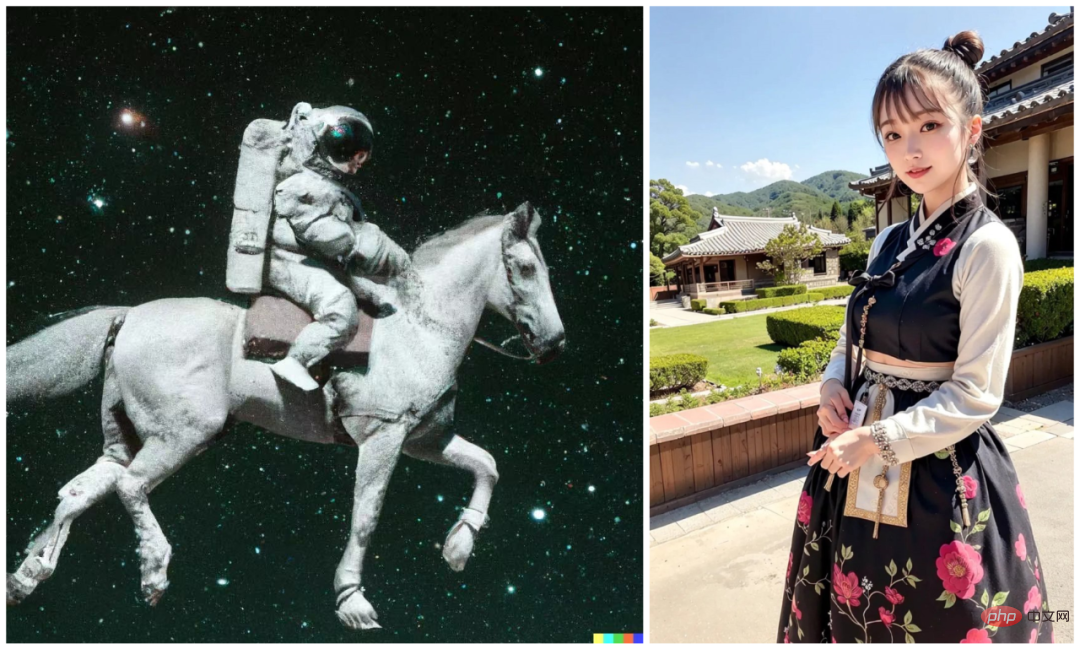

D'un astronaute équestre à une dame en trois dimensions, la peinture IA semble avoir fait des progrès révolutionnaires en moins d'un an.

Cet "astronaute équestre" est dessiné par le modèle graphique vincentien DALL・E 2 lancé par OpenAI en avril 2022. Son prédécesseur, DALL・E, a montré aux gens la capacité de générer directement des images à partir de texte en 2021, brisant ainsi le mur dimensionnel entre le langage naturel et la vision. Sur cette base, DALL・2 va encore plus loin et permet aux utilisateurs de modifier l'image originale, par exemple en ajoutant un corgi à l'image. Cette opération apparemment simple reflète en fait l'amélioration de la contrôlabilité du modèle de peinture AI.

Cependant, en termes d'influence, le modèle de diagramme Vincent le plus populaire en 2022 n'est pas DALL・E 2, mais un autre modèle avec des fonctions similaires - Stable Diffusion. Comme DALL・E 2, Stable Diffusion permet également aux créateurs de modifier les images générées, mais l'avantage est que le modèle est open source et peut fonctionner sur des GPU grand public. Ainsi, après sa sortie en août 2022, Stable Diffusion est rapidement devenu populaire et est devenu le modèle de diagramme Vincent le plus populaire en quelques mois seulement.

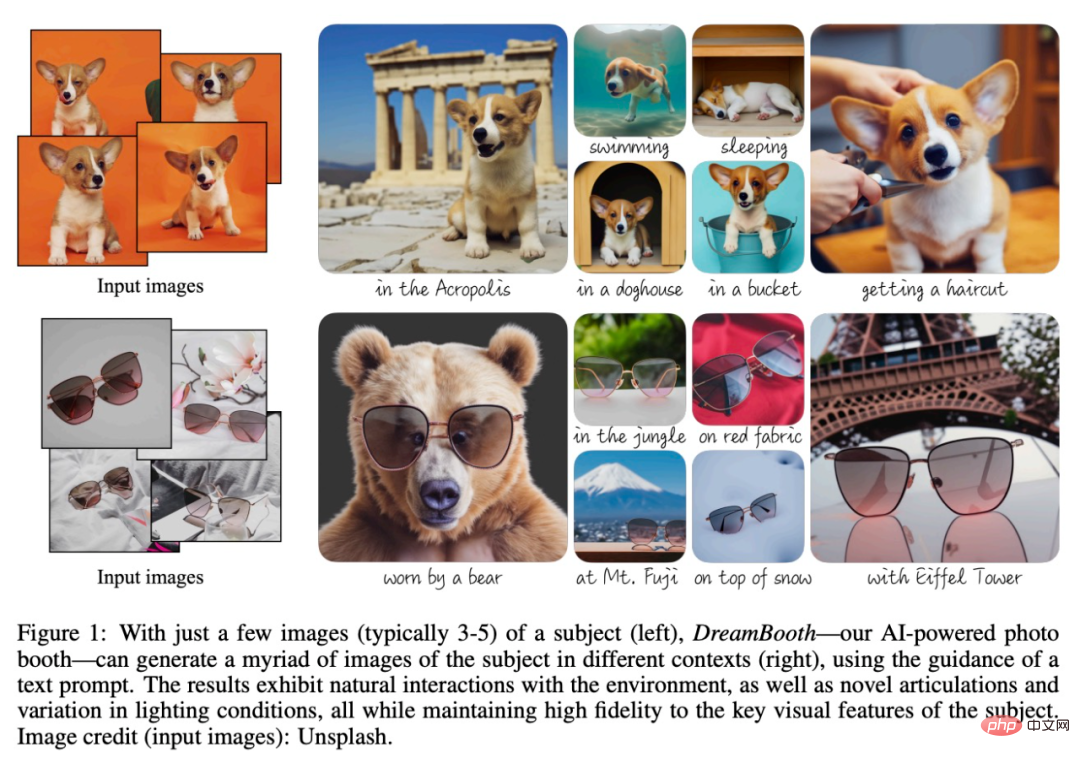

Des chercheurs de Google et de l'Université de Boston ont proposé un modèle de diffusion texte-image « personnalisé » DreamBooth, où les utilisateurs n'ont qu'à fournir 3 à 5 échantillons + une phrase. , l'IA peut personnaliser des images photoréalistes.

De plus, une équipe de recherche de l'UC Berkeley a également proposé une nouvelle méthode pour éditer des images selon des instructions humaines InstructPix2Pix, ce modèle combine GPT-3 et Diffusion stable. Étant donné une image d'entrée et une description textuelle indiquant au modèle quoi faire, le modèle peut suivre les instructions de description pour modifier l'image. Par exemple, pour remplacer les tournesols du tableau par des roses, il vous suffit de dire directement « remplacer les tournesols par des roses » directement au modèle.

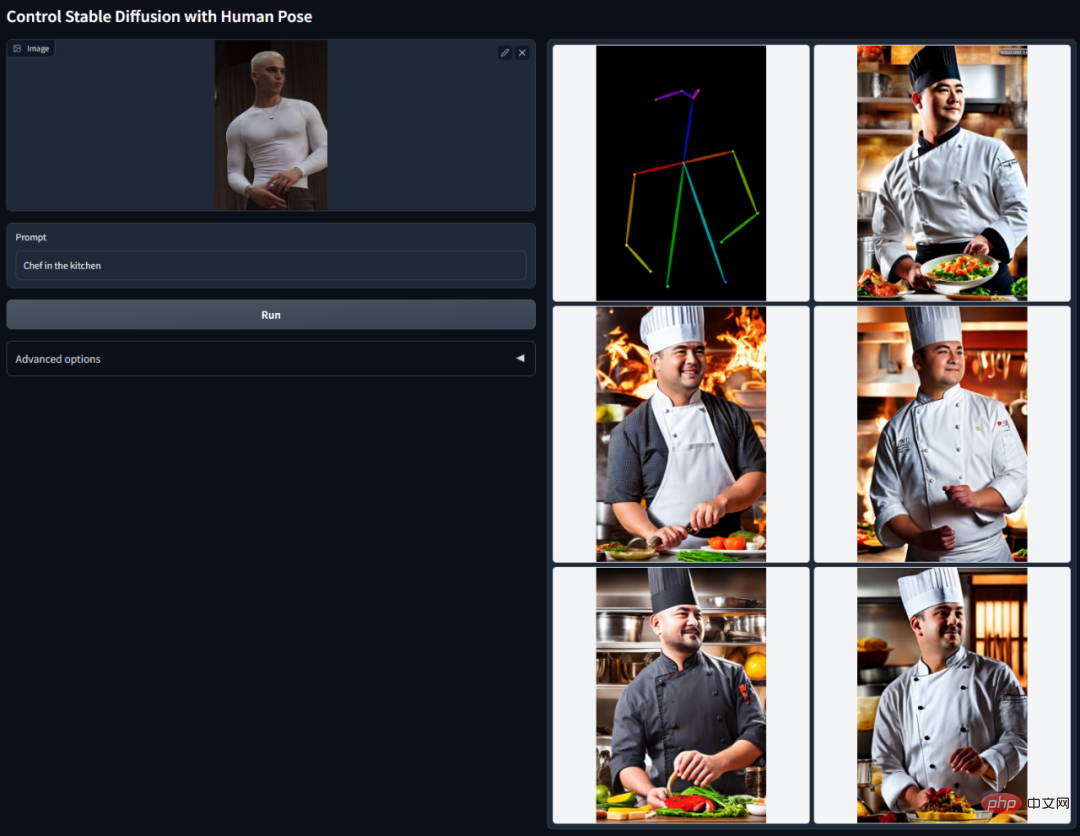

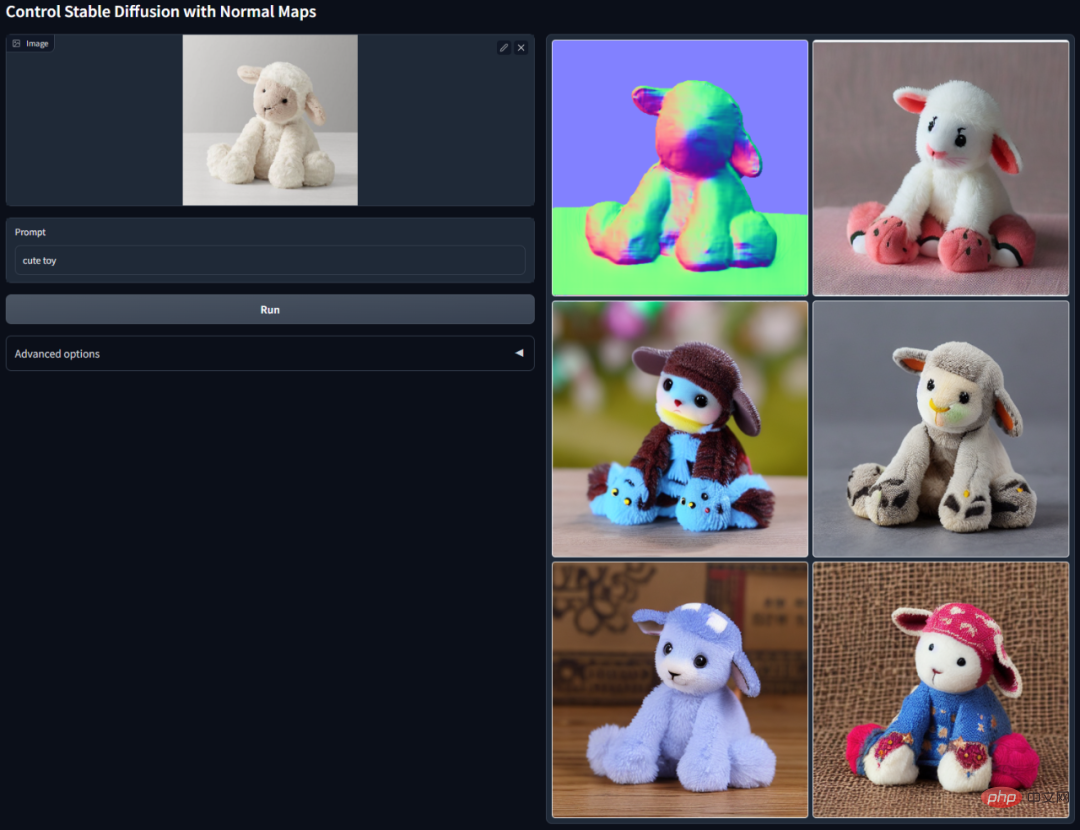

À l'aube de 2023, un modèle appelé ControlNet a poussé la flexibilité de ce type de contrôle jusqu'au sommet.

L'idée principale de ControlNet est d'ajouter des conditions supplémentaires à la description du texte pour contrôler le modèle de diffusion (comme la diffusion stable), contrôlant ainsi mieux la pose du personnage, la profondeur, la structure de l'image et d'autres informations du généré. image.

Les conditions supplémentaires ici sont saisies sous la forme d'une image. Le modèle peut effectuer une détection des bords Canny, une détection de profondeur, une segmentation sémantique, une détection de ligne de transformation de Hough, une détection globale des bords imbriqués (HED) et une posture humaine basée sur cela. image d'entrée, reconnaissance, etc., puis conserver ces informations dans l'image générée. En utilisant ce modèle, nous pouvons convertir directement des dessins au trait ou des graffitis en images en couleur, générer des images avec la même structure de profondeur, etc., et optimiser la génération de mains de personnages grâce aux points clés des mains.

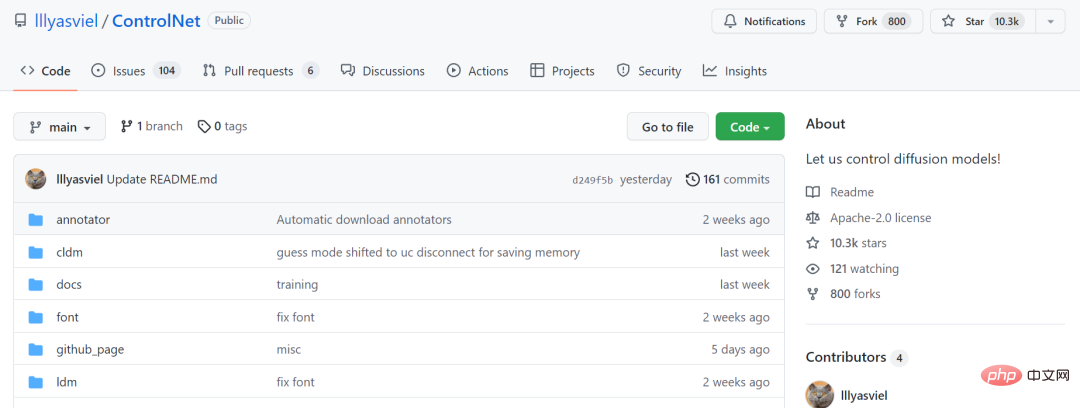

Ce modèle a fait d'énormes vagues dans le domaine de la peinture IA, et le nombre de stars GitHub de projets connexes a dépassé les 10 000.

Lien du projet : https://github.com/lllyasviel/ControlNet

Bien que de nombreuses personnes ne l'utilisent actuellement que pour générer des femmes en deux dimensions et en trois dimensions, c'est plus largement utilisé Ses utilisations ont également été progressivement découvertes, comme la conception de maisons, la photographie, la production cinématographique et télévisuelle, la conception publicitaire, etc. Dans ces scénarios, ControlNet est utilisé avec certains outils précédents, tels que LoRA pour gérer les problèmes de réglage fin des grands modèles, l'outil de conversion vidéo en animation EbSynth, etc. L’application combinée de ces outils accélère l’intégration des modèles de peinture IA dans le processus de production.

Utilisez des outils comme ControlNet et EbSynth pour repenser vos intérieurs. Source de l'image : https://creativetechnologydigest.substack.com/p/controlling-artistic-chaos-with-controlnet (tutoriel complet inclus) générer des modèles 3D. Source de l'image : https://www.reddit.com/r/StableDiffusion/comments/115eax6/im_working_on_api_for_the_a1111_controlnet/

Utilisation de Dreambooth et Con trolNet change l'éclairage de l'image 2D, peut être utilisé pour la post-production de photos et de vidéos. Source de l'image : https://www.reddit.com/r/StableDiffusion/comments/1175id9/when_i_say_mindblowing_i_mean_it_new_experiments/

Utilisation de ControlNet et E bSynth convertit l'animation en personne réelle . Bien que les résultats ne soient pas encore excellents, cela a montré le potentiel d’adapter l’anime en live-action sans avoir besoin d’acteurs. Source de l'image https://www.reddit.com/r/StableDiffusion/comments/117ewr9/anime_to_live_action_with_controlnet_ebsynth_not/

Le célèbre "nouveau logo" de la marque généré par un designer utilisant ControlNet. Source de l'image : https://twitter.com/fofrAI/status/1628882166900744194

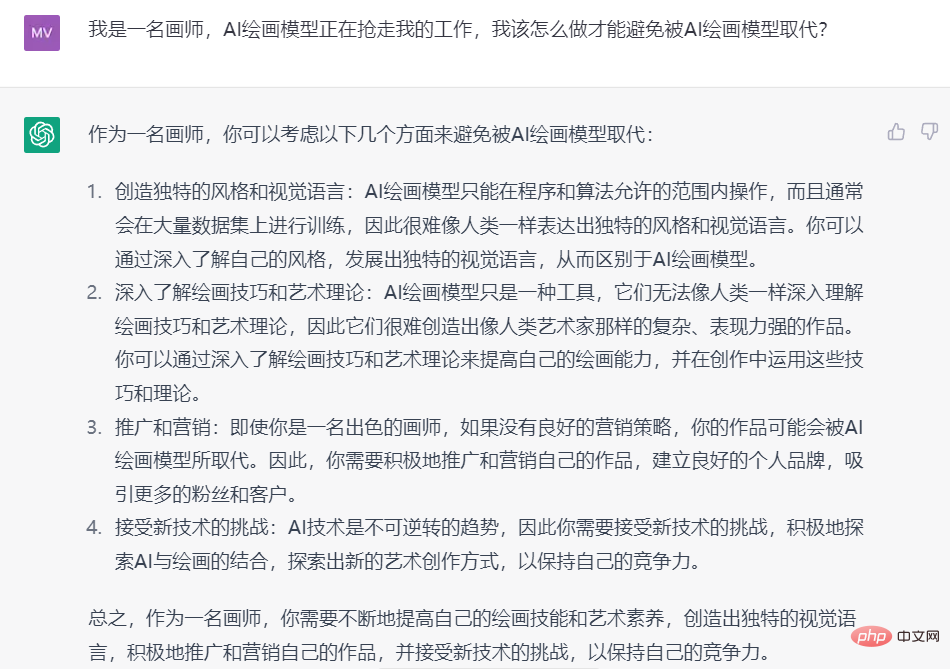

En plus des surprises, les progrès de ces technologies ont également plongé les praticiens de la peinture et d'autres domaines dans l'anxiété et la colère. Le problème est que l’IA pourrait vous faire perdre votre emploi. Malheureusement, de nombreuses images générées par l'IA sont des plagiats et des imitations d'artistes actuels, et les droits de propriété intellectuelle des artistes ont été violés.

Source de l'image : https://www.zhihu.com/question/583294094

Avec ces problèmes encore à résoudre, la peinture par IA est devenue un problème aigu dans le cercle des peintres. Beaucoup de gens pensent que tout le monde devrait boycotter la peinture IA et défendre ensemble ses droits. Par conséquent, lorsque la nouvelle s'est répandue selon laquelle un artiste bien connu était soupçonné d'avoir utilisé la peinture IA pour contribuer à un studio de jeux, d'autres artistes ont été complètement indignés.Dans le même temps, les joueurs étaient également en colère. Parce qu'il existe encore certaines limites dans la peinture par l'IA à l'heure actuelle, comme ne pas être capable de bien gérer les détails des mains (vous pouvez le voir si vous regardez attentivement la fille sur la première image de cet article), elle ne peut pas répondre aux exigences des joueurs. pour des effets visuels exquis, des personnages dotés de personnalité et de créativité, etc. , de nombreux joueurs se sont sentis « dupés ». Par conséquent, le studio de jeux mentionné ci-dessus ne peut qu'émettre une déclaration d'urgence indiquant qu'il "n'utilisera pas la peinture IA dans ses produits".

Mais combien de temps cette situation va-t-elle durer ? Lorsque le niveau de peinture de l'IA atteint un niveau difficile à distinguer à l'œil nu, comment savoir si le jeu auquel vous jouez est celui de l'artiste ou de l'IA, ou d'une « équipe » composée des deux ? Source : https://m.weibo.cn/2268335814/4870844515358190 Peut-être dans quelques mois , Les outils de peinture de l'IA seront comme des programmeurs comme Copilot, il est devenu un outil indispensable aux peintres dans leur travail quotidien. Bien entendu, cela a également pratiquement relevé la barre pour cette industrie, tout comme pour d’autres industries qui ont été « envahies » par l’IA. Comment maintenir sa compétitivité dans une telle vague est peut-être une question à laquelle tout le monde devrait réfléchir.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI