Maison >Périphériques technologiques >IA >L'algorithme NeRF à vue unique S^3-NeRF utilise des informations multi-éclairage pour restaurer la géométrie de la scène et les informations sur les matériaux.

L'algorithme NeRF à vue unique S^3-NeRF utilise des informations multi-éclairage pour restaurer la géométrie de la scène et les informations sur les matériaux.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-13 10:58:021489parcourir

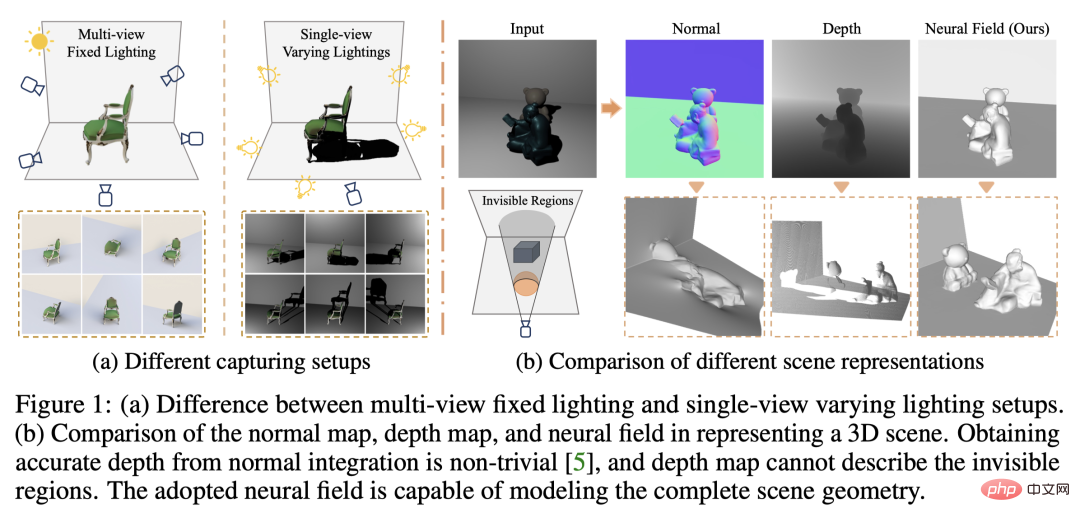

Les travaux actuels de reconstruction d'images 3D utilisent généralement une méthode de reconstruction stéréo multi-vues (Multi-view Stereo) qui capture la scène cible à partir de plusieurs points de vue (multi-vues) dans des conditions d'éclairage naturel constantes. Cependant, ces méthodes supposent généralement des surfaces lambertiennes et ont des difficultés à récupérer les détails haute fréquence.

Une autre méthode de reconstruction de scène consiste à utiliser des images capturées à partir d'un point de vue fixe mais de points lumineux différents. Les méthodes photométriques stéréo, par exemple, prennent cette configuration et utilisent ses informations d'ombrage pour reconstruire les détails de surface d'objets non lambertiens. Cependant, les méthodes existantes à vue unique utilisent généralement des cartes normales ou des cartes de profondeur pour représenter les surfaces visibles, ce qui les rend incapables de décrire l'arrière des objets et les zones obstruées, et ne peuvent reconstruire que la géométrie de la scène en 2,5D. De plus, les cartes normales ne peuvent pas gérer les discontinuités de profondeur.

Dans une étude récente, des chercheurs de l'Université de Hong Kong, de l'Université chinoise de Hong Kong (Shenzhen), de l'Université technologique de Nanyang et du MIT-IBM Watson AI Lab ont proposé d'utiliser plusieurs sources de lumière à vue unique (une seule source lumineuse). vue, multi-lumières) pour reconstruire une scène 3D complète.

- Lien papier : https://arxiv.org/abs/2210.08936

- Page d'accueil du papier : https://ywq.github.io/s3nerf/

- Lien de code : https://github.com/ywq/s3nerf

Contrairement aux méthodes à vue unique existantes basées sur des cartes normales ou des cartes de profondeur, S3-NeRF est basé sur des scènes neuronales Représentation neuronale de la scène, tout en utilisant les informations d'ombrage et d'ombre dans la scène pour reconstruire l'intégralité de la scène 3D (y compris les zones visibles/invisibles). Les méthodes de représentation de scène neuronale utilisent des perceptrons multicouches (MLP) pour modéliser un espace 3D continu, en mappant des points 3D sur des attributs de scène tels que la densité, la couleur, etc. Bien que la représentation de scènes neuronales ait fait des progrès significatifs dans la reconstruction multi-vues et la synthèse de nouvelles vues, elle a été moins explorée dans la modélisation de scènes à vue unique. Contrairement aux méthodes existantes basées sur la représentation de scènes neuronales qui reposent sur la cohérence des photos multi-vues, S3-NeRF optimise principalement le champ neuronal en utilisant les informations d'ombrage et d'ombre sous une seule vue.

Nous avons constaté que le simple fait d'introduire des informations sur la position de la source lumineuse directement dans NeRF en entrée ne permet pas de reconstruire la géométrie et l'apparence de la scène. Pour mieux utiliser les images stéréo photométriques capturées, nous modélisons explicitement la géométrie de la surface et le BRDF à l'aide d'un champ de réflexion, et utilisons un rendu basé sur la physique pour calculer la couleur des points 3D de la scène, obtenue via le rendu stéréo. pixel bidimensionnel correspondant au rayon. Parallèlement, nous effectuons une modélisation différentiable de la visibilité de la scène et calculons la visibilité du point en traçant les rayons entre le point 3D et la source lumineuse. Cependant, étant donné que la visibilité de tous les points d'échantillonnage sur un rayon est coûteuse en calcul, nous optimisons la modélisation des ombres en calculant la visibilité des points de surface obtenus par lancer de rayons.

Représentation de la scène basée sur le champ de réflexion neuronale

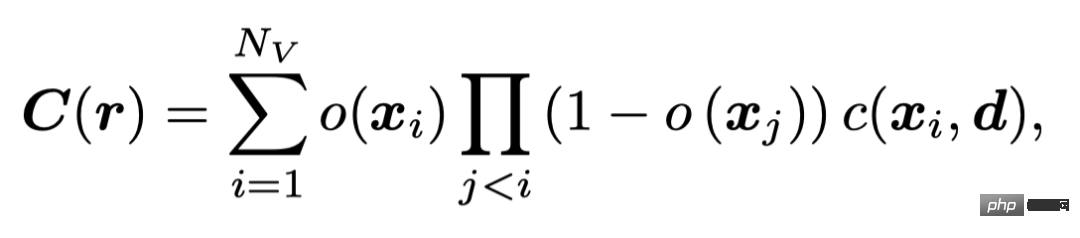

Nous utilisons un champ d'occupation similaire à UNISURF pour caractériser la géométrie de la scène. UNISURF mappe les coordonnées du point 3D et la direction de la ligne de visée à la valeur d'occupation et à la couleur du point via MLP, et obtient la couleur du pixel grâce au rendu stéréo,

Nv suréchantillons chaque rayon Le nombre de points.

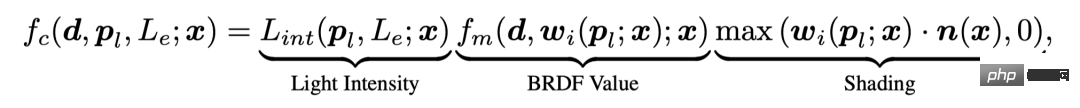

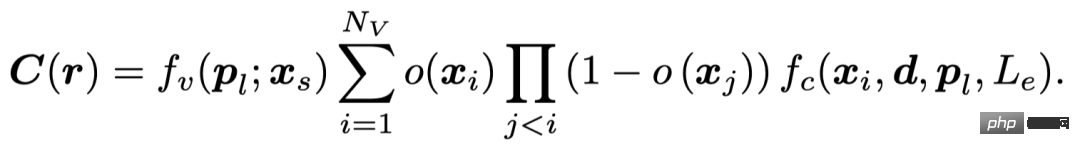

Pour utiliser efficacement les informations d'ombrage dans les images stéréo photométriques, S3-NeRF modélise explicitement le BRDF de la scène et utilise un rendu basé sur la physique pour obtenir la couleur des points 3D. Dans le même temps, nous modélisons la visibilité lumineuse des points 3D de la scène pour tirer parti des riches ombres de l'image et obtenons la valeur finale du pixel grâce à l'équation suivante.

Modèle de rendu basé sur la physique

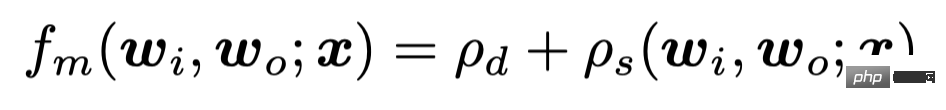

Notre approche prend en compte les surfaces non lambertiennes et les BRDF spatialement variables. La valeur du point x observé depuis la direction de la ligne de visée d sous la source lumineuse du point en champ proche (pl, Le) peut être exprimée par

Parmi eux, nous considérons le problème d'atténuation de la lumière du point. source de lumière, à travers le point source de lumière. La distance calcule l'intensité de la lumière incidente sur ce point. Nous utilisons un modèle BRDF qui prend en compte la réflexion diffuse et spéculaire

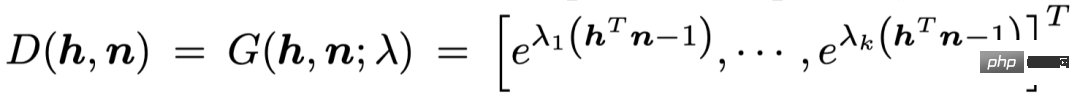

pour représenter la réflectance spéculaire à travers une combinaison pondérée de base gaussienne sphère

Modélisation des ombres

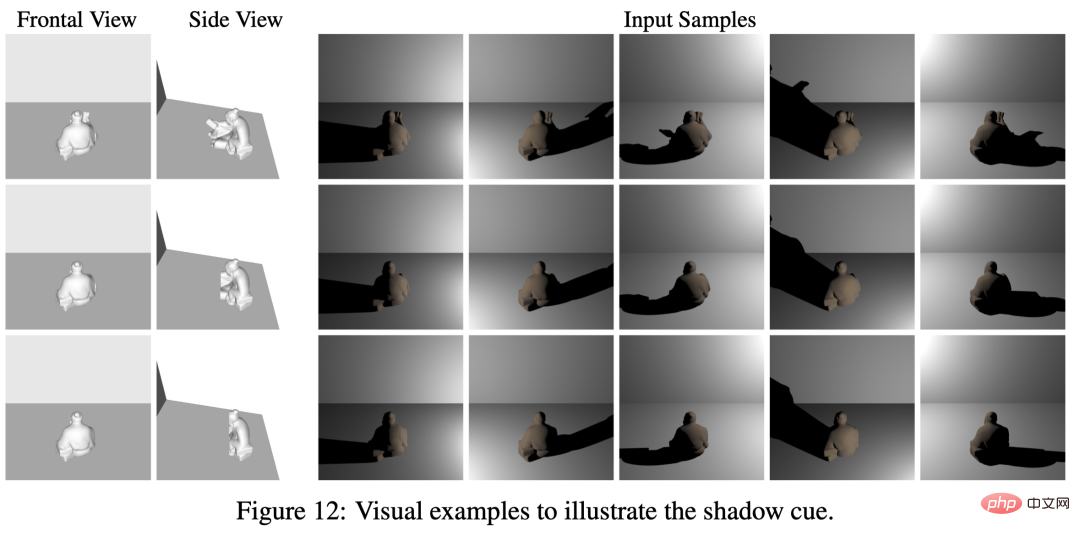

Ombres dans la géométrie de la scène L'un des indices cruciaux dans la reconstruction. Les trois objets sur la photo ont la même forme et la même apparence vue de face, mais ont des formes différentes au dos. Grâce aux ombres produites sous différents éclairages, nous pouvons observer que les formes des ombres sont différentes, ce qui reflète les informations géométriques des zones invisibles dans la vue de face. La lumière crée certaines contraintes sur le contour arrière de l'objet à travers les ombres réfléchies dans l'arrière-plan.

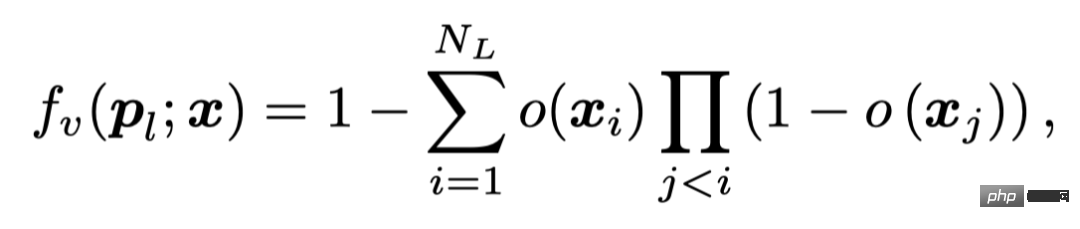

Nous reflétons la visibilité lumineuse du point en calculant la valeur d'occupation entre le point 3D - la source lumineuse

où, NL est le point - le segment de ligne de source lumineuse Nombre de points échantillonnés.

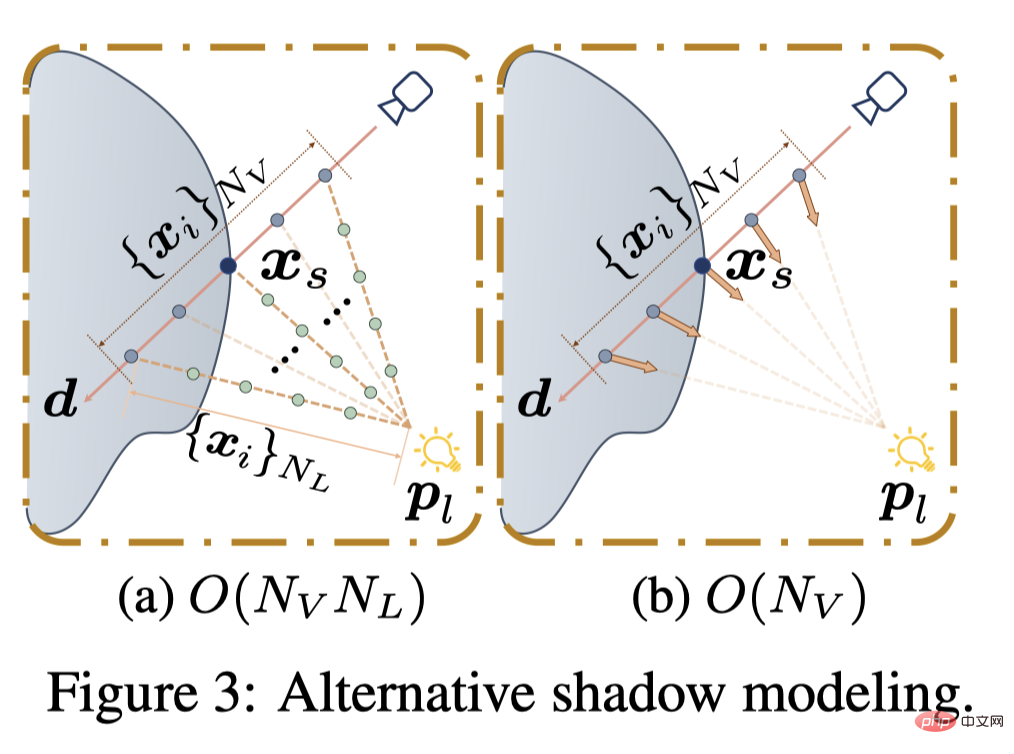

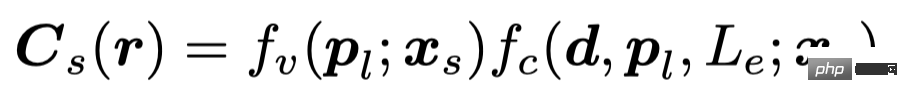

En raison du coût de calcul important du calcul de la visibilité de tous les points Nv échantillonnés par points de pixels le long de la lumière (O (NvNL)), l'existant les méthodes sont Utiliser MLP pour régresser directement la visibilité des points (O (Nv)), ou pré-extraire les points de surface après avoir obtenu la géométrie de la scène (O (NL)). S3-NeRF calcule la visibilité lumineuse du pixel en ligne à travers les points de surface localisés par recherche de racine et exprime la valeur du pixel à l'aide de la formule suivante.

Optimisation de scène

Notre méthode ne nécessite pas de supervision des ombres, mais s'appuie sur la perte de reconstruction de l'image pour l'optimisation. Étant donné qu'il n'y a pas de contraintes supplémentaires apportées par d'autres perspectives dans une seule perspective, si une stratégie d'échantillonnage comme UNISURF est adoptée pour réduire progressivement la plage d'échantillonnage, le modèle commencera à se dégrader après la réduction de l'intervalle d'échantillonnage. Par conséquent, nous adoptons une stratégie de rendu stéréo et de rendu de surface conjoints, en utilisant la recherche de racine pour localiser les points de surface afin de restituer la couleur et de calculer la perte L1.

Résultats expérimentaux

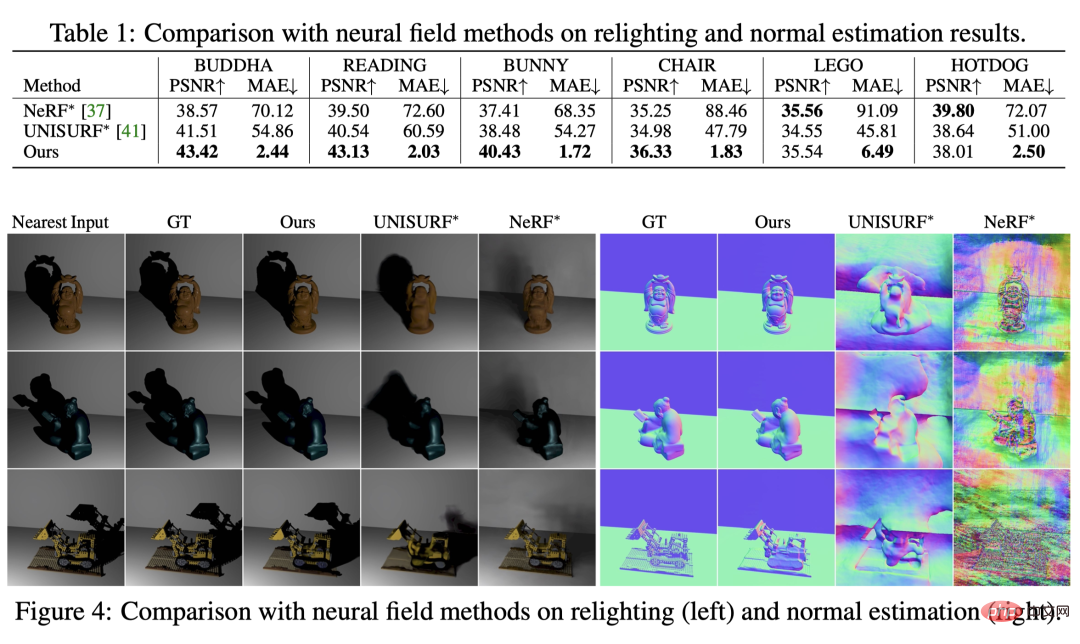

Comparaison avec la méthode du champ de rayonnement neuronal

Nous comparons d'abord avec deux méthodes de base basées sur les champs de rayonnement neuronal (en raison de tâches différentes, nous introduisons les informations sur la source lumineuse dans leur couleur MLP). Vous pouvez voir qu’ils sont incapables de reconstruire la géométrie de la scène ou de générer avec précision des ombres sous un nouvel éclairage.

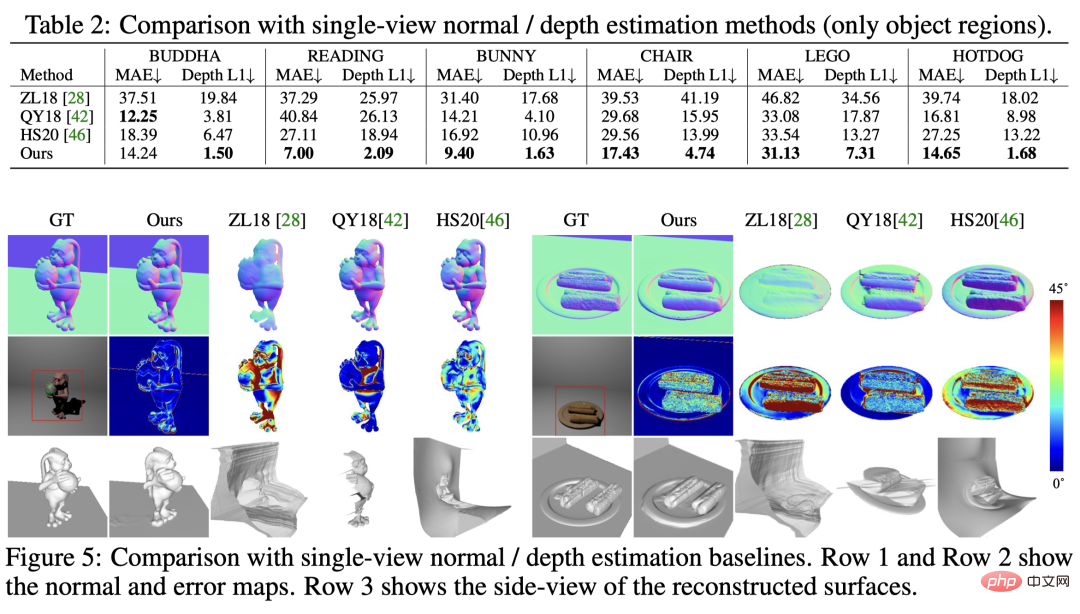

Comparaison avec les méthodes d'estimation de forme à vue unique

Dans la comparaison avec les méthodes d'estimation normale/profondeur à vue unique existantes, on peut voir que notre méthode a de meilleures performances en estimation normale et en profondeur Les deux méthodes ont obtenu les meilleurs résultats et ont pu reconstruire simultanément les zones visibles et invisibles de la scène.

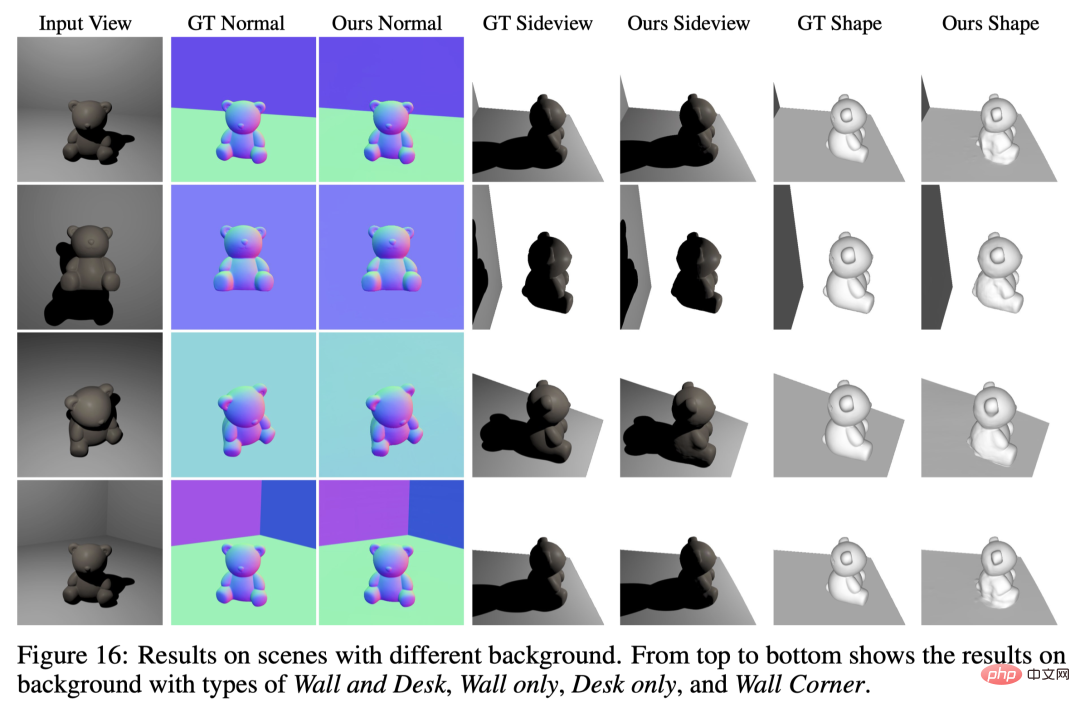

Reconstruction de scènes avec différents arrière-plans

Notre méthode convient à une variété de scènes avec différentes conditions d'arrière-plan.

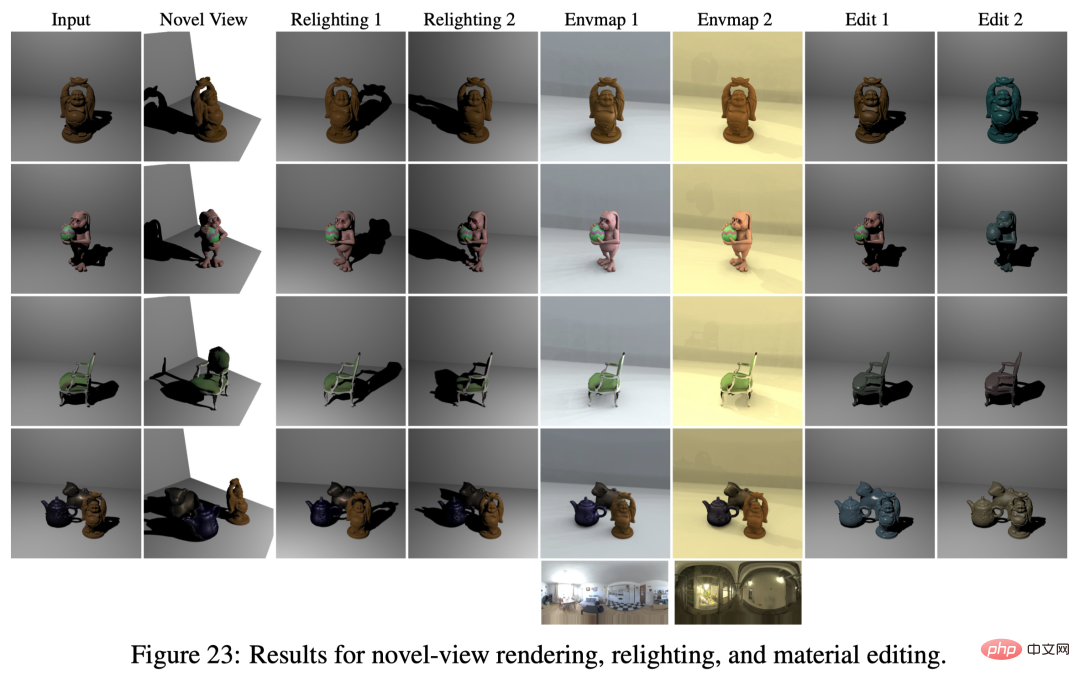

Nouveau rendu de vue, changement d'éclairage et édition de matériaux

Sur la base de la modélisation de scène par champ de réflexion neuronale, nous avons réussi à découpler la géométrie/matériau/éclairage de la scène, etc., afin qu'elle puisse être appliqué au nouveau rendu de vue, au changement d'éclairage de scène, à l'édition de matériaux et à d'autres applications.

Reconstruction de scènes de tournage réelles

Nous avons tourné trois scènes réelles pour explorer son aspect pratique. Nous avons corrigé la position de la caméra, utilisé la lampe de poche du téléphone portable comme source de lumière ponctuelle (la source de lumière ambiante était éteinte) et déplacé la lampe de poche de manière aléatoire pour capturer des images sous différentes sources de lumière. Cette configuration ne nécessite pas d'étalonnage de la source lumineuse, nous appliquons SDPS-Net pour obtenir une estimation approximative de la direction de la source lumineuse et initialisons la position de la source lumineuse en estimant approximativement les distances relatives caméra-objet et source lumineuse-objet. Les positions des sources lumineuses sont optimisées conjointement avec la géométrie de la scène et BRDF pendant la formation. On peut voir que même avec un réglage de capture de données plus décontracté (sans calibrage de la source lumineuse), notre méthode peut toujours bien reconstruire la géométrie de la scène 3D.

Résumé

- S3-NeRF optimise les champs de réflexion neuronale pour reconstruire la géométrie de la scène 3D et les informations matérielles en utilisant des images prises sous plusieurs points lumineux dans une seule vue.

- En utilisant des indices d'ombrage et d'ombre, S3-NeRF peut restaurer efficacement la géométrie des zones visibles/invisibles de la scène, réalisant ainsi la reconstruction de la géométrie complète de la scène/BRDF d'un point de vue monoculaire.

- Diverses expériences montrent que notre méthode peut reconstruire des scènes avec diverses géométries/matériaux complexes, et peut gérer des arrière-plans de différentes géométries/matériaux et différentes quantités de lumière/distributions de sources lumineuses.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI