Maison >Périphériques technologiques >IA >Le modèle Google PaLM est-il également déclaré éveillé par les profanes ? Insiders du secteur : les tests de rationalité ne sont que 3 % meilleurs que GPT

Le modèle Google PaLM est-il également déclaré éveillé par les profanes ? Insiders du secteur : les tests de rationalité ne sont que 3 % meilleurs que GPT

- PHPzavant

- 2023-04-13 09:10:021238parcourir

« L'intelligence artificielle générale » est désormais presque devenue la technologie « de l'eau au pétrole » des années 2020. Presque tous les deux mois, quelqu'un annoncera qu'il a découvert/croit qu'un certain grand modèle a éveillé la nature humaine et que l'IA est « venue à l'esprit ». vie" . Celui qui a fait le plus de bruit à propos de ce genre d’actualité ces derniers temps est Google. Il est de notoriété publique que l'ancien chercheur Blake Lemoine a déclaré que le grand modèle de langage LaMDA est « vivant ». Comme prévu, ce vieil homme est entré dans le processus de démission.

En fait, presque au même moment, il y avait aussi un article quasi-soft de Google dans The Atlantic Monthly disant qu'un autre nouveau grand modèle de langage, PaLM, est également devenu "une véritable intelligence artificielle générale" (C'est un véritable intelligence générale artificielle) .

"The Atlantic" a annoncé de force que PaLM est devenu AGI

Mais presque personne n'a lu cet article, il n'a donc déclenché que quelques discussions et critiques.

Cependant, même si personne ne lit les manuscrits de publications de classe mondiale qui font l'éloge de fabricants de classe mondiale, ils seront toujours comme le disent les vieilles lignes de films : « Comme des lucioles dans la nuit noire, si brillantes et exceptionnelles... " 2022 Le 19 juin 2019, The Atlantic a publié un article intitulé « La conscience artificielle est ennuyeuse ».

Le titre web de cet article dans "The Atlantic" est plus simple que le titre de l'article qui tente de le dissimuler : "L'IA PaLM de Google est bien plus étrange que consciente".

Le contenu n’est pas surprenant, c’est l’éloge de l’auteur après avoir interviewé des membres de l’équipe du projet PaLM de Google Brain : 540 milliards de paramètres, capables d’accomplir des centaines de tâches différentes sans pré-formation. Peut raconter des blagues et résumer du texte. Si l'utilisateur saisit une question en bengali, le modèle PaLM peut répondre en bengali et en anglais.

Si l'utilisateur a besoin de traduire un morceau de code du langage C vers Python, le modèle PaLM peut également le compléter rapidement. Mais cet article est progressivement passé d'un scénario d'interview vantard soupçonné d'être un article soft, à une ébauche flatteuse : annonçant que le modèle PaLM est « une véritable intelligence artificielle générale » (C'est une véritable intelligence artificielle générale).

"La fonction qui a surpris ses propres développeurs, et qui demande du sang-froid et de la distance intellectuelle pour ne pas avoir peur et l'accepter - PaLM est rationnel, une certaine distance et un certain sang-froid intellectuel pour ne pas paniquer. )

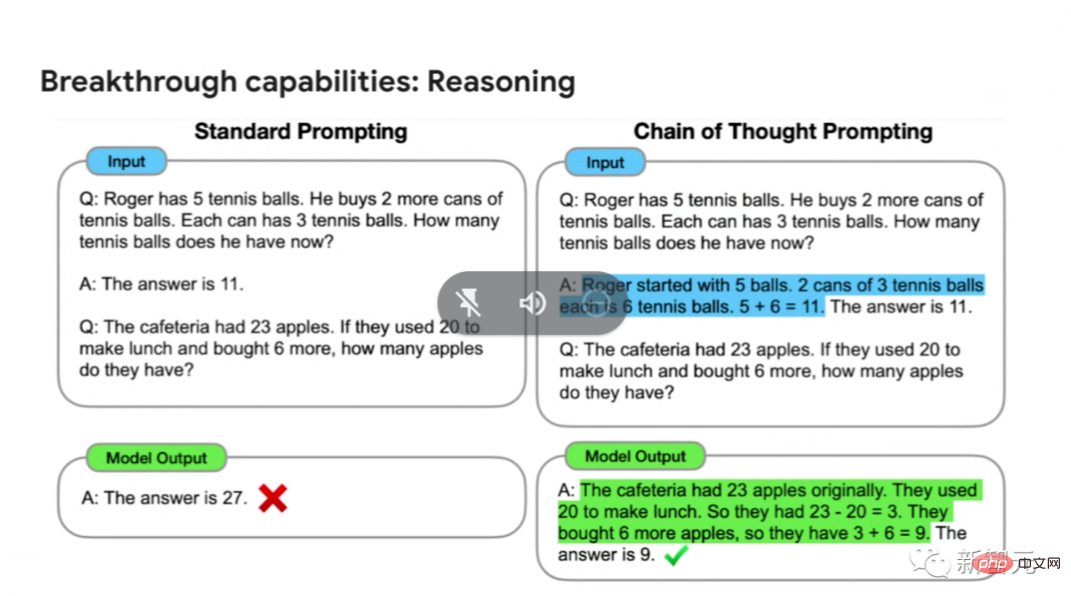

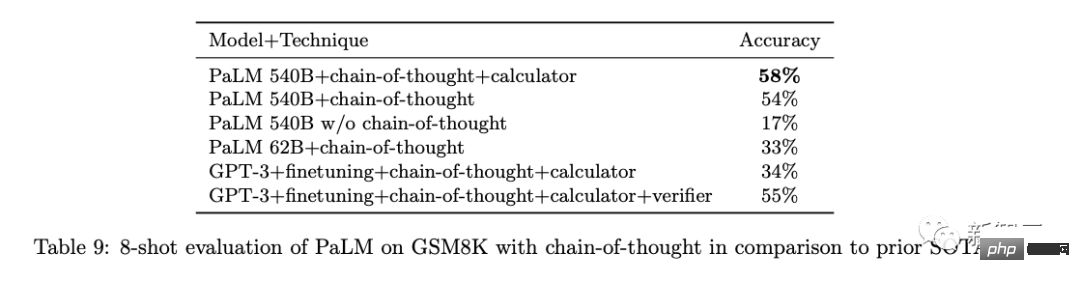

C'est la deuxième fois ce mois-ci que Google annonce de force qu'un grand modèle est AGI. Quel est le fondement de cette affirmation ? Selon l'auteur de cet article, c'est parce que le modèle PaLM peut « sortir des sentiers battus » pour résoudre seul différentes tâches intelligentes sans formation spécifique au préalable. De plus, le modèle PaLM a une fonction « d'invite de chaîne de réflexion ». En langue vernaculaire, après avoir démonté, expliqué et démontré le processus de résolution de problèmes au modèle PaLM, PaLM peut trouver lui-même la bonne réponse.

Jeff Dean lui-même n'a jamais dit que PaLM était AGI

L'écart entre le gadget et les preuves a un énorme sentiment de « enlève ton pantalon et regarde ça » : il s'avère que l'auteur de "The Atlantic Monthly" a également des opinions différentes. C'est une habitude de commencer à interviewer des gens pour écrire des articles après avoir vérifié les informations.

La raison pour laquelle je dis cela est que lorsque le professeur Jeff Dean a dirigé l'équipe pour lancer le modèle PaLM, il a introduit la fonction « Thinking Chain Prompt ». Mais Google Brain n'oserait jamais se vanter que ce produit est un « Terminator » qui a pris vie. En octobre 2021, Jeff Dean a personnellement écrit un article présentant une nouvelle architecture d'apprentissage automatique : Pathways. Le but est très simple : permettre à une IA de couvrir des dizaines de milliers de tâches, de comprendre différents types de données et d'y parvenir avec une efficacité extrêmement élevée en même temps :

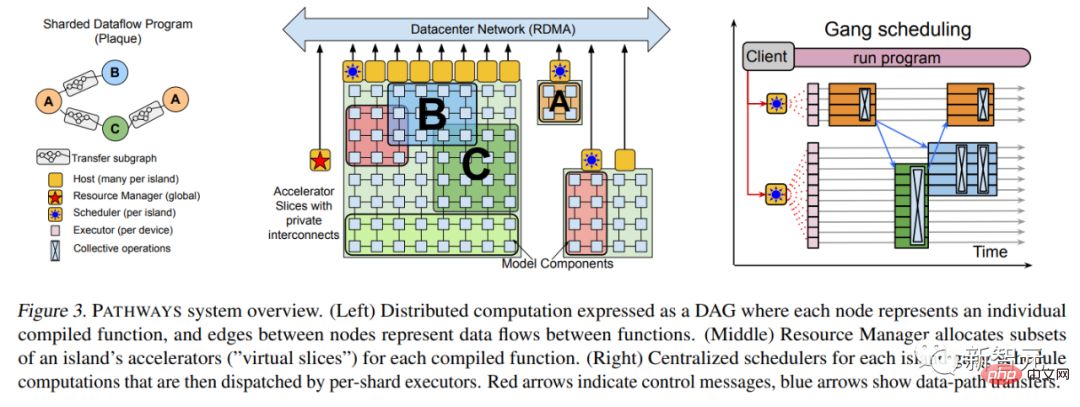

En mars 2022, plus de six mois plus tard, Jeff Dean a finalement publié l'article Pathways.  Adresse papier : https://arxiv.org/abs/2203.12533 Parmi eux, de nombreux détails techniques sont ajoutés, comme l'architecture système la plus basique, etc.

Adresse papier : https://arxiv.org/abs/2203.12533 Parmi eux, de nombreux détails techniques sont ajoutés, comme l'architecture système la plus basique, etc.

En avril 2022, le modèle de langage PaLM de Google construit à l'aide du système Pathways a été lancé. Ce modèle de langage Transformer avec 540 milliards de paramètres a successivement brisé le SOTA de plusieurs tâches de traitement du langage naturel. En plus d'utiliser le puissant système Pathways, l'article introduit que la formation de PaLM utilise 6144 TPU v4, en utilisant un ensemble de données de haute qualité de 780 milliards de jetons, dont 22 % sont des corpus non anglais et multilingues.

Adresse papier : https://arxiv.org/abs/2204.02311 « Apprentissage auto-supervisé » et « Invites de la chaîne de réflexion » étaient des concepts familiers dans l'industrie de l'IA auparavant, et le Le modèle PaLM n'est qu'un concept plus récent. Mettez en œuvre davantage le concept dans la réalité. Pour aggraver les choses, l'article d'Atlantic Monthly déclarait directement que "les chercheurs de Google ne savent pas pourquoi le modèle PaLM peut remplir cette fonction"... C'est parce que le professeur Jeff Dean est trop occupé et cherche quelque chose à faire pour lui.

Critiques : la déclaration de l'Atlantic Monthly n'est pas fiable

Effectivement, le professeur Melanie Mitchell, membre du Santa Fe Institute en Californie, aux États-Unis, a publié une série de messages sur son compte de réseau social, remettant implicitement mais fermement en question l'Atlantique. Mensuel 》Cet article.

Melanie Mitchell a déclaré : "Cet article est très intéressant, mais je pense que l'auteur n'a peut-être pas interviewé de professionnels de l'industrie de l'IA autres que des chercheurs de Google.

Par exemple, il existe diverses preuves affirmant que le modèle PaLM est un "véritable AGI". Je n'ai pas l'autorisation d'utiliser PaLM, mais dans le document publié par Google en avril, il n'a montré que des résultats significatifs dans des tests d'apprentissage sur de petits échantillons sur plusieurs tests de référence, mais pas tous. Les résultats des tests d'apprentissage sur petits échantillons de PaLM sont tout aussi robustes

Et selon le libellé du ", le nombre de benchmarks utilisés dans le test utilise la technologie "d'apprentissage par raccourcis" pour simplifier la difficulté. Atlantic Monthly", PaLM peut au moins être très fiable, très polyvalent et fiable. Précision générale pour accomplir diverses tâches.

Cependant, ni cet article ni le document d'avril de Google ne décrivent les capacités et les limites du modèle PaLM dans

Et l'affirmation de PaLM selon laquelle elle est « rationnelle » doit particulièrement être vérifiée. Des affirmations similaires de la série GPT ont été falsifiées par des initiés de l'industrie qui ont mené diverses expériences à ce sujet. si PaLM veut l'obtenir, un tel honneur mérite le même niveau de vérification contradictoire. De plus, selon les aveux de Google dans le document d'avril, le test de référence rationnel de PaLM n'est que légèrement meilleur que plusieurs modèles SOTA similaires dans l'industrie, et il n'y en a pas beaucoup. gagnants. .

Le plus important est que l'article de PaLM n'a pas été évalué par des pairs et que le modèle n'est ouvert à aucun accès externe. ou évalué. »

Le plus important est que l'article de PaLM n'a pas été évalué par des pairs et que le modèle n'est ouvert à aucun accès externe. ou évalué. »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI