Maison >Périphériques technologiques >IA >Le nouveau travail du gourou de l'apprentissage par renforcement Sergey Levine : trois grands modèles apprennent aux robots à reconnaître leur chemin

Le nouveau travail du gourou de l'apprentissage par renforcement Sergey Levine : trois grands modèles apprennent aux robots à reconnaître leur chemin

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 23:55:091543parcourir

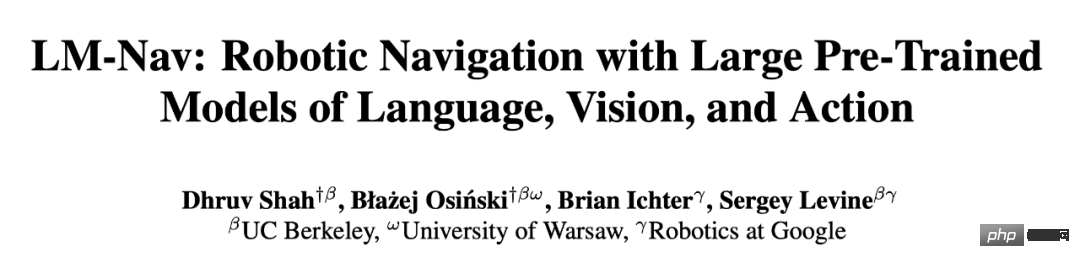

Un robot doté d'un grand modèle intégré a appris à suivre des instructions linguistiques pour atteindre sa destination sans regarder une carte. Cette réussite est issue du nouveau travail du gourou de l'apprentissage par renforcement, Sergey Levine.

Étant donné une destination, est-il difficile d'arriver avec succès sans traces de navigation ?

Cette tâche est également très difficile pour les humains ayant un mauvais sens de l'orientation. Mais dans une étude récente, plusieurs universitaires ont « enseigné » le robot en utilisant seulement trois modèles pré-entraînés.

Nous savons tous que l'un des principaux défis de l'apprentissage des robots est de permettre aux robots d'effectuer diverses tâches selon des instructions humaines de haut niveau. Cela nécessite des robots capables de comprendre les instructions humaines et d’être équipés d’un grand nombre d’actions différentes pour exécuter ces instructions dans le monde réel.

Pour l'instruction suite aux tâches de navigation, les travaux antérieurs se sont principalement concentrés sur l'apprentissage à partir de trajectoires annotées d'instructions textuelles. Cela peut permettre de comprendre des instructions textuelles, mais le coût de l'annotation des données a entravé l'utilisation généralisée de cette technique. D’un autre côté, des travaux récents ont montré que la formation auto-supervisée de politiques conditionnées par des objectifs peut permettre d’acquérir une navigation robuste. Ces méthodes entraînent des contrôleurs basés sur la vision sur de grands ensembles de données non étiquetés par réétiquetage post-hoc. Ces méthodes sont évolutives, générales et robustes, mais nécessitent souvent l’utilisation de mécanismes fastidieux de spécification de cible basés sur la localisation ou l’image.

Dans un dernier article, des chercheurs de l'UC Berkeley, de Google et d'autres institutions visent à combiner les avantages de ces deux méthodes pour créer un système auto-supervisé de navigation robot applicable aux données de navigation sans aucune annotation de l'utilisateur, en utilisant une pré-formation. du modèle pour exécuter des instructions en langage naturel. Les chercheurs utilisent ces modèles pour construire une « interface » qui communique les tâches au robot. Ce système exploite les capacités de généralisation des modèles de langage pré-entraînés et de langage de vision pour permettre aux systèmes robotiques d'accepter des instructions complexes de haut niveau.

- Lien papier : https://arxiv.org/pdf/2207.04429.pdf

- Lien code : https://github.com/blazejosinski/lm_nav

Le chercheur a observé , des interfaces peuvent être créées en tirant parti de modèles pré-entraînés disponibles dans le commerce, formés sur de vastes corpus d'ensembles de données visuelles et linguistiques largement disponibles et qui ont montré des capacités de généralisation sans tir pour permettre le suivi d'instructions spécifiques. Pour y parvenir, les chercheurs ont combiné les avantages des modèles pré-entraînés indépendants des robots en matière de vision et de langage ainsi que des modèles de navigation pré-entraînés. Plus précisément, ils ont utilisé un modèle de navigation visuelle (VNM : ViNG) pour créer la sortie visuelle d'un robot dans une « carte mentale » topologique de l'environnement. Étant donné une instruction textuelle de forme libre, un grand modèle de langage pré-entraîné (LLM : GPT-3) est utilisé pour décoder l'instruction en une série de points caractéristiques de forme textuelle. Ensuite, un modèle de langage visuel (VLM : CLIP) est utilisé pour établir ces points caractéristiques du texte dans la carte topologique en déduisant la vraisemblance conjointe des points caractéristiques et des nœuds. Un nouvel algorithme de recherche est ensuite utilisé pour maximiser la fonction objectif probabiliste et trouver le chemin d'instruction du robot, qui est ensuite exécuté par le VNM. L'apport principal de la recherche est la méthode de navigation sous modèles à grande échelle (LM Nav), un système de suivi d'instructions spécifique. Il combine trois grands modèles indépendants pré-entraînés : un modèle de contrôle de robot auto-supervisé qui exploite les observations visuelles et les actions physiques (VNM), un modèle de langage visuel qui place les images dans le texte mais sans environnement de mise en œuvre concret (VLM) et un grand modèle de langage capable d'analyser et de traduire du texte, mais n'ayant aucune base visuelle ni sens incarné (LLM) pour permettre le suivi des instructions à long terme dans des environnements réels complexes. Pour la première fois, les chercheurs ont instancié l'idée de combiner des modèles de vision et de langage pré-entraînés avec des contrôleurs conditionnels à la cible pour dériver des chemins d'instructions exploitables dans l'environnement cible sans aucun réglage précis. Notamment, les trois modèles sont formés sur des ensembles de données à grande échelle, disposent de fonctions objectives auto-supervisées et sont utilisés immédiatement sans réglage fin - la formation de LM Nav ne nécessite pas d'annotation humaine des données de navigation du robot.

Des expériences montrent que LM Nav est capable de suivre avec succès des instructions en langage naturel dans un nouvel environnement tout en utilisant des commandes précises pour éliminer l'ambiguïté du chemin lors d'une navigation suburbaine complexe de 100 mètres.

Aperçu du modèle LM-Nav

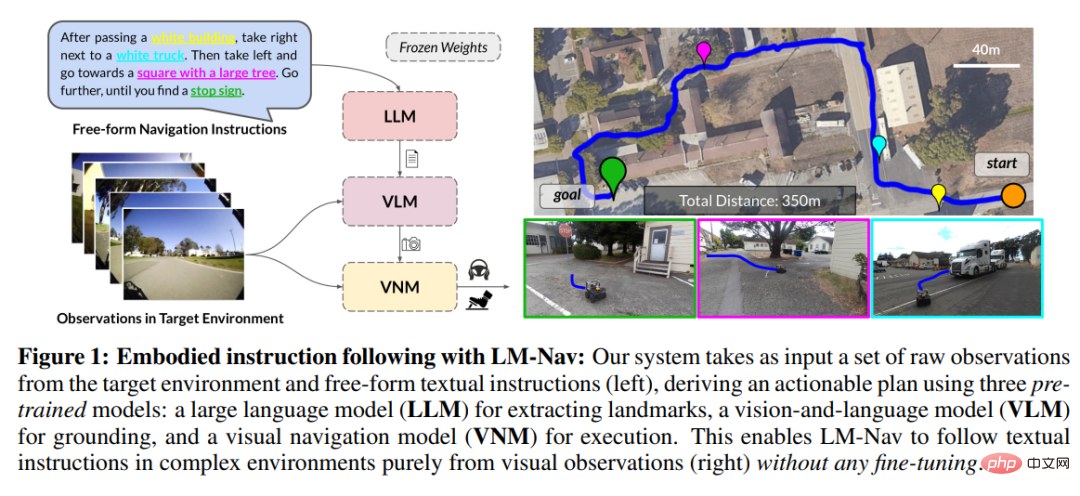

Alors, comment les chercheurs utilisent-ils des modèles d'images et de langage pré-entraînés pour fournir des interfaces texte pour les modèles de navigation visuelle ?

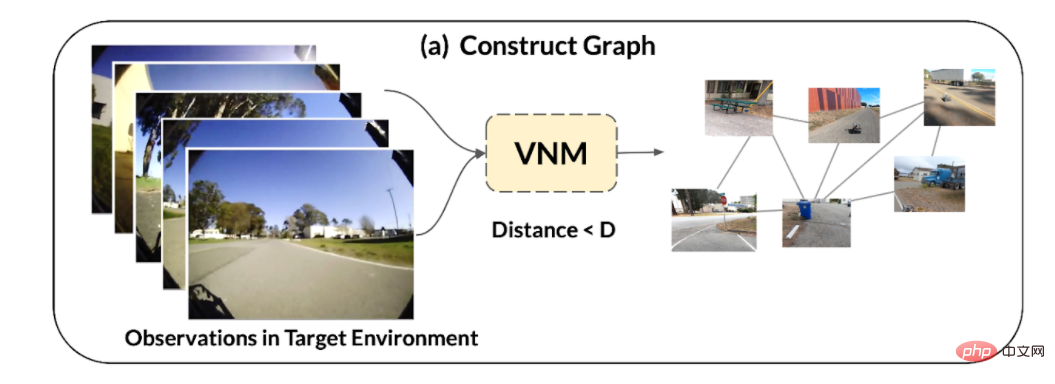

1. Étant donné un ensemble d'observations dans l'environnement cible, utilise la fonction de distance conditionnelle cible, qui fait partie du modèle de navigation visuelle (VNM), pour déduire la connectivité entre elles et construire la topologie de l'environnement. schéma de connectivité.

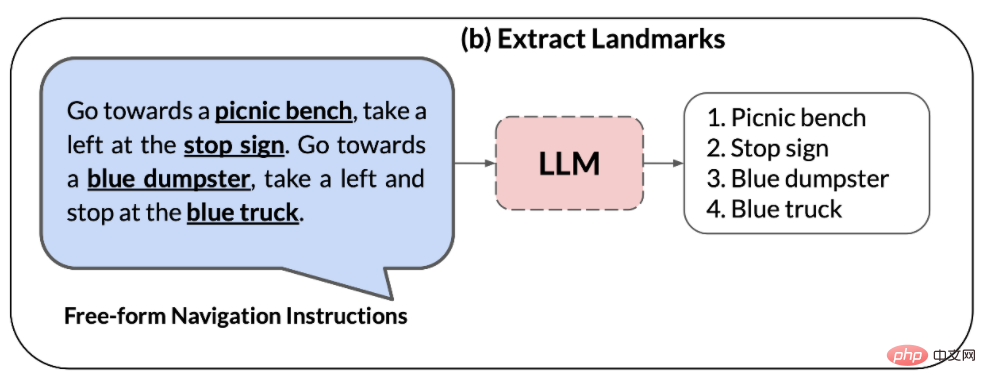

2. Le grand modèle de langage (LLM) est utilisé pour analyser les instructions en langage naturel en une série de points caractéristiques, Ces points caractéristiques peuvent être utilisés comme sous-objectifs intermédiaires pour la navigation.

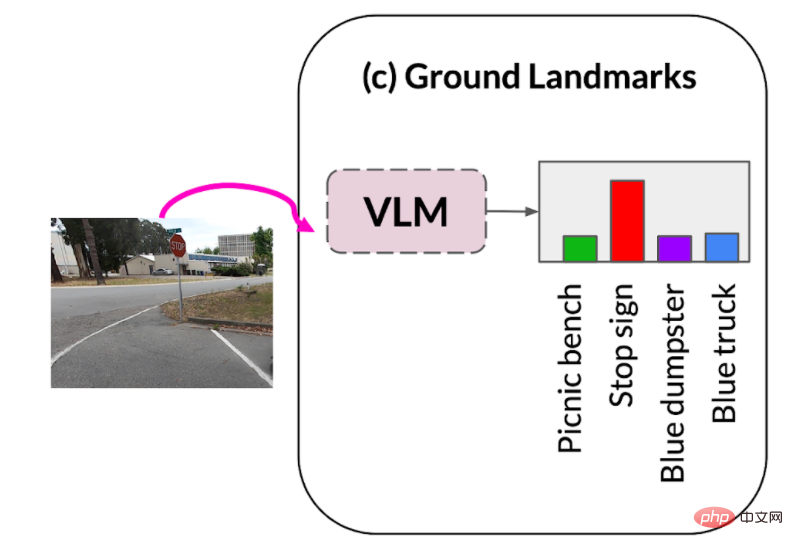

3. Le modèle de langage visuel (VLM) est utilisé pour créer des observations visuelles basées sur des phrases de points caractéristiques. Le modèle de langage visuel déduit une distribution de probabilité conjointe sur les descriptions de points caractéristiques et les images (formant les nœuds dans le graphique ci-dessus).

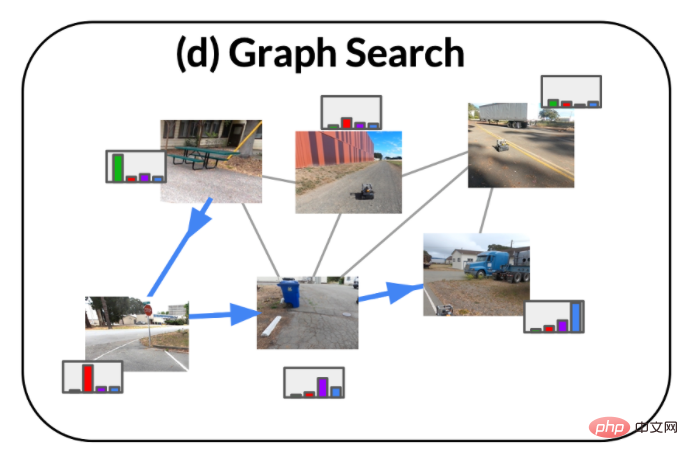

4. En utilisant la distribution de probabilité de VLM et la connectivité graphique déduite par VNM, adopte un nouvel algorithme de recherche pour récupérer un chemin d'instruction optimal dans l'environnement, lequel chemin d'instruction (i) satisfait à l'original instruction, (ii) est le chemin le plus court dans le graphique qui peut atteindre l’objectif.

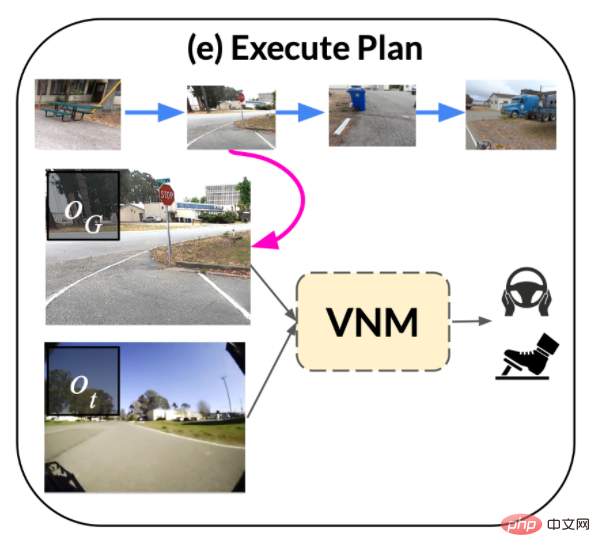

5. Ensuite, Le chemin d'instruction est exécuté par la politique conditionnelle cible, qui fait partie du VNM.

Résultats expérimentaux

Évaluation qualitative

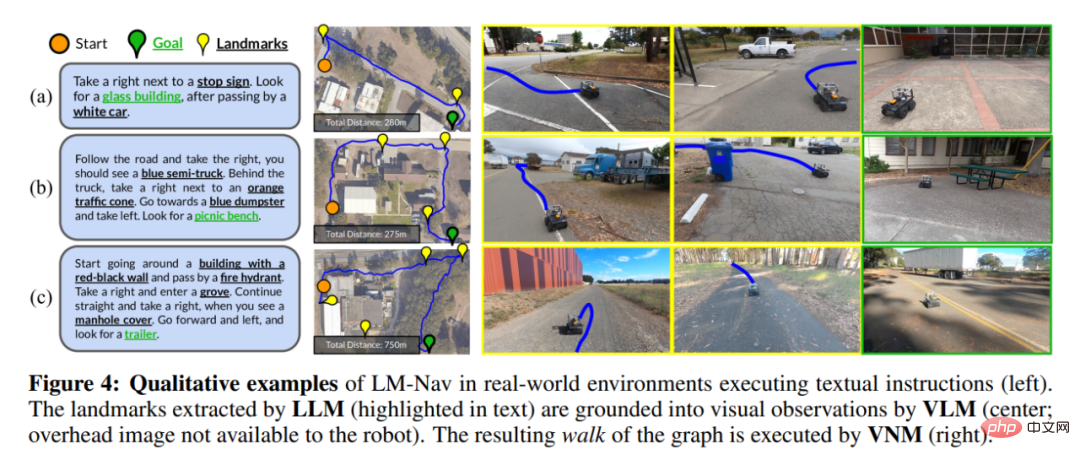

La figure 4 montre quelques exemples du chemin emprunté par le robot (à noter que le robot ne peut pas obtenir l'image au-dessus de la tête et le positionnement spatial des points caractéristiques, ce qui est montré n'est qu'un effet visuel).

Dans la figure 4(a), LM-Nav est capable de localiser avec succès des points caractéristiques simples de ses traversées précédentes et de trouver un court chemin vers l'objectif. Bien qu'il existe plusieurs points caractéristiques de stationnement dans l'environnement, la fonction objectif de l'équation 3 permet au robot de sélectionner le point caractéristique de stationnement correct dans le contexte, minimisant ainsi la distance de déplacement globale.

La figure 4(b) met en évidence la capacité de LM-Nav à analyser des itinéraires spécifiés avec plusieurs points caractéristiques : même si atteindre directement le dernier point caractéristique est l'itinéraire le plus court en ignorant le chemin d'instruction, le robot peut toujours trouver un chemin A qui visite tous les points caractéristiques dans le bon ordre.

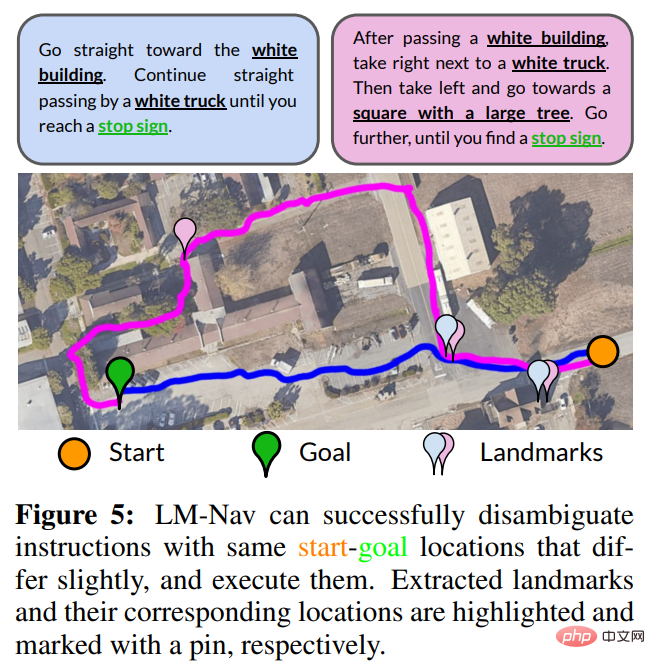

Utilisez des directives pour lever l'ambiguïté. Puisque le but de LM Nav est de suivre des instructions, et pas seulement d'atteindre l'objectif final, différentes instructions peuvent entraîner des traversées différentes. La figure 5 montre un exemple dans lequel la modification des instructions peut lever l'ambiguïté sur plusieurs chemins vers un objectif. Pour les invites plus courtes (bleues), LM Nav préfère le chemin le plus direct. Lors de la spécification d'un itinéraire plus fin (magenta), LM Nav emprunte des chemins alternatifs à travers différents ensembles de points caractéristiques.

La situation des points caractéristiques manquants. Bien que LM-Nav puisse analyser efficacement les points caractéristiques dans les instructions, les localiser sur le graphique et trouver le chemin vers l'objectif, ce processus repose sur l'hypothèse que les points caractéristiques (i) existent dans l'environnement réel et (ii) peuvent être reconnu par VLM. La figure 4(c) montre une situation dans laquelle le chemin exécutable ne parvient pas à visiter l'un des points caractéristiques (une bouche d'incendie) et emprunte un chemin autour du haut du bâtiment au lieu du bas. Ce cas de panne était dû à l'incapacité du VLM à détecter les bouches d'incendie à partir des observations du robot.

Dans une évaluation indépendante de l'efficacité du VLM dans la récupération des points caractéristiques, les chercheurs ont découvert que bien qu'il s'agisse du meilleur modèle standard pour ce type de tâche, CLIP est incapable de récupérer un petit nombre de points caractéristiques « durs ». , y compris les bouches d'incendie et les bétonnières. Mais dans de nombreuses situations réelles, le robot peut toujours trouver un chemin pour visiter les points caractéristiques restants.

Évaluation quantitative

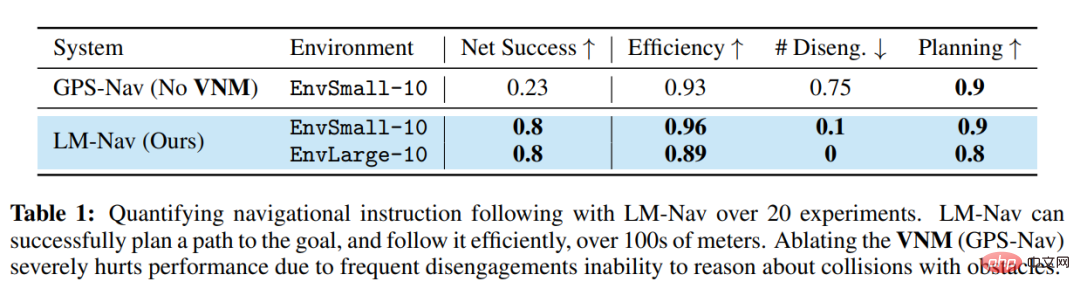

Le tableau 1 résume les performances quantitatives de ce système en 20 instructions. Dans 85 % des expérimentations, LM-Nav a pu suivre systématiquement les instructions sans collision ni détachement (en moyenne une intervention tous les 6,4 kilomètres de trajet). Par rapport au modèle de base sans navigation, LM-Nav fonctionne systématiquement mieux dans l'exécution de trajectoires cibles efficaces et sans collision. Dans toutes les expériences infructueuses, l’échec peut être attribué à des capacités insuffisantes lors de la phase de planification – l’incapacité de l’algorithme de recherche à localiser intuitivement certains points caractéristiques « durs » dans le graphique – entraînant une exécution incomplète des instructions. Une enquête sur ces modes de défaillance a révélé que la partie la plus critique du système est la capacité du VLM à détecter des points caractéristiques inconnus, tels que des bouches d'incendie, et des scènes dans des conditions d'éclairage difficiles, telles que des images sous-exposées.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI