Maison >Périphériques technologiques >IA >Une revue historique de 30 ans, Jeff Dean : Nous avons compilé une revue de recherche sur les « modèles experts clairsemés »

Une revue historique de 30 ans, Jeff Dean : Nous avons compilé une revue de recherche sur les « modèles experts clairsemés »

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 23:01:041531parcourir

Le modèle expert clairsemé est un concept vieux de 30 ans qui est encore largement utilisé aujourd'hui et constitue une architecture populaire dans le deep learning. Ces architectures incluent des systèmes experts hybrides (MoE), des transformateurs de commutation, des réseaux de routage, des couches BASE, etc. Les modèles experts clairsemés ont démontré de bonnes performances dans de nombreux domaines tels que le traitement du langage naturel, la vision par ordinateur et la reconnaissance vocale.

Récemment, Jeff Dean, leader de l'IA de Google, et d'autres ont rédigé une revue des modèles experts clairsemés, examinant le concept de modèles experts clairsemés, fournissant une description de base des algorithmes généraux et attendant enfin avec impatience les futures orientations de recherche.

Adresse papier : https://arxiv.org/pdf/2209.01667.pdf

En augmentant le budget de calcul, les données de formation et la taille du modèle, l'apprentissage automatique (en particulier le langage naturel) a fait des progrès significatifs. Les modèles de langage d'étape bien connus incluent GPT-2 (Radford et al., 2018), BERT (Devlin et al., 2018), T5 (Raffel et al., 2019), GPT-3 (Brown et al., 2020) , Gopher (Rae et al., 2021), Chinchilla (Hoffmann et al., 2022) et PaLM (Chowdhery et al., 2022).

Cependant, les modèles de pointe nécessitent désormais des milliers d'accélérateurs dédiés interconnectés et prennent des semaines ou des mois à s'entraîner, ce qui rend ces modèles coûteux à produire (Patterson et al., 2021). À mesure que les systèmes d’apprentissage automatique évoluent, le domaine recherche des paradigmes de formation et de service plus efficaces. Des modèles experts clairsemés sont apparus comme une solution prometteuse.

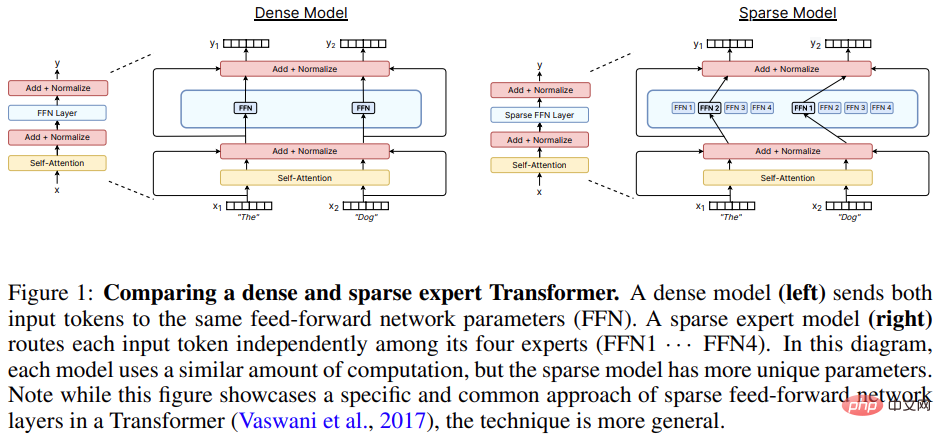

Un modèle expert clairsemé (dont les systèmes experts mixtes (MoE) sont la variante la plus populaire) est un type particulier de réseau neuronal dans lequel un ensemble de paramètres est divisé en « experts » et chaque « expert » A un poids unique.

Pendant la formation et l'inférence, le modèle attribue des échantillons d'entrée à des poids experts spécifiques, permettant à chaque échantillon d'interagir avec seulement un sous-ensemble des paramètres du réseau, contrairement aux méthodes conventionnelles qui utilisent l'intégralité du réseau pour chaque entrée. Étant donné que seul un petit nombre d’experts est utilisé pour chaque échantillon, l’effort de calcul est considérablement réduit par rapport au modèle total.

De nombreux modèles experts clairsemés modernes s'inspirent de Shazeer et al. La recherche a formé le plus grand modèle de l’époque et a obtenu des résultats de pointe en matière de modélisation linguistique et de traduction. La popularité des modèles experts clairsemés a encore augmenté lorsqu'ils sont utilisés conjointement avec les modèles de langage Transformer (Lepikhin et al., 2020 ; Fedus et al., 2021). Bien que la plupart des travaux portent sur le traitement du langage naturel, des modèles experts clairsemés ont également été utilisés avec succès dans divers domaines, notamment la vision par ordinateur (Puigcerver et al., 2020), la reconnaissance vocale (You et al., 2021) et l'apprentissage multimodal. (Mustafa et al., 2022). Clark et al. (2022) ont étudié les propriétés de mise à l'échelle de modèles experts clairsemés sous différentes tailles de modèle et nombre d'experts. De plus, les résultats de pointe sur de nombreux benchmarks sont actuellement détenus par des modèles experts clairsemés tels que ST-MoE (Zoph et al., 2022). Ce domaine évolue rapidement avec les progrès de la recherche et de l’ingénierie.

Cet article de synthèse restreint la portée de l'enquête à des modèles experts clairsemés dans l'ère étroite de l'apprentissage profond (à partir de 2012), passe en revue les progrès récents et discute des pistes futures prometteuses.

Sparse Expert Model

Le concept de MoE dans l'apprentissage automatique remonte à il y a au moins 30 ans. Dans les premiers concepts, les experts définissaient un réseau neuronal complet, et MoE était similaire à une méthode d'ensemble.

Eigen et al. (2013) ont proposé d'utiliser une architecture hybride experte en couches empilées sur MNIST instable. Ce travail a jeté les bases de la mise en œuvre efficace des modèles ultérieurs.

Shazeer et al. (2017) ont proposé d'insérer une couche MoE entre deux couches LSTM, et le modèle clairsemé résultant a atteint les performances SOTA en traduction automatique. Cependant, bien que cette méthode ait été couronnée de succès, les recherches ultérieures ont été comme une hibernation et ont stagné, et la plupart des recherches se sont tournées vers Transformer.

Entre 2020 et 2021, GShard et Switch Transformer ont été lancés, qui ont tous deux remplacé la couche feed-forward dans Transformer par une couche experte.

Bien que l'approche consistant à utiliser une couche d'experts soit devenue le paradigme dominant, la recherche des deux dernières années a revisité le concept de modèles experts en tant que modèles complètement indépendants pour atteindre la modularité et la composabilité.

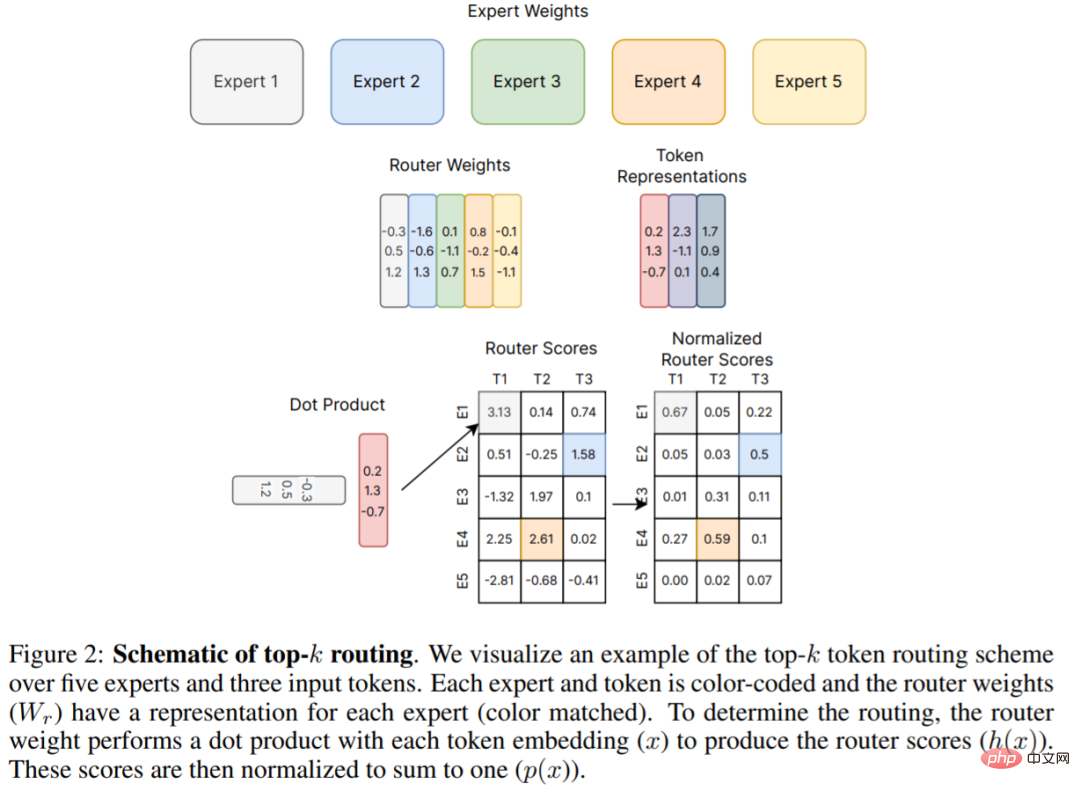

La figure 2 ci-dessous est le mécanisme de routage top-k original proposé par Shazeer et al (2017), qui constitue la base de nombreux travaux ultérieurs. Cet article de synthèse explique en détail les nouveaux développements dans les algorithmes de routage au chapitre 4.

Matériel

Des modèles experts clairsemés modernes ont été co-conçus avec des systèmes distribués pour former les plus grands réseaux de neurones.

La recherche sur les grands réseaux de neurones (Brown et al., 2020 ; Rae et al., 2021 ; Chowdhery et al., 2022) montre que les réseaux de neurones ont largement dépassé la capacité de mémoire d'un seul accélérateur, donc les poids, l'activation fonctions, les tenseurs tels que les variables d'optimisation nécessitent un partitionnement à l'aide de diverses stratégies parallèles.

Trois méthodes parallèles courantes incluent : le parallélisme des données (copie des poids du modèle, partitionnement des données), le parallélisme du modèle tenseur (les tenseurs de données et de poids sont partagés entre les appareils) et le parallélisme du pipeline (des couches entières ou des groupes de couches sont partagés entre les appareils), les modèles experts hybrides sont souvent capables de s’adapter à ces scénarios parallèles.

En termes de formation et de déploiement du modèle MoE, Jaszczur et al. (2021) ont fragmenté toutes les couches du modèle Transformer, obtenant ainsi 37 fois l'accélération de l'inférence. Kossmann et al. bibliothèque Le problème de contrainte de taille de lot expert statique est résolu.

En plus du parallélisme des données, du parallélisme des modèles et du parallélisme expert, Rajbhandari et al. (2022) ont proposé la bibliothèque DeepSpeed-MoE pour prendre en charge le partitionnement ZeRO et ZeRO-Offload, permettant une amélioration de l'inférence 10x et des performances de traduction SOTA, augmentant ainsi le la praticité du modèle dans les services de production est démontrée.

Propriétés de mise à l'échelle des modèles experts clairsemés

La perte d'entropie croisée des modèles de langage neuronal dense se comporte comme une loi de puissance en ce qui concerne le nombre de paramètres du modèle, le volume de données et le budget de calcul (Kaplan et al., 2020). Les coefficients de la loi de puissance ont ensuite été corrigés dans Hoffmann et al. (2022), ce qui suggère que le calcul du modèle optimal nécessite un équilibre plus étroit entre l'expansion des données et des paramètres. En revanche, les premières études de modèles experts clairsemés qui se développaient de manière heuristique ont obtenu de solides résultats empiriques mais n'ont pas décrit soigneusement les lois d'expansion. De plus, certains travaux ont mis en évidence les différences entre les actions en amont (par exemple la pré-formation) et en aval (par exemple le réglage fin) (Fedus et al., 2021 ; Artetxe et al., 2021), compliquant encore davantage la compréhension des modèles experts clairsemés.

Extensions amont

Les modèles experts clairsemés fonctionnent bien lorsqu'ils sont formés sur de grands ensembles de données. Un modèle courant dans le traitement du langage naturel consiste à effectuer une formation en amont (par exemple, une pré-formation) suivie d'une formation en aval (par exemple, un réglage fin) sur une distribution de données spécifique d'intérêt. Au stade amont, les modèles experts clairsemés génèrent systématiquement des gains plus élevés que les modèles homologues denses. Shazeer et al. (2017) ont proposé des courbes d'échelle en ce qui concerne les paramètres du modèle et le budget de calcul sur la référence de modélisation linguistique d'un milliard de mots (Chelba et al., 2013), réalisant des gains significatifs par rapport à la version dense. Lepikhin et al. (2020) ont proposé une version améliorée de la fonction d'expansion du modèle et ont obtenu un gain de score BLEU de 13,5 sur leur plus grand modèle clairsemé à paramètres 600B. Switch Transformer (Fedus et al., 2021) a mesuré une accélération du temps de mur de 4 à 7 fois sur le modèle T5 en utilisant les mêmes ressources informatiques. Les travaux ont également étudié la mise à l'échelle de la perte d'entropie croisée en fonction du nombre de paramètres, mais ont observé que les gains diminuaient au-delà de 256 experts.

Expansion aval

Cependant, une mise à l'échelle fiable en amont n'a pas immédiatement généré des gains cohérents sur les tâches en aval. Dans un travail mettant en évidence les défis du transfert, Fedus et al. ne s'ajuste pas bien aux tâches d'inférence intensives telles que SuperGLUE. Cette découverte laisse entrevoir des recherches supplémentaires nécessaires et l'équilibre entre les calculs et les paramètres qui peuvent être nécessaires.

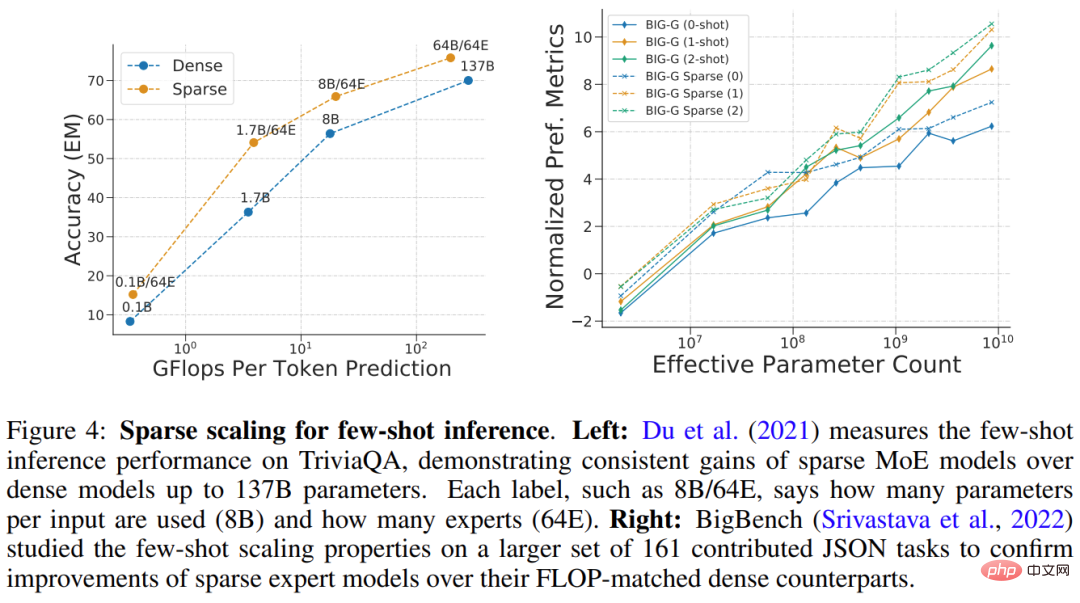

Du et al. (2021) ont démontré une extension du modèle GLaM clairsemé allant de 1B à 64B FLOP en utilisant 64 experts par couche clairsemée. GLaM a obtenu des résultats SOTA, surpassant le modèle GPT-3 à paramètre 175B (Brown et al., 2020) en termes de performances zéro et unique. Dans le même temps, le FLOP utilisé par chaque jeton lors de l'inférence a été réduit de 49. %. La consommation a été réduite de 65 % (comme le montre la figure 4 (à gauche) ci-dessous). La figure 4 ci-dessous (à droite) est un autre exemple de modèle clairsemé fonctionnant bien sur l'inférence à quelques coups.

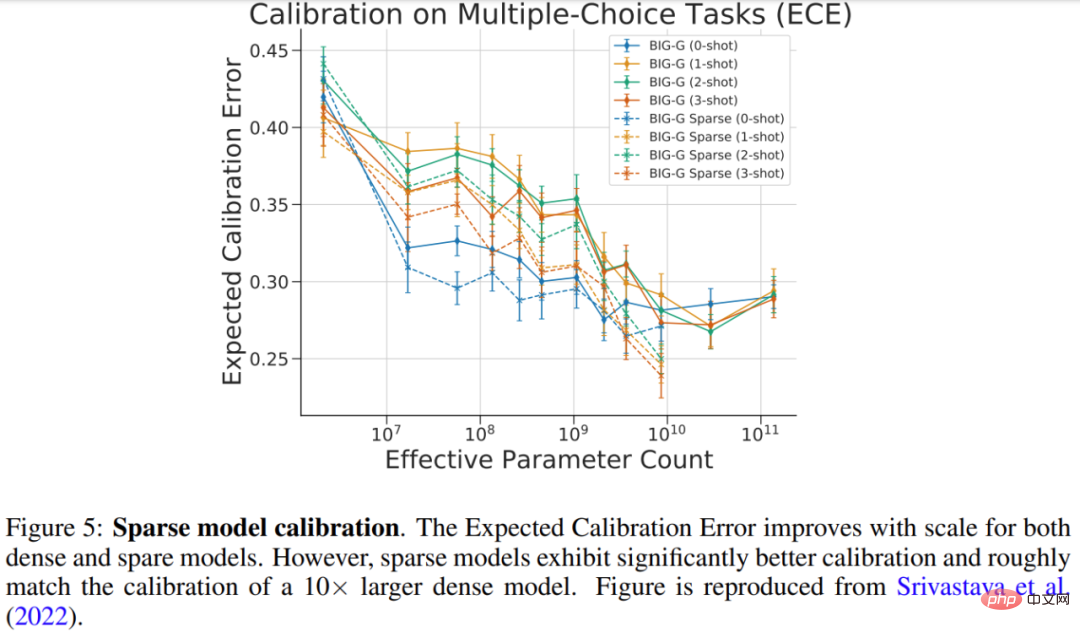

Srivastava et al. (2022) ont étudié l'étalonnage de modèles clairsemés sur la tâche BIG-Bench à choix multiples, qui mesure dans quelle mesure la probabilité prédite correspond à la probabilité correcte. Les résultats de l'étude sont présentés dans la figure 5 ci-dessous, et bien que l'étalonnage se soit amélioré pour les modèles denses et clairsemés plus grands, l'étalonnage du modèle clairsemé était comparable à celui du modèle dense utilisant 10 fois plus de FLOP.

Agrandissez le nombre, la taille et la fréquence des couches expertes

Il existe plusieurs hyperparamètres importants qui contrôlent l'expansion des modèles experts clairsemés, notamment : 1) le nombre d'experts, 2) le nombre d'experts par taille d'expert, et 3) fréquence des niveaux d'experts. Ces décisions peuvent avoir des impacts significatifs sur l’expansion en amont et en aval.

De nombreux premiers travaux s'étendaient à des milliers d'experts relativement petits par couche, ce qui se traduisait par une excellente qualité de pré-formation et de traduction (Shazeer et al., 2017 ; Lepikhin et al., 2020 ; Fedus et al., 2021). Cependant, la qualité des modèles clairsemés se dégrade de manière disproportionnée lors du changement de domaine (Artetxe et al., 2021) ou de l'ajustement fin pour différentes répartitions de tâches (Fedus et al., 2021). Pour obtenir un meilleur équilibre entre calculs et paramètres, les modèles clairsemés SOTA pour l'inférence en quelques coups (GLaM (Du et al., 2021)) et le réglage fin (ST-MoE (Zoph et al., 2022)) ne peuvent être utilisés que au maximum 64 grands experts. En raison de la dimension experte accrue, ces modèles nécessitent des stratégies de partitionnement spécifiques au niveau du système pour que les accélérateurs fonctionnent efficacement (Du et al., 2021 ; Rajbhandari et al., 2022).

Algorithme de routage

L'algorithme de routage est une caractéristique clé de toutes les architectures expertes clairsemées et détermine où envoyer les échantillons. Ce domaine a été largement étudié, y compris des approches contre-intuitives utilisant des modèles de routage fixes et non appris (Roller et al., 2021). Étant donné que des décisions discrètes sont prises quant aux experts à sélectionner, les décisions d'acheminement sont souvent non différenciables.

Le problème de sélection d'experts a ensuite été redéfini comme le problème de Bandit, et certains travaux ont utilisé l'apprentissage par renforcement pour apprendre la sélection d'experts (Bengio et al., 2016 ; Rosenbaum et al., 2017 ; 2019 ; Clark et al. , 2022 ). Shazeer et al. (2017) ont proposé un algorithme heuristique différentiable pour contourner les difficultés de l'apprentissage par renforcement.

Cet article développe la classification des algorithmes de routage et explique plus en détail le problème clé dans ce domaine : l'équilibrage de charge.

Le développement rapide des modèles experts clairsemés

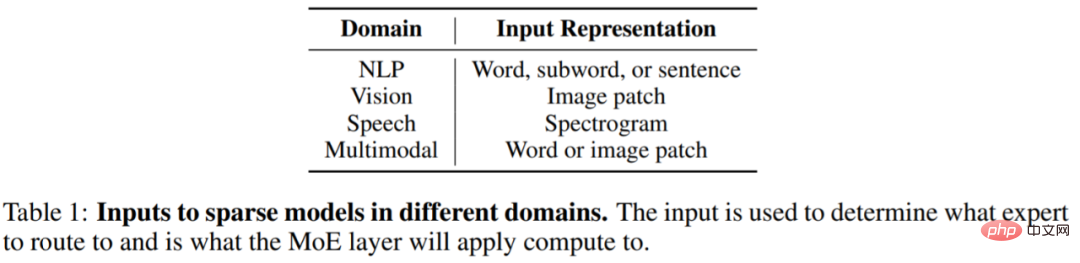

L'influence des modèles experts clairsemés s'étend rapidement à d'autres domaines au-delà de la PNL, notamment la vision par ordinateur, la reconnaissance vocale et les applications multimodales. Bien que les domaines soient différents, l'architecture et l'algorithme du modèle sont à peu près les mêmes, et le tableau 1 ci-dessous montre la représentation d'entrée de couche clairsemée pour différents domaines.

Les modèles experts clairsemés se sont développés très rapidement ces dernières années. Prenant comme exemple le domaine du NLP, Shazeer et al. (2017) ont introduit des couches expertes hybrides pour la modélisation du langage LSTM et la traduction automatique, qui sont insérées entre les couches standard du modèle LSTM.

En 2020, Lepikhin et al. (2020) ont introduit pour la première fois la couche MoE dans Transformer. Lorsque les chercheurs ont étendu chaque couche d'experts à 2 048 experts, le modèle a obtenu des résultats de traduction SOTA dans 100 langues différentes.

Fedus et al. (2021) ont créé un modèle de langage de paramètres 1,6T clairsemé atteignant la qualité de pré-entraînement SOTA.

De nouvelles recherches stimulent le développement d'inférences d'apprentissage en quelques étapes et de critères de réglage précis. Du et al. (2021) ont formé un modèle de langage de décodage MoE pur, obtenant des résultats SOTA sur de petits échantillons et ne nécessitant que 1/3 du calcul requis pour former GPT-3. Zoph et al. (2022) ont proposé ST-MoE, un modèle d'encodeur-décodeur clairsemé qui réalise SOTA sur un large éventail de tâches d'inférence et de génération. Lorsqu'il est affiné sur SuperGLUE, ST-MoE surpasse PaLM-540B tout en utilisant seulement environ 1/20ème des FLOP de pré-entraînement et 1/40ème des FLOP d'inférence.

Quand utiliser des modèles clairsemés

Une question courante est la suivante : si vous disposez d'un budget de calcul ou d'un FLOP fixe (par exemple, 100 GPU pendant 20 heures), quel type de modèle devez-vous entraîner pour obtenir les meilleures performances ?

Fondamentalement, les modèles clairsemés permettent d'augmenter considérablement le nombre de paramètres dans le modèle en augmentant le nombre d'experts, tout en gardant le FLOP par échantillon à peu près constant. Cette approche peut être bonne ou mauvaise, selon l’objectif du modèle.

Sparsity est bénéfique lorsque vous disposez de nombreux accélérateurs (par exemple GPU/TPU) pour transporter tous les paramètres supplémentaires liés à l'utilisation de la parcimonie.

L'utilisation de la parcimonie nécessite également un examen attentif des tâches en aval. Si vous disposez de nombreuses machines pour le pré-entraînement mais peu pour le réglage précis ou le service, la rareté (par exemple, le nombre d'experts) doit être ajustée en fonction de la quantité de mémoire disponible dans les cas d'utilisation en aval.

Dans certains cas, les modèles clairsemés semblent toujours pires que les modèles denses. Par exemple, lorsque tous les paramètres sont stockés dans la mémoire de l’accélérateur, un modèle clairsemé est inférieur à un modèle dense. Les modèles clairsemés sont idéaux lorsque vous avez la possibilité de vous entraîner ou de servir en parallèle sur plusieurs machines afin d'héberger des paramètres de modèle supplémentaires provenant d'experts.

De plus, cet article de synthèse présente également les améliorations, l'interprétabilité et les orientations de recherche futures de la formation sur modèles clairsemés. Les amis intéressés peuvent consulter l'article original pour en savoir plus sur le contenu de la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI