Maison >Périphériques technologiques >IA >Voici comment apprendre à ChatGPT à lire des images

Voici comment apprendre à ChatGPT à lire des images

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 22:58:051826parcourir

Le modèle « Wen Sheng Tu » sera populaire en 2022, qu'est-ce qui sera populaire en 2023 ?

La réponse de l’ingénieur en apprentissage automatique Daniel Bourke est : l’inverse !

Non, un nouveau modèle de « texte basé sur une image » a explosé sur Internet, et ses excellents effets ont incité de nombreux internautes à le republier et à l'aimer.

Non seulement la fonction de base « regarder des images et parler », mais aussi écrire des poèmes d'amour, expliquer des intrigues, concevoir des dialogues pour les objets en images, etc., cette IA peut tout gérer en douceur !

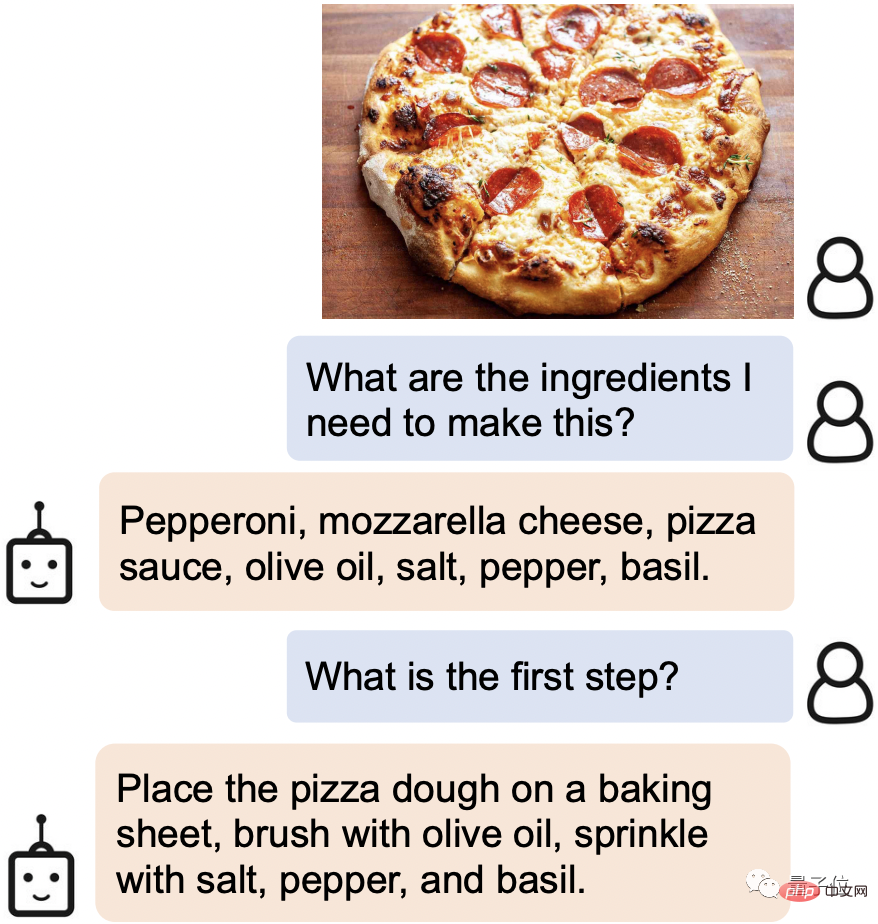

Par exemple, lorsque vous trouvez un plat alléchant en ligne, envoyez-lui simplement la photo, et il reconnaîtra immédiatement les ingrédients et les étapes de cuisson requis :

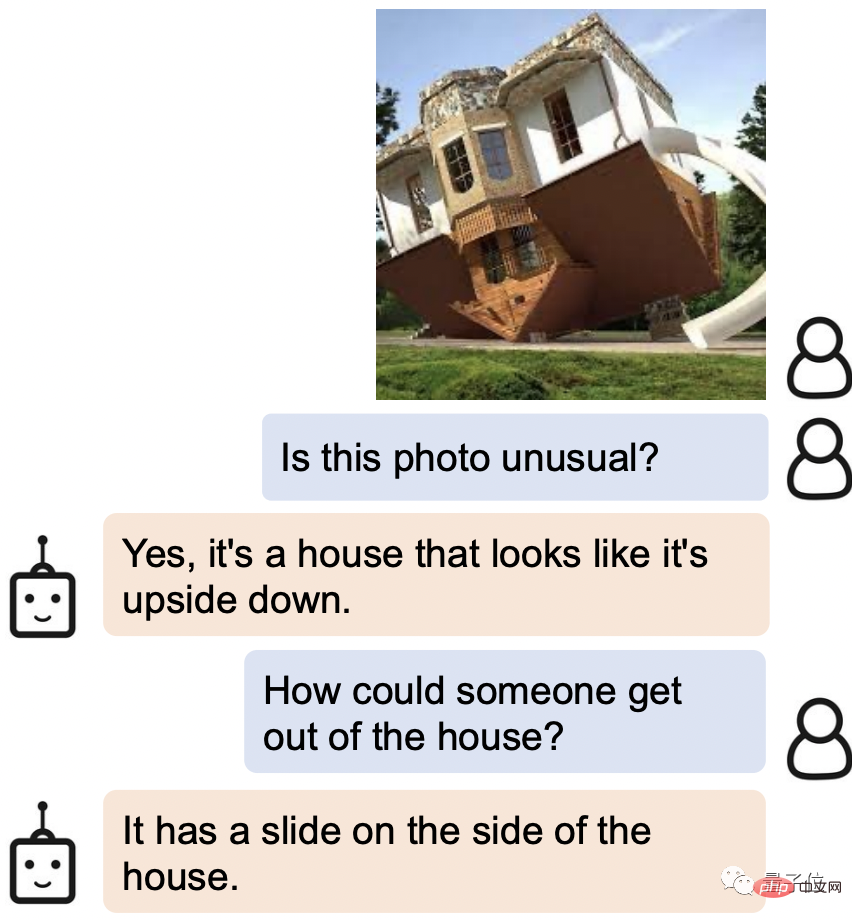

Même certains des détails de la photo de Leeuwenhoek peuvent également être "vu" clairement.

Quand on lui a demandé comment sortir de la maison à l’envers sur la photo, la réponse d’AI a été : n’y a-t-il pas un toboggan sur le côté ?

Cette nouvelle IA s'appelle BLIP-2 (Bootstrapping Language-Image Pre-training 2), et le code est actuellement open source.

La chose la plus importante est que, contrairement aux recherches précédentes, BLIP-2 utilise un cadre de pré-formation universel, il peut donc être connecté arbitrairement à votre propre modèle de langage.

Certains internautes réfléchissent déjà à la combinaison puissante après avoir changé l'interface en ChatGPT.

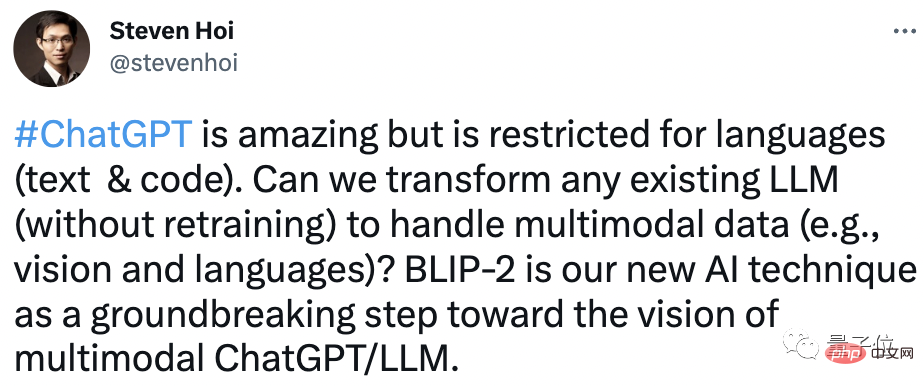

L'un des auteurs, Steven Hoi, a même déclaré : BLIP-2 sera la "version multimodale de ChatGPT" dans le futur.

Alors, quelles sont les autres choses étonnantes à propos de BLIP-2 ? Regardez en bas ensemble.

Excellente capacité de compréhension

BLIP-2 peut être considéré comme étant très diversifié dans son gameplay.

Il vous suffit de fournir une image, et vous pouvez lui parler, et elle peut répondre à diverses exigences telles que raconter des histoires, raisonner et générer un texte personnalisé.

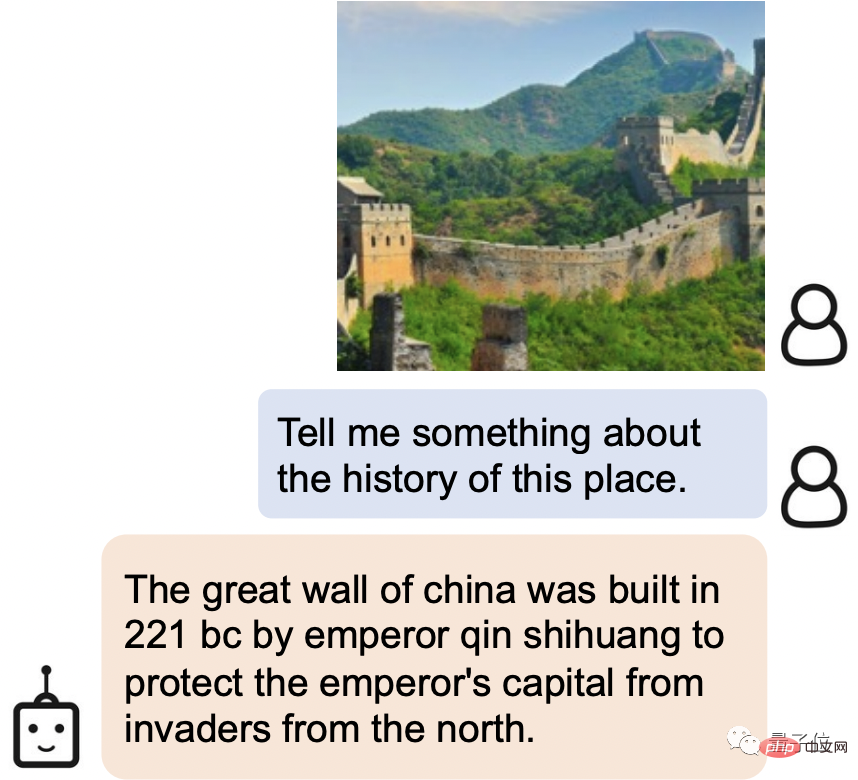

Par exemple, BLIP-2 peut non seulement identifier facilement l'endroit pittoresque de l'image comme étant la Grande Muraille, mais également présenter l'histoire de la Grande Muraille :

La Grande Muraille de Chine a été construite par Qin Shihuang en 221 avant JC pour protéger la capitale impériale de l'invasion du Nord.

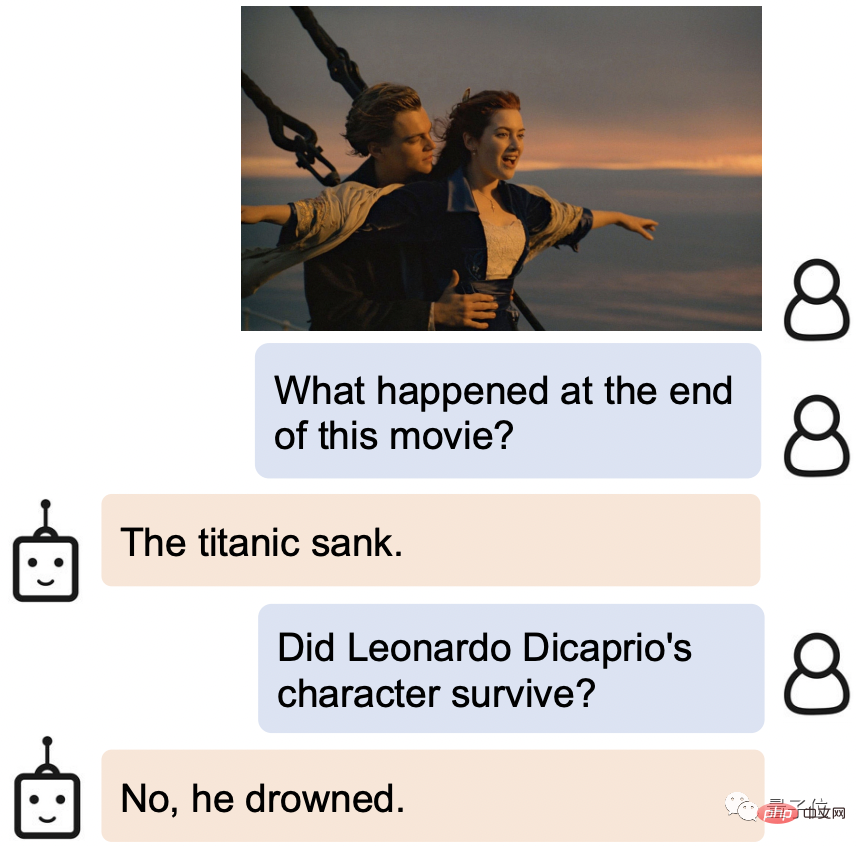

Filmez-le encore, BLIP-2 sait non seulement d'où il vient, mais connaît également la fin de l'histoire : le Titanic a coulé et le héros s'est noyé.

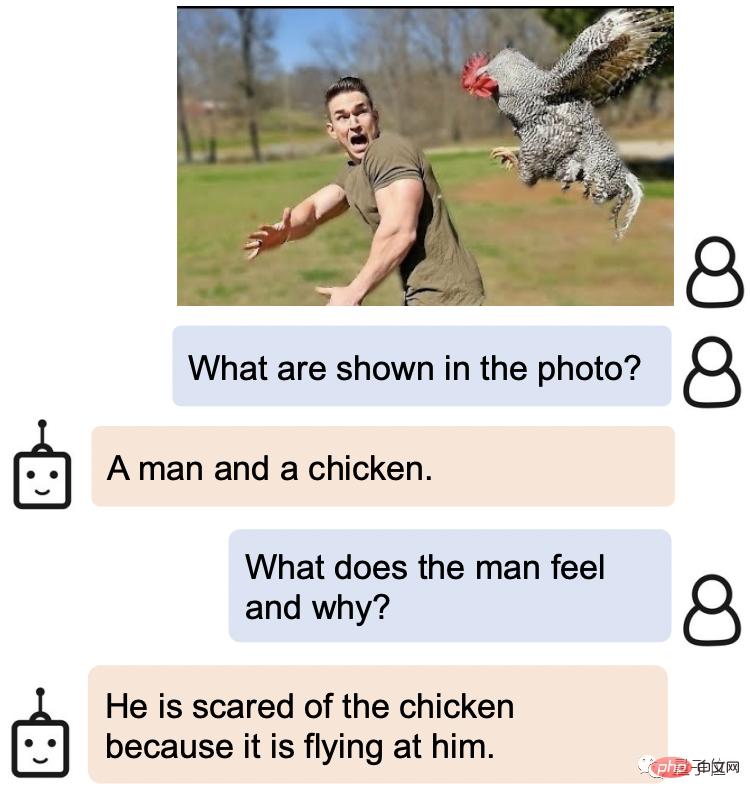

BLIP-2 saisit également très précisément l'expression humaine.

Quand on lui demande quelle est l'expression de l'homme sur cette photo et pourquoi il est comme ça, la réponse de BLIP-2 est : il a peur du poulet parce qu'il vole vers lui.

Ce qui est encore plus étonnant, c'est que BLIP-2 fonctionne également très bien sur de nombreuses questions ouvertes.

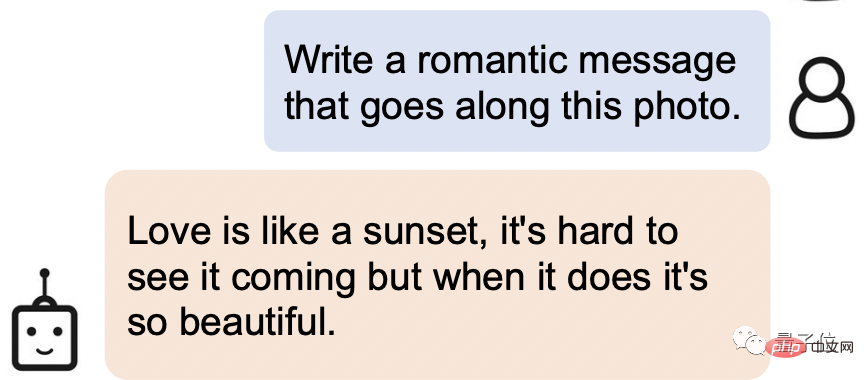

Demandez-lui d'écrire une phrase romantique basée sur l'image ci-dessous :

Voici la réponse : L'amour est comme un coucher de soleil, c'est difficile de le voir venir, mais quand ça arrive, c'est tellement beau.

Non seulement cette personne a une parfaite capacité de compréhension, mais ses connaissances littéraires sont également assez fortes !

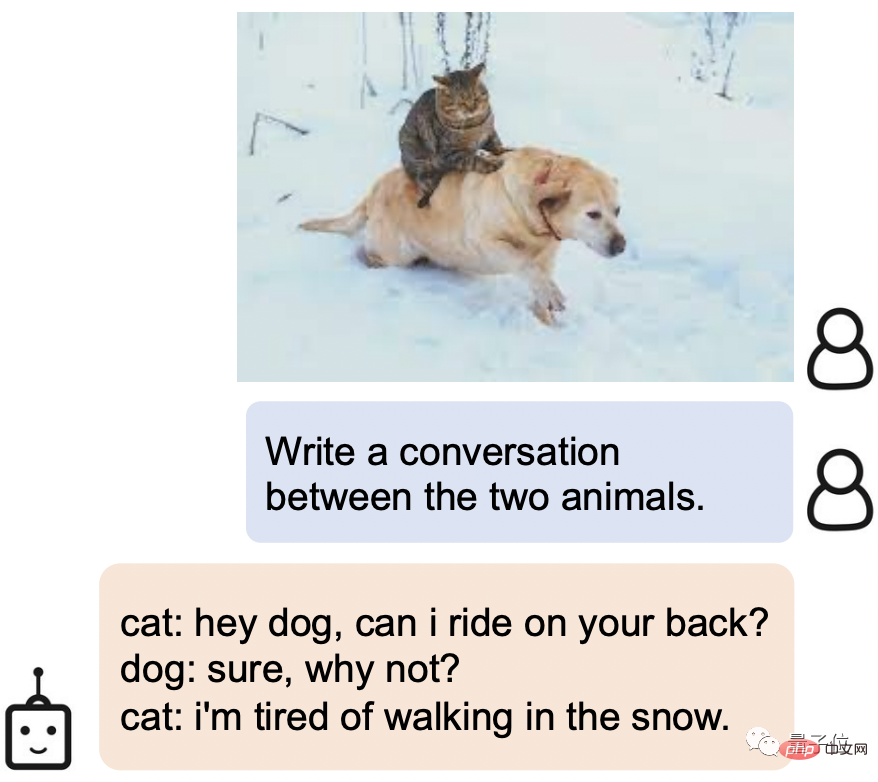

Laissez-le générer un dialogue pour les deux animaux de l'image. BLIP-2 peut également facilement gérer le paramètre chat arrogant x chien idiot :

.Chat : Hé, chien, puis-je monter sur ton dos ?

Chien : Bien sûr, pourquoi pas ?

Chat : J'en ai marre de marcher dans la neige.

Alors, comment BLIP-2 atteint-il une capacité de compréhension aussi puissante ?

Réalisez un nouveau SOTA sur plusieurs tâches de langage visuel

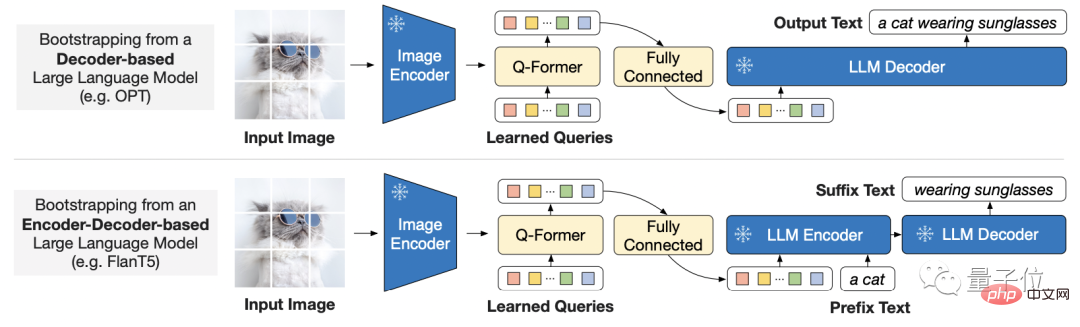

Considérant le coût croissant de la formation de bout en bout de modèles à grande échelle, BLIP-2 utilise une stratégie de pré-formation générale et efficace :

Provenant du commerce Pré-entraînement guidé du langage visuel dans des encodeurs d'images pré-entraînés gelés et de grands modèles de langage gelés.

Cela signifie également que chacun peut choisir le modèle qu'il souhaite utiliser.

Afin de combler le fossé entre les modes, le chercheur a proposé un transformateur de requête léger.

Ce Transformer est pré-entraîné en deux étapes :

La première étape amorce l'apprentissage de la représentation visuelle du langage à partir d'un encodeur d'image figé, et la deuxième étape amorce la vision d'un modèle de langage figé à l'apprentissage de la génération de langage.

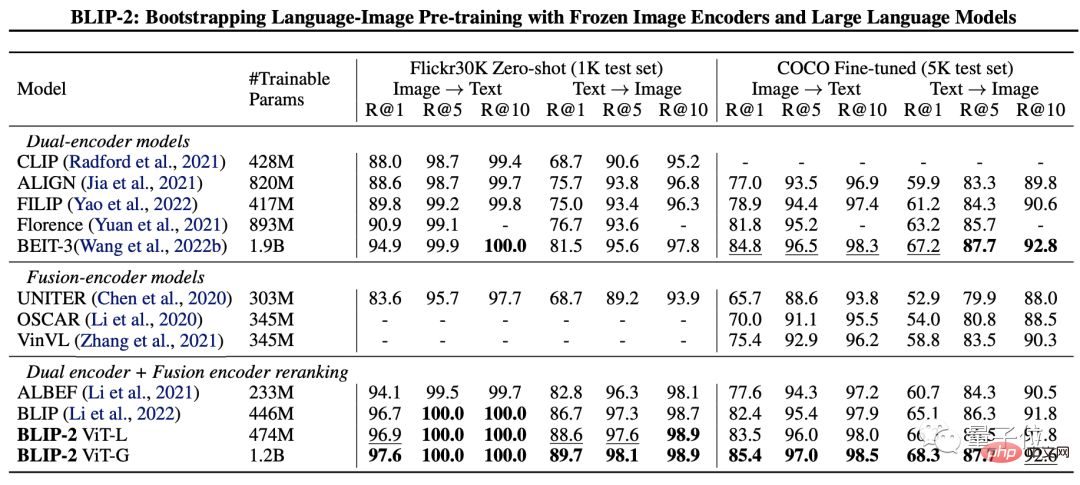

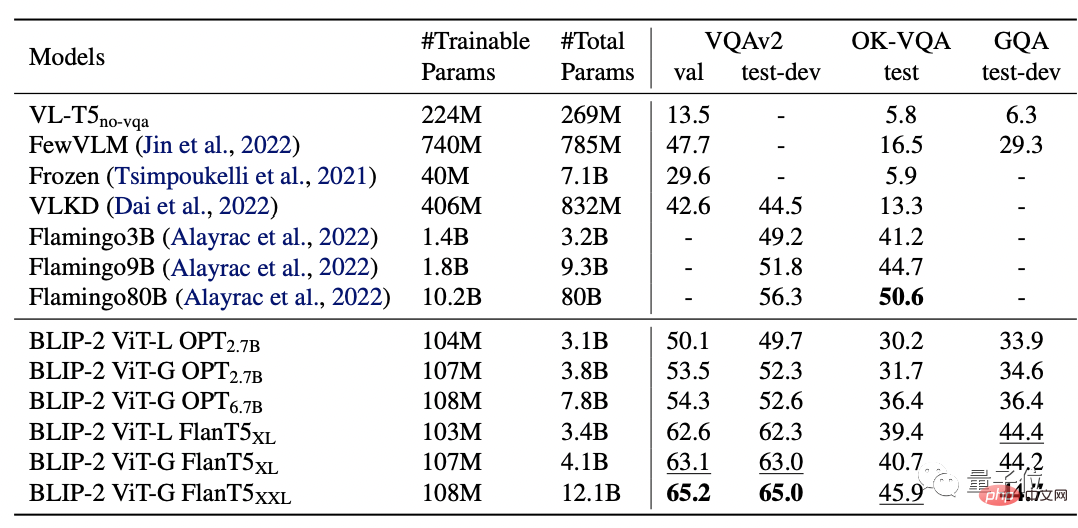

Afin de tester les performances de BLIP-2, les chercheurs l'ont évalué sur des tâches de génération de texte d'image zéro, de réponse visuelle à des questions, de récupération de texte d'image et de sous-titrage d'image.

Les résultats finaux montrent que BLIP-2 a atteint SOTA sur plusieurs tâches de langage visuel.

Parmi eux, BLIP-2 est 8,7% plus élevé que Flamingo 80B sur Zero-shot VQAv2, et les paramètres d'entraînement sont réduits de 54 fois.

Et il est évident qu’un encodeur d’image plus puissant ou un modèle de langage plus puissant donnera de meilleures performances.

Il convient de mentionner que le chercheur a également mentionné à la fin de l'article que BLIP-2 présente encore une lacune, à savoir le manque de capacité d'apprentissage du contexte :

Chaque échantillon ne contient qu'une seule image- paire de texte, il n'est actuellement pas possible d'apprendre des corrélations entre plusieurs paires image-texte en une seule séquence.

Équipe de recherche

L'équipe de recherche de BLIP-2 est issue de Salesforce Research.

Le premier auteur est Junnan Li, qui est également le premier auteur de BLIP lancé il y a un an.

Actuellement, il est chercheur scientifique principal au Salesforce Asia Research Institute. Diplômé de l'Université de Hong Kong avec un baccalauréat et un doctorat de l'Université nationale de Singapour.

Le champ de recherche est très large, incluant l'apprentissage auto-supervisé, l'apprentissage semi-supervisé, l'apprentissage faiblement supervisé et le langage visuel.

Ce qui suit est le lien papier et le lien GitHub du BLIP-2. Les amis intéressés peuvent le récupérer ~

Lien papier : https://arxiv.org/pdf/2301.12597.pdf

Lien GitHub : https: /. /github.com/salesforce/LAVIS/tree/main/projects/blip2

Lien de référence : [1]https://twitter.com/mrdbourke/status/1620353263651688448

[2]https://twitter com. /LiJunnan0409/status/1620259379223343107

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI