Maison >Périphériques technologiques >IA >Subvertissez trois concepts ! Dernière recherche de Google : est-il plus précis de calculer la « similarité » avec un modèle peu performant ?

Subvertissez trois concepts ! Dernière recherche de Google : est-il plus précis de calculer la « similarité » avec un modèle peu performant ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 22:25:041636parcourir

Le calcul de la similarité entre images est un problème ouvert en vision par ordinateur.

Aujourd'hui, alors que la génération d'images est populaire partout dans le monde,

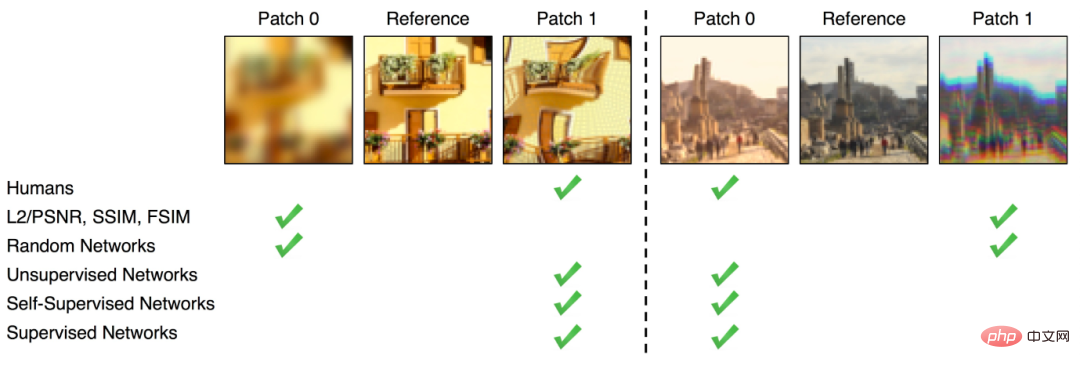

Comment définir la « similarité »est également une question clé dans l'évaluation de l'authenticité des images générées. Bien qu'il existe actuellement des méthodes relativement directes pour calculer la similarité d'une image, comme la mesure des

différences en pixels(comme FSIM, SSIM), la différence de similarité obtenue par cette méthode n'est pas la même que la différence perçue par le œil humain La différence est profonde. Après l'essor du deep learning, certains chercheurs ont découvert que la représentation intermédiaire

obtenue après une formation sur ImageNet par certains classificateurs de réseaux neuronaux, tels qu'AlexNet, VGG, SqueezeNet, etc., peut être utilisée pour le calcul de la perception similarité.En d’autres termes, l’intégration est plus proche de la perception qu’ont les gens de la similitude de plusieurs images que les pixels

.

Bien sûr, ceci  n'est qu'une hypothèse

n'est qu'une hypothèse

Récemment, Google a publié un article étudiant spécifiquement si le classificateur ImageNet peut mieux évaluer la similarité perceptuelle.

Lien papier : https://openreview.net/pdf?id=qrGKGZZvH0

Lien papier : https://openreview.net/pdf?id=qrGKGZZvH0

Bien qu'il y ait eu des travaux sur l'ensemble de données BAPPS

publié en 2018, basé sur leLes scores perceptuels ont été étudiés sur le classificateur ImageNet de première génération. Afin d'évaluer davantage la corrélation entre la précision et les scores perceptuels, ainsi que l'impact de divers hyperparamètres, l'article a ajouté les résultats de recherche du dernier modèle ViT. Plus la précision est élevée, plus la similarité perçue est mauvaise ?

Il est bien connu que les fonctionnalités apprises grâce à la formation sur ImageNet peuvent être bien transférées à de nombreuses tâches en aval et améliorer les performances des tâches en aval, ce qui fait également de la pré-formation sur ImageNet une opération standard.De plus, obtenir une plus grande précision sur ImageNet signifie souvent de meilleures performances sur un ensemble diversifié de tâches en aval, telles que la robustesse aux images endommagées, aux données non distribuées, etc. Performances de généralisation et transfert d'apprentissage vers des ensembles de données catégorielles plus petits.

Mais en termes de calcul de similarité perceptuelle, tout semble inversé.

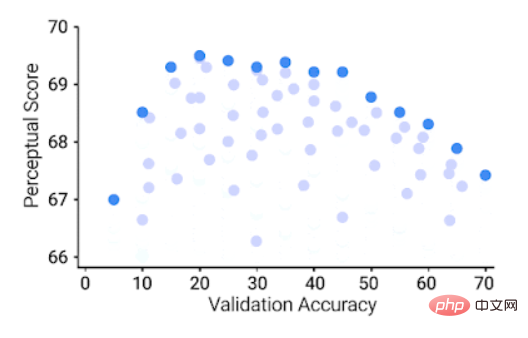

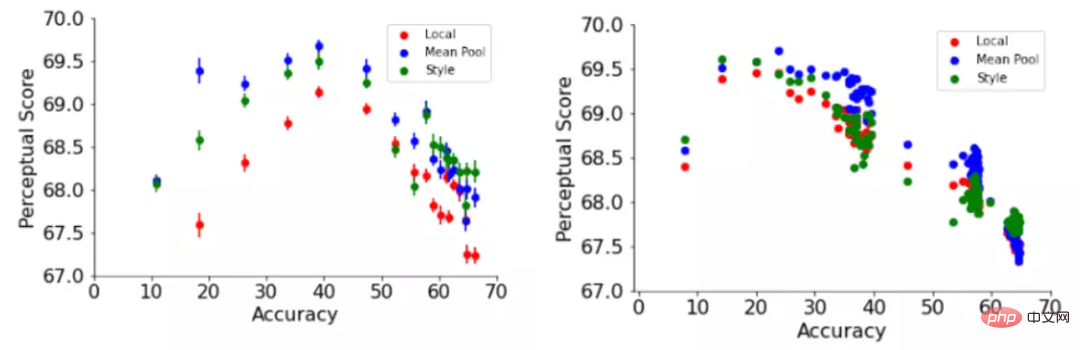

Les modèles qui atteignent une grande précision sur ImageNet ont en fait de moins bons scores de perception, tandis que les modèles avec des scores « moyens » ont les meilleures performances sur la tâche de similarité perceptuelle.

Précision de validation ImageNet 64 × 64 (axe x), score perceptuel 64 × 64 sur l'ensemble de données BAPPS (axe y), chaque point bleu représente un classificateur ImageNet

Précision de validation ImageNet 64 × 64 (axe x), score perceptuel 64 × 64 sur l'ensemble de données BAPPS (axe y), chaque point bleu représente un classificateur ImageNet

Vous pouvez voir On peut voir qu'un meilleur classificateur ImageNet atteint un meilleur score de perception dans une certaine mesure, mais au-delà d'un certain seuil, l'amélioration de la précision réduira le score de perception. La précision du classificateur est modérée (20,0-40,0), ce qui peut obtenir. le meilleur score de perception .

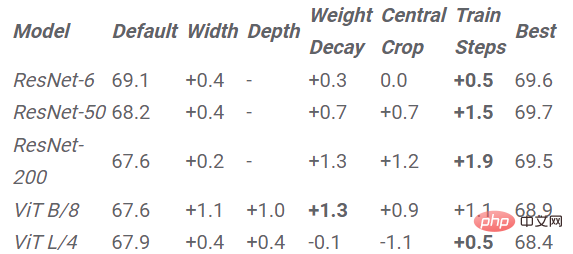

L'article étudie également l'impact des hyperparamètres du réseau neuronal sur les scores de perception, tels que la largeur, la profondeur, le nombre d'étapes d'entraînement, l'atténuation du poids, le lissage et l'abandon des étiquettes.

Pour chaque hyperparamètre, il existe une précision optimale, L’augmentation de la précision améliore le score de perception, mais cette valeur optimale est assez faible et est atteinte très tôt dans le balayage des hyperparamètres.

De plus, une augmentation de la précision du classificateur entraîne un pire score de perception.

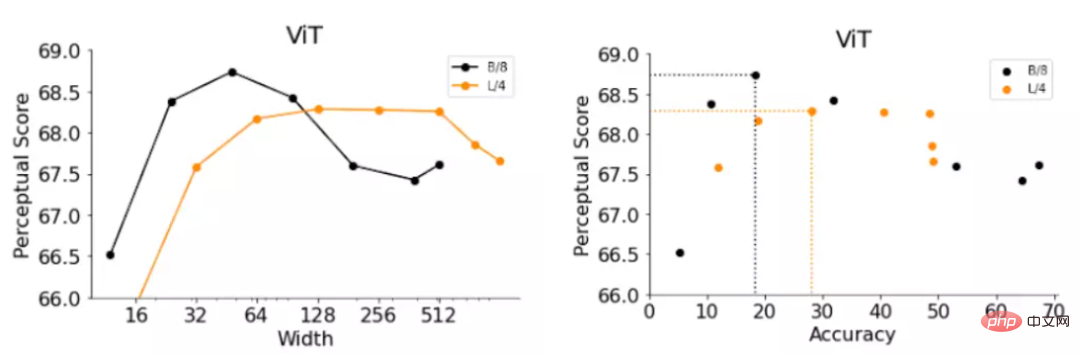

Par exemple, l'article donne le changement de score perceptuel par rapport à deux hyperparamètres : les étapes d'entraînement dans les ResNets et la largeur dans les ViT.

Les ResNets arrêtés précocement ont obtenu les meilleurs scores de perception à différents réglages de profondeur de 6, 50 et 200 Les scores de perception de ResNet-50 et ResNet-200 ont atteint leurs valeurs les plus élevées au cours des premières époques de formation, Mais après le pic, la valeur du score perceptuel du classificateur le plus performant a chuté plus fortement. Les résultats montrent que l'ajustement du taux de formation et d'apprentissage des ResNets peut améliorer la précision du modèle à mesure que le pas augmente. De même, après le pic, le modèle présente également une diminution progressive des scores de similarité perceptuelle qui correspond à cette précision progressivement croissante. ViTs se compose d'un ensemble de blocs Transformer appliqués à l'image d'entrée. La largeur du modèle ViT est le nombre de neurones de sortie d'un seul bloc Transformer. En remplaçant la largeur des deux variantes ViT, les chercheurs ont obtenu deux modèles B/8 (c'est-à-dire le modèle Base-ViT, la taille du patch est de 4) et L/4 (c'est-à-dire le modèle Large-ViT), et ont évalué avec précision la sexualité. et les évaluations de perception. Les résultats sont toujours similaires aux observations ResNets à arrêt précoce, avec des ViT plus étroits avec une précision inférieure et fonctionnant mieux que la largeur par défaut. Cependant, les largeurs optimales de ViT-B/8 et ViT-L/4 sont respectivement de 6 % et 12 % de leurs largeurs par défaut. L'article fournit également une liste expérimentale plus détaillée pour d'autres hyperparamètres tels. comme la largeur, la profondeur, le nombre d'étapes d'entraînement, la diminution du poids, le lissage des étiquettes et l'abandon sur ResNet et ViT. Donc, si vous souhaitez améliorer la similarité perçue, la stratégie est simple, il suffit de réduire la précision de manière appropriée. Améliorez le score de perception en réduisant le modèle ImageNet, les valeurs du tableau représentent l'amélioration obtenue en mettant à l'échelle le modèle avec des hyperparamètres donnés par rapport au modèle avec des hyperparamètres par défaut selon la conclusion ci-dessus, nous proposons une stratégie simple pour améliorer le score perceptuel d'une architecture : réduire le modèle pour réduire la précision jusqu'à ce que le score perceptuel optimal soit atteint. L'amélioration du score de perception obtenue en réduisant chaque modèle sur chaque hyperparamètre est également visible dans les résultats expérimentaux. L'arrêt anticipé entraîne l'amélioration du score la plus élevée sur toutes les architectures, à l'exception de ViT-L/4, et l'arrêt anticipé est la stratégie la plus efficace sans nécessiter de longues recherches dans la grille. Dans des travaux antérieurs, la fonction de similarité perceptuelle a été calculée en utilisant la distance euclidienne à travers les dimensions de l'espace image. Cette approche suppose une correspondance directe entre les pixels, mais cette correspondance peut ne pas s'appliquer aux images courbes, translatées ou pivotées. Dans cet article, les chercheurs ont adopté deux fonctions perceptuelles qui reposent sur la représentation globale de l'image, à savoir la fonction de perte de style et la normalisation dans le travail de transfert de style neuronal qui capture la similitude de style entre deux images. fonction. La fonction de perte de style compare la matrice de corrélation croisée inter-canaux entre deux images, tandis que la fonction de pooling moyen compare la représentation globale moyenne spatialement. La fonction globale du perceptron améliore systématiquement le score de perception des hyperparamètres par défaut de la formation réseau et de ResNet-200 en fonction de l'époque de la formation L'article explore également certaines hypothèses pour expliquer l'exactitude et les relations entre les scores de perception et en ont tiré des informations supplémentaires. Par exemple, la précision du modèle sans la connexion de saut couramment utilisée est également inversement proportionnelle au score de perception, les couches plus proches de la sortie ayant en moyenne des scores de perception inférieurs à celles des couches plus proches de l'entrée. Exploration également plus approfondie de la sensibilité à la distorsion, de la granularité de la catégorie ImageNet et de la sensibilité à la fréquence spatiale. En bref, cet article explore la question de savoir si l'amélioration de la précision de la classification produira de meilleures mesures de perception. Il étudie la relation entre la précision et les scores de perception sur les ResNets et les ViT sous différents hyperparamètres, et constate que les scores de perception et la précision présentent un U inversé. relation de type, dans laquelle les scores de précision et de perception sont liés dans une certaine mesure, montrant une relation en forme de U inversé. Enfin, l'article discute en détail de la relation entre la précision et le score de perception, y compris la connexion sautée, la fonction de similarité globale, la sensibilité à la distorsion, le score de perception hiérarchique, la sensibilité à la fréquence spatiale et la granularité des catégories ImageNet. Bien que l'explication exacte du compromis entre la précision d'ImageNet et la similarité perceptuelle reste un mystère, cet article constitue un premier pas en avant.

Fonction perceptuelle globale

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI