Maison >Périphériques technologiques >IA >Meta lance le modèle mondial du MoDem : résoudre trois défis majeurs dans le domaine visuel, présenté par LeCun

Meta lance le modèle mondial du MoDem : résoudre trois défis majeurs dans le domaine visuel, présenté par LeCun

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 20:22:011600parcourir

Le 27 décembre, MetaAI est responsable de A

dans le domaine de la vision et de l'apprentissage par renforcement. Au soir du 27, le nombre de lectures de ce tweet a atteint 73,9k.

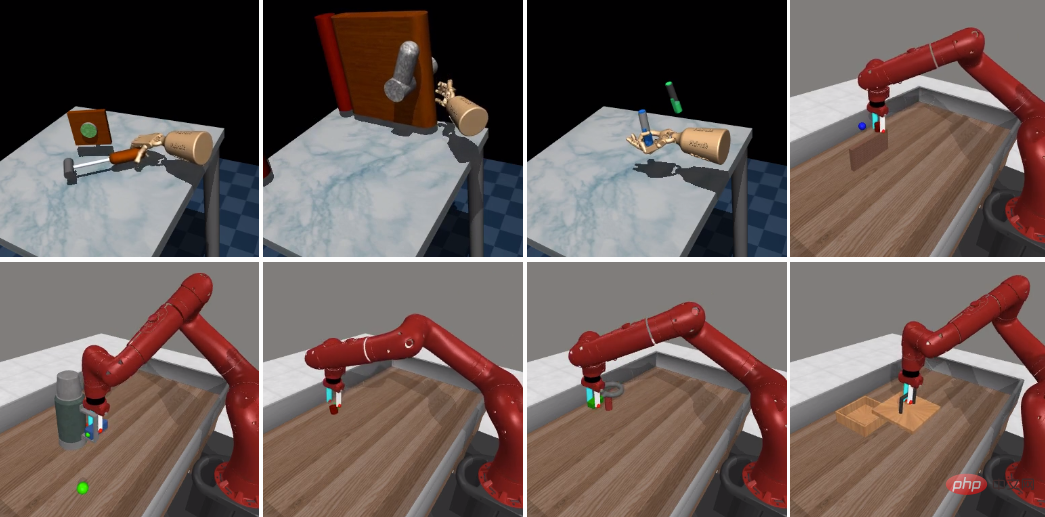

Avec seulement 5 démonstrations, MoDem peut résoudre des tâches difficiles de contrôle de mouvement visuel avec des récompenses clairsemées et des espaces d'action de grande dimension en 100 000 étapes d'interaction, surpassant largement les méthodes existantes. .

Est-ce bon ?

Ils ont constaté que le taux de réussite du MoDem dans l'accomplissement de tâches de récompense clairsemées était 150 %-250 % plus élevé que les méthodes précédentes dans les régimes à faibles données.

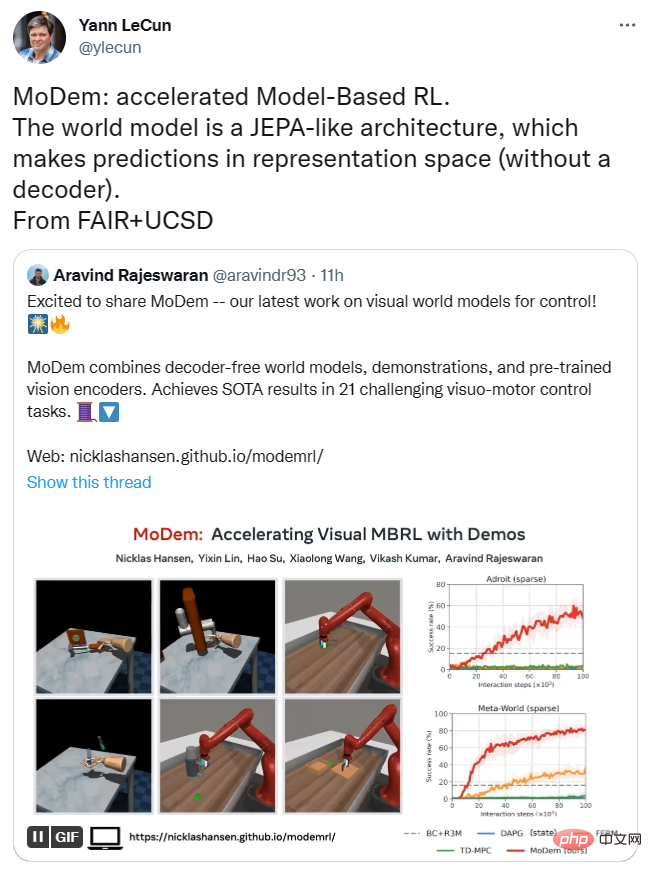

Lecun a également transmis cette recherche, affirmant que l'architecture du modèle du MoDem est similaire à celle du JEPA et peut faire des prédictions dans l'espace de représentation sans avoir besoin d'un décodeur.

L'éditeur a mis le lien ci-dessous, les amis intéressés peuvent y jeter un oeil~

Lien papier : https://arxiv.org/abs/2212.05698

Lien Github : https://github.com/facebookresearch/modem

Research Innovation and Model Architecture

Un échantillon inefficace est un défi majeur dans le déploiement d'algorithmes d'apprentissage par renforcement profond (RL) dans des applications pratiques, en particulier le contrôle de mouvement par vision.

La RL basée sur un modèle a le potentiel d'atteindre une efficacité d'échantillonnage élevée en apprenant simultanément un modèle mondial et en utilisant un déploiement synthétique pour la planification et l'amélioration des politiques.

Cependant, dans la pratique, l'apprentissage efficace des échantillons dans le RL basé sur des modèles est entravé par les défis d'exploration. Cette recherche résout précisément ces principaux défis.

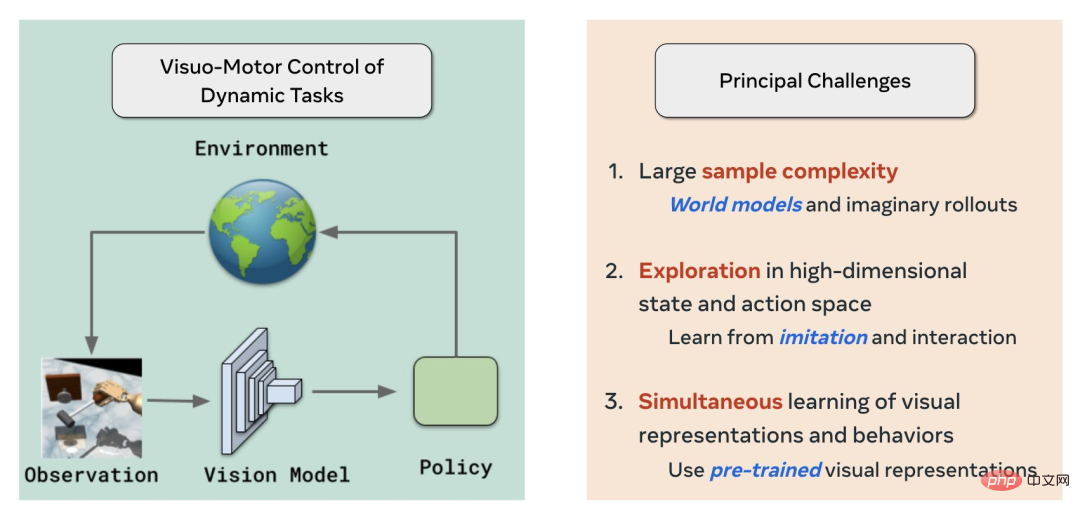

Tout d'abord, le MoDem résout trois défis principaux dans le domaine de l'apprentissage/contrôle par renforcement visuel en utilisant respectivement le modèle mondial, l'imitation + RL et la pré-formation visuelle auto-supervisée :

- Grande complexité d'échantillon)

- Exploration dans un espace d'état et d'action de grande dimension

- Apprentissage simultané de représentations visuelles et de comportements

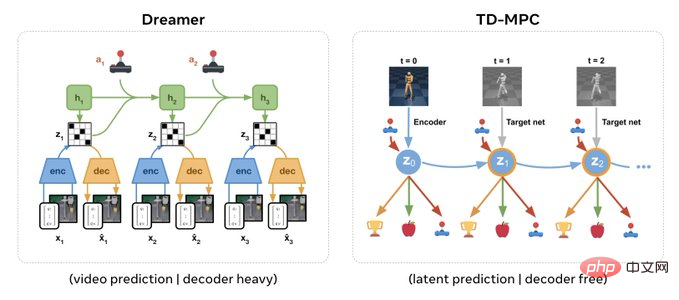

Cette fois, l'architecture du modèle est similaire au JEPA de Yann LeCun et ne nécessite pas de décodeur.

Aravind Rajeswaran, l'auteur, a déclaré que par rapport à Dreamer, qui nécessite un décodeur avec une prédiction au niveau des pixels et une architecture lourde, l'architecture sans décodeur peut prendre en charge l'insertion directe de représentations visuelles pré-entraînées à l'aide de SSL.

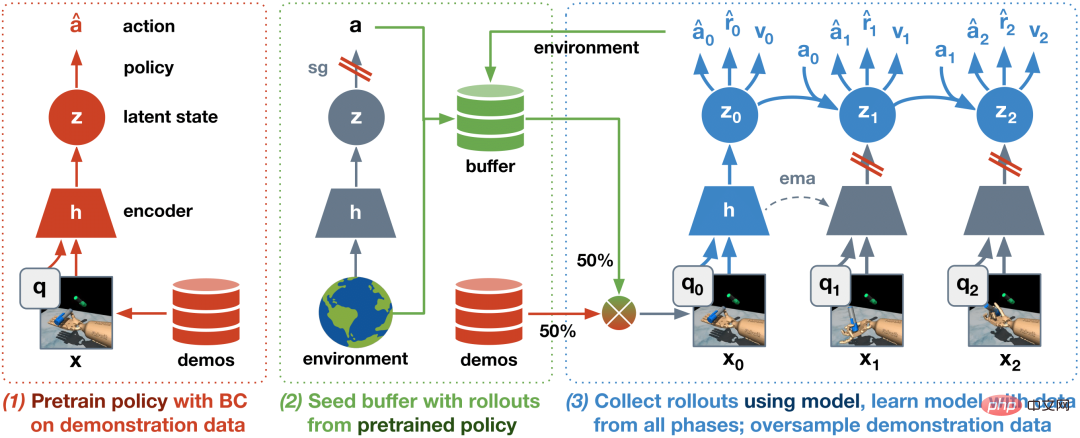

De plus, basé sur IL+RL, ils ont proposé un algorithme en trois étapes :

- Stratégie de pré-formation BC

- Pré-entraîner le modèle mondial à l'aide d'un ensemble de données de départ contenant des démonstrations et des explorations. Cette étape est importante pour la stabilité et l'efficacité globales

- Affiner le modèle mondial grâce à l'interaction en ligne .

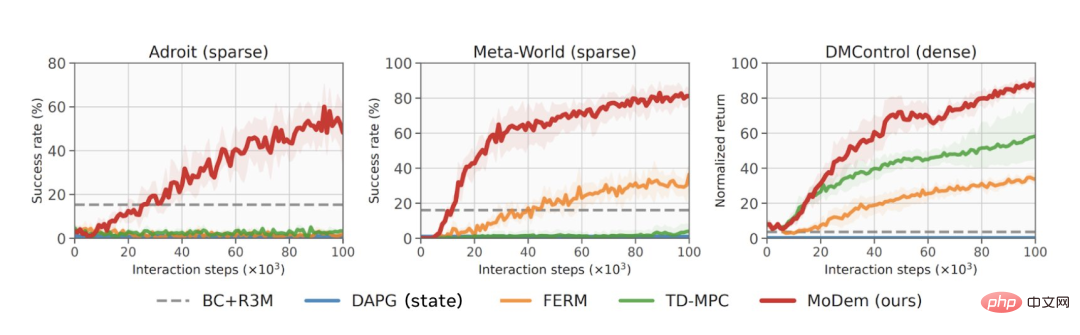

Les résultats montrent que l'algorithme généré a obtenu des résultats SOTA (résultat de pointe) dans 21 tâches de contrôle de mouvement visuel difficiles, y compris l'opération adroite Adroit, les suites de contrôle MetaWorld et DeepMind.

Du point de vue des données, le MoDem est bien meilleur que les autres modèles dans diverses tâches, et les résultats sont 150 à 250 % supérieurs à ceux de la méthode SOTA précédente.

Les lignes rouges représentent la performance du MoDem dans diverses tâches

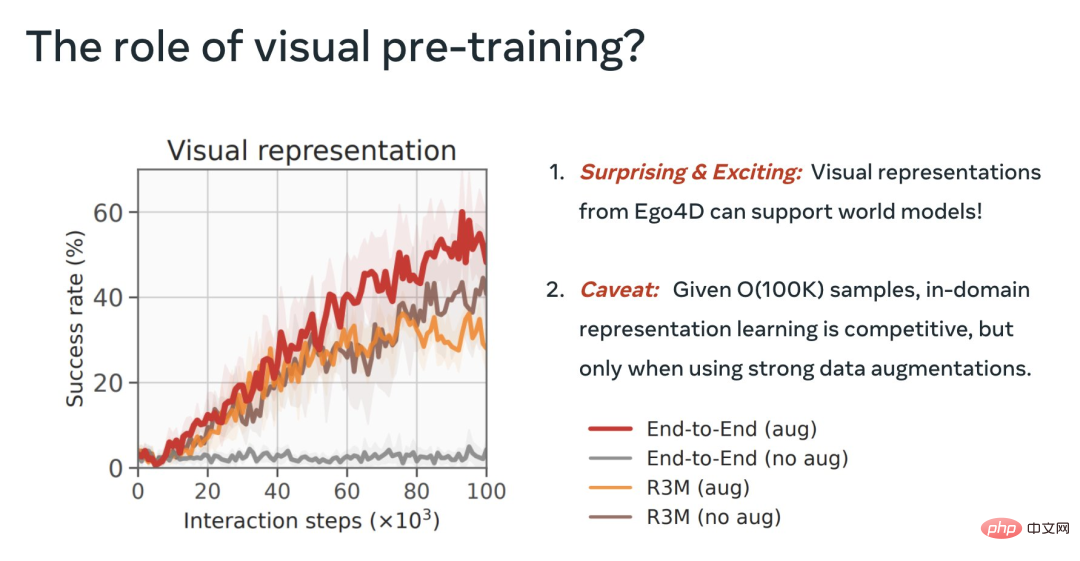

Au cours du processus, ils ont également clarifié l'importance des différentes étapes du MoDem, l'importance de l'augmentation des données pour le MBRL visuel et le utilité des représentations visuelles pré-entraînées.

Enfin, l'utilisation de la fonctionnalité R3M figée est de loin supérieure à l'approche E2E directe. C’est passionnant et montre que le pré-entraînement visuel à partir de la vidéo peut prendre en charge les modèles mondiaux.

Mais l'E2E avec des données solides en août rivalise avec le R3M gelé, on peut faire mieux avec le pré-entraînement.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI