Maison >Périphériques technologiques >IA >Google est le premier à lancer la génération vidéo AIGC, internautes : vous pouvez personnaliser les films

Google est le premier à lancer la génération vidéo AIGC, internautes : vous pouvez personnaliser les films

- PHPzavant

- 2023-04-12 20:10:121666parcourir

Nous savons que les progrès des modèles génératifs et des modèles de langage visuel multimodal ont ouvert la voie à des modèles texte-image à grande échelle dotés d'un réalisme et d'une diversité génératifs sans précédent. Ces modèles offrent de nouveaux processus créatifs, mais se limitent à composer de nouvelles images plutôt qu'à éditer des images existantes. Pour combler cette lacune, des méthodes intuitives d'édition textuelle permettent l'édition textuelle d'images générées et réelles et préservent certaines des propriétés originales de ces images. Semblables aux images, de nombreux modèles de conversion texte-vidéo ont été proposés récemment, mais il existe peu de méthodes utilisant ces modèles pour le montage vidéo.

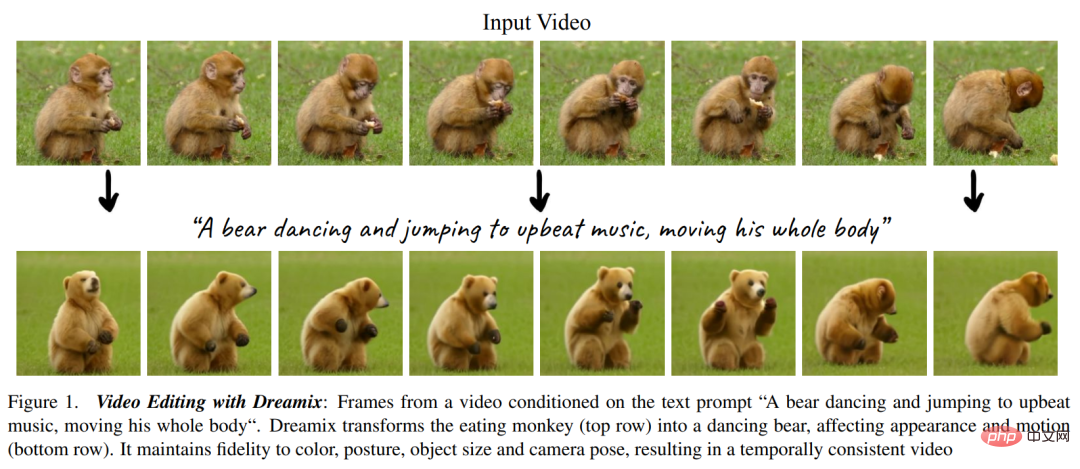

Dans le montage vidéo guidé par texte, l'utilisateur fournit une vidéo d'entrée ainsi qu'une invite de texte décrivant les propriétés attendues de la vidéo générée, comme le montre la figure 1 ci-dessous. Les objectifs comportent les trois aspects suivants : 1) Alignement, la vidéo éditée doit être conforme à l'invite de texte de saisie ; 2) Fidélité, la vidéo éditée doit conserver le contenu de la vidéo originale, 3) Qualité, la vidéo éditée doit être de haute qualité. .

Comme vous pouvez le constater, le montage vidéo est plus difficile que le montage d'images, il nécessite de synthétiser de nouvelles actions plutôt que de simplement modifier l'apparence visuelle. Il est également nécessaire de maintenir une cohérence temporelle. Par conséquent, l’application de méthodes d’édition au niveau de l’image telles que SDEdit et Prompt-to-Prompt aux images vidéo ne suffit pas pour obtenir de bons résultats.

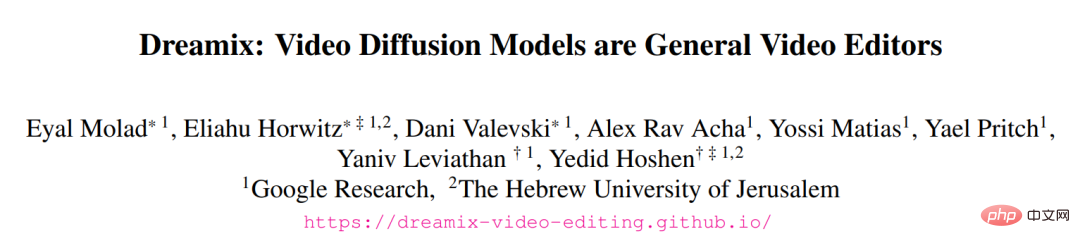

Dans un article récemment publié sur arXiv par Google Research et d'autres, des chercheurs ont proposé une nouvelle méthode Dreamix, inspirée par UniTune pour diffuser des vidéos conditionnelles au texte Model (modèle de diffusion vidéo, VDM) est appliqué au montage vidéo.

- Adresse de papier: https://arxiv.org/pdf/2302.01329.pdf

- project Homepage: https: //dreamix-videoo-editing.github. io/

Le cœur de la méthode dans cet article est de faire en sorte que le texte conditionnel VDM maintienne une haute fidélité à la vidéo d'entrée grâce aux deux idées principales suivantes. L'une n'utilise pas de bruit pur comme initialisation du modèle, mais utilise une version dégradée de la vidéo originale pour conserver uniquement de faibles informations spatio-temporelles en réduisant la taille et en ajoutant du bruit ; modèle génératif sur la vidéo originale Spend.

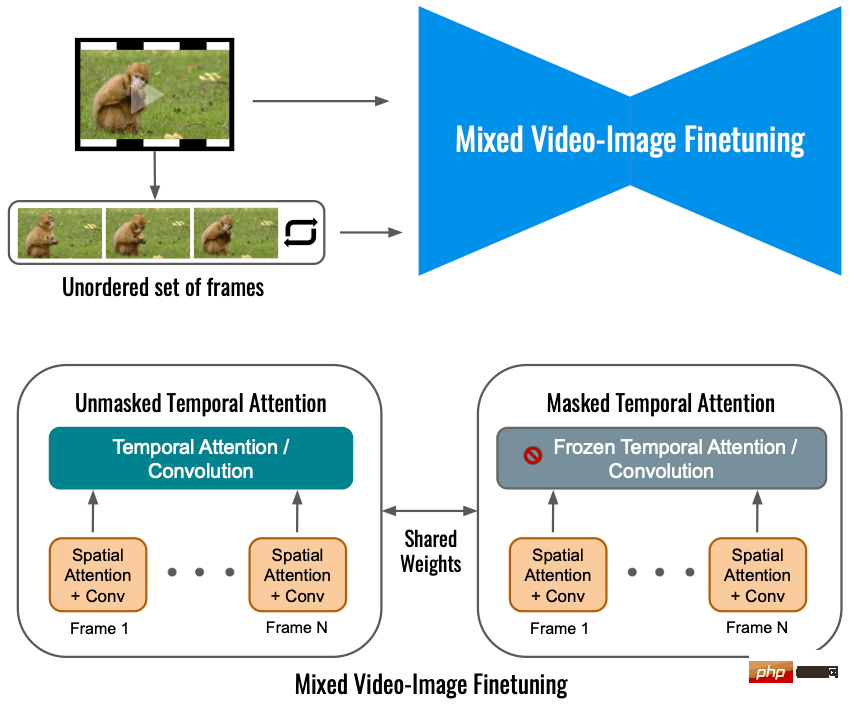

Le réglage fin garantit que le modèle comprend les propriétés haute résolution de la vidéo originale. Un simple réglage fin de la vidéo d'entrée contribue à une édition de mouvement relativement faible, car le modèle apprend à préférer le mouvement brut plutôt que de suivre les invites textuelles. Nous proposons une nouvelle méthode de réglage hybride dans laquelle le VDM est également affiné sur un ensemble d'images individuelles de la vidéo d'entrée et ignore leur synchronisation. Le réglage fin du mélange améliore considérablement la qualité de l’édition de mouvement.Les chercheurs ont ensuite utilisé leur modèle de montage vidéo pour proposer un

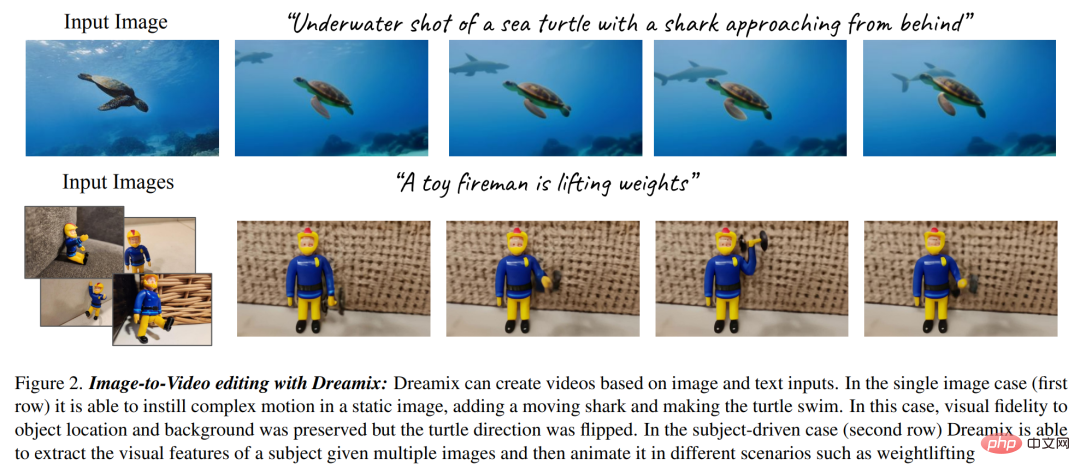

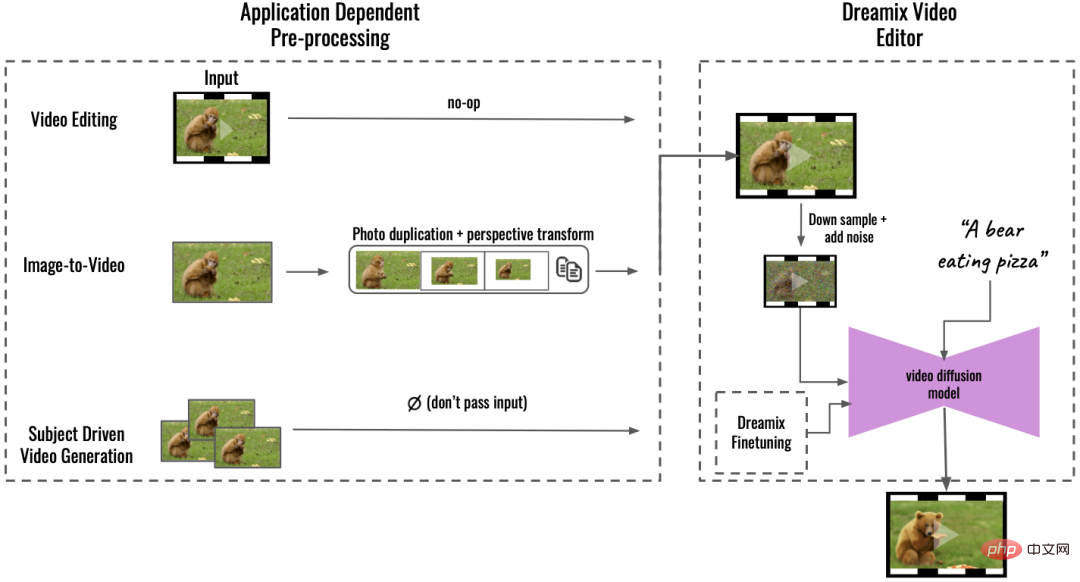

nouveau cadre d'animation d'images, comme le montre la figure 2 ci-dessous. Le cadre comprend plusieurs étapes, telles que l'animation d'objets et d'arrière-plans dans des images, la création de mouvements de caméra dynamiques, etc. Pour ce faire, ils effectuent de simples opérations de traitement d'image telles que la copie d'images ou la transformation géométrique d'images, créant ainsi des vidéos grossières. Utilisez ensuite l'éditeur vidéo Dreamix pour éditer la vidéo. En outre, les chercheurs ont également utilisé leur méthode de réglage fin pour la génération vidéo axée sur les objectifs, à savoir la version vidéo de Dreambooth.

Concernant cette étude de Google, certains disent que les outils de mouvement et d'édition 3D+ pourraient être des sujets populaires pour la prochaine vague d'articles.

Quelqu'un d'autre a dit : Vous pourrez bientôt réaliser votre propre film avec un budget limité, tout ce dont vous avez besoin c'est d'un écran vert et de cette technologie :

Aperçu de la méthode

Cet article propose une nouvelle méthode de montage vidéo, plus précisément :

Montage vidéo guidé par texte par rétro-ingénierie de vidéos corrompues

Ils adoptent des VDM (modèles de diffusion vidéo) en cascade, d'abord par sous-échantillonnage qui détruit dans une certaine mesure la vidéo d'entrée puis ajoute du bruit. Ensuite, un modèle de diffusion en cascade est utilisé pour le processus d'échantillonnage et conditionné au temps t pour mettre à l'échelle la vidéo jusqu'à la résolution spatio-temporelle finale.

Dans le processus de destruction de la vidéo d'entrée, vous devez d'abord effectuer une opération de sous-échantillonnage pour obtenir le modèle de base (16 images 24 × 40), puis ajouter du bruit gaussien avec une variance de  pour plus Détruisez la vidéo d'entrée.

pour plus Détruisez la vidéo d'entrée.

Pour la vidéo traitée ci-dessus, l'étape suivante consiste à utiliser VDM en cascade pour mapper la vidéo basse résolution corrompue sur une vidéo haute résolution alignée sur le texte. L’idée centrale ici est que, étant donné une vidéo bruitée, à très faible résolution temporelle et spatiale, il existe de nombreuses vidéos parfaitement réalisables à haute résolution qui lui correspondent. Le modèle de base de cet article part d'une vidéo corrompue, qui a le même bruit que le processus de diffusion au temps s. L’étude a ensuite utilisé le VDM pour inverser le processus de diffusion jusqu’au temps 0. Enfin, la vidéo est mise à niveau grâce au modèle super-résolution.

Réglage fin de l'image vidéo hybride

L'utilisation uniquement de la vidéo d'entrée pour affiner le modèle de diffusion vidéo limitera les changements de mouvement de l'objet. Au lieu de cela, cette étude a utilisé une cible hybride, c'est-à-dire en plus. à la cible d'origine (coin inférieur gauche) De plus, cet article affine également les ensembles d'images non ordonnés, ce qui se fait via une « attention temporelle masquée » pour empêcher l'attention temporelle et la convolution d'être affinées (en bas à droite). Cette opération permet d'ajouter du mouvement aux vidéos statiques.

Inférence

Basée sur le prétraitement de l'application (prétraitement dépendant de l'application, image de gauche ci-dessous), cette recherche prend en charge une variété d'applications et peut convertir le contenu d'entrée en vidéo unifiée. format. Pour la conversion image-vidéo, l'image d'entrée est copiée et transformée, synthétisant une vidéo brute avec un certain mouvement de caméra ; pour la génération vidéo pilotée par objet, son entrée est omise et affinée séparément pour maintenir la fidélité. Cette vidéo brute est ensuite montée à l'aide de Dreamix Video Editor (à droite) : comme mentionné précédemment, la vidéo est d'abord détruite par sous-échantillonnage, ajoutant du bruit. Un modèle de diffusion vidéo guidé par texte est ensuite appliqué pour mettre à l'échelle la vidéo jusqu'à sa résolution temporelle et spatiale finale.

Montage vidéo : dans l'image ci-dessous, Dreamix a changé l'action en danse et l'apparence de singe en ours, mais les attributs de base du sujet dans la vidéo n'ont pas changé :

Image vers la vidéo : Lorsque le l'entrée est une image Dreamix peut utiliser ses priorités vidéo pour ajouter de nouveaux objets en mouvement, comme l'image ci-dessous où une licorne apparaît dans une forêt brumeuse et effectue un zoom avant.

Pingouins apparaissant à côté de la cabane :

Génération de vidéo axée sur un objectif : Dreamix peut également prendre une collection d'images montrant le même thème et générer une nouvelle vidéo avec celle-ci. thème pour les objets en mouvement. L'image ci-dessous montre une chenille se tortillant sur une feuille :

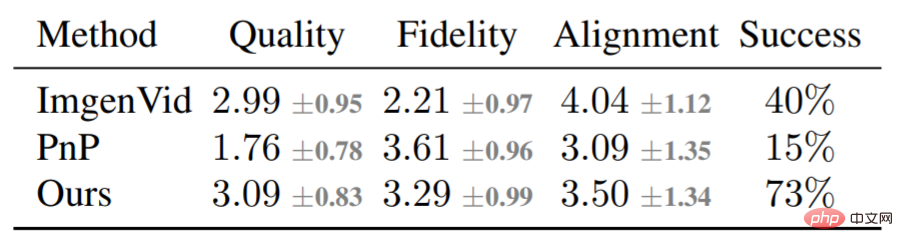

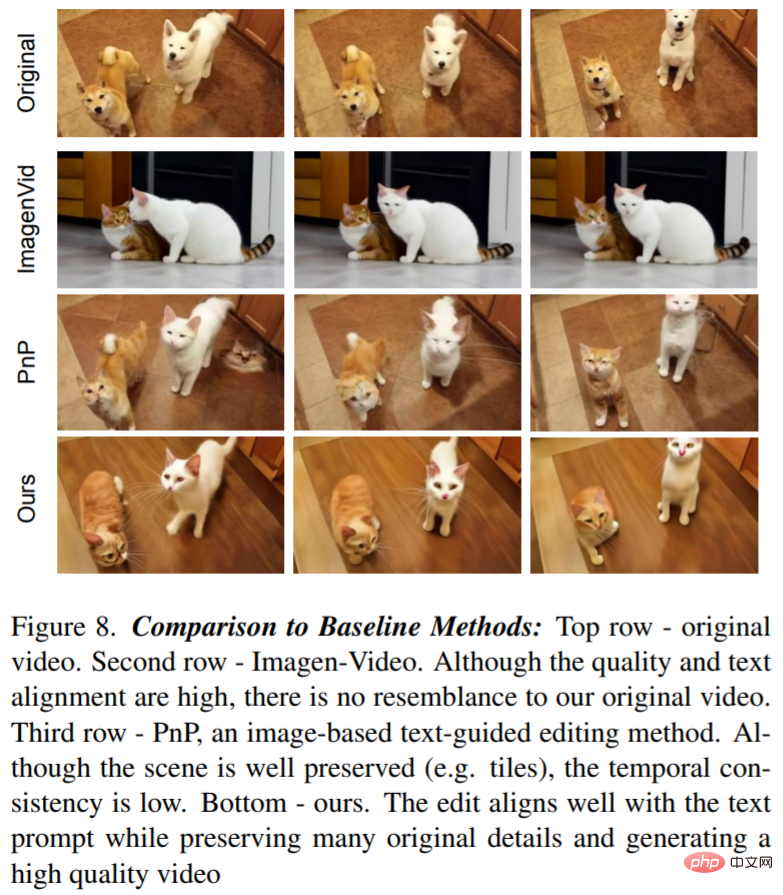

En plus de l'analyse qualitative, l'étude a également mené une comparaison de base, comparant principalement Dreamix avec Imagen-Video et Plug-and-Play (PnP). méthode de comparaison. Le tableau suivant montre les résultats de notation :

La figure 8 montre une vidéo éditée par Dreamix et deux exemples de base : Le modèle texte-vidéo permet un montage basse fidélité car il n'utilise pas la vidéo originale comme condition. PnP préserve la scène mais manque de cohérence d'une image à l'autre ; Dreamix fonctionne bien sur les trois objectifs.

Veuillez vous référer au document original pour plus de détails techniques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI