Maison >Périphériques technologiques >IA >Deux jours seulement après sa mise en ligne, le site Web destiné à rédiger des articles avec de grands modèles d'IA a été radié à la vitesse de la lumière : fabrication irresponsable

Deux jours seulement après sa mise en ligne, le site Web destiné à rédiger des articles avec de grands modèles d'IA a été radié à la vitesse de la lumière : fabrication irresponsable

- 王林avant

- 2023-04-12 19:19:261694parcourir

Il y a quelques jours, Meta AI et Papers with Code ont publié le modèle de langage à grande échelle Galactica. Une caractéristique majeure de ce modèle est de libérer vos mains et les rédacteurs fantômes peuvent vous aider à rédiger des articles. ? Les résumés, introductions, formules, références, etc. sont tous inclus.

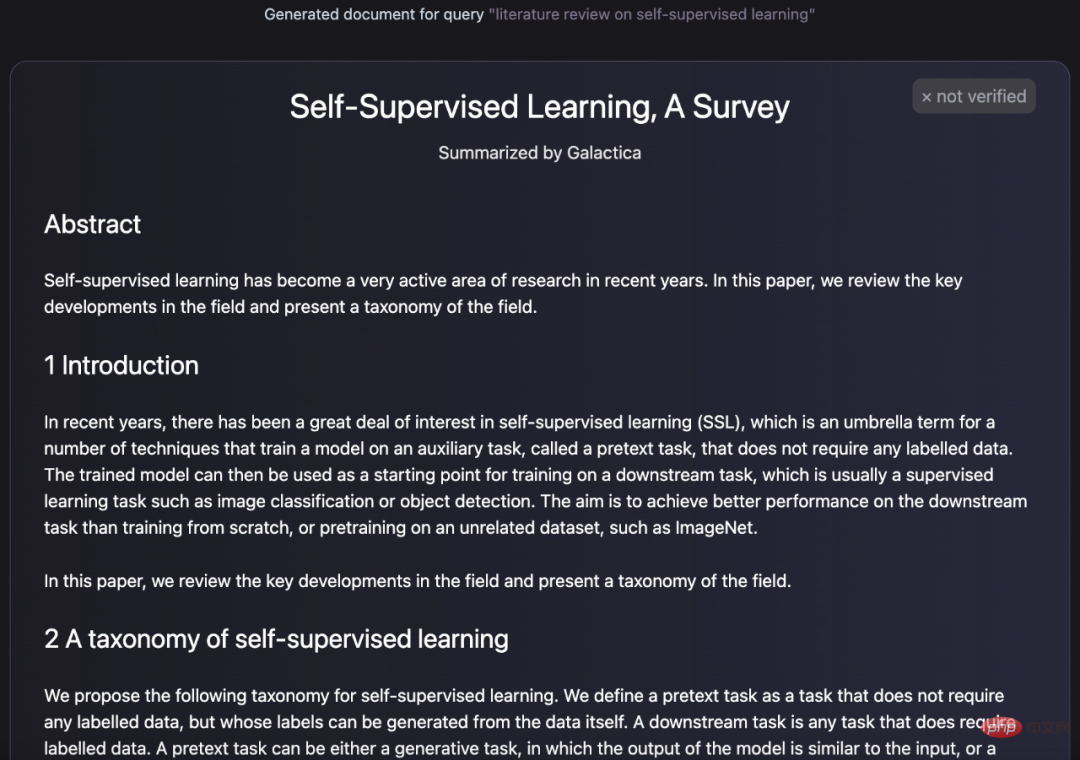

Tout comme ce qui suit, le texte généré par Galactica ressemble à la configuration d'un article :

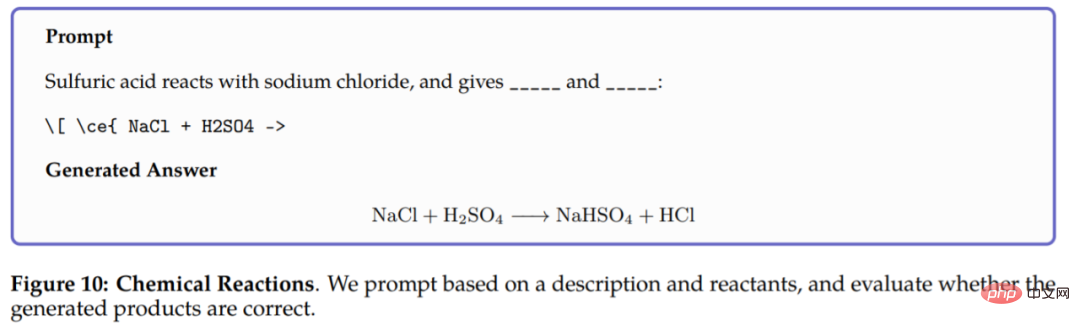

Non seulement génère des articles, Galactica peut également générer des requêtes encyclopédiques pour les entrées et faire des commentaires informatifs sur les questions posées. Réponse : En plus de la génération de texte, Galactica peut également effectuer des tâches multimodales impliquant des formules chimiques et des séquences protéiques. Par exemple, dans une réaction chimique, on demande à Galactica de prédire les produits de la réaction dans l'équation chimique LaTeX. Le modèle peut raisonner uniquement sur la base des réactifs. Les résultats sont les suivants :

Afin de. faciliter aux utilisateurs l'expérience de cette recherche, l'équipe a également spécialement lancé la version d'essai. Comme indiqué ci-dessous, il y a quelques jours, cette interface affichait également des fonctions de saisie, de génération et autres.

(version précédente) Adresse de la version d'essai de Galactica : https://galactica.org/

En quelques jours seulement, son interface est devenue ainsi, et la saisie n'est plus possible .

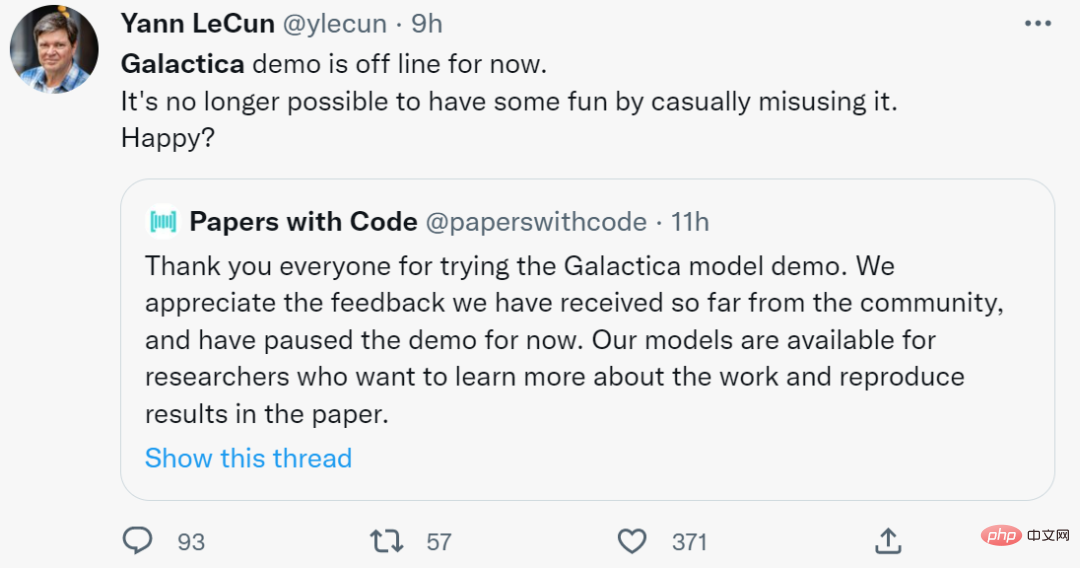

Selon Papers with Code, ils ont reçu des retours de la communauté et ont suspendu la fonction démo de Galactica. Yann LeCun, le lauréat du prix Turing qui le félicitait sur Twitter il y a deux jours, a déclaré aujourd'hui, impuissant, qu'il ne pouvait plus en tirer le bonheur. Êtes-vous heureux ?

Cependant, par rapport à ceux qui recommandent fortement cette recherche, certains internautes ont soulevé certaines objections. Par rapport aux avantages qu'elle apporte, Galactica entraînera des conséquences plus négatives pour les étudiants qui rédigent des articles. c'est le cas.

Par rapport aux étudiants qui l'utilisent pour rédiger des articles, le problème découvert par l'internaute ci-dessous est encore plus grave.

"J'ai posé quelques questions à Galactica et ses réponses étaient fausses ou biaisées, mais semblaient correctes et faisant autorité." Après une série d'expériences, l'utilisateur de Twitter Michael Black a déclaré : "Galactica a généré le texte est grammatical et semble authentique. Le résultat L'article peut être correct, mais il peut aussi être erroné ou biaisé, ce qui rend difficile la détection de cette façon de penser. "

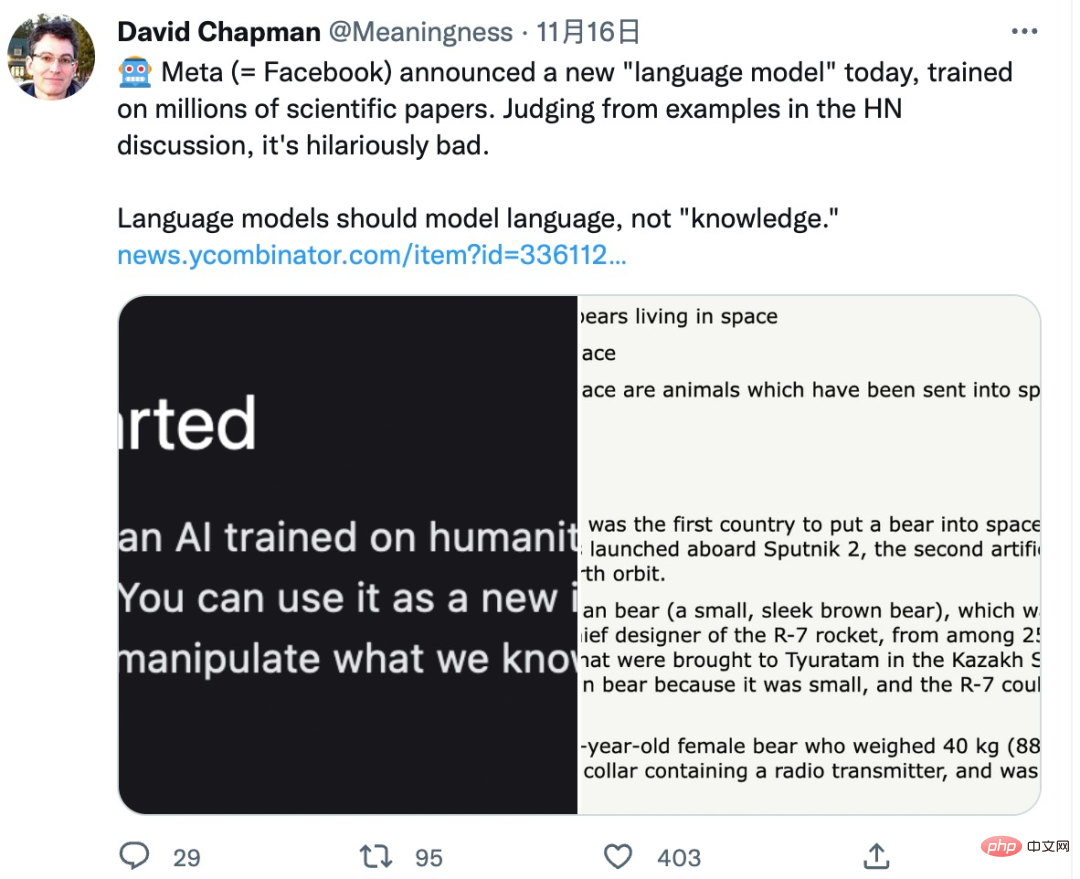

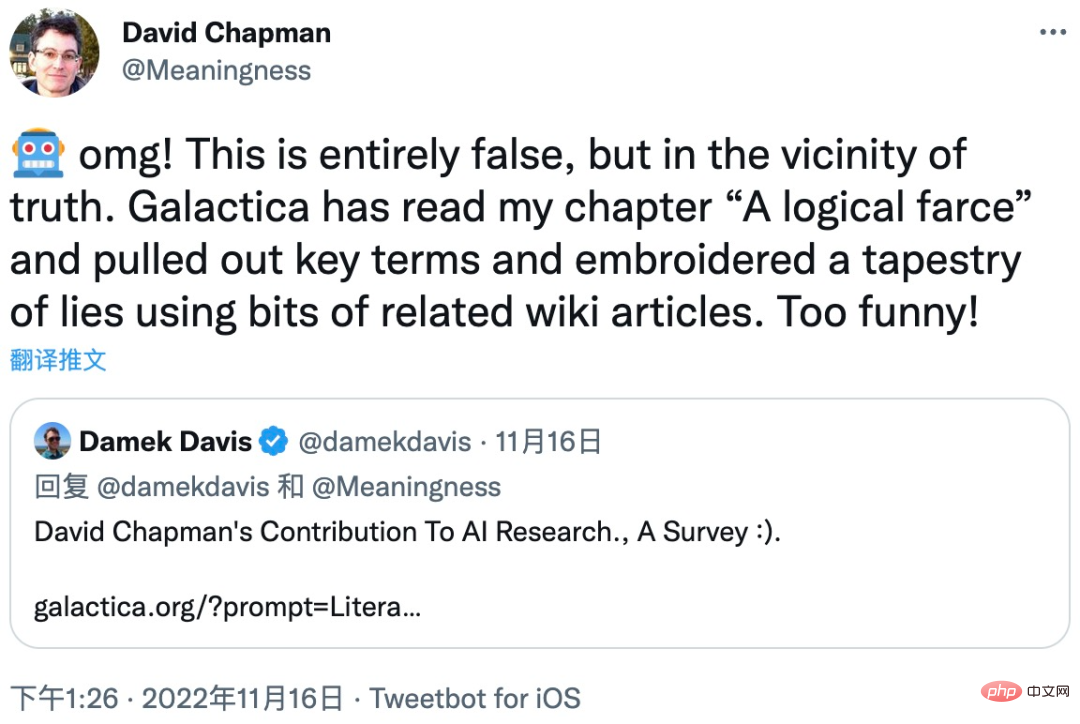

"Il fournit une science faisant autorité, mais sans la base d'une méthode scientifique. les propriétés statistiques de l'écriture scientifique, ce qui rend difficile la distinction du vrai du faux. Cela peut ouvrir une science profonde. L'ère de la contrefaçon sera citée par d'autres dans de vrais articles, mais j'apprécie l'intention originale de ce projet. veuillez noter qu'il ne s'agit pas d'un accélérateur pour la science. Ce n'est pas un outil utile pour la rédaction scientifique. Ceci est potentiellement déformant et dangereux pour la science. Capture d'écran de la réponse de Michael Black. Lien : https://twitter.com/Michael_J_Black/status/1593133722316189696 Michael Black n'est pas le seul à avoir découvert que Galactica a des problèmes tels que le laxisme et la génération d'articles pseudo-scientifiques. D'autres internautes l'ont également découvert. ce défaut. Jetons un coup d’œil aux autres commentaires des internautes. Après le lancement de la version d'essai de Galactica, de nombreux chercheurs ont émis des doutes à son sujet. Un spécialiste de l'IA nommé David Chapman a souligné que les modèles de langage devraient organiser et synthétiser le langage plutôt que de générer des connaissances : C'est en effet une question qui mérite réflexion. connaissance", alors comment juger si cette connaissance est correcte ? Comment vont-ils influencer, voire induire en erreur les humains ? David Chapman a utilisé l'un de ses articles comme exemple pour illustrer la gravité de ce problème. Le modèle Galactica a extrait les termes clés de la partie « Une farce logique » du document, puis a utilisé certains articles Wikipédia connexes, et enfin a édité et synthétisé un article plein d'erreurs et d'omissions. Depuis que la version d'essai du modèle Galactica a été supprimée, nous ne voyons pas à quel point cet article s'écarte de l'intention initiale du journal. Mais il est concevable que les débutants soient sérieusement induits en erreur s'ils lisent cet article sur la synthèse du modèle Galactica. Gary Marcus, spécialiste bien connu de l'IA et fondateur de Robust.AI, a également exprimé de forts doutes sur le modèle Galactica : « C'est un peu effrayant que les grands modèles de langage (LLM) confondent mathématiques et connaissances scientifiques. peuvent l'aimer et l'utiliser pour tromper leurs professeurs. Cela devrait nous inquiéter Des chercheurs du Département d'informatique de l'Université de New York ont également testé les résultats du modèle Galactica et ont découvert que Galactica n'avait pas répondu à la question. : Source : https://cs.nyu.edu/~davise/papers/ExperimentWithGalactica.html

Non seulement cela, mais il y a des erreurs factuelles dans certains détails dans la réponse du modèle Galactica : Cette expérience à New. L'Université York montre très spécifiquement qu'il existe de graves erreurs dans les résultats du modèle Galactica, et l'étude a mené plusieurs expériences sur différents problèmes, et à chaque fois Galactica Les réponses sont pleines d'erreurs. Cela montre que les informations d'erreur générées par Galactica ne le sont pas. accident. Rapport d'expérimentation de l'Université de New York : https://cs.nyu.edu/~davise/papers/ExperimentWithGalactica.html Face à l'échec de Galactica, certains internautes l'ont attribué aux limites de Deep. apprentissage : « L'essence de l'apprentissage profond est d'apprendre à partir des données, qui sont intrinsèquement différentes de l'intelligence humaine et ne peuvent pas du tout atteindre l'intelligence artificielle générale (AGI). l'apprentissage profond, mais il ne fait aucun doute que les modèles de langage comme Galactica qui génèrent de manière incorrecte des « connaissances » ne sont pas recommandés.Provoquer une controverse

Gravity Probe B (GP-B) est en effet une sonde scientifique lancée par la NASA pour tester l'exactitude de la relativité générale et l'effet de traînée du référentiel. Leonard Schiff était en effet le physicien qui a proposé l'expérience, et Francis Everitt était le chercheur principal (PI) du projet.

Cependant, la question posée par le chercheur de NYU était la suivante : des articles de Wikipédia liés à des expériences visant à déterminer la constante gravitationnelle, tandis que le modèle Galactica répondait "à des informations encyclopédiques liées à des expériences liées au test de la théorie de la relativité générale". C’est fondamentalement faux.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI