Maison >Périphériques technologiques >IA >Le nombre de paramètres est de 1/50, Meta publie un modèle de 11 milliards de paramètres, battant Google PaLM

Le nombre de paramètres est de 1/50, Meta publie un modèle de 11 milliards de paramètres, battant Google PaLM

- 王林avant

- 2023-04-12 18:10:031237parcourir

Nous pouvons comprendre les grands modèles de langage (LLM) comme de petits échantillons d'apprenants, qui peuvent apprendre de nouvelles tâches avec peu d'exemples, ou même apprendre avec seulement des instructions simples, où la quantité de paramètres de modèle et de données de formation est limitée. L'augmentation de la taille est la clé à la capacité de généralisation du modèle. Cette amélioration des LLM est due à une plus grande puissance de calcul et des capacités de stockage. Intuitivement, des capacités d'inférence améliorées conduiront à une meilleure généralisation et donc à moins d'apprentissage d'échantillons. Cependant, il n'est pas clair dans quelle mesure un apprentissage efficace sur petits échantillons nécessite une connaissance approfondie des paramètres du modèle.

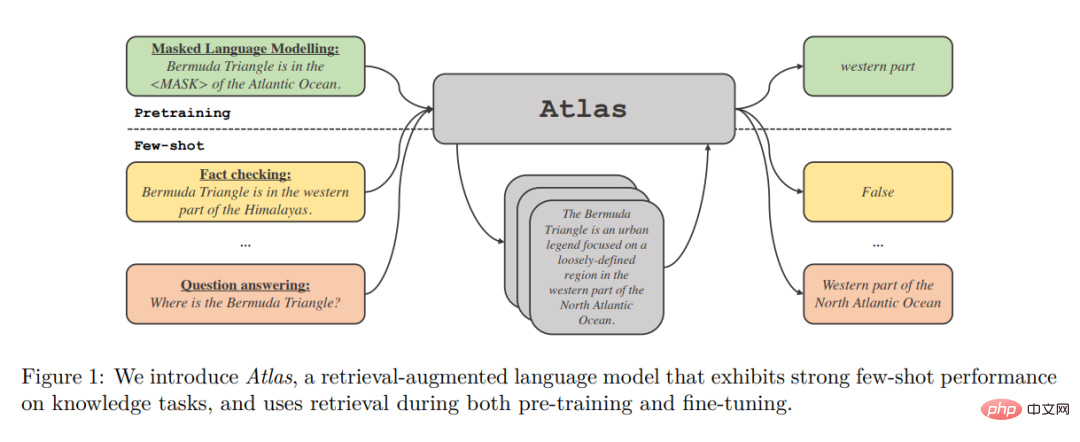

Jusqu’à présent, les modèles d’amélioration de la récupération n’ont pas démontré de capacités convaincantes d’apprentissage sur de petits échantillons. Dans cet article, des chercheurs de Meta AI Research et d'autres institutions se demandent si l'apprentissage sur petits échantillons nécessite que le modèle stocke une grande quantité d'informations dans ses paramètres, et si le stockage peut être dissocié de la généralisation. Ils ont proposé Atlas, qui est un type de modèle de langage amélioré par la récupération et doté de fortes capacités d'apprentissage sur petits échantillons, même si le nombre de paramètres est inférieur à celui des autres modèles d'apprentissage puissants actuels sur petits échantillons.

Le modèle utilise le stockage non paramétrique, c'est-à-dire l'utilisation d'un récupérateur neuronal basé sur de grandes sources de connaissances externes non statiques pour améliorer le modèle de langage paramétrique. Outre leurs capacités de stockage, ces architectures sont attrayantes en raison de leurs avantages en termes d’adaptabilité, d’interprétabilité et d’efficacité.

La récupération par Atlas des documents pertinents est un outil de récupération de densité générale basé sur le double encodeur Contriever architecture. Récupérez les fichiers associés en fonction du contexte actuel lors de la récupération des fichiers. Les documents récupérés ainsi que le contexte actuel sont traités par un modèle séquence à séquence qui utilise l'architecture Fusion-in-Decoder pour générer la sortie correspondante.

Les auteurs étudient l'impact de différentes techniques sur les performances de la formation Atlas sur des ensembles de données sur petits échantillons sur une gamme de tâches en aval, y compris la réponse aux questions et la vérification des faits. L'étude a révélé que la composante conjointe de pré-formation est cruciale pour les performances d'un petit échantillon, et les auteurs ont évalué de nombreuses tâches et programmes de pré-formation existants et nouveaux. Atlas présente de solides performances en aval dans des environnements de petit échantillon et riches en ressources.

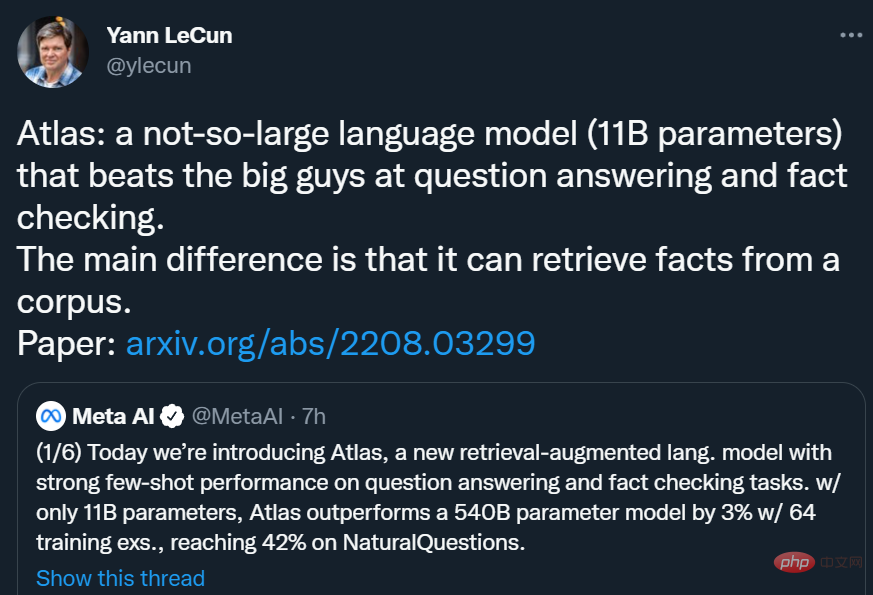

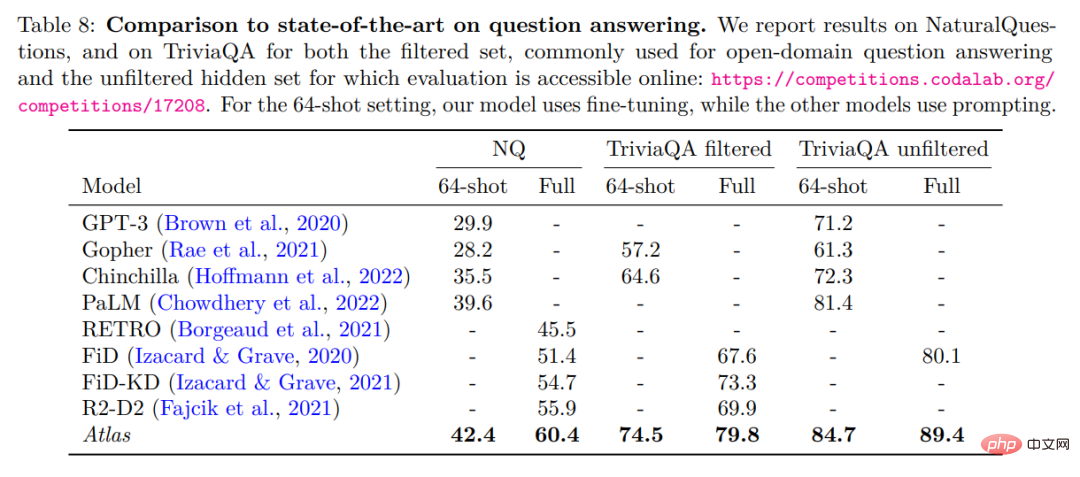

Avec seulement 11B de paramètres, Atlas utilise 64 exemples d'entraînement pour atteindre une précision de 42,4 % sur NaturalQuestions (NQ), soit près de 3 points de pourcentage de plus que le modèle de paramètres 540B PaLM (39,6 %) et est le meilleur au monde. . Dans le paramètre Ensemble de données (Complet), le taux de précision est de 64,0 %.

Yann LeCun a déclaré : Atlas est un modèle de langage pas trop gros (paramètres 11B) qui bat les « grands » en matière de questions/réponses et de vérification des faits. La principale différence d’Atlas est qu’il peut récupérer des faits à partir d’un corpus.

Yann LeCun a déclaré : Atlas est un modèle de langage pas trop gros (paramètres 11B) qui bat les « grands » en matière de questions/réponses et de vérification des faits. La principale différence d’Atlas est qu’il peut récupérer des faits à partir d’un corpus.

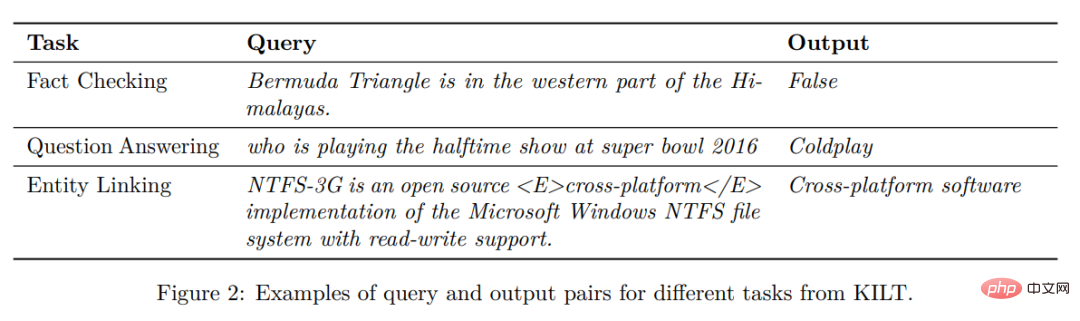

Présentation de la méthode Atlas suit un cadre texte-texte. Cela signifie que le cadre général de toutes les tâches est le suivant : le système prend une requête de texte en entrée et génère une sortie de texte. Par exemple, dans le cas de tâches de questions et réponses, la requête correspond à une question et le modèle doit générer une réponse. Dans le cas de tâches de classification, la requête correspond à la saisie de texte et le modèle génère des étiquettes de classe, c'est-à-dire les mots correspondant aux étiquettes. Le benchmark KILT de la figure 2 donne plus d'exemples de tâches en aval. De nombreuses tâches de traitement du langage naturel nécessitent des connaissances, et Atlas vise à améliorer les modèles texte-texte standard grâce à la récupération, car la récupération peut être essentielle à la capacité du modèle à apprendre dans des scénarios sur petits échantillons.

Atlas suit un cadre texte-texte. Cela signifie que le cadre général de toutes les tâches est le suivant : le système prend une requête de texte en entrée et génère une sortie de texte. Par exemple, dans le cas de tâches de questions et réponses, la requête correspond à une question et le modèle doit générer une réponse. Dans le cas de tâches de classification, la requête correspond à la saisie de texte et le modèle génère des étiquettes de classe, c'est-à-dire les mots correspondant aux étiquettes. Le benchmark KILT de la figure 2 donne plus d'exemples de tâches en aval. De nombreuses tâches de traitement du langage naturel nécessitent des connaissances, et Atlas vise à améliorer les modèles texte-texte standard grâce à la récupération, car la récupération peut être essentielle à la capacité du modèle à apprendre dans des scénarios sur petits échantillons.

Architecture Le modèle Atlas est basé sur deux sous-modèles : le retriever et le modèle de langage. Lors de l'exécution d'une tâche, de la réponse aux questions à la génération d'articles Wikipédia, le modèle récupère d'abord les k principaux documents pertinents d'un grand corpus de texte via un outil d'extraction. Ces documents, ainsi que la requête, sont ensuite transmis en entrée au modèle de langage, qui génère une sortie. Le récupérateur et le modèle de langage sont tous deux basés sur des réseaux de transformateurs pré-entraînés, qui sont décrits en détail ci-dessous.

Le modèle Atlas est basé sur deux sous-modèles : le retriever et le modèle de langage. Lors de l'exécution d'une tâche, de la réponse aux questions à la génération d'articles Wikipédia, le modèle récupère d'abord les k principaux documents pertinents d'un grand corpus de texte via un outil d'extraction. Ces documents, ainsi que la requête, sont ensuite transmis en entrée au modèle de langage, qui génère une sortie. Le récupérateur et le modèle de langage sont tous deux basés sur des réseaux de transformateurs pré-entraînés, qui sont décrits en détail ci-dessous.

Récupération : le module de récupération d'Atlas est basé sur Contriever, une technologie de récupération d'informations basée sur l'intégration de densité continue. Contriever utilise une architecture à double encodeur dans laquelle les requêtes et les documents sont intégrés indépendamment par des encodeurs de transformateur. Une mutualisation moyenne est appliquée à la sortie de la dernière couche pour obtenir une représentation vectorielle de chaque requête ou document. Ensuite, en calculant le produit scalaire des intégrations mutuelles entre la requête et chaque document, leurs scores de similarité sont obtenus. Le modèle Contriever est pré-entraîné à l'aide de la perte contrastive MoCo et utilise uniquement des données non supervisées. L'un des avantages des récupérateurs de densité est que les encodeurs de requêtes et de documents peuvent être formés sans annotations de documents à l'aide de techniques standard telles que la descente de gradient et la distillation.

Modèle de langage : pour le modèle de langage, Atlas s'appuie sur l'architecture séquence à séquence T5. Le modèle s'appuie également sur les modifications Fusion-in-Decoder du modèle séquence à séquence et traite chaque document indépendamment dans l'encodeur. Le modèle concatène ensuite les sorties des encodeurs correspondant à différents documents et effectue une attention croisée sur une seule séquence dans le décodeur. Le modèle connecte la requête à chaque document dans l'encodeur. Une autre façon de traiter les documents récupérés dans un modèle de langage consiste à concaténer la requête et tous les documents et à utiliser cette longue séquence comme entrée dans le modèle. Mais cette méthode est moins évolutive, c'est-à-dire qu'elle ne s'adaptera pas à mesure que le nombre de documents augmente, car le mécanisme d'auto-attention de l'encodeur conduira à une complexité temporelle de O(n^2) (où n est le nombre de documents). documents ).

Résultats expérimentaux

Les auteurs évaluent Atlas sur deux critères de réponse aux questions en domaine ouvert, NaturalQuestions et TriviaQA. Et un petit ensemble de données de 64 échantillons et un ensemble de formation complet ont été utilisés pour comparer avec les travaux antérieurs. La comparaison détaillée est présentée dans le tableau ci-dessous.

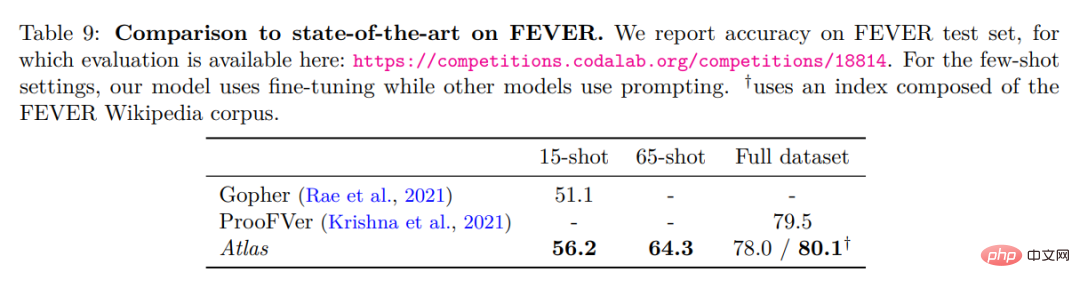

Meilleure performance en 64 questions et réponses de NaturalQuestions et TriviaQA. Il surpasse notamment les modèles plus grands (PaLM) ou les modèles nécessitant plus de calculs d’entraînement (Chinchilla). Atlas peut également obtenir des résultats optimaux en utilisant l'ensemble complet d'entraînement, par exemple en augmentant la précision des NaturalQuestions de 55,9 % à 60,4 %. Ce résultat a été obtenu avec les paramètres par défaut d'Atlas, en utilisant un index composé de CCNet et du corpus Wikipédia de décembre 2021. Le tableau ci-dessous présente les résultats des tests sur l'ensemble de données de vérification des faits FEVER.

Atlas Dans le cas de 64 coups, les échantillons d'entraînement sont échantillonnés à partir de l'ensemble d'entraînement complet. Atlas a atteint une précision de 64,3 %. Dans le cas de 15 tirs, 5 échantillons sont uniformément échantillonnés dans chaque classe. Par rapport aux résultats de Gopher, la précision d'Atlas est de 56,2 %, soit 5,1 points de pourcentage de plus que celle de Gopher. Le modèle Atlas a été affiné sur l'ensemble complet de la formation et a atteint une précision de 78 %, soit 1,5 % de moins que ProoFVer. ProoFVer utilise une architecture spécialisée pour former les récupérateurs avec des annotations au niveau des phrases et est fourni par le corpus Wikipédia publié avec FEVER, tandis qu'Atlas récupère à partir de CCNet et du dump Wikipédia de décembre 2021. Lorsqu'on lui a donné un indice constitué du corpus Wikipédia FEVER, Atlas a atteint un niveau optimal de 80,1 %.

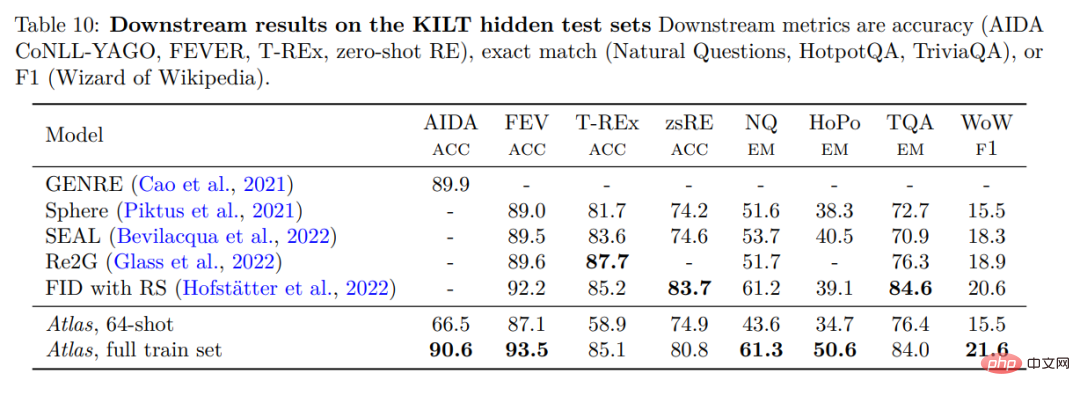

Pour vérifier les performances d'Atlas, Atlas a été évalué sur KILT, un benchmark composé de plusieurs tâches différentes à forte intensité de connaissances. Le tableau ci-dessous montre les résultats sur l'ensemble de test.

Atlas 64-shot surpasse de loin les algorithmes aléatoires dans les expériences et est même à égalité avec certains modèles affinés du classement. Par exemple, sur FEVER, Atlas 64-shot n'a que 2 à 2,5 points de retard sur Sphere, SEAL et Re2G, tandis que sur Zero-shot RE, il surpasse Sphere et SEAL. Sur l’ensemble de données complet, les performances d’Atlas se situent à 3 % près du meilleur modèle dans 3 ensembles de données, mais elles sont les meilleures dans les 5 ensembles de données restants.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI