Maison >Périphériques technologiques >IA >Capacités d'IA visuelle unifiée ! Détection et segmentation automatisées d'images, et images vincentiennes contrôlables, produites par une équipe chinoise

Capacités d'IA visuelle unifiée ! Détection et segmentation automatisées d'images, et images vincentiennes contrôlables, produites par une équipe chinoise

- 王林avant

- 2023-04-12 17:31:171196parcourir

Cet article est réimprimé avec l'autorisation d'AI New Media Qubit (ID de compte public : QbitAI). Veuillez contacter la source pour la réimpression.

Il est maintenant vraiment temps de rivaliser avec la vitesse des mains dans le cercle de l'IA.

Non, le SAM de Meta vient d'être lancé il y a quelques jours, et les programmeurs nationaux sont venus superposer les buffs, intégrant en un seul détection de cible, segmentation et génération de fonctions majeures d'IA visuelle !

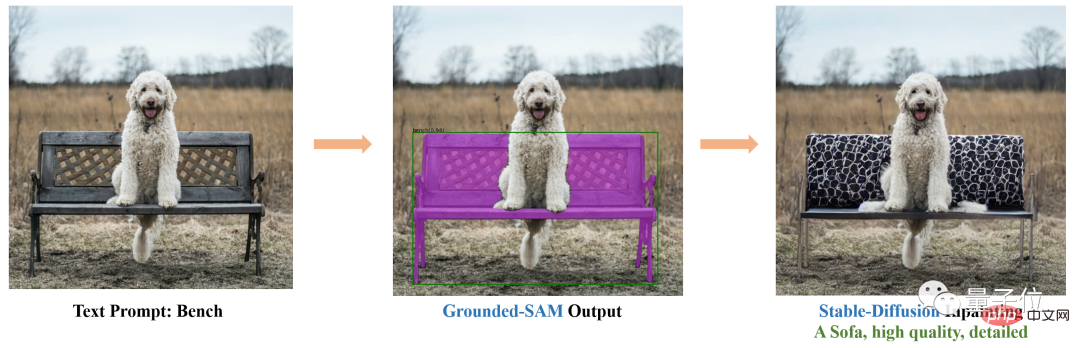

Par exemple, grâce à Stable Diffusion et SAM, vous pouvez facilement remplacer la chaise sur la photo par un canapé :

Changer de vêtements et de couleur de cheveux est également très simple :

Dès que le projet est lancé est sorti, beaucoup de gens se sont exclamés : La vitesse de la main est trop rapide !

Quelqu'un d'autre a dit : Il y a de nouvelles photos de mariage de Yui Aragaki et moi.

Ce qui précède est l'effet apporté par Gounded-SAM Le projet a reçu 1,8k étoiles sur GitHub.

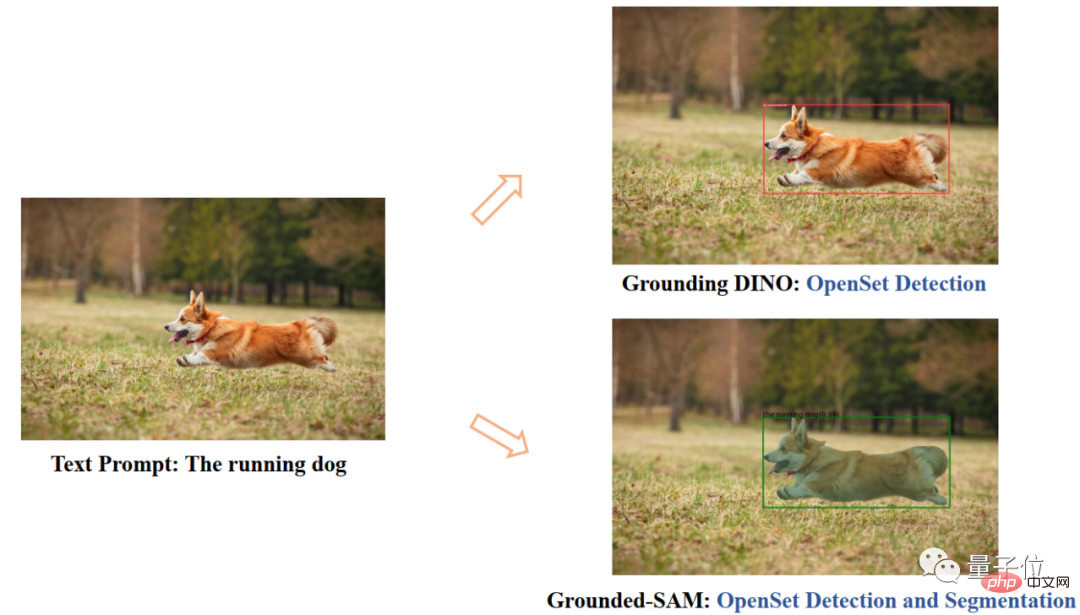

En termes simples, il s'agit d'une application de vision zéro qui n'a besoin que de saisir des images pour détecter et segmenter automatiquement les images.

Cette recherche provient de l'IDEA Research Institute (Institut de recherche sur l'économie numérique de la région de la Grande Baie de Guangdong-Hong Kong-Macao), dont le fondateur et président est Shen Xiangyang.

Aucune formation supplémentaire requise

Grounded SAM se compose principalement de deux modèles : Grounding DINO et SAM.

Parmi eux, SAM (Segment Anything) est un modèle de segmentation à échantillon zéro qui vient d'être lancé par Meta il y a 4 jours.

Il peut générer des masques pour tous les objets dans les images/vidéos, y compris les objets et les images qui ne sont pas apparus pendant le processus de formation.

En laissant SAM renvoyer un masque valide pour n'importe quelle invite, le modèle peut générer un masque raisonnable parmi toutes les possibilités, même si l'invite est ambiguë ou pointe vers plusieurs objets. Cette tâche est utilisée pour pré-entraîner le modèle et résoudre les tâches générales de segmentation en aval via des astuces.

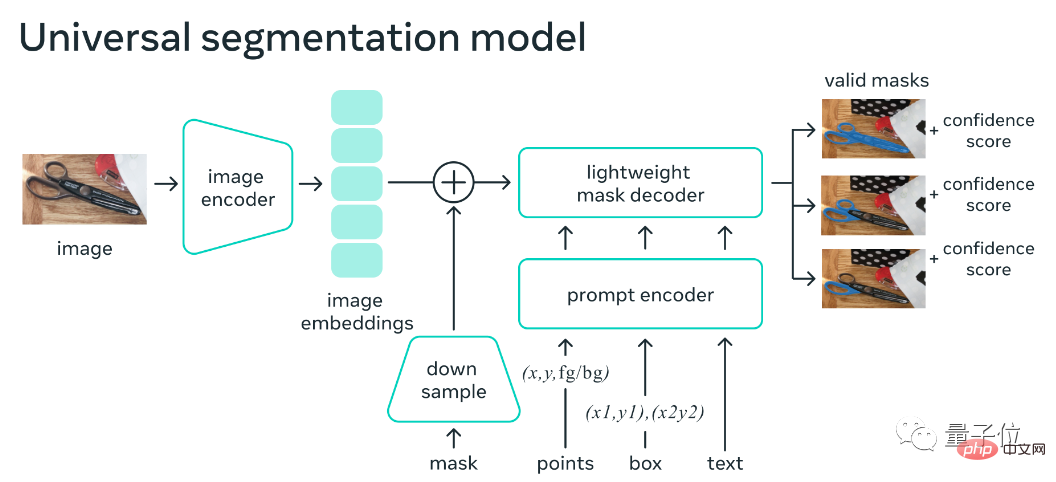

Le cadre du modèle se compose principalement d'un encodeur d'image, d'un encodeur d'indices et d'un décodeur de masque rapide. Après avoir calculé l'intégration de l'image, SAM est capable de générer une segmentation basée sur n'importe quelle invite du Web en 50 millisecondes.

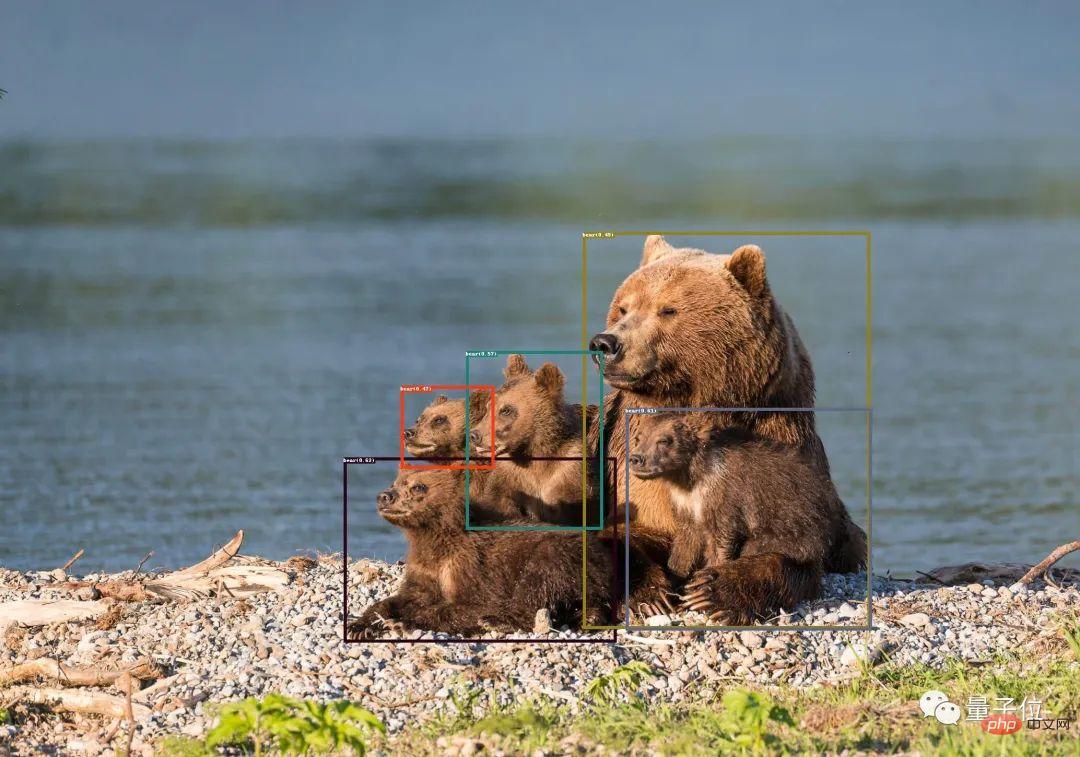

Grounding DINO est une réalisation existante de cette équipe de recherche.

Il s'agit d'un modèle de détection zéro tir, qui peut générer des boîtes d'objets et des étiquettes avec des descriptions textuelles.

Après avoir combiné les deux, vous pouvez trouver n'importe quel objet dans l'image via une description textuelle, puis utiliser les puissantes capacités de segmentation de SAM pour segmenter le masque de manière fine

En plus de ces capacités. , ils superposent également la capacité de diffusion stable, qui est la génération d'images contrôlables présentée au début.

Il convient de mentionner que Stable Diffusion était capable d'atteindre des fonctions similaires auparavant. Effacez simplement les éléments de l’image que vous souhaitez remplacer et entrez l’invite de texte.

Cette fois, Grounded SAM peut enregistrer l'étape de sélection manuelle et la contrôler directement via une description textuelle.

De plus, combiné au BLIP (Bootstrapping Language-Image Pre-training), il génère des titres d'images, extrait des étiquettes, puis génère des boîtes d'objets et des masques.

Actuellement, des fonctionnalités plus intéressantes sont en cours de développement.

Par exemple, quelques extensions de personnages : changement de vêtements, couleur de cheveux, couleur de peau, etc.

La méthode de consommation spécifique a également été donnée sur GitHub. Le projet nécessite Python 3.8 ou supérieur, pytorch 1.7 ou supérieur, torchvision 0.8 ou supérieur, et les dépendances associées doivent être installées. Pour un contenu spécifique, veuillez consulter la page du projet GitHub.

L'équipe de recherche est issue de l'IDEA Research Institute (Institut de recherche sur l'économie numérique de la région de la Grande Baie de Guangdong-Hong Kong-Macao).

Les informations publiques montrent que l'institut est une institution internationale de recherche innovante dans le domaine de l'intelligence artificielle, de l'industrie de l'économie numérique et des technologies de pointe. L'ancien scientifique en chef du Microsoft Asia Research Institute et ancien vice-président de Microsoft Global Intelligence Dr Shen Xiangyang. est le fondateur et le président.

One More Thing

Pour les travaux futurs de Grounded SAM, l'équipe a plusieurs perspectives :

- Générer automatiquement des images pour former un nouvel ensemble de données

- Modèle de base puissant avec pré-formation à la segmentation

- Coopérer avec (Chat- )GPT

- Constituez un pipeline qui génère automatiquement des étiquettes, des boîtes et des masques d'image, et peut générer de nouvelles images.

Il convient de mentionner que de nombreux membres de l'équipe de ce projet sont des répondants actifs dans le domaine de l'IA sur Zhihu. Cette fois, ils ont également répondu aux questions sur Grounded SAM sur les chaussures pour enfants intéressés. Vous pouvez laisser un message pour obtenir des conseils ~.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI