Maison >Périphériques technologiques >IA >DALL-E et Flamingo peuvent-ils se comprendre ? Trois réseaux neuronaux SOTA pré-entraînés unifient les images et le texte

DALL-E et Flamingo peuvent-ils se comprendre ? Trois réseaux neuronaux SOTA pré-entraînés unifient les images et le texte

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 16:49:101371parcourir

Un objectif important de la recherche multimodale est d'améliorer la capacité de la machine à comprendre les images et le texte. En particulier, les chercheurs ont déployé de grands efforts pour parvenir à une communication significative entre les deux modèles. Par exemple, la génération de sous-titres d’images devrait être capable de convertir le contenu sémantique de l’image en un texte cohérent et compréhensible par les humains. En revanche, les modèles génératifs texte-image peuvent également exploiter la sémantique des descriptions textuelles pour créer des images réalistes.

Cela amène à quelques questions intéressantes liées à la sémantique : pour une image donnée, quelle description textuelle décrit le plus précisément l'image ? De même, pour un texte donné, quelle est la manière la plus significative de mettre en œuvre une image ? Concernant la première question, certaines études affirment que la meilleure description d’image doit être une information à la fois naturelle et capable de restituer le contenu visuel. Quant à la deuxième question, les images significatives doivent être de haute qualité, diversifiées et fidèles au contenu du texte.

Dans tous les cas, motivées par la communication humaine, des tâches interactives impliquant des modèles génératifs texte-image et des modèles génératifs image-texte peuvent nous aider à sélectionner les paires image-texte les plus précises.

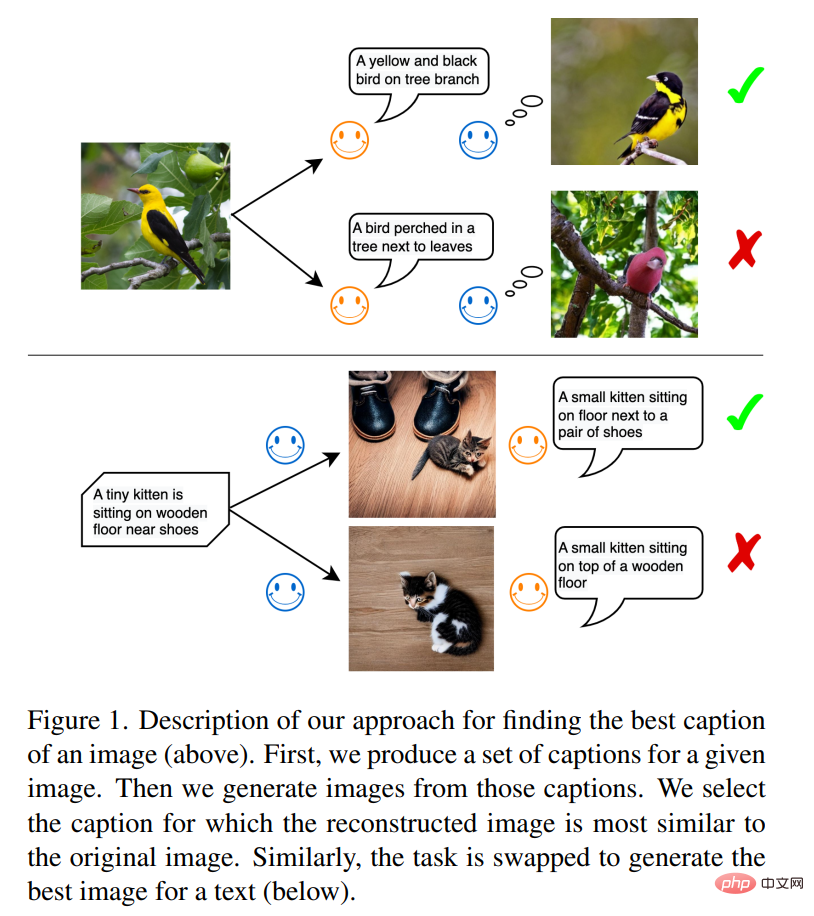

Comme le montre la figure 1, dans la première tâche, le modèle image-texte est l'expéditeur de l'information et le modèle texte-image est le récepteur de l'information. L'objectif de l'émetteur est de communiquer le contenu de l'image au destinataire en utilisant le langage naturel afin qu'il comprenne le langage et reconstruise une représentation visuelle réaliste. Une fois que le récepteur peut reconstruire les informations de l’image originale avec une haute fidélité, cela indique que les informations ont été transférées avec succès. Les chercheurs pensent que la description textuelle générée de cette manière est optimale et que l'image générée par celle-ci est également la plus similaire à l'image originale.

Cette règle s’inspire de l’utilisation du langage par les gens pour communiquer. Imaginez le scénario suivant : lors d'une scène d'appel d'urgence, la police apprend par téléphone l'accident de voiture et l'état des blessés. Il s’agit essentiellement du processus de description d’images par les témoins présents sur les lieux. La police doit reconstruire mentalement la scène environnementale sur la base de la description verbale afin d'organiser une opération de sauvetage appropriée. Évidemment, la meilleure description textuelle devrait être le meilleur guide pour la reconstruction de la scène.

La deuxième tâche implique la reconstruction de texte : le modèle texte-image devient l'expéditeur du message, et le modèle image-texte devient le récepteur du message. Une fois que les deux modèles s'accordent sur le contenu de l'information au niveau textuel, le support image utilisé pour véhiculer l'information est l'image optimale qui reproduit le texte source.

Dans cet article, la méthode proposée par des chercheurs de l'Université de Munich, de Siemens et d'autres institutions est étroitement liée à la communication entre agents. La langue est la principale méthode d’échange d’informations entre agents. Mais comment pouvons-nous être sûrs que le premier agent et le deuxième agent ont la même compréhension de ce qu’est un chat ou d’un chien ?

Adresse papier : https://arxiv.org/pdf/2212.12249.pdf

L'idée que cet article souhaite explorer est de laisser le premier agent analyser l'image et générer une description du texte de l'image, puis le deuxième agent récupère le texte et simule l'image en fonction de celui-ci. Parmi eux, ce dernier processus peut être considéré comme un processus d’incarnation. L'étude estime que la communication réussit si l'image simulée par le deuxième agent est similaire à l'image d'entrée reçue par le premier agent (voir Figure 1).

Dans les expériences, cette étude a utilisé des modèles disponibles dans le commerce, en particulier des modèles pré-entraînés à grande échelle récemment développés. Par exemple, Flamingo et BLIP sont des modèles de description d'images qui peuvent générer automatiquement des descriptions textuelles basées sur des images. De même, les modèles de génération d'images formés sur des paires image-texte peuvent comprendre la sémantique profonde du texte et synthétiser des images de haute qualité, telles que le modèle DALL-E et le modèle de diffusion latente (SD).

De plus, l'étude utilise également le modèle CLIP pour comparer des images ou du texte. CLIP est un modèle de langage visuel qui mappe les images et le texte dans un espace d'intégration partagé. Cette étude utilise des ensembles de données de texte d'image créés manuellement tels que COCO et NoCaps pour évaluer la qualité du texte généré. Les modèles génératifs d'images et de textes comportent des composants stochastiques qui permettent d'échantillonner à partir de distributions, sélectionnant ainsi le meilleur parmi une gamme de textes et d'images candidats. Différentes méthodes d'échantillonnage, y compris l'échantillonnage par noyau, peuvent être utilisées dans les modèles de description d'image, et cet article utilise l'échantillonnage par noyau comme modèle de base pour montrer la supériorité de la méthode utilisée dans cet article.

Présentation de la méthode

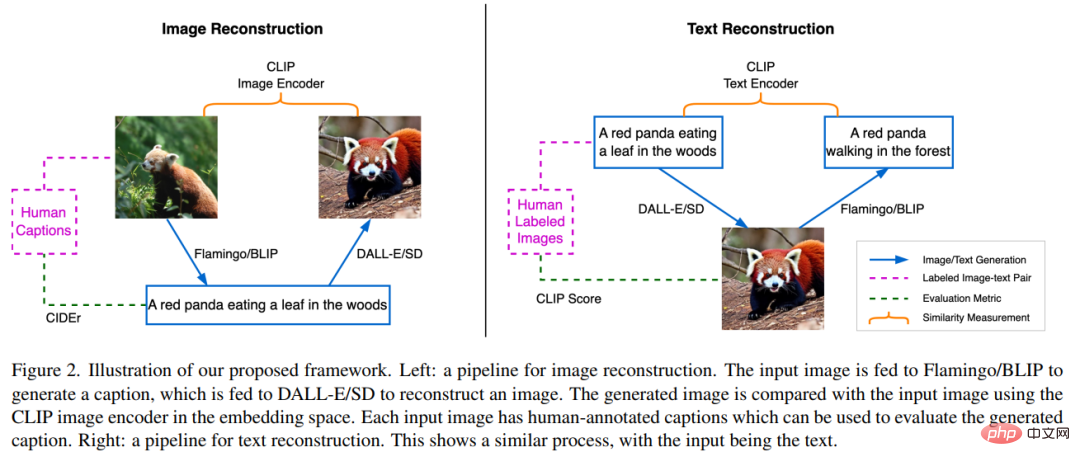

Le cadre de cet article se compose de trois réseaux de neurones SOTA pré-entraînés. Premièrement, le modèle de génération image-texte ; deuxièmement, le modèle de génération texte-image ; troisièmement, le modèle de représentation multimodale composé d'un encodeur d'image et d'un encodeur de texte, qui peuvent respectivement mapper des images ou des textes dans leurs intégrations sémantiques.

Reconstruction d'image par description textuelle

Comme le montre la moitié gauche de la figure 2, la tâche de reconstruction d'image consiste à utiliser le langage comme instructions pour reconstruire l'image source. favoriser la description de la scène source pour une génération de texte optimale. Tout d’abord, une image source x est introduite dans le modèle BLIP pour générer plusieurs textes candidats y_k. Par exemple, un panda roux mange des feuilles dans les bois. L'ensemble de textes candidats générés est noté C, puis le texte y_k est envoyé au modèle SD pour générer l'image x'_k. Ici, x'_k fait référence à l'image générée à partir du panda rouge. Par la suite, l'encodeur d'images CLIP est utilisé pour extraire les caractéristiques sémantiques :  et

et  de la source et des images générées.

de la source et des images générées.

Ensuite, la similarité cosinus entre ces deux vecteurs d'intégration est calculée dans le but de trouver la description du texte candidat y_s, c'est-à-dire

où s est l'index d'image le plus proche de l'image source.

L'étude utilise CIDEr (Image Description Metric) et fait référence à des annotations humaines pour évaluer les meilleurs textes. Puisque nous nous intéressons à la qualité du texte généré, cette étude définit le modèle BLIP pour produire un texte à peu près de la même longueur. Cela garantit une comparaison relativement équitable, car la longueur du texte est positivement corrélée à la quantité d’informations contenues dans l’image qui peuvent être transmises. Durant ce travail, tous les modèles seront figés et aucun réglage fin ne sera effectué.

Reconstruction de texte à partir d'images

La partie droite de la figure 2 montre le processus inverse du processus décrit dans la section précédente. Le modèle BLIP nécessite de deviner le texte source guidé par une SD, qui a accès au texte mais ne peut restituer son contenu que sous forme d'image. Le processus commence par utiliser SD pour générer des images candidates x_k pour le texte y, et l'ensemble résultant d'images candidates est noté K. La génération d'images à l'aide de SD implique un processus d'échantillonnage aléatoire, où chaque processus de génération peut aboutir à différents échantillons d'images valides dans un immense espace de pixels. Cette diversité d'échantillonnage fournit un pool de candidats pour filtrer les meilleures images. Par la suite, le modèle BLIP génère une description textuelle y’_k pour chaque image échantillonnée x_k. Ici, y’_k fait référence au texte initial Un panda roux rampe dans la forêt. L'étude utilise ensuite l'encodeur de texte CLIP pour extraire les caractéristiques du texte source et du texte généré, désignées respectivement par  et

et  . Le but de cette tâche est de trouver la meilleure image candidate x_s qui correspond à la sémantique du texte y. Pour ce faire, l'étude doit comparer la distance entre le texte généré et le texte saisi, puis sélectionner l'image avec la plus petite distance de texte appariée, c'est-à-dire

. Le but de cette tâche est de trouver la meilleure image candidate x_s qui correspond à la sémantique du texte y. Pour ce faire, l'étude doit comparer la distance entre le texte généré et le texte saisi, puis sélectionner l'image avec la plus petite distance de texte appariée, c'est-à-dire

L'étude estime que l'image x_s peut décrire au mieux la description du texte y, car il peut fournir du contenu au destinataire avec une perte d'informations minimale. De plus, l'étude traite l'image  correspondant au texte y comme une présentation de référence de y et quantifie la meilleure image comme sa proximité avec l'image de référence.

correspondant au texte y comme une présentation de référence de y et quantifie la meilleure image comme sa proximité avec l'image de référence.

Résultats expérimentaux

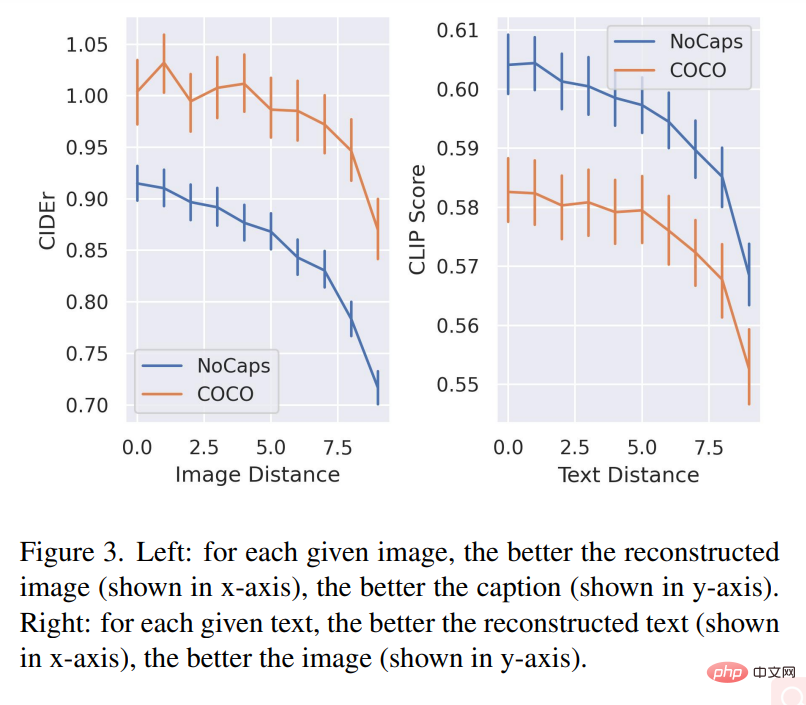

Le graphique de gauche de la figure 3 montre la corrélation entre la qualité de la reconstruction de l'image et la qualité du texte de description sur les deux ensembles de données. Pour chaque image donnée, plus la qualité de l'image reconstruite (affichée sur l'axe des x) est bonne, meilleure est la qualité de la description du texte (affichée sur l'axe des y).

Le graphique de droite de la figure 3 révèle la relation entre la qualité du texte récupéré et la qualité de l'image générée : pour chaque texte donné, meilleure est la description du texte reconstruit (affichée sur l'axe des x), meilleure est la qualité de l'image ( affiché sur l’axe y) est meilleur.

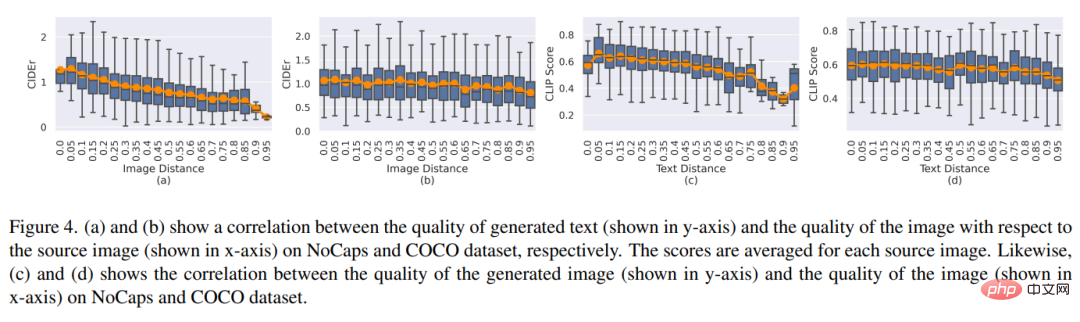

Les figures 4(a) et (b) montrent la relation entre la qualité de la reconstruction de l'image et la qualité moyenne du texte basée sur les images sources. Les figures 4 (c) et (d) montrent la corrélation entre la distance du texte et la qualité de l'image reconstruite.

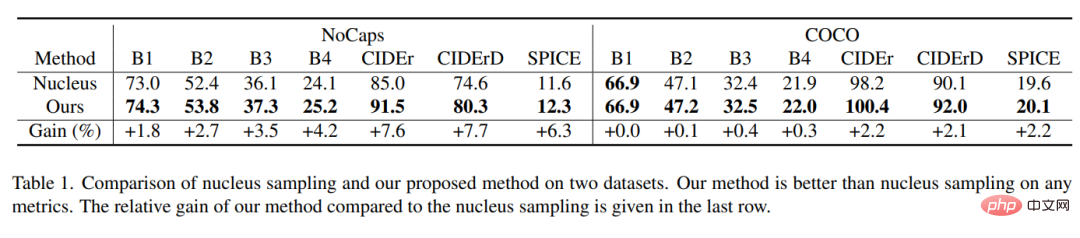

Le tableau 1 montre que la méthode d'échantillonnage de l'étude surpasse l'échantillonnage par noyau dans chaque métrique, et le gain relatif du modèle peut atteindre 7,7 %.

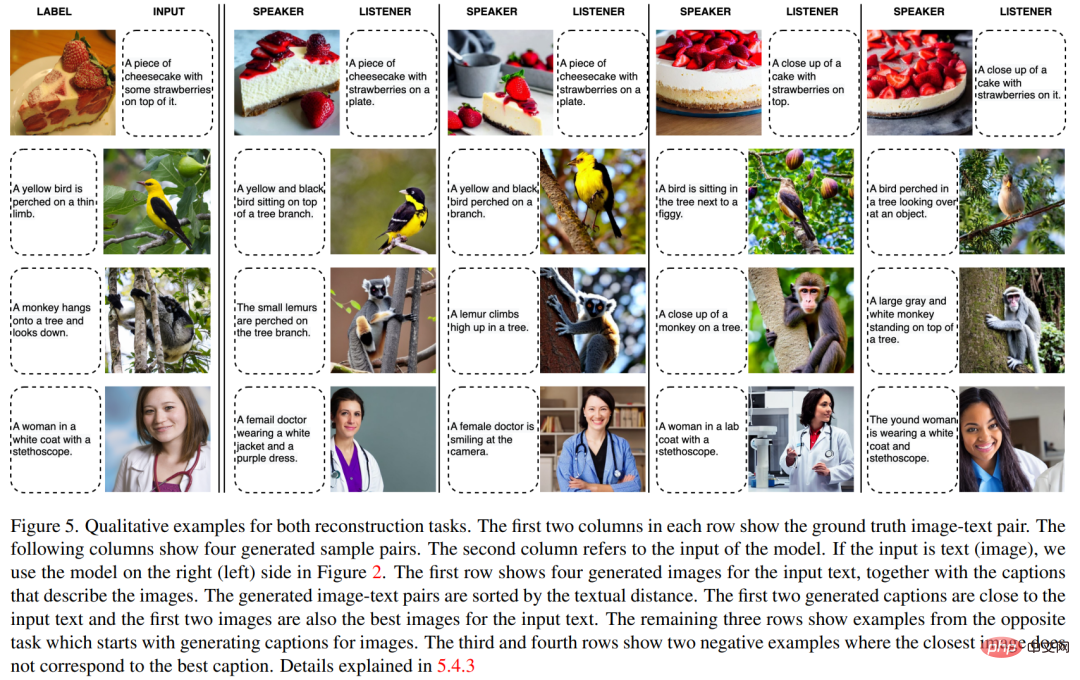

La figure 5 montre des exemples qualitatifs de deux tâches de reconstruction.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI