Maison >Périphériques technologiques >IA >OpenAI lance GPT-4, qui a une plus grande capacité de résolution de questions. Il accepte également la saisie d'images, ce qui facilite la compréhension des mèmes !

OpenAI lance GPT-4, qui a une plus grande capacité de résolution de questions. Il accepte également la saisie d'images, ce qui facilite la compréhension des mèmes !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 16:13:041741parcourir

GPT-4 est enfin disponible !

Après le carnaval des marchés financiers, GPT-4 est né sous les projecteurs. OpenAI a publié ce dernier modèle sur son site officiel avec le titre "GPT-4 est le système le plus avancé d'OpenAI, capable de produire des réponses plus sûres et plus utiles".

Cette itération n'est pas lente du tout. ChatGPT a été lancée il y a à peine quatre mois et est devenue l'application grand public à la croissance la plus rapide de l'histoire.

En général, GPT-4 améliore la technologie de base de ChatGPT, ce qui lui confère un plus large éventail de connaissances générales et de capacités de résolution de problèmes que les versions précédentes, permettant au logiciel de chat de résoudre des problèmes plus difficiles avec une plus grande précision.

De plus, il ajoute également de nouvelles fonctionnalités, telles que l'acceptation d'images en entrée, la génération de titres, la classification et l'analyse.

GPT-4 est également capable de traiter du texte de plus de 25 000 mots, permettant des applications telles que la création de contenu long, les conversations étendues, la recherche et l'analyse de documents, et bien plus encore.

Nouvelles fonctionnalités : compréhension accessible des mèmes

L'une des plus grandes mises à jour du modèle GPT-4 est qu'il introduit des images en entrée et génère des légendes, une classification et une analyse pour celles-ci, tandis que GPT-3.5 ne peut accepter que du texte. .

Par exemple, l'exemple suivant :

Question : Qu'est-ce qu'il y a de drôle dans cette image ? Décrivez-la petit à petit.

Réponse GPT-4 : Cette image montre un adaptateur "Lightning Cable" avec trois images.

Figure 1 : Un smartphone doté d'un connecteur VGA (un grand connecteur bleu à 15 broches généralement utilisé sur les écrans d'ordinateur) branché sur son port de chargement.

Figure 2 : L'emballage de l'adaptateur « Lightning Cable », avec une photo du connecteur VGA dessus.

Figure 3 : Gros plan du connecteur VGA, se terminant par un petit connecteur Lightning (utilisé pour charger les iPhones et autres appareils Apple).

L'humour de cette image vient de l'absurdité de brancher un gros connecteur VGA obsolète dans un petit port de chargement de smartphone moderne.

Actuellement, bien que GPT-4 ne soit pas assez puissant pour permettre la génération de texte en vidéo et d'autres contenus générés dynamiquement, il donne un aperçu de ce à quoi ressemblera le chat multi-éléments dans le futur, et il est facile de imaginez qu'à l'avenir, comment la vidéo, l'audio, les images et toutes les autres formes de contenu seront intégrés dans le chat.

Anciennes capacités : lorsque la tâche est suffisamment complexe, GPT-4 sera un cran au-dessus de GPT-3.5

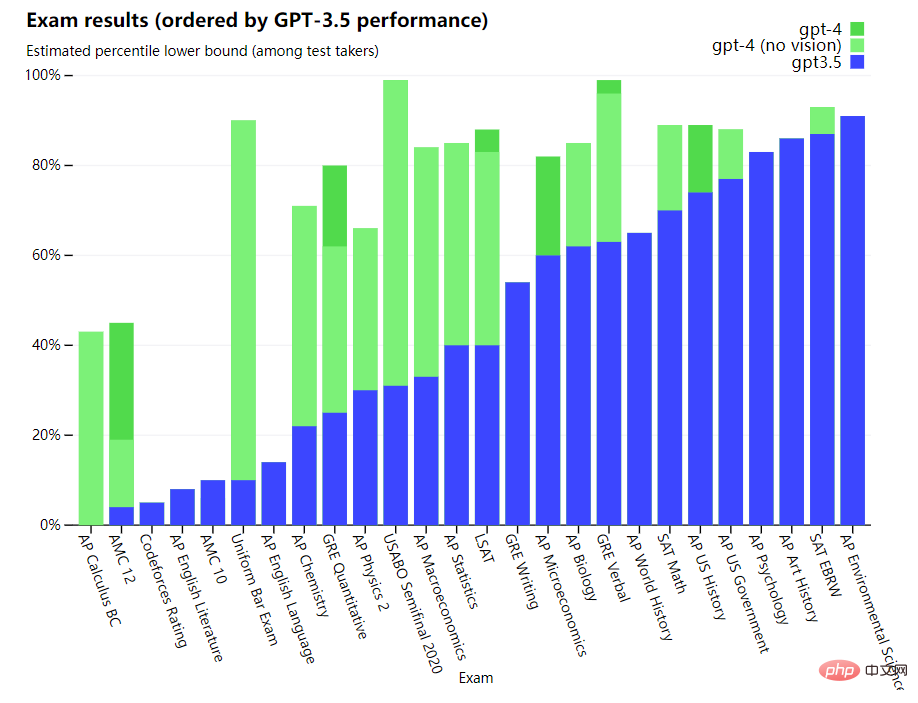

GPT-4, car la dernière étape d'OpenAI dans l'expansion de l'apprentissage profond, est essentiellement un grand modèle multimodal ((accepte la saisie d'images et de texte, émet une sortie de texte), bien qu'inférieures à celles des humains dans de nombreux scénarios du monde réel, ses capacités sont proches, voire dépassent, les performances du niveau humain sur divers critères professionnels et universitaires.

Par exemple, il a réussi l'examen du barreau simulé avec des scores se situant autour des 10 % supérieurs, tandis que GPT-3.5 a obtenu des scores se situant autour des 10 % inférieurs ;

La différence entre GPT-3.5 et GPT-4 peut être subtile s'il ne s'agit que d'une conversation informelle, mais lorsque la complexité de la tâche atteint un seuil suffisant, la différence devient apparente ーー Comparé à GPT-3.5, GPT-4 est plus fiable, plus créatif et capable de gérer des instructions plus nuancées.

Pour comprendre la différence entre les deux modèles, OpenA a testé divers benchmarks, notamment des examens de simulation conçus à l'origine pour les humains, et on peut constater que dans des tests plus avancés, GPT-4 fonctionne bien mieux que GPT-3.5.

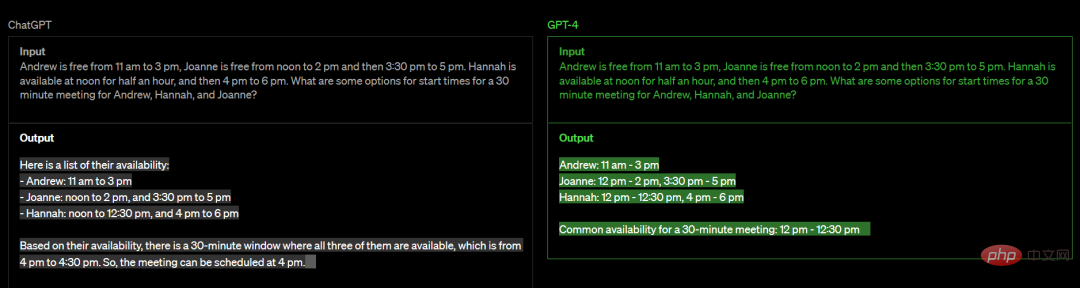

Pour un autre exemple, on peut voir que GPT-4 a de meilleures capacités de compréhension.

OMT : introduction de commentaires plus humains

Pour augmenter la complexité du modèle, GPT-4 intègre également davantage de commentaires humains, y compris les commentaires soumis par les utilisateurs de ChatGPT, pour améliorer le comportement de GPT-4. OpenAI a déclaré que la société "travaille avec plus de 50 experts pour fournir des commentaires précoces dans des domaines tels que la sûreté et la sécurité de l'IA

".Dans le cadre de cette annonce, OpenAI a partagé les cas d'utilisation de plusieurs entreprises qui ont testé GPT-4, notamment Duolingo, Stripe, Morgan Stanley et le gouvernement islandais. La société a également partagé un blog de recherche sur GPT-4, soulignant que « GPT-4 présente encore de nombreuses limites connues que nous travaillons dur pour résoudre, telles que les préjugés sociaux, les hallucinations et les invites contradictoires.

Informaticien, Brown University Suresh. » Venkatasubramanian, professeur à l'Université Brown, reste prudemment optimiste quant à cette nouvelle. Dans une interview avec VentureBeat, il a déclaré : « Je serais intéressé de voir comment ChatGPT se comporte lors d'un test de résistance sous le regard du public, et je suis particulièrement intéressé de savoir si et comment il peut produire un contenu trompeusement authentique, et quelles protections. sont en place pour empêcher que cela ne se produise. »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI