Maison >Périphériques technologiques >IA >Une étude montre que les grands modèles de langage ont des problèmes de raisonnement logique

Une étude montre que les grands modèles de langage ont des problèmes de raisonnement logique

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 15:19:031384parcourir

Traducteur | Li Rui

Réviseur | Sun Shujuan

Avant que les chatbots dotés de sensibilité ne deviennent un sujet brûlant, les grands modèles de langage (LLM) suscitaient déjà plus d'enthousiasme et d'inquiétude. Ces dernières années, les grands modèles linguistiques (LLM), des modèles d'apprentissage profond formés sur de grandes quantités de texte, ont obtenu de bons résultats sur plusieurs critères utilisés pour mesurer les capacités de compréhension du langage.

Les grands modèles linguistiques tels que GPT-3 et LaMDA parviennent à maintenir la cohérence sur des textes plus longs. Ils semblent bien informés sur différents sujets et restent cohérents tout au long des longues conversations. Les grands modèles de langage (LLM) sont devenus si convaincants que certaines personnes les associent à la personnalité et à des formes supérieures d'intelligence.

Mais les grands modèles linguistiques (LLM) peuvent-ils effectuer un raisonnement logique comme les humains ? Transformers, une architecture d'apprentissage profond utilisée dans les grands modèles de langage (LLM), n'apprend pas à simuler les capacités de raisonnement, selon un article de recherche publié par des scientifiques de l'UCLA. Au lieu de cela, les ordinateurs ont trouvé des moyens intelligents d’apprendre les propriétés statistiques inhérentes aux problèmes de raisonnement.

Les chercheurs ont testé l'architecture Transformer BERT actuellement populaire dans un espace problématique limité. Leurs résultats montrent que BERT peut répondre avec précision aux problèmes d'inférence sur des exemples au sein d'une distribution dans l'espace de formation, mais ne peut pas généraliser à des exemples dans d'autres distributions basées sur le même espace de problèmes.

Et ces tests mettent en évidence certaines des lacunes des réseaux de neurones profonds et les benchmarks utilisés pour les évaluer.

1. Comment mesurer le raisonnement logique en intelligence artificielle ?

Il existe plusieurs benchmarks pour les systèmes d'intelligence artificielle ciblant les problèmes de traitement et de compréhension du langage naturel, tels que GLUE, SuperGLUE, SNLI et SqUAD. Au fur et à mesure que Transformer s'est développé et a été formé sur des ensembles de données plus volumineux, Transformer a pu améliorer progressivement ces références.

Il convient de noter que les performances des systèmes d’IA sur ces benchmarks sont souvent comparées à l’intelligence humaine. La performance humaine par rapport à ces critères est étroitement liée au bon sens et aux capacités de raisonnement logique. Mais il n’est pas clair si les grands modèles de langage s’améliorent parce qu’ils acquièrent des capacités de raisonnement logique ou parce qu’ils sont exposés à de grandes quantités de texte.

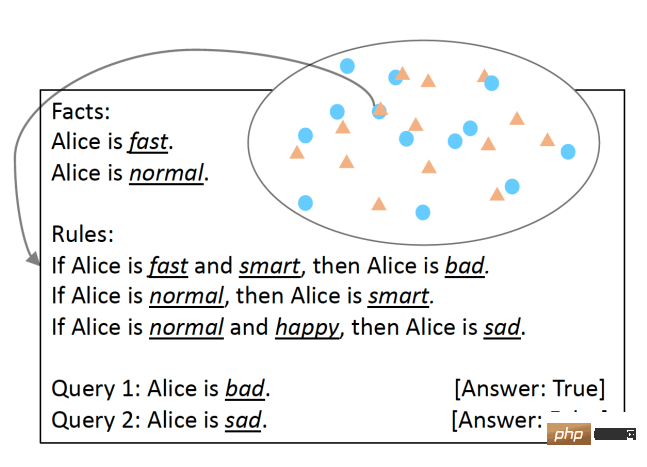

Pour tester cela, les chercheurs de l'UCLA ont développé SimpleLogic, une classe de questions de raisonnement logique basées sur la logique propositionnelle. Pour garantir que les capacités de raisonnement du modèle linguistique ont été rigoureusement testées, les chercheurs ont éliminé les différences linguistiques en utilisant des structures linguistiques modèles. Les problèmes SimpleLogic consistent en un ensemble de faits, de règles, de requêtes et d'étiquettes. Les faits sont des prédicats connus pour être « vrais ». Les règles sont des conditions, définies comme des termes. Une requête est une question à laquelle un modèle de machine learning doit répondre. L'étiquette est la réponse à la requête, c'est-à-dire « vrai » ou « faux ». Les questions SimpleLogic sont compilées en chaînes de texte continues contenant les signaux et délimiteurs attendus par le modèle de langage lors de la formation et de l'inférence.

Questions au format SimpleLogic L'une des caractéristiques de SimpleLogic est que ses questions sont autonomes et ne nécessitent aucune connaissance préalable. Ceci est particulièrement important car, comme le disent de nombreux scientifiques, lorsque les humains parlent, ils ignorent les connaissances partagées. C’est pourquoi les modèles linguistiques tombent souvent dans un piège lorsqu’on leur pose des questions sur les connaissances fondamentales du monde que tout le monde connaît. En revanche, SimpleLogic fournit aux développeurs tout ce dont ils ont besoin pour résoudre leurs problèmes. Par conséquent, tout développeur examinant un problème posé par le format SimpleLogic devrait être capable de déduire ses règles et de gérer de nouveaux exemples, quelles que soient ses connaissances de base.

2. Caractérisation statistique et inférence logique

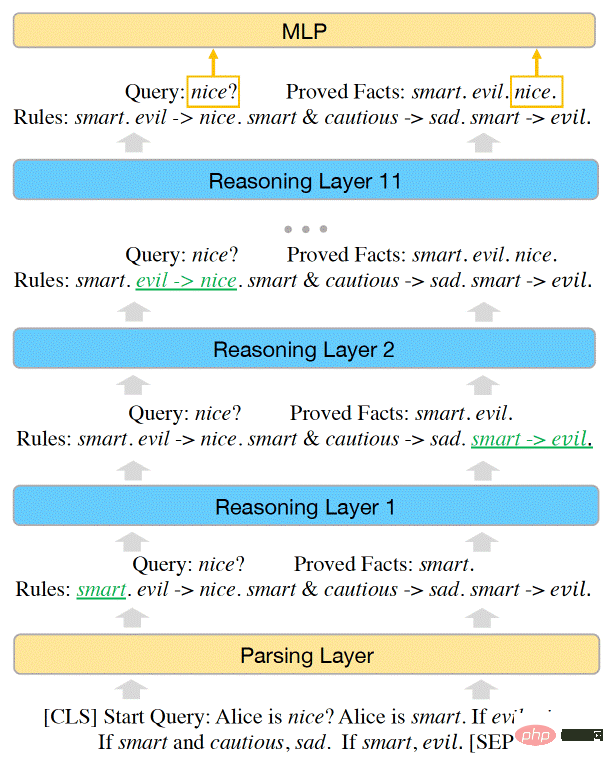

Les chercheurs ont démontré que l'espace du problème dans SimpleLogic peut être représenté par une fonction d'inférence. Les chercheurs ont en outre montré que BERT est suffisamment puissant pour résoudre tous les problèmes de SimpleLogic et qu'ils peuvent ajuster manuellement les paramètres du modèle d'apprentissage automatique pour représenter la fonction d'inférence.

Cependant, lorsqu'ils ont formé BERT sur l'exemple d'ensemble de données SimpleLogic, le modèle n'a pas pu apprendre la fonction d'inférence par lui-même. Les modèles d'apprentissage automatique parviennent à atteindre une précision presque parfaite sur une distribution de données. Mais cela ne se généralise pas à d’autres distributions au sein du même espace problématique. C'est le cas même si l'ensemble de données de formation couvre tout l'espace du problème et que toutes les distributions proviennent de la même fonction d'inférence.

La capacité du modèle BERT Transformer est suffisante pour représenter les capacités d'inférence de SimpleLogic

(Remarque : ceci est différent du défi de généralisation hors distribution, qui s'applique aux problèmes d'espace ouvert. Lorsque le modèle ne peut pas généraliser aux données OOD, lors du traitement. Lorsque les données sont en dehors de la plage de distribution de leur ensemble d'apprentissage, leurs performances chuteront considérablement)

Les chercheurs ont écrit : « Après une enquête plus approfondie, nous fournissons une explication à ce paradoxe : un modèle qui atteint une grande précision uniquement sur des exemples de tests de distribution n'a pas appris à raisonner. En fait, le modèle a appris à utiliser les caractéristiques statistiques des problèmes d'inférence logique. faire des prédictions, plutôt que de modéliser des fonctions d'inférence correctes. »

Cette découverte met en évidence un défi important dans l'utilisation de l'apprentissage en profondeur pour les tâches linguistiques. Les réseaux de neurones sont très efficaces pour découvrir et ajuster les caractéristiques statistiques. Dans certaines applications, cela peut être très utile. Par exemple, dans l’analyse des sentiments, il existe de fortes corrélations entre certains mots et catégories de sentiments.

Cependant, pour les tâches de raisonnement logique, même si des caractéristiques statistiques existent, le modèle doit essayer de trouver et d'apprendre les caractéristiques de raisonnement sous-jacentes.

"Il faut faire preuve de prudence lorsque nous tentons de former des modèles neuronaux de bout en bout pour résoudre des tâches de traitement du langage naturel (NLP) qui impliquent à la fois un raisonnement logique et des connaissances préalables et présentent des différences linguistiques", ont écrit les chercheurs. Les défis posés par SimpleLogic deviennent encore plus graves dans le monde réel, où les grandes quantités d'informations requises pour les grands modèles de langage (LLM) ne sont tout simplement pas contenues dans les données.

Les chercheurs ont observé que lorsqu'ils supprimaient une fonctionnalité statistique de l'ensemble de données de formation, les performances du modèle de langage s'amélioraient sur d'autres distributions du même espace problématique. Le problème, cependant, est qu’il est plus facile à dire qu’à faire de découvrir et de supprimer plusieurs fonctionnalités statistiques. Comme le soulignent les chercheurs dans leur article, « de telles caractéristiques statistiques peuvent être nombreuses et extrêmement complexes, ce qui les rend difficiles à supprimer des données de formation

3. L'inférence dans le Deep Learning

Malheureusement, en raison de la taille du langage. Le modèle augmente, le problème du raisonnement logique ne disparaît pas. C'est juste caché dans d'immenses architectures et de très grands corpus de formation. Les grands modèles de langage (LLM) peuvent très bien décrire des faits et assembler des phrases, mais en termes de raisonnement logique, ils utilisent toujours des fonctionnalités statistiques pour le raisonnement, ce qui ne constitue pas une base solide. De plus, rien n’indique qu’en ajoutant des couches, des paramètres et des attentions aux Transformers, le fossé du raisonnement logique sera comblé.

Cet article est cohérent avec d'autres travaux montrant les limites des réseaux de neurones dans l'apprentissage de règles logiques, comme le jeu de la vie ou le raisonnement abstrait à partir de données visuelles. L'article met en évidence l'un des principaux défis auxquels sont confrontés les modèles linguistiques actuels. Comme le soulignent les chercheurs de l'UCLA : « D'une part, lorsqu'un modèle est formé pour apprendre une tâche à partir de données, il a toujours tendance à apprendre des modèles statistiques qui sont intrinsèquement présents dans les exemples d'inférence. s'appuyer sur des modèles statistiques pour faire des inférences Comme il est difficile de construire un ensemble de données d'inférence logique qui ne contient pas de caractéristiques statistiques, il est difficile d'apprendre des inférences à partir des données ://bdtechtalks.com/2022/06/27/large-. modèles-de-langage-raisonnement-logique/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI