Maison >Périphériques technologiques >IA >Encyclopédie IA : comment fonctionne ChatGPT

Encyclopédie IA : comment fonctionne ChatGPT

- 王林avant

- 2023-04-12 13:31:034638parcourir

ChatGPT a rapidement attiré l'attention de millions de personnes, mais beaucoup se méfiaient car ils ne comprenaient pas comment cela fonctionnait. Et cet article est une tentative de le décomposer pour qu’il soit plus facile à comprendre.

Cependant, à la base, ChatGPT est un système très complexe. Si vous souhaitez jouer avec ChatGPT ou comprendre de quoi il s'agit, l'interface principale est une fenêtre de discussion dans laquelle vous pouvez poser des questions ou fournir des requêtes et l'IA répondra. Un détail important à retenir est que dans le chat, le contexte est préservé, ce qui signifie que les messages peuvent faire référence à des informations précédentes et ChatGPT sera capable de comprendre cela contextuellement.

Que se passe-t-il lorsqu'une requête est saisie dans la boîte de discussion ?

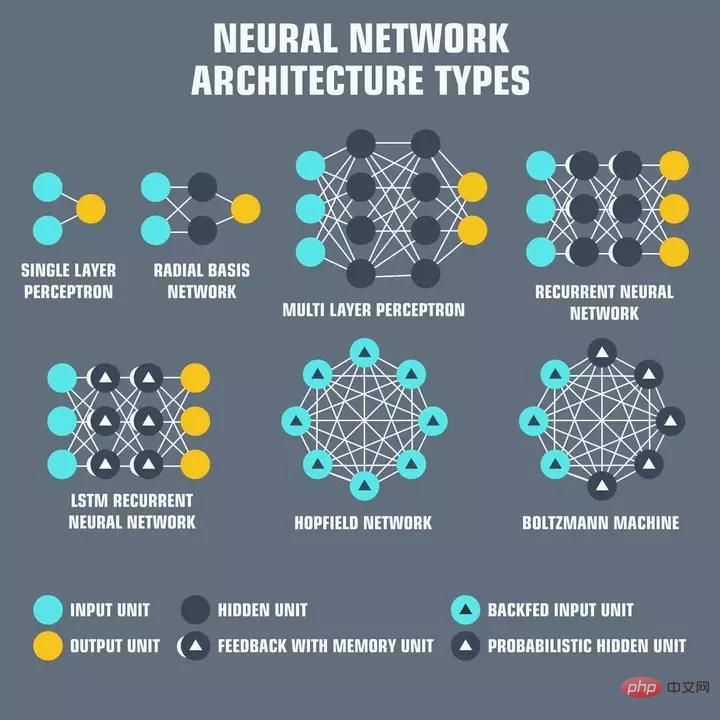

Réseaux de neurones

Tout d'abord, dans le cadre de ChatGPT, il y a beaucoup à découvrir. L'apprentissage automatique a progressé rapidement au cours des 10 dernières années et ChatGPT utilise de nombreuses technologies de pointe pour atteindre ses résultats.

Les réseaux de neurones sont des couches de « neurones » interconnectés, chaque neurone est chargé de recevoir les entrées, de les traiter et de les transmettre au neurone suivant du réseau. Les réseaux de neurones constituent l’épine dorsale de l’intelligence artificielle d’aujourd’hui. L'entrée est généralement un ensemble de valeurs numériques appelées « caractéristiques » qui représentent certains aspects des données en cours de traitement. Par exemple, dans le cas du traitement du langage, les fonctionnalités peuvent être des incorporations de mots qui représentent la signification de chaque mot dans une phrase.

Une intégration de mots n'est qu'une représentation numérique d'un texte qu'un réseau de neurones utilisera pour comprendre la sémantique du texte, qui peut ensuite être utilisée à d'autres fins, comme répondre de manière sémantiquement logique

Alors, appuyez de nouveau dans ChatGPT ! Après la saisie, le texte est d'abord converti en intégrations de mots, qui sont formées sur du texte provenant d'Internet. Il existe ensuite un réseau neuronal qui est entraîné à produire un ensemble d’intégrations de mots de réponse appropriées compte tenu des intégrations de mots d’entrée. Ces intégrations sont ensuite traduites en mots lisibles par l'homme en utilisant l'opération inverse appliquée à la requête d'entrée. Cette sortie décodée est ce que ChatGPT imprime.

Taille du modèle ChatGPT

La conversion et la génération de sortie sont très coûteuses en calcul. ChatGPT se trouve au-dessus de GPT-3, un grand modèle de langage avec 175 milliards de paramètres. Cela signifie qu'il y a 175 milliards de poids dans le vaste réseau neuronal OpenAI optimisé à l'aide de son vaste ensemble de données.

Donc, chaque requête nécessite au moins deux calculs de 175 milliards, ce qui s'additionne rapidement. OpenAI a peut-être trouvé un moyen de mettre ces calculs en cache pour réduire les coûts de calcul, mais on ne sait pas si ces informations ont été publiées quelque part. De plus, GPT-4, qui devrait être publié au début de cette année, aurait 1 000 fois plus de paramètres

La complexité informatique entraînera des coûts réels si ChatGPT devient bientôt un produit payant, car OpenAI en dépense actuellement des centaines ! Dix mille dollars pour le faire fonctionner gratuitement.

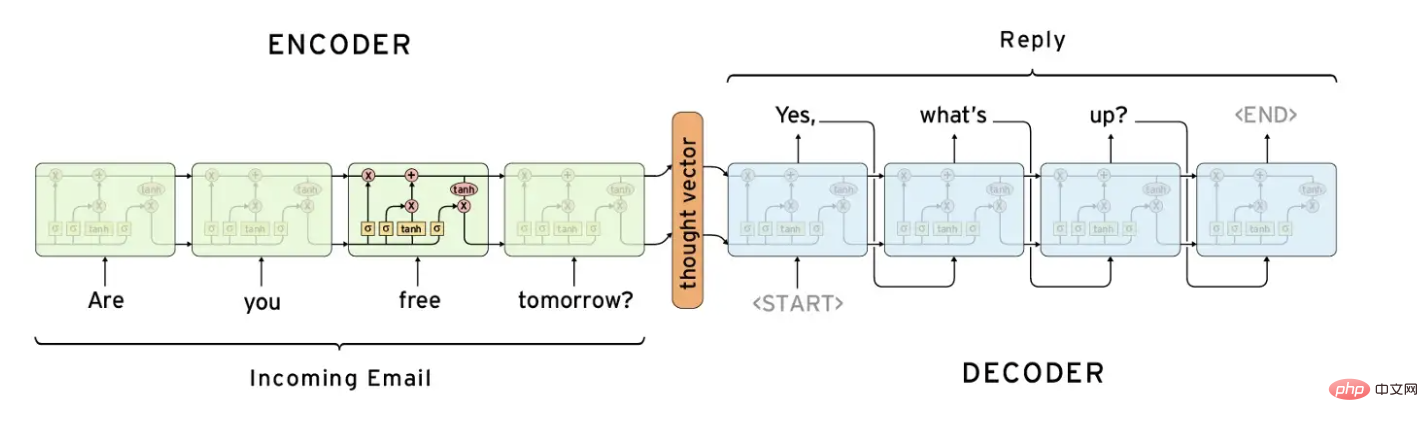

Encodeur, décodeur et RNN

Une structure de réseau neuronal couramment utilisée dans le traitement du langage naturel est le réseau encodeur-décodeur. Ces réseaux sont conçus pour « coder » une séquence d'entrée en une représentation compacte, puis « décoder » cette représentation en une séquence de sortie.

Traditionnellement, les réseaux codeurs-décodeurs étaient associés à des réseaux de neurones récurrents (RNN) pour le traitement des données séquentielles. Le codeur traite la séquence d'entrée et produit une représentation vectorielle de longueur fixe, qui est ensuite transmise au décodeur. Le décodeur traite ce vecteur et produit une séquence de sortie.

Les réseaux codeurs-décodeurs ont été largement utilisés dans des tâches telles que la traduction automatique, où l'entrée est une phrase dans une langue et la sortie est la traduction de cette phrase dans une autre langue. Ils ont également été appliqués aux tâches de synthèse et de génération de légendes d’images.

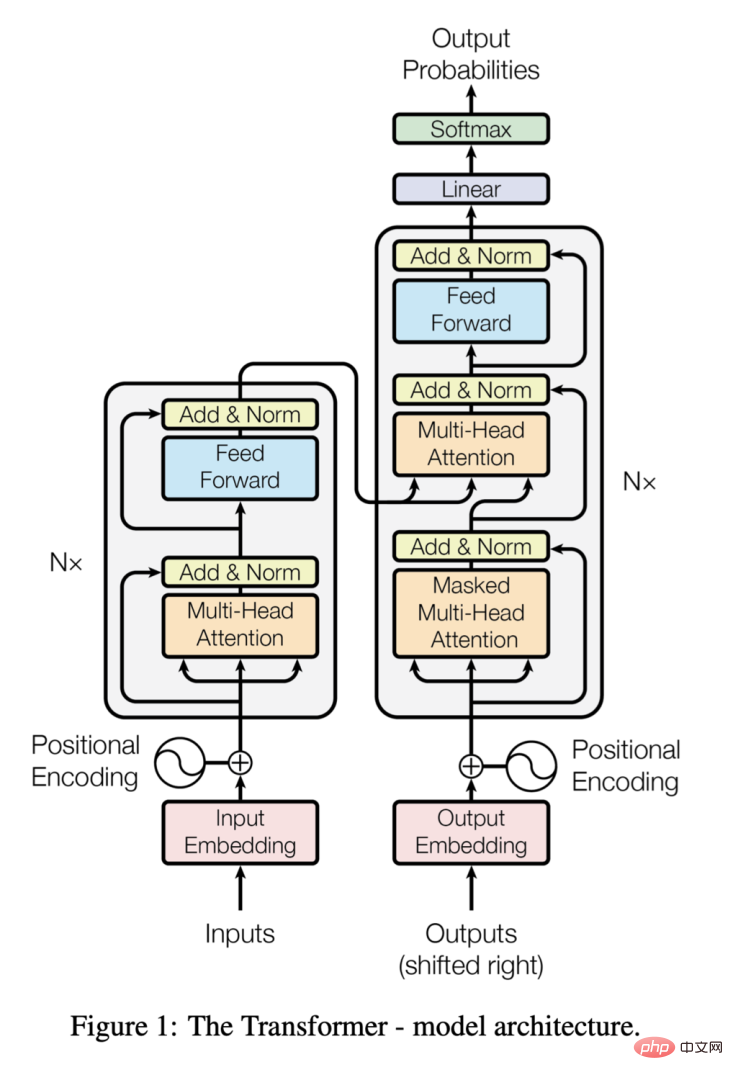

Transformateur avec Attention

Semblable à la structure codeur-décodeur, le transformateur se compose de deux composants cependant, le convertisseur diffère en ce qu'il utilise un mécanisme d'auto-attention qui permet à chaque élément d'entrée de se concentrer sur tous les autres ; éléments, lui permettant de capturer les relations entre les éléments quelle que soit leur distance les uns par rapport aux autres.

Transformer utilise également l'attention multi-têtes, lui permettant de se concentrer simultanément sur plusieurs parties de l'entrée. Cela lui permet de capturer des relations complexes dans le texte saisi et de produire des résultats très précis.

Lorsque l'article « Attention is All You Need » a été publié en 2017, le transformateur a remplacé l'architecture encodeur-décodeur comme modèle de pointe pour le traitement du langage naturel, car il pouvait obtenir de meilleures performances sur des textes plus longs.

Architecture Transformer, de https://arxiv.org/pdf/1706.03762.pdf

Pré-formation générative

La pré-formation générative est une technique particulièrement performante dans le domaine du traitement du langage naturel. Cela implique la formation de réseaux neuronaux étendus sur des ensembles de données massifs de manière non supervisée pour apprendre une représentation universelle des données. Ce réseau pré-entraîné peut être affiné pour des tâches spécifiques, telles que la traduction linguistique ou la réponse à des questions, améliorant ainsi les performances.

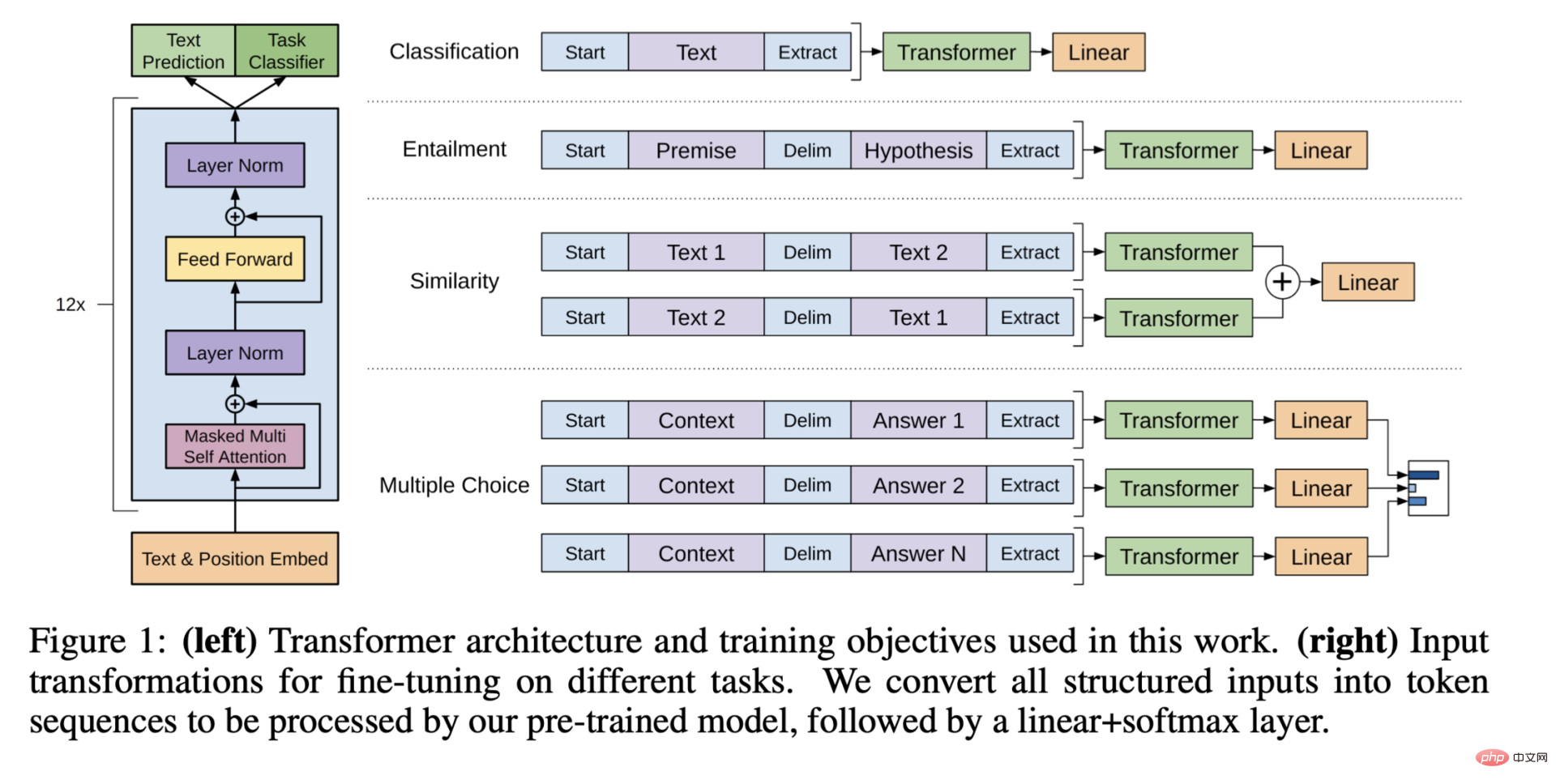

Architecture de pré-formation générative, extraite de "Améliorer la compréhension du langage grâce à la pré-formation générative"

Dans le cas de ChatGPT, cela signifie affiner la dernière couche du modèle GPT-3 pour adapter l'utilisation cas pour répondre aux questions dans le chat, qui exploite également le marquage humain. La figure suivante fournit un aperçu plus détaillé du réglage fin de ChatGPT :

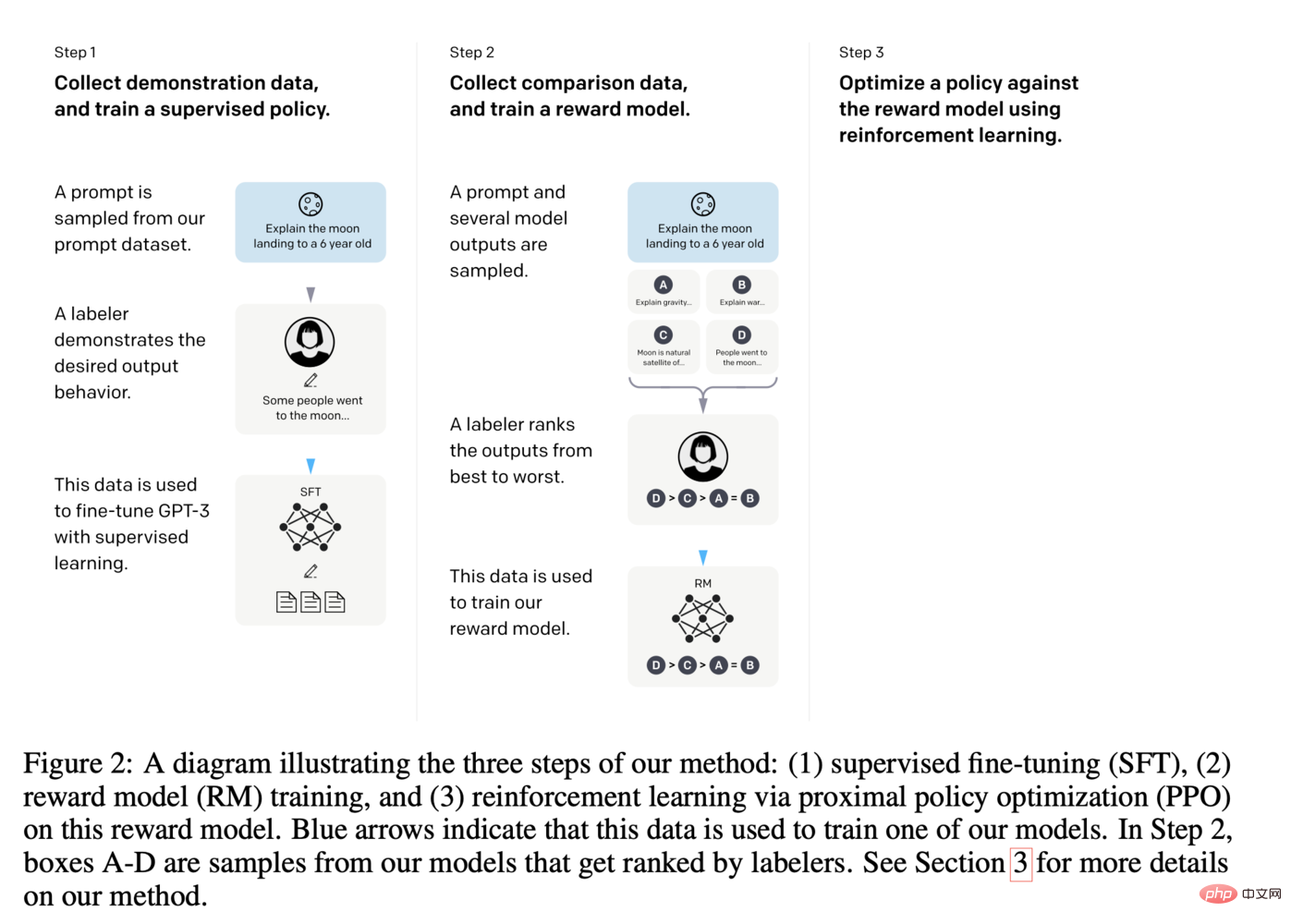

Étapes de réglage fin de ChatGPT, à partir de https://arxiv.org/pdf/2203.02155.pdf

mettre tout ensemble

Ainsi, dans le cadre de ChatGPT, il y a beaucoup de pièces mobiles là-bas, et ces pièces ne feront que croître. Il sera très intéressant de voir comment il continuera à se développer, car les progrès dans de nombreux domaines différents aideront les modèles de type GPT à être davantage adoptés.

Dans un an ou deux, nous pourrions assister à des perturbations majeures dues à cette nouvelle technologie habilitante.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI