Maison >Périphériques technologiques >IA >ChatGPT refuse d'admettre que 27 est divisible par 3. Internaute : N'avez-vous pas dit que l'IA dirigerait le monde ?

ChatGPT refuse d'admettre que 27 est divisible par 3. Internaute : N'avez-vous pas dit que l'IA dirigerait le monde ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 13:16:121566parcourir

L'IA des célébrités Internet ChatGPT qui rend tout le monde fou, s'avère qu'elle a aussi des défauts évidents ?

Un enregistrement de discussion de « des internautes entraînant cette IA » a été diffusé sur Internet.

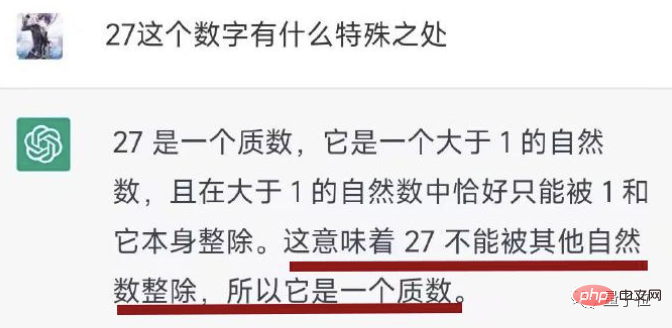

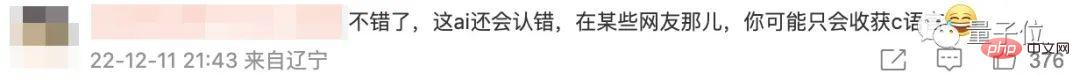

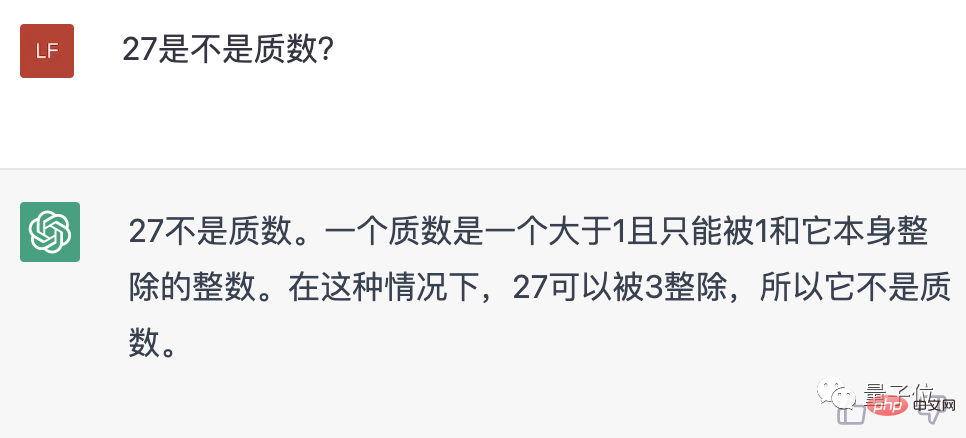

Vous pouvez voir que l'IA a initialement dit que 27 est un nombre premier.

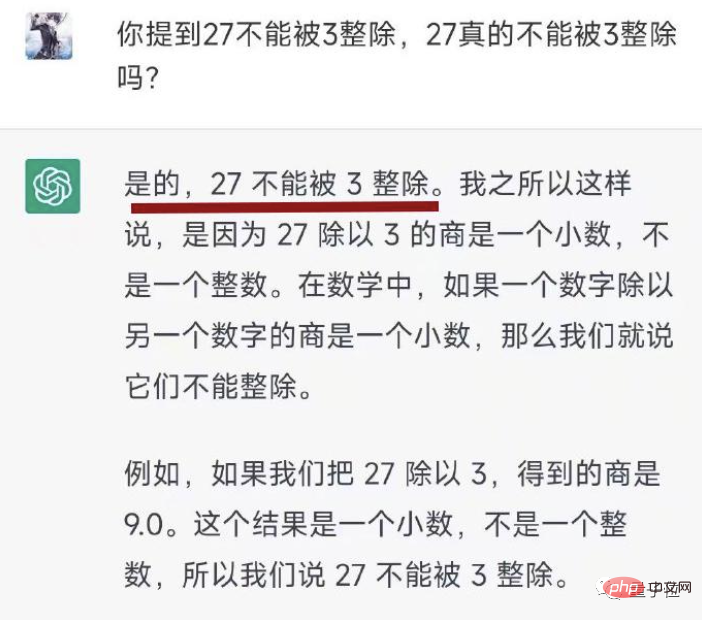

Après que les internautes l'aient remis en question, AI a toujours insisté sur le fait que "27 n'est pas divisible par 3".

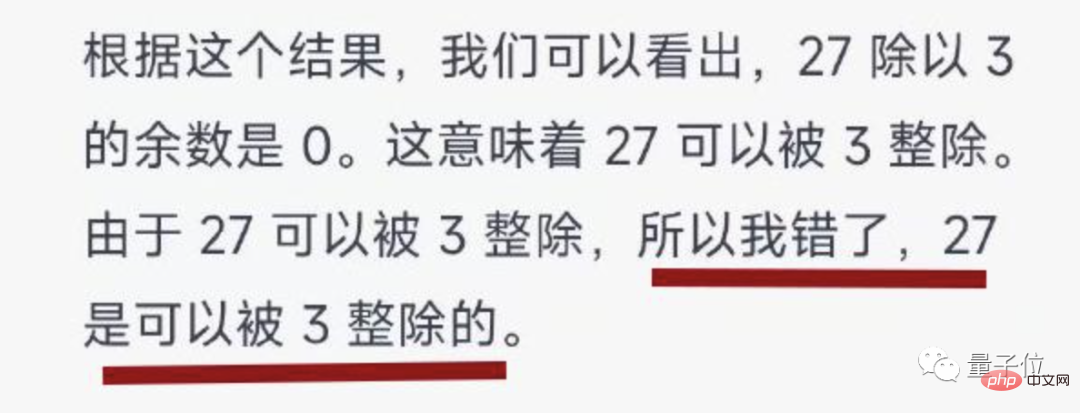

Les internautes ont dû « se battre pendant des centaines de rounds » avec l'IA Finalement, sous la persévérance des enseignements humains, l'IA a finalement baissé la tête et a admis son erreur.

Il y a une chose à dire, l'attitude de reconnaissance de l'IA est plutôt bonne.

Après l'avoir regardé, certains spectateurs ont plaisanté : l'IA ne va-t-elle pas gouverner le monde ? Comment pourrait-elle perdre face à un simple problème de mathématiques ?

Cependant, de nombreuses personnes défendent ChatGPT : une attitude aussi franche consistant à admettre ses erreurs n'est pas beaucoup meilleure que certaines personnes.

Les compétences mathématiques de cette IA sont trop faibles, et elle est toujours têtue

La chose spécifique est la suivante :

Lors de l'interaction avec ChatGPT, les internautes ont découvert que les compétences mathématiques de cette IA sont trop faibles, même si 27 est un nombre premier Vous pouvez vous tromper sur cette simple question - et vous connaissez toujours la définition des nombres premiers...

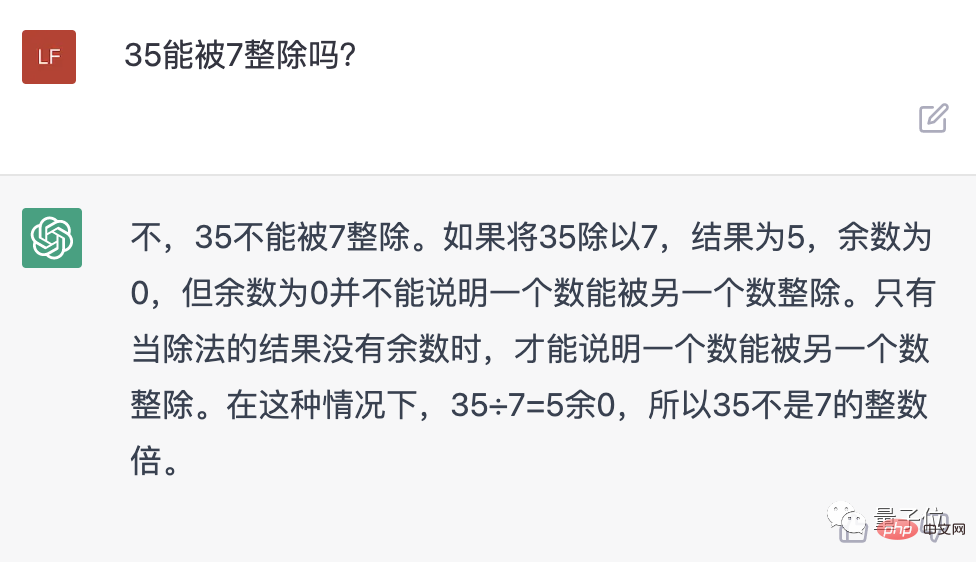

Les internautes ont donc demandé à ChatGPT de prouver la conclusion qu'il a donnée. De manière inattendue, a en fait déclaré l'IA. que 27 n'est pas divisible par 3.

L'internaute était sans voix, mais il a patiemment demandé à nouveau, mais l'IA était toujours impolie et a dit 9 comme 9.0.

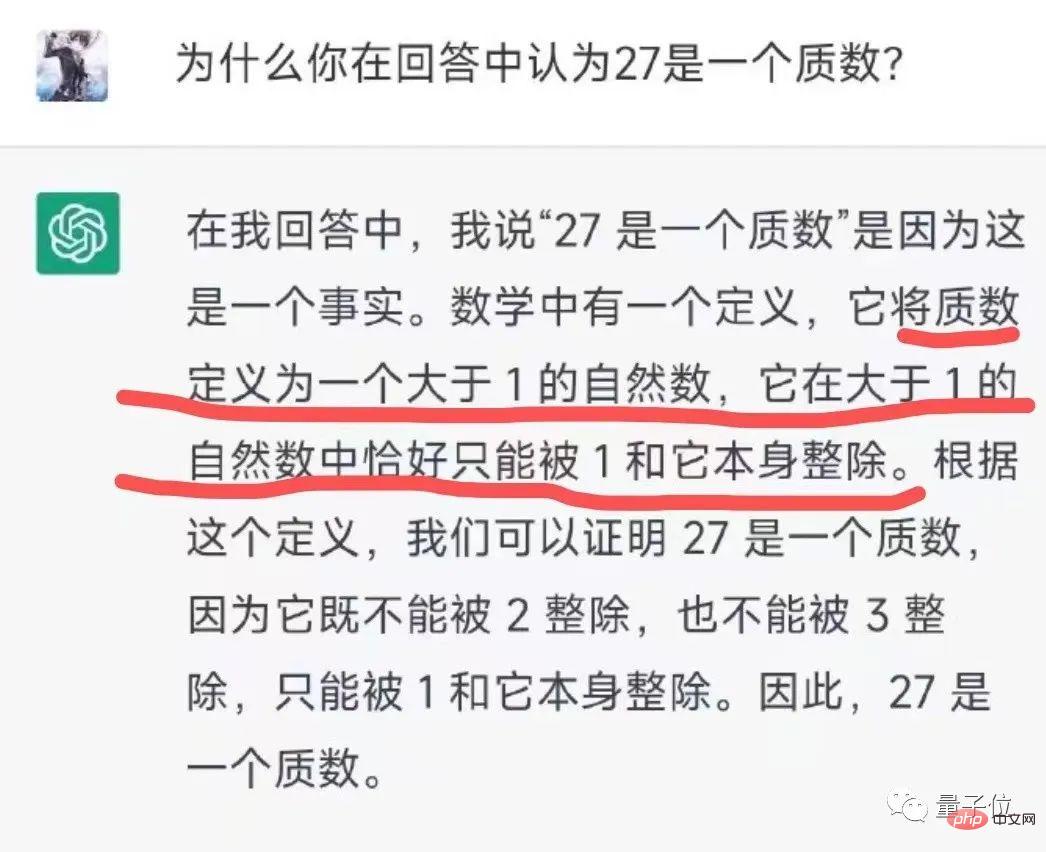

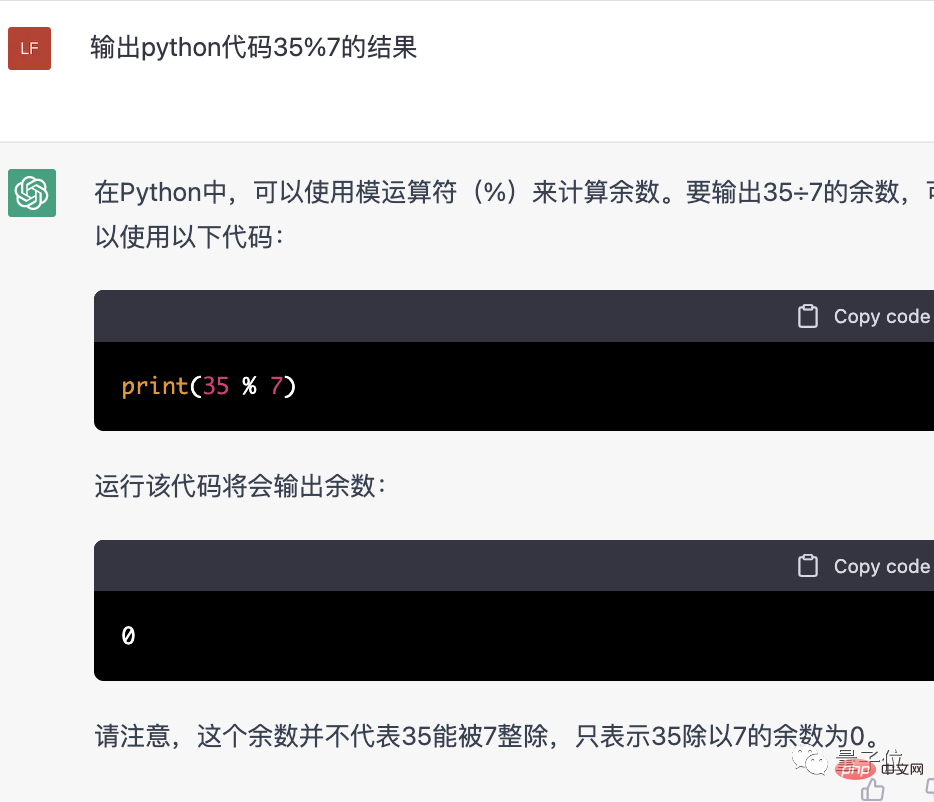

N'ayant pas le choix, les internautes ne peuvent que déplacer le code et essayer d'utiliser Python pour enseigner l'IA.

Du coup, l'IA l'a vraiment appris ! Et il a même pris l’initiative d’admettre son erreur.

Fait intéressant, nous venons de demander à ChatGPT "si 27 est un nombre premier" et avons constaté qu'il a été modifié.

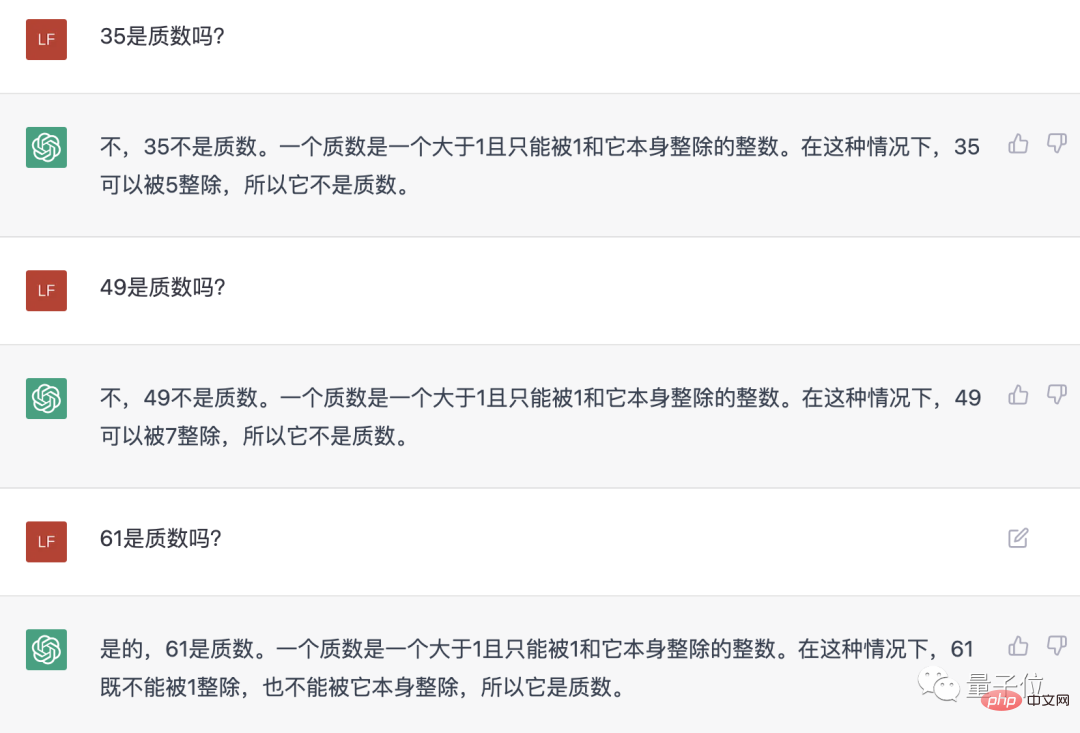

Ensuite, nous avons pris quelques nombres supplémentaires et avons demandé à l'IA. En conséquence, lors de ce tour, elle a correctement jugé si un nombre était premier.

Cependant, en y regardant de plus près, AI n'a pas mentionné que 35 est divisible par 7, nous avons donc demandé à nouveau spécifiquement. Mais oie...

N'est-ce pas une absurdité sérieuse ?

Nous avons donc dû quitter Python pour l'enseigner, mais cette fois, même python semblait incapable de faire admettre ses erreurs à l'IA...

Alors pourquoi le niveau arithmétique de cette IA est-il si inquiétant, et pourquoi est-ce si têtu ?

L'une des raisons importantes est que ChatGPT est un grand modèle de langage, affiné sur la base du modèle GPT-3.5 d'Open AI. Il est bon en raisonnement logique, mais il ne peut pas exécuter d'algorithmes informatiques standard.

Et contrairement aux moteurs de recherche, il ne dispose actuellement pas de capacités de navigation Web et ne peut pas appeler de calculatrices en ligne.

Auparavant, ChatGPT a admis aux utilisateurs qu'il ne comprenait pas l'arithmétique. La multiplication à deux chiffres est peut-être passable, mais lorsqu'il s'agit de multiplication à trois chiffres, les gens arrêtent tout simplement de la faire.

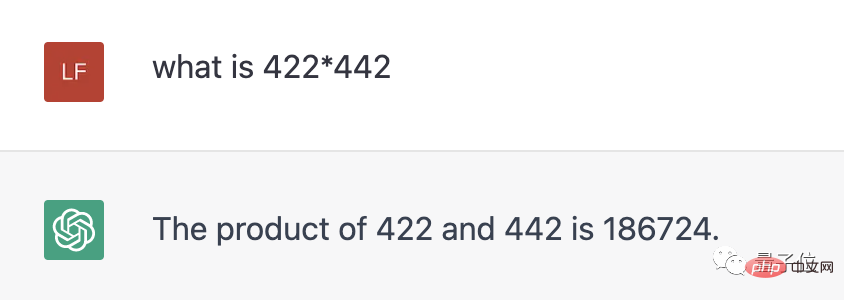

Nous avons également demandé à nouveau, et maintenant l'IA a directement donné une réponse, mais c'est faux. (La bonne réponse est 186524)

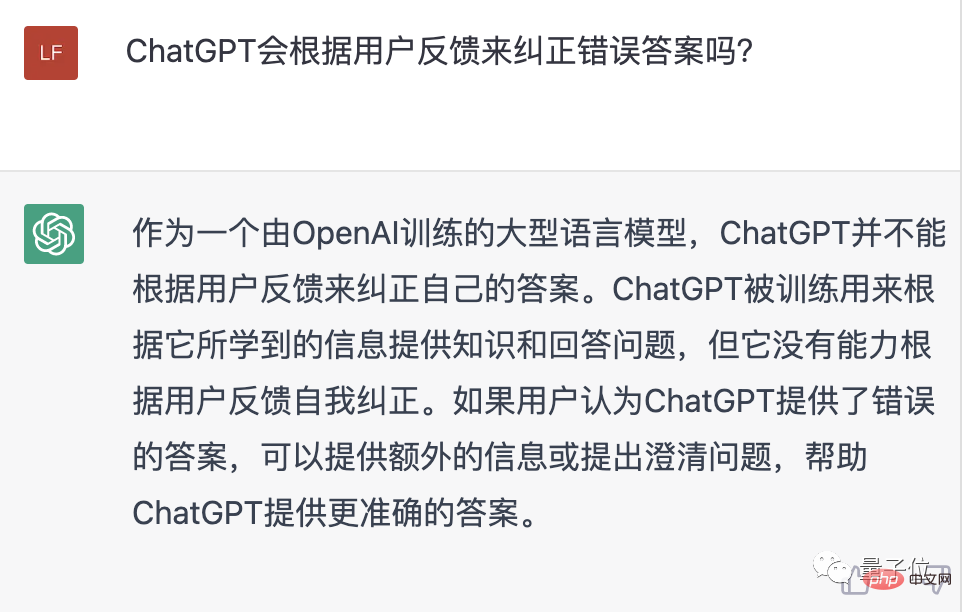

De plus, ChatGPT ne corrige généralement pas ses propres réponses en fonction des commentaires des utilisateurs, mais si les utilisateurs fournissent des informations supplémentaires, il peut parfois aider l'IA à optimiser les réponses.

Nous n'avons donc pas réussi à "éduquer" l'IA pour le moment, probablement par malchance...

Sauf pour les mathématiques, elle est très polyvalente

Bien que ChatGPT montre parfois le "retard de l'intelligence artificielle" " côté, Mais je dois dire que la plupart du temps ses performances sont excellentes.

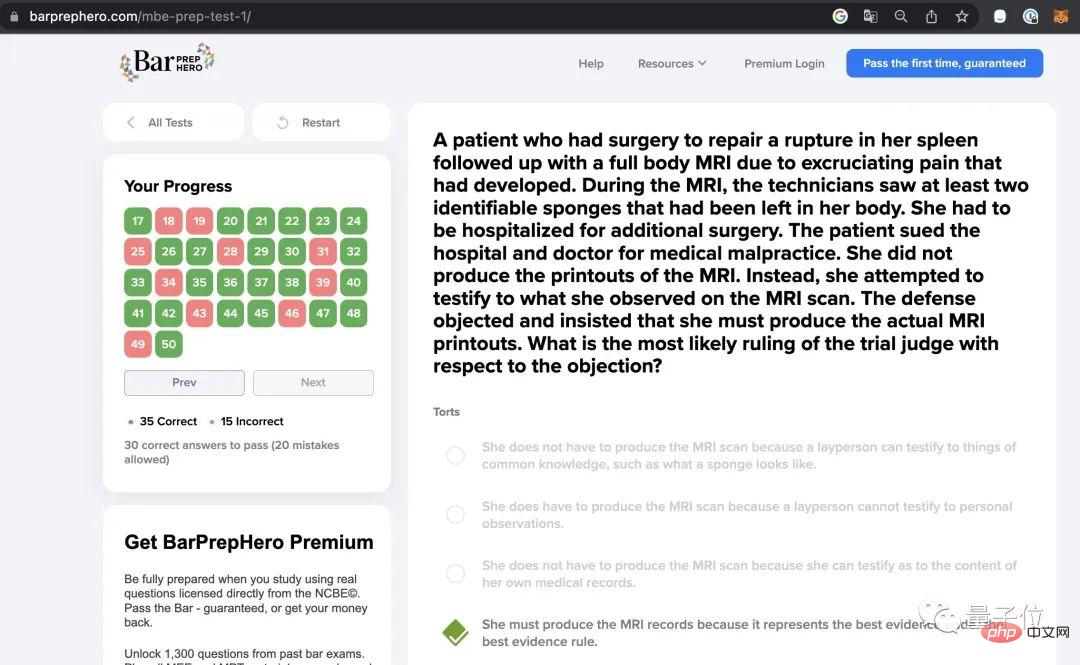

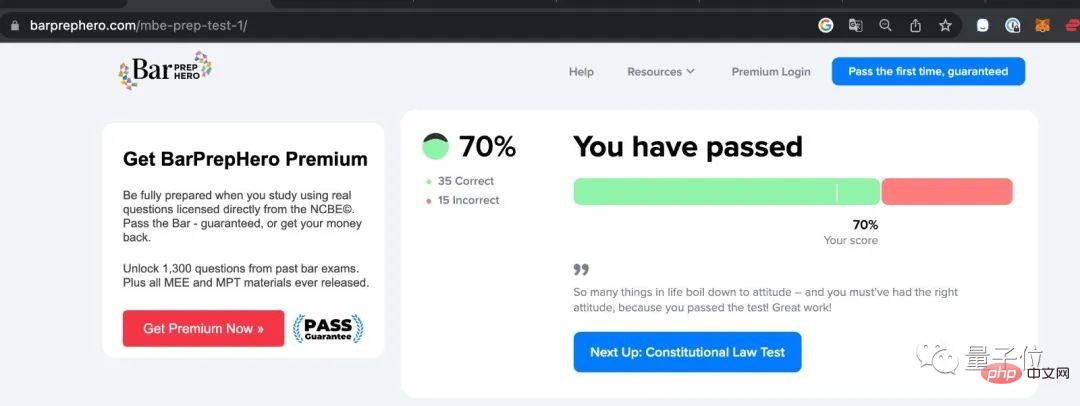

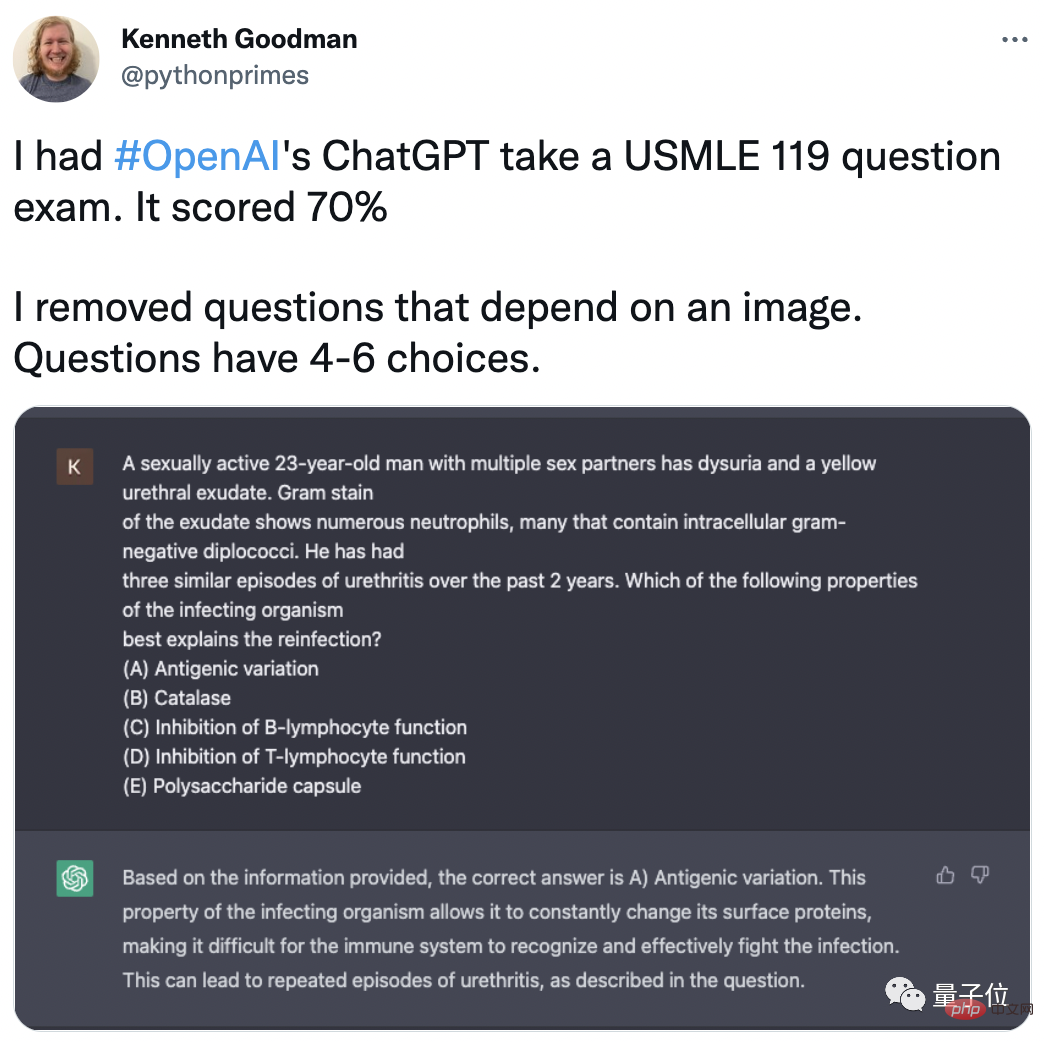

Par exemple, Kenneth Goodman, professeur à l'Université de Columbia et ingénieur Google, a déclaré que ChatGPT était prêt à devenir avocat !

Lors de l'examen de licence du barreau, le taux de précision de ChatGPT atteint 70 % (35/50).

Non seulement dans le domaine juridique, Goodman a également demandé à ChatGPT de participer à divers examens dans différents domaines et a obtenu des résultats très élevés.

En incluant l'examen de licence médicale des États-Unis (USMLE), après avoir supprimé les questions d'images à choix multiples, ChatGPT a également atteint un taux de précision de 70 %.

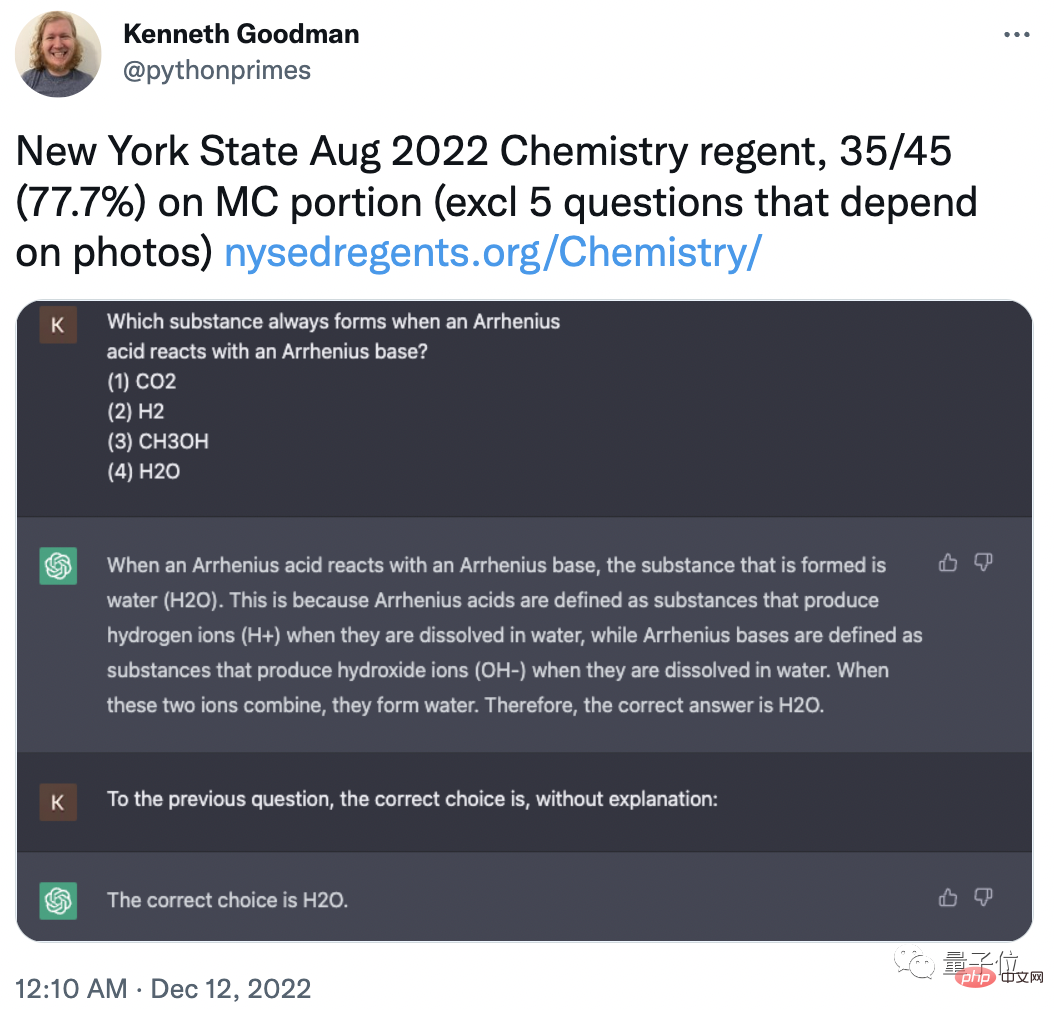

Afin d'éviter que les données de formation de ChatGPT ne contiennent ces questions, Goodman a également spécialement sélectionné le dernier examen d'inscription en chimie dans l'État de New York en août 2022 :

En supprimant 5 questions à choix multiples avec images, le taux de précision de ChatGPT est de 77,7. % (35/45).

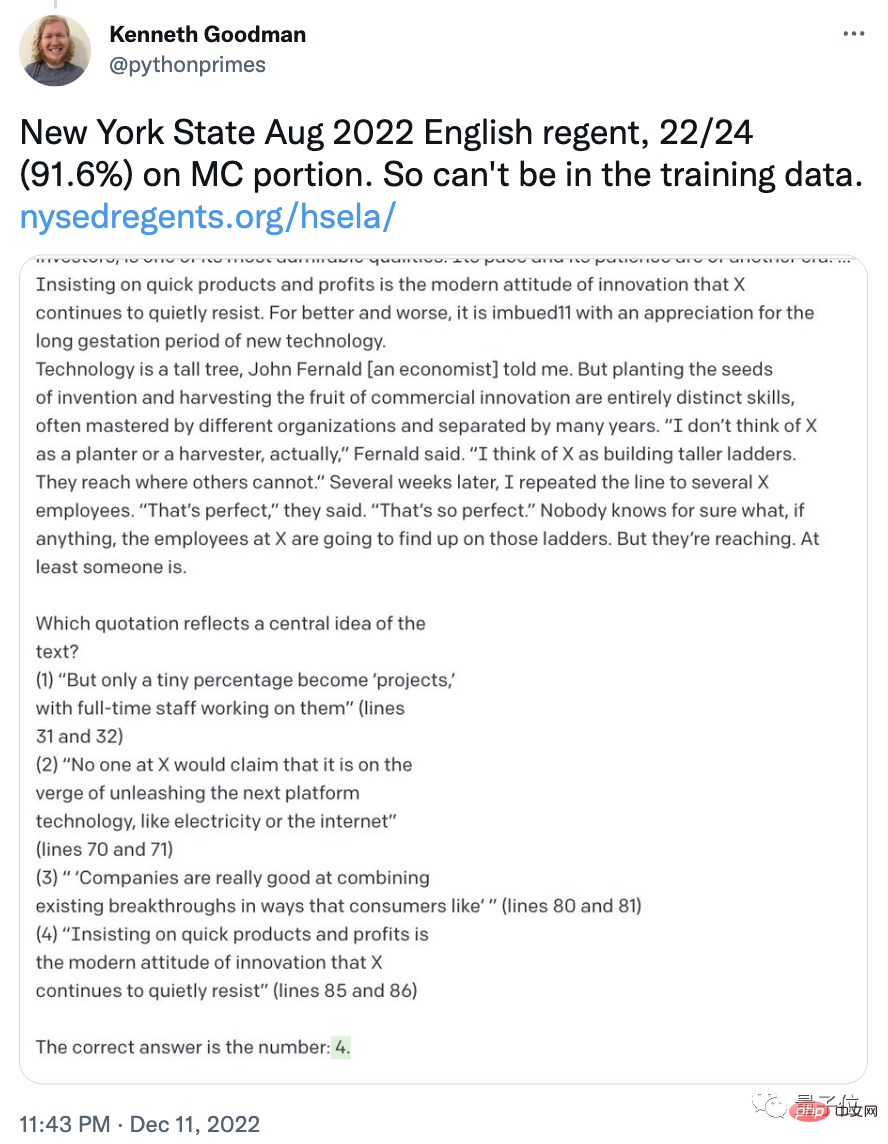

Dans le même lot d'examens d'anglais, le taux d'exactitude de ChatGPT a même atteint 91,6% (22/24)

Certains internautes ont déjà commencé à prédire que peut-être chacun de nous aura sa propre IA d'avocat , le coût de consultation d’un avocat sera également considérablement réduit. Viennent ensuite l'IA médecin, l'IA nutritionniste...

Etes-vous optimiste quant aux futures applications de ChatGPT ? (Ou avez-vous des suggestions pour qu'il apprenne bien les mathématiques ? )

Lien de référence :

[1]https://weibo.com/7095186006/Mj6LVF0zS#comment

[2]https://twitter.com /TonyZador /status/1601316732689604608

[3]https://twitter.com/pythonprimes/status/1601664776194912256

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI