Maison >Périphériques technologiques >IA >Comment comprendre la nouvelle loi de Moore proposée par OpenAI ? Le géant chinois de la puissance informatique cachée a quelque chose à dire

Comment comprendre la nouvelle loi de Moore proposée par OpenAI ? Le géant chinois de la puissance informatique cachée a quelque chose à dire

- 王林avant

- 2023-04-12 11:34:071419parcourir

Cet article est réimprimé avec l'autorisation d'AI New Media Qubit (ID de compte public : QbitAI). Veuillez contacter la source pour la réimpression.

ChatGPT est populaire partout dans le monde et tout ce qui s'y rapporte est au premier plan.

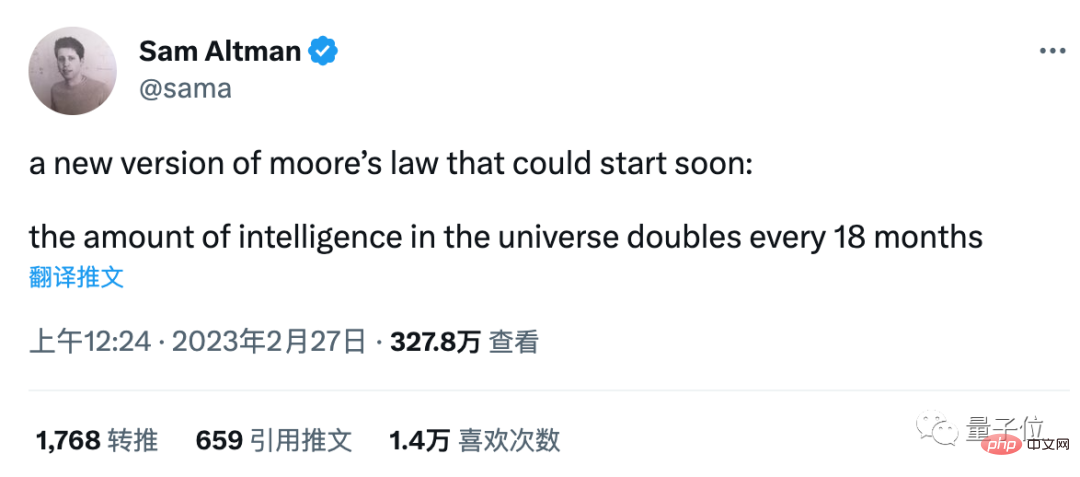

Les propos apparemment désinvoltes du PDG d'OpenAI, Sam Altman, sont devenus le centre de discussions animées :

Une nouvelle version de la loi de Moore arrive bientôt, L'intelligence dans l'univers double tous les 18 mois .

Certaines personnes pensent que cela peut faire référence aux paramètres du réseau neuronal, mais cela n'est pas cohérent avec les données de ces dernières années.

Certaines personnes comprennent que c'est la capacité de tous les agents intelligents, y compris les humains et l'IA, mais comment mesurer cet indicateur est devenu un problème.

De nombreux universitaires et internautes ne sont pas d'accord avec ce jugement, Grady Booch, scientifique chez IBM, a déclaré que cela n'avait aucun sens, et c'est devenu le commentaire numéro un.

A ces discussions, Altman a simplement répondu "Pas encore".

Mais quoi qu’il en soit, derrière le développement rapide de l’IA, la puissance de calcul est un indicateur clair et mesurable et une condition essentielle.

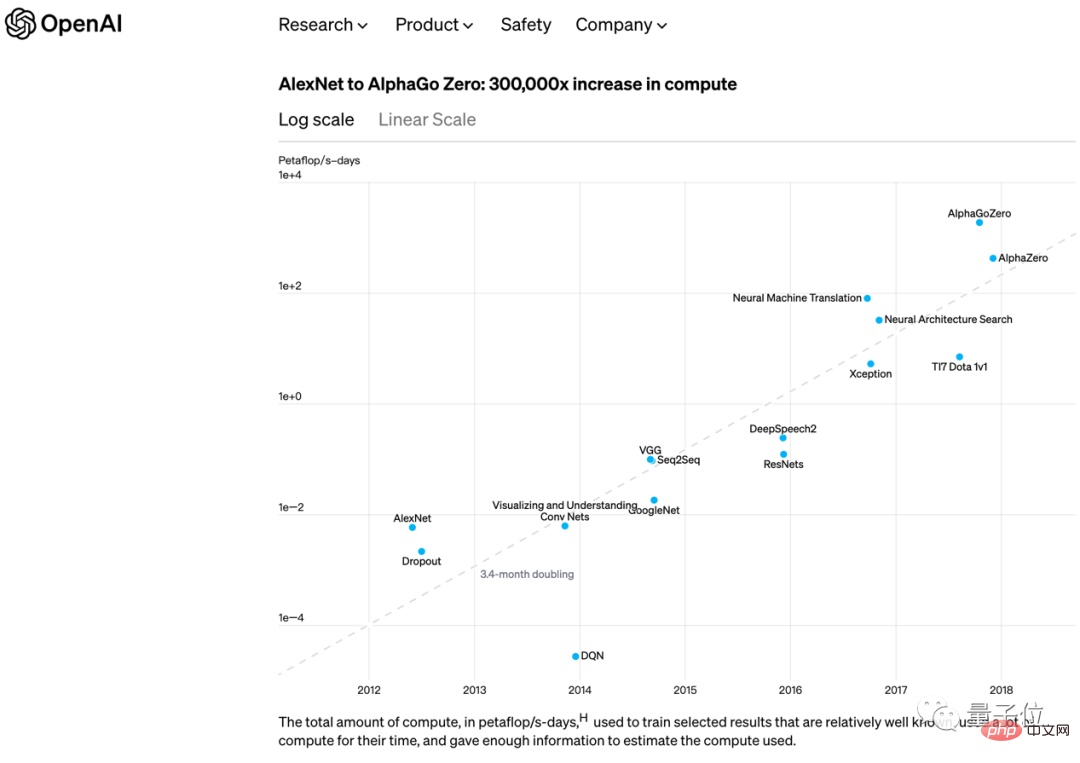

Dès 2018, OpenAI a également publié une autre opinion similaire à la loi de Moore :

De AlexNet en 2012 à AlphaGo Zero fin 2017, La puissance de calcul nécessaire pour entraîner le plus grand modèle d'IA tous les 3,4 mois la double .

Peu de temps après, le GPT-3 qu'ils ont eux-mêmes publié a raccourci ce nombre à doublé en 2 mois.

À l'ère ChatGPT, ce n'est pas seulement la puissance de calcul de la formation de l'IA qui doit être prise en compte. Avec 100 millions d'utilisateurs actifs mensuels dans le monde, l'accès à la recherche Microsoft Bing et à d'autres produits, la puissance de calcul d'inférence de l'IA est également un support important.

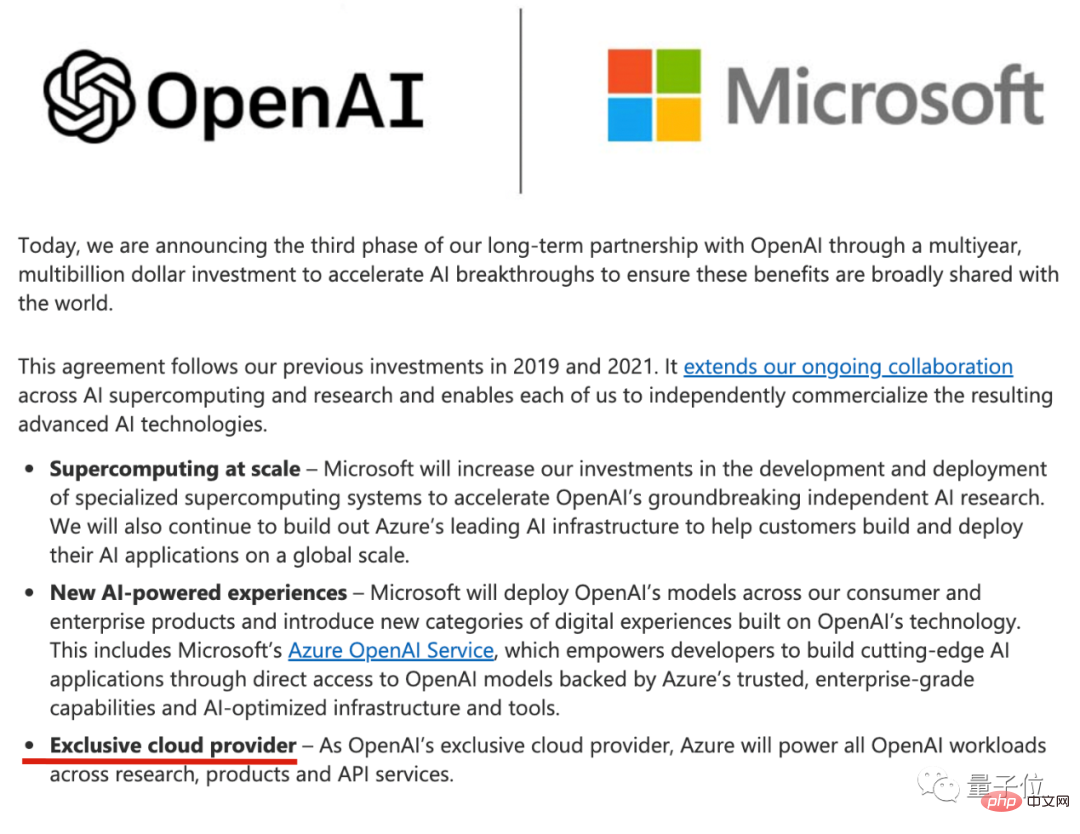

Le fournisseur de puissance de calcul le plus direct pour ChatGPT est le cloud Microsoft Azure, qui est le fournisseur cloud exclusif d'OpenAI depuis qu'il a investi pour la première fois 1 milliard de dollars américains dans OpenAI en 2019.

Avec le dernier investissement supplémentaire de 10 milliards de dollars américains, les deux parties ont de nouveau souligné ce point dans leur déclaration.

Un approvisionnement exclusif signifie que l'infrastructure de développement d'OpenAI est entièrement construite sur le cloud Azure, en utilisant la chaîne d'outils fournie par le cloud Azure.

Cela signifie également que la prochaine armée d'entrepreneurs en IA ne pourra choisir le cloud Azure que s'ils souhaitent utiliser ChatGPT.

En conséquence, Google AI est soutenu par son propre Google Cloud, et Amazon, le numéro un du secteur du cloud computing, a également contacté de toute urgence HuggingFace pour coopérer au déploiement du grand modèle open source Bloom.

...

Et le cloud computing n'est pas la source de la puissance de calcul. Tout comme ChatGPT est en plein essor, un certain nombre d'entreprises aux performances exceptionnelles sont apparues du côté de l'offre de puissance de calcul.

Vous penserez peut-être tout de suite à certains joueurs, mais il y a aussi des joueurs auxquels on ne s'attend peut-être pas car ils sont trop connus dans d'autres métiers précédents.

Parmi eux se trouve un joueur chinois.

La nouvelle loi de Moore ne peut être séparée de la puissance de calcul

Lorsque la dernière vague d'applications d'IA représentées par des algorithmes de reconnaissance d'images et de recommandation a été mise en œuvre pour promouvoir le développement de l'économie numérique, la puissance de calcul est passée d'un terme technique à un terme économique. , et a été utilisé par l'industrie , ont souligné à plusieurs reprises les milieux universitaires.

Lorsque cette vague d'IA générative a suscité un enthousiasme mondial, la puissance de calcul a été une fois de plus améliorée pour être adaptée au travail et à la vie des gens ordinaires et a été perçue par le public.

Combien coûte ChatGPT ?

SemiAnalysis, une organisation d'information sur l'industrie des semi-conducteurs, a fait une estimation : mesuré par GPU, environ 3 617 serveurs Nvidia HGX A100 sont nécessaires, soit 28 936 A100 mesurés par fonds, le coût de chaque question utilisateur est de 0,36 centime, Il peut être complété en une journée. Cela coûtera 690 000 $.

La conclusion est la suivante : si ChatGPT devait supporter tout le trafic des recherches Google, un total de 4,1 millions de GPU NVIDIA A100 serait nécessaire.

Alors naturellement, NVIDIA est le profiteur le plus connu de la popularité de ChatGPT. NVIDIA représente actuellement environ 75 à 80 % du marché des puces IA. Chaque recherche brûlante sur ChatGPT est le bruit des pièces d'or arrivant sur le compte de Lao Huang, avec le soutien de cette vague d'enthousiasme, dès la sortie du. dernier rapport financier, le cours de l'action NVIDIA est à En 2023, il augmentera de 45 %.

Le PDG Huang Renxun a également fait la dernière déclaration lors de la conférence téléphonique :

"L'IA générative a donné aux entreprises mondiales un sentiment d'urgence stratégique pour développer et déployer l'intelligence artificielle

Et ce n'est que le début, selon Citibank It." On prévoit que les ventes de GPU de Nvidia atteindront entre 3 et 11 milliards de dollars au cours des 12 prochains mois.

En plus de NVIDIA, le gagnant du bonus ChatGPT tracé en amont du GPU est TSMC au niveau de la fabrication des puces.

Récemment, il a été rapporté que Nvidia, AMD et Apple avaient récemment passé des commandes d'urgence pour TSMC, dans l'espoir de s'emparer de la future capacité de production.

Auparavant, le principal pilier de revenus de TSMC était depuis de nombreuses années le secteur des smartphones. Cependant, en 2022, sous le double impact de la faiblesse des ventes de smartphones et de l'essor de l'intelligence artificielle, le secteur du calcul haute performance l'a dépassé pendant trois trimestres consécutifs. -c'est peut-être aussi un tournant dans l'époque.

Plus important encore, TSMC a clairement indiqué ce changement. Dans de récentes déclarations publiques, TSMC a exprimé des attentes optimistes pour l'année à venir, et son expression est également très intrigante : bien que l'industrie mondiale des semi-conducteurs soit confrontée à une récession, ses performances pour l'ensemble de l'année devraient encore légèrement croître.

Bien sûr, si l'on déduit plus simplement et grossièrement, en fait, lorsque Nvidia augmentera, les performances de TSMC ne seront pas mauvaises. Après tout, le rôle de la chaîne industrielle et la relation entre l'offre et la demande sont là.

Donc, sur la base de cette offre et de cette demande, les dividendes de la puissance de calcul apportés par ChatGPT iront-ils également aux fabricants de cloud computing et de services cloud ?

Oui, pas entièrement.

Avec la popularité de ChatGPT, de nombreuses analyses ont pointé du doigt le cloud computing, mais certains analystes se sont rapidement concentrés sur le maillon intermédiaire - le lien intermédiaire entre le GPU et les services de cloud computing - le serveur.

Pour que les puces jouent réellement un rôle, elles ne peuvent pas contourner les serveurs : la façon dont les puces sont interconnectées à grande vitesse, la façon dont l'ensemble de l'armoire contrôle la consommation d'énergie et la dissipation thermique, et la façon dont la conception du système s'adapte aux différentes charges de travail, tout cela affecte la performance finale. et l'efficacité.

Gartner prédit que d'ici 2025, le marché mondial des serveurs atteindra 135 milliards de dollars, parmi lesquels les serveurs IA et les services cloud IA vont exploser.

Et c'est dans ce lien, en direction des serveurs d'IA, que se cachent les participants chinois en puissance de calcul évoqués au début de l'article.

Lenovo.

Peut-être qu'avant, vous connaissiez davantage le groupe Lenovo grâce aux PC, mais l'essence du PC est aussi la puissance de calcul personnelle.

Lenovo a parcouru un tel chemin, du PC au calcul haute performance en passant par une infrastructure informatique plus large.

En témoignent les données des rapports financiers les plus intuitives. Selon le rapport financier du troisième trimestre publié par Lenovo Group (octobre-décembre 2022), son activité de solutions d'infrastructure ISG (Infrastructure Solutions Group) a vu son chiffre d'affaires augmenter de 48 % et son bénéfice d'exploitation grimper de 156 %.

Cela contraste fortement avec les expéditions mondiales de serveurs enregistrées par DigiTimes au cours de la même période, qui ont chuté de 7,1 % sur un an et de 4,3 % sur un mois.

Lenovo Group ISG fournit des solutions et des infrastructures dont la puissance de calcul est le cœur. Les serveurs sont l'une des activités les plus importantes.

Et il est plus directement réparti dans l'activité serveurs. Le chiffre d'affaires de ce trimestre a augmenté de 35 % sur un an, et il est devenu le troisième fournisseur de serveurs au monde - le dividende en puissance de calcul de GhatGPT est indispensable.

Mais la popularité soudaine de ChatGPT n’a en réalité fait que mettre au premier plan le rôle caché du groupe Lenovo en tant que vainqueur de la puissance de calcul.

Comment Lenovo devient-il le champion « invisible » de la puissance de calcul ?

Yang Yuanqing, président-directeur général du groupe Lenovo, a déclaré que l'infrastructure de puissance de calcul universelle requise derrière ChatGPT se trouve être la force de Lenovo déployée depuis de nombreuses années.

Lenovo a déjà prévu la demande d'équipements informatiques et a proposé une nouvelle architecture informatique de "end-edge-cloud-network-intelligence".

L'année dernière, Lenovo a en outre proposé une puissance de calcul universelle. C'est-à-dire qu'avec la croissance explosive des données, nous sommes entrés dans une nouvelle ère de numérisation et d'intelligence. La demande en informatique se multiplie. Les équipements de « combat individuel » et les centres de données localisés sont loin de pouvoir répondre aux besoins informatiques. À tout moment et en tout lieu, la demande nécessite une nouvelle architecture informatique « d'intelligence de réseau cloud de pointe » pour fournir aux utilisateurs une puissance de calcul universelle et omniprésente. On peut voir que ce que Lenovo veut être n'est pas une « source d'eau » pour produire de la puissance de calcul, mais un « livreur d'eau » - intégrant des puces dans des serveurs qui peuvent libérer efficacement de la puissance de calcul et sont moins susceptibles d'être perçues par le monde extérieur.

Dans ce rôle et ce positionnement, le groupe Lenovo est très « fort » – le cœur de cette force réside dans deux aspects.

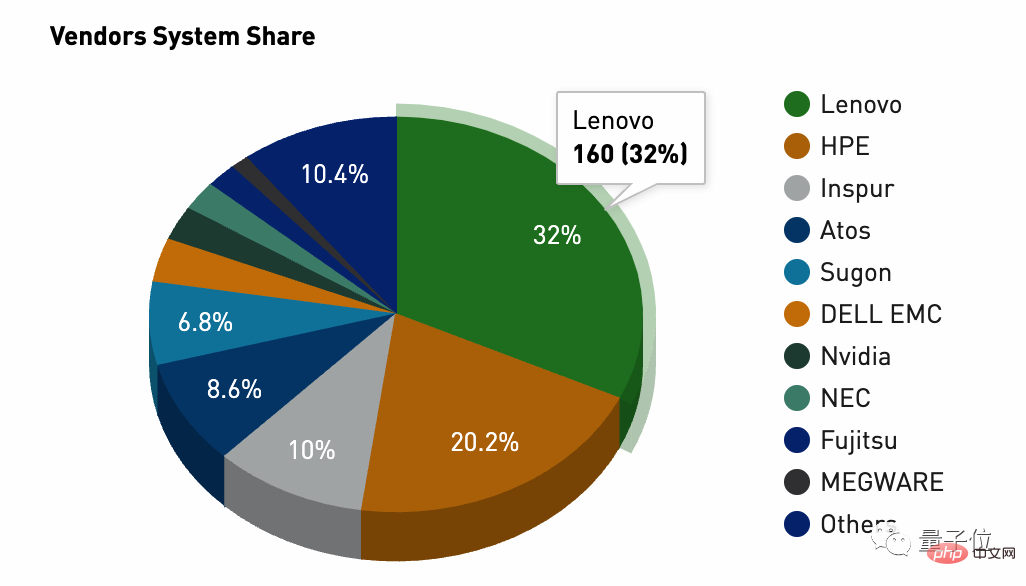

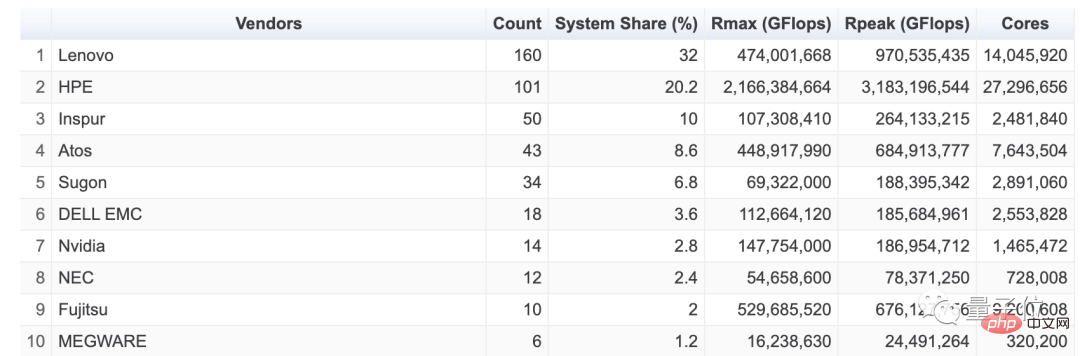

Le premier est la performance du produit du serveur ; le second est l'échelle de quantité. Dans ce domaine, la liste mondiale du calcul haute performance TOP500 est la meilleure référence pour observer la puissance de calcul des serveurs. Si vous ouvrez le dernier numéro de la liste mondiale du calcul haute performance TOP500 (novembre 2022), vous pouvez percevoir ce qui précède. force du groupe Lenovo. La part de marché représente 32%, se classant au premier rang mondial avec une offre de 160 unités, devançant même le deuxième groupe Hewlett-Packard de près de 12 points de pourcentage.

De plus, l'alimentation en puissance de calcul du groupe Lenovo présente également l'universalité et la diversité dans la composition de la clientèle.

En réponse à une question de Nihon Keizai Shimbun, Kirk Skaugen, vice-président exécutif du groupe Lenovo, a révélé à la manière de Versailles : 8 des 10 principaux fournisseurs de cloud public au monde sont des clients du groupe Lenovo.

En d'autres termes, les serveurs Lenovo ont été reconnus par les clients du monde entier, ce qui n'est pas facile pour les fabricants de serveurs nationaux.

Parmi ces clients, des étrangers pensent qu'ils incluent le deuxième cloud Microsoft Azure dans le domaine du cloud - le moteur d'accélération derrière ChatGPT et le « père financier ».

Lorsque Microsoft a investi massivement dans le support d'OpenAI, il y a eu des commentaires selon lesquels le PDG astucieux de Microsoft, Nadella, n'utiliserait pas d'argent réel pour investir dans le support. Le noyau fourni était des services cloud à prix égal. Il a non seulement obtenu les capitaux propres d'OpenAI, mais a également obtenu. a atteint le plus haut niveau. La configuration stratégique de l'institut de recherche en IA a amené les clients et la croissance vers son propre cloud Azure. C'est comme faire d'une pierre deux coups. Cette entreprise ne peut pas être perdue.

Je ne m'attendais tout simplement pas à ce que le fou OpenAI se fasse vraiment un nom avec les grands modèles. Il a vraiment enflammé l'Internet technologique mondial avec une innovation accidentelle de ChatGPT, et a plongé tous les acteurs dans l'enthousiasme des grands modèles et de l'IA générative.

Non seulement Microsoft a été le premier à en profiter, mais il a également poussé son ancien rival Google dans une impasse, bouleversant la vache à lait de recherche de Google. Nadella estime que ses rêves ont été doux ces derniers temps.

Le groupe Lenovo, qui entretient un partenariat étroit avec Microsoft et a remporté le Microsoft Device Partner Award en 2022, a vu ses avantages se refléter directement dans ses résultats financiers.

De plus, grâce à cette relation, nous pouvons également comprendre pourquoi le PDG de Microsoft, Nadella, est apparu à la conférence sur l'innovation et la technologie du groupe Lenovo 2021. Cependant, l'annonce de l'époque était trop « argot de l'industrie » et doit être combinée avec le bonus ChatGPT d'aujourd'hui. Pour bien comprendre, l'annonce de l'époque se lisait ainsi : à l'avenir, les deux parties mèneront une coopération plus approfondie dans les trois domaines du PC, du cloud computing et de l'edge computing, ainsi que des services.

Mais même si le groupe Lenovo devient le fournisseur de puissance de calcul de l'engouement pour ChatGPT, cela signifie-t-il que cette perspective est durable ? Après tout, les cas de Microsoft et de ChatGPT ont leurs particularités, et le groupe Lenovo en coulisses a la chance d'avoir goûté à la douceur.

Mais à en juger par l'orientation de développement du grand modèle établi par ChatGPT, la tendance se poursuivra et l'offre de puissance de calcul subira également des changements de direction.

Selon une conclusion récente tirée par « Financial Eleven » basée sur les opinions de nombreux professionnels de l'infrastructure, la puissance de calcul de l'IA aura un impact significatif sur le modèle financier du cloud computing, et derrière elle se cache la logique de croissance exponentielle de style Moore :

Premièrement, la consommation d'énergie de calcul et le taux de croissance de l'IA seront bien supérieurs à la consommation générale d'énergie de calcul. Les données de l’Académie des technologies de l’information et des communications de 2022 montrent que la puissance de calcul générale de la Chine atteindra 95 EFlops en 2021, avec un taux de croissance de 24 % et une part de 47 %. L'échelle de la puissance de calcul intelligente est de 104EFlops, avec un taux de croissance de 85 % et une part de plus de 50 %. Cela signifie que la puissance de calcul intelligente deviendra un nouveau point de croissance pour le cloud computing.

Deuxièmement, le prix de la puissance de calcul intelligente est plus élevé que celui de la puissance de calcul générale. Le prix de la puissance de calcul générale est en constante diminution et, en raison de la relative rareté de la puissance de calcul de l’IA, le prix est actuellement en hausse. Théoriquement, la marge bénéficiaire brute de la puissance de calcul de l’IA qui réalise des opérations à grande échelle est supérieure de plus de 10 % à celle de la puissance de calcul générale.

Troisièmement, l'utilisation de la puissance de calcul de l'IA + de grands modèles dans les industries verticales peut permettre l'émergence de nouveaux modèles d'application. Par exemple, dans les scénarios de finance, de conduite autonome, de recherche et développement médical et de fabrication intelligente, les entreprises doivent généralement acheter la plate-forme open source de grands modèles d'IA de l'entreprise et régler de petits modèles adaptés à leur propre entreprise. Ce type de service d'IA basé sur PaaS peut générer plus de 60 % des bénéfices bruts. Il s’agit actuellement de la meilleure voie pour approfondir l’utilisation de la puissance de calcul de l’IA/des modèles d’IA.

Ce changement de direction dans la puissance de calcul de l'IA peut avoir des impacts plus spécifiques sur le marché chinois :

À l'heure actuelle, il est indéniable qu'il existe un écart important entre la puissance de calcul de l'IA et les grands modèles des fournisseurs de cloud chinois et de Microsoft. . La raison en est qu’il existe des lacunes en termes d’échelle de puissance de calcul, d’échelle de données et de précision des modèles. En prenant comme exemple l'ampleur de la puissance de calcul, un cluster informatique intelligent prenant en charge ChatGPT nécessite au moins des dizaines de milliers de cartes graphiques NVIDIA GPU A100. Une formation complète sur un modèle coûte plus de 12 millions de dollars.

Le cluster informatique intelligent derrière ChatGPT coûte plus d'un milliard de yuans rien que pour l'achat de cartes graphiques GPU. Il n’existe actuellement pas plus de trois entreprises nationales capables de prendre en charge une infrastructure similaire. Les centres de données des fournisseurs de cloud chinois ne sont généralement équipés que de milliers de cartes graphiques GPU. La raison en est que le coût d’achat d’un GPU Nvidia de haut niveau s’élève à 80 000 yuans. Un serveur nécessite généralement 4 à 8 GPU et le coût d'un serveur GPU dépasse généralement 400 000 yuans. Le prix moyen d'un serveur national est de 40 000 à 50 000 yuans. Cela signifie que le coût d’un serveur GPU est plus de 10 fois supérieur à celui d’un serveur ordinaire.

Ainsi, cette vague de changement technologique entraînée par les grands modèles peut essentiellement déduire les défis et les opportunités pour les acteurs chinois de l'alimentation informatique.

Tout d’abord, il doit disposer d’une infrastructure de cluster informatique intelligent complète, mature et stable.

Deuxièmement, en plus de performances globales, les produits associés doivent également présenter des avantages en matière d'efficacité énergétique : protection de l'environnement et réduction des coûts.

Ainsi, après avoir clarifié ces deux conclusions, nous pouvons probablement savoir pourquoi le groupe Lenovo, en tant que gagnant caché derrière le bonus ChatGPT, continuera à avoir des perspectives de puissance de calcul durable.

Si la puissance de calcul a inauguré la nouvelle loi de Moore, la question de la consommation d'énergie ne peut être ignorée. Le principal responsable du Département de haute technologie de la Commission nationale du développement et de la réforme a déclaré en 2021 que la consommation annuelle d'électricité des données de mon pays. Les centres représentent environ 10% de la consommation électrique de l'ensemble de la société, soit 2%.

Pour le dire de manière plus intuitive, « la consommation annuelle d'électricité dépasse 2,5 fois la production d'électricité du barrage des Trois Gorges ». La loi de Moore est une croissance exponentielle, et la production d'électricité du barrage des Trois Gorges ne peut pas croître de façon exponentielle.

Le groupe Lenovo a développé la technologie leader de refroidissement à eau chaude « Poséidon », qui utilise de l'eau chaude à 50 °C pour évacuer la chaleur par circulation, éliminant ainsi le besoin de refroidisseurs et d'échangeurs de chaleur Il peut également utiliser des déchets. chaleur pour fournir de l'énergie aux bâtiments Chauffage, Économies annuelles sur la facture d'électricité et réduction des émissions de plus de 42 %

Sur la dernière liste mondiale HPC Green500, le système Henri fourni par le groupe Lenovo a certifié une performance de 6,5091 milliards d'opérations à virgule flottante par watt de La consommation d'énergie, qui non seulement répond aux exigences nationales et internationales, en a même fait le système informatique haute performance le plus économe en énergie au monde.

En fait, Lenovo n'est plus l'entreprise uniquement informatique selon votre stéréotype. Dans l'ensemble, à mesure que le secteur des infrastructures informatiques explose, le groupe Lenovo dans son ensemble a progressivement achevé sa transformation : la proportion du chiffre d'affaires total provenant des activités autres que les ordinateurs personnels a dépassé 40 %.

Qu'il s'agisse de ChatGPT, de grands modèles ou même de l'IA, le dividende de la puissance de calcul qui est le premier à augmenter dans le cycle d'innovation technologique rafraîchit le groupe Lenovo, ou plus précisément, pousse le champion caché derrière l'alimentation en puissance de calcul. la scène.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI